DeepSeek新模型霸榜,代碼能力與OpenAI o1相當且確認開源,網(wǎng)友:今年編程只剩Tab鍵

DeepSeek版o1,有消息了。

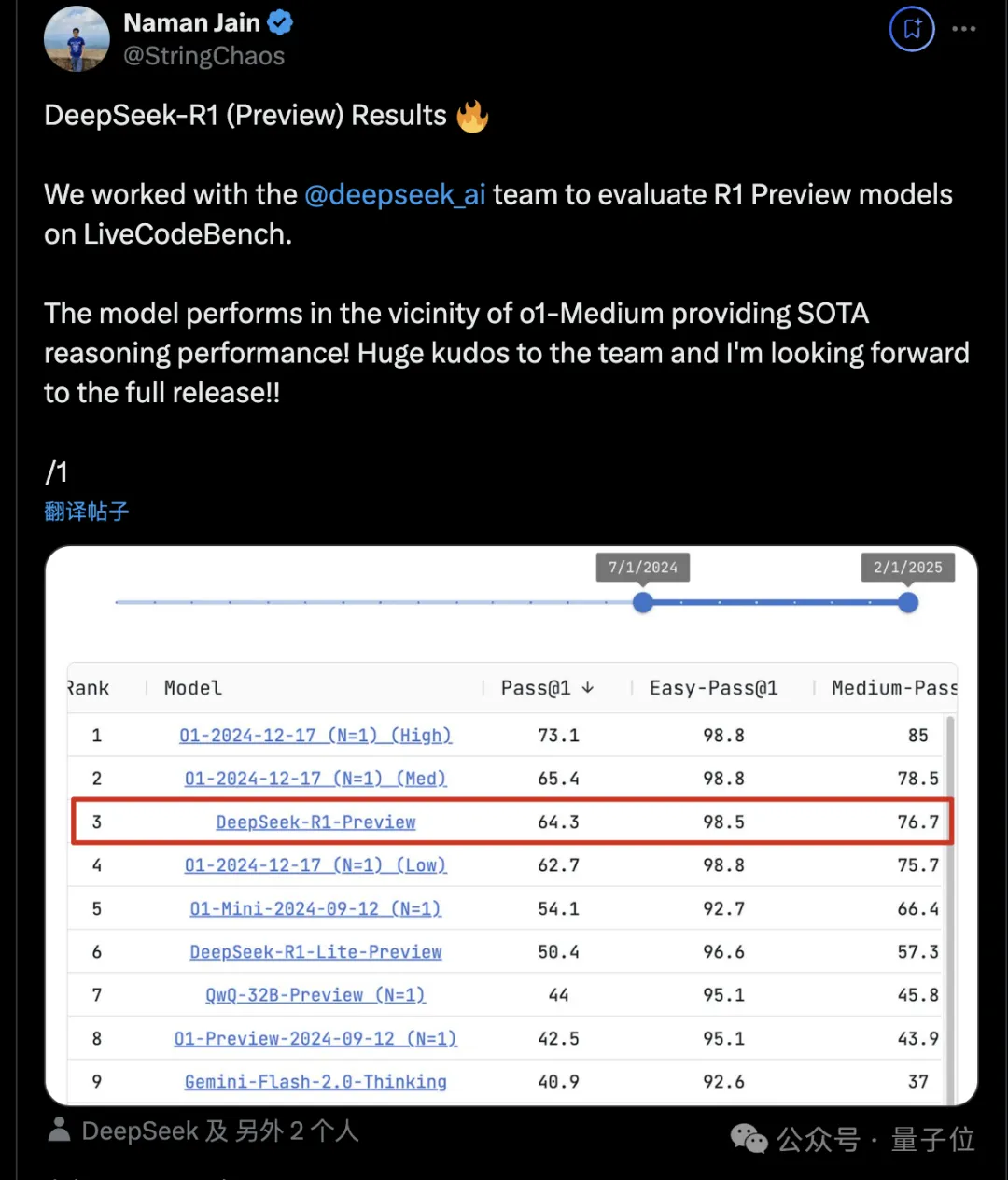

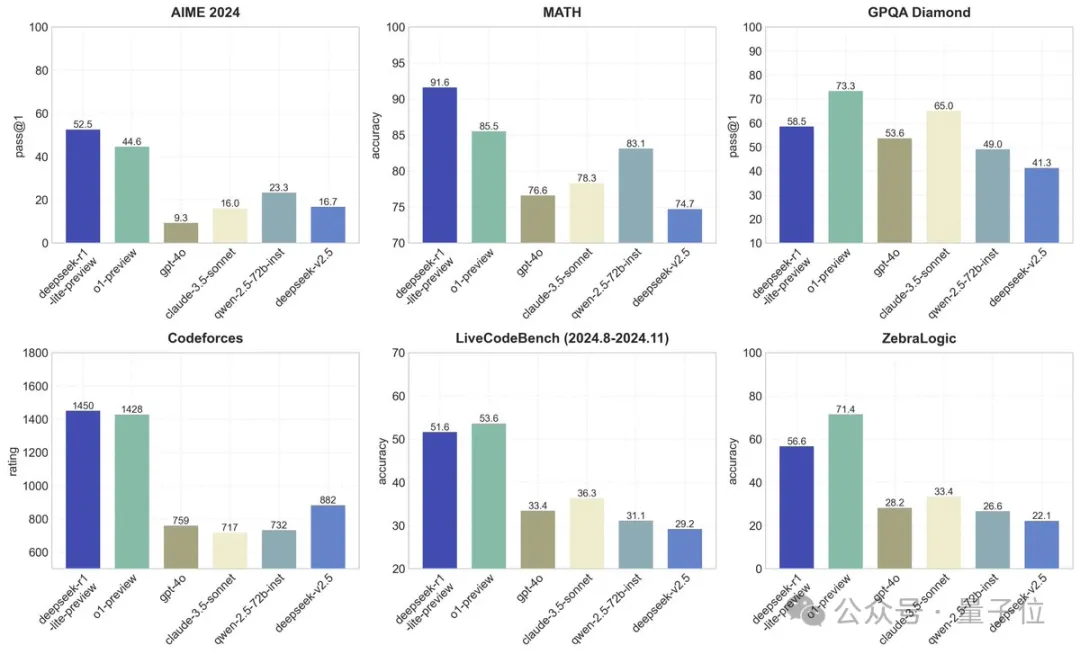

還未正式發(fā)布,已在代碼基準測試LiveCodeBench霸榜前三,表現(xiàn)與OpenAI o1的中檔推理設(shè)置相當。

注意了,這不是在DeepSeek官方App已經(jīng)能試玩的DeepSeek-R1-Lite-Preview(輕量預(yù)覽版)。

而是摘掉了輕量版的帽子,稱為DeepSeek-R1-Preview(預(yù)覽版),意味著替換了規(guī)模更大的基礎(chǔ)模型。

LiveCodeBench團隊透露,他們正在與DeepSeek合作評估新模型的能力,在合作過程中,DeepSeek團隊還幫他們找出并解決了評分系統(tǒng)的一些bug。

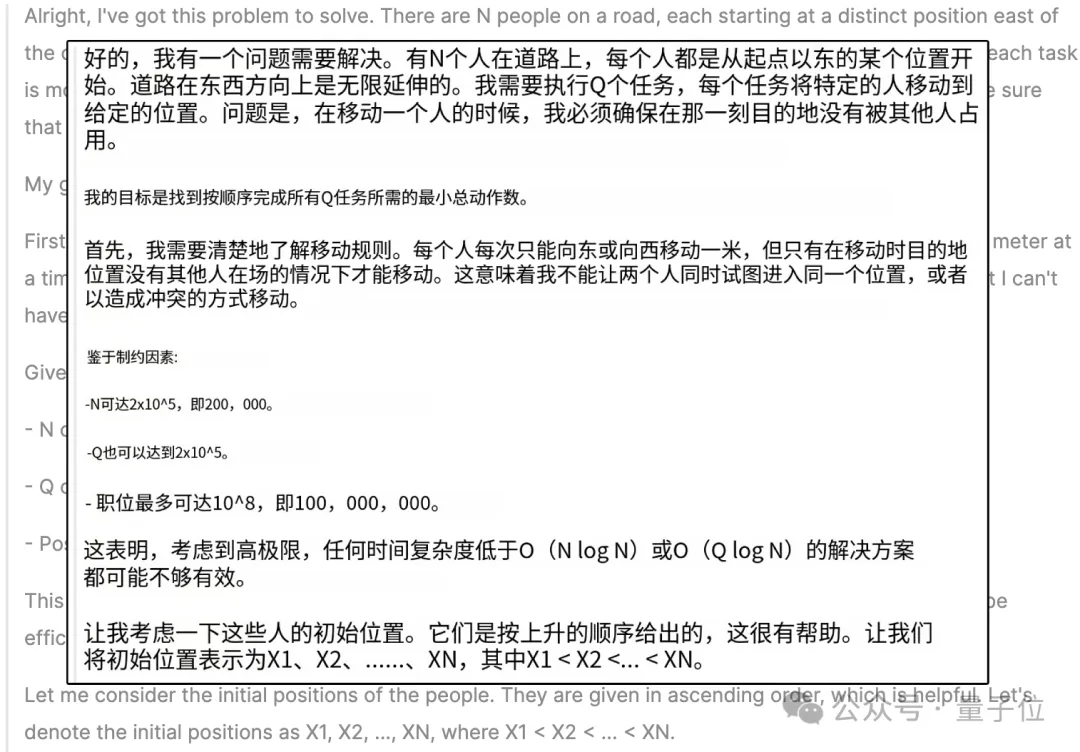

與此同時,他們還曬出了目前僅有的一張DeepSeek-R1-Preview的思考過程。

鑒于DeepSeek此前已宣布R1模型將開源,有網(wǎng)友表示,與OpenAI o1編程能力相當?shù)拈_源模型即將發(fā)布,2025年的編程就只剩下按Tab鍵了。

DeepSeek推理大模型滿血版

兩個月前,DeepSeek在官網(wǎng)上線DeepSeek-R1-Lite-Preview時曾透露:

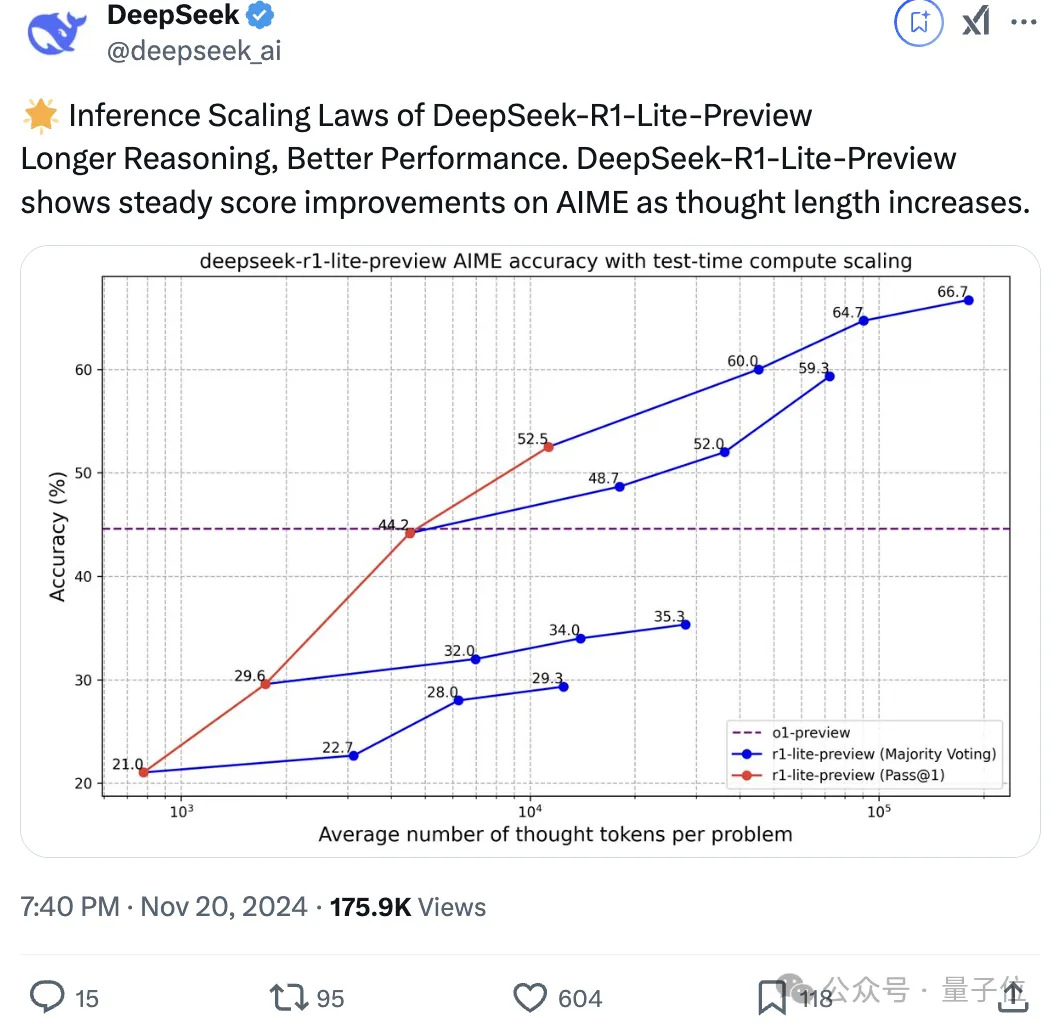

DeepSeek-R1-Lite-Preview使用強化學(xué)習(xí)訓(xùn)練,推理含大量反思和驗證,遵循新的Scaling Laws——

推理越長,表現(xiàn)越強。

在AIME測試基準中,隨著推理長度的增加,DeepSeek-R1-Lite-Preview表現(xiàn)出穩(wěn)定的得分提升。

DeepSeek-R1-Lite推理的特點在網(wǎng)友們的后續(xù)測試中也得到了驗證:

在某些情況下,模型似乎能夠在生成推理步驟時自我糾正,表現(xiàn)出類似原生“自我反思”的能力。不過,沒有訓(xùn)練數(shù)據(jù)、模型架構(gòu)和技術(shù)報告/論文的細節(jié),很難確認這一點。

期待未來的開源模型和API!

摘掉Lite的帽子,變成DeepSeek-R1-Preview,意味著換了更大的基礎(chǔ)模型。

之前Lite版就在難度較高數(shù)學(xué)和代碼任務(wù)上超越o1-preview,大幅領(lǐng)先GPT-4o。

這次在LiveCodeBench上,這次的DeepSeek-R1-Preview的表現(xiàn)又與OpenAI o1-Medium相當,網(wǎng)友們更加期待開源模型和API了。

LiveCodeBench由UC伯克利、MIT和康奈爾大學(xué)團隊推出,旨在對大模型的代碼能力進行全面且無污染的評估。

具體避免測試數(shù)據(jù)泄露的方法,是隨著時間的推移不斷從人類的編程競賽平臺收集新的題目。

除了代碼生成,還會評估模型在代碼自修復(fù)、執(zhí)行和測試輸出預(yù)測等方面的能力。

這樣實時更新、確保公平性和可靠性的測試方法,獲得了開發(fā)者社區(qū)的認可。

還有程序猿喊話Cursor直接把R1-Preview集成到Agent mode里:

One More Thing

趕在春節(jié)前,許多還在做訓(xùn)練的國產(chǎn)大模型團隊,都把自家模型更新了一遍:

MiniMax開源4M超長上下文新模型!性能比肩DeepSeek-v3、GPT-4o

全球首次!國產(chǎn)AI開源端側(cè)GPT-4o海外爆火,8B參數(shù)iPad就能跑

國內(nèi)數(shù)學(xué)最強!實測訊飛版o1:上能打奧賽卷高考,下能輔導(dǎo)寒假作業(yè)

阿里開源首個視覺推理模型,擊敗GPT-4o,網(wǎng)頁一度404

……

OpenAI似乎要趁這邊放假開始搞事情了(狗頭),奧特曼發(fā)帖透露:

o3-mini完成外部合作測試,已確定最終版,將在幾周內(nèi)推出,會同時上線API和ChatGPT。

在后續(xù)對話中,奧特曼還確認了未來模型更多基本情況:

- o3-mini的速度會非常快

- o3-mini大多數(shù)情況下不如o1-pro

- o3 pro收費從$200/月起步

- OpenAI正在關(guān)注如何讓AI一次性輸出更多內(nèi)容

- 2025年計劃把GPT系列和o系列合并