解決文生圖質量和美學問題,字節跳動提出VMix:多維度美學控制方法,一鍵提升圖像美學

本文經AIGC Studio公眾號授權轉載,轉載請聯系出處。

為了解決擴散模型在文生圖的質量和美學問題,字節跳動&中科大研究團隊提出VMix美學條件注入方法,通過將抽象的圖像美感拆分成不同維度的美學向量引入擴散模型,從而實現細粒度美學圖像生成。論文基于提出的方法訓練了一個即插即用的模塊,無需再訓練即可應用于不同的開源模型,提升模型的生成美感。

相關鏈接

- 文章:https://arxiv.org/pdf/2412.20800

- 代碼:https://github.com/fenfenfenfan/VMix

- 項目:https://vmix-diffusion.github.io/VMix/

論文介紹

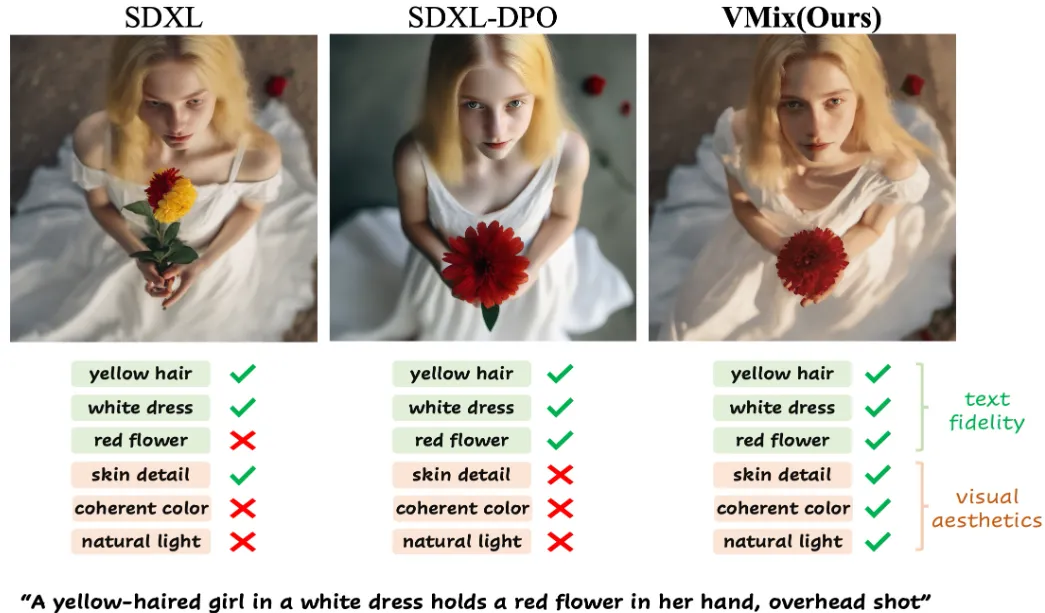

雖然擴散模型在文本到圖像生成方面表現出色,但它們仍可能無法生成高度美觀的圖像。更具體地說,在顏色、光照、構圖等更細粒度的維度上,生成的圖像與現實世界的美學圖像之間仍然存在差距。

在本文中,我們提出了跨注意值混合控制(VMix)適配器,這是一種即插即用的美學適配器,通過(1)通過初始化美學嵌入將輸入文本提示解開為內容描述和美學描述,以及(2)通過值混合交叉注意將美學條件整合到去噪過程中,網絡通過零初始化的線性層連接,來升級生成圖像的質量,同時保持跨視覺概念的通用性。我們的關鍵見解是通過設計一種優越的條件控制方法來增強現有擴散模型的美學呈現,同時保持圖像-文本對齊。

通過我們精心的設計,VMix 足夠靈活,可以應用于社區模型以獲得更好的視覺性能而無需重新訓練。為了驗證我們方法的有效性,我們進行了大量實驗,結果表明 VMix 優于其他最先進的方法,并且與其他社區模塊(例如 LoRA、ControlNet 和 IPAdapter)兼容以用于圖像生成。

現有的方法總是無法滿足人類對視覺生成內容的細粒度偏好。人類喜愛的圖像應該同時在各種細粒度的美學維度上表現出色,例如自然光、連貫的色彩和合理的構圖。為了應對這一挑戰,我們推出了VMix,這是一種新穎的即插即用適配器,旨在系統地彌合生成的圖像與現實世界圖像在各種美學維度上的美學質量差距。

現有的方法總是無法滿足人類對視覺生成內容的細粒度偏好。人類喜愛的圖像應該同時在各種細粒度的美學維度上表現出色,例如自然光、連貫的色彩和合理的構圖。為了應對這一挑戰,我們推出了VMix,這是一種新穎的即插即用適配器,旨在系統地彌合生成的圖像與現實世界圖像在各種美學維度上的美學質量差距。

它是如何工作的?

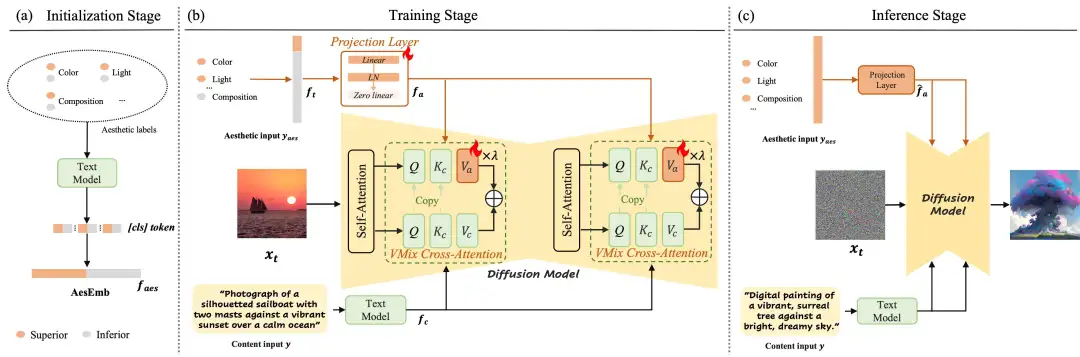

VMix 示意圖:

VMix 示意圖:

(a)在初始化階段,通過 CLIP 將預定義的美學標簽轉化為 [CLS] token,從而得到 AesEmb,只需要在訓練開始時處理一次。

(b)在訓練階段,項目層首先將輸入的美學描述 y aes映射到與內容文本嵌入 f t具有相同 token 維度的 嵌入 f a 。然后通過值混合交叉注意力將文本嵌入 f t集成到去噪網絡中。

(c) 在推理階段,VMix 從 AesEmb 中提取所有正向美學嵌入以形成美學輸入,并與內容輸入一起輸入到模型中進行去噪過程。

美學細膩控制

VMix 可以通過調整美學嵌入來實現細粒度的美學控制。當僅使用單維美學標簽時,可以觀察到圖像質量在特定維度上得到改善。當使用全正美學標簽時,圖像的視覺性能整體優于基線。

Prompt: "A girl leaning against a window with a breeze blowing, summer portrait, half-length medium view"

與當前方法的比較

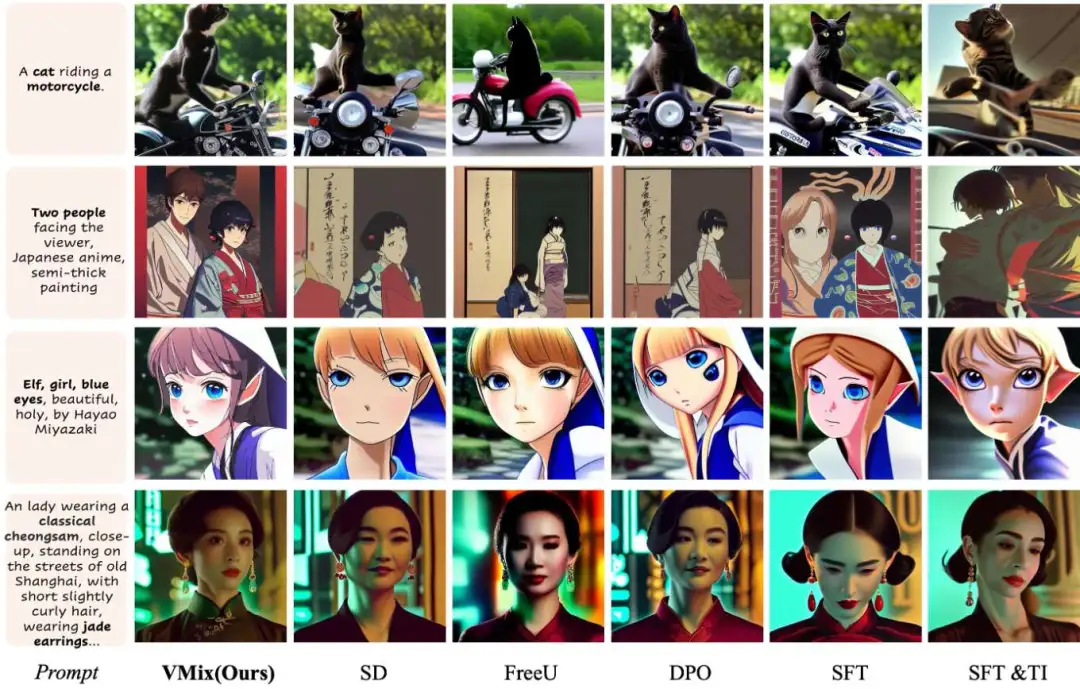

與各種最先進的方法進行定性比較。所有結果均基于穩定擴散。

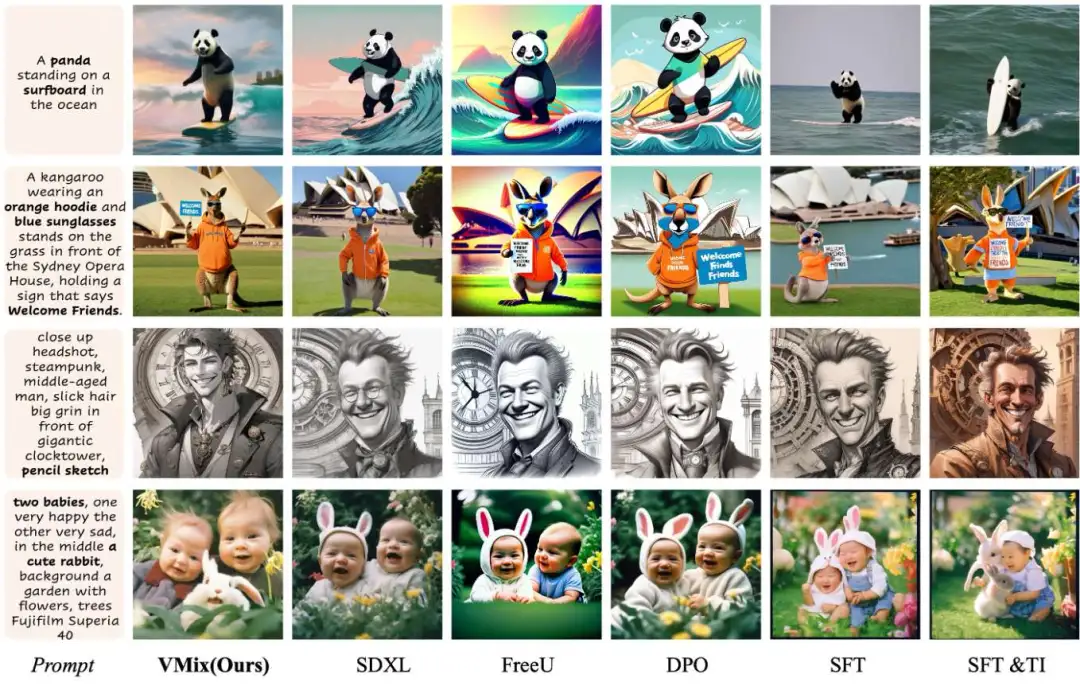

與各種最先進的方法進行定性比較。所有方法的結果均基于 SDXL。

與各種最先進的方法進行定性比較。所有方法的結果均基于 SDXL。

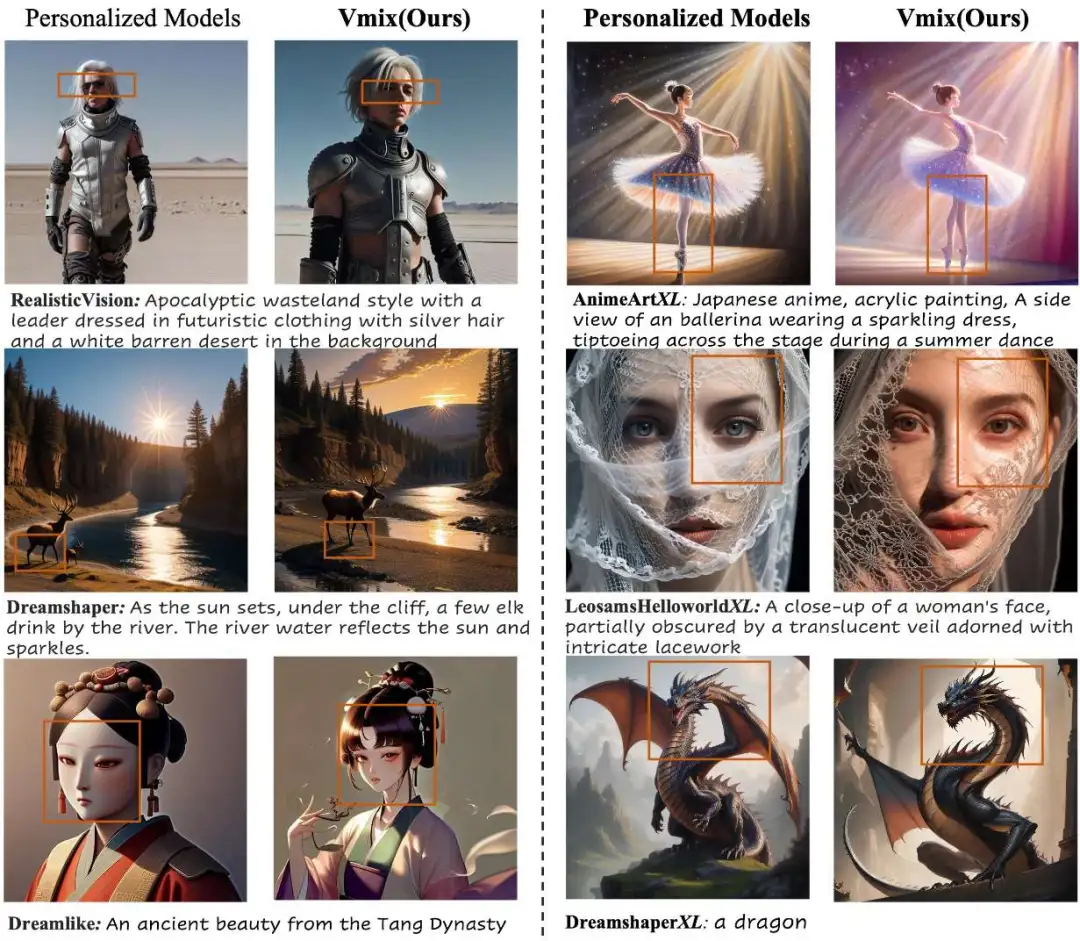

個性化文本轉圖像模型

帶有或不帶有 VMix 的個性化模型生成的圖像。