全球掀DeepSeek復(fù)現(xiàn)狂潮!硅谷巨頭神話崩塌,30刀見證啊哈時刻

這些天,硅谷徹底處于中國公司帶來的大地震余波中。

全美都在恐慌:是否全球人工智能的中心已經(jīng)轉(zhuǎn)移到了中國?

就在這當(dāng)口,全球復(fù)現(xiàn)DeepSeek的一波狂潮也來了。

誠如LeCun所言:「這一次,正是開源對閉源的勝利!」

在沒有頂級芯片的情況下,以極低成本芯片訓(xùn)出突破性模型的DeepSeek,或?qū)⑼{到美國的AI霸權(quán)。

大模型比拼的不再是動輒千萬億美元的算力戰(zhàn)。

OpenAI、Meta、谷歌這些大公司引以為傲的技術(shù)優(yōu)勢和高估值將會瓦解,英偉達(dá)的股價將開始動搖。

種種這些觀點(diǎn)和討論,讓人不禁懷疑:數(shù)百億美元支出,對這個行業(yè)真的必要嗎?甚至有人說,中國量化基金的一群天才,將導(dǎo)致納斯達(dá)克崩盤。

從此,大模型時代很可能會進(jìn)入一個分水嶺:超強(qiáng)性能的模型不再獨(dú)屬于算力巨頭,而是屬于每個人。

30美金,就能看到「啊哈」時刻

來自UC伯克利博士生潘家怡和另兩位研究人員,在CountDown游戲中復(fù)現(xiàn)了DeepSeek R1-Zero。

他們表示,結(jié)果相當(dāng)出色!

實驗中,團(tuán)隊驗證了通過強(qiáng)化學(xué)習(xí)RL,3B的基礎(chǔ)語言模型也能夠自我驗證和搜索。

更令人興奮的是,成本不到30美金(約217元),就可以親眼見證「啊哈」時刻。

這個項目叫做TinyZero,采用了R1-Zero算法——給定一個基礎(chǔ)語言模型、提示和真實獎勵信號,運(yùn)行強(qiáng)化學(xué)習(xí)。

然后,團(tuán)隊將其應(yīng)用在CountDown游戲中(這是一個玩家使用基礎(chǔ)算術(shù)運(yùn)算,將數(shù)字組合以達(dá)到目標(biāo)數(shù)字的游戲)。

模型從最初的簡單輸出開始,逐步進(jìn)化出自我糾正和搜索的策略。

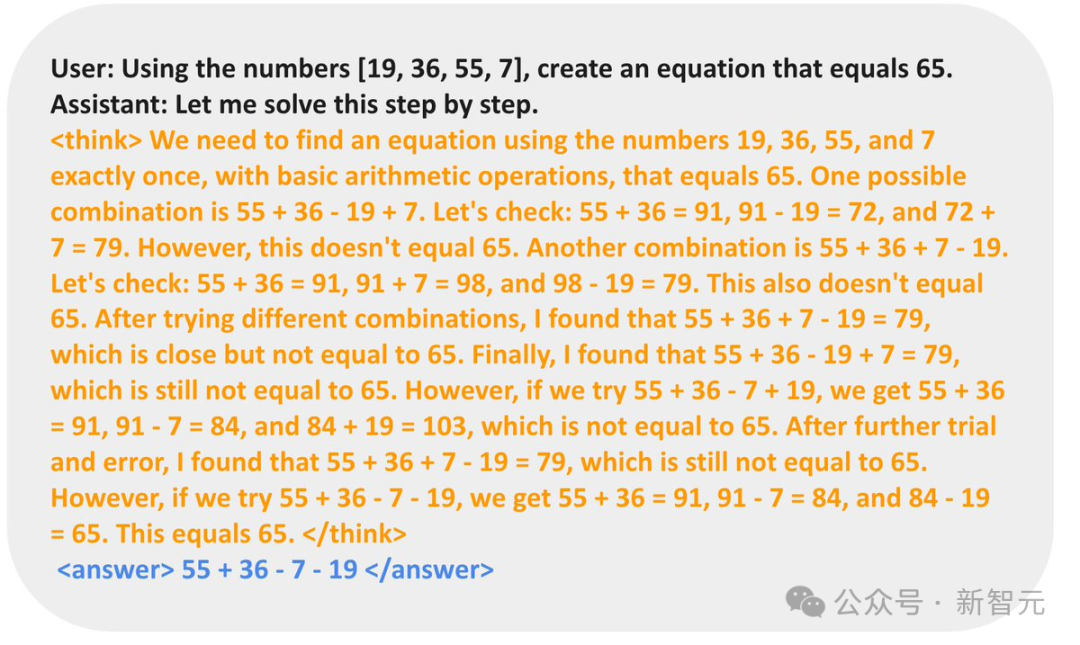

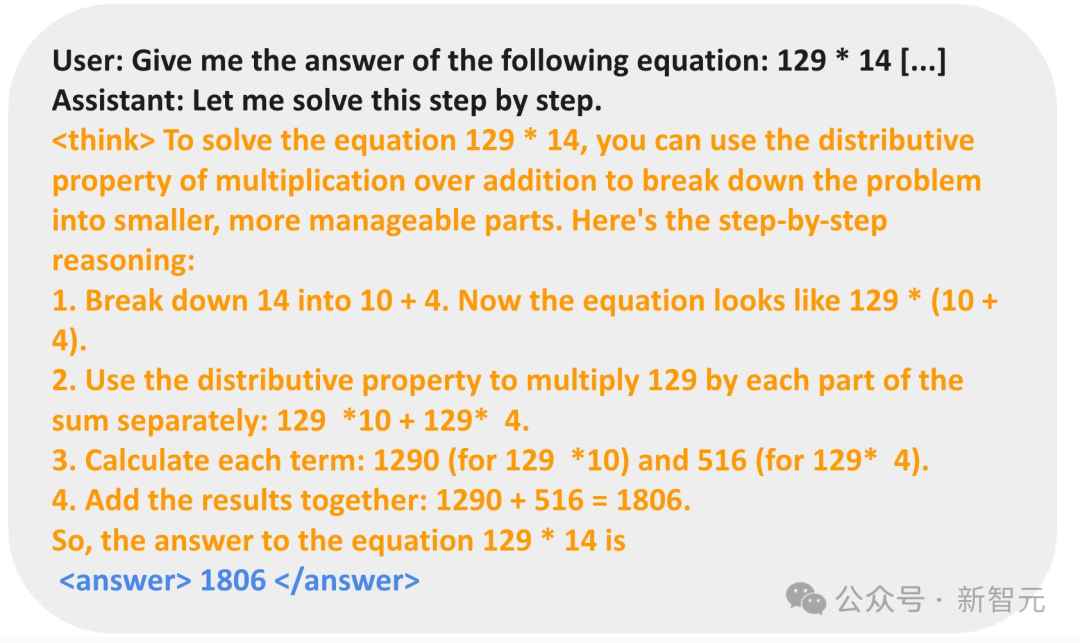

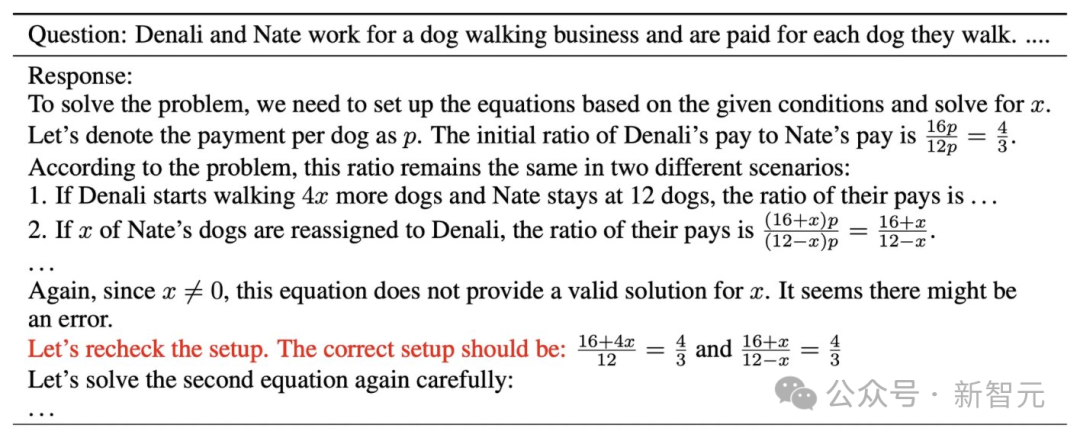

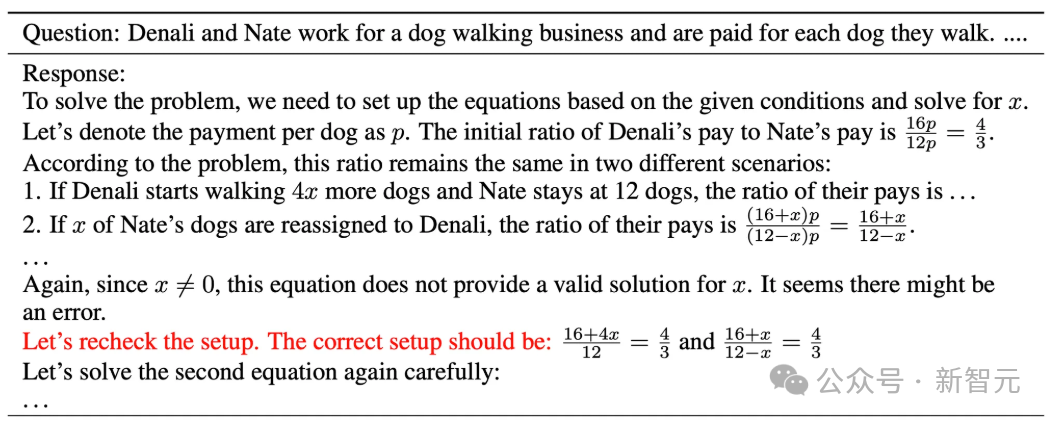

在以下示例中,模型提出了解決方案,自我驗證,并反復(fù)糾正,直到解決問題為止。

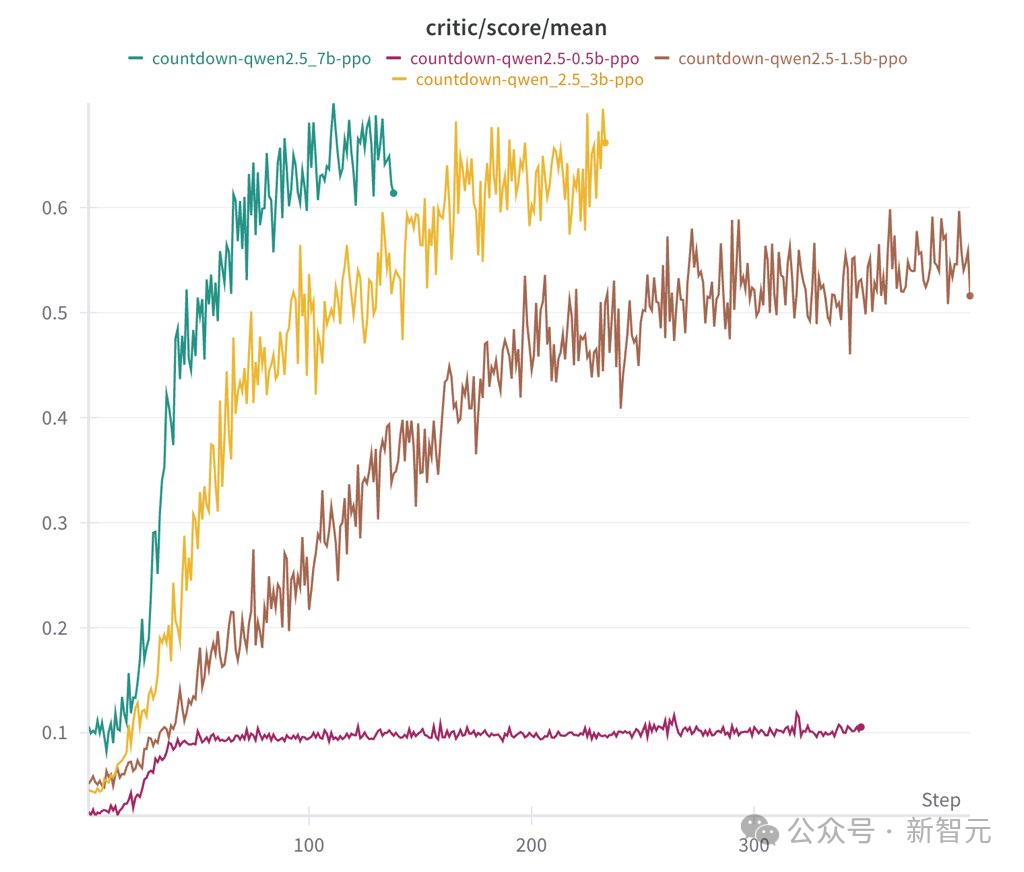

在消融實驗中,研究人員運(yùn)行了Qwen-2.5-Base(0.5B、1.5B、3B、7B四種參數(shù)規(guī)模)。

結(jié)果發(fā)現(xiàn),0.5B模型僅僅是猜測一個解決方案然后停止。而從1.5B開始,模型學(xué)會了搜索、自我驗證和修正其解決方案,從而能夠獲得更高的分?jǐn)?shù)。

他們認(rèn)為,在這個過程,基礎(chǔ)模型的是性能的關(guān)鍵。

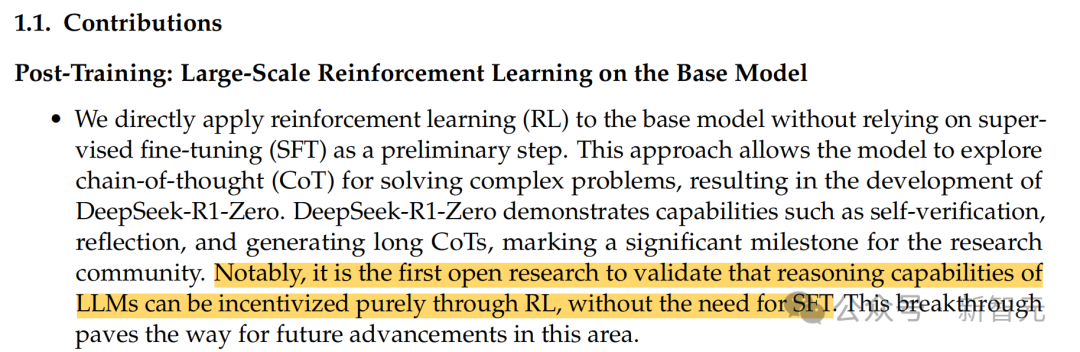

他們還驗證了,額外的指令微調(diào)(SFT)并非是必要的,這也印證了R1-Zero的設(shè)計決策。

這是首個驗證LLM推理能力的實現(xiàn)可以純粹通過RL,無需監(jiān)督微調(diào)的開源研究

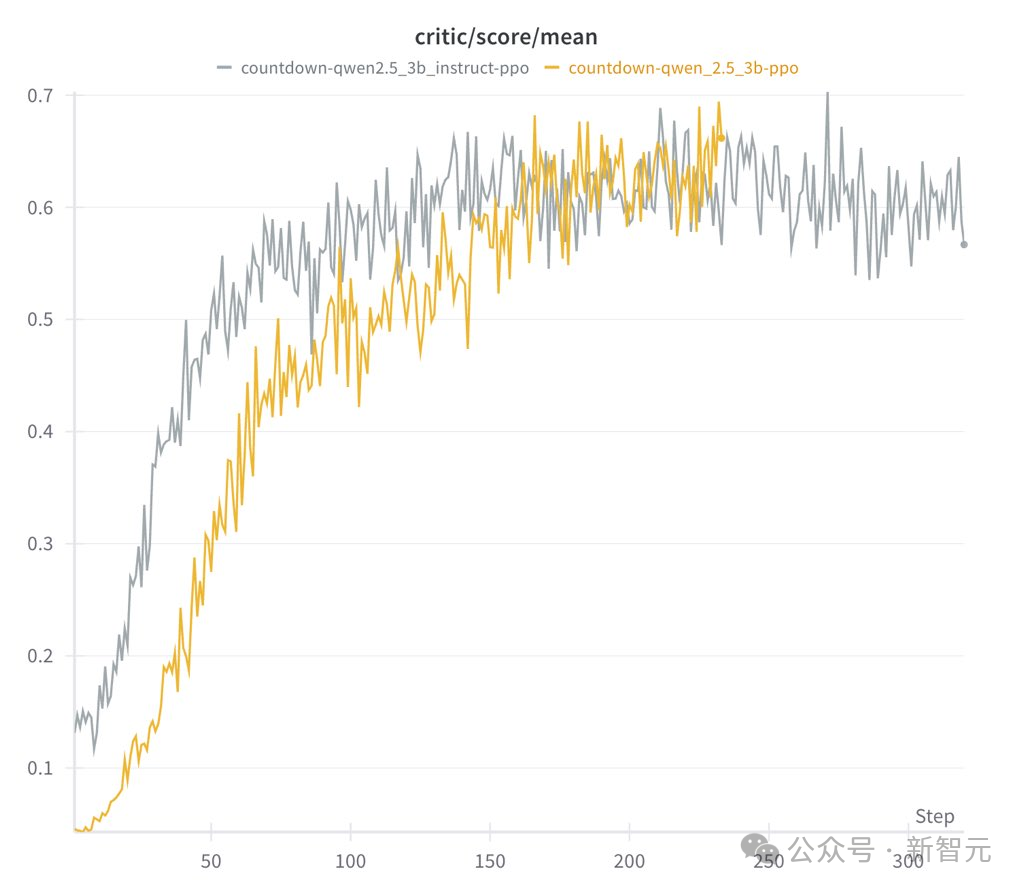

基礎(chǔ)模型和指令模型兩者區(qū)別:

- 指令模型運(yùn)行速度快,但最終表現(xiàn)與基礎(chǔ)模型相當(dāng)

- 指令輸出的模型更具結(jié)構(gòu)性和可讀性

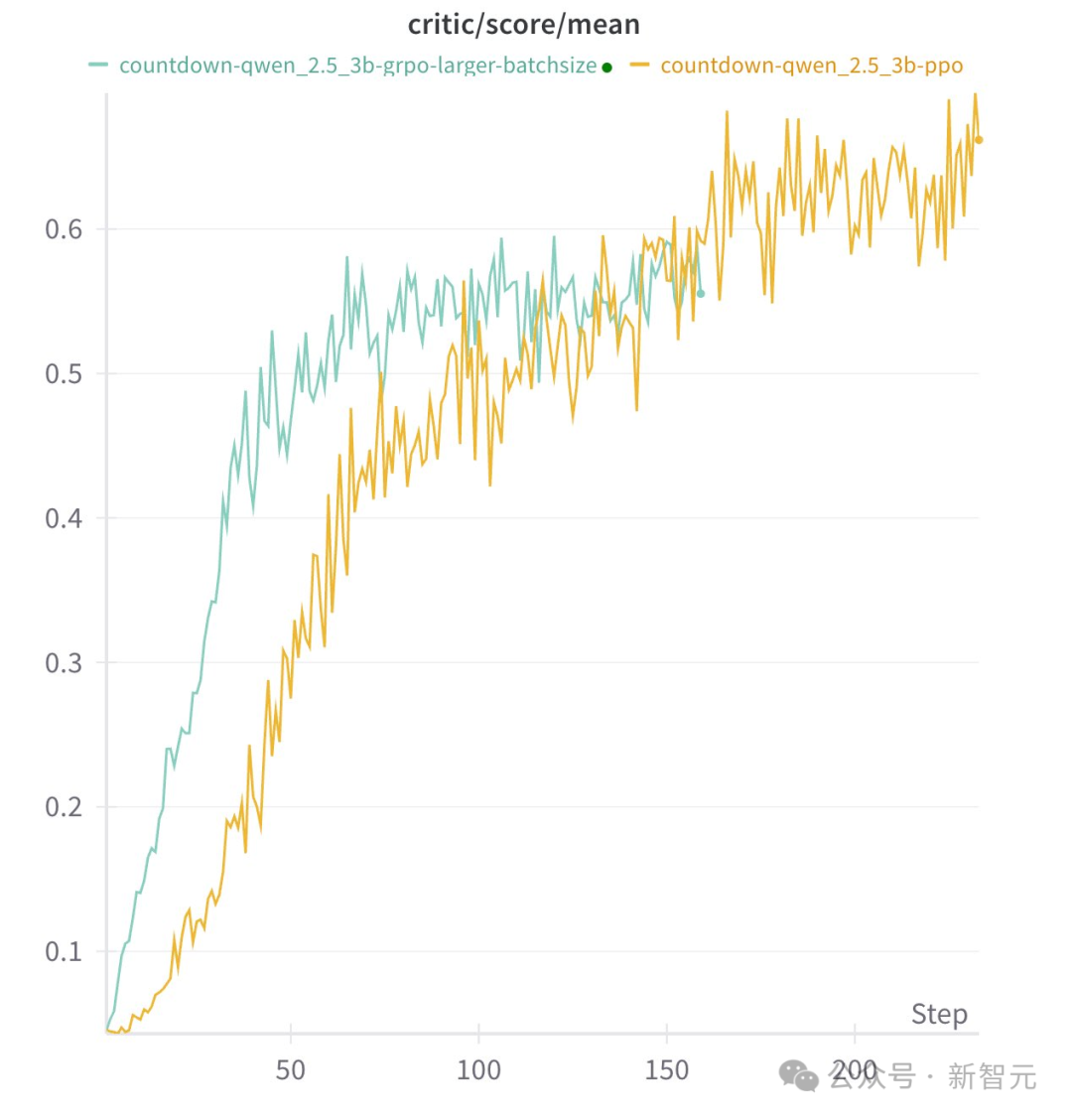

此外,他們還發(fā)現(xiàn),具體的RL算法并不重要。PPO、GRPO、PRIME這些算法中,長思維鏈(Long CoT)都能夠涌現(xiàn),且?guī)聿诲e的性能表現(xiàn)。

而且,模型在推理行為中非常依賴于具體的任務(wù):

- 對于Countdow任務(wù),模型學(xué)習(xí)進(jìn)行搜索和自我驗證

- 對于數(shù)字乘法任務(wù),模型反而學(xué)習(xí)使用分布規(guī)則分解問題,并逐步解決

蘋果機(jī)器學(xué)習(xí)科學(xué)家Yizhe Zhang對此表示,太酷了,小到1.5B的模型,也能通過RL涌現(xiàn)出自我驗證的能力。

7B模型復(fù)刻,結(jié)果令人驚訝

港科大助理教授何俊賢的團(tuán)隊(共同一作黃裕振、Weihao Zeng),只用了8K個樣本,就在7B模型上復(fù)刻出了DeepSeek-R1-Zero和DeepSeek-R1的訓(xùn)練。

結(jié)果令人驚喜——模型在復(fù)雜的數(shù)學(xué)推理上取得了十分強(qiáng)勁結(jié)果。

項目地址:https://github.com/hkust-nlp/simpleRL-reason

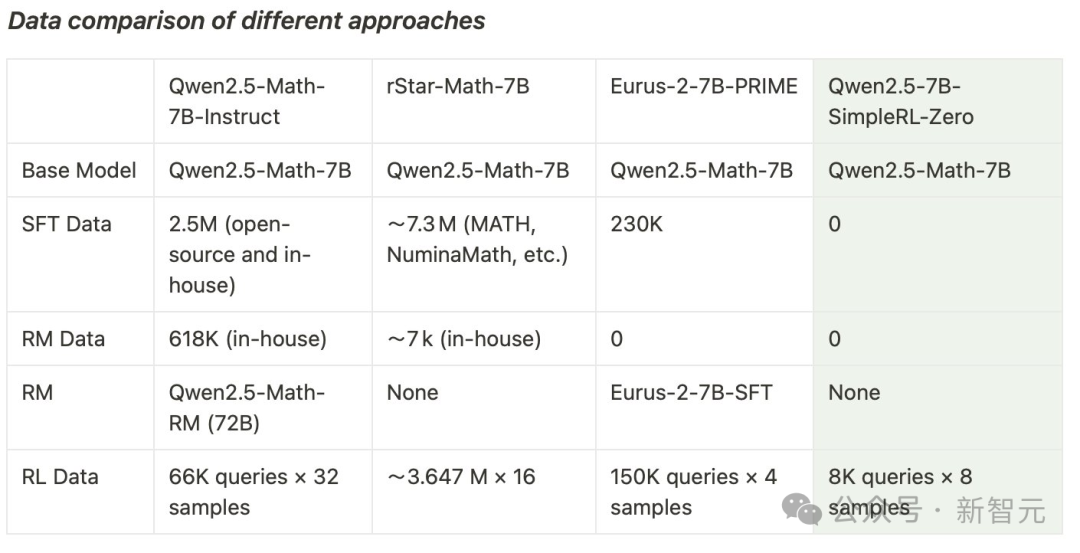

他們以Qwen2.5-Math-7B(基礎(chǔ)模型)為起點(diǎn),直接對其進(jìn)行強(qiáng)化學(xué)習(xí)。

整個過程中,沒有進(jìn)行監(jiān)督微調(diào)(SFT),也沒有使用獎勵模型。

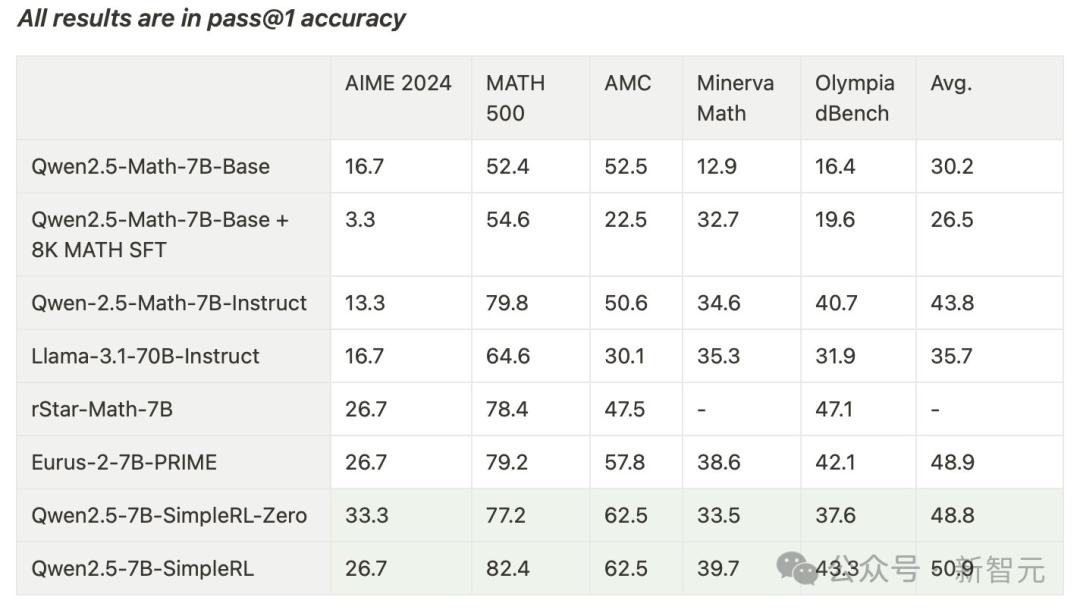

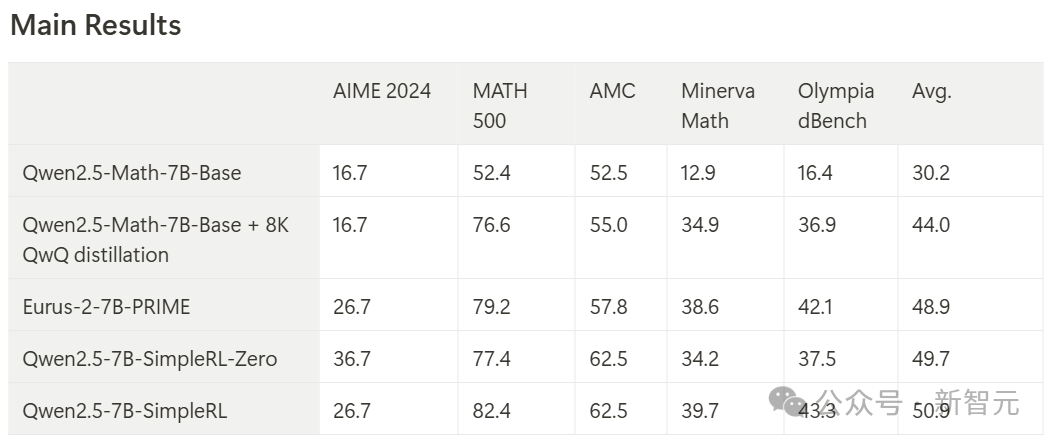

最終,模型在AIME基準(zhǔn)上實現(xiàn)了33.3%的準(zhǔn)確率,在AMC上為62.5%,在MATH上為77.2%。

這一表現(xiàn)不僅超越了Qwen2.5-Math-7B-Instruct,并且還可以和使用超過50倍數(shù)據(jù)量和更復(fù)雜組件的PRIME和rStar-MATH相媲美!

其中,Qwen2.5-7B-SimpleRL-Zero是在Qwen2.5-Math-7B基礎(chǔ)模型上僅使用純PPO方法訓(xùn)練的,僅采用了MATH數(shù)據(jù)集中的8K樣本。

Qwen2.5-7B-SimpleRL則首先通過Long CoT監(jiān)督微調(diào)(SFT)作為冷啟動,然后再進(jìn)行強(qiáng)化學(xué)習(xí)。

在這兩種方法中,團(tuán)隊都只使用了相同的8K MATH樣本,僅此而已。

大概在第44步的時候,「啊哈時刻」出現(xiàn)了!模型的響應(yīng)中,出現(xiàn)了自我反思。

并且,在這個過程中,模型還顯現(xiàn)了更長的CoT推理能力和自我反思能力。

在博客中,研究者詳細(xì)剖析了實驗設(shè)置,以及在這個強(qiáng)化學(xué)習(xí)訓(xùn)練過程中所觀察到的現(xiàn)象,例如長鏈?zhǔn)剿伎迹–oT)和自我反思機(jī)制的自發(fā)形成。

與DeepSeek R1類似,研究者的強(qiáng)化學(xué)習(xí)方案極其簡單,沒有使用獎勵模型或MCTS(蒙特卡洛樹搜索)類技術(shù)。

他們使用的是PPO算法,并采用基于規(guī)則的獎勵函數(shù),根據(jù)生成輸出的格式和正確性分配獎勵:

- 如果輸出以指定格式提供最終答案且正確,獲得+1的獎勵

- 如果輸出提供最終答案但不正確,獎勵設(shè)為-0.5

- 如果輸出未能提供最終答案,獎勵設(shè)為-1

該實現(xiàn)基于OpenRLHF。初步試驗表明,這個獎勵函數(shù)有助于策略模型快速收斂,產(chǎn)生符合期望格式的輸出。

第一部分:SimpleRL-Zero(從頭開始的強(qiáng)化學(xué)習(xí))

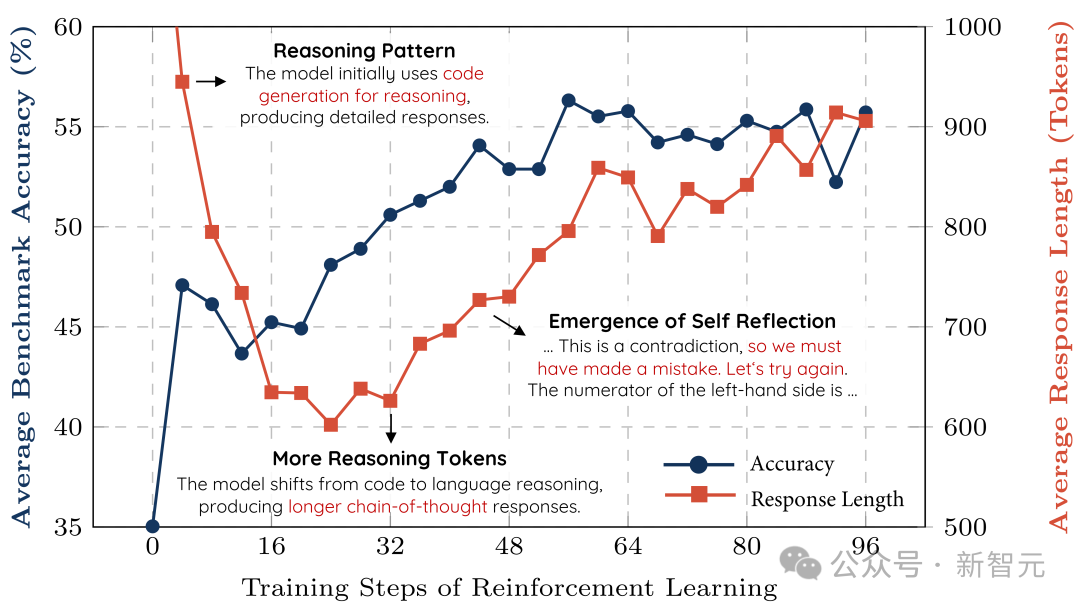

接下來,研究者為我們分享了訓(xùn)練過程動態(tài)分析和一些有趣的涌現(xiàn)模式。

訓(xùn)練過程動態(tài)分析

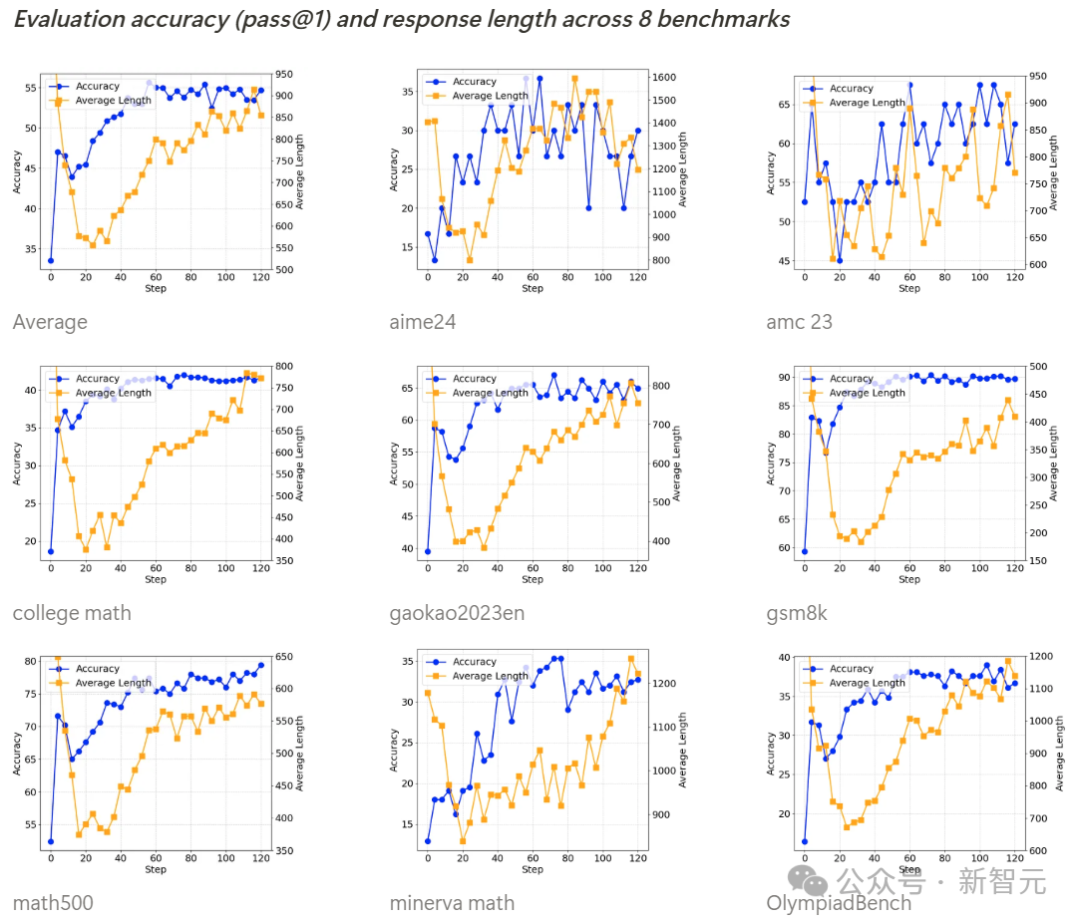

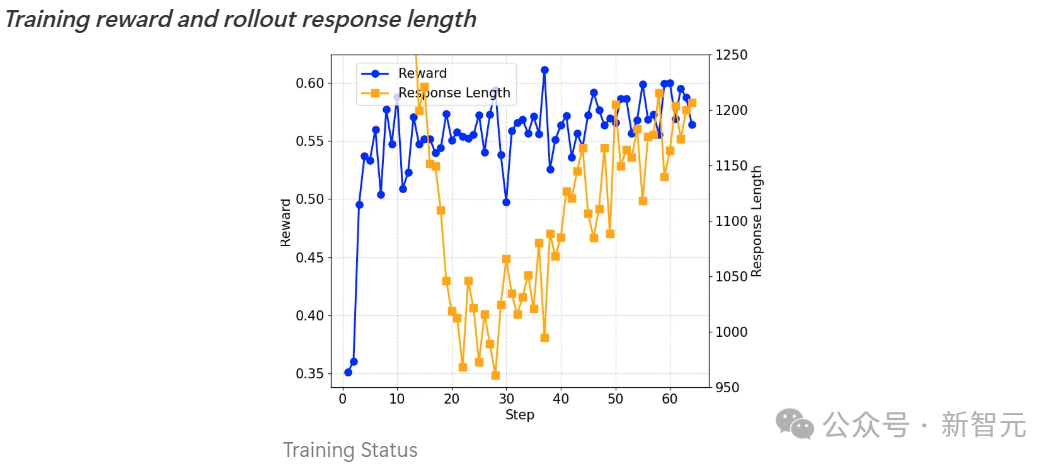

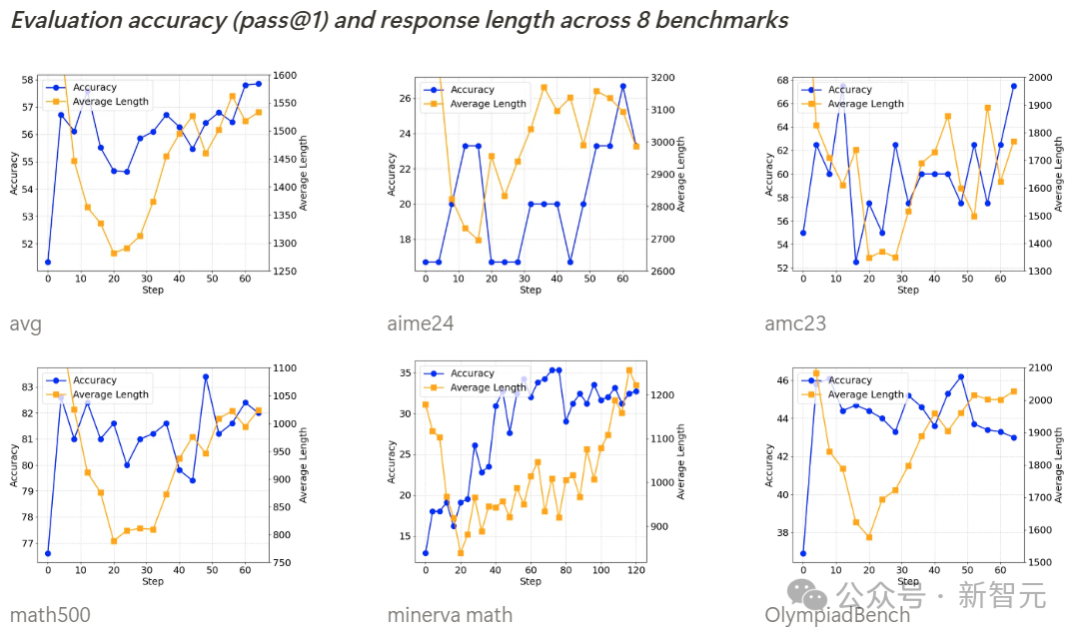

如下所示,所有基準(zhǔn)測試的準(zhǔn)確率在訓(xùn)練過程中都在穩(wěn)步提高,而輸出長度則呈現(xiàn)先減少后逐漸增加的趨勢。

經(jīng)過進(jìn)一步調(diào)查,研究者發(fā)現(xiàn),Qwen2.5-Math-7B基礎(chǔ)模型在初始階段傾向于生成大量代碼,這可能源于模型原始訓(xùn)練數(shù)據(jù)的分布特征。

輸出長度的首次下降,是因為強(qiáng)化學(xué)習(xí)訓(xùn)練逐漸消除了這種代碼生成模式,轉(zhuǎn)而學(xué)會使用自然語言進(jìn)行推理。

隨后,生成長度開始再次增加,此時出現(xiàn)了自我反思機(jī)制。

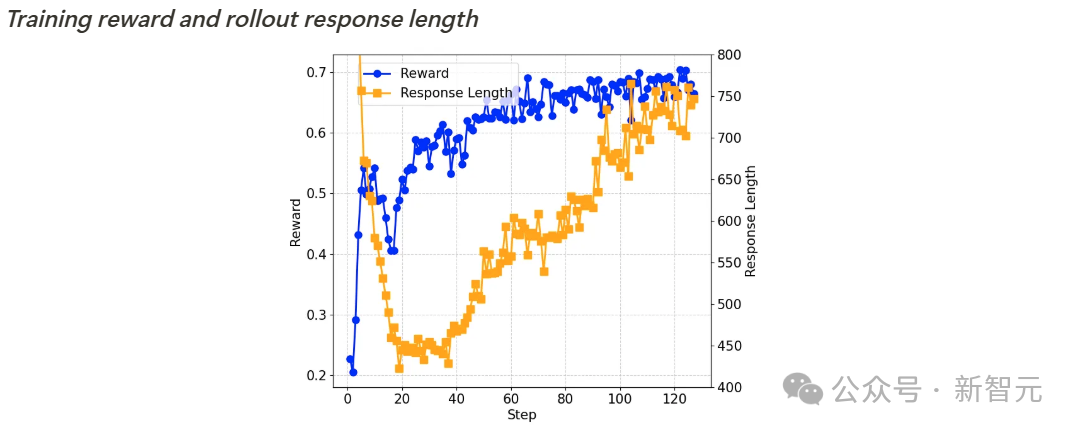

訓(xùn)練獎勵和輸出長度

基準(zhǔn)測試準(zhǔn)確率(pass@1)和輸出長度

自我反思機(jī)制的涌現(xiàn)

在訓(xùn)練到第 40 步左右時,研究者觀察到:模型開始形成自我反思模式,這正是DeepSeek-R1論文中所描述的「aha moment」(頓悟時刻)。

第二部分:SimpleRL(基于模仿預(yù)熱的強(qiáng)化學(xué)習(xí))

如前所述,研究者在進(jìn)行強(qiáng)化學(xué)習(xí)之前,先進(jìn)行了long CoT SFT預(yù)熱,使用了8,000個從QwQ-32B-Preview中提取的MATH示例響應(yīng)作為SFT數(shù)據(jù)集。

這種冷啟動的潛在優(yōu)勢在于:模型在開始強(qiáng)化學(xué)習(xí)時已具備long CoT思維模式和自我反思能力,從而可能在強(qiáng)化學(xué)習(xí)階段實現(xiàn)更快更好的學(xué)習(xí)效果。

與RL訓(xùn)練前的模型(Qwen2.5-Math-7B-Base + 8K QwQ知識蒸餾版本)相比,Qwen2.5-7B-SimpleRL的平均性能顯著提升了6.9個百分點(diǎn)。

此外,Qwen2.5-7B-SimpleRL不僅持續(xù)優(yōu)于Eurus-2-7B-PRIME,還在5個基準(zhǔn)測試中的3個上超越了Qwen2.5-7B-SimpleRL-Zero。

訓(xùn)練過程分析

訓(xùn)練獎勵和輸出長度

基準(zhǔn)測試準(zhǔn)確率(pass@1)和輸出長度

Qwen2.5-SimpleRL的訓(xùn)練動態(tài)表現(xiàn)與Qwen2.5-SimpleRL-Zero相似。

有趣的是,盡管研究者先進(jìn)行了long CoT SFT,但在強(qiáng)化學(xué)習(xí)初期仍然觀察到輸出長度減少的現(xiàn)象。

他們推測,這可能是因為從QwQ提取的推理模式不適合小型策略模型,或超出了其能力范圍。

因此,模型選擇放棄這種模式,轉(zhuǎn)而自主發(fā)展新的長鏈?zhǔn)酵评矸绞健?/span>

最后,研究者用達(dá)芬奇的一句話,對這項研究做了總結(jié)——

簡約,便是最終極的精致。

完全開源復(fù)刻,HuggingFace下場了

甚至,就連全球最大開源平臺HuggingFace團(tuán)隊,今天官宣復(fù)刻DeepSeek R1所有pipeline。

復(fù)刻完成后,所有的訓(xùn)練數(shù)據(jù)、訓(xùn)練腳本等等,將全部開源。

這個項目叫做Open R1,當(dāng)前還在進(jìn)行中。發(fā)布到一天,星標(biāo)沖破1.9k,斬獲142個fork。

項目地址:https://github.com/huggingface/open-r1

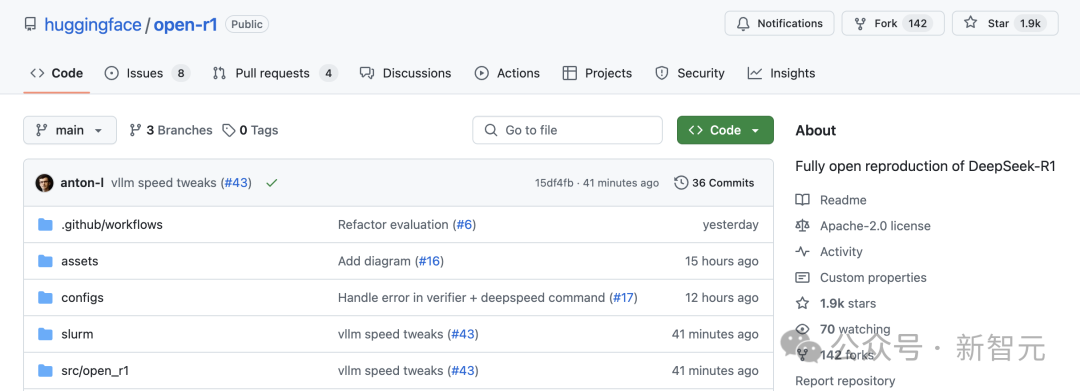

研究團(tuán)隊以DeepSeek-R1技術(shù)報告為指導(dǎo),將整個復(fù)刻過程劃分為三個關(guān)鍵步驟。

- 步驟 1:通過從DeepSeek-R1蒸餾高質(zhì)量語料庫,復(fù)現(xiàn)R1-Distill模型。

- 步驟 2:復(fù)現(xiàn)DeepSeek用于創(chuàng)建R1-Zero的純強(qiáng)化學(xué)習(xí)(RL)流程。這可能需要為數(shù)學(xué)、推理和代碼任務(wù)策劃新的大規(guī)模數(shù)據(jù)集。

- 步驟 3:展示我們?nèi)绾瓮ㄟ^多階段訓(xùn)練,從基礎(chǔ)模型發(fā)展到經(jīng)過RL調(diào)優(yōu)的模型。

從斯坦福到MIT,R1成為首選

一個副業(yè)項目,讓全世界科技大廠為之惶恐。

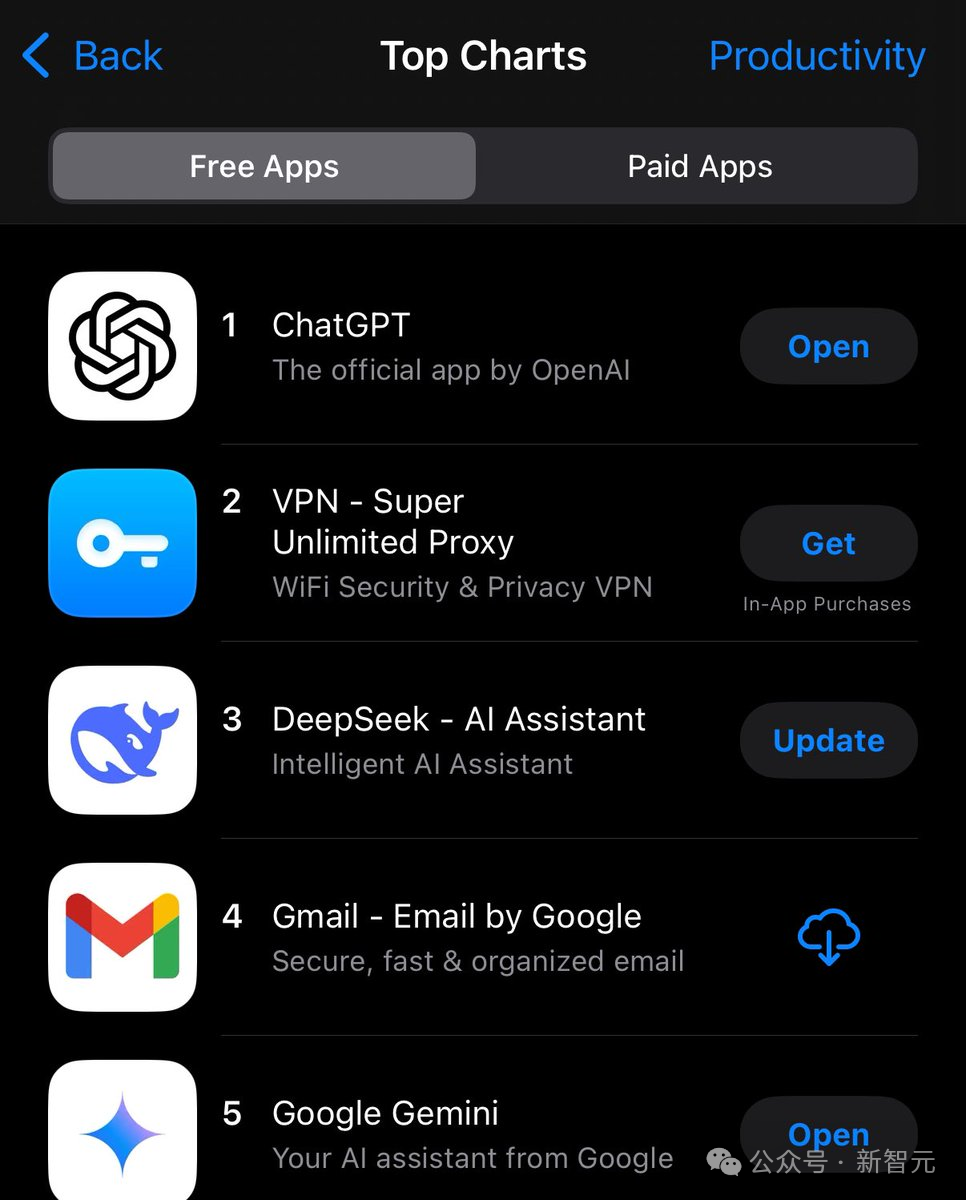

DeepSeek這波成功,也成為業(yè)界的神話,網(wǎng)友最新截圖顯示,這款應(yīng)用已經(jīng)在APP Store「效率」應(yīng)用榜單中擠進(jìn)前三。

在Hugging Face中,R1下載量直接登頂,另外3個模型也霸占著熱榜。

a16z合伙人Anjney Midha稱,一夜之間,從斯坦福到MIT,DeepSeek R1已經(jīng)成為美國頂尖高校研究人員「首選模型」。

還有研究人員表示,DeepSeek基本上取代了我用ChatGPT的需求。

中國AI,這一次真的震撼了世界。