半導體研究機構SemiAnalysis認為,DeepSeek囤積了6萬張英偉達GPU卡,其中包括1萬張A100、1萬張H100、1萬張“特供版”H800、3萬張“特供版”H20。馬斯克認為DeepSeek實際使用的GPU數量可能接近5萬個Nvidia H100 GPU。但是,據論文顯示,DeepSeek-V3開源基礎模型的訓練在2048塊英偉達H800 GPU集群上完成。

什么是真實的?什么是在炒作呢?

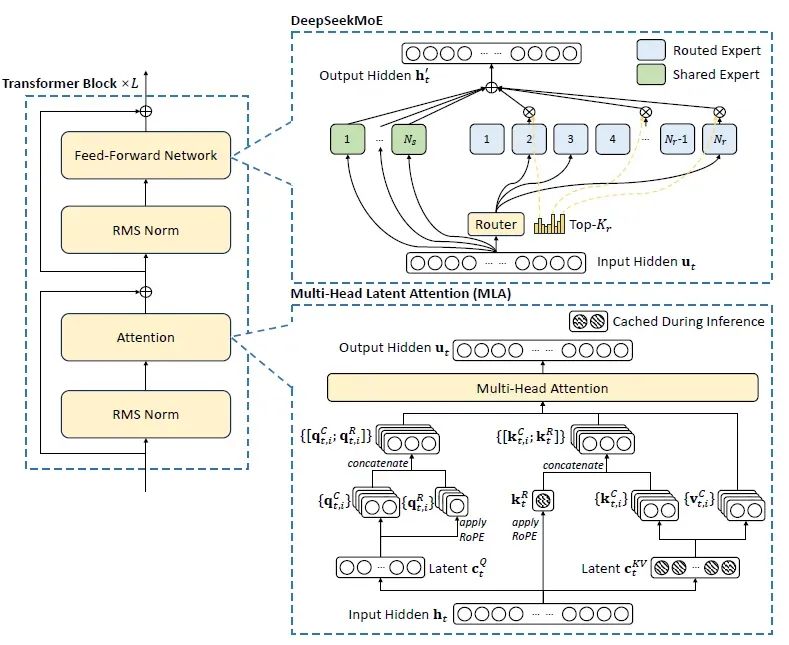

架構的影響

DeepSeek的架構是一個開源的專家混合 (MoE) 語言模型,使用一個創(chuàng)新的 Transformer 體系結構設計,用于經濟的訓練和有效的推理,其核心可能是多頭潛在注意 (MLA) 和 DeepSeekMoE。

圖片

圖片

多頭注意力 (MHA) 中的鍵值 (KV) 緩存是 LLM 推理的一個重要瓶頸。分組查詢注意力 (GQA) 和多查詢注意力 (MQA) 等方法試圖緩解這一問題,但往往會影響性能。MLA 通過利用低級關鍵值聯(lián)合壓縮來解決這個問題。實證結果表明,MLA 不僅優(yōu)于傳統(tǒng)的 MHA,而且顯著降低了 KV 緩存,從而提高了推理效率。

MLA 的主要目標是通過將鍵和值壓縮成比原始表示尺寸小得多的潛在向量,從而減小 KV 緩存的大小。這些被壓縮的潛在 KV 向量存儲在 KV 緩存中,然后在生成階段 (通過上投影) 被解壓縮到原始維度,以便進行多頭注意力的計算。這種優(yōu)化維護甚至可以增強模型的準確性,同時將緩存大小降低到與 GQA 所達到的大小相當的水平。事實上,這種緩存減少方法可以與 MQA (最積極的緩存減少方案) 相媲美,同時提供與傳統(tǒng) MHA 相當甚至更高的模型精度。

DeepSeekMoE 引入了兩項關鍵創(chuàng)新,以最大限度地實現專家的專業(yè)性:

- 細粒度專家細分:將專家細分為更細的粒度,以實現更高的專業(yè)化和更精確的知識獲取。

- 共享專家隔離:隔離專門的專家以減少路由專家之間的知識冗余。

使用相同數量的激活參數和全部專家參數,DeepSeekMoE 的性能明顯優(yōu)于 GShard 等傳統(tǒng) MoE 架構。

另外. DeepSeek 還采用了多令牌預測 (MTP) 。MTP 沒有嚴格地逐個生成令牌,而是訓練模型一次處理多個令牌。這種方法提高了吞吐量,也是 DeepSeek-V3 比 DeepSeek-V2 快三倍生成文本的部分原因。

通過整合這些創(chuàng)新,DeepSeek提供了強大的性能、成本效益高的培訓、大量的 KV 緩存減少和高推理吞吐量。

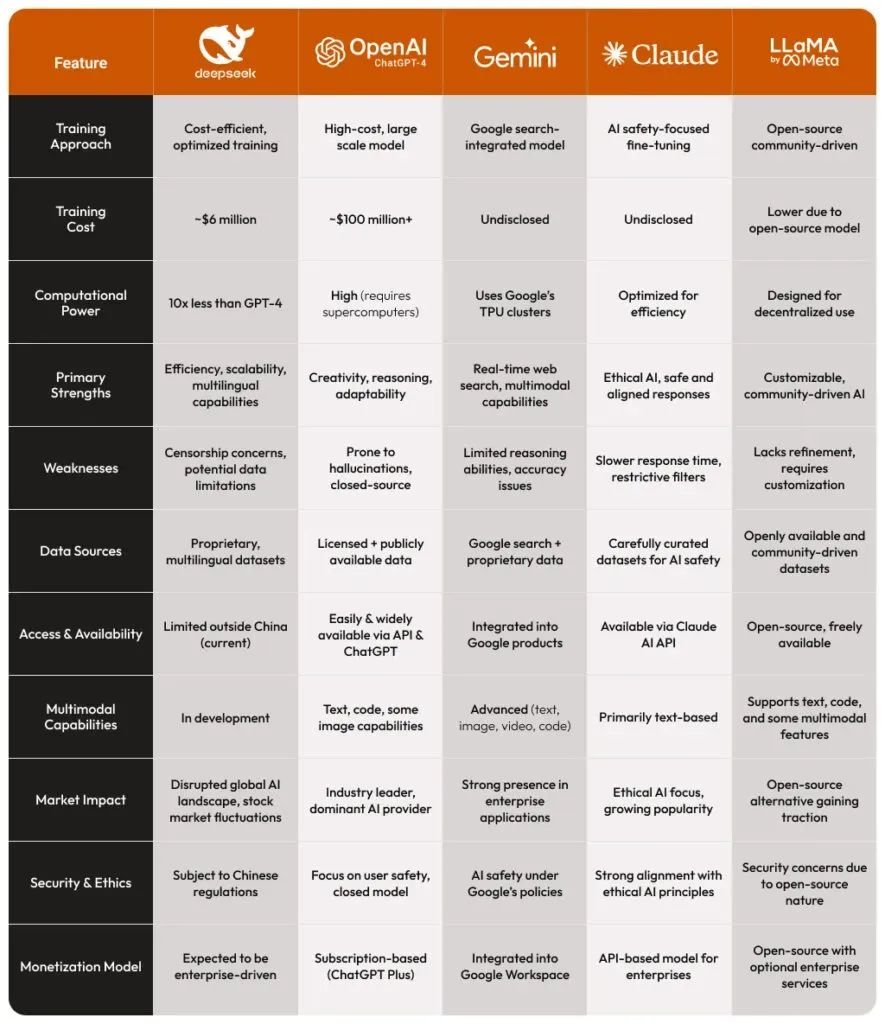

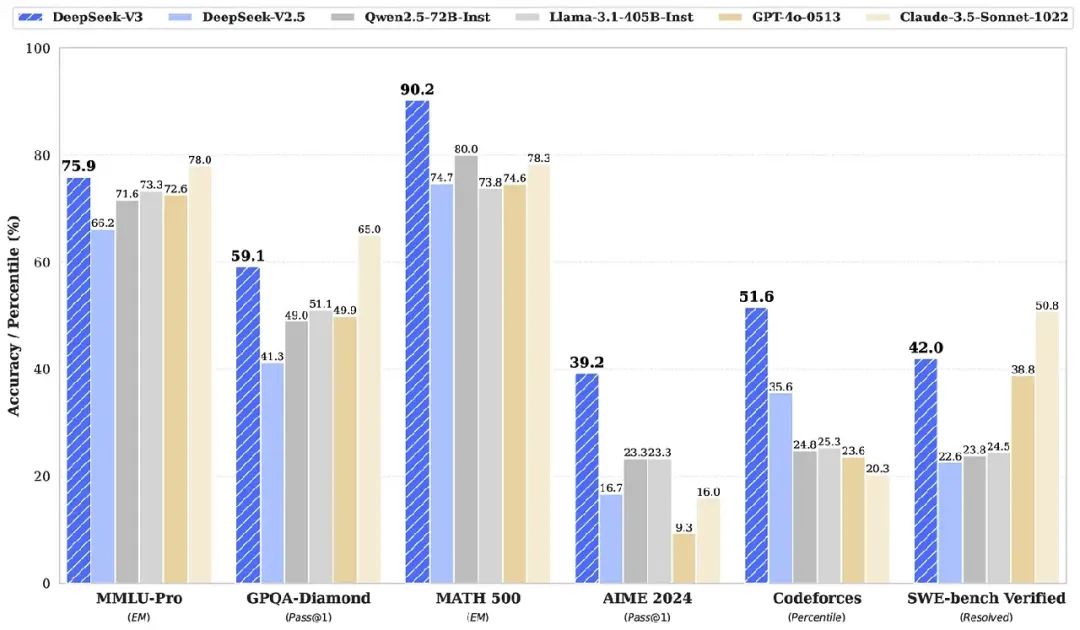

DeepSeek 與其他大模型的對比

下面表格提供了一個 DeepSeek 比較其他領先的人工智能語言模型的簡要說明。它強調了 DeepSeek 與 ChatGPT、 Gemini、 Claude 和 Llama 之間的關鍵區(qū)別,側重于性能、效率和培訓成本等方面。

圖片

圖片

簡單而言,

- DeepSeek 正在通過成本效益高的培訓和具有競爭力的性能 / 資源比例,打動人工智能市場,在 DeepSeek 與 Openai ChatGPT 的對比中提供了一個令人信服的案例。

- OpenAI (ChatGPT-4) 仍然占據主導地位,但 DeepSeek 的崛起引入了一個新的玩家,能夠以更低的成本提供類似的功能。DeepSeek VS ChatGPT 目前成為了一種趨勢。

- 谷歌 Gemini 與搜索的整合使其在實時更新方面功能強大,而 DeepSeek 的多語言專注可能使其成為強大的替代品。

- Anthropic Claude 優(yōu)先考慮人工智能的安全性,將自己定位為一個值得信賴的模型,但它可能缺乏 DeepSeek 的可擴展性和適應性。

- Meta 的Llama是開源的,允許定制,但它可能還沒有達到 DeepSeek 在多語言和結構化人工智能響應方面的表現。據報道,Meta建立了四個作戰(zhàn)室來調查深度搜索的發(fā)展趨勢。

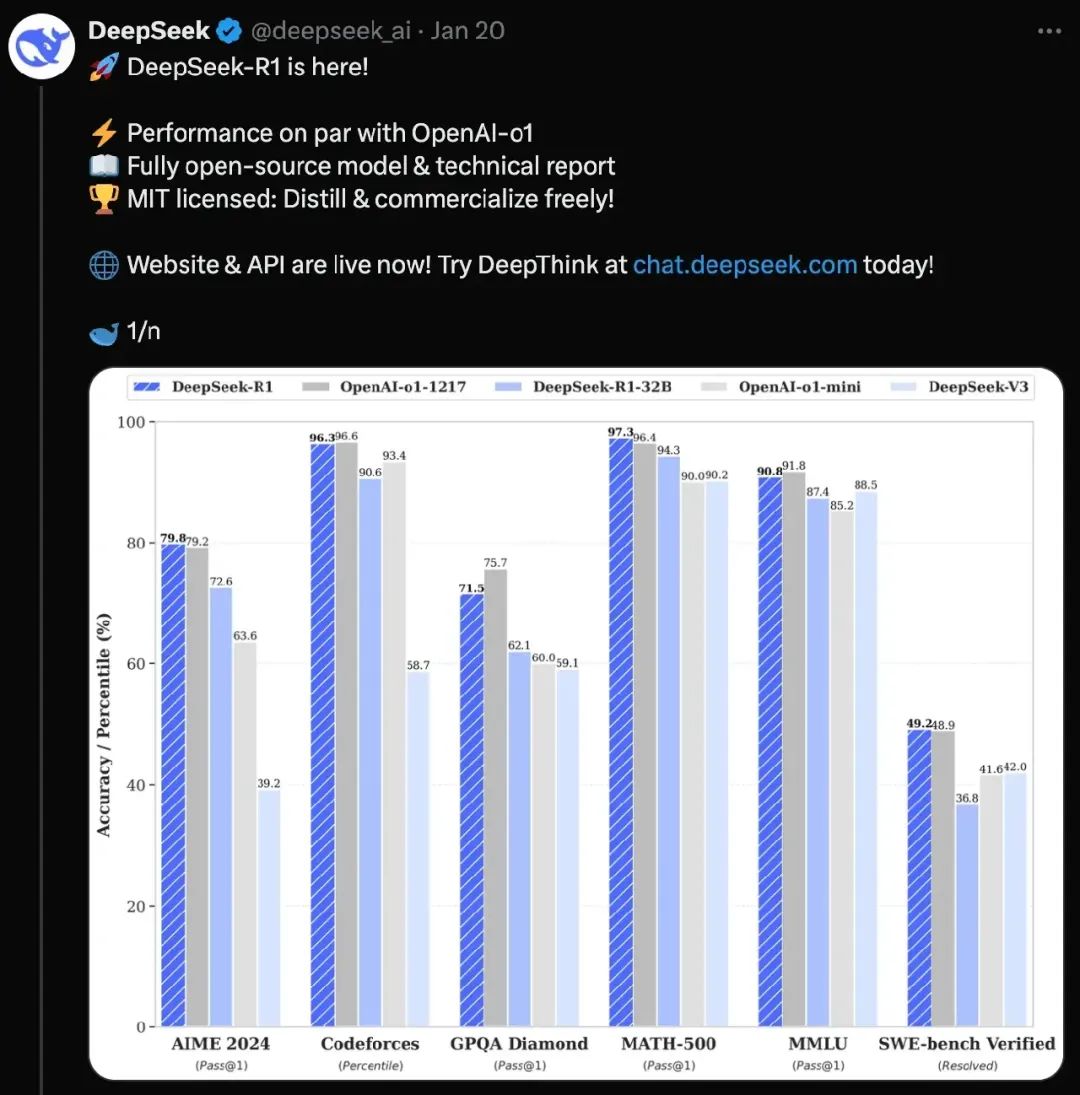

就性能指標而言,

“DeepSeek” 無疑是一個戲劇性的入口,引發(fā)了一場關于人工智能未來的全球對話。它的創(chuàng)新方法和令人印象深刻的能力既令人興奮又令人關切,突出了技術進步與地緣政治考慮之間復雜的相互作用。

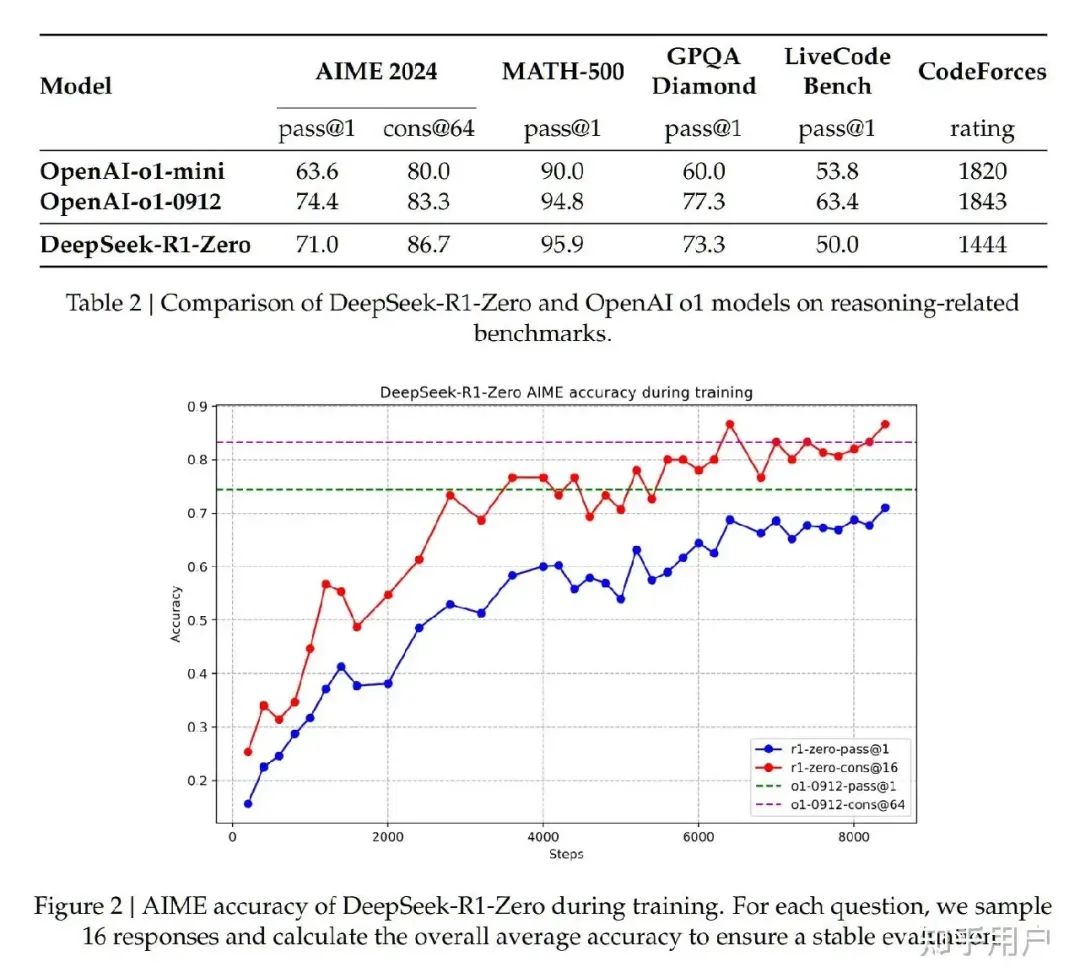

DeepSeek 的各模型對比:V3,R1 和R1-Zero

DeepSeek R1 專為高級推理任務設計,利用強化學習技術提高其性能,在復雜的推理任務中脫穎而出。這個模型在需要邏輯推理和問題解決的場景中特別有效。

圖片

圖片

相比之下,DeepSeek V3 是為自然語言處理任務的多功能性而構建的,側重于使用混合專家體系結構的可伸縮自然語言處理,使其能夠有效地處理各種應用程序。考慮一個場景,其中 DeepSeek-V3 的任務是根據用戶提示詞生成文本。該模型對輸入進行評估,僅激活與提示的具體上下文最相關的專家,從而優(yōu)化其處理能力。例如,如果提示此與技術編碼有關,那么專門研究編程語言的專家將被激活,而其他專家子系統(tǒng)將保持休眠狀態(tài),從而節(jié)省計算資源。

圖片

圖片

最后,DeepSeek R1-Zero 代表了一種創(chuàng)新的方法,它只通過強化學習進行培訓,而不需要事先監(jiān)督微調。這個模型已經顯示出有前途的推理能力,但可能需要與可讀性和連貫性做斗爭。

圖片

圖片

雖然它只保留了在推理過程中激活 370 億個參數的效率,但它強調了在不同任務之間的泛化,而不需要大量的微調或特定于任務的訓練數據。在推理和數學相關任務方面,DeepSeek r 1 始終優(yōu)于 DeepSeek r 1-zero,更適合需要精確計算和邏輯推理的應用。

回到本文開始提出的問題,那么DeepSeek 模型訓練真正的成本是什么?使用了多少GPU呢?

成本的計算分析

根據可用數據,我們可以計算分析,得到可能的結果。

首先,我們假設使用了50000個GPU,訓練了60天相當于1440個小時,則總的訓練時長=50000 X 1440 = 72000000 GPU小時。

再假設每個GPU小時的成本=3美元,那么訓練成本= 72000000 X 3 = 246000000 美元。一般地,其他附加成本約占訓練成本的10~20%,我們假設附加成本約占訓練成本的15%,則訓練的總成本為 246000000 x 115% = 248400000 美元,與傳說中的2.48億美元吻合。

我們知道如何訓練的總成本=總的GPU小時 x 單個GPU小時的成本,則總的GPU小時 =訓練的總成本/ 單個GPU小時的成本,如果訓練的總成本是500萬美元,單個GPU小時的成本的成本是3美元的話,則總的GPU小時= 5000000/3=1666667 GPU小時。

既然知道了訓練的總GPU小時數,就可以估算總的訓練時長了。

已知總的GPU小時 = GPU個數 X 小時為單位的訓練時長,則 小時為單位的訓練時長= 總的GPU小時 /GPU個數,如果使用了50000個GPU的話,所以總的訓練時長= 1666667 /50000 = 33.33 小時,約為1.39天。

如果使用了2000個GPU的話, 總的訓練時長= 1666667 /2000 = 833.33 小時,約為34.72天。

因此, 500 萬美元可能更貼近于真實,這只是訓練成本,即~35天內 2000 個 NVIDIA H800 GPU。2.48 億美元的估計則是基于 50000 個 GPU 60 天的訓練,這種設置可能只是一種謠傳。DeepSeek 擁有它們,但該項目只使用了 2000 個 GPU,實現了智能優(yōu)化 。

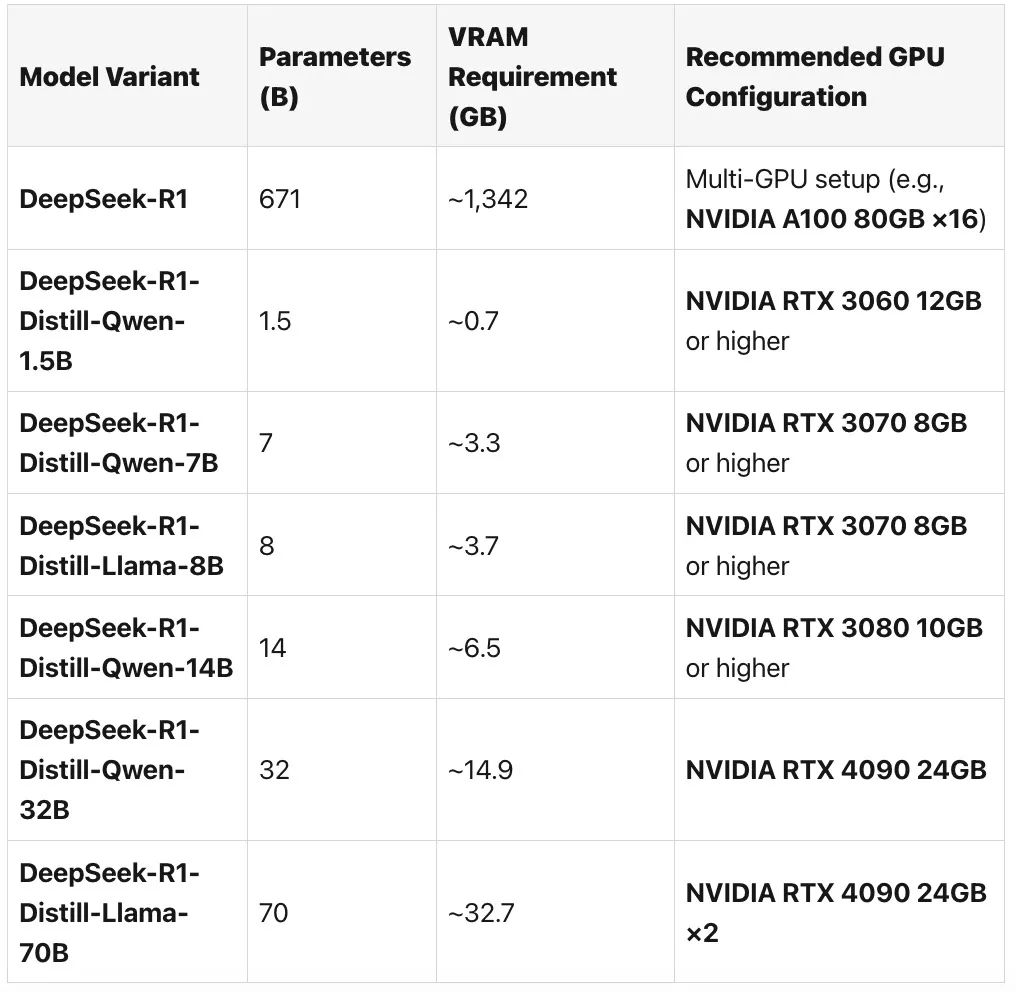

以DeepSeek R1 為例, 有人推薦了如下的GPU配置:

圖片

圖片

一旦經過了訓練,DeepSeek 大模型推理階段的硬件需求明顯降低,即使在功能較差的 GPU 上部署也是可行的。

- 更少的 GPU 需求:推理可以在像 NVIDIA RTX 4090 (24 GB VRAM) 或企業(yè)級 A100 這樣的 GPU 上執(zhí)行,而不是大規(guī)模集群。

- 更低的 VRAM 使用:使用 4 位和 8 位量化,DeepSeek 降低了高達 75% 的 VRAM 消耗,允許高效的模型服務。

- 能源節(jié)省:相比于訓練推理的能源消耗降低了超過 50% 能源消耗。

- 實時處理:優(yōu)化的執(zhí)行管道允許低延遲推斷,這對于聊天機器人和自動化等 AI 驅動的應用程序至關重要。

問題是:“DeepSeek” 是一個轉瞬即逝的現象,還是一股將重塑人工智能世界的力量呢?

一句話小結

DeepSeek 的 GPU 需求突出了有效的人工智能基礎設施規(guī)劃的必要性。通過使用智能工作負載分配、量化和動態(tài) GPU 分配,業(yè)務可以顯著降低計算成本,同時保持高性能。DeepSeek R1 顯示了大模型領域上的創(chuàng)新,一些的復現版本也證明了這一點。

ps. 需要注意的是,那些“精簡版”的R1 版本并不是模型的全部。完整模型為 671B 參數,每個實例需要 ~16 個 80GB GPU。而且,托管版本可能會使用用戶的數據進行訓練,所以在上傳敏感內容之前請仔細檢查。