踹了OpenAI后,Figure光速發布具身大模型Helix,能力前所未有、創多項第一

在 2 月份突然宣布終結與 OpenAI 合作之后,知名機器人初創公司 Figure AI 在本周四晚公開了背后的原因:他們已經造出了自己的通用具身智能模型 Helix。

Helix 是一個通用的視覺 - 語言 - 動作(VLA)模型,它統一了感知、語言理解和學習控制,以克服機器人技術中的多個長期挑戰。

Helix 創造了多項第一:

- 全身控制:它是歷史上第一個類人機器人上半身的高速連續控制 VLA 模型,覆蓋手腕、軀干、頭部和單個手指;

- 多機器人協作:可以兩臺機器人用一個模型控制協作,完成前所未見的任務;

- 抓取任何物品:可以撿起任何小型物體,包括數千種它們從未遇到過的物品,只需遵循自然語言指令即可;

- 單一神經網絡:Helix 使用一組神經網絡權重來學習所有行為 —— 抓取和放置物品、使用抽屜和冰箱、以及跨機器人交互 —— 無需任何任務特定的微調;

- 本地化:Helix 是史上第一個在本地 GPU 運行的機器人 VLA 模型,已經具備了商業化落地能力。

在智能駕駛領域,今年各家車廠都在推進端到端技術的大規模落地,如今 VLA 驅動的機器人也已進入了商業化的倒計時,如此看來 Helix 可謂是具身智能的一次重大突破。

一、人形機器人技術的新擴展

Figure 表示,家庭環境是機器人技術面臨的最大挑戰。與受控的工業環境不同,家庭中充滿了無數非規則物體,如易碎的玻璃器皿、皺巴巴的衣物、散落的玩具,每件物品的形狀、大小、顏色和質地都難以預測。為了讓機器人在家庭中發揮作用,它們需要能夠按需生成智能的新行為。

當前的機器人技術無法擴展到家庭環境中 —— 目前,即使教機器人一個單一的新行為,也需要大量的人力投入。要么需要數小時的博士級專家手動編程,要么需要數千次的演示,這兩種方法的成本都高得令人望而卻步。

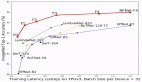

圖 1:不同方法獲取新機器人技能的擴展曲線。在傳統的啟發式操作中,技能的增長依賴于專家手動編寫腳本。在傳統機器人模仿學習中,技能的擴展依賴于收集的數據。而通過 Helix,新技能可以通過語言即時指定。

當前,人工智能的其他領域已經掌握了這種即時泛化的能力。如果能簡單地將視覺 - 語言模型(VLM)中捕獲的豐富語義知識直接轉化為機器人動作,或許會實現技術突破。

這種新能力將從根本上改變機器人技術的擴展軌跡(圖 1)。于是,關鍵問題變成了:如何從 VLM 中提取所有這些常識性知識,并將其轉化為可泛化的機器人控制?Figure 構建了 Helix 來彌合這一差距。

二、Helix:首個機器人系統 1 + 系統 2 VLA 模型

Helix 是機器人領域上首創的「系統 1 + 系統 2」VLA 模型,用于高速、靈巧地控制整個人形機器人上半身。

Figure 表示,先前的方法面臨一個根本性的權衡:VLM 主干是通用的,但速度不快,而機器人視覺運動策略是快速的,但不夠通用。Helix 通過兩個互補的系統解決了這一權衡,這兩個系統經過端到端的訓練,可以進行通信:

- 系統 1 (S1):一種快速反應的視覺運動策略,可將 S2 產生的潛在語義表征轉換為 200 Hz 的精確連續機器人動作;

- 系統 2 (S2):一個機載互聯網預訓練的 VLM,以 7-9 Hz 運行,用于場景理解和語言理解,實現跨物體和上下文的廣泛泛化。

這種解耦架構允許每個系統在其最佳時間尺度上運行。S2 可以「慢慢思考」高層次目標,而 S1 可以「快速思考」機器人實時執行和調整的動作。例如,在協作行為中(見下圖),S1 可以快速適應伙伴機器人不斷變化的動作,同時保持 S2 的語義目標。

Helix 能讓機器人快速進行精細的運動調整,這是在執行新語義目標時對協作伙伴做出反應所必需的。

Helix 的設計相較于現有方法具有以下幾個關鍵優勢:

- 速度與泛化能力:Helix 在速度上與專門用于單一任務的行為克隆策略相當,同時能夠零樣本泛化到數千種新測試對象上;

- 可擴展性:Helix 直接輸出高維動作空間的連續控制,避免了之前 VLA 方法中使用的復雜動作標記化方案。這些方案在低維控制設置(例如二值化平行夾爪)中取得了一些成功,但在高維人形控制中面臨擴展挑戰;

- 架構簡潔性:Helix 使用標準架構 —— 一個開源的、開放權重的 VLM 用于系統 2,以及一個簡單的基于 Transformer 的視覺運動策略用于系統 1;

- 關注點分離:將 S1 和 S2 解耦使我們能夠分別迭代每個系統,而無需受限于尋找統一的觀察空間或動作表示。

Figure 介紹了部分模型及訓練細節,其收集了一個高質量、多機器人、多操作員的多樣化遙操作行為數據集,總計約 500 小時。為了生成自然語言條件下的訓練對,工程人員使用了一個自動標注的視覺語言模型(VLM)來生成事后指令。

該 VLM 會處理來自機器人機載攝像頭的分段視頻片段,并提示:「你會給機器人什么指令以使其執行視頻中看到的動作?」訓練期間處理的所有物品在評估中被排除,以防止數據污染。

三、模型架構

Helix 系統主要由兩個主要組件組成:S2,一個 VLM 骨干網絡;S1,一個潛在條件視覺運動 Transformer。

S2 基于一個 70 億參數的開源、開放權重的 VLM 構建,該 VLM 在互聯網規模數據上進行了預訓練。它處理單目機器人圖像和機器人狀態信息(包括手腕姿態和手指位置),并將它們投影到視覺語言嵌入空間中。結合指定期望行為的自然語言指令,S2 將所有語義任務相關信息提煉為一個連續的潛在向量,傳遞給 S1 以調節其低級動作。

S1 是一個 8000 萬參數的交叉注意力編碼器 - 解碼器 Transformer,負責低級控制。它依賴于一個完全卷積的多尺度視覺骨干網絡進行視覺處理,該網絡完全在模擬環境中進行預訓練初始化。雖然 S1 接收與 S2 相同的圖像和狀態輸入,但它以更高的頻率處理這些輸入,以實現更靈敏的閉環控制。來自 S2 的潛在向量被投影到 S1 的標記空間中,并與 S1 視覺骨干網絡提取的視覺特征沿序列維度連接,提供任務條件。

在工作時,S1 以 200 赫茲的頻率輸出完整的上半身人形控制,包括期望的手腕姿態、手指屈曲和外展控制,以及軀干和頭部方向目標。Figure 在動作空間中附加了一個合成的「任務完成百分比」動作,使 Helix 能夠預測自身的終止條件,從而更容易對多個學習到的行為進行排序。

1. 訓練

Helix 的訓練是完全端到端的:從原始像素和文本命令映射到具有標準回歸損失的連續動作。

梯度的反向傳播路徑是通過用于調節 S1 行為的隱通信向量從 S1 到 S2,從而允許對這兩個組件進行聯合優化。

Helix 不需要針對具體某某任務進行調整;它只需維持單個訓練階段和一組神經網絡權重,無需單獨的動作頭或針對每個任務的微調階段。

在訓練期間,他們還會在 S1 和 S2 輸入之間添加一個時間偏移量。此偏移量經過校準以匹配 S1 和 S2 部署的推理延遲之間的差距,確保部署期間的實時控制要求準確反映在訓練中。

2. 經過優化的流式推理

Helix 的訓練設計可實現在 Figure 機器人上高效地并行部署模型,每臺機器人都配備了雙低功耗嵌入式 GPU。推理管道分為 S2(高級隱規劃)和 S1(低級控制)模型,每個模型都在專用 GPU 上運行。

S2 作為異步后臺進程運行,用于處理最新的觀察結果(機載攝像頭和機器人狀態)和自然語言命令。它不斷更新編碼高級行為意圖的共享內存隱向量。

S1 作為單獨的實時進程執行,其目標是維持讓整個上身動作平滑執行所需的關鍵 200Hz 控制回路。它的輸入是最新的觀察結果和最新的 S2 隱向量。由于 S2 和 S1 推理之間存在固有的速度差異,因此 S1 自然會在機器人觀察上以更高的時間分辨率運行,從而為反應控制創建更緊密的反饋回路。

這種部署策略有意反映了訓練中引入的時間偏移量,從而可最大限度地減少訓練推理分布差距。這種異步執行模型允許兩個進程以各自最佳頻率運行,使 Helix 的運行速度能與最快的單任務模仿學習策略一樣快。

有趣的是,在 Figure 發布 Helix 之后,清華大學博士生 Yanjiang Guo 表示其技術思路與他們的一篇 CoRL 2024 論文頗為相似,感興趣的讀者也可參照閱讀。

論文地址:https://arxiv.org/abs/2410.05273

四、結果

1. 細粒度 VLA 全上身控制

Helix 能以 200Hz 的頻率協調 35 自由度的動作空間,控制從單個手指運動到末端執行器軌跡、頭部注視和軀干姿勢等一切。

頭部和軀干控制具有獨特的挑戰 —— 當頭部和軀干移動時,會改變機器人可以觸及的范圍和可以看到的范圍,從而產生反饋回路,過去這種反饋回路會導致不穩定。

視頻 3 演示了這種協調的實際操作:機器人用頭部平穩地跟蹤雙手,同時調整軀干以獲得最佳觸及范圍,同時保持精確的手指控制以進行抓握。在此之前,在如此高維的動作空間中實現這種精度水平是很難的,即使對于單個且已知的任務也是如此。Figure 公司表示,之前還沒有 VLA 系統能夠表現出這種程度的實時協調,同時保持跨任務和物體泛化的能力。

Helix 的 VLA 能控制整個人形機器人上半身,這是機器人學習領域首個做到一點的模型。

2. 零樣本多機器人協同

Figure 表示,他們在一個高難度多智能體操作場景中將 Helix 推向極限:兩臺 Figure 機器人協作實現零樣本雜貨存放。

視頻 1 展示了兩個基本進步:兩臺機器人成功地操作了全新的貨物(訓練期間從未遇到過的物品),展示了對各種形狀、大小和材料的穩健泛化。

此外,兩個機器人都使用相同的 Helix 模型權重進行操作,無需進行特定于具體機器人的訓練或明確的角色分配。它們的協同是通過自然語言提示詞實現的,例如「將一袋餅干遞給你右邊的機器人」或「從你左邊的機器人那里接過一袋餅干并將其放在打開的抽屜里」(參見視頻 4)。這是首次使用 VLA 展示多臺機器人之間靈活、擴展的協作操作。考慮到它們成功處理了全新的物體,這項成就就顯得尤其顯著了。

Helix 實現精確的多機器人協同

3. 涌現出「拿起任何東西」能力

只需一個「拿起 [X]」指令,配備了 Helix 的 Figure 機器人基本就能拿起任何小型家用物品。在系統性測試中,無需任何事先演示或自定義編程,機器人就成功地處理了雜亂擺放的數千件新物品 —— 從玻璃器皿和玩具到工具和衣服。

特別值得注意的是,Helix 可以建立互聯網規模的語言理解和精確的機器人控制之間的聯系。例如,當被提示「拿起沙漠物品」時,Helix 不僅能確定出玩具仙人掌與這個抽象概念相匹配,還能選擇最近的手并能通過精確運動命令安全地抓起它。

Figure 公司表示:「對于在非結構化環境中部署人形機器人,這種通用的『語言到動作』抓取能力開辟了令人興奮的新可能。」

Helix 可將「拿起 [X]」等高層面指令轉譯成低層動作

五、討論

1. Helix 的訓練效率很高

Helix 以極少的資源實現了強大的物體泛化。Figure 公司表示:「我們總共使用了約 500 小時的高質量監督數據來訓練 Helix,這僅僅是之前收集的 VLA 數據集的一小部分(<5%),并且不依賴多機器人具身收集或多個訓練階段。」他們注意到,這種收集規模更接近現代單任務模仿學習數據集。盡管數據要求相對較小,但 Helix 可以擴展到更具挑戰性的動作空間,即完整的上身人形控制,具有高速率、高維度的輸出。

2. 單一權重集

現有的 VLA 系統通常需要專門的微調或專用的動作頭來優化執行不同高級行為的性能。值得注意的是,Helix 僅使用一組神經網絡權重(系統 2 為 7B、系統 1 為 80M),就可以完成在各種容器中拾取和放置物品、操作抽屜和冰箱、協調靈巧的多機器人交接以及操縱數千個新物體等動作。

「拿起 Helix」(Helix 意為螺旋)

六、總結

Helix 是首個通過自然語言直接控制整個人形機器人上半身的「視覺 - 語言 - 動作」模型。與早期的機器人系統不同,Helix 能夠即時生成長視界、協作、靈巧的操作,而無需任何特定于任務的演示或大量的手動編程。

Helix 表現出了強大的對象泛化能力,能夠拿起數千種形狀、大小、顏色和材料特性各異的新奇家居用品,并且這些物品在訓練中從未遇到過,只需用自然語言命令即可。該公司表示:「這代表了 Figure 在擴展人形機器人行為方面邁出了變革性的一步 —— 我們相信,隨著我們的機器人越來越多地協助日常家庭環境,這一步將至關重要。」

雖然這些早期結果確實令人興奮,但總體來說,我們上面看到的還都屬于概念驗證,只是展示了可能性。真正的變革將發生在能大規模實際部署 Helix 的時候。期待那一天早些到來!

最后順帶一提,Figure 的發布可能只是今年具身智能眾多突破的一小步。今天凌晨,1X 機器人也官宣即將推出新品。

參考內容:

- https://www.figure.ai/news/helix

- https://techcrunch.com/2025/02/20/figures-humanoid-robot-takes-voice-orders-to-help-around-the-house/

- https://x.com/op7418/status/1892612512547213312

- https://x.com/ericjang11/status/1892665299704422667

- https://news.ycombinator.com/item?id=43115079