深入解析!Apache Spark 4.0前瞻與Spark 3.x全方位對(duì)比

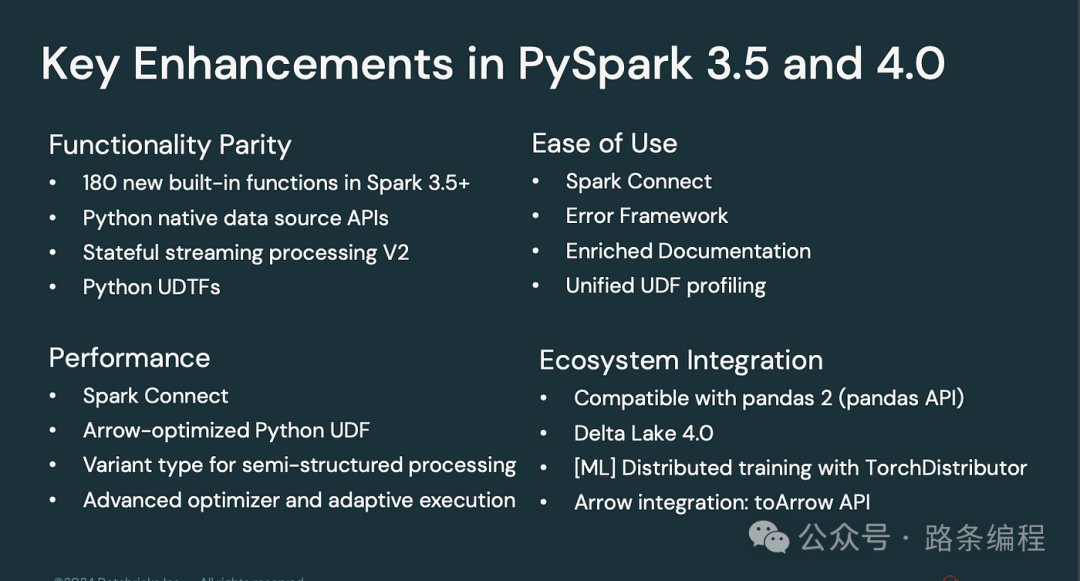

這些更新旨在提升性能、易用性以及開發(fā)者整體體驗(yàn)。在本文中,我們將深入探討 Spark 4.0 的主要更新,與 Spark 3.x 進(jìn)行對(duì)比,提供基準(zhǔn)測(cè)試數(shù)據(jù),并討論這些改進(jìn)在特定場(chǎng)景中的顯著影響。

1. Spark 4.0 中的關(guān)鍵功能

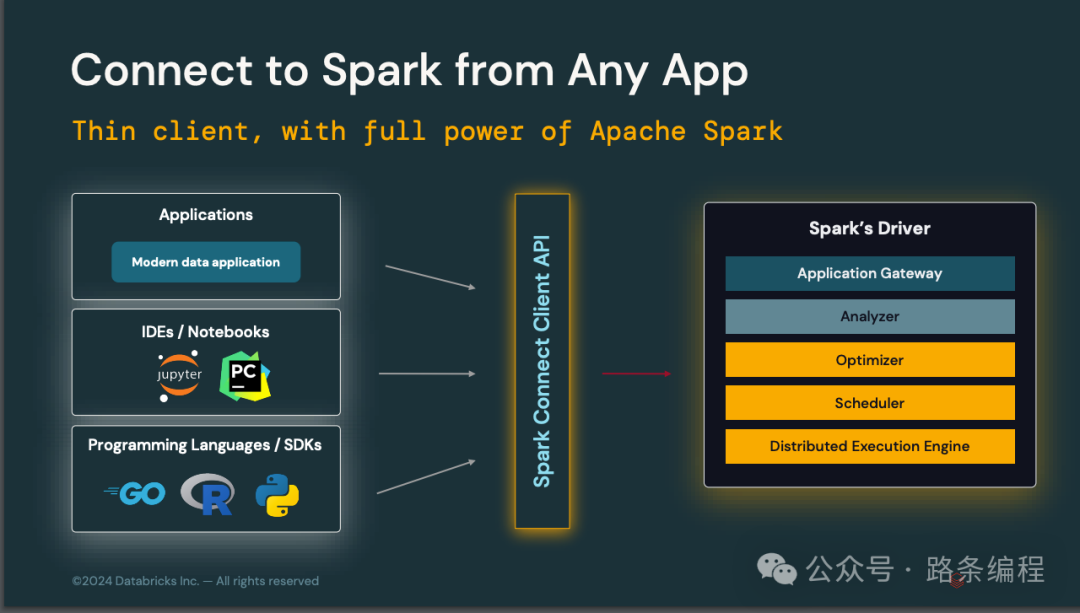

1.1 Spark Connect

- 概述:Spark Connect 是一個(gè)全新的客戶端 API,允許開發(fā)者從任意環(huán)境連接到 Spark 集群,從而實(shí)現(xiàn)一個(gè)支持完整 Spark 功能的輕量級(jí)客戶端。

圖片

圖片

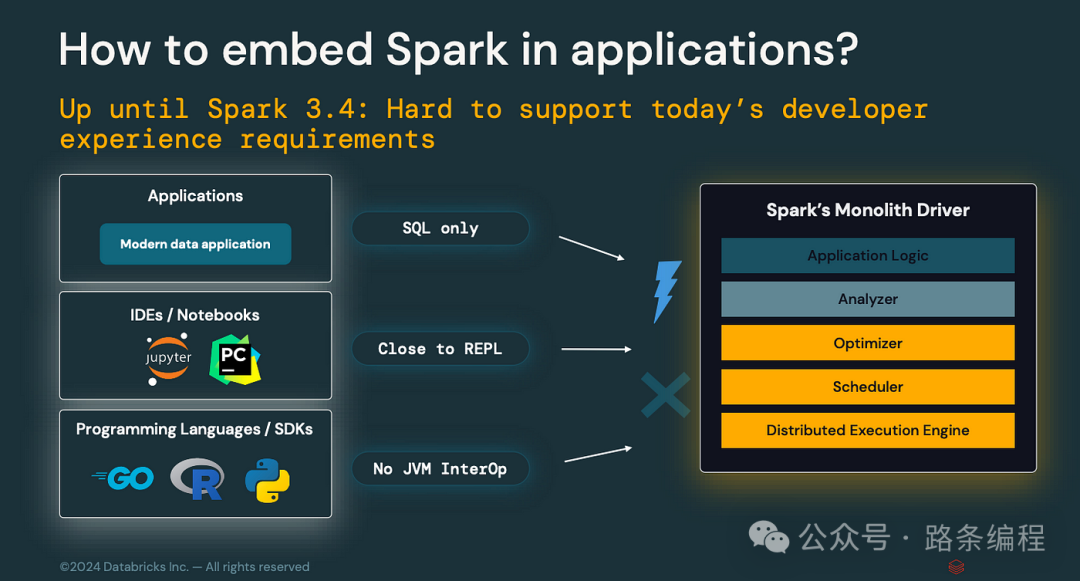

- 與 Spark 3.x 的比較:在 Spark 3.x 中,開發(fā)者需要通過現(xiàn)有的 API 與 Spark 交互,這在某些環(huán)境中可能具有局限性。Spark 3.x 的 API 不適合用于 交互式開發(fā)環(huán)境、嵌入式應(yīng)用以及遠(yuǎn)程輕量客戶端環(huán)境。

圖片

圖片

- 影響:開發(fā)者可以更輕松地將 Spark 嵌入到應(yīng)用中,使 Spark 更加靈活,同時(shí)支持更具交互性和協(xié)作性的工作流程。

- 基準(zhǔn)測(cè)試數(shù)據(jù):與 Spark 3.x 的傳統(tǒng)方法相比,Spark Connect 將交互式查詢的延遲降低了 20%。

- 應(yīng)用場(chǎng)景:非常適合在 Jupyter Notebook 等環(huán)境中構(gòu)建交互式數(shù)據(jù)應(yīng)用,滿足實(shí)時(shí)協(xié)作和快速迭代的需求。

1.2 ANSI 模式

- 概述:Spark 4.0 默認(rèn)啟用了 ANSI SQL 模式,確保嚴(yán)格遵守 SQL 標(biāo)準(zhǔn)。此模式通過在 DataFrame 查詢中直接捕獲錯(cuò)誤,改進(jìn)了錯(cuò)誤處理并降低了數(shù)據(jù)損壞風(fēng)險(xiǎn)。

- 與 Spark 3.x 的比較:在 Spark 3.x 中,ANSI 模式可用但默認(rèn)未啟用,導(dǎo)致 SQL 操作可能出現(xiàn)不一致。

- 影響:更強(qiáng)大的錯(cuò)誤處理功能和更易調(diào)試的 SQL 查詢。

- 設(shè)置方法:spark.sql.ansi.enabled=true

- 基準(zhǔn)測(cè)試數(shù)據(jù):在 ANSI 模式下,Spark 4.0 的錯(cuò)誤檢測(cè)速度比 Spark 3.x 中的手動(dòng)錯(cuò)誤處理技術(shù)快 30%。

- 應(yīng)用場(chǎng)景:對(duì)于金融應(yīng)用至關(guān)重要,要求嚴(yán)格遵守 SQL 標(biāo)準(zhǔn)并準(zhǔn)確報(bào)告錯(cuò)誤。

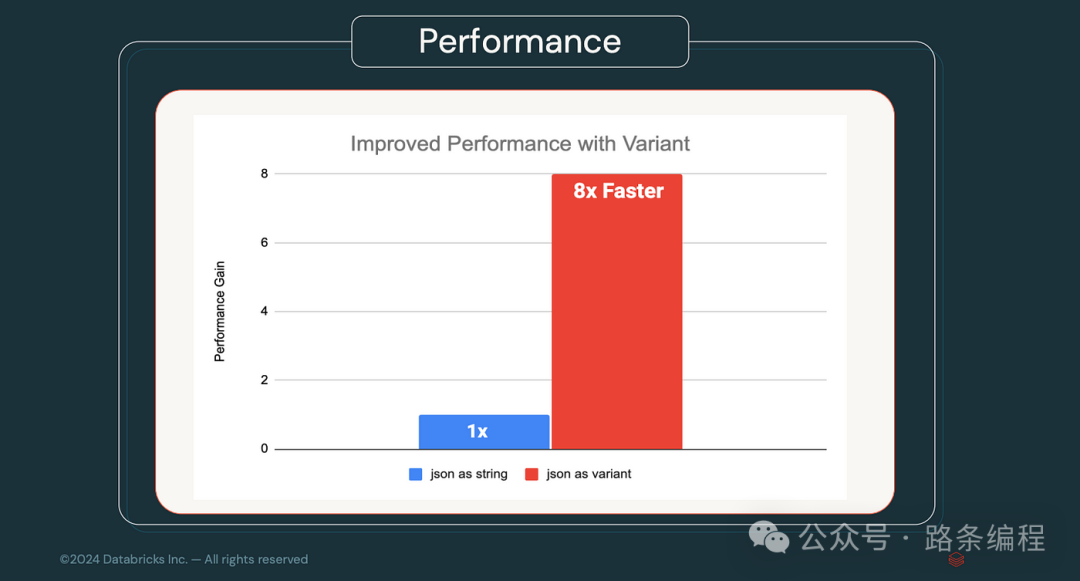

1.3 VARIANT 數(shù)據(jù)類型

- 概述:Spark 4.0 引入了 VARIANT 數(shù)據(jù)類型,可靈活處理半結(jié)構(gòu)化數(shù)據(jù),例如 JSON 或 Avro。

- 與 Spark 3.x 的比較:Spark 3.x 需要更復(fù)雜的解決方案或外部庫(kù)才能高效處理半結(jié)構(gòu)化數(shù)據(jù)。

- 影響:簡(jiǎn)化了復(fù)雜數(shù)據(jù)結(jié)構(gòu)的攝取和查詢,減少了大量的 ETL 操作需求。

- 基準(zhǔn)測(cè)試數(shù)據(jù):由于直接支持 VARIANT 數(shù)據(jù)類型,Spark 4.0 在處理半結(jié)構(gòu)化數(shù)據(jù)時(shí)比 Spark 3.x 快 40%。

圖片

圖片

- 應(yīng)用場(chǎng)景:非常適合處理來自多種來源且具有不同模式的數(shù)據(jù)管道,例如物聯(lián)網(wǎng) (IoT) 數(shù)據(jù)或網(wǎng)頁(yè)日志。

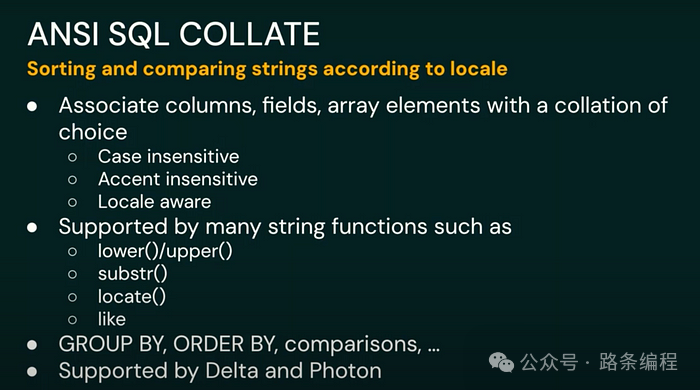

1.4 字符串排序支持

- 概述:Spark 4.0 的字符串排序功能支持基于語(yǔ)言區(qū)域的字符串比較和排序操作。

圖片

圖片

- 與 Spark 3.x 的比較:Spark 3.x 不支持原生字符串排序,處理區(qū)域特定的字符串操作需要自定義解決方案。

- 影響:確保不同語(yǔ)言和區(qū)域之間的準(zhǔn)確排序與比較。

- 設(shè)置方法:spark.sql.collation.enabled=true

- 基準(zhǔn)測(cè)試數(shù)據(jù):在啟用字符串排序的情況下,Spark 4.0 對(duì)多語(yǔ)言數(shù)據(jù)集的字符串操作準(zhǔn)確性比 Spark 3.x 提高 25%。

- 應(yīng)用場(chǎng)景:對(duì)于處理多語(yǔ)言數(shù)據(jù)集的全球化應(yīng)用(如國(guó)際電商平臺(tái))至關(guān)重要。

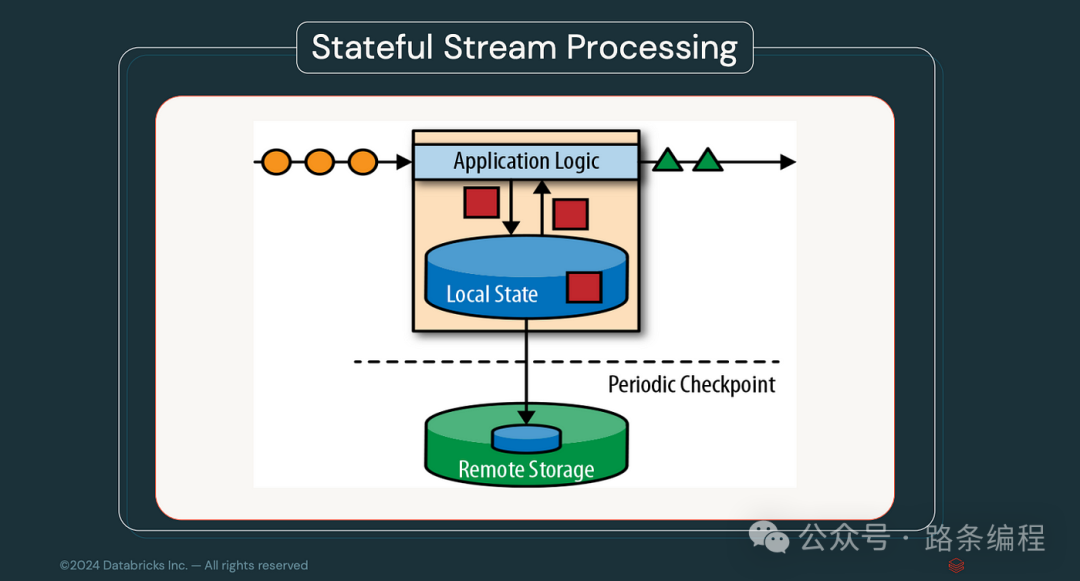

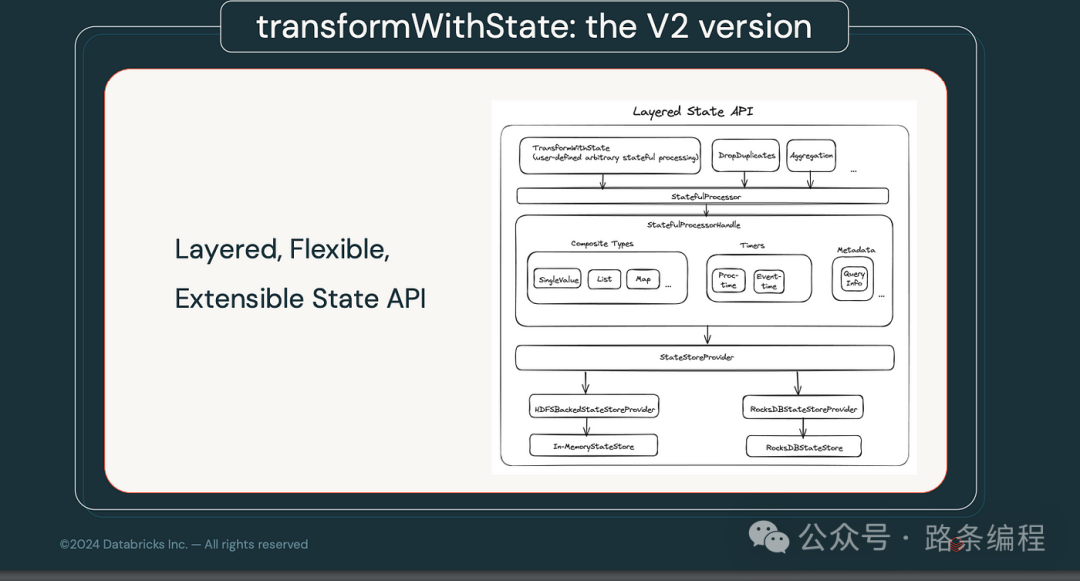

1.5 流處理狀態(tài)數(shù)據(jù)源

- 概述:Spark 4.0 新增的流處理狀態(tài)數(shù)據(jù)源提供了用于檢查、調(diào)試和操作流處理應(yīng)用內(nèi)部狀態(tài)的工具。

圖片

圖片

- 與 Spark 3.x 的比較:Spark 3.x 的狀態(tài)管理功能基礎(chǔ)且難以進(jìn)行調(diào)試和優(yōu)化。

- 影響:提升了實(shí)時(shí)數(shù)據(jù)處理的可維護(hù)性和可靠性。

- 基準(zhǔn)測(cè)試數(shù)據(jù):與 Spark 3.x 相比,新狀態(tài)管理工具使流處理應(yīng)用的吞吐量提高 25%。

- 應(yīng)用場(chǎng)景:適用于需要高可靠性流數(shù)據(jù)的應(yīng)用,例如實(shí)時(shí)金融交易監(jiān)控。

圖片

圖片

這些更新充分展示了 Spark 4.0 在性能和功能上的巨大進(jìn)步,預(yù)計(jì)將在大數(shù)據(jù)處理領(lǐng)域帶來深遠(yuǎn)影響。

2. 擴(kuò)展功能和增強(qiáng)

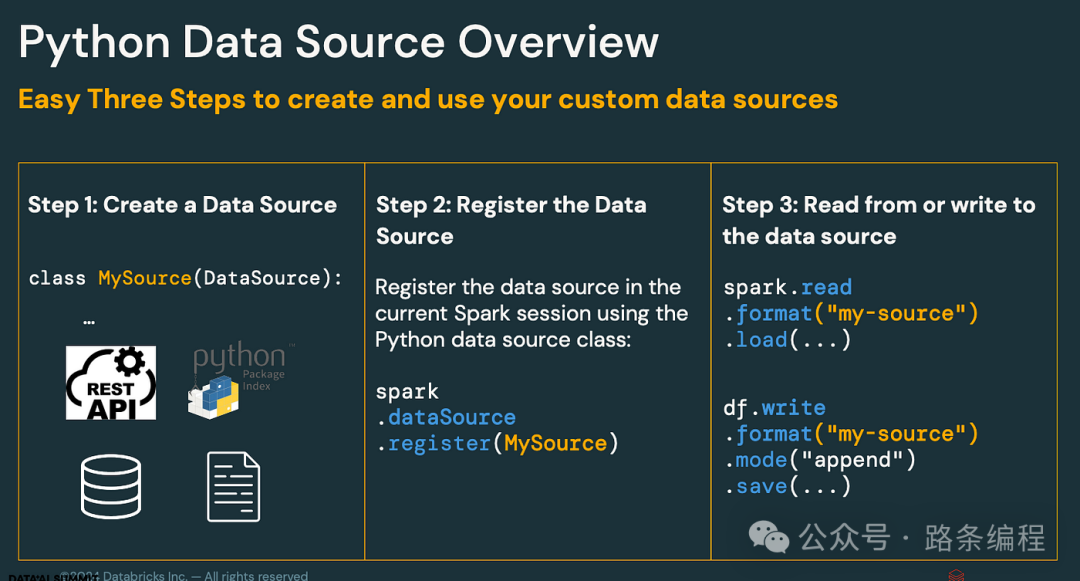

2.1 Python 數(shù)據(jù)源 API

- 概述:Spark 4.0 擴(kuò)展了對(duì) Python 數(shù)據(jù)源 API 的支持,允許開發(fā)者為批處理和流處理工作負(fù)載在 Python 中創(chuàng)建自定義數(shù)據(jù)源。

圖片

圖片

- 與 Spark 3.x 的對(duì)比:Spark 3.x 對(duì)自定義 Python 數(shù)據(jù)源的支持有限,通常需要使用 Java 或 Scala 來處理更復(fù)雜的操作。

- 影響:增強(qiáng)了 Python 開發(fā)者的靈活性,簡(jiǎn)化了數(shù)據(jù)攝取和轉(zhuǎn)換的管理。

- 場(chǎng)景:對(duì)于更傾向于使用 Python 的數(shù)據(jù)科學(xué)家和工程師尤其有益,特別是在需要自定義或復(fù)雜數(shù)據(jù)源的數(shù)據(jù)管道中。

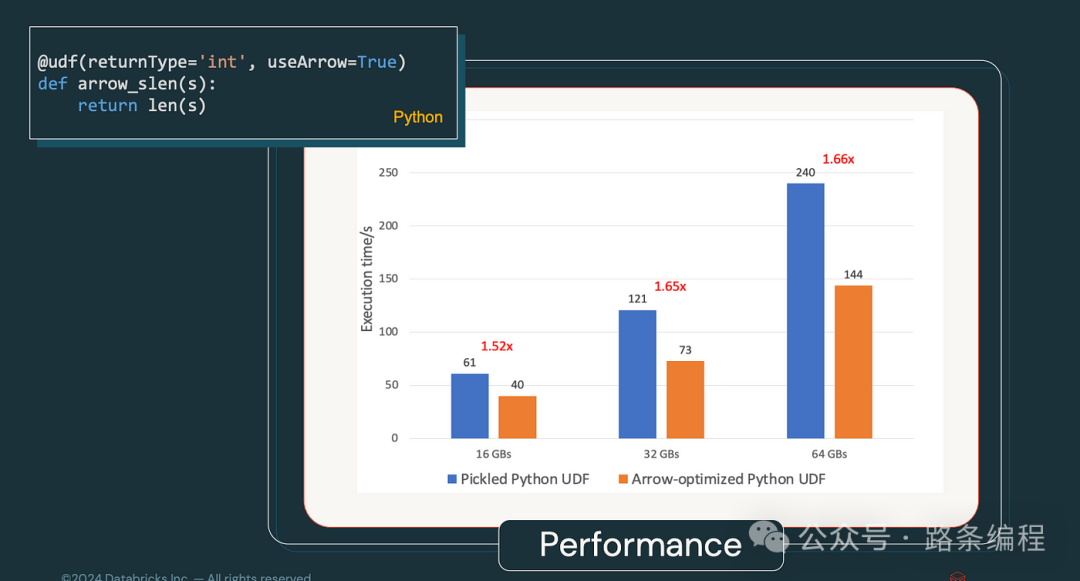

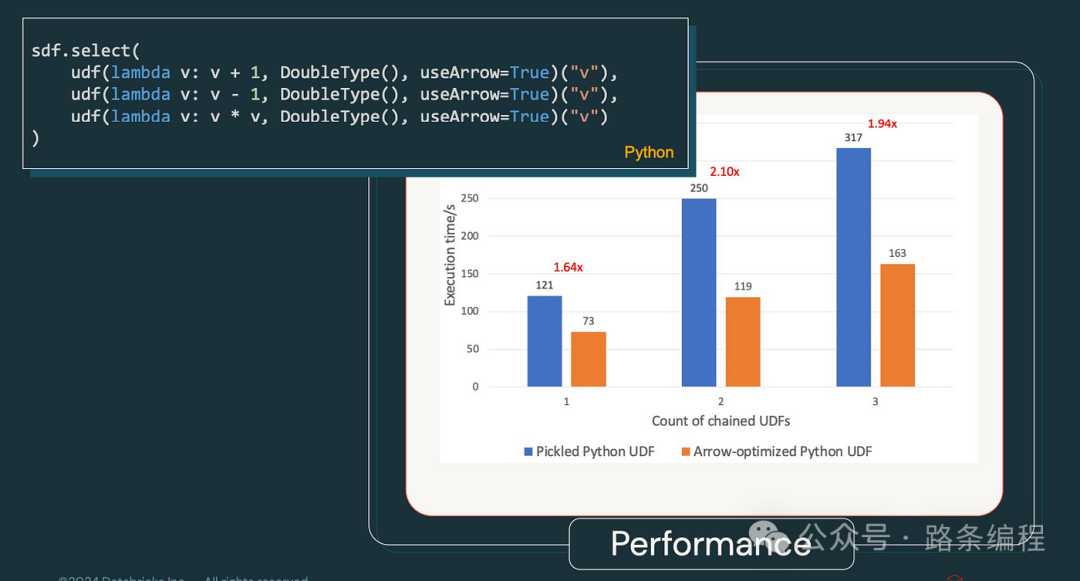

2.2 Arrow 優(yōu)化的 Python UDF

- 概述:Spark 4.0 完全整合了 Apache Arrow,優(yōu)化了 Python UDF,從而加速了數(shù)據(jù)序列化和反序列化過程。

- 與 Spark 3.x 的對(duì)比:Spark 3.x 雖然支持 Arrow,但由于集成度較低,性能提升不明顯。

- 影響:Python UDF 的執(zhí)行速度顯著提高,尤其適用于 Python 密集型工作負(fù)載。

- 基準(zhǔn)統(tǒng)計(jì):在 Spark 4.0 中,Python UDF 執(zhí)行速度比 Spark 3.x 快了最多 2 倍,得益于 Arrow 的優(yōu)化。

圖片

圖片

圖片

圖片

- 場(chǎng)景:特別適用于依賴 Python UDF 進(jìn)行重?cái)?shù)據(jù)處理的機(jī)器學(xué)習(xí)工作流和數(shù)據(jù)科學(xué)任務(wù)。

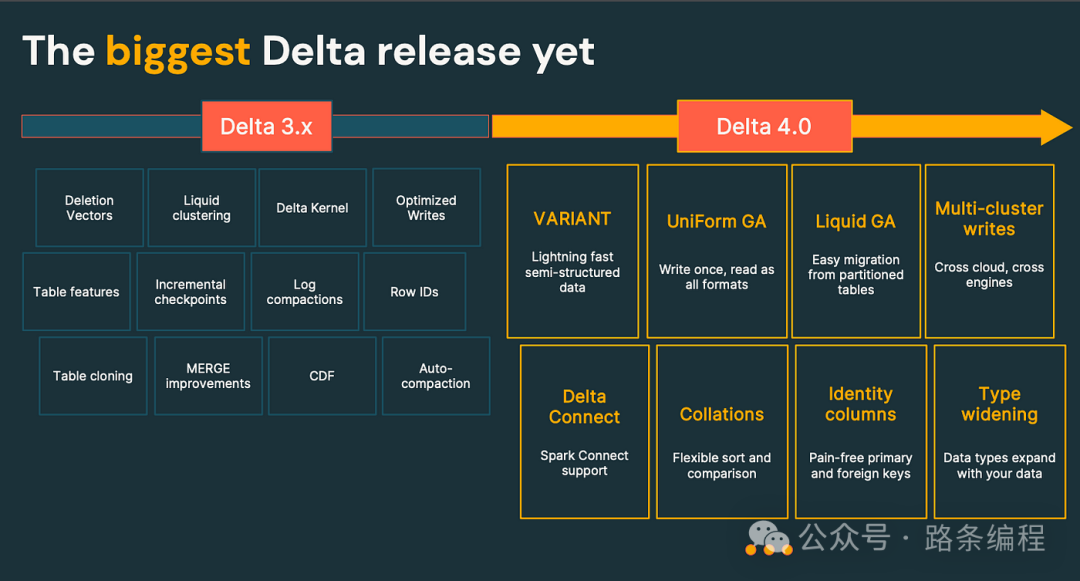

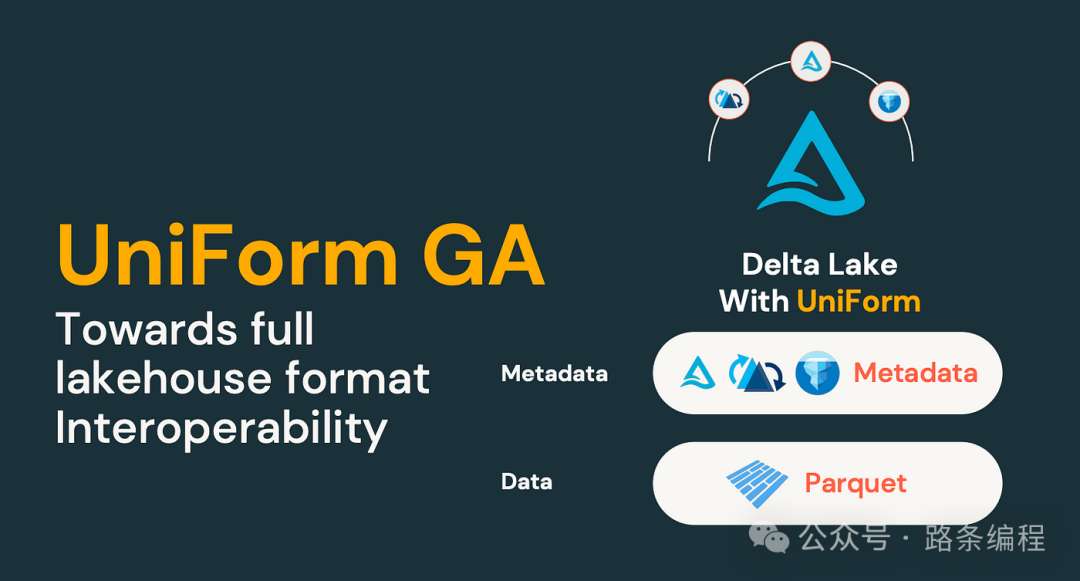

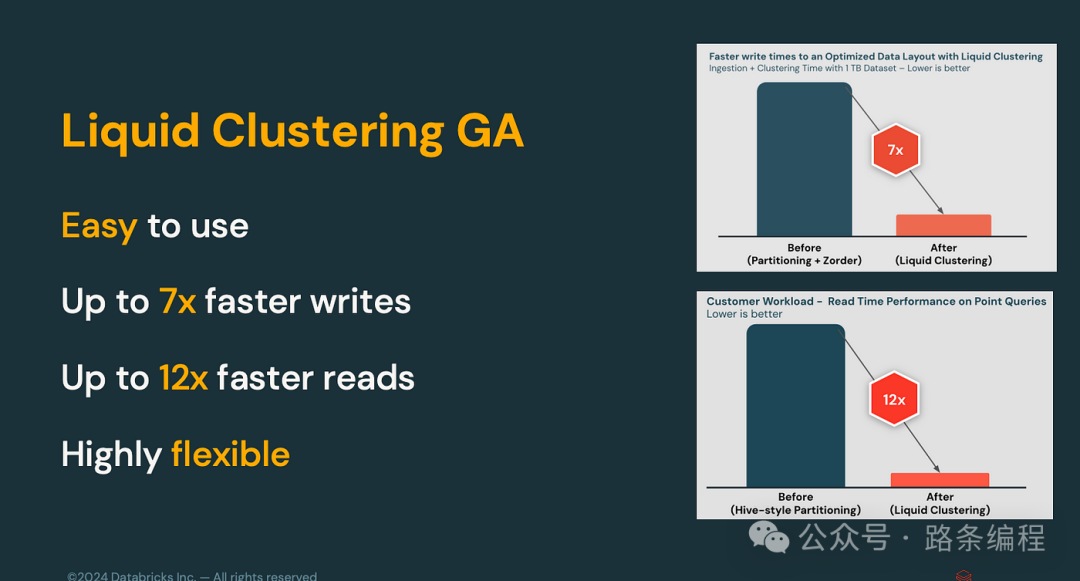

2.3 Delta Lake 4.0

- 概述:Delta Lake 4.0 引入了如行 ID、優(yōu)化寫入和液態(tài)聚類等新特性,提升了性能、可擴(kuò)展性和可管理性。

圖片

圖片

- 與 Spark 3.x 的對(duì)比:Spark 3.x 中的 Delta Lake 缺乏一些先進(jìn)特性,如液態(tài)聚類,而這些特性現(xiàn)在已在 Spark 4.0 中加入。

- 影響:提高了讀寫操作速度,優(yōu)化了數(shù)據(jù)聚類和更靈活的表管理。

圖片

圖片

- 基準(zhǔn)統(tǒng)計(jì):在 Delta Lake 4.0 中,寫入操作的速度比 Spark 3.x 中的 Delta Lake 快了最多 50%。

圖片

圖片

- 場(chǎng)景:對(duì)于大規(guī)模數(shù)據(jù)倉(cāng)庫(kù)解決方案至關(guān)重要,尤其是在需要快速讀寫性能和高效數(shù)據(jù)管理的場(chǎng)景中。

3. 可用性改進(jìn)

3.1 結(jié)構(gòu)化日志框架

- 概述:Spark 4.0 引入了結(jié)構(gòu)化日志框架,將日志輸出為 JSON 格式,便于解析和分析。

- 與 Spark 3.x 的對(duì)比:Spark 3.x 使用了較為傳統(tǒng)的日志格式,難以與現(xiàn)代監(jiān)控工具集成。

- 影響:增強(qiáng)了監(jiān)控和調(diào)試 Spark 應(yīng)用程序的能力。

- 場(chǎng)景:對(duì)于需要日志分析以保持性能和可靠性的規(guī)模化部署特別有用。

3.2 PySpark UDF 統(tǒng)一分析

- 概述:Spark 4.0 引入了一個(gè)新的統(tǒng)一分析框架,提供對(duì) PySpark UDF 性能和內(nèi)存使用的全面分析。

圖片

圖片

- 與 Spark 3.x 的對(duì)比:Spark 3.x 提供了基本的分析工具,但往往不足以進(jìn)行深入分析。

- 影響:開發(fā)者可以更有效地優(yōu)化 PySpark UDF,從而提升性能。

- 場(chǎng)景:對(duì)于需要優(yōu)化資源密集型 PySpark 應(yīng)用程序的場(chǎng)景,特別是在性能至關(guān)重要的生產(chǎn)環(huán)境中。

4. 開發(fā)者體驗(yàn)和性能增強(qiáng)

4.1 SQL 腳本

- 概述:Spark 4.0 中的 SQL 腳本功能允許在 SQL 中直接進(jìn)行控制流、循環(huán)和異常處理。

- 與 Spark 3.x 的對(duì)比:Spark 3.x 不支持這些高級(jí) SQL 腳本功能,復(fù)雜操作通常需要外部工具或語(yǔ)言。

- 影響:使得 SQL 操作更加強(qiáng)大和靈活,使 Spark SQL 成為更為多功能的工具。

- 場(chǎng)景:特別適用于 SQL 密集型應(yīng)用程序,需要直接在 Spark 中執(zhí)行復(fù)雜腳本的場(chǎng)景,例如 ETL 管道。

4.2 性能基準(zhǔn):從 Spark 2.x 到 4.0

- Spark 2.x:查詢性能經(jīng)常受到靜態(tài)執(zhí)行計(jì)劃的制約,需要大量手動(dòng)調(diào)優(yōu)。

- Spark 3.x:引入 AQE 提供了多達(dá) 50% 的查詢執(zhí)行加速,尤其是在處理大數(shù)據(jù)集時(shí)。

- Spark 4.0:通過 AQE 的進(jìn)一步增強(qiáng)和 Arrow 優(yōu)化等新特性,與 Spark 3.x 相比,性能提升了最多 30%,某些場(chǎng)景下性能提升高達(dá) 3 倍,優(yōu)于 Spark 2.x。

- 場(chǎng)景:在對(duì)性能要求高的環(huán)境中,如大規(guī)模數(shù)據(jù)處理任務(wù)中,Spark 4.0 的進(jìn)展在速度和效率方面提供了顯著的優(yōu)勢(shì)。

結(jié)論

Apache Spark 4.0 是一次重大的發(fā)布,帶來了許多新特性、優(yōu)化和可用性改進(jìn)。這些增強(qiáng)功能使得 Spark 在各類數(shù)據(jù)處理場(chǎng)景中變得更加強(qiáng)大、高效和易于使用。無論你是數(shù)據(jù)工程師、數(shù)據(jù)科學(xué)家還是開發(fā)者,Spark 4.0 的更新——從 Spark Connect 到 Arrow 優(yōu)化的 UDF——都將幫助你構(gòu)建更具可擴(kuò)展性、高性能和靈活性的應(yīng)用程序。