英偉達(dá)下場(chǎng),首次優(yōu)化DeepSeek-R1!B200性能狂飆25倍,碾壓H100

當(dāng)FP4的魔法與Blackwell的強(qiáng)大算力相遇,會(huì)碰撞出怎樣的火花?

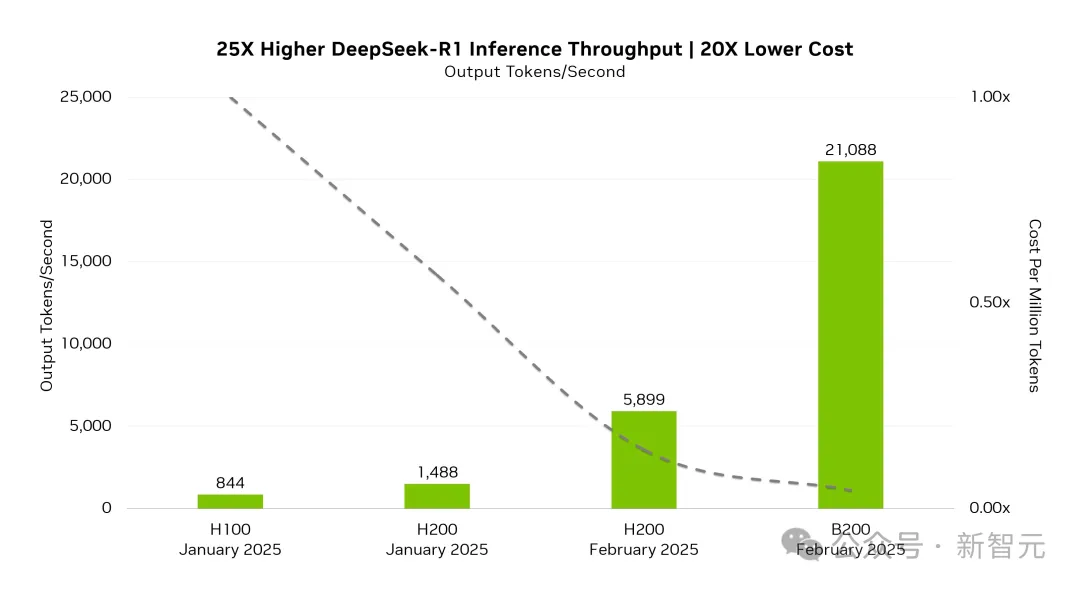

答案是:推理性能暴漲25倍,成本狂降20倍!

隨著DeepSeek-R1本地化部署的爆火,英偉達(dá)也親自下場(chǎng),開(kāi)源了首個(gè)基于Blackwell架構(gòu)的優(yōu)化方案——DeepSeek-R1-FP4。

在新模型的加持下,B200實(shí)現(xiàn)了高達(dá)21,088 token每秒的的推理吞吐量,相比于H100的844 token每秒,提升了25倍。

與此同時(shí),每token的成本也實(shí)現(xiàn)了20倍的降低。

通過(guò)在Blackwell架構(gòu)上應(yīng)用TensorRT DeepSeek優(yōu)化,英偉達(dá)讓具有FP4生產(chǎn)級(jí)精度的模型,在MMLU通用智能基準(zhǔn)測(cè)試中達(dá)到了FP8模型性能的99.8%。

DeepSeek-R1首次基于Blackwell GPU優(yōu)化

目前,英偉達(dá)基于FP4優(yōu)化的DeepSeek-R1檢查點(diǎn)現(xiàn)已在Hugging Face上開(kāi)源。

模型地址:https://huggingface.co/nvidia/DeepSeek-R1-FP4

后訓(xùn)練量化

模型將Transformer模塊內(nèi)的線性算子的權(quán)重和激活量化到了FP4,適用于TensorRT-LLM推理。

這種優(yōu)化將每個(gè)參數(shù)從8位減少到4位,從而讓磁盤(pán)空間和GPU顯存的需求減少了約1.6倍。

使用TensorRT-LLM部署

要使用TensorRT-LLM LLM API部署量化后的FP4權(quán)重文件,并為給定的提示生成文本響應(yīng),請(qǐng)參照以下示例代碼:

硬件要求:需要支持TensorRT-LLM的英偉達(dá)GPU(如B200),并且需要8個(gè)GPU來(lái)實(shí)現(xiàn)tensor_parallel_size=8的張量并行。

性能優(yōu)化:代碼利用FP4量化、TensorRT引擎和并行計(jì)算,旨在實(shí)現(xiàn)高效、低成本的推理,適合生產(chǎn)環(huán)境或高吞吐量應(yīng)用。

from tensorrt_llm import SamplingParams

from tensorrt_llm._torch import LLM

def main():

prompts = [

"Hello, my name is",

"The president of the United States is",

"The capital of France is",

"The future of AI is",

]

sampling_params = SamplingParams(max_tokens=32)

llm = LLM(model="nvidia/DeepSeek-R1-FP4", tensor_parallel_size=8, enable_attention_dp=True)

outputs = llm.generate(prompts, sampling_params)

# Print the outputs.

for output in outputs:

prompt = output.prompt

generated_text = output.outputs[0].text

print(f"Prompt: {prompt!r}, Generated text: {generated_text!r}")

# The entry point of the program need to be protected for spawning processes.

if __name__ == '__main__':

main()對(duì)于此次優(yōu)化的成果,網(wǎng)友表示驚嘆。

「FP4魔法讓AI未來(lái)依然敏銳!」網(wǎng)友Isha評(píng)論道。

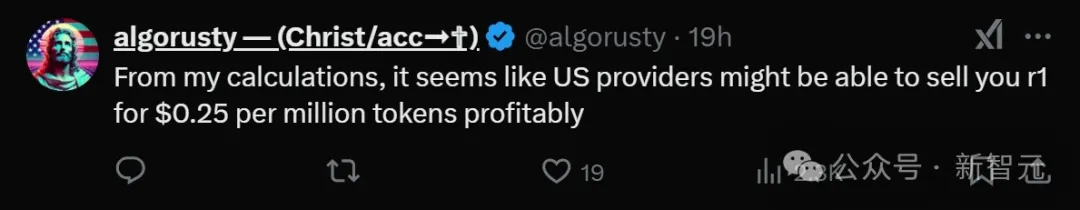

網(wǎng)友a(bǔ)lgorusty則聲稱,有了這次的優(yōu)化后,美國(guó)供應(yīng)商能夠以每百萬(wàn)token 0.25美元的價(jià)格提供R1。

「還會(huì)有利潤(rùn)。」

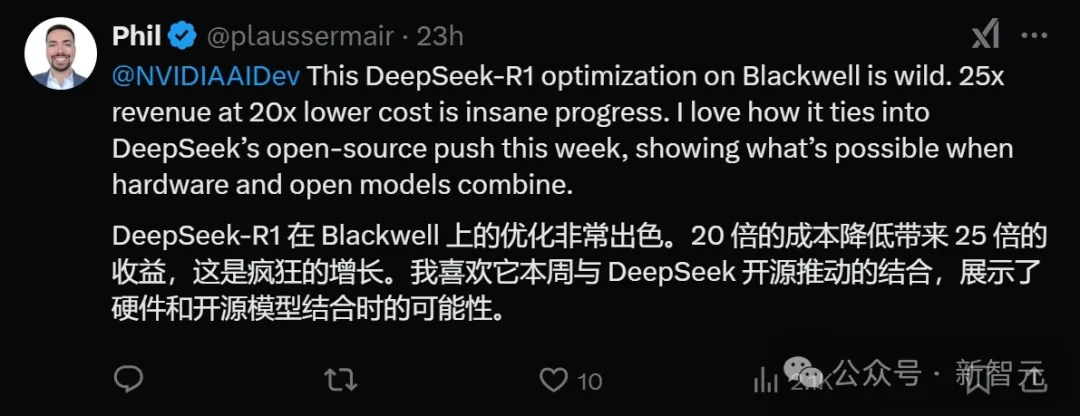

網(wǎng)友Phil則將這次的優(yōu)化與DeepSeek本周的開(kāi)源5連發(fā)結(jié)合了起來(lái)。

「這展示了硬件和開(kāi)源模型結(jié)合的可能性。」他表示。

DeepSeek全面開(kāi)源

如今DeepSeek持續(xù)5天的「開(kāi)源周」已經(jīng)進(jìn)行到了第3天。

周一,他們開(kāi)源了FlashMLA。這是DeepSeek專為英偉達(dá)Hopper GPU打造的高效MLA解碼內(nèi)核,特別針對(duì)變長(zhǎng)序列進(jìn)行了優(yōu)化,目前已正式投產(chǎn)使用。

周二開(kāi)源了DeepEP,這是一個(gè)專為混合專家系統(tǒng)(MoE)和專家并行(EP)設(shè)計(jì)的通信庫(kù)。

周三開(kāi)源的是DeepGEMM。這是一個(gè)支持稠密和MoE模型的FP8 GEMM(通用矩陣乘法)計(jì)算庫(kù),可為V3/R1的訓(xùn)練和推理提供強(qiáng)大支持。

總的來(lái)說(shuō),不管是英偉達(dá)開(kāi)源的DeepSeek-R1-FP4,還是DeepSeek開(kāi)源的三個(gè)倉(cāng)庫(kù),都是通過(guò)對(duì)英偉達(dá)GPU和集群的優(yōu)化,來(lái)推動(dòng)AI模型的高效計(jì)算和部署。