DeepSeek崛起:如何在AI賽道實現彎道超車?

1. 前言

最近 AI 黑馬 DeepSeek 火遍大街小巷,不知道大家都體驗過沒有,反正身邊已經有很多同學朋友跑來問我:哎小?,你們公司不也是做 AI(人工智能)的嗎,有聽說過 DeepSeek 嗎?

那顯然聽過,從目前的形勢來看,它不僅又一次帶動國內的 AI 潮,也直接影響了大多數科技巨頭公司的股票,以及整個互聯網經濟。別的不說,就我 2019 年買的互聯網基金,終于重新回本盈利了 ㄟ(≧◇≦)ㄏ

那么,DeepSeek 有這么厲害嗎?

有人說,它搞崩了美國的股市,徹底實現了彎道超車;也有人說,它不過是借著 OpenAI 的東風,吹得再高也只是曇花一現,根本不值一提。

網絡上的聲音非常兩級分化,要么吹得天花亂墜,要么嗤之以鼻。

話說回來,聊 AI 這么“高大上”的東西,如果不清楚原理就瞎說,那和耍流氓有啥區別。但也不能太學術,畢竟咱也不是專門吃這碗飯的,也不需要了解那么學術化的知識,例如下面這種看到就想打瞌睡的:

圖片

圖片

所以,DeepSeek 到底是被夸大,還是真的這么牛B,我們今天就用最通俗的語言來科普一下。

2. LLM 大語言模型

首先要想弄明白 AI,咱們還得先搞清楚大語言模型(LLM)。

這么說吧,當今社會上幾乎所有的大語言模型,像什么 OpenAI 的 ChatGPT,谷歌的 Gemini,Meta 的 LLaMA,以及國內比較出名的百度文心一言,華為的盤古,還有咱們今天要說的 DeepSeek,他們都來自同一個核心結構,就是 Transformer(變形金剛的英文)。

Transformer 這個概念源自 2017 年的來自谷歌團隊的一篇神論文《Attention Is All You Need》,它的第一作者是一位印度裔科學家,名叫 Ashish Vaswani。

Transformer 最主要的原理名叫 Self-Attention(自注意力機制),即先挑出一句話里最關鍵的詞,算一下他們之間的關聯,最后再推斷出來這句話說了啥。

2.1 AI 理解人類語言

我知道大家可能已經聽不下去了,我們下面開始說人話,假設有這么一句話:“貓坐在墊子上,它很舒服”,這里的 “它” 指的是誰?

對于咱們人類而言很容易知道,那不就是貓嗎?

可對于 AI 來說,卻曾經是一個千古難題,因為他根本就不理解。那到底要怎么讓 AI 理解是貓很舒服還是墊子舒服呢?

其實在這段話里出現了不少概念,有貓、墊子、坐、上、它、舒服等等。

要想讓 AI 區分他們,就得先給每個詞都貼上性格標簽。

2.2 性格標簽

什么是性格標簽?

咱們先拿人來打個比方,大家想象一下,每個人都有不同性格特征對吧?可怎么表示能讓計算機區分不同性格的人呢?畢竟計算機只能看懂數字,于是聰明的科學家想了個辦法,給計算機做一個簡單的二進制數字圖表。

比如內向這個維度,-1 是最內向,零是中間,而 1 是最外向。以此類推,還有善良幽默直率等等性格。

圖片

圖片

小明很外向 0.8,比較善良 0.6,有一點幽默 0.3;而老王性格有點內向是 -0.2,但是他很幽默是 0.7,而且很直率 0.8。

這樣我們就可以通過一組數字標簽,即“數字向量”,讓計算機區分小明和老王,畢竟計算機只認數字不認人。

同樣,在 Transformer 處理語言的時候,他也要給每個英文單詞或是漢字配上性格標簽,也就是剛才說的數字向量。

圖片

圖片

那么咱們再來看剛才句子里出現的那些詞匯:

貓是動物 0.9,它不是物品 -0.8,有點感情 0.6,體積不算大 0.3

墊子不是動物 -0.9,它是物品 0.8,幾乎沒有情感 0.1,它的動物屬性是 0.5,物品屬性 0.2,情感 0

有了這些所謂的數字,也就是數字向量,一下就可以知道貓大概率是動物類,跟墊子差的有點遠;還能明白貓多少有點情感,墊子幾乎沒有情感,而舒服這種情感詞匯更可能說的是貓而不是墊子。

于是,計算機聽不懂人話的千古難題,就被一堆數字的比對算法給解決了,讓 AI 慢慢地具備了理解我們的能力。

當然所謂的理解這種擬人化的說法也只是個比喻,實際上模型并沒有自我意識,而是通過無數次的訓練迭代更新參數,逐漸學會了在向量空間中表示貓、墊子的概念差異。

說人話就是 AI 需要大量的計算才能理解一個單詞,而一句話、一段話甚至一整篇文章,就得需要指數級增長的海量計算!

2.3 模型訓練

那么就到了下一步模型訓練,大致我把它總結為 4 個步驟。

第一步就是給所有的單詞自動編碼,前面咱們已經提到了計算機它只認識數字不理解文字,于是 AI 先把所有的單詞轉換成一組數值嵌入向量,這些向量并不是人類人工定好的,而是 AI 通過大規模的文本學習對比后算出來的。

圖片

圖片

在學習的過程中,AI 可能會看到很多關于貓的句子,比如貓喜歡吃魚,貓和狗都是寵物,于是 AI 發現貓和狗經常出現在類似的句子里,它們可能具有相似的向量,貓和魚也會經常的出現在一起,它們倆之間一定有某種特殊的聯系。

第二步,通過填空游戲進行自監督學習(Self-Supervised Learning)。為什么叫自監督,因為 AI 沒有老師告訴他每個單詞的含義,而是自己通過填空游戲來學習。在訓練的時候,AI 它會在海量文本上做完形填空題,比如訓練數據:

AI 可能會預測沙發、床、墊子概率比較高,比如電風扇、燈泡概率比較低。

而每次 AI 猜錯,它就會根據誤差調整內部的向量,也就是那個詞的標簽數字,讓下一次的預測更加的精準,就這么反反復復不斷考試,不斷改錯,一點點學會了人類語言的基本規律。

再說到第三步自注意力機制(Self-Attention),也就是剛才提到的那篇神論文《Attention Is All You Need》里的關鍵原理,能讓 AI 自動找出句子中最相關的單詞。

圖片

圖片

再看剛才舉的那個例子,“它” 指代的是什么?句子里的重點是在講什么?貓在墊子上睡覺很舒服,AI 計算出來的相關性可能會是:

“它” 是電子的相關性 0.4,它是貓的相關性 0.9

就這樣,AI 不僅學會了單詞的意思,還理解了詞、句子與句子之間的邏輯關系。

再到第四步,就是反復訓練加參數調整,把上述的填空題和 Self-Attention 的步驟,在海量的數據上循環的進行上百萬乃至上億次的訓練,每次迭代都會更新參數,慢慢形成更準確的理解和推理能力。

最終 AI 學會了生成文章,學會了回答人類的問題,甚至推斷語境做推理,看起來像是能聽懂了人話,可其實 AI 只是在做算術。

2.4 GPT 的恐怖計算量

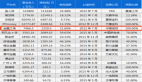

說到算數,大家一定想問:像訓練一個 GPT4 這個級別的大語言模型到底需要多少次計算呢?

在 AI 訓練里面通常用也就是浮點運算 FLOP 次數來衡量計算量,比如一次簡單的計算:

圖片

圖片

就算一個 FLOP,OpenAI 上一代的產品 GPT3 的計算次數就是一個恐怖的天文數字,大約一共是 1750 億的參數,用了 3.14×10 的 23次方的 FLOPs,那也就是 3140 萬億億(注意是兩個億)次浮點運算,相當于一臺當時的頂級 GPU A100,以每秒 312 萬億次浮點運算的速度連續運行了 355 年,或者是用 3640 臺 A100 一起跑一個月的時間。

圖片

圖片

據說在 GPT3 的訓練中一共看了大約 5,000 億個單詞,并且預測了 10 萬億個 Token,也就是做了 10 萬億次完形填空題來學習語言,至于 GPT4,它的規模比 GPT3 大了 10 倍以上,計算量和開銷更是不用多說,據傳訓練一次 GPT4 就得花費幾千萬美元。

3. DeepSeek 如何彎道超車

說到這里,鋪墊了那么長,相信大家已經有了大致的概念,那么下面咱們終于要說到國內的 DeepSeek 了。

3.1 芯片限制

由于美國對中國的高端芯片制裁,頂尖的 GPU 比如 H100,肯定是不會賣給中國的。于是英偉達給中國市場提供了一個專用芯片,叫做 H800,即 H100 的中國市場閹割版,它的性能大概是 H100 的 60%~77%,也就是 1.3~1.6 倍的差距。

那么下面咱們就要聊到今天的重頭戲,DeepSeek 是如何用 H800 的閹割版 GPU,采用 550 萬左右的成本達到上億美元 GPT4 的效果呢?答案就是模型蒸餾技術。

3.2 模型蒸餾

前面我們一直反復強調,在一開始 GPT 并沒有老師手把手的告訴他每個單詞的含義,可在模型蒸餾里 DeepSeek 卻找到了老師,而這位老師據傳正是已經訓練成熟的 ChatGPT,那到底是怎么教的呢?

咱們還用剛才的例子舉例來說:貓坐在墊子上,它很舒服,“它”指的是什么?

那么基于 DeepSeek 的學習步驟如下:第一步輸入數據給 GPT,也就是教師模型,這時 GPT 已經是一個經過海量數據訓練的大師了,理解語言非常準確。

第二步,GPT 生成輸出(軟標簽),GPT 分析完了之后可能會給出一個這樣的概率分布,比如說:輸出它指的是貓的概率是 85%,它指的是墊子的概率是 15%。

GPT 不僅告訴了 DeepSeek 正確的答案是貓,還能讓 DeepSeek 知道 GPT 在判斷時的細節和關聯度。

圖片

圖片

不僅如此,DeepSeek 還會記錄老師的思考過程。除了最終答案,DeepSeek 還可能獲取在中間層的一些其他信息,比如剛才說的注意分數、隱藏狀態等等,就像是獲得老師的心得筆記。

接下來,即最后一步獲得老師的心得筆記之后,DeepSeek 就不需要從 0 開始琢磨每一個詞之間的關系,而是直接學習老師的經驗,反復學習 GPT 這種軟標簽后,DeepSeek 大大縮短了訓練時間,節省了大量的算力,并且最終可以輸出與 GPT4 相近的結果。

上述的過程就叫模型蒸餾,用大模型當老師,把知識蒸餾到自己的小模型里,最終 DeepSeek 可以比老師更快給出靠譜的答案,且訓練的成本也比老師大大的降低。

除此之外,由于 DeepSeek 是國內訓練的大語言模型,所以在模型進化的過程中,吸收了很多“本土優勢”,在回答一些國內民生、經濟方面的問題時,比 ChatGPT 會更貼合實際一些。

4. 小結

說了這么多,小?覺得,科技進步就像站在巨人的肩膀上打籃球,跳得高才能看得遠。就像模型蒸餾,小模型有了大模型當老師,學習起來事半功倍,省時省力。開源的精神也在于此,它讓知識在更廣泛的范圍內流動和共享,激發出更多的創新火花。

想象一下,有一天 AI 能極大程度幫我們解決工作難題,甚至實時監測我們的身體健康。同時,AI 將在醫療、教育、環境保護等領域發揮更為重要的作用,幫助我們解決當今世界面臨的諸多挑戰。