360智腦開源Light-R1!1000美元數(shù)學上首次從零超越DeepSeek-R1-Distill

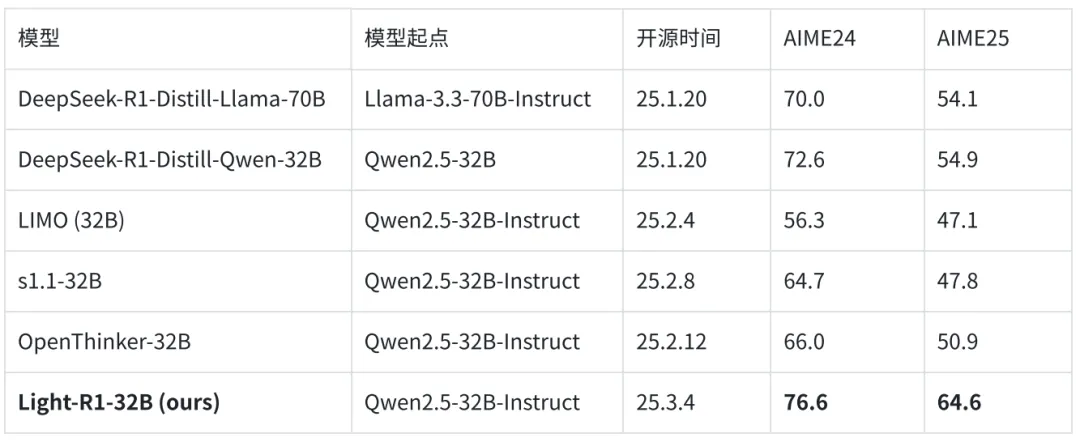

2025 年 3 月 4 日,360 智腦開源了 Light-R1-32B 模型,以及全部訓練數(shù)據(jù)、代碼。僅需 12 臺 H800 上 6 小時即可訓練完成,從沒有長思維鏈的 Qwen2.5-32B-Instruct 出發(fā),僅使用 7 萬條數(shù)學數(shù)據(jù)訓練,得到 Light-R1-32B,在 AIME24 測試基準中取得 76.6 分、AIME25 取得 64.6 分,在數(shù)學評測上開源首次實現(xiàn)從零大幅超越 DeepSeek-R1-Distill-Qwen-32B 的 72.6 分和 54.9 分。

一周前,360 智腦聯(lián)合北大開源了 TinyR1-32B-Preview,從 DeepSeek-R1-Distill-Qwen-32B 訓練,在數(shù)學、科學和代碼上取得了接近 DeepSeek-R1 滿血版的優(yōu)異效果。Light-R1-32B 則不依賴 DeepSeek-R1-Distill,從沒有長思維鏈的模型出發(fā),在數(shù)學上從零復現(xiàn)并超越了 DeepSeek-R1-Distill-Qwen-32B。360 智腦希望這些工作助力開源社區(qū)發(fā)展。

注:表中為 64 次采樣均分,較 16 次平均更穩(wěn)定;其他開源模型截取開源匯報的結果,若沒有則測試 64 次取均分。

- 模型倉庫:https://huggingface.co/qihoo360/Light-R1-32B

- 項目地址:https://github.com/Qihoo360/Light-R1

低成本從零超越,領域專精

DeepSeek-R1 模型發(fā)布以來,盡管許多開源工作試圖在 72B 或更小的模型上復現(xiàn)長思維鏈的 DeepSeek-R1 的性能,但至今還沒有在 AIME24 等高難度數(shù)學競賽中達到接近 DeepSeek-R1-Distill-Qwen-32B 的 72.6 分的成績。

360 智腦開源的 Light-R1-32B 實現(xiàn)了突破,從沒有長思維鏈的 Qwen2.5-32B-Instruct 開始訓練,它在 AIME24 上取得了 76.6 的高分、在 AIME25 上 64.6 分,均顯著超越 DeepSeek-R1-Distill-Qwen-32B。

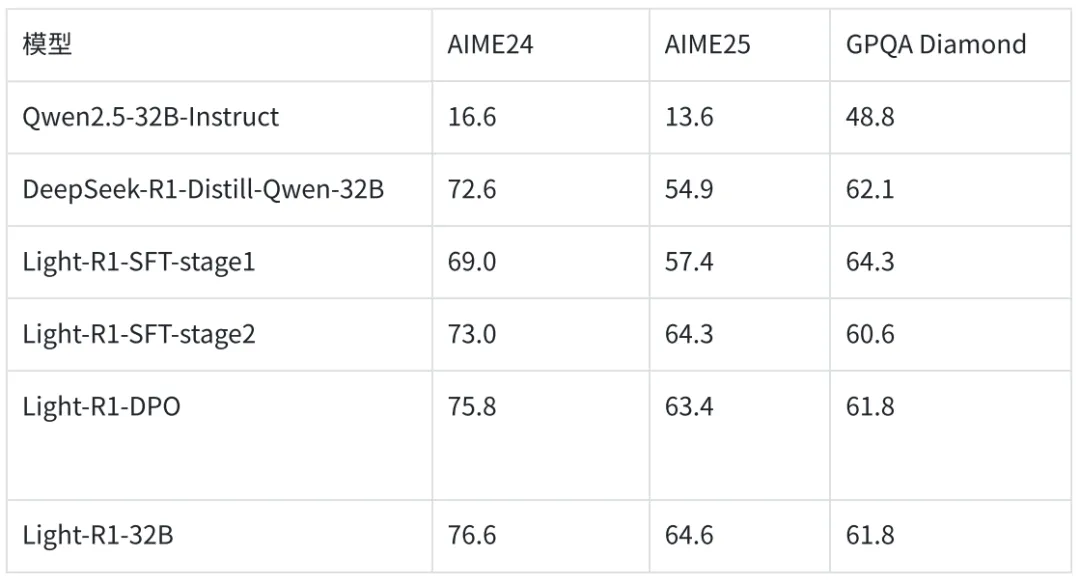

Light-R1-32B 的這套從零訓練的方案,按 H800 租用價格估算,訓練成本僅需 1000 美元左右。僅使用了 7 萬條數(shù)學數(shù)據(jù),通過兩階段的課程學習 SFT 接著 DPO,即可超過 DeepSeek-R1-Distill-Qwen-32B,12 臺 H800 機器的訓練時長僅需 6 小時以內(約 4+0.5+0.5 小時)。

雖然僅使用數(shù)學數(shù)據(jù)訓練了模型的長思維鏈能力,但在 GPQA Diamond 任務上的優(yōu)秀結果,讓我們相信 Light-R1 的訓練方案的泛化性及有效性。相比于內部目前正在研發(fā)的強化學習路線,Light-R1 的課程學習 SFT+DPO 對整個訓練流程更輕便,成本也更友好。隨著訓練和推理技術的不斷發(fā)展,未來長思維鏈模型將更加普及,Light-R1 正為低成本快速訓練一個領域專精推理模型提供了重要參考。

全量開源,簡單易用

Light-R1 開源首日即開源全量訓練和評測資產(chǎn):

- Light-R1-32B 模型:沿用 Qwen2.5-32B Apache 2.0 License;

- 課程學習 SFT+DPO 數(shù)據(jù)集:兩階段課程學習 SFT 和 DPO 的全部數(shù)據(jù);

- 360-LLaMA-Factory 訓練框架:在長思維鏈數(shù)據(jù) Post-Training(尤其是 DPO)上解鎖序列并行;

- 完整評測代碼和結果:基于 DeepScaleR 的評測工具,Light-R1-32B 的原始采樣結果也在 Huggingface 模型目錄下。

Fully open at Day 1,確保可信度和可復現(xiàn)性。360 智腦也正在探索強化學習續(xù)訓,未來性能有望進一步提升。

Light-R1-32B 基于 Qwen tokenizer 增加了個別特殊 token。使用 Light-R1-32B 模型時,因其長思維鏈能力目前僅通過數(shù)學數(shù)據(jù)訓練,故并不會對所有用戶輸入輸出長思維鏈。參照 DeepSeek 的推理建議,我們在聊天模板中硬編碼了 < think> token 強制其思考。建議使用較新版本的 vLLM 或 SGLang 進行推理。

課程 SFT+DPO,穩(wěn)步提升

數(shù)據(jù)準備

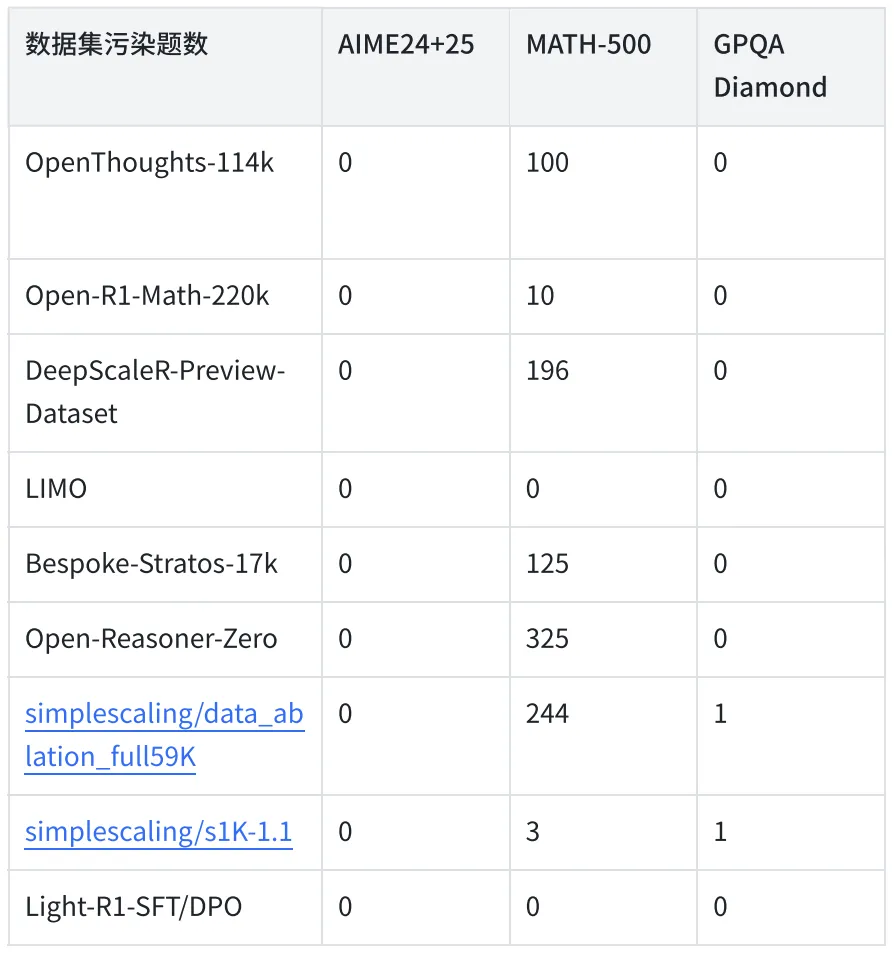

訓練用的數(shù)學題來自 OpenR1-Math-220k、OpenThoughts-114k、Omni-MATH、AIME(截至 2023 年)等多個開源的數(shù)學數(shù)據(jù)集,并對 AIME、MATH、GPQA 等基準測試的數(shù)據(jù)泄露去除了污染的題目。

數(shù)學題的答案抓取了 DeepSeek-R1 的結果并經(jīng)過驗證過濾。同時使用 DeepScaleR-1.5B-Preview 進行采樣根據(jù)回答正確率估算題目的難度分級。

課程學習 SFT+DPO

基于 Qwen2.5-32B-Instruct,依次進行 Post-Training:

- SFT 階段 1:根據(jù)驗證結果和難度分級初篩,得到 7 萬條數(shù)據(jù)進行 SFT;

- SFT 階段 2:在 SFT 階段 1 之后,篩選出難度最大的 3 千條數(shù)據(jù),進行 SFT;

- DPO 階段:在 SFT 階段 2 之后,在 3 千條數(shù)據(jù)上多次采樣 Light-R1-SFT 階段 2 的回答,根據(jù)驗證結果和 DeepSeek-R1 的回答構建 DPO pair 對,進行 DPO,使用 DPO 原始 loss 或 NCA loss。

模型融合

最終,智腦團隊將 SFT 階段 2、DPO 和另一個 DPO 版本的模型(AIME24 74.7 分)融合,使用 Arcee 團隊的 mergekit 工具,得到 Light-R1-32B。這兩個 DPO 版本在訓練數(shù)據(jù)和超參上略有不同。

整個訓練流程中,每一步的提升都在前文的表格中體現(xiàn)。在完全沒訓練的科學類題目評測 GPQA 上,數(shù)學專項訓練導致了部分遺忘,但 Light-R1-32B 也體現(xiàn)了較強的泛化性。

數(shù)據(jù)去重,助力開源生態(tài)

基準測試分數(shù)既有其重要性,也有局限性。雖然預訓練階段的個別基準測試污染難以完全避免,但在后訓練階段,應當嚴格杜絕數(shù)據(jù)污染,在訓練集中對測試數(shù)據(jù)嚴格去重。360 智腦在研發(fā)過程中發(fā)現(xiàn),雖然開源數(shù)據(jù)集對 AIME 都沒有污染,但是在 MATH-500 和 GPQA 上都存在一定污染,通過 N-gram 或純字母匹配檢測,可以發(fā)現(xiàn)原題或僅更改數(shù)字的計算題。針對這種情況,Light-R1-32B 在訓練過程中做了嚴格去重。

在開源社區(qū)中,Light-R1-32B 是首個從零訓練超越 DeepSeek-R1-Distill-Qwen-32B 的模型。Light-R1-32B 基于開源模型 Qwen2.5-32B-Instruct 和 DeepSeek-R1 和多個開源數(shù)據(jù),使用開源框架 360-LLaMA-Factory 訓練,使用開源項目 DeepScaleR 和 verl 評測。360 希望通過 Light-R1-32B 和上周開源的 TinyR1 等工作助力開源生態(tài)發(fā)展,加速中國 AI。

注:本文 “從零” 表示從沒有長思維鏈的模型開始訓練

團隊成員:Liang Wen, Fenrui Xiao, Xin He, Yunke Cai, Qi An, Zhenyu Duan, Yimin Du, Junchen Liu, Lifu Tang, Xiaowei Lv, Haosheng Zou, Yongchao Deng, Shousheng Jia, Xiangzheng Zhang