超越DeepSeek-R1關鍵RL算法GRPO,CMU「元強化微調」新范式登場

大語言模型(LLM)在推理領域的最新成果表明了通過擴展測試時計算來提高推理能力的潛力,比如 OpenAI 的 o1 系列。

通常來說,這些方法在訓練模型時可以產生比典型正確解決方案更長的軌跡,并包含了試圖實現某些「算法」的 token:例如反思前一個答案、規劃或實現某種形式的線性搜索。這些方法包括顯式地微調預訓練 LLM 以適應算法行為,例如對搜索數據進行監督微調(SFT)或針對 0/1 正確性獎勵運行結果獎勵(outcome-reward,OR)RL。

雖然通過「結果獎勵 RL 生成長推理鏈」的方式來訓練模型消耗測試時計算的前景看好,但為了繼續從擴展測試時計算中獲得收益,我們最終需要回答一些關鍵的理解和方法設計問題。

第一個問題:當前的 LLM 是否高效使用了測試時間計算?也就是說,它們是否消耗了與典型解決方案長度大致相當的 token,或者它們是否在簡單的問題上使用了太多 token?

第二個問題:當運行測試時 token 預算遠大于用于訓練的 token 預算時,LLM 是否能夠「發現」用于更難問題的解決方案?最終,我們希望模型能夠從它們生成的每個 token(或任何語義上有意義的片段)中獲得足夠的效用,這不僅是為了提高效率,還因為這樣做可以形成一個系統化的流程來發現更難、分布外問題的解決方案。

在本文中,CMU、HuggingFace 的研究者提出從元強化學習(RL)的視角來形式化上述優化測試時計算的挑戰。

- 論文標題:Optimizing Test-Time Compute via Meta Reinforcement Fine-Tuning

- 論文地址:https://arxiv.org/pdf/2503.07572

- 項目主頁:https://cohenqu.github.io/mrt.github.io/

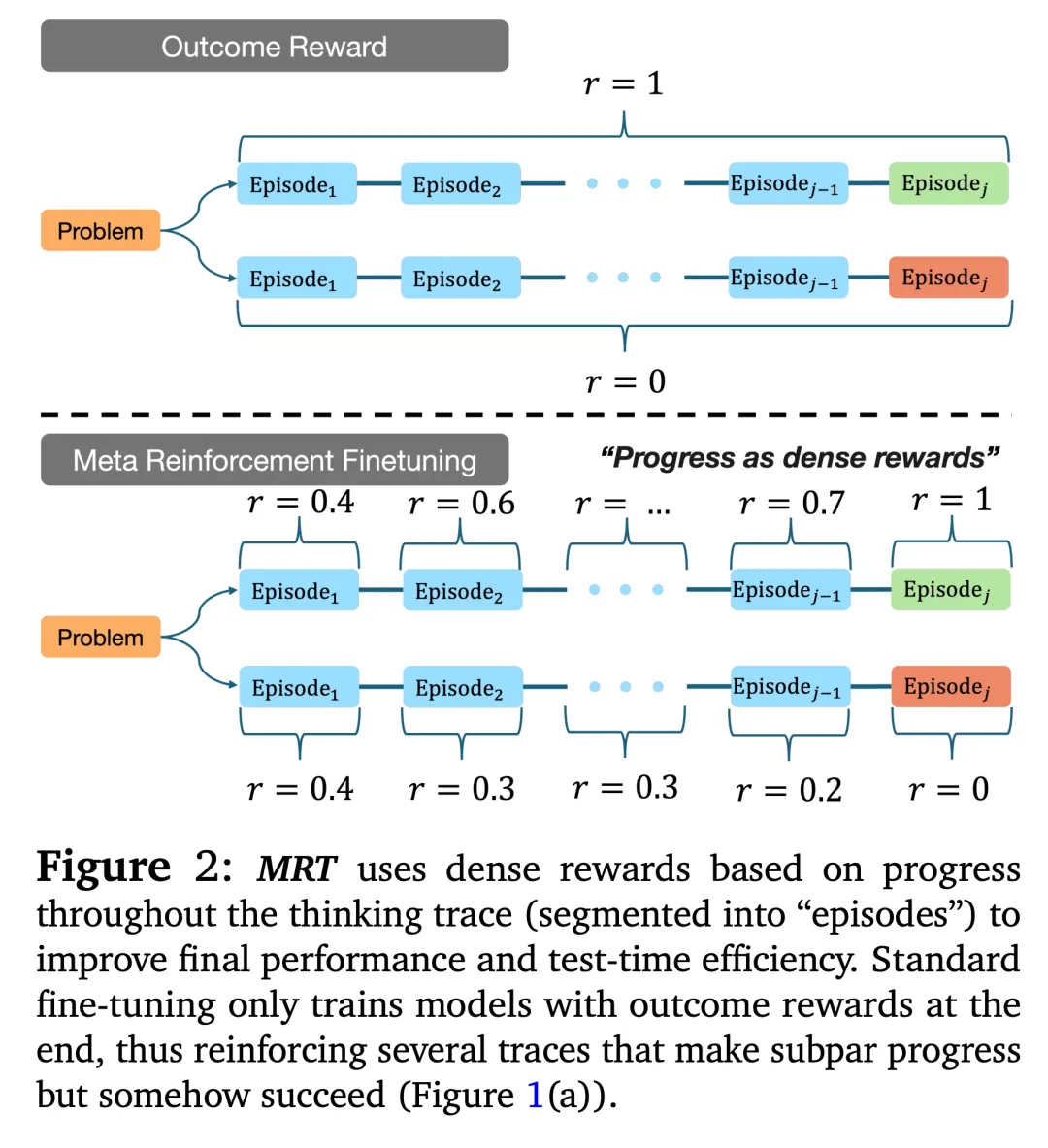

在構建方法的過程中,研究者在給定問題上將 LLM 的輸出流分割成多個片段(圖 2)。如果我們只關心效率,那么 LLM 應該只學習利用并直接輸出最終答案,而無需耗費太多片段。另一方面,如果 LLM 僅專注于發現(discovery),那么探索就更可取,這樣 LLM 就可以耗費幾個片段來嘗試不同的方法,并進行驗證和修改,然后得出最終答案。

從根本上說,這與傳統的 RL 不同,這里的目標是學習一個可以在每個測試問題上實現探索 - 利用算法的 LLM。換句話說,本文的目標是從訓練數據中學習這樣的算法,使其成為一個「元」RL 學習問題。

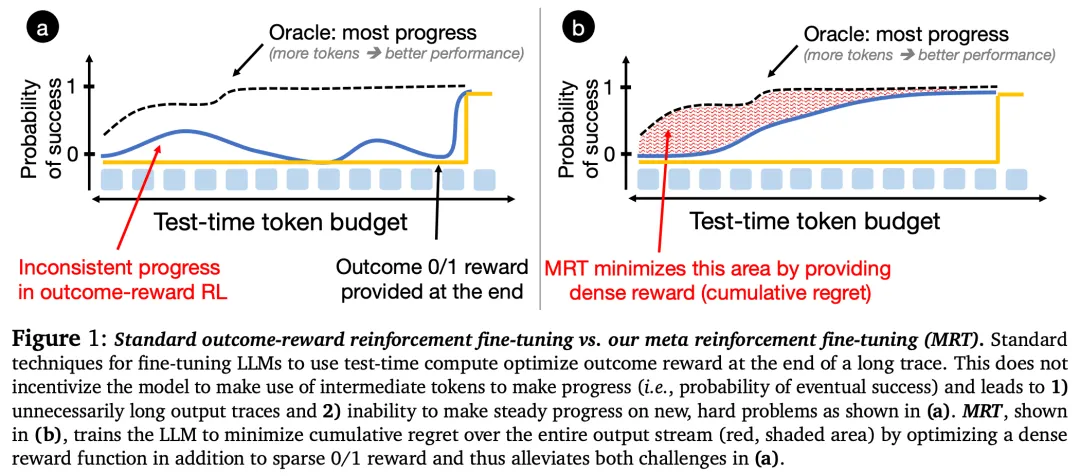

理想的「元」行為是在過早采用一種方法(即「利用」片段)和嘗試過多高風險策略(即「探索」片段)之間取得平衡的行為。從元 RL 文獻中,我們知道探索和利用的最佳權衡相當于最小化輸出 token 預算的累積悔值。這種悔值衡量了 LLM 與一個 oracle 比較器成功可能性之間的累積差異,如圖 1 (b) 中的紅色陰影區域所示。

理想的「元」行為是在過早采用一種方法(即「利用」片段)和嘗試過多高風險策略(即「探索」片段)之間取得平衡的行為。從元 RL 文獻中,我們知道探索和利用的最佳權衡相當于最小化輸出 token 預算的累積悔值。這種悔值衡量了 LLM 與一個 oracle 比較器成功可能性之間的累積差異,如圖 1 (b) 中的紅色陰影區域所示。

通過訓練 LLM 來最小化每個查詢的累積悔值,本文學習了一種在某種程度上與測試時預算無關的策略,即在部署時 LLM 僅耗費必要數量的 token,同時在更大的 token 預算下運行時仍會取得進展。

具體地,研究者利用一類新的微調方法來優化測試時計算,通過最小化累積悔值的概念產生了一種被稱為元強化微調(Meta Reinforcement Fine-Tuning,MRT)的解決方案(或范式),從而為評估現有推理模型(如 Deepseek-R1)在使用測試時計算的有效性提供了一個指標。

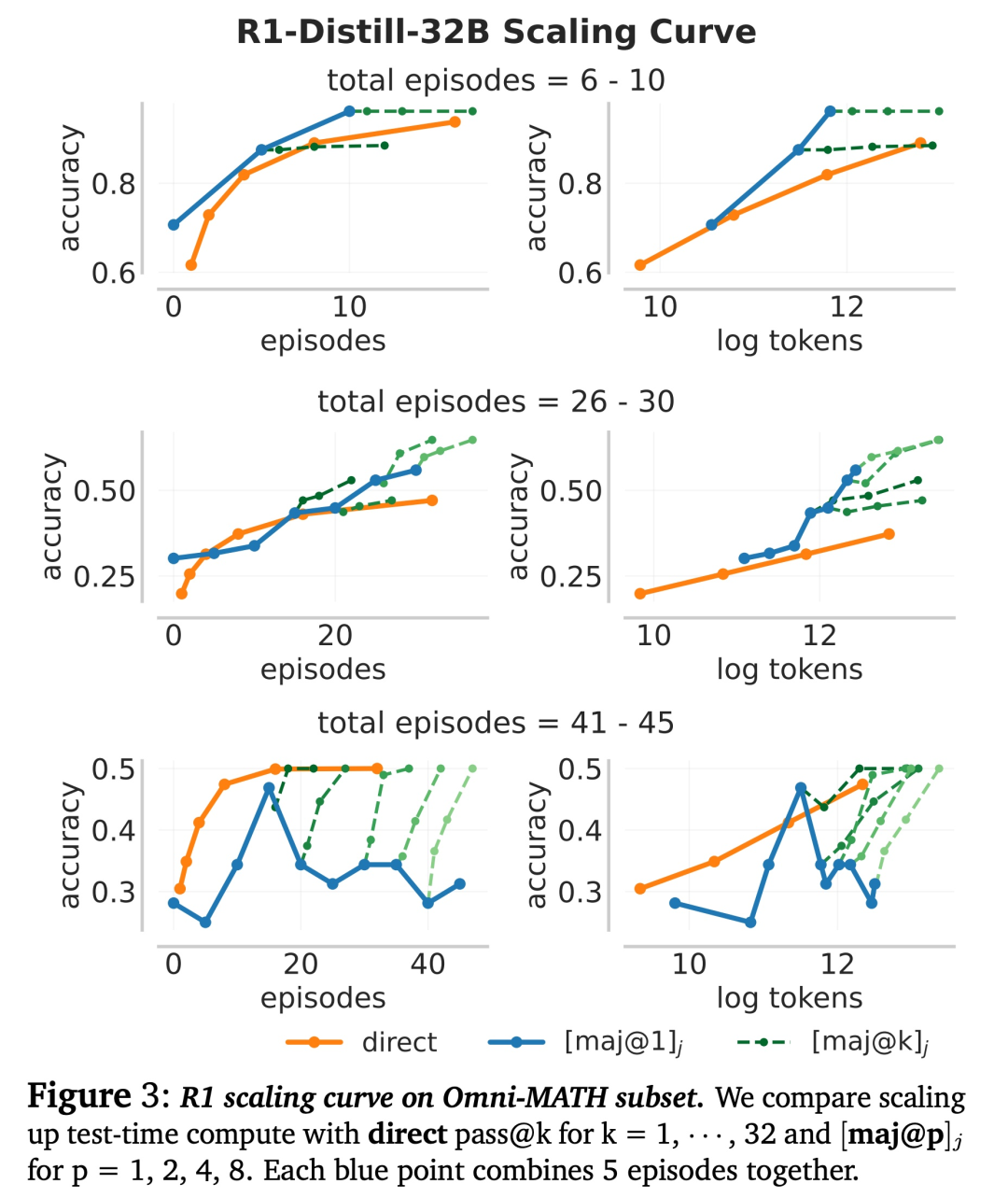

研究者發現,使用結果獎勵 RL 進行微調的 SOTA LLM 無法通過更多片段來提高發現正確答案的概率,即它們沒有取得穩定的「進展」(如上圖 1 (a) 所示),即使這種行為對于發現未見過難題的解決方案至關重要。事實上,在 FLOPs 匹配的評估中,運行更少片段并結合多數投票的更簡單方法通常對較難的問題更有效(下圖 3)。

相反,研究者表明,當目標是最小化悔值時,除了結果獎勵之外,對進展的優化也會自然而然出現。本文的微調范式 MRT 為 RL 訓練規定了密集的獎勵(reward bonus)。直觀地說,這一進展獎勵衡量了在生成給定片段之前和之后獲得正確答案的似然的變化。

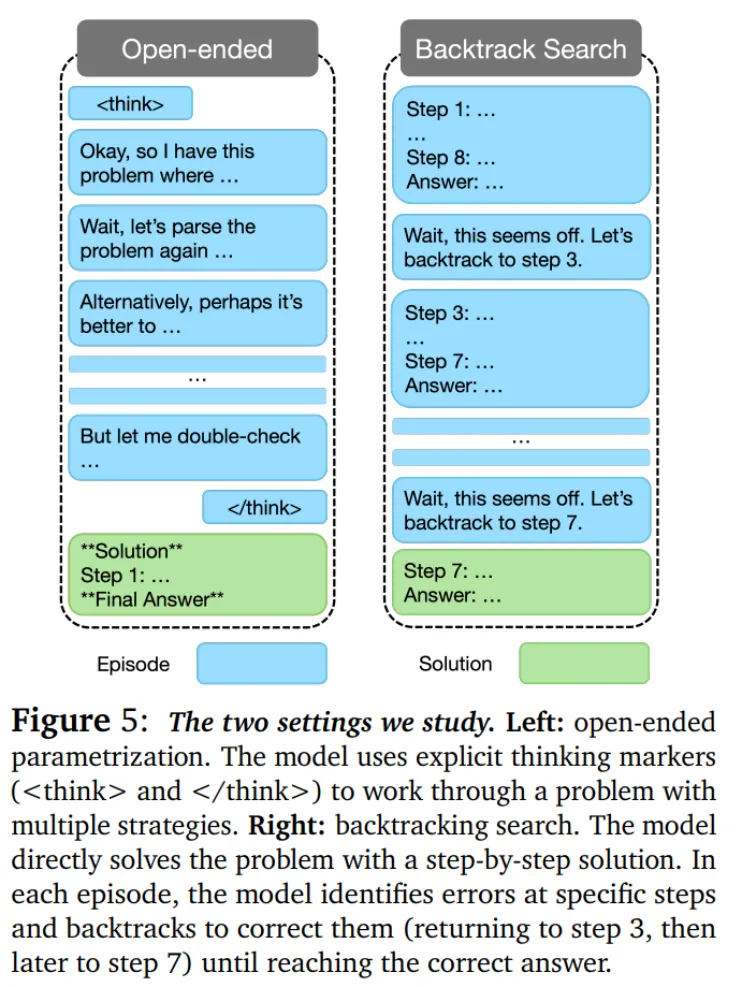

在實驗部分,研究者在兩種設置下對 MRT 進行了評估,二者的不同之處在于它們對片段進行參數化的方式。對于第一種設置,他們對基礎模型進行微調,包括 DeepScaleR-1.5B-Preview、DeepSeek-R1-Distill-Qwen-1.5B 和 DeepSeekR1-Distill-Qwen-7B,并采用了數學推理問題數據集。

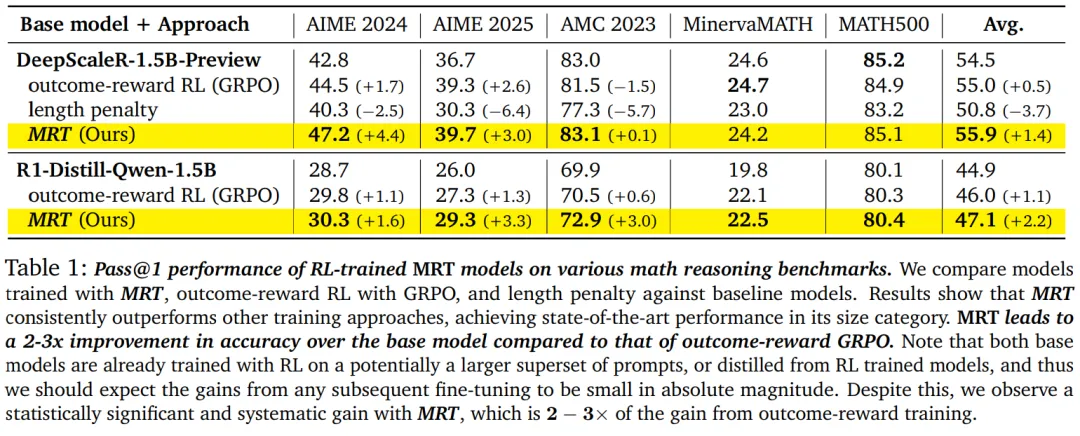

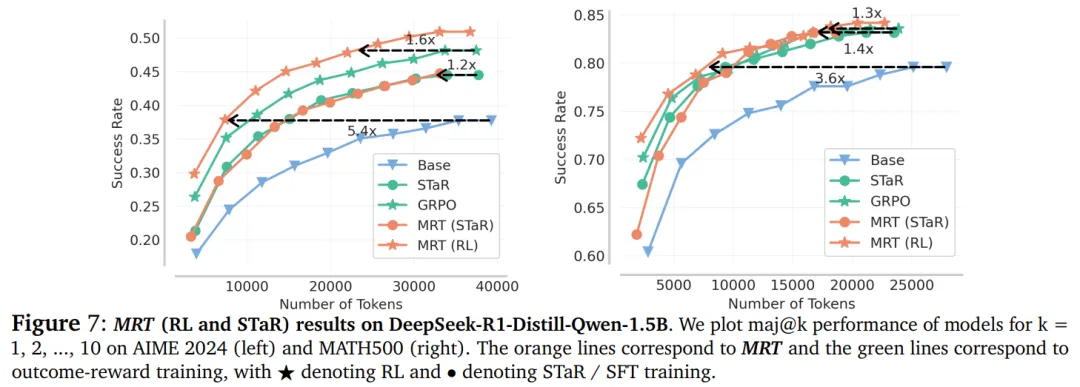

結果發現,MRT 的表現始終優于結果獎勵強化學習,在多個基準測試(AIME 2024、AIME 2025、AMC 2023 等)上取得了 15 億參數規模的 SOTA 結果,其相較于基礎模型的準確率提升是標準結果獎勵 RL(GRPO)的約 2-3 倍,而 token 效率是 GRPO 的 1.5 倍、是基礎模型的 5 倍。GRPO 是 DeepSeek-R1 的關鍵強化學習算法。

對于第二種設置,研究者對 Llama 3.1 進行微調以實現回溯,結果表明,MRT 相較于 STaR 和 GRPO 均實現了 1.6-1.7 倍的 token 效率提升。

元強化微調(MRT)范式

MRT 的目標是直接學習一種與預算無關(budget-agnostic)的 LLM,使其能夠穩步取得進展。

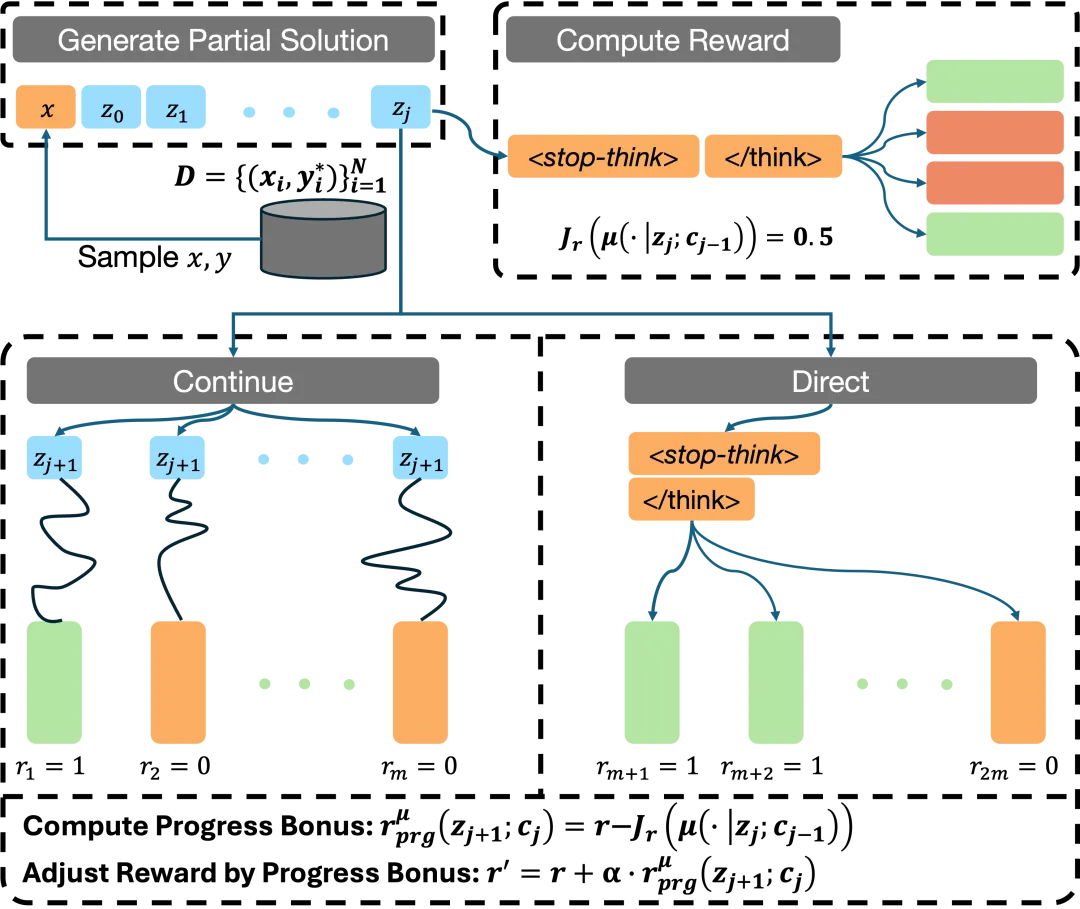

該研究使用在線強化學習方法(如 GRPO)實現元強化學習范式。下面是它的工作原理:

該研究定義了一個元證明器策略(Meta-Prover Policy)μ,用于評估一個片段對解決問題的貢獻程度。該策略的工作方式如下:

- 強制終止當前的思考塊(thought block),使用「time is up」提示(prompt);

- 讓模型根據當前的推理前綴(reasoning prefix)生成其最佳猜測的解決方案。

對于推理過程中的每一個片段,需要這樣操作:

- 使用元證明器策略 μ 計算思維前綴的獎勵;

- 基于這個前綴采樣多個策略內的軌跡(rollouts),這些軌跡被均勻分配為:繼續進一步推理;終止思考軌跡并生成最佳猜測的解決方案;

- 根據對進展(progress)的獎勵,然后計算進展獎勵。

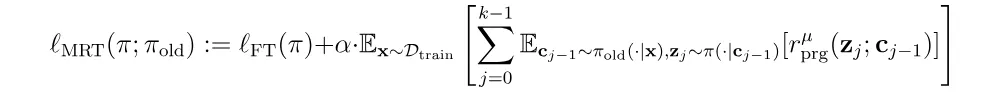

在訓練過程中,該研究優化了包含標準結果獎勵和基于進展的密集獎勵獎勵的 MRT 目標函數:

實驗結果

實驗評估了 MRT 在優化「測試時計算」資源方面的有效性。

如表 1 所示,MRT 的表現優于在相同數據集上未使用密集獎勵訓練的模型。

此外,該研究還得出了以下結論:

- 基于 DeepScaleR-1.5B-Preview 基礎模型微調的模型達到了其規模下 SOTA 水平。由于模型在經過蒸餾或已經經過強化學習(RL)訓練的基礎模型上進行了訓練,因此絕對性能提升較小。然而,與基于結果獎勵的 RL 方法(如 GRPO)相比,使用 MRT 的相對性能提升約為 2-3 倍。

- 當使用 DeepScaleR-1.5B 模型在 AIME 問題數據集上進行微調時,MRT 不僅在 AIME 2024 和 AIME 2025 評估集上取得了更好的性能(這或許在意料之中),而且在相對于結果獎勵強化學習(RL)分布外的 AMC 2023 數據集上也保持了較好的性能。

MRT 對 token 的處理效率

前文我們已經看到 MRT 可以在 pass@1 準確率上超越標準的結果獎勵強化學習(RL)。接下來,作者嘗試評估 MRT(RL)在 token 效率上是否可以帶來提升。

如圖 7 所示,MRT 在 AIME 2024 數據集上,在相同 token 數量的情況下,平均準確率比基礎模型高出 5%。此外,MRT(RL)在 AIME 2024 上所需的 token 數量比基礎模型少 5 倍,在 MATH 500 上少 4 倍,就能達到相同的性能(本例中使用的是 DeepSeek-R1 蒸餾的 Qwen-1.5B 模型)。

同樣地,MRT 在 token 效率上比結果獎勵 RL 提高了 1.2-1.6 倍。這些結果表明,MRT 在保持或提升準確率的同時,顯著提高了 token 效率。

回溯搜索設置中的線性化評估

在這種設置中,模型被限制為先生成一個解決方案,接著進行錯誤檢測,最后在進行修正(如圖 5 所示)。

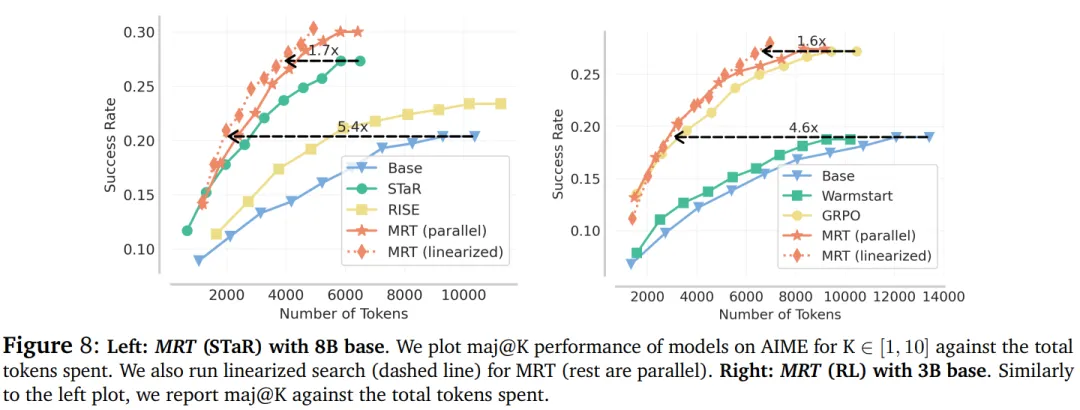

該研究首先對基于 Llama-3.1-8B 模型微調的 MRT 的 STaR 變體進行評估。如圖 8(左)所示,MRT 在兩種評估模式下(并行模式為實線;線性化模式為虛線)均實現了最高的測試效率,并在線性化評估模式下將效率提高了 30% 以上。

圖 8(右)顯示,與結果獎勵 GRPO 相比,MRT(RL)通過減少 1.6 倍的 token 來提升線性化效率。