騰訊混元在AI視頻上又放大招了!

最近他們開源了一個全新的視頻生成框架 —— HunyuanCustom,主打兩個關鍵詞:身份一致性 和 多模態輸入,直接命中當前AI視頻的兩個痛點!

看了他們的開源日直播之后,真的感覺這一步跨得很大,是向“可用AI視頻”邁進的重要一步。不管是生成短片、制作電商廣告,人物不能“變臉”、內容能穩定控制,這都是基礎中的基礎。

來看看 HunyuanCustom 的“身份一致性”表現有多驚艷:

單主體場景:給定一張男生或女生的照片,系統可以在不同場景中——比如工作、學習、遛狗等——都保持人物的臉型和氣質不變,表現非常穩定。

多主體場景就更精彩了:

比如,和熊貓對打(而且熊貓不糊、不飄)

圖片

圖片

再比如,小哥舉著樂事薯片講解,全程薯片這個“第二主角”都沒有消失、扭曲或者漂移,做廣告簡直讓甲方媽媽都能放心了!

圖片

圖片

動作的自然程度也讓人眼前一亮:女生奔跑后轉身擁抱男生,整個過程銜接自然,沒有那種讓人出戲的“AI味”。

另外,HunyuanCustom 還支持多模態驅動!來看這個由口播音頻驅動的視頻片段,模特自然講解產品,雖然口型還有點不貼合,但整體效果已經非常接近實拍。

模型對開發者非常友好,最低24G顯存就能跑,不過官方推薦顯存80GB,這樣可以兼顧速度和生成質量,特別適用于高分辨率視頻生成任務。

圖片

圖片

開源主頁:https://hunyuancustom.github.io/

技術詳解:HunyuanCustom有哪些黑科技?

HunyuanCustom 是一個多模態視頻生成模型,核心目標是保持生成視頻中“人物身份”的一致性,并支持根據文本、圖片、音頻、視頻等多種條件進行控制。

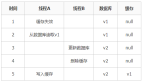

首先,模型引入了一個基于 LLaVA 的圖文融合模塊,用來增強圖像與文本之間的理解。文本描述中會包含 "the man looks like the image..." ,系統會將“image token”替換為用戶上傳的圖片,從而將人物特征更準確地融入文本語義中,幫助生成更具身份一致性的視頻內容。

圖片

圖片

其次,HunyuanCustom 還設計了一個圖像身份增強模塊。該模塊會將輸入圖像沿時間軸拼接,并借助視頻模型對時間序列的強大建模能力,在整個視頻中維持主體特征的一致性,也就是說,無論視頻播放到哪一幀,主角的樣貌都能保持穩定、不“變臉”。

在支持音頻和視頻作為輸入條件方面,HunyuanCustom 針對不同模態分別設計了專屬的注入機制。這些機制與身份保持模塊是解耦的,也就是說,即使在輸入中加入音頻或視頻,也不會干擾主體的身份一致性。

最終,HunyuanCustom 實現了對圖像、音頻和視頻條件的解耦式控制,在以主體為中心的多模態視頻生成任務中展現出極大的潛力。