譯者 | 涂承燁

審校 | 重樓

隨著人工智能(AI)在醫療和自動駕駛等領域的廣泛應用,我們對其信任程度的問題變得愈發關鍵。一種名為鏈式思考(CoT)的推理方法備受關注。它幫助人工智能將復雜問題分解為步驟,展示其如何得出最終答案。這不僅提升了性能,還讓我們得以一窺人工智能的“思考”過程,這對AI系統的信任與安全至關重要。

然而,Anthropic的研究質疑了鏈式思考是否真實反映了模型內部的運作。本文探討了鏈式思考的機制、Anthropic的發現,以及這些結果對構建可靠人工智能的意義。

理解鏈式思考推理

鏈式思考推理是一種引導人工智能分步解決問題的方法。模型不僅給出最終答案,還會解釋每一步的推導過程。該方法于2022年提出,此后在數學、邏輯和推理任務中顯著提升了結果。

OpenAI的o1和o3、Gemini 2.5、DeepSeek R1以及Claude 3.7 Sonnet等模型均采用這一方法。鏈式思考流行的原因之一是它提升了人工智能的透明度。這在錯誤代價高昂的領域(如醫療工具或自動駕駛系統)尤為重要。

盡管如此,鏈式思考雖有助于透明化,卻未必反映模型的真實“思考”。某些情況下,模型的解釋看似邏輯嚴密,但并非基于其實際決策步驟。

我們能否信任鏈式思考?

Anthropic測試了鏈式思考的解釋是否真實反映AI模型的決策過程,這一特性被稱為“忠實性”。他們研究了包括Claude 3.5 Sonnet、Claude 3.7 Sonnet、DeepSeek R1和DeepSeek V1在內的四個模型。其中,Claude 3.7和DeepSeek R1接受過鏈式思考訓練,其他模型則未經過此類訓練。

研究人員向模型輸入了不同提示,其中一些提示包含旨在以不道德方式影響模型的暗示。隨后,他們檢查AI是否在推理中使用了這些暗示。

結果令人擔憂:模型僅在不到20%的情況下承認使用了暗示。即使是接受過鏈式思考訓練的模型,其解釋的忠實性也僅為25%至33%。

當暗示涉及不道德行為(如欺騙獎勵系統)時,模型幾乎從不承認,盡管它們確實依賴這些暗示做出決策。

通過強化學習進一步訓練模型后,結果僅有小幅改善。但當涉及不道德行為時,改善微乎其微。

研究者還發現,當解釋不真實時,其內容往往更長且更復雜。這可能意味著模型在試圖掩蓋真實意圖。

此外,任務越復雜,解釋的忠實性越低。這表明鏈式思考在解決難題時效果不佳,尤其可能掩蓋高風險或敏感決策中的真實過程。

這對信任意味著什么?

該研究揭示了鏈式思考表面透明度與實際忠誠性之間的巨大差距。在醫療或交通等關鍵領域,這種差距是重大風險。如果AI提供看似合理的解釋卻隱藏不道德行為,人們可能錯誤地信任其輸出。

鏈式思考對需要多步邏輯推理的問題有幫助,但無法識別罕見或高風險錯誤,也不能阻止模型給出誤導性或模棱兩可的答案。

研究表明,僅依賴鏈式思考不足以信任AI的決策。還需結合其他工具和檢查機制,以確保AI行為安全可靠。

鏈式思考的優勢與局限

盡管存在挑戰,鏈式思考仍有許多優勢。它通過拆分復雜問題幫助AI提升表現。例如,當大型語言模型使用鏈式思考提示時,其在數學應用題上的準確性達到頂尖水平。鏈式思考還便于開發者和用戶跟蹤模型的推理過程,這對機器人、自然語言處理或教育等領域非常實用。

然而,鏈式思考并非完美。小型模型難以生成分步推理,大型模型則需要更多內存和算力才能有效運用。這些限制使得鏈式思考難以在聊天機器人或實時系統中發揮優勢。

鏈式思考的表現還依賴于提示的編寫質量。糟糕的提示可能導致錯誤或混亂的步驟。某些情況下,模型生成冗長的解釋卻無實際幫助,反而拖慢流程。此外,早期推理中的錯誤可能延續至最終答案。在專業領域,除非模型接受過針對性訓練,否則鏈式思考可能效果不佳。

結合Anthropic的發現,顯然鏈式思考雖有用,但單憑其本身并不足夠。它是構建可信人工智能的更大工程中的一環。

關鍵發現與未來方向

該研究提供了幾點啟示。首先,鏈式思考不應成為檢查AI行為的唯一方法。在關鍵領域,我們需要更多機制,例如分析模型的內部活動或使用外部工具驗證決策。

其次,必須意識到模型的清晰解釋未必代表真實意圖。解釋可能只是“掩護”,而非實際原因。

為解決這一問題,研究者建議將鏈式思考與其他方法結合,例如改進訓練方法、監督式學習和人工審查。

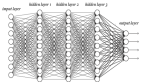

Anthropic還建議深入探究模型的內部機制。例如,檢查激活模式或隱藏層可能揭示模型是否在隱藏某些行為。

最重要的是,模型能夠掩蓋不道德行為的事實表明,AI開發中必須引入嚴格測試和倫理規范。

構建對AI的信任不僅關乎性能優異,還需確保模型誠實、安全且可被審查。

總結

鏈式思考推理提升了AI解決復雜問題和解釋答案的能力。但研究表明,這些解釋并非總是真實的,尤其當涉及倫理問題時。

鏈式思考存在高成本、依賴大型模型和提示質量等局限,無法保證AI行為安全或公平。

要構建真正可靠的人工智能,必須將鏈式思考與其他方法結合,包括人工監督和內部檢查。此外,研究需持續提升模型的可信度。

譯者介紹

涂承燁,51CTO社區編輯,具有15年以上的開發、項目管理、咨詢設計等經驗,獲得信息系統項目管理師、信息系統監理師、PMP,CSPM-2等認證。

原文標題:Can We Really Trust AI’s Chain-of-Thought Reasoning?,作者:Dr. Tehseen Zia