極低成本,復現GPT-4o圖像風格化一致性!NUS推出OmniConsistency

本文由 NUS ShowLab 主導完成。第一作者宋亦仁為新加坡國立大學 ShowLab@NUS 在讀博士生,研究方向是視覺生成和多模態,在 CVPR、SIGGRAPH、NeurIPS 等國際頂級會議上發表多篇研究成果。共同一作劉成為 NUS 重慶研究院四年級本科生,研究方向是視覺生成。項目負責作者為該校校長青年教授壽政。

不久前,GPT-4o 的最新圖像風格化與編輯能力橫空出世,用吉卜力等風格生成的效果令人驚艷,也讓我們清晰看到了開源社區與商業 API 在圖像風格化一致性上的巨大差距。

目前,開源擴散模型在 image-to-image 風格遷移中普遍面臨一個蹺蹺板困境:要想增強風格化效果,往往會犧牲細節、結構和語義一致性;而要保持一致性,風格表達則明顯退化。

為了解決這一難題,我們提出 OmniConsistency,利用配對數據復現 GPT-4o 的出色風格化一致性,為開源生態注入接近商業級的能力。

- 論文標題:OmniConsistency: Learning Style-Agnostic Consistency from Paired Stylization Data

- 項目主頁:https://github.com/showlab/OmniConsistency

- 論文鏈接:https://arxiv.org/abs/2505.18445

- Demo 試用鏈接:https://huggingface.co/spaces/yiren98/OmniConsistency

我們的解決方案:OmniConsistency

我們提出 OmniConsistency, 一個基于 DiT 的通用一致性增強插件,它可以在保持強烈風格化效果的同時,精準保留輸入圖像的細節、語義和結構。

OmniConsistency 的訓練僅用了 2600 對 GPT-4o 生成的高質量圖像,全流程只用約 500 小時 GPU 算力,成本極低。

OmniConsistency 有哪些亮點?來看三句話總結:

? 解決風格化與一致性之間的蹺蹺板問題

? 即插即用,兼容社區任意 Flux 底模的風格 LoRA

? 輕量高效,效果出色,媲美 GPT-4o

為什么現有方法會出現風格退化?

目前各大廠商的 AI 圖生圖業務的主流做法是組合風格化 LoRA + 一致性插件 + image2image pipeline。在特定風格數據上微調得到的風格 LoRA 模塊,能夠在文本到圖像(text-to-image, T2I)任務中實現高質量風格圖像生成。一致性模塊(如 ControlNet、IP-Adapter、Redux 等)負責在圖像到圖像(image-to-image, I2I)任務中維持結構、邊緣或姿態等條件,允許使用更大的去噪強度來獲得更強的風格化效果。

問題是,當把這兩類模塊組合在一起用時,風格模塊要的 “自由發揮” 和一致性模塊要的 “嚴謹控制” 彼此掣肘。尤其在 I2I 任務中,風格表達往往會被削弱,出現明顯的風格退化。換句話說,現有方法被困在風格化強度和一致性之間的蹺蹺板上,無法兩全。

方法介紹:OmniConsistency 的核心設計

OmniConsistency 的核心目標是打破圖像風格化任務中 “風格表達” 與 “一致性保持” 之間的蹺蹺板困境。為了解決這一問題,我們提出了一種全新的、風格 - 一致性解耦學習方法,其包括以下三項關鍵設計:

1. In-Context 一致性學習框架:從數據對學習

OmniConsistency 創新性地提出了一種基于風格化圖像對的一致性學習機制:不是像現有方法那樣先在風格結果上訓練 LoRA,再用一致性插件去適配(這往往帶來沖突);而是直接利用原圖與其高一致性風格化結果的成對關系,專門學習圖像在風格遷移中的一致性保持規律。

具體做法是:將原圖經過 VAE 編碼得到的 clean latent token 拼接到 denoise token 上,通過因果注意力機制引導模型學習配對圖像風格化前后的一致性。

2. 兩階段風格 - 一致性解耦訓練策略:穩健泛化的關鍵

為了從訓練策略上徹底分離風格表達與一致性保持,我們采用了階段化解耦訓練機制:

- 第一階段:風格學習。我們基于 22 種不同的藝術風格,用風格化結果圖為每種風格獨立訓練一個 LoRA 模塊,最終構建出一個穩定的 風格 LoRA 模塊庫。

- 第二階段:一致性學習。在該階段,我們凍結所有風格 LoRA,用風格化前后的配對數據訓練一個輕量級的一致性模塊(Consistency LoRA)。我們設計了 LoRA Bank 滾動加載機制,即訓練時動態輪換風格 LoRA 與其對應的訓練子集。這樣能確保一致性模塊專注于跨風格保持結構和語義,而不學習任何具體風格內容。

這種訓練解耦策略在保持風格表達能力的同時,極大提升了模型對多風格場景下的一致性泛化能力。

3. 模塊化架構設計:即插即用,兼容性強

OmniConsistency 被設計為一套完全模塊化的插拔系統,兼容性極強:

- Plug-and-Play LoRA:一致性模塊專門作用于條件分支,與風格 LoRA 使用獨立 “插槽”,二者在架構上無參數沖突。因此,任何 HuggingFace 社區風格 LoRA 模型均可直接與 OmniConsistency 聯動,無需修改或重訓練。

- 因果注意力:不同于 Flux 和之前的可控性生成工作, 我們將雙向注意力機制改成 Causal Attention. 我們定義了一個注意力 mask, 限制 Condition token 的 Query 和 Noised&Text Token 的 Key 計算注意力。 這樣的好處是 Flux 的 Noised&Text 分支上沒有新增可訓練的 LoRA 參數, 完全為風格化 LoRA 騰出掛載位點。

- 兼容 EasyControl/ IP-Adapter 等控制信號:由于一致性模塊采用因果注意力 + 條件注入策略,其他控制方法也可無縫集成,互不干擾。

數據集構建

我們采用 GPT-4o 自動生成了一套高質量配對數據:設計 22 種不同風格的提示詞,上傳原始圖像,生成對應的風格化版本,還配上詳細文本描述。

然后,我們通過人工篩選,剔除了風格不一致、細節錯誤、姿態錯位等問題圖,最終精選出 2600 對高質量圖像對,涵蓋了動漫、素描、像素畫、水彩、賽博朋克等風格。

效果如何?

直接上圖, OmniConsistency 能很好的維持風格化前后構圖、語義、細節一致,對人物面部特征的維持也有一定作用。對多人合影等復雜場景,很好的維持了人數、姿勢、性別、種族、年齡,甚至還能維持圖片中的英文文字正確性。

OmniConsistency 對訓練階段沒見過的風格 LoRA 也有很好的泛化作用。

定量評估

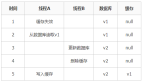

論文構建了一個全新數據集,包括:22 種風格、2600 對高質量圖像對, 由 GPT-4o 構建并進行人工篩選。用 100 張復雜場景測試圖(多人合影、建筑、動物等)作為 benchmark。使用 LibLib 網站上 5 個訓練階段未見過的全新風格 LoRA ,進行定量計算。

采用用多項指標全面評估,包括風格一致性評估(FID、CMMD、DreamSim、CLIP Image Score、GPT-4o Score);內容一致性評估(DreamSim、CLIP Image Score、GPT-4o 評分);圖文對齊(CLIP Score)。

總結

風格一致性:FID 和 CMMD 指標顯著優于基線,風格化程度接近 LoRA 文生圖 效果。

內容一致性:復雜場景下的細節、語義、結構保持能力大幅提升。

泛化能力:在未見過的 LoRA 風格上泛化效果出色,顯示出強大的風格無關性。

輕量高效:得益于特征復用和位置編碼差值技術,推理顯存與時間開銷相比 Flux text2image pipeline 僅增加約 5%,適合部署到生產環境。

即插即用、廣泛兼容:模塊化設計支持與社區 LoRA、EasyControl、IPAdapter 等主流插件無縫集成,無需重訓即可使用。