DR-RAG:理想汽車最新RAG研究成果,準確率和響應時間遠超其他RAG框架

1. DR-RAG有多厲害?

圖片

圖片

圖片

圖片

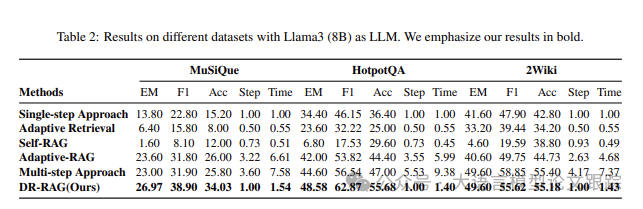

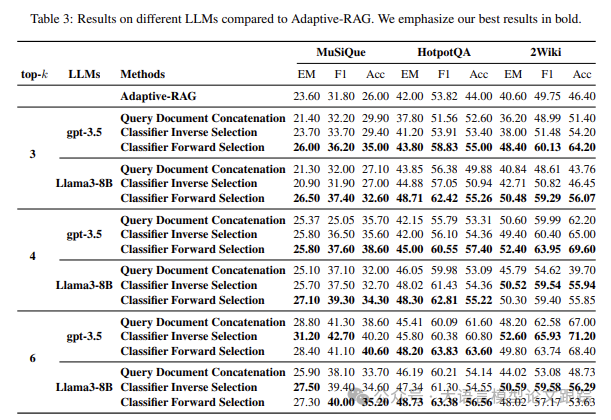

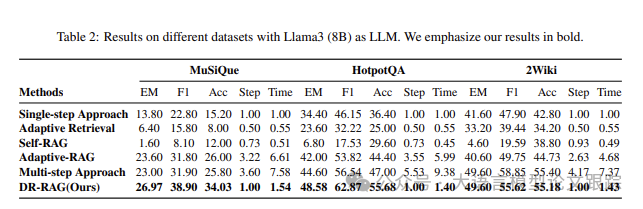

上面兩個表分別展示了DR-RAG與其他幾個當前流行的RAG框架對比的效果,特別是Adaptive RAG。可以看到,在多個測試數據集上,DR-RAG要比其他框架(比如:Adaptive RAG和Self RAG)準確率都要更高。而且在相同TopK參數的前提下,DR-RAG的召回率更高,從而回答正確的比例也越高。

圖片

圖片

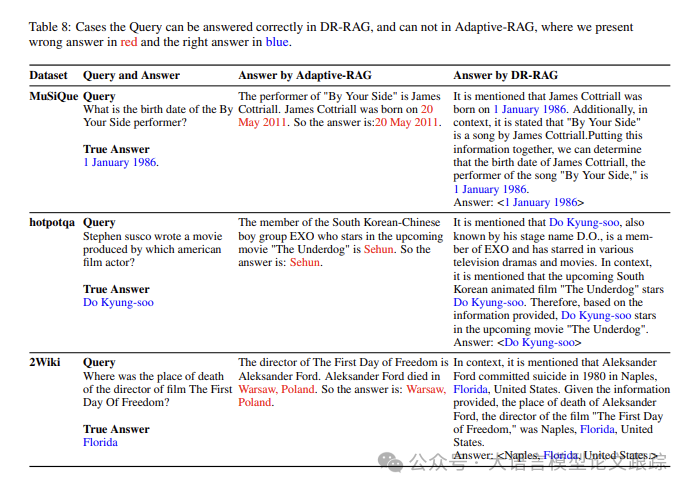

上面這個圖展示了DR-RAG與Adaptive RAG對比的一些例子,從例子里可以看出,DR-RAG在一些問題上,比Adaptive RAG回答的更準確。

圖片

圖片

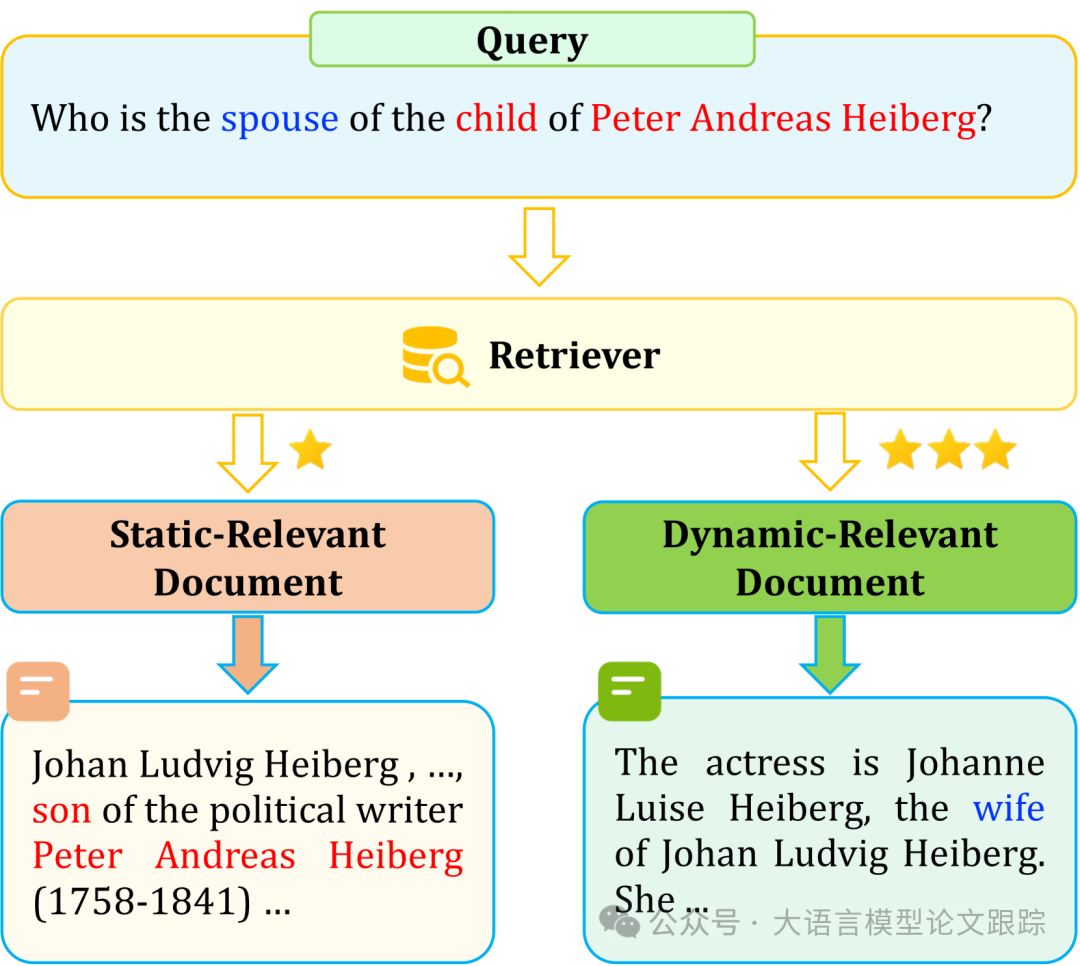

比如上面這個圖里的例子,傳統檢索器能夠輕松地獲取高相關性的靜態文檔(用紅色標出),卻難以捕獲那些雖然相關性不高(用藍色標出),但對于問題答案至關重要的動態文檔。

靜態相關文檔(Static-Relevant Documents,SRD):對答案生成至關重要且緊密相關的文檔。

動態相關文檔(Dynamic-Relevant Documents,DRD):相關性不高,但對答案生成同樣關鍵的文檔。

對于 “誰是彼得·安德烈亞斯·海伯格孩子的妻子?”這個問題,與“彼得·安德烈亞斯·海伯格”和“孩子/兒子”高度相關的靜態相關文檔(上圖以紅色標出)較容易被檢索。然而,動態相關文檔(以藍色標出)由于只與查詢中的“配偶/妻子”相關,因此難以被檢索。

知識庫中關于“配偶”的信息可能非常多,導致這些動態相關文檔在檢索過程中排名較低。在靜態和動態相關文檔之間,“約翰·路德維格·海伯格”與“妻子”之間的聯系非常緊密。如果將查詢中的“配偶/妻子”也納入考慮,便能輕松地檢索到動態相關文檔,從而得出答案。

2. 什么是DR-RAG?

DR-RAG是指:Dynamic Relevant Retrieval-Augmented Generation,動態相關檢索增強生成。該方法是由理想汽車團隊與中山大學、東北大學和四川大學等共同提出的一種新方法。

圖片

圖片

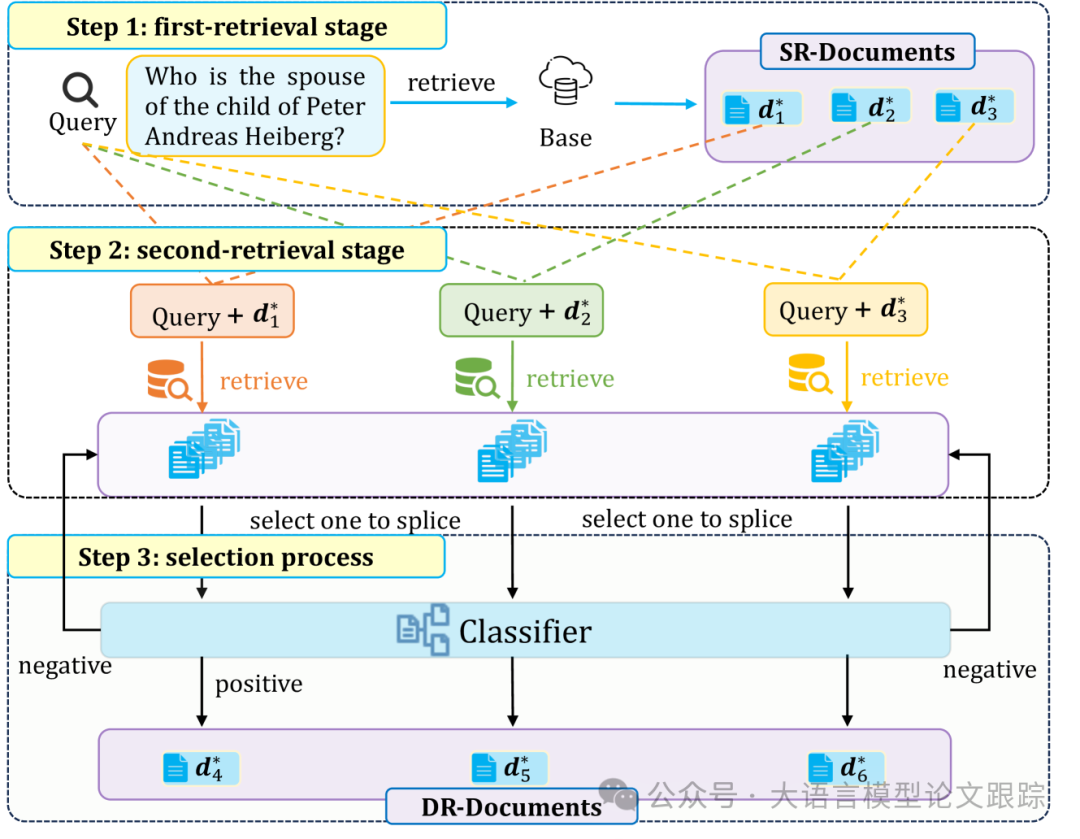

第一部分的例子,我們看到了DR-RAG擅長回答的問題類型:發現相關性不高,但是對回答問題很重要的文檔。之所以DR-RAG如此厲害,是因為DR-RAG采用了一種兩步檢索框架,用于挖掘查詢和文檔之間的相關性。

圖片

圖片

如上圖:

? 第一步,根據與查詢的高相關度檢索靜態相關文檔(SR-Documents)。

? 第二步,將這些靜態文檔與查詢結合,以檢索一系列動態相關文檔(DR-Documents)。

? 最終,逐一挑選DR-Documents,將其與查詢及靜態文檔串聯,輸入分類器,以篩選出最具相關性的動態文檔。

遺憾的是,找遍了整篇論文,好像沒有找到有關這個分類器如何得到、如何復現的一些細節(也許是我漏掉了)

為了讓RAG回答問題更加準確,需要盡可能給出與回答問題最重要的文檔;因此,我們必須檢索非常多文檔,以讓模型給出更加全面的回答。

DR-RAG的宗旨是從檢索到的文檔中篩選出最相關、最重要的文檔,并且確保不遺漏LLM回答問題所需的關鍵信息。而實際上,僅憑相似性匹配(SM)很難一網打盡所有靜態和動態相關的文檔。

通常,大家會通過推升K值來增加DRD的概率,比如:在MuSiQue系統中,將k值從3增至6,僅將召回率從58%提升至76%,依然有許多相關文檔未能被檢索。此外,不相關的文檔可能會給LLMs帶來冗余信息。

所以,DR-RAG實際上是在保持top-k不變的情況下,通過提升基于動態相關性的文檔召回率,來改善檢索效果。

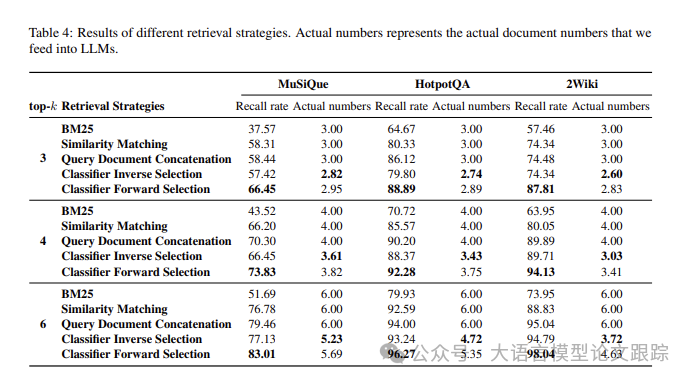

3. 性能分析

3.1 召回率對LLM的影響

圖片

圖片

召回率對RAG和LLM至關重要。因為當召回率不高時,模型接觸的信息不完整、或者缺失,那么容易產生“幻覺”的模型則難以準確回答問題。在2Wiki數據集中,DR-RAG在僅選擇前6個文檔時,已經達到了98%的高回憶率。

3.2 冗余信息對LLM的影響

若上下文中的冗余信息得以減少,大型語言模型便能更透徹地理解查詢,減少誤解。隨著輸入模型的文檔數量增多,無效信息可能激增約三成,但模型在作答時卻難以辨識。模型或許會依賴這些冗余信息,給出錯誤的答案。

在RAG過程中,應盡可能減少向模型提供冗余或不準確的信息。

以2Wiki數據集為例,當提供給模型的文檔數量k為4或6時,從CIS(Classifier Inverse Selection)過渡到CFS(Classifier Forward Selection),召回率的提升并不顯著,反而在評價指標上有所降低。因此,作者提出了CFS方法,用來平衡信息的冗余度和相關性。

3.3 用更少的文檔來提升召回率

CFS策略在降低文檔數量的同時提高回憶率。在二次檢索過程中,由于所需文檔已被檢索,為每對查詢-文檔找到匹配項似乎成了不可能的任務。這導致實際檢索到的文檔數量可能少于預定的k。以HotpotQA數據集為例,當k設為6,實際上平均只有5.35份文檔被提供給LLMs,這在一定程度上減少了無關信息的干擾。

CFS方法在減少實際檢索文檔數量的同時,與QDC(Query Documents Concatenation)方法相比,實現了更高的回憶率。CFS方法在三大評價指標上均獲得了更高的分數,證明了其在減少冗余輸入的情況下,相比其他方法具有更卓越的檢索性能。

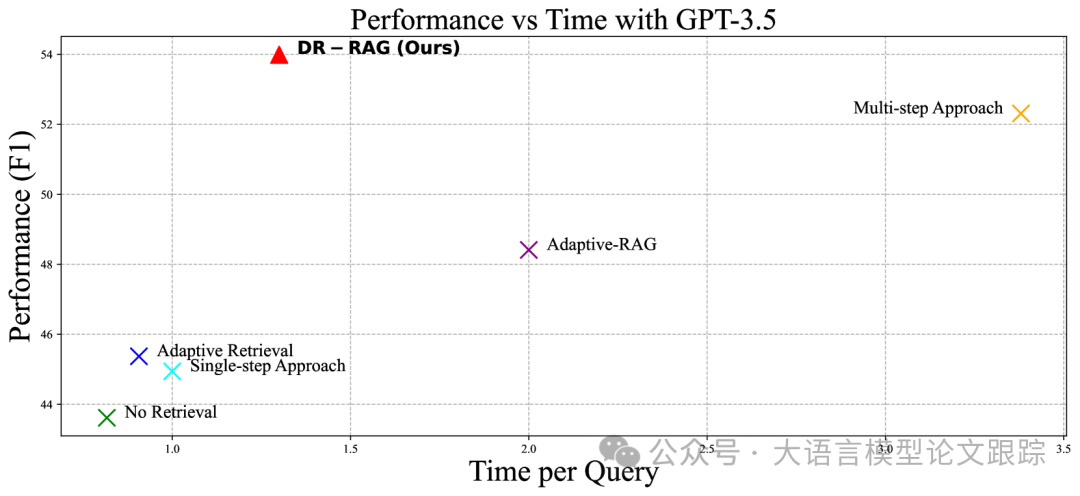

3.4 響應速度優化

圖片

圖片

相較于以往的RAG框架,DR-RAG在整體流程中實現了更優的時間管理。其他RAG框架在獲取答案前可能需多次調用LLMs,造成高昂的計算開銷。實際上,優化LLMs的推理時間在實際應用中同樣重要。單次調用LLMs就需耗費大量時間,多次調用則在時間成本上構成巨大挑戰。

圖片

圖片

為此,作者設計一個小規模、參數較少的模型,以實現更高效的優化策略,避免頻繁調用LLMs。如上表所示,與Adaptive-RAG相比,我們平均減少了74.2%的時間消耗。因此,DR-RAG在實驗效率上的提升,以及在時間成本上的優勢,使其在實際工程應用中具有重要價值。

? 論文原文: https://arxiv.org/abs/2406.07348