Mobile-Agent-v2:GPT4v + 多Agent提高40%準(zhǔn)確率 精華

1. Mobile-Agent-V2是什么?

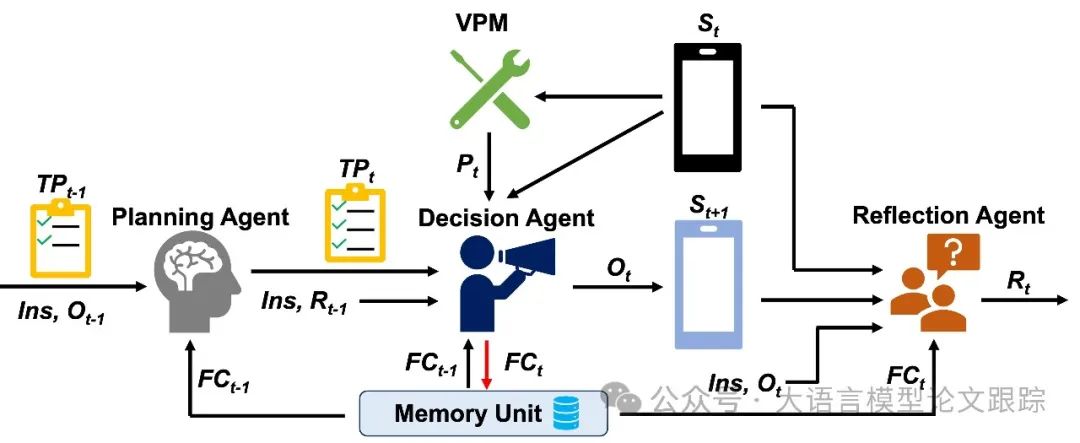

Mobile-Agent-v2是一款通過(guò)多Agent合作實(shí)現(xiàn)有效導(dǎo)航的移動(dòng)設(shè)備操作助手。它包含三個(gè)專(zhuān)業(yè)角色:規(guī)劃Agent、決策Agent和反思Agent。

? 規(guī)劃Agent負(fù)責(zé)根據(jù)歷史操作生成任務(wù)進(jìn)度,并通過(guò)設(shè)計(jì)的記憶單元保存歷史屏幕中的焦點(diǎn)內(nèi)容。

? 決策Agent在生成操作時(shí)會(huì)參考記憶單元,并檢查屏幕上的焦點(diǎn)內(nèi)容,同時(shí)更新記憶。

? 反思Agent則觀察決策代理操作前后屏幕的變化,評(píng)估操作是否達(dá)到預(yù)期,并在必要時(shí)采取措施重新執(zhí)行。

三個(gè)角色在進(jìn)度、決策和反思階段各司其職,共同協(xié)作,以簡(jiǎn)化導(dǎo)航的復(fù)雜性。

圖片

圖片

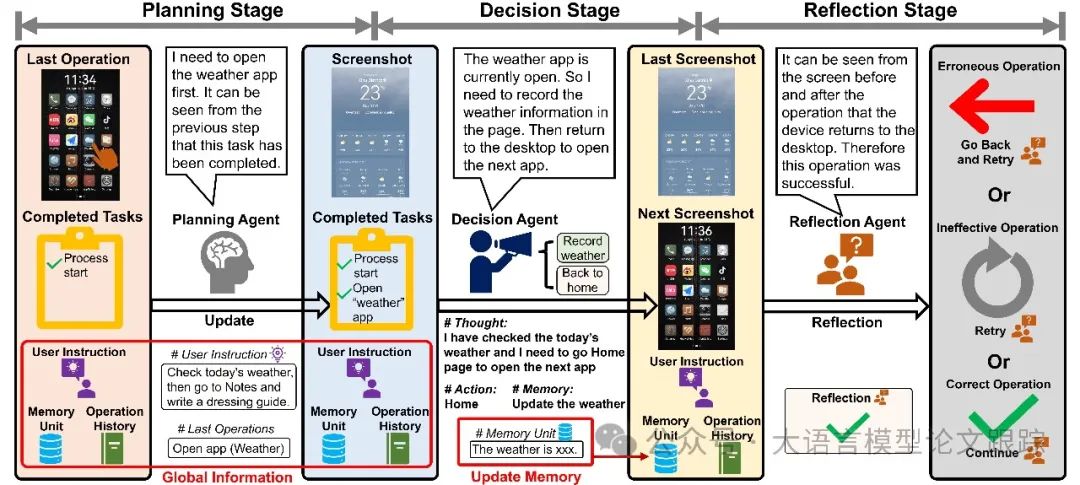

Mobile-Agent-v2 的運(yùn)作是循環(huán)迭代的,其流程上圖。為了提升代理對(duì)屏幕的識(shí)別力和從歷史記錄中導(dǎo)航焦點(diǎn)內(nèi)容的能力,特別設(shè)計(jì)了視覺(jué)感知模塊和記憶單元。規(guī)劃代理首先更新任務(wù)進(jìn)度,決策代理?yè)?jù)此導(dǎo)航當(dāng)前任務(wù)的發(fā)展。決策代理隨后根據(jù)任務(wù)進(jìn)度、屏幕狀態(tài)以及前一次操作的反饋(如果有誤)來(lái)執(zhí)行任務(wù)。操作后,反思代理會(huì)對(duì)比操作前后的屏幕,判斷操作是否達(dá)到預(yù)期效果。

1.1 視覺(jué)感知模塊

即便是最先進(jìn)的 MLLMs,在端到端處理屏幕識(shí)別時(shí)也面臨挑戰(zhàn)。為此,集成了視覺(jué)感知模塊來(lái)強(qiáng)化這一功能。該模塊包含三種工具:文本識(shí)別、圖標(biāo)識(shí)別和圖標(biāo)描述。將截屏輸入模塊,可以提取出屏幕上的文本和圖標(biāo)信息及其坐標(biāo)。

1.2 記憶模塊

圖片

圖片

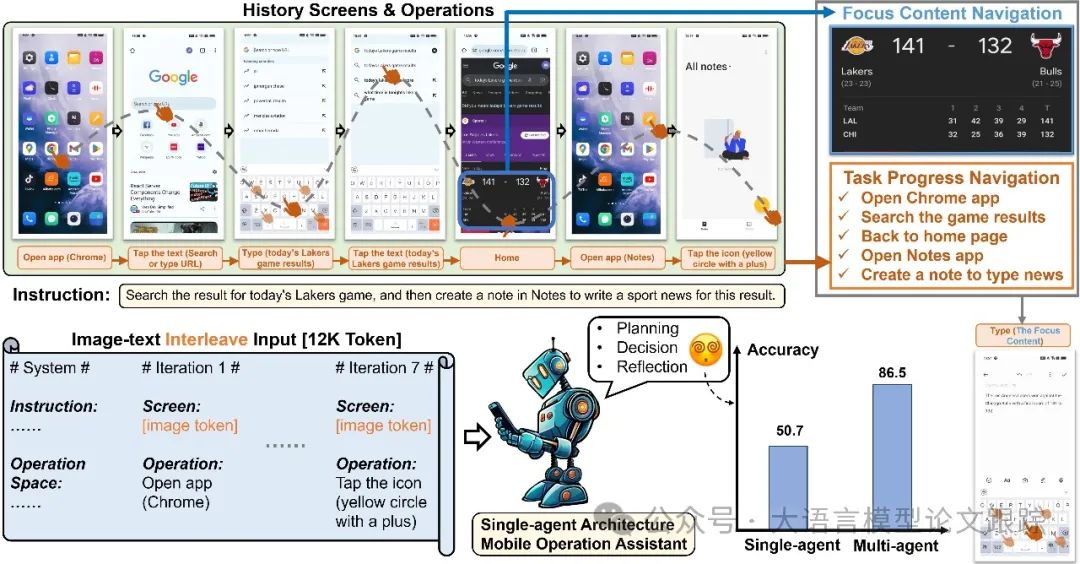

鑒于規(guī)劃代理產(chǎn)出的任務(wù)進(jìn)度以文本形式展現(xiàn),從歷史屏幕中導(dǎo)航焦點(diǎn)內(nèi)容依舊充滿(mǎn)挑戰(zhàn)。為應(yīng)對(duì)這一難題,構(gòu)建了一個(gè)記憶模塊,用以保存與當(dāng)前任務(wù)相關(guān)聯(lián)的歷史屏幕焦點(diǎn)內(nèi)容。此記憶單元作為短期記憶模塊,伴隨任務(wù)進(jìn)展而實(shí)時(shí)更新。在涉及多個(gè)應(yīng)用的復(fù)雜場(chǎng)景中,記憶單元發(fā)揮著關(guān)鍵作用。例如,在上圖展示的情形中,決策代理所捕捉的天氣信息將在后續(xù)步驟中發(fā)揮作用,此時(shí),與天氣應(yīng)用頁(yè)面相關(guān)的信息會(huì)被同步更新至記憶單元。

1.3 規(guī)劃Agent

圖片

圖片

為了降低決策過(guò)程中對(duì)冗長(zhǎng)歷史操作的依賴(lài),引入了獨(dú)立的規(guī)劃代理。盡管每次操作發(fā)生在不同的頁(yè)面且各有差異,但許多操作的目標(biāo)往往是一致的。以上圖中的例子為例,前四次操作均旨在查找比賽結(jié)果。因此,設(shè)計(jì)了規(guī)劃代理,旨在歸納歷史操作并追蹤任務(wù)的進(jìn)展。

1.4 決策Agent

決策代理在決策階段運(yùn)行,生成操作動(dòng)作并在設(shè)備上執(zhí)行它們,同時(shí)還負(fù)責(zé)更新記憶單元中的焦點(diǎn)內(nèi)容。

操作空間:為了降低操作的復(fù)雜性,作者設(shè)計(jì)了一個(gè)操作空間,并限制決策代理僅從此空間中選擇操作。對(duì)于自由度較高的操作,如點(diǎn)擊和滑動(dòng),引入了一個(gè)額外的參數(shù)空間來(lái)定位或處理特定內(nèi)容。以下是操作空間的詳細(xì)描述:

? 打開(kāi)應(yīng)用(應(yīng)用名稱(chēng))。如果當(dāng)前頁(yè)面是主頁(yè),可以使用此操作打開(kāi)名為“應(yīng)用名稱(chēng)”的應(yīng)用。

? 點(diǎn)擊(x,y)。此操作用于點(diǎn)擊坐標(biāo)為(x,y)的位置。

? 滑動(dòng)(x1,y1),(x2,y2)。此操作用于從坐標(biāo)為(x1,y1)的位置滑動(dòng)到坐標(biāo)為(x2,y2)的位置。

? 輸入(文本)。如果當(dāng)前鍵盤(pán)處于激活狀態(tài),可以使用此操作在輸入框中輸入“文本”的內(nèi)容。

? 主頁(yè)。此操作用于從任何頁(yè)面返回到主頁(yè)。

? 停止。如果決策代理認(rèn)為所有要求都已滿(mǎn)足,可以使用此操作來(lái)終止整個(gè)操作過(guò)程。

記憶單元更新:由于決策代理所做的每項(xiàng)操作都與任務(wù)高度相關(guān),并基于當(dāng)前頁(yè)面的視覺(jué)感知結(jié)果,因此非常適合在屏幕頁(yè)面內(nèi)觀察與任務(wù)相關(guān)的焦點(diǎn)內(nèi)容。因此,賦予了決策代理更新記憶單元的能力。在做出決策時(shí),決策代理會(huì)被提示觀察當(dāng)前屏幕頁(yè)面內(nèi)是否有與任務(wù)相關(guān)的焦點(diǎn)內(nèi)容。如果觀察到此類(lèi)信息,決策代理會(huì)將其更新到記憶中,供后續(xù)決策參考。

1.5 反思Agent

盡管配備了視覺(jué)感知模塊,Mobile-Agent-v2 有時(shí)仍會(huì)執(zhí)行出人意料的操作。在某些特定情境下,即便是頂尖的 MLLM 如 GPT-4V,也可能引發(fā)嚴(yán)重的誤判。為此,作者引入了反思代理,用以監(jiān)測(cè)決策代理操作前后屏幕的變化,判斷操作是否達(dá)到預(yù)期效果。

參照上面的架構(gòu)圖,反思代理在執(zhí)行操作后會(huì)得出三種反思結(jié)果:錯(cuò)誤操作、無(wú)效操作和正確操作。以下是對(duì)這三種結(jié)果的具體說(shuō)明:

? 錯(cuò)誤操作:指引導(dǎo)設(shè)備進(jìn)入與任務(wù)無(wú)關(guān)頁(yè)面的操作。比如,代理本想在通訊應(yīng)用中與聯(lián)系人 A 發(fā)消息,卻誤入了聯(lián)系人 B 的聊天界面。

? 無(wú)效操作:指對(duì)當(dāng)前頁(yè)面未產(chǎn)生任何變化的操作。比如,代理意圖點(diǎn)擊某個(gè)圖標(biāo),卻誤觸了圖標(biāo)旁邊的空白區(qū)域。

? 正確操作:指符合決策代理預(yù)期,并向完成用戶(hù)指令邁進(jìn)的操作。

遇到錯(cuò)誤操作時(shí),頁(yè)面將回退至操作前的狀態(tài);遇到無(wú)效操作時(shí),頁(yè)面保持不變。無(wú)論是錯(cuò)誤還是無(wú)效操作,都不會(huì)被記錄在操作歷史中,以避免代理重復(fù)無(wú)效的行為。而當(dāng)操作正確時(shí),相關(guān)信息將被更新至操作歷史,頁(yè)面狀態(tài)也將同步更新。

2. 效果測(cè)評(píng)

2.1 任務(wù)完成度評(píng)估

圖片

圖片

圖片

圖片

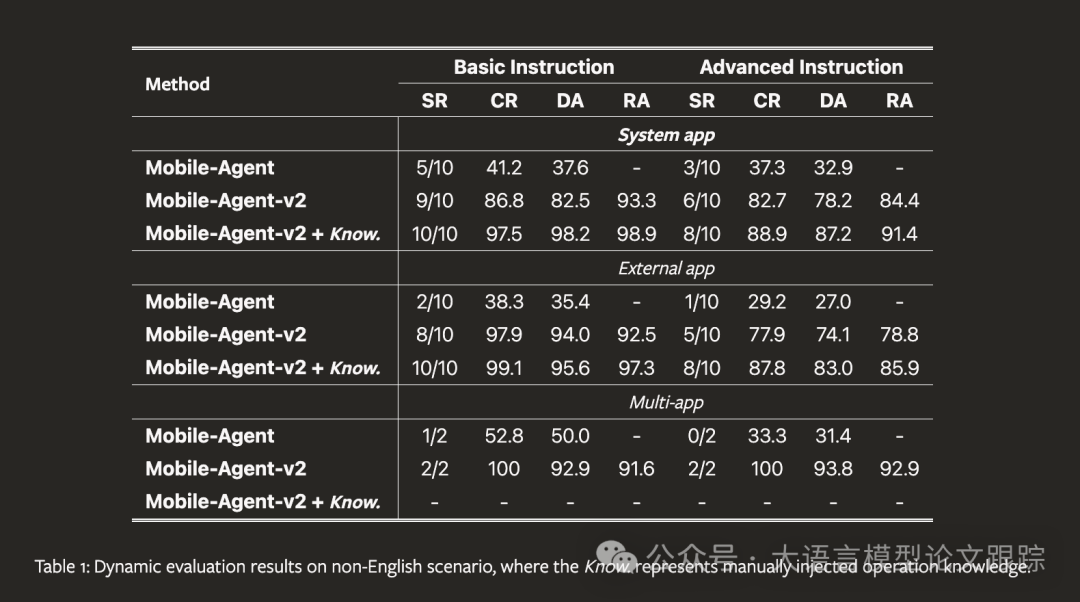

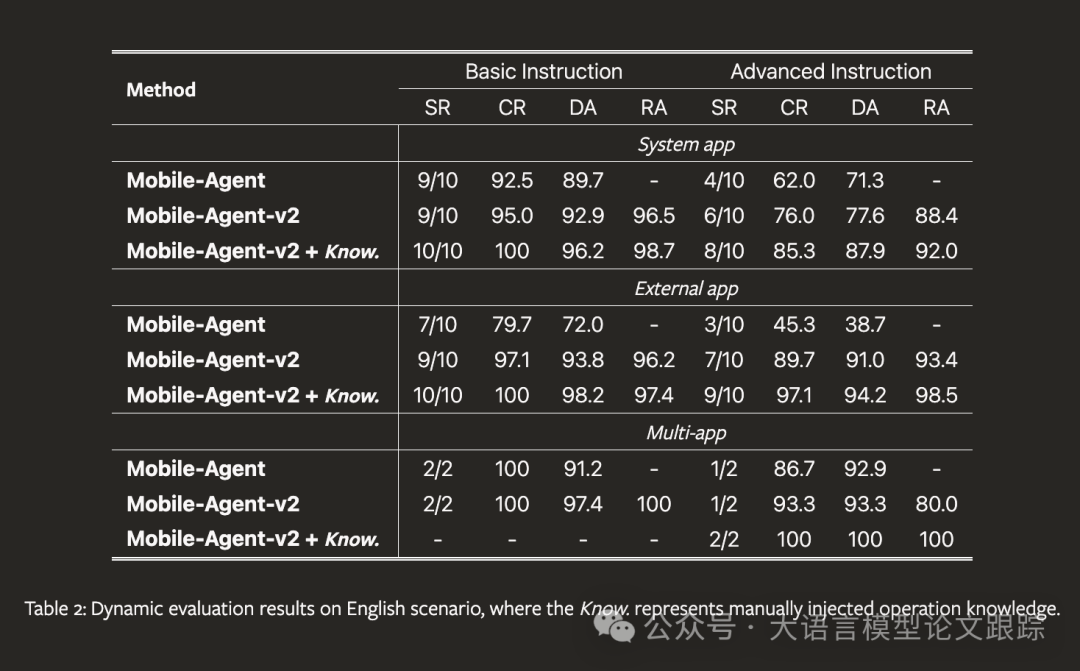

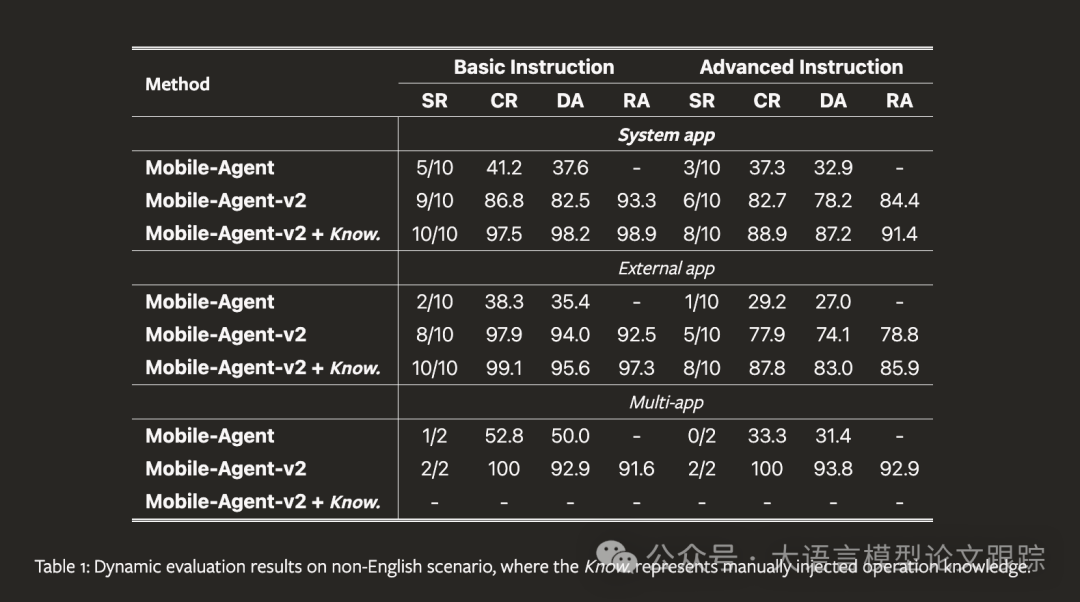

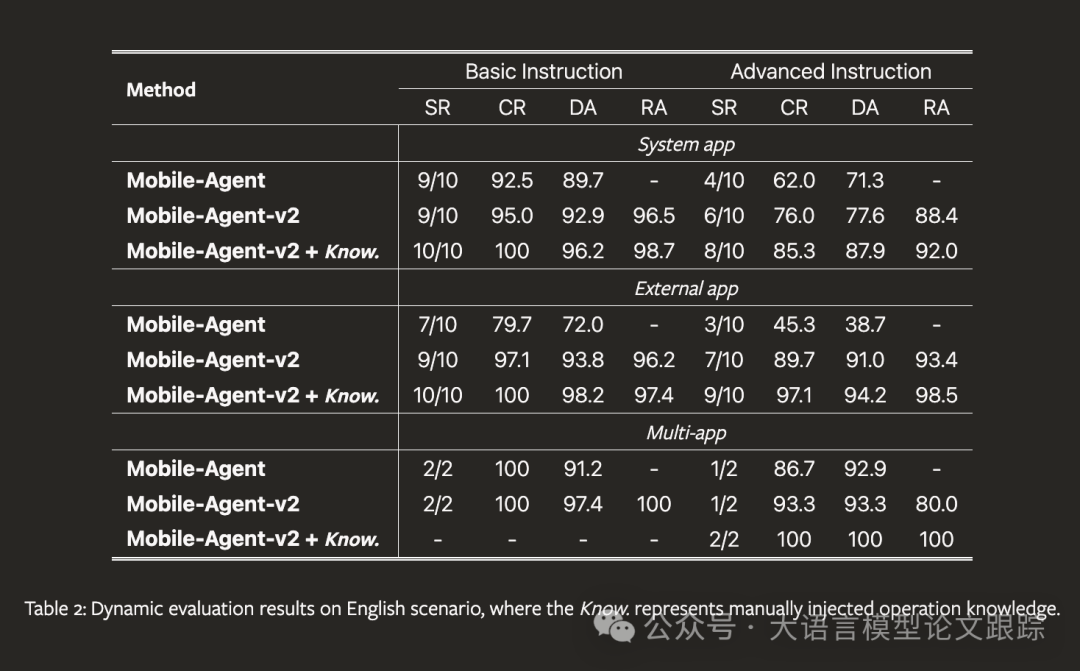

上面兩個(gè)表分別展示了Mobile-Agent-v2在非英語(yǔ)和英語(yǔ)環(huán)境下的性能表現(xiàn)。相較于Mobile-Agent,Mobile-Agent-v2在基礎(chǔ)和高級(jí)指令的執(zhí)行上均有顯著提升。得益于多代理架構(gòu)的支持,即便面對(duì)極具挑戰(zhàn)性的高級(jí)指令,**Mobile-Agent-v2的成功率也能達(dá)到55%**,遠(yuǎn)高于Mobile-Agent的20%。在英語(yǔ)環(huán)境下,Mobile-Agent-v2同樣實(shí)現(xiàn)了顯著的性能提升,其成功率平均提高了27%,即便在Mobile-Agent本就表現(xiàn)較好的英語(yǔ)場(chǎng)景中。

2.2 反思能力評(píng)估

即便在知識(shí)注入的情況下,**決策準(zhǔn)確率可能無(wú)法達(dá)到100%,但完成率卻能達(dá)到100%**。這說(shuō)明即便有外部知識(shí)輔助,Mobile-Agent-v2在決策時(shí)仍可能犯錯(cuò),正如人類(lèi)一樣,完全避免決策錯(cuò)誤是困難的。這突顯了反思代理的重要性。

2.3 應(yīng)用類(lèi)型評(píng)估

綜合各項(xiàng)指標(biāo),可以發(fā)現(xiàn)所有方法在系統(tǒng)應(yīng)用上的性能普遍優(yōu)于第三方應(yīng)用。從多應(yīng)用的評(píng)估結(jié)果來(lái)看,Mobile-Agent-v2在成功率和完成率上相較于Mobile-Agent分別提升了37.5%和44.2%。與單一應(yīng)用任務(wù)相比,跨應(yīng)用任務(wù)更依賴(lài)于歷史操作和焦點(diǎn)內(nèi)容的檢索。這一顯著的性能提升證明了Mobile-Agent-v2的多代理架構(gòu)和記憶單元在其中扮演了重要角色。

2.3 操作知識(shí)注入評(píng)估

圖片

圖片

圖片

圖片

從上面兩個(gè)表的知識(shí)注入結(jié)果來(lái)看,操作知識(shí)能顯著提高M(jìn)obile-Agent-v2的性能,表明人工注入的操作知識(shí)有助于克服代理在操作上的局限。這一發(fā)現(xiàn)意味著知識(shí)注入能夠擴(kuò)展Mobile-Agent-v2的應(yīng)用范圍,因?yàn)榧幢闶菑?fù)雜任務(wù),也可以通過(guò)人工編寫(xiě)的操作教程來(lái)指導(dǎo)代理完成。這為移動(dòng)設(shè)備自動(dòng)化腳本測(cè)試提供了新思路,表明通過(guò)自動(dòng)化生成高質(zhì)量的操作知識(shí),可以進(jìn)一步提升Mobile-Agent-v2的性能。此外,知識(shí)注入的成功也為未來(lái)移動(dòng)應(yīng)用測(cè)試開(kāi)辟了新的可能性。目前移動(dòng)應(yīng)用測(cè)試多依賴(lài)于手工腳本編寫(xiě),這限制了測(cè)試的普及性并提高了用戶(hù)使用門(mén)檻。通過(guò)將自然語(yǔ)言測(cè)試程序注入Mobile-Agent-v2,可以在移動(dòng)界面元素大小或顏色發(fā)生變化時(shí),保持系統(tǒng)的穩(wěn)定運(yùn)行,同時(shí)語(yǔ)言描述也省去了腳本編寫(xiě)中所需的知識(shí)庫(kù)。

2.4 MLLMs性能評(píng)估

圖片

圖片

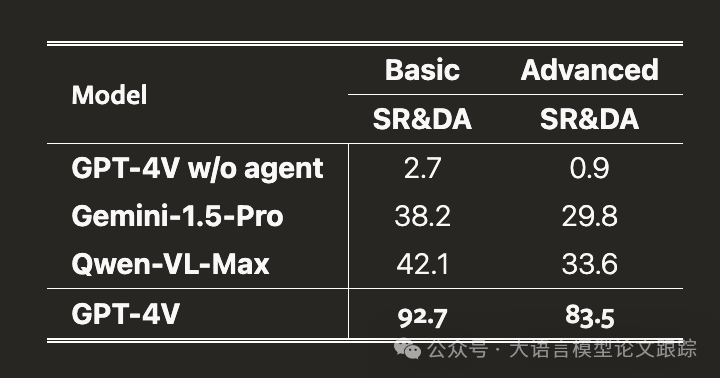

在上表中,對(duì)Mobile-Agent-v2框架下不同MLLMs的性能進(jìn)行了評(píng)估。由于部分模型不擅長(zhǎng)處理序列輸入,特別挑選了特定指令,并調(diào)整了每一步,使其成為獨(dú)立的單步任務(wù)。因此,僅評(píng)估了成功率(等同于決策準(zhǔn)確率)。我們還評(píng)估了繞過(guò)代理架構(gòu),直接使用GPT-4V進(jìn)行端到端操作的效果。結(jié)果顯示,直接使用GPT-4V作為移動(dòng)設(shè)備操作助手幾乎不可行。結(jié)合代理架構(gòu)使用的GPT-4V,仍然是實(shí)現(xiàn)操作能力的最優(yōu)配置。

3. 使用案例

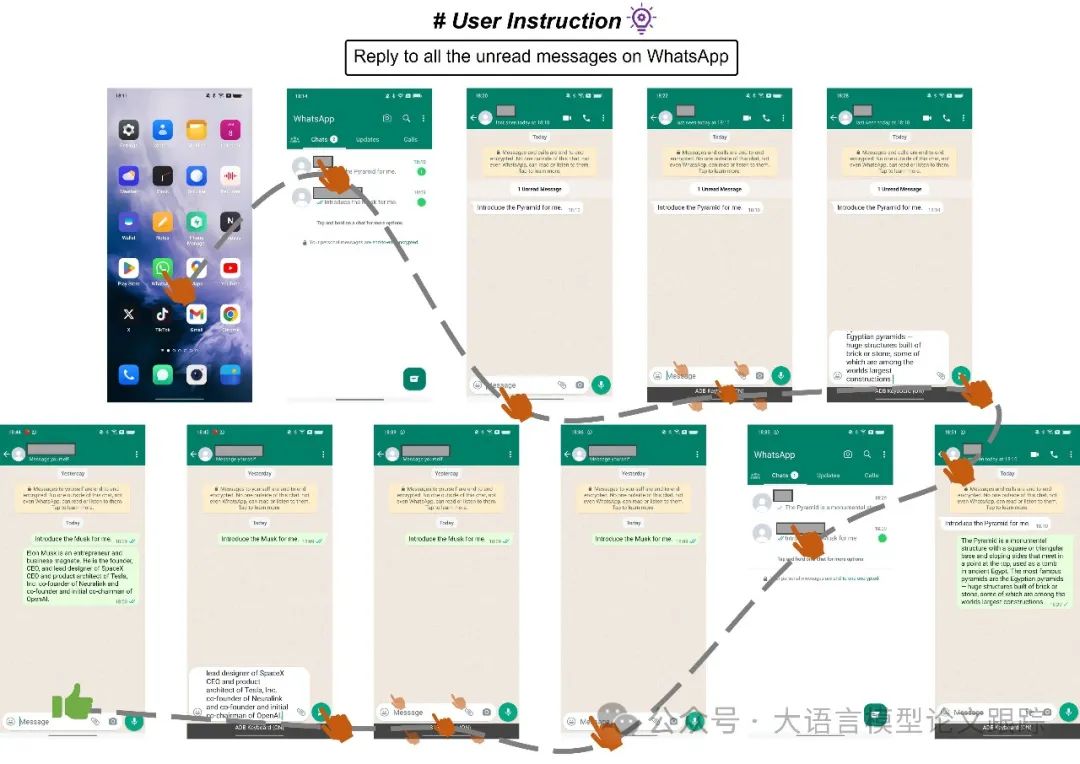

在WhatApp上回復(fù)消息:

圖片

圖片

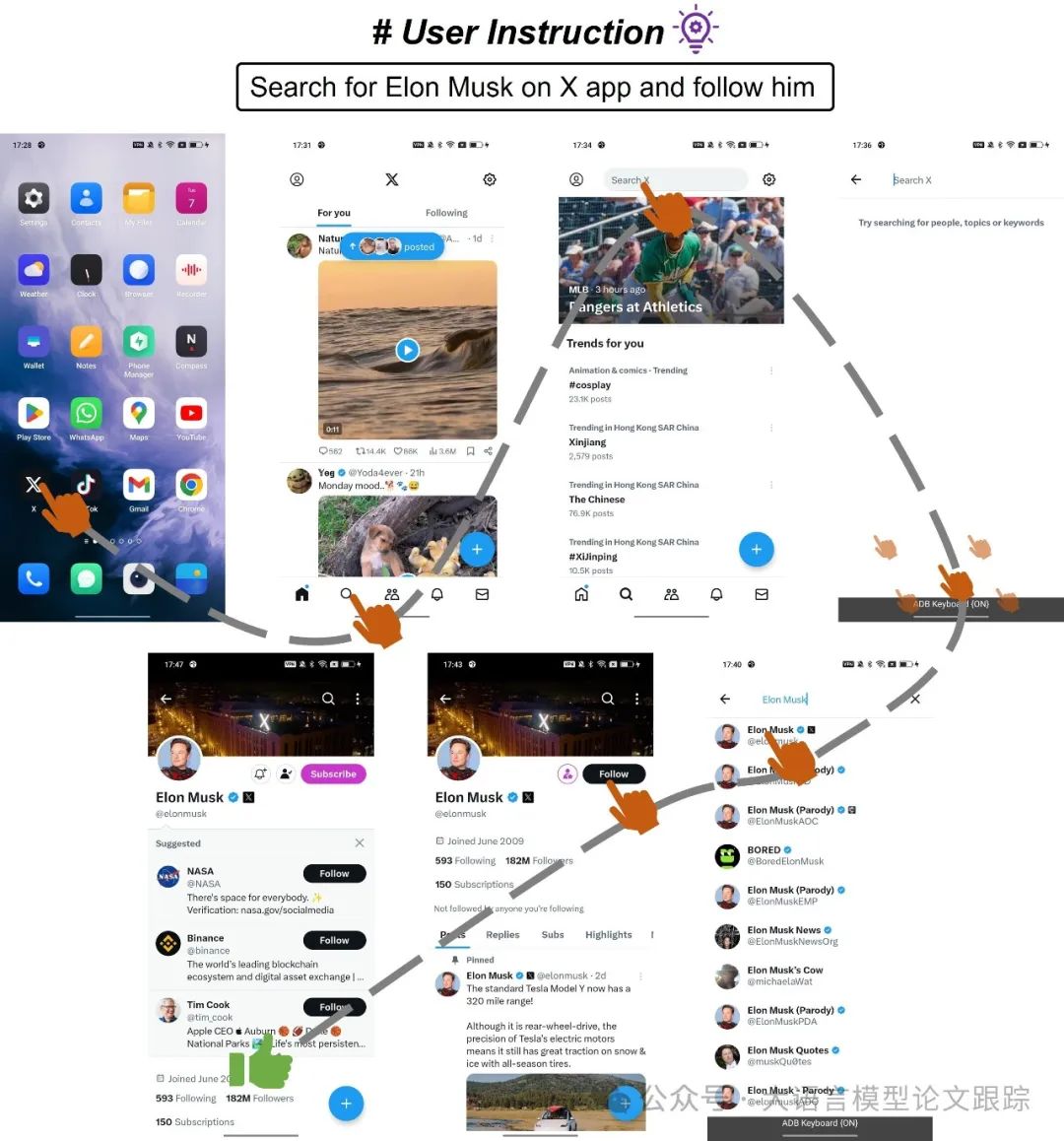

在社交媒體X上搜索明星并關(guān)注:

圖片

圖片

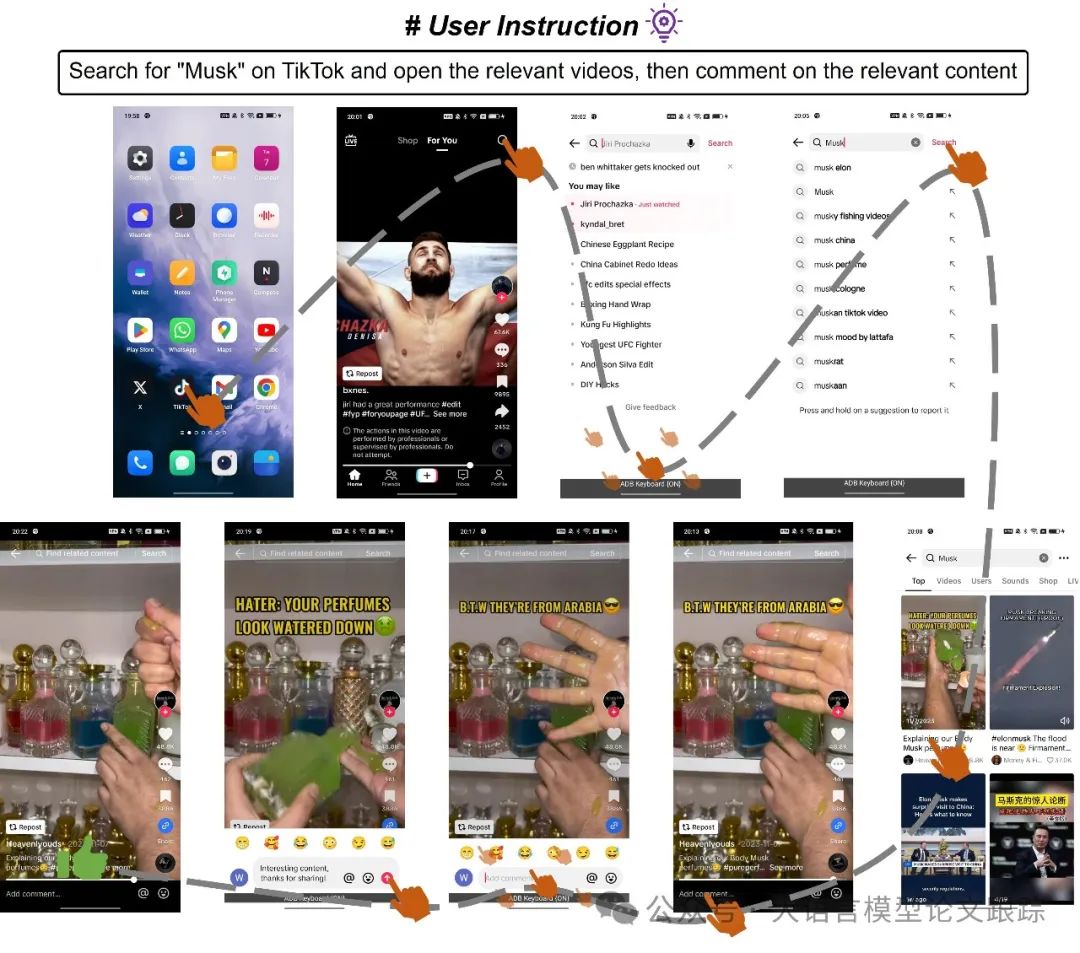

在Tiktok上搜索視頻并評(píng)論:

圖片

圖片

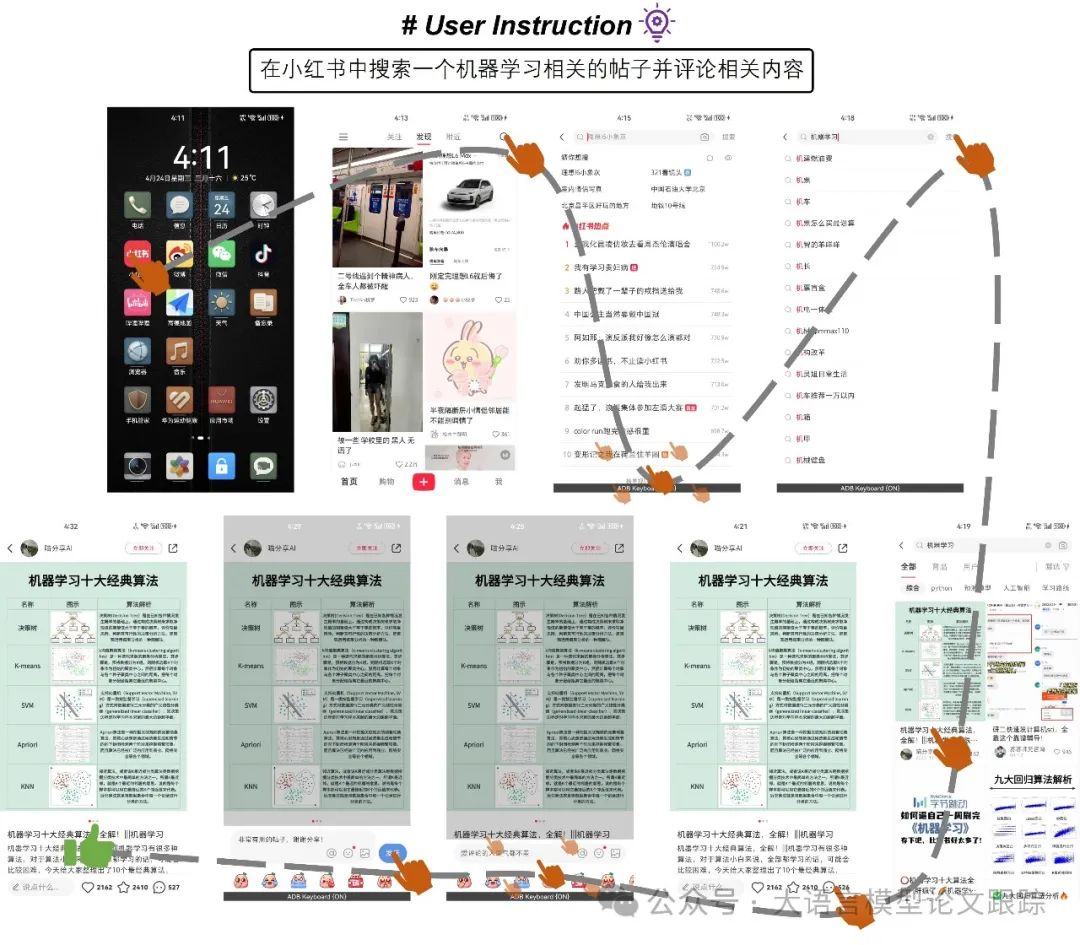

在小紅書(shū)上搜索內(nèi)容:

圖片

圖片

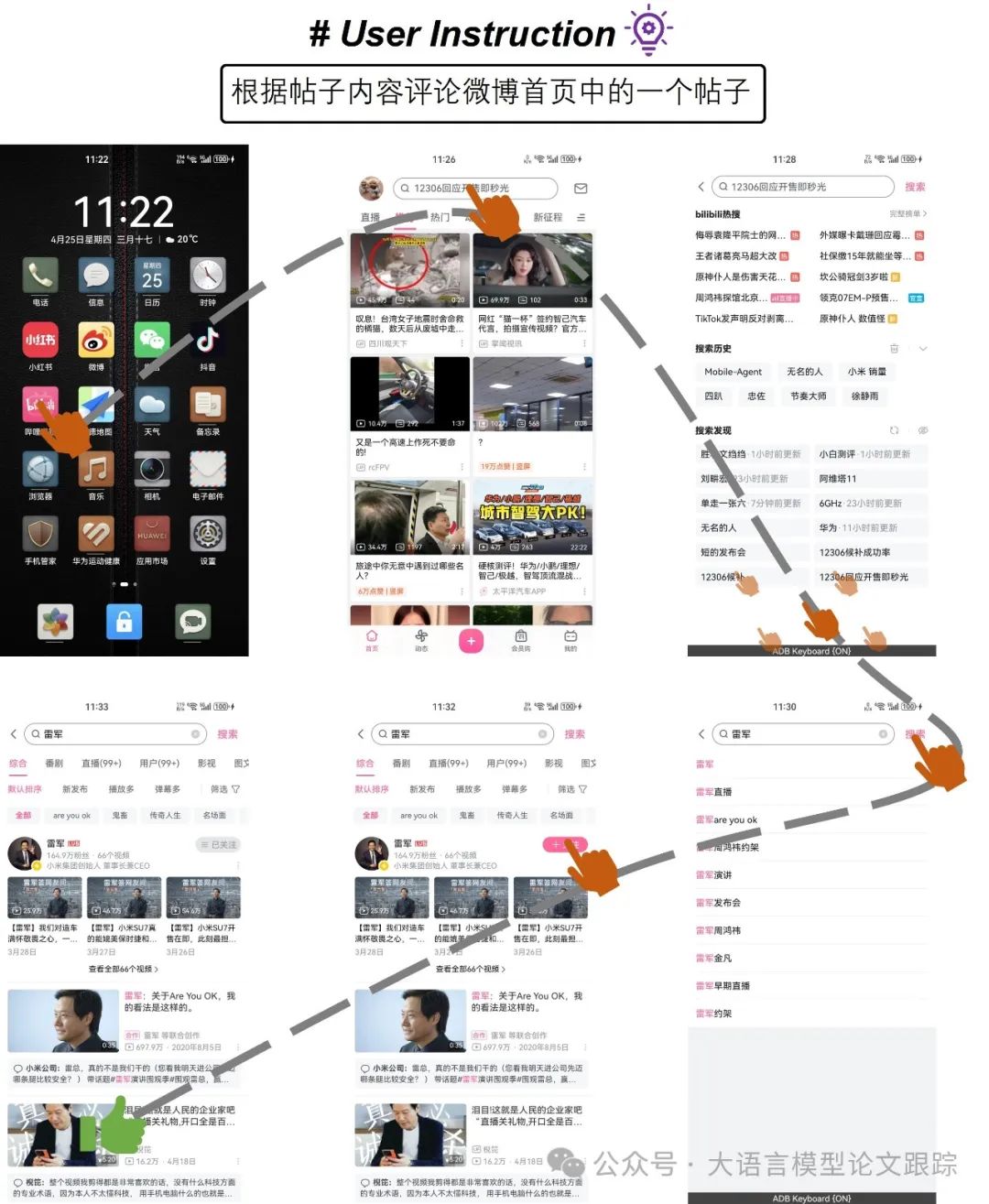

根據(jù)微博內(nèi)容發(fā)表評(píng)論:

圖片

圖片

在b站搜索大v并關(guān)注:

圖片

圖片

? 論文原文: https://arxiv.org/abs/2406.01014

本文轉(zhuǎn)載自??大語(yǔ)言模型論文跟蹤??,作者:HuggingAGI