到底什么是視覺語言模型?(分類/訓練/評估)

5月27日,Meta發布了Vision Language Model行業研究的綜述論文《An Introduction to Vision-Language Modeling》。全文干貨滿滿,但篇幅過長,所以筆者把每一章節放到獨立的文章中,方便對VLM領域感興趣的同學們一邊讀一邊翻譯一邊消化,覺得有用就一鍵三連吧~

*本文只摘譯精華部分,需要了解全文的請至文末跳轉至原文鏈接閱讀。*樓主會用GPTs翻譯形成初稿,然后自己精讀后完成終稿,力求每一句話自己都能理解后再輸出譯文。

引言

近年來,語言建模技術取得了顯著進展。許多大型語言模型(LLMs),如Llama或ChatGPT,現在能夠解決各種任務,其使用變得越來越普及。這些模型過去主要處理文本輸入,但現在擴展到了視覺輸入。將視覺與語言結合將開啟許多關鍵應用,這些應用對當前的AI技術革命至關重要。盡管已有多項工作將大型語言模型擴展到視覺領域,但語言與視覺的結合尚未完全解決。例如,大多數模型在理解空間關系或計數時存在困難,除非進行復雜的工程處理并依賴額外的數據標注。許多視覺語言模型(VLMs) 也缺乏對屬性和順序的理解。它們經常忽略輸入prompt的一部分,導致需要進行大量提示工程以產生期望的結果。此外,一些模型還可能產生不需要或不相關的內容。因此,開發可靠的模型仍然是一個非常活躍的研究領域。

這篇文章介紹了VLMs的基礎知識。作者將解釋什么是VLMs,它們是如何訓練的,以及如何根據不同的研究目標有效地評估VLMs。這篇文章不應被視為對VLMs的全面調查或指南,也因此不打算引用VLM研究領域的每一項工作,不會捕捉到該領域的每一個最佳實踐。相反,本文的目的是提供一個清晰易懂的VLM研究入門,并強調該領域的有效研究實踐。這篇介紹對希望進入該領域的學生或其他領域的研究人員特別有用。

文章首先介紹不同的VLM訓練范式,討論對比學習方法如何改變了該領域;接著介紹利用掩碼策略或生成組件的方法;最后介紹使用預訓練主干(如LLMs)的VLMs。將VLMs分類并非易事,因為它們大多有重疊的組件。然而,作者希望我們的分類能夠幫助新研究人員導航該領域,并揭示VLMs背后的內部機制。

文章接下來介紹了訓練VLMs的典型方法。例如本文討論了:哪些數據集適合不同的研究目標?哪種數據整理策略最有效?用戶是否需要訓練一個文本編碼器,還是可以利用預訓練的LLM?對比學習損失是否足以理解視覺,還是生成組件是關鍵?該章節還介紹了一些常用的技術,以提高模型性能以及改進對齊和基礎。

雖然提供訓練模型的方法是更好理解VLMs需求的關鍵步驟,但提供這些模型的穩健和可靠評估同樣重要。許多用于評估VLMs的基準最近被引入。然而,這些基準中的一些具有研究人員應該注意的基本局限性。通過討論VLM基準的優缺點,作者希望能闡明改進用戶對VLMs理解的挑戰。該章節首先討論評估VLMs視覺語言能力的基準,然后介紹如何衡量偏見。

下一代的VLMs將能夠通過將視頻映射到語言來理解視頻。然而,視頻存在一些圖像沒有的不同挑戰。計算成本當然要高得多,但還有其他關于如何通過文本映射時間維度的考慮。通過揭示從視頻中學習的當前方法,作者希望突出需要解決的當前研究挑戰。

通過降低進入VLM研究的門檻,Meta團隊希望為更負責任的VLM開發奠定基礎,同時推動視覺理解的邊界。

VLM的分類

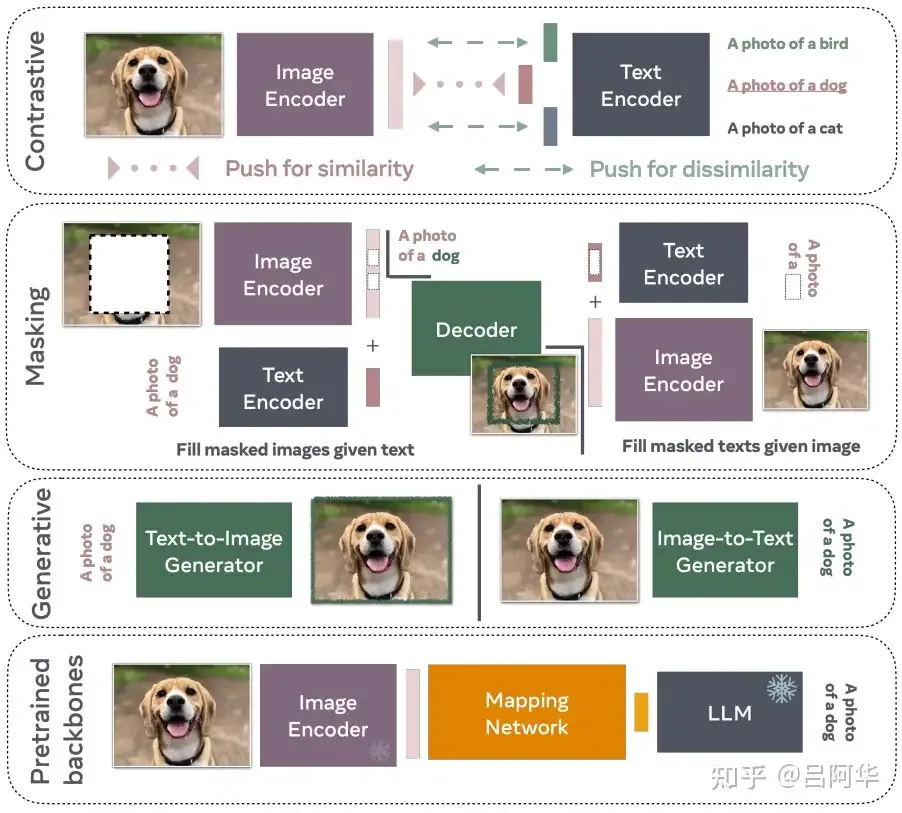

隨著深度學習在計算機視覺和自然語言處理領域的顯著進展,已經有多個將這兩個領域結合的嘗試。本文重點介紹了基于transformers的最新技術,作者將這些最新的嘗試分為四種不同的訓練范式(見圖1)。

圖1:VLMs的分類

- 第一種是對比訓練,這是一種常用策略,利用正負樣本對進行訓練。VLM通過預測正樣本對的相似表示和負樣本對的不同表示來進行訓練。

- 第二種是掩碼方法,通過給定部分未掩碼文本來重建被掩碼的圖像塊。同樣,通過在標題中掩碼詞語,可以訓練VLM在給定未掩碼圖像的情況下重建這些詞語。

- 基于預訓練模型的VLMs通常利用開源的LLMs(如Llama)來學習圖像編碼器(也可以是預訓練的)和LLM之間的映射。學習預訓練模型之間的映射通常比從頭開始訓練文本和圖像編碼器的計算成本更低。

- 雖然大多數方法利用中間表示或部分重建,生成式VLMs通過生成圖像或標題進行訓練。由于這些模型的特點,它們通常訓練成本最高。

需要強調的是,這些范式并不互斥,許多方法結合了對比、掩碼和生成標準。對于每種范式,本文僅介紹一兩個模型,以便讀者對這些模型的設計有一個高層次的了解。詳見以下傳送門:

Meta最新Vision-Language Model研究綜述(一)——VLMs的分類(https://zhuanlan.zhihu.com/p/700599618)

VLM的訓練

最近的研究已經揭示了擴展計算能力對提高深度神經網絡性能的重要性。受到這些擴展規律的啟發,最近的許多研究都集中在增加計算資源和擴大規模,以學習更好的模型。這導致了像CLIP這樣的模型,它在極高計算預算下訓練了4億張圖像。即使是它的開源版本OpenCLIP,也在256到600個GPU上訓練了多天或多周,具體取決于模型的大小。然而,最近的研究表明,通過使用數據管理流程,可以突破Scaling Laws的限制。

本文中首先討論數據在模型訓練中的重要性,并介紹一些用于創建VLM訓練數據集的方法。然后討論一些常用的軟件、工具和技巧,以更高效地訓練VLM。由于訓練VLM的方法有多種,本文還會探討在特定情況下應選擇哪種類型的模型。最后,本文還會介紹一些提高基準的方法,即正確映射文本與視覺線索的能力。此外,作者還介紹了使用人類偏好來改進模型對齊的技術。VLM經常用于讀取和翻譯文本,因此也會介紹一些增強VLM OCR能力的方法,還會討論一些常見的微調方法。

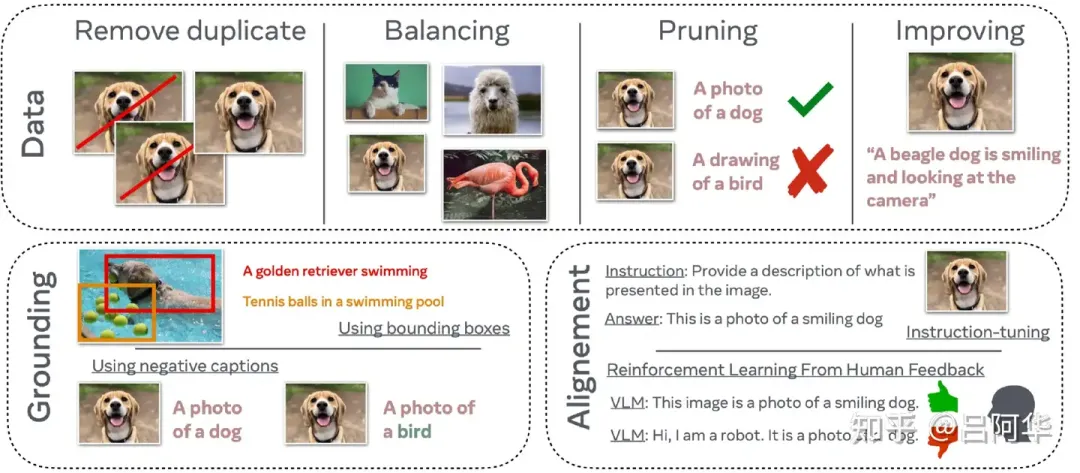

圖2:訓練VLM時需要注意的重要因素。

圖2展示了一些訓練VLM時的重要因素。數據是訓練VLM的核心要素之一,為了學習涵蓋廣泛概念的優質模型,必須擁有多樣化且平衡的數據集。同時,刪除大型數據集中的重復數據非常重要,這不僅可以節省大量計算時間,還能減少模型記憶風險。此外,修剪數據也是關鍵步驟,需要確保圖像的標題確實反映了其內容。提高標題質量對于增強VLM的性能也至關重要。

正確關聯VLM中的詞匯和具體概念是另一個關鍵步驟。常見的方法包括使用邊界框或負面標題。最后,對齊模型的輸出與人類預期答案也是必不可少的步驟,以確保模型生成的回答符合人類的期望。

詳見以下傳送門:

Meta最新Vision-Language Model研究綜述(二)——VLMs的訓練 (https://zhuanlan.zhihu.com/p/700728458)

VLM的評估

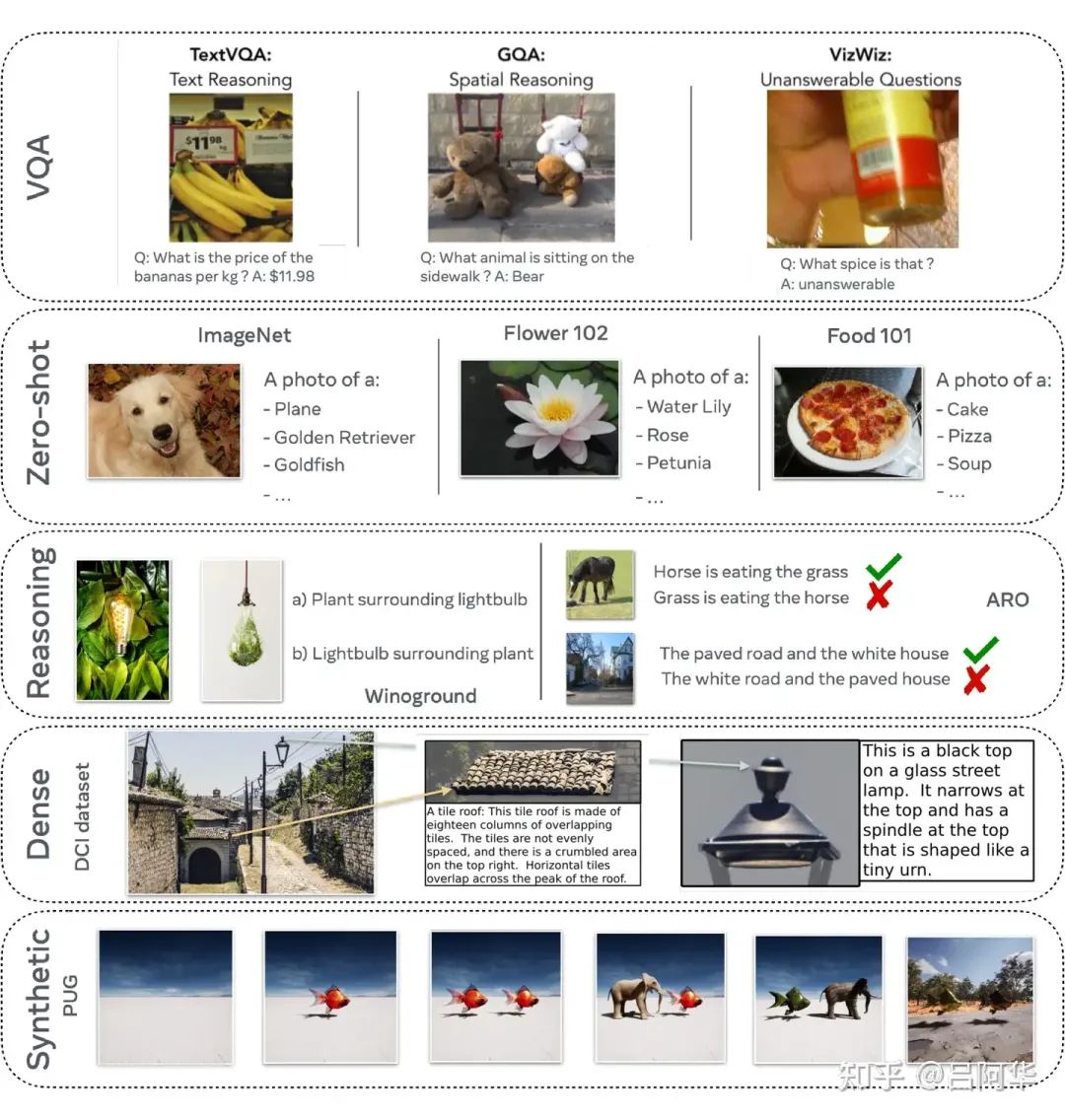

因為VLM的主要能力是將文本與圖像匹配,所以評估其視覺語言能力,確保詞語確實對應于視覺線索,至關重要。早期評估VLM的任務包括圖像描述和視覺問答(VQA)。此外,還有評估模型從圖像中理解和讀取文本能力的文本中心VQA任務。另一種常見評估方法是基于零樣本預測,例如ImageNet分類任務,這對于評估VLM的世界知識是否足夠非常重要。更近期的基準如Winoground則測量視覺語言組合推理能力。鑒于VLM模型常會顯示偏見或幻覺,因此評估這些問題同樣重要。

圖3:評估VLM的不同方法

圖3展示了評估VLMs的常用方法,視覺問答是最常用的一種。盡管這種方法通過精確字符串匹配來比較模型的答案和標準答案,但這可能會低估模型的實際性能。推理評估方法包括給VLM提供一個標題列表,并讓其選擇最可能的一個。在這一類中,兩個常用的基準是Winoground和ARO。最近,人們還可以使用密集的人工注釋來評估模型將標題準確映射到圖像相應部分的能力。最后,還可以使用像PUG這樣的合成數據生成不同配置的圖像,以評估VLM在特定變化下的魯棒性。

詳見以下傳送門:

Meta最新Vision-Language Model研究綜述(三)——VLMs的評估 (https://zhuanlan.zhihu.com/p/700943845)

從圖像擴展到視頻

迄今為止,本主要關注的是在靜態視覺數據(圖像)上訓練和評估的VLMs。然而,視頻數據帶來了新的挑戰和潛在的新能力,例如理解物體的運動和動態,或在時間和空間上定位物體和動作。文本到視頻檢索、視頻問答和視頻生成迅速成為計算機視覺的核心任務。

視頻的時間維度在存儲、GPU內存和訓練方面帶來了幀率的挑戰。例如,如果每幀都被視為圖像,那么24幀每秒的視頻需要24倍的存儲和處理能力。這需要在視頻VLMs中進行權衡。例如,可以使用壓縮格式的視頻(如H.264編碼)并在數據加載器中即時解碼;從圖像編碼器初始化視頻編碼器;以及在視頻編碼器中引入空間/時間池化或掩碼機制。非端到端的VLMs通過離線提取視頻特征并訓練使用視頻特征而不是像素幀的模型,以處理長視頻數據。

與圖像-文本模型類似,早期的視頻-文本模型通過自監督準則從頭開始訓練視覺和文本組件。但與圖像模型不同,對比視頻-文本模型并不是首選方法,早期更傾向于視頻和文本的早期融合和時間對齊,因為在表示中更多的時間粒度比計算視頻的全局表示更有趣。最近,視頻-語言模型也出現了類似于圖像-語言模型的趨勢:使用預訓練的LLMs并與視頻編碼器對齊,增強LLMs的視頻理解能力。現代技術如視覺指令微調也常用于并適應于視頻數據處理。

詳見以下傳送門:

Meta最新Vision-Language Model研究綜述(四)——從圖像擴展到視頻 (https://zhuanlan.zhihu.com/p/701035253)

總結

將視覺映射到語言仍然是一個活躍的研究領域。從對比學習方法到生成方法,有許多訓練VLMs的途徑。然而,高昂的計算和數據成本往往成為多數研究人員的障礙。這促使研究人員更多地利用預訓練的LLMs或圖像編碼器,僅學習模態之間的映射。不論使用何種技術來訓練VLMs,一些通用的考慮因素仍需注意。大規模高質量的圖像和描述是提升模型性能的重要因素。改進模型的基礎能力以及使模型符合人類偏好,也是提升模型可靠性的關鍵步驟。

為了評估模型性能,已經引入了多個基準來衡量視覺語言和推理能力;然而,其中許多基準存在嚴重的局限性,例如僅能通過利用語言先驗知識來解決問題。將圖像與文本綁定并不是VLMs的唯一目標;視頻也是一種重要的模態,可以用來學習表示。然而,在實現良好的視頻表示學習之前,仍有許多挑戰需要克服。VLMs的研究仍然非常活躍,因為還有許多關鍵組件需要完善,以使這些模型更加可靠。

本文轉自 AI生成未來 ,作者:呂阿華