多領域SOTA誕生!Vid2World:打通視頻擴散到世界模型的“任督二脈”|清華、重大

論文鏈接:https://arxiv.org/pdf/2505.14357

項目鏈接:https://knightnemo.github.io/vid2world/

生成效果速覽

亮點直擊

- 首個系統性探索如何將全序列、非因果、被動的視頻擴散模型遷移為自回歸、交互式、動作條件的世界模型的問題。

- 提出Vid2World,一個通用且高效的解決方案,包含了將視頻擴散模型因果化和動作條件化的多項新穎技術。

- Vid2World在多個領域中都達到了SOTA,為這一關鍵問題建立了新的基準,并為未來研究提供了有力支持。

將視頻傳播模型轉換為交互式世界模型涉及兩個關鍵挑戰

總結速覽

解決的問題

- 現有世界模型的局限性:傳統世界模型在順序決策中雖然具有效率優勢,但通常依賴大量特定領域的數據訓練,且生成結果粗糙、保真度低,難以適應復雜環境。

- 視頻擴散模型的潛力未被充分利用:盡管大規模預訓練的視頻擴散模型具備生成高質量、真實世界動態視頻的能力,但尚未被有效遷移用于交互式世界模型中。

提出的方案

- 提出Vid2World,一種通用方法,用于將預訓練的視頻擴散模型轉化為自回歸、交互式、動作條件的世界模型。

- 該方法通過結構調整和訓練目標變換,實現對原始被動模型的因果化處理,使其支持順序生成與交互。

應用的技術

- 模型因果化(Causalization):重構視頻擴散模型的架構與訓練目標,使其支持基于歷史信息的自回歸預測。

- 因果動作引導機制(Causal Action Guidance):引入動作條件控制模塊,增強生成過程對動作的響應能力,實現更強的交互性。

- 遷移學習:將大規模預訓練的視頻生成模型遷移至世界建模任務,提升泛化能力與表現力。

達到的效果

- Vid2World 在機器人操作和游戲模擬等多個任務中取得了當前最先進的性能。

- 建立了該方向上的新基準,驗證了將視頻擴散模型用于世界建模的可行性與優勢。

- 為未來多模態世界模型的研究提供了可擴展、高效的解決方案和技術路徑。

該研究開辟了將強大的視頻生成模型用于交互式世界建模的新方向,為多模態智能體的構建提供了重要基礎。

方法

盡管視頻擴散模型在生成高保真、物理上合理的序列方面表現出色,但其默認形式在本質上與交互式世界建模不兼容。具體而言,有兩個關鍵的轉換障礙尤為突出:

- 缺乏因果生成能力:典型的視頻擴散模型使用雙向時間上下文生成幀,允許未來幀影響過去幀;

- 缺乏動作條件建模:這些模型通常基于粗粒度的視頻級輸入(例如文本提示)進行條件建模,缺乏對細粒度、幀級動作的條件建模機制。

雖然這些設計在開放式視頻合成中非常有效,但與交互式世界建模的需求并不一致。交互式世界建模要求預測必須僅依賴于過去的觀測和動作,并且模型必須對幀級動作做出靈敏響應,準確捕捉其對未來預測的影響。

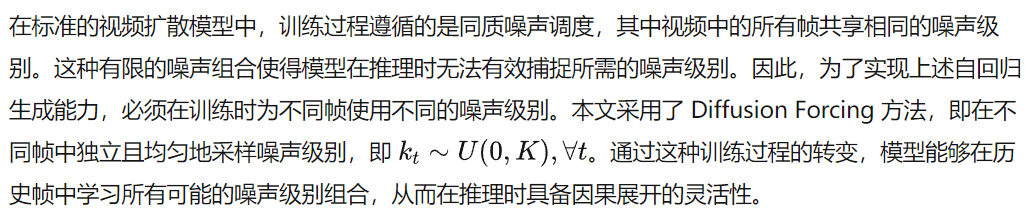

本文提出了 Vid2World,這是一種將預訓練視頻擴散模型遷移為交互式世界模型的通用方法。Vid2World 引入了兩個關鍵修改,分別用于實現自回歸生成和動作條件生成。首先,本文提出了視頻擴散因果化策略,該策略將非因果架構轉換為時間因果變體,與后訓練目標兼容,同時最大限度地保留預訓練權重。然后,引入了因果動作引導機制,以在推理過程中以無分類器方式實現逐步的交互式回滾。該方法通過輕量級嵌入層注入動作信號,并通過獨立的動作 dropout 擴展后訓練目標。本文的訓練與推理方法概覽如下圖 3 所示。

視頻擴散因果化

因果動作引導

雖然實現因果生成對于向交互式世界模型的轉變至關重要,但這些經過改造的因果擴散模型仍然無法提供基于動作的生成結果。已有大量工作 [1, 3, 63] 通過視頻級條件來引入動作條件,即將整個動作序列編碼為一個單一的嵌入,類似于文本到視頻生成模型中的文本嵌入。除了缺乏進行幀級細粒度動作條件預測的能力之外,這種全局條件本質上也與自回歸生成不兼容,因為動作是逐步到達的,必須在推理過程中以在線方式處理。

這種dropout機制直觀上鼓勵模型學習在動作序列所有可能子集條件下的分數函數。因此,模型被迫學習當前動作對預測轉移的影響,從而在測試時實現無分類器引導。在推理時,可以通過以下方式引導模型的生成結果:

本文提出了Vid2World,這是一種將全序列、非因果、被動視頻擴散模型轉化為自回歸、交互式、動作條件世界模型的通用方法。通過視頻擴散因果化,開啟了模型進行因果生成的能力;通過因果動作引導,我們將動作引導引入到交互式設置中。在算法 1 和算法 2 中提供了本文方法的偽代碼。

實驗

作為 Vid2World 的概念驗證,本文采用 DynamiCrafter作為基礎模型,它是一個基于 U-Net 的最先進潛在視頻擴散模型,預訓練于大規模網絡級視頻數據集,擁有 11 億個可訓練參數。我們在多個領域中展示了本文方法的有效性,涵蓋現實世界的機器人操作和游戲仿真中的高動態 3D 場景。通過視頻預測結果以及離線策略評估等下游任務,我們展示了 Vid2World 不僅獲得了與真實數據高度相似和真實感強的模型,還獲得了能夠在序列決策中輔助下游任務的模型。

Vid2World 在機器人操作中的應用

機器人操作是世界模型的理想測試平臺,要求在現實世界物理約束下進行時間一致、動作條件的預測,這些預測既要在視覺上真實,又要在因果上可信。這些嚴格的要求使其成為評估模型可控性和保真度的嚴苛且實際相關的基準。

設置。 本文使用 RT-1 數據集,這是一個涵蓋多種操作任務(包括抓取、放置、操作抽屜等)的現實世界機器人經驗集合。對于我們提出的方法,我們考慮兩種推理設置:

- Vid2World-NAR:類似于傳統視頻擴散模型和基線方法,我們在所有幀上使用相同的噪聲水平進行去噪,同時生成整個序列,即非自回歸方式;

- Vid2World:我們以自回歸方式對每一幀進行去噪,并結合動作引導。

參考 Diffusion Forcing,在自回歸展開過程中,在生成過程中向歷史幀添加統一的小噪聲。

基線。 為驗證本文方法作為遷移方法的有效性,采用多種基線,這些基線基于相同的基礎模型但使用不同的轉換方法,包括動作條件微調、語言條件微調、ControlNet和分類器引導。按照基線實現中的訓練和驗證集劃分進行模型訓練。

評估指標。 對于評估指標,本文采用常用的視頻生成指標,用于衡量模型生成結果與真實幀序列在像素級或語義上的相似性。這些指標包括 Fréchet Video Distance (FVD) 、Fréchet Image Distance (FID)、結構相似度指數 (SSIM)、學習感知圖像塊相似度 (LPIPS) 和峰值信噪比 (PSNR)。

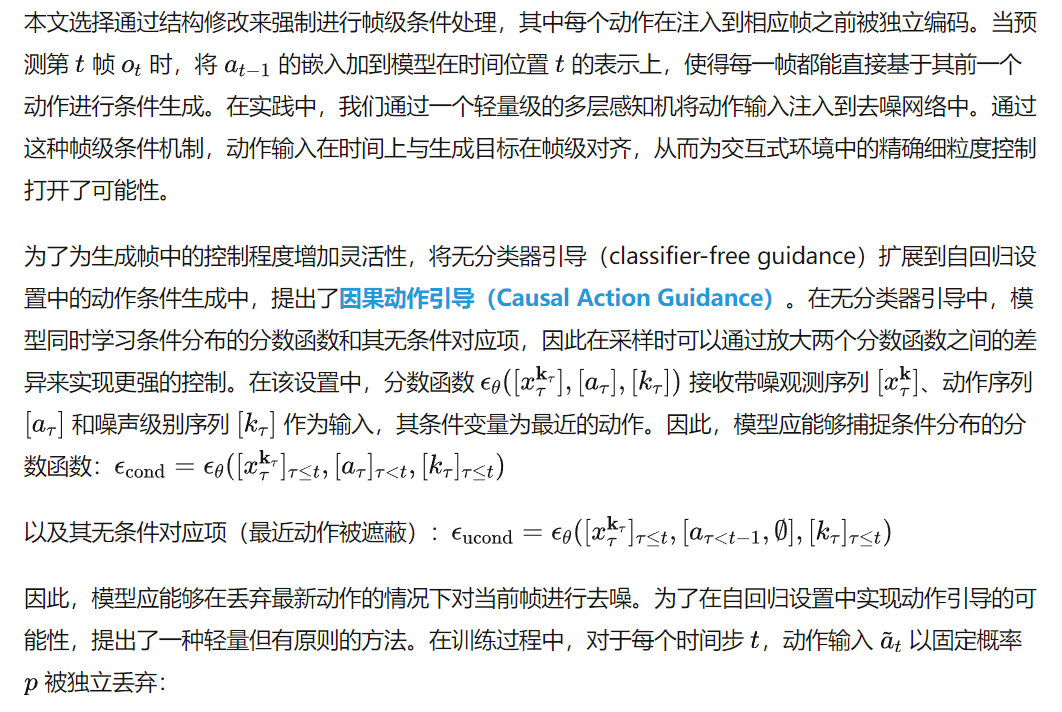

結果。 如下表 1 所示,Vid2World 在非自回歸和自回歸設置下均展現出強大的量化性能,表現優于或可與其他遷移方法相媲美。在非自回歸采樣設置下,Vid2World 以顯著優勢超越所有已有方法。即使在其他基線方法無法適用的自回歸設置下,Vid2World 仍保持了與這些方法相當甚至更優的性能,展示了其在視頻預測方面的強大能力。

Vid2World 在游戲仿真中的應用

游戲仿真是世界建模的關鍵應用領域,近年來在文獻中受到越來越多的關注。在該設置中,世界模型的交互性尤為關鍵,因為它為構建神經游戲引擎——即通過學習的動態支持實時用戶交互的模型——打開了大門。這是一個特別具有挑戰性的領域,因為其本質上具有復雜的時間動態,并且動作對視覺轉換有強烈影響,包括快速且不連續的視角變化、豐富接觸的物體交互以及細粒度的運動模式,要求模型能夠對復雜、因果交織的視覺-時序線索進行推理。

設置。 為了探索本文方法在高度動態且視覺復雜的 3D 環境中的能力,將 Vid2World 應用于著名視頻游戲《反恐精英:全球攻勢(CS:GO)》。使用 Pearce 等人提出的在線數據集,該數據集包含來自 Dust II 地圖的 550 萬幀(95 小時)真人在線游戲畫面。為了與基線方法進行可比性評估,遵循 DIAMOND的設置,使用完全相同的 50 萬幀保留集(對應 500 個片段,約 8 小時)進行測試。DIAMOND 是一種最先進的自回歸世界模型,它基于固定數量的歷史觀測和動作生成下一幀。采用前文中的評估指標,衡量生成視頻與真實視頻在視覺和語義上的相似性。由于 DIAMOND需要 4 幀作為條件輸入,使用四幀歷史幀初始化,并自回歸地生成幀,直到達到 16 幀的序列長度。評估指標僅在預測幀上計算,不包括用于條件輸入的幀。

結果。 如下表 2 所示,Vid2World 在所有評估指標上均顯著優于 DIAMOND 的兩種配置,包括在 FVD 上相對提高 81.8%,在 FID 上提升 77.2%,相較于最優基線配置。這些結果展示了本文方法在視覺保真度和語義一致性方面的卓越性能,顯示了將視頻擴散模型用于交互式神經游戲引擎的潛力。

消融研究

為了驗證本文提出方法的有效性,我們在自回歸設置下進行了消融實驗。關注兩個問題:(1)模型在交互式視頻預測設置中執行動作引導的能力有多重要?(2)所提出的混合權重遷移是否能在視頻預測任務中帶來更好的遷移效果?本文在 RT-1數據集上進行消融實驗,所有模型均訓練 30k 次梯度步,以控制計算預算。考慮兩種模型變體:

- Vid2World w/o Action Guidance:該變體在訓練時未使用動作 dropout,導致模型只能在提供完整動作序列作為確定性條件時進行生成;

- **Vid2World w/o Mixed weight transfer (MWT)**:該變體使用 shift 權重遷移初始化時間卷積權重進行訓練。

如下表 3 所示,這兩種技術在 Vid2World 的卓越性能中都起到了關鍵作用。

結論

本研究將被動視頻擴散模型轉化為交互式世界模型。提出了Vid2World,引入了兩個關鍵機制——視頻擴散因果化和因果動作引導——以支持自回歸、動作條件的生成。大量實驗表明,Vid2World 在視頻預測任務中達到了最先進的性能,同時也有效支持了下游決策任務。盡管本研究標志著一次成功的初步嘗試,但仍有大量空間可供進一步探索。首先,由于計算資源限制,僅采用了相對輕量的視頻擴散模型作為基礎模型,我們預期探索更大規模的模型有望帶來更優性能。其次,訓練過程仍然相對耗時。期待未來的方法能夠在更少的訓練步數下實現相當或更優的性能。

本文轉自AI生成未來 ,作者:AI生成未來