開源的金融分析工具,Llama3-70B-Instruct模型編織開放的金融智能網

在自然語言處理(NLP)領域的持續進步中,大型語言模型(LLMs)的領域適應模型變得越來越重要。針對特定任務優化的模型能夠提供清晰、簡潔和正確的信息,這是商業和最終用戶都需要的用例。從醫療診斷到法律咨詢,再到金融分析,LLMs 正在逐步改變我們與信息互動的方式。然而隨著這些模型在特定領域的應用越來越廣泛,領域適應性的挑戰也隨之而來。特別是在金融領域,對于精確性和可靠性的需求尤為重要。

領域適應性指的是模型在特定領域內保持或提高其性能的能力。這一過程通常涉及持續預訓練(CPT),即在模型的原有知識基礎上引入新領域的數據。但是這種方法可能會導致災難性遺忘,即模型在學習新任務時遺忘了原有任務的知識。這在金融領域尤為嚴重,因為錯誤的信息可能會導致巨大的經濟損失。

在這樣的背景下,Llama3-70B-Instruct 模型的出現為金融領域的數據分析帶來了巨大的變化。該模型專為解析和理解美國證券交易委員會(SEC)的復雜數據而設計,能夠為金融專業人士提供深入的投資分析和風險管理支持。通過持續預訓練和模型合并技術,Llama3-70B-Instruct 成功地在保持通用語言處理能力的同時,增強了對SEC數據的領域特定理解。感興趣的小伙伴可通過 hugging face 使用該模型(鏈接地址:https://huggingface.co/arcee-ai/Llama-3-SEC-Base)。

研究團隊背后的 Arcee AI是一家位于美國佛羅里達州的前沿人工智能公司。由 Shamane Siriwardhana、Mark McQuade、Thomas Gauthier 等領域專家領銜,這個團隊致力于將最新的 AI 研究成果轉化為實際應用,他們的工作不僅展示了 Llama3-70B-Instruct 在金融領域的潛在影響,也為其他領域的 AI 應用提供了寶貴的見解和方法論。

Llama-3-SEC-Base 模型

Llama-3-SEC-Base 模型代表了一次重要的突破,它是專門為分析美國證券交易委員會(SEC)數據而設計的領域特定聊天代理。該模型基于 Meta-Llama-3-70B-Instruct 模型構建,繼承了其強大的自然語言處理能力,并通過持續預訓練(CPT)的方法,融入了大量的 SEC 數據,以提升其在金融領域的專業性和準確性。

基礎架構和訓練數據 Llama-3-SEC-Base 的核心架構是建立在 Meta-Llama-3-70B-Instruct 的基礎上,這是一個具有 70 億參數的大型語言模型。在訓練過程中,模型首先接受了 20 億個令牌的 SEC 文件數據,這是其最終目標的 720 億個令牌數據的一個中間檢查點。此外,為了保持模型對通用語言的理解,研究團隊還將 1 億個通用數據令牌從 Together AI 的 RedPajama 數據集中混合進來。這種數據的混合旨在平衡領域特定知識和通用語言理解的能力。

SEC 數據分析的用例 Llama-3-SEC-Base 在 SEC 數據分析中的應用廣泛,包括但不限于:

- 深入的投資分析和決策支持,幫助投資者和金融分析師深入理解市場動態和公司財務狀況。

- 風險管理和評估,為金融機構提供全面的風險評估工具,以制定有效的風險緩解策略。

- 監管合規性檢查,確保企業遵守相關法規,并識別潛在的違規行為。

- 促進公司治理透明度,通過分析 SEC 文件,提供關于公司治理實踐的深入見解。

- 市場研究和行業趨勢跟蹤,為市場分析師提供寶貴的數據支持,以識別行業發展趨勢和市場機會。

評估方法和性能指標 為了驗證 Llama-3-SEC-Base 的效能,研究團隊采用了一系列領域特定和通用的評估指標。領域特定的評估包括困惑度測試,以衡量模型對 SEC 數據的處理性能;以及提取式數值推理任務,使用 TAT-QA 和 ConvFinQA 數據集的子集進行測試。通用評估指標則包括 BIG-bench、AGIEval、GPT4all 和 TruthfulQA,這些指標評估了模型在廣泛任務上的表現。

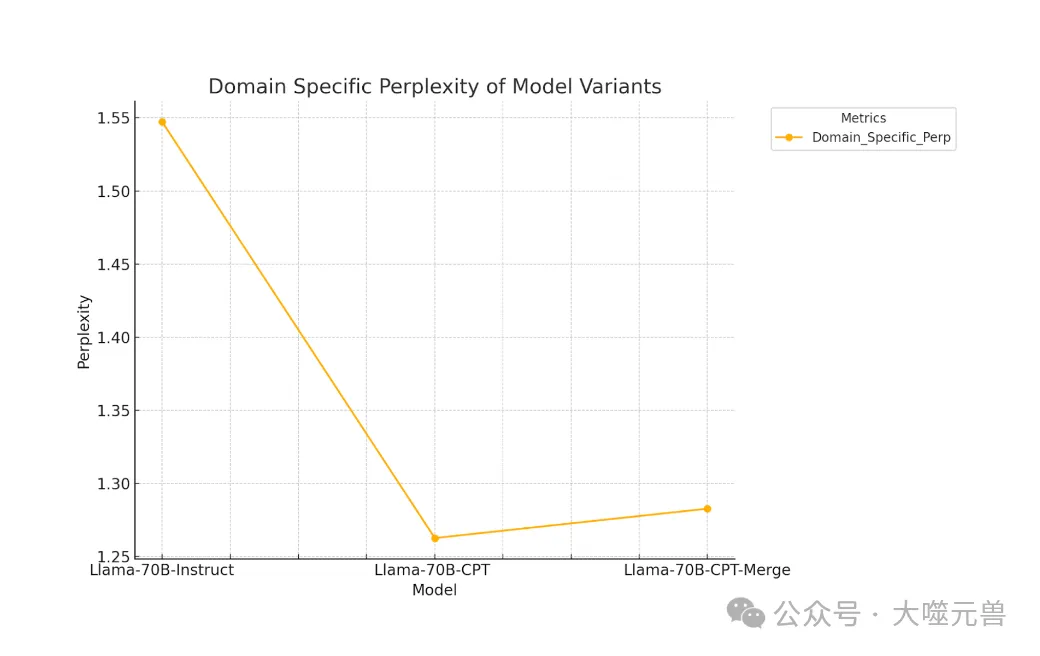

洞察圖 1:領域特定困惑度,衡量模型在 SEC 相關數據上的性能。

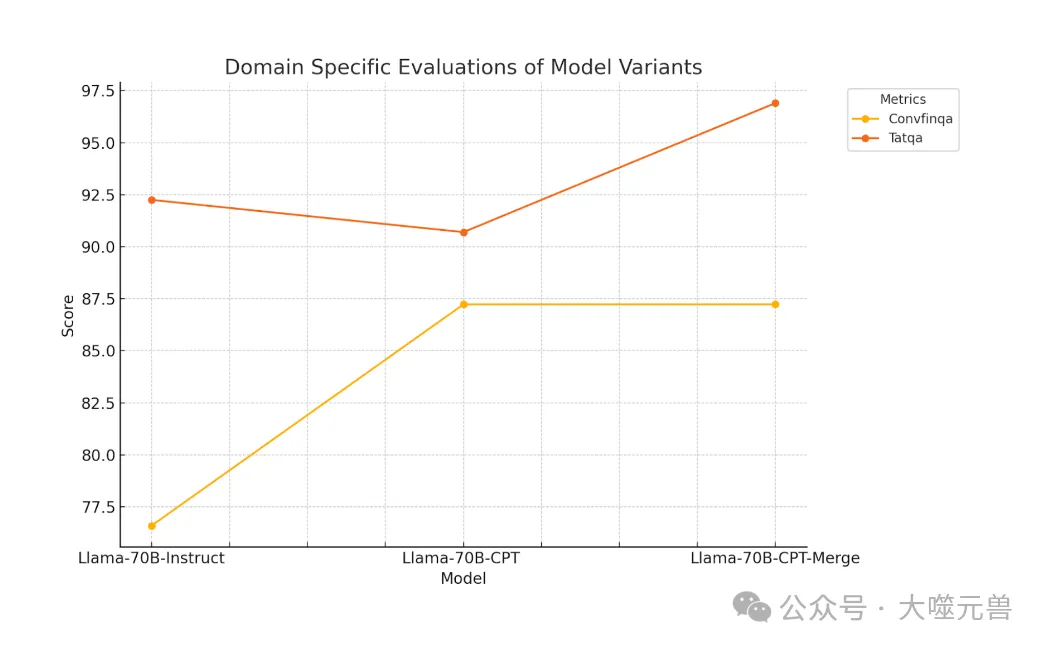

洞察圖 2:使用 TAT-QA 和 ConvFinQA 數據集的子集提取數值推理任務。

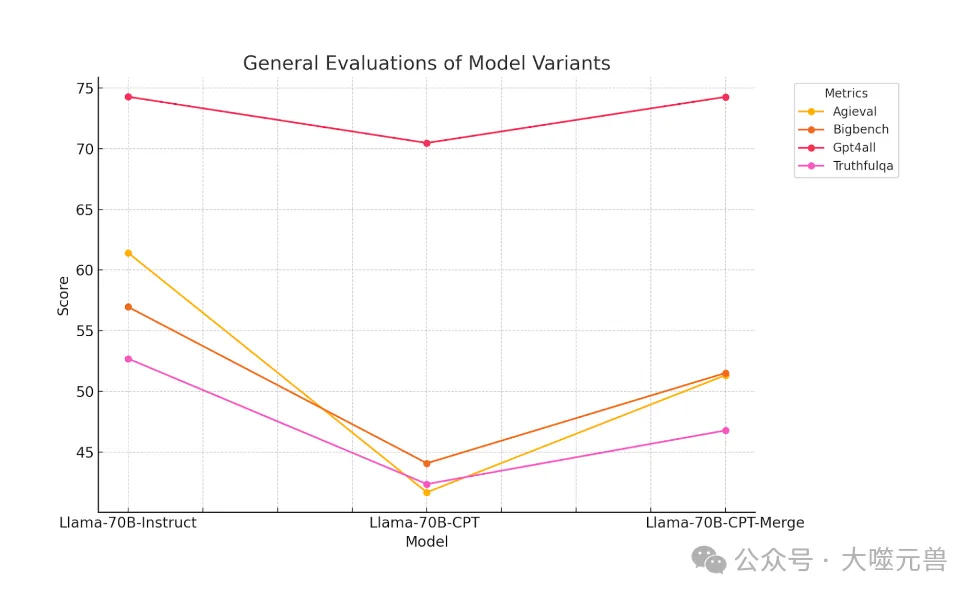

洞察圖 3:通用評估指標,例如 BIG-bench、AGIEval、GPT4all 和 TruthfulQA,用于評估模型在各種任務上的表現。

評估結果顯示,Llama-3-SEC-Base 在領域特定性能上取得了顯著提升,同時在通用能力上也保持了強大的表現。這證明了持續預訓練和模型合并技術在提高領域適應性方面的有效性,同時也展示了 Llama-3-SEC-Base 成為金融領域內不可或缺工具的潛力。

持續預訓練(CPT)

在語言模型的領域適應預訓練中,持續預訓練(CPT)是一個關鍵的概念,它涉及將新數據集從一個新領域引入到模型中。例如,PMC-LLaMA 是一個開源的醫療特定大型語言模型,它結合了純 CPT 和醫療特定指令調整的數據中心知識注入。ChipNeMo 探索了大型語言模型在工業芯片設計中的應用,采用領域適應性 CPT 方法進行適應。Arcee 的 CPT 工作包括使用領域特定數據集擴展基礎模型的訓練,如 Llama-2-base 或 Mistral7B-base,這允許我們微調模型以適應專業領域的細微差別。

持續預訓練(CPT)是一種先進的技術,它允許模型在原有知識的基礎上,通過引入新領域的數據來增強其在特定領域的表現。這種方法對于提升大型語言模型(LLMs)的領域適應性至關重要,尤其是在處理復雜和專業化數據的場景中。

CPT 本質上是一種增量學習過程,它使得模型能夠在不丟失先前學習的知識的情況下,逐步吸收新的信息。在 Llama3-70B-Instruct 模型中,CPT 被用來專門處理 SEC 數據,這是一種高度結構化且含義豐富的金融數據。通過 CPT,Llama3-70B-Instruct 能夠更好地理解和生成與 SEC 報告相關的文本,從而為金融分析師和投資者提供更深入的洞察。

在 CPT 的實施過程中,Llama3-70B-Instruct 模型被訓練以處理大量的 SEC 文件數據。這些數據包括了公司的季度和年度報告、內部交易文件、代理聲明等,總共涉及了 720 億個令牌。此外,為了保持模型的通用性,研究團隊還引入了來自 Together AI 的 RedPajama 數據集的 10 億個通用數據令牌。技術上,CPT 使用了 Megatron-Core 框架,這是一個支持大規模并行處理的訓練框架。訓練是在 AWS SageMaker HyperPod 集群上進行的,該集群配備了高性能的 H100 GPU,確保了訓練過程的高效和可擴展性。

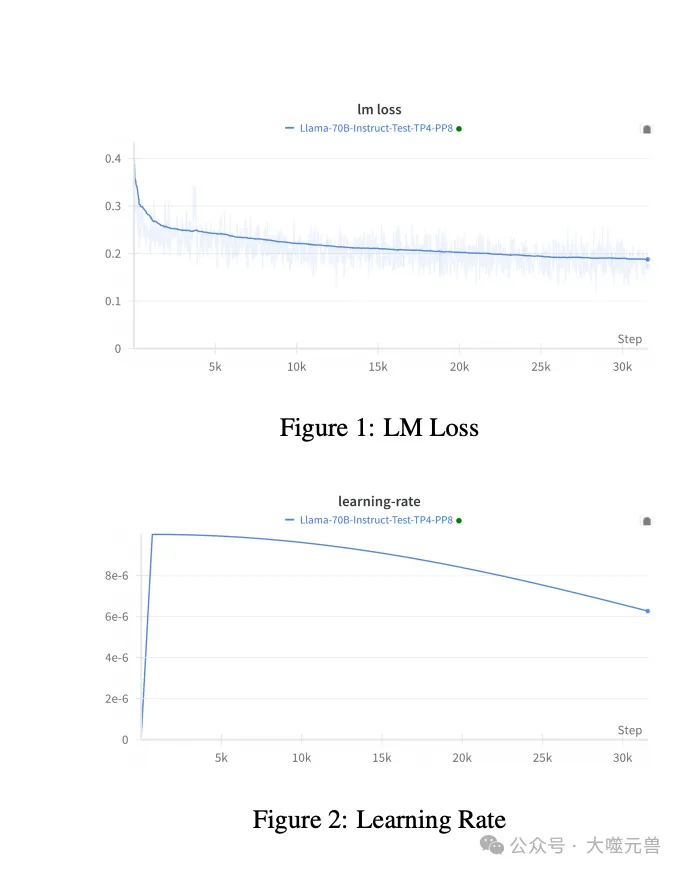

我們的訓練在 AWS SageMaker HyperPod 集群上進行,該集群由 4 個節點組成,每個節點都配備了 32 個 H100 GPU。在 CPT 層,我們混合了 700 億個 SEC 數據令牌和 Together AI 的 RedPijama 數據的 10 億個通用樣本。我們計劃在未來發布更多的檢查點。當前的 LM 損失和學習率曲線分別在圖 1 和圖 2 中展示。

圖1:LM損失 圖2:學習率

CPT 對 Llama3-70B-Instruct 模型的性能產生了顯著的影響。首先它顯著提高了模型在 SEC 數據分析任務上的準確性和深度。模型在領域特定的困惑度測試中表現出色,顯示出對 SEC 數據的深入理解。另外CPT 還增強了模型在提取式數值推理任務上的能力,這在金融領域尤為重要。然而CPT 過程中也存在著災難性遺忘的風險,即模型可能會在學習新領域知識的同時,丟失一些原有的通用語言處理能力。為了緩解這一問題,研究團隊采用了模型合并技術,將經過 CPT 的模型與原始的 Meta-Llama-3-70B-Instruct 模型結合,以保留模型的通用能力。

CPT 是實現 Llama3-70B-Instruct 模型領域適應性的關鍵步驟,它不僅提高了模型在特定領域的性能,也為如何平衡領域專業化和通用性提供了有價值的見解。

?模型合并技術

模型合并技術是一種創新的方法,旨在通過整合多個預訓練模型的知識來增強單一模型的能力。這種技術對于解決持續預訓練(CPT)過程中可能出現的災難性遺忘問題至關重要,尤其是在領域適應性方面。

模型合并的核心原理是將不同模型的權重和特征結合起來,形成一個新的、更強大的模型。在 Llama3-70B-Instruct 的情況中,這意味著將專門針對 SEC 數據分析進行預訓練的模型與通用的 Meta-Llama-3-70B-Instruct 模型相結合。這樣做的目的是保留原始模型的通用語言處理能力,同時增加對 SEC 數據的專業理解。

TIES(Tensor Integration and Entanglement Synthesis)是一種流行的模型合并方法,它通過在不同模型之間共享和重新分配權重來工作。TIES 的優勢在于它能夠有效地保留兩個模型的知識,同時減少了因為模型容量限制而可能丟失的信息。然而這種方法也有其局限性,例如在合并過程中可能會引入一些不相關的噪聲,或者在某些特定任務上的性能可能不如單獨的專業模型。

模型合并對于提高 Llama3-70B-Instruct 模型的領域適應性起到了關鍵作用。通過合并,模型不僅在 SEC 數據分析任務上表現出色,而且在通用評估指標上也保持了穩定的性能。這表明模型合并可以有效地緩解 CPT 過程中的災難性遺忘問題,使模型能夠在學習新領域知識的同時保留原有的通用語言處理能力。

模型合并技術為 Llama3-70B-Instruct 模型的領域適應性提供了一種有效的解決方案。它不僅增強了模型在特定領域的性能,還確保了模型在廣泛的任務上保持了高水平的通用性。這一技術的成功應用為未來在其他領域內實施類似技術提供了寶貴的經驗和啟示。

?評估和結果

對于大型語言模型(LLMs)的評估是一個復雜且多維的過程,尤其是當模型被設計來處理特定領域的數據時。Llama3-70B-Instruct 模型的評估涵蓋了領域特定和通用基準,以確保其在各個方面的性能都符合高標準。

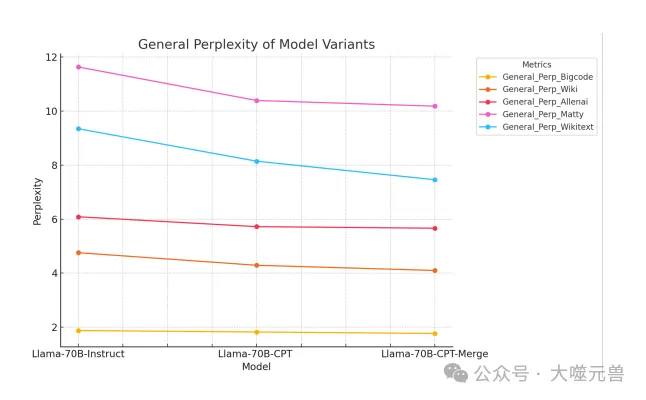

為了確保我們模型的穩健性,我們在領域特定和通用基準上進行了徹底的評估。領域特定評估對于評估模型在其目標領域內的性能至關重要。然而,通用評估同樣重要,以確保模型沒有遺忘其原始能力。在每次評估中,我們比較了以下模型:

1.Llama-70B-Instruct:Meta 發布的原始指導模型。

2.Llama-70B-CPT:持續預訓練后的 Llama-70B-Instruct 模型,檢查點在處理 200 億個令牌后保存。

3.Llama-70B-CPT-Merge:使用 TIES 方法將 Llama-70B-CPT 模型與原始 Llama-70B-Instruct 模型合并。

領域特定困惑度對于評估模型在其目標領域內的性能至關重要,確保有效適應領域數據。跟蹤困惑度的變化有助于評估持續預訓練和領域特定改進的影響。

CPT 降低了與 SEC 數據相關的困惑度,表明模型對這一特定領域的理解和適應性有所提高。將 CPT 模型與 Llama3-Instruct 版本合并后,困惑度略有增加,可能是由于重新引入了一些丟失的聊天能力。盡管合并后困惑度略有增加,但最終模型的困惑度仍低于原始模型,表明有效的領域適應同時保留了聊天能力。這表明模型合并并沒有損害在持續預訓練過程中獲得的注入領域知識。

對于領域特定評估,我們測試了模型在提取式數值推理任務上的性能,即 TAT-QA 和 ConvFinQA 的子集,這些任務雖然與 SEC 數據不完全相關,但仍然與評估領域特定性能相關。

對于 ConvFinQA,CPT 后性能明顯提高,并在與指導模型合并后進一步提高。對于 TAT-QA,只有在合并后才觀察到顯著改進,這可能是由于它在混合表格和文本內容方面的專業化,而這在 SEC 數據中的表示較少。對于財務分類任務,模型將文本分類為前提或聲明,CPT 后我們看到了非常顯著的準確性改進,接近完美分數,并表明模型有效地從 SEC 數據的無監督訓練中學習新任務。合并后準確性有所下降,但仍然遠高于指導基線。

Llama3-70B-Instruct 模型在領域特定的評估中表現出色,特別是在處理 SEC 數據分析任務時。模型在困惑度測試中得分低,表明其對金融數據的理解深入。在提取式數值推理任務上,模型同樣展現了強大的性能,這些任務包括 TAT-QA 和 ConvFinQA 數據集的子集,它們雖然不完全相關于 SEC 數據,但對評估模型在金融領域的表現至關重要。

在通用基準上,Llama3-70B-Instruct 經過 CPT 和模型合并后,仍然保持了良好的性能。盡管在某些通用評估指標上出現了輕微的性能下降,但這主要是由于模型在學習新領域知識時,必須在保留原有知識和適應新知識之間找到平衡。

CPT 顯著提高了模型在 SEC 數據分析方面的專業性,但也帶來了災難性遺忘的風險。通過模型合并技術,特別是 TIES 方法,研究團隊成功地將 CPT 模型與原始 Meta-Llama-3-70B-Instruct 模型結合,這不僅緩解了災難性遺忘的問題,還增強了模型在特定領域的性能。

洞察圖 6:在所有通用數據集上,CPT 與大量 SEC 領域特定令牌(20B)一起使用,降低了困惑度,表明預測能力得到了提高。

即使在經過廣泛的領域特定訓練之后,模型仍然保持對通用領域的熟悉性,這一點從圖表中顯示的通用文本的穩定困惑度指標中可以看出。這表明 CPT 并沒有降低模型的通用知識,盡管它可能會減少某些能力。正如洞察圖 1 所示,我們建議未來的工作可以通過更好的 SFT 適應來幫助恢復模型的指令跟隨能力,利用保留的知識。

Llama3-70B-Instruct 在多個任務上的表現證明了其作為一個領域特定 AI 聊天代理的有效性。然而仍有改進空間,特別是在提高模型對 SEC 數據的理解深度和廣度方面。未來的工作可以集中在優化 CPT 過程,以及探索更先進的模型合并技術,以進一步提高模型的領域適應性和減少對通用性能的影響。

總體而言,Llama3-70B-Instruct 模型的綜合評估結果令人鼓舞,它不僅在領域特定任務上表現出色,而且在通用任務上也保持了可靠的性能。這些成果為未來在其他領域內實施類似技術提供了寶貴的經驗和啟示,展示了 AI 在領域適應性方面的巨大潛力和應用前景。

討論

在深入探索 Llama3-70B-Instruct 模型的領域適應性和持續預訓練(CPT)的挑戰時,我們必須認識到,雖然 CPT 在提高模型對特定領域數據的理解方面取得了顯著成果,但它也帶來了災難性遺忘的風險。這種遺忘現象可能導致模型在吸收新知識的同時喪失原有的通用語言處理能力。因此,如何在增強模型的領域專業性與保持其通用性之間找到平衡,成為了一個關鍵的研究課題。

模型合并技術,尤其是 TIES 方法,為這一挑戰提供了一個有效的解決方案。通過將經過 CPT 的模型與原始的 Meta-Llama-3-70B-Instruct 模型結合,不僅保留了模型的通用能力,還增強了其在 SEC 數據分析領域的專業性。這種方法的成功應用表明,模型合并可以作為一種強大的工具,用于在不犧牲通用性的前提下提升模型的領域適應性。

未來的工作方向應該集中在進一步優化對齊方法和數據處理層。對齊方法,如監督式微調(SFT)、直接偏好優化(DPO)和人類反饋的強化學習(RLHF),可以幫助模型更準確地理解和執行特定領域的任務。同時,改進數據處理層,特別是在數據過濾和選擇方面的方法,將有助于模型更有效地處理大規模的領域特定數據集,同時減少災難性遺忘的風險。

Llama3-70B-Instruct 模型的領域適應性和持續預訓練的挑戰突顯了在 AI 領域中不斷追求平衡的重要性。模型合并技術的成功實踐為未來的研究提供了寶貴的經驗,而對齊方法和數據處理層的持續改進將進一步推動領域特定 AI 聊天代理的發展。(END)

參考資料

1. https://arxiv.org/pdf/2406.14971

2. https://huggingface.co/arcee-ai/Llama-3-SEC-Base

本文轉載自 ??大噬元獸??,作者: FlerkenS