Llama 3來了!首批開源 8B 和 70B兩個版本,未來有望開源400B大模型! 原創 精華

Llama系列是如今最流行的開源大模型,今天,Meta發布了其最新版本——Llama 3!并將很快上線 AWS、Databricks、Google Cloud、Hugging Face、Kaggle、IBM WatsonX、Microsoft Azure、NVIDIA NIM 和 Snowflake 等平臺。

在未來幾個月里,Meta預計將推出新的功能、更長的上下文窗口、額外的模型大小以及增強的性能,并且將分享 Llama 3 的研究論文。

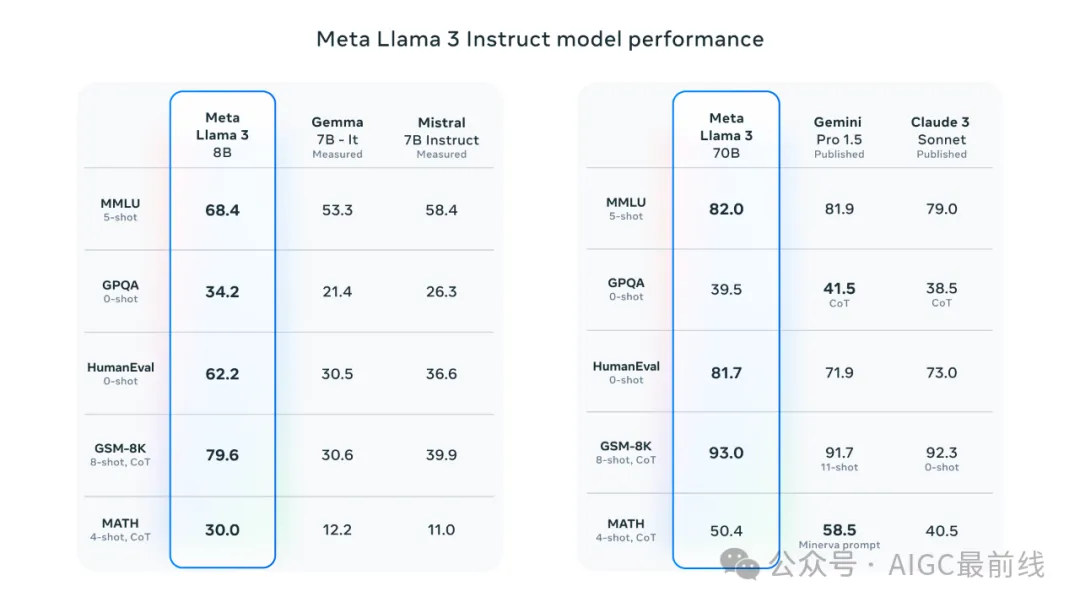

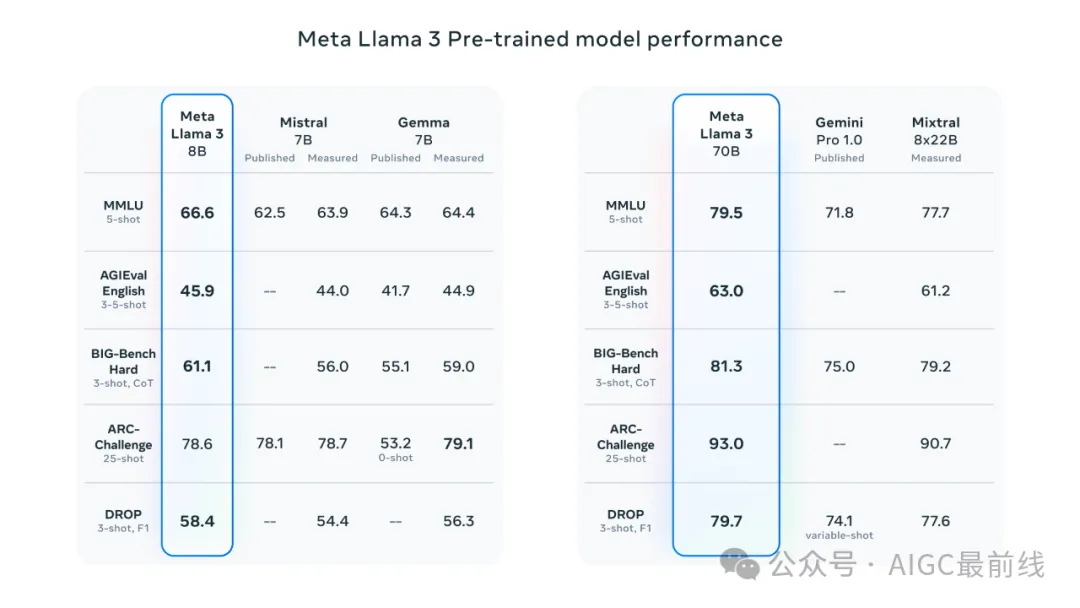

Llama 3 包含預訓練和指令微調的語言模型,參數為 8B 和 70B,可以支持廣泛的用例。這一代的 Llama 在各種行業基準測試中展現出最先進的性能,并提供了新的功能,包括改進的推理能力。

最先進的性能

新 8B 和 70B 參數的 Llama 3 模型比 Llama 2 跨越了一個重要的進步,并在這些規模上樹立了新的技術標準。由于在預訓練和后訓練中的改進,預訓練和指令微調模型是當今 8B 和 70B 參數規模下的最佳模型。后訓練程序的改進大大降低了虛假拒絕率,提高了對齊度,并增加了模型響應的多樣性。在推理、代碼生成和指令跟隨等大大改進了能力,使 Llama 3 更易于控制。

有關評估詳細信息,請參閱用于計算這些評估的設置和參數。

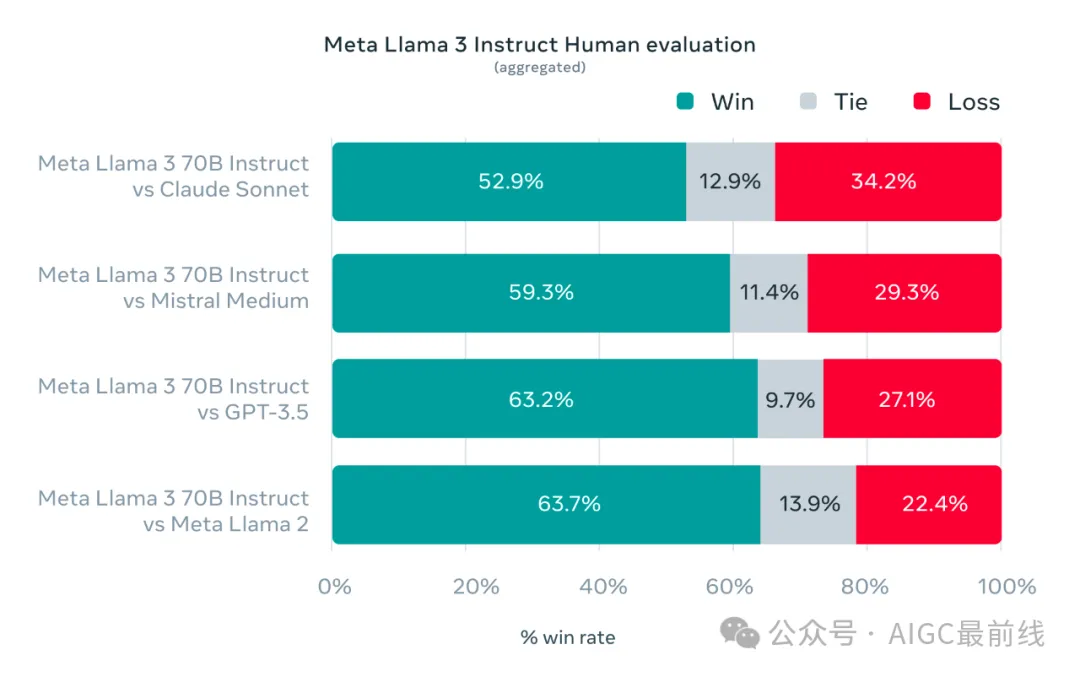

在 Llama 3 的開發過程中,Meta關注了模型在標準基準測試中的性能,并力求優化在真實場景中的性能。為此,研究人員開發了一個新的高質量人工評估集。這個評估集包含了 1800 個提示,涵蓋了 12 個關鍵用例:征求建議、頭腦風暴、分類、閉合問題回答、編碼、創意寫作、提取、扮演角色/人物、開放式問題回答、推理、重寫和摘要。為了防止模型在這個評估集上意外過度擬合,即使Meta自己的建模團隊也無法訪問它。下面的圖表顯示了在這些類別和提示中的人工評估的綜合結果,與 Claude Sonnet、Mistral Medium 和 GPT-3.5 進行了比較。

人類注釋員基于這個評估集的偏好排名凸顯了 70B 指令跟隨模型在真實場景中與相同規模競爭模型相比的強勁性能。

為了開發出優秀的語言模型,Meta認為創新、擴展和簡化優化至關重要。Meta在整個 Llama 3 項目中都采用了這種設計理念,并重點關注了四個關鍵要素:模型架構、預訓練數據、擴大預訓練規模和指令微調。

模型架構

根據Meta的設計理念,選擇了在 Llama 3 中采用相對標準的僅解碼器的Transformer架構。與 Llama 2 相比,做出了幾項關鍵改進。Llama 3 使用了一個詞匯量為 128K 的分詞器,它更有效地編碼語言,從而大大提高了模型性能。為了提高 Llama 3 模型的推理效率,在 8B 和 70B 大小的模型中都采用了分組查詢注意力(GQA)。Meta使用一個長度為 8,192 個令牌的序列訓練模型,并使用掩碼來確保自注意力不會跨越文檔邊界。

訓練數據

要訓練出最佳的語言模型,策劃一個大規模、高質量的訓練數據集至關重要。根據設計原則,Meta大量投資于預訓練數據。Llama 3 在公開可用的來源中收集了超過 15T 個令牌的預訓練數據。Meta的訓練數據集比用于 Llama 2 的數據集大了七倍,其中包括了四倍的代碼。為了準備即將到來的多語言用例,超過 5% 的 Llama 3 預訓練數據集由覆蓋超過 30 種語言的高質量非英語數據組成。然而,Meta不指望在這些語言中獲得與英語相同水平的性能。

為了確保 Llama 3 在最高質量的數據上進行訓練,Meta開發了一系列數據過濾流程。這些流程包括使用啟發式過濾器、NSFW 過濾器、語義去重方法和文本分類器來預測數據質量。Meta發現以前的 Llama 代的能力驚人地好,能夠識別高質量的數據,因此使用 Llama 2 生成了驅動 Llama 3 的文本質量分類器的訓練數據。

Meta還進行了大量實驗,評估了在最終的預訓練數據集中混合來自不同來源的數據的最佳方法。這些實驗使能夠選擇一種數據混合,以確保 Llama 3 在各種用例中表現良好,包括瑣事問題、STEM、編碼、歷史知識等。

擴大預訓練規模

為了有效利用 Llama 3 模型中的預訓練數據,Meta付出了大量努力來擴大預訓練規模。具體來說,研究人員開發了一系列詳細的用于下游基準評估的擴展定律。這些擴展定律使能夠選擇最佳的數據混合,并做出關于如何最佳利用訓練計算資源的明智決策。重要的是,擴展定律使能夠在實際訓練模型之前,預測最大的模型在關鍵任務上(例如,在 HumanEval 基準測試中評估的代碼生成)的性能。這有助于確保最終模型在各種用例和能力中表現出強勁的性能。

在 Llama 3 的開發過程中,Meta對擴展行為進行了幾項新的觀察。例如,雖然 8B 參數模型的訓練計算資源的奇奇拉最佳量對應著約 200B 個令牌,但發現即使在模型訓練了兩個數量級的數據后,模型的性能仍然會持續改善。 8B 和 70B 參數模型在對其進行了多達 15T 個令牌的訓練后,仍然呈對數線性改進。較大的模型可以在較少的訓練計算資源下達到這些較小模型的性能,但較小的模型通常更受歡迎,因為它們在推理過程中更加高效。

為了訓練最大的 Llama 3 模型,結合了三種并行化方式:數據并行化、模型并行化和管道并行化。最有效的實現在同時訓練 16K 個 GPU 時,每個 GPU 的計算利用率超過 400 TFLOPS。在兩個自定義構建的 24K GPU 集群上進行了訓練。為了最大程度地提高 GPU 的正常運行時間,Meta開發了一套先進的新訓練堆棧,用于自動化錯誤檢測、處理和維護。

指令微調

為了充分發揮預訓練模型在聊天應用場景中的潛力,Meta還對指令微調方法進行了創新。后訓練方法是監督微調(SFT)、拒絕抽樣、近端策略優化(PPO)和直接策略優化(DPO)的組合。在 SFT 中使用的提示質量以及在 PPO 和 DPO 中使用的偏好排名對齊模型的性能有著極大的影響。在模型質量上取得的一些最大改進來自于精心策劃這些數據,并對人類注釋員提供的標注進行了多輪質量保證。

通過 PPO 和 DPO 學習偏好排名也極大地提高了 Llama 3 在推理和編碼任務上的性能。,如果你向模型提出一個它難以回答的推理問題,模型有時會產生正確的推理軌跡:模型知道如何生成正確的答案,但它不知道如何選擇它。通過偏好排名的訓練,模型可以學會如何進行選擇。

利用 Llama 3 構建

Meta的愿景是使開發人員能夠定制 Llama 3,以支持相關的使用案例,并使其更容易采用最佳實踐并改善開放生態系統。在這個版本中,Meta提供了新的信任和安全工具,包括更新的 Llama Guard 2 和 Cybersec Eval 2 組件,以及 Code Shield 的引入——這是一個用于過濾由 LLM 生成的不安全代碼的推理時間保護欄。

Meta還與 torchtune 共同開發了 Llama 3,這是一個新的 PyTorch 原生庫,用于輕松編寫、微調和實驗 LLM。torchtune 提供了內存高效和可修改的訓練配方,完全用 PyTorch 編寫。該庫集成了流行的平臺,如 Hugging Face、Weights & Biases 和 EleutherAI,甚至支持 Executorch,在各種移動和邊緣設備上實現高效推理。從提示工程到使用 Llama 3 與 LangChain,Meta都有一份全面的入門指南,從下載 Llama 3 到在您的生成式 AI 應用程序中進行規模化部署。

責任的系統級方法

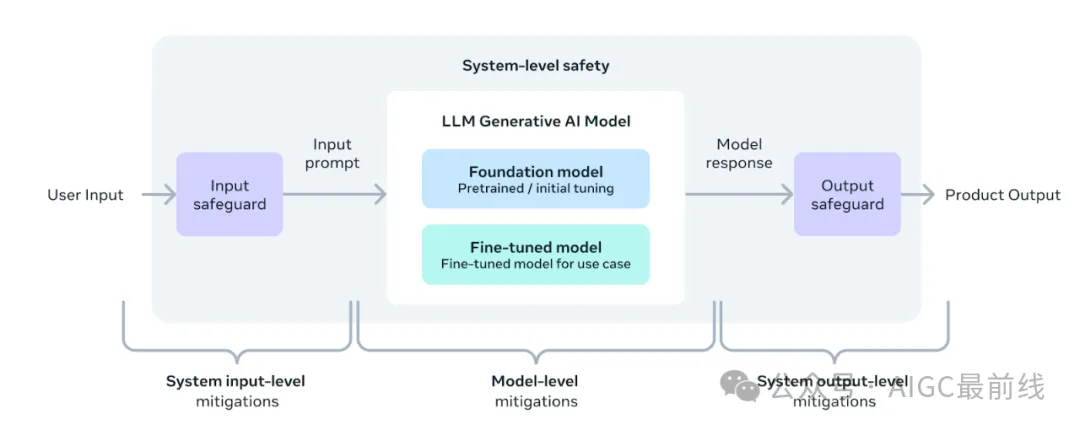

設計 Llama 3 模型的目標是最大限度地提高其幫助性,同時確保采用行業領先的負責任部署方法。為了實現這一目標,Meta采用了一種新的、系統級的方法來負責任地開發和部署 Llama。Meta將 Llama 模型視為更廣泛系統的一部分,讓開發人員坐在駕駛座上。Llama 模型將作為開發人員根據其獨特的最終目標設計的系統的基礎組成部分。

指令微調在確保模型安全性方面也起著重要作用。指令微調模型已經通過內部和外部努力進行了安全的紅隊測試。紅隊方法利用人類專家和自動化方法生成對抗性提示,試圖引發問題響應。例如,對與化學、生物、網絡安全等風險領域相關的誤用風險進行了全面測試。所有這些努力都是迭代的,用于指導發布模型的安全微調。

Llama Guard 模型旨在成為提示和響應安全的基礎,并可以根據應用需求輕松進行微調以創建新的分類。作為起點,新的 Llama Guard 2 使用最近公布的 MLCommons 分類法,旨在支持這一重要領域的產業標準的出現。此外,CyberSecEval 2 在其前身的基礎上增加了對 LLM 允許濫用其代碼解釋器、攻擊性網絡安全功能以及易受提示注入攻擊的傾向性的評估。最后,Meta引入了 Code Shield,它增加了對 LLM 生成的不安全代碼進行推理時間過濾的支持。這提供了關于不安全代碼建議、代碼解釋器濫用預防以及安全命令執行的風險緩解。

鑒于生成式 AI 領域的發展速度,Meta相信開放式方法是將生態系統匯聚在一起并減輕這些潛在危害的重要途徑。作為其中的一部分,Meta正在更新《負責任使用指南》(RUG),提供了使用 LLM 進行負責任開發的全面指南。正如在 RUG 中概述的那樣,Meta建議根據適用于應用的內容指南檢查和過濾所有輸入和輸出。此外,許多云服務提供商提供內容調節 API 和其他用于負責任部署的工具,鼓勵開發人員考慮使用這些選項。

Llama 3 的下一步是什么?

Llama 3 8B 和 70B 模型標志著Meta計劃發布的 Llama 3 的開始。而且還有更多的功能即將推出。

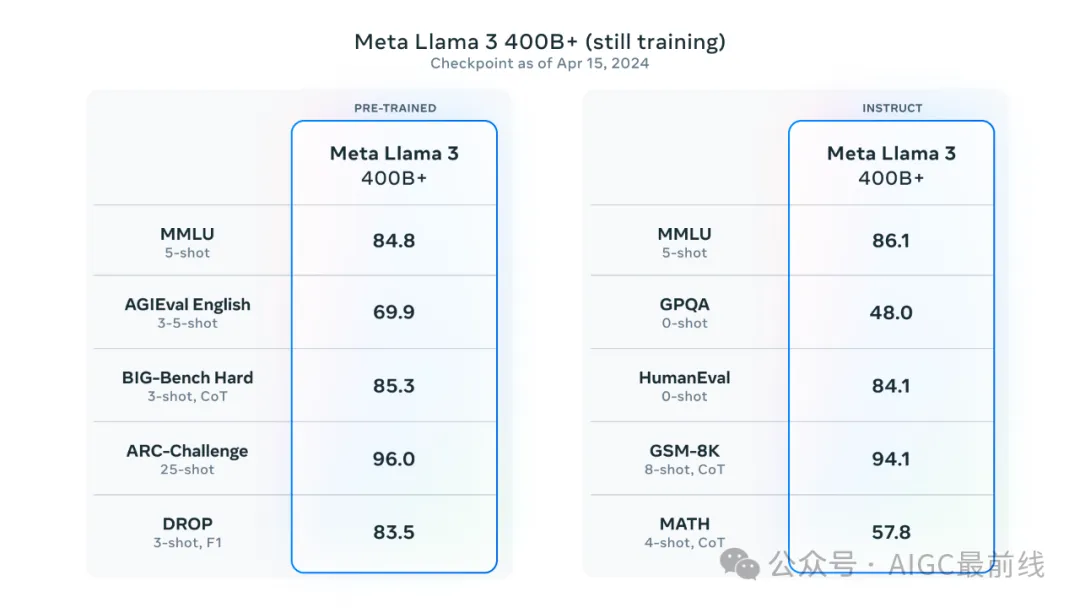

Meta的最大模型包含超過 400B 的參數,盡管這些模型仍在訓練中,但Meta團隊對它們的趨勢感到興奮。在接下來的幾個月中,Meta將發布多個具有新功能的模型,包括多模態、多語言對話的能力、更長的上下文窗口和更強大的整體功能。Meta還將在完成對 Llama 3 的訓練后發布詳細的研究論文。

為了讓您提前了解這些模型目前的情況,Meta想分享一些關于最大的 LLM 模型趨勢的快照。請注意,這些數據基于 Llama 3 的早期檢查點,這些功能目前不支持作為今天發布的模型的一部分。

Meta致力于持續發展和建設一個開放的人工智能生態系統,以負責任地發布模型。Meta長期以來一直相信開放性能夠帶來更好、更安全的產品,加速創新,并促進更健康的整體市場。這對 Meta 是有利的,也對社會是有益的。以社區為先的方式對待 Llama 3,從今天開始,這些模型已經可以在領先的云、托管和硬件平臺上使用,而且還會有更多平臺的支持即將到來。

Llama 3網址:https://llama.meta.com/llama3/

譯自(有刪改):https://ai.meta.com/blog/meta-llama-3/?utm_source=twitter&utm_medium=organic_social&utm_content=video&utm_campaign=llama3

本文轉載自公眾號AIGC最前線

原文鏈接:??https://mp.weixin.qq.com/s/cyuPhRxeYQx6BgjqA0dPzw??