圖遇見大型語言模型:進展與未來方向的研究 原創

摘要:在現實世界的應用中,如引文網絡、社交網絡和生物數據等領域,圖(graph)在表示和分析復雜關系方面起著至關重要的作用。最近,大型語言模型(Large Language Models, LLMs)在眾多領域取得了顯著成功,并且也被應用于與圖相關的任務中,以超越傳統的基于圖神經網絡(Graph Neural Networks, GNNs)的方法,并實現了最先進的性能。本綜述首先對現有整合LLMs與圖的各類方法進行了全面回顧與分析。首先,我們提出了一種新的分類法,根據LLMs在圖相關任務中所扮演的角色(即增強器、預測器和對齊組件)將現有方法組織為三個類別。隨后,我們沿著該分類法的三個類別系統性地調研了具有代表性的方法。最后,我們討論了當前研究存在的局限性,并指出了未來研究的有前景方向。相關論文已進行總結,并將在以下網址持續更新:https://github.com/yhLeeee/Awesome-LLMs-in-Graph-tasks。

1、引言

圖或圖論,在當今世界的眾多領域中扮演著基礎性角色,特別是在科技、科學和物流領域[引用文獻:Ji等人,2021年]。圖數據展現了節點之間的結構特性,從而揭示了圖內各組成部分之間的關系。許多真實世界的數據集,比如引文網絡[引用文獻:Sen等人,2008年]、社交網絡[引用文獻:Hamilton等人,2017年]以及分子結構數據[引用文獻:Wu等人,2018年],本質上都可以用圖的形式來表示。

為了處理與圖相關的各種任務,圖神經網絡(Graph Neural Networks, GNNs)[引用文獻:Kipf和Welling,2016;Velickovic等人,2018年]已經成為處理和分析圖數據的最熱門選擇之一。GNNs的主要目標是通過節點間的遞歸消息傳遞和聚合機制,為不同類型的下游任務獲取節點、邊或整個圖級別的具有表達力的表示形式。這些機制允許GNNs能夠捕獲和傳播節點特征信息,從而實現對圖結構數據的有效學習和推斷。

近年來,諸如Transformer[ Vaswani等人,2017年]、BERT[ Kenton和Toutanova,2019年]、GPT[ Brown等人,2020年]及其變體等大型語言模型(LLMs)取得了重大進展。這些LLMs能夠在稍作適應后輕松應用于多種下游任務,在諸如情感分析、機器翻譯和文本分類等各種自然語言處理任務上展現出卓越性能[Zhao等人,2023d]。盡管它們的核心關注點一直是文本序列,但越來越多的研究興趣在于增強LLMs的多模態能力,使其能夠處理包括圖[Chai等人,2023年]、圖像[Zhang等人,2023b年]和視頻[Zhang等人,2023a年]在內的多樣化數據類型。

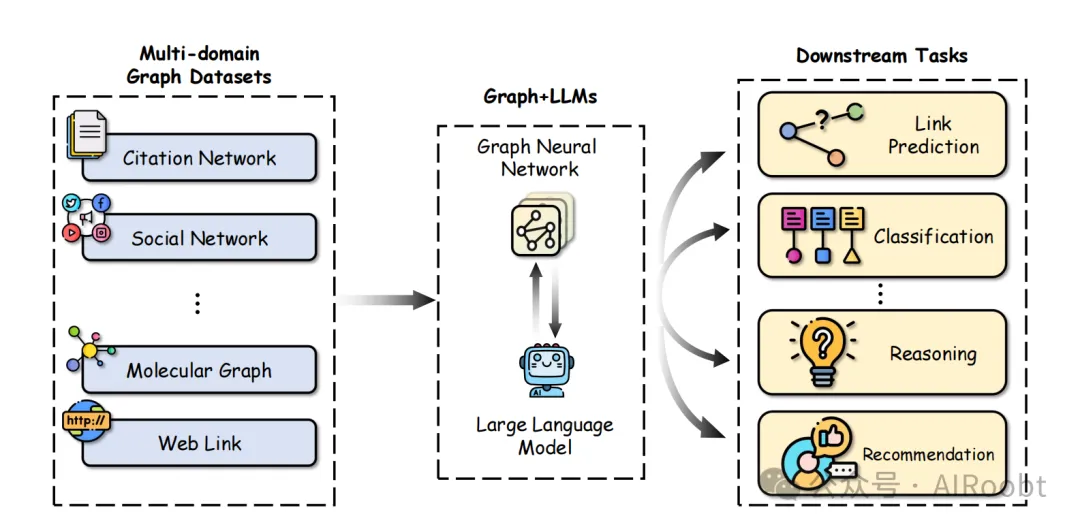

LLMs在圖相關任務中的應用日益顯著。借助LLMs,人們與圖形交互的方式發生了顯著轉變,特別是在包含帶有文本屬性節點的圖形上。如圖1所示,圖與LLMs的集成在眾多圖領域的各種下游任務中都展現出了成功案例。將LLMs與傳統的GNNs結合使用可以互惠互利并增強圖學習效果。雖然GNNs擅長捕捉結構信息,但其主要依賴于語義受限的嵌入作為節點特征,這限制了它們表達節點全部復雜性的能力。而引入LLMs可以使GNNs得到更強的節點特征,有效捕獲結構和上下文兩方面的信息。另一方面,LLMs在編碼文本方面表現出色,但在捕捉圖形數據中存在的結構信息時往往較弱。將GNNs與LLMs相結合,既可以利用LLMs強大的文本理解能力,又能發揮GNNs捕獲結構關系的優勢,從而實現更全面、強大的圖學習。例如,TAPE[He等人,2023年]利用由LLMs生成的與節點(如論文)相關的語義知識來改進GNNs中初始節點嵌入的質量。此外,InstructGLM[葉等人,2023年]用LLMs替換了GNNs中的預測器,通過展平圖形和設計指令提示等技術,利用自然語言的強大表征能力。MoleculeSTM[劉等人,2022年]將GNNs和LLMs對齊到同一向量空間中,將文本知識(即關于分子的信息)引入圖中,從而提升推理能力。

圖1:在眾多不同的圖領域中,圖與大型語言模型(LLMs)的整合在多種下游任務中均展現出成功的應用。

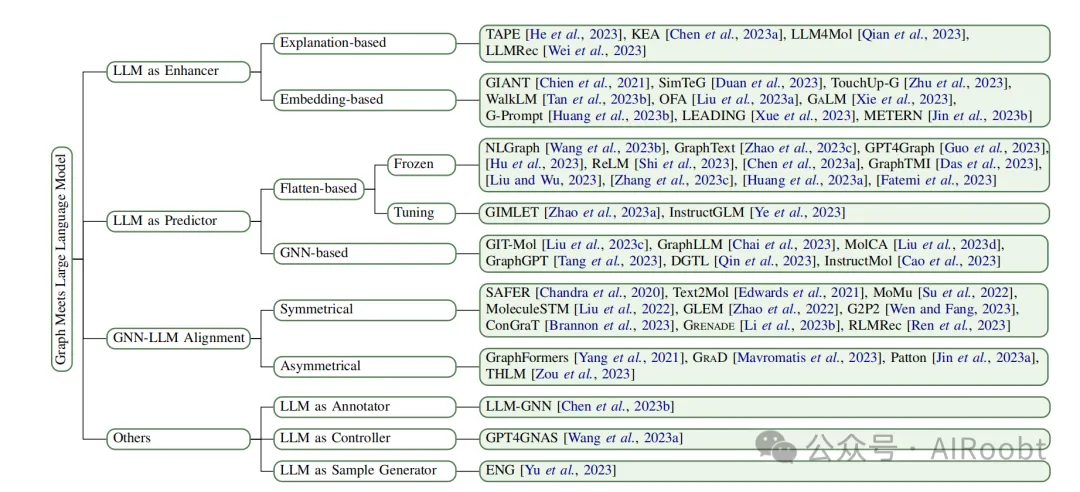

顯然,從不同角度來看,LLMs對圖相關任務產生了重大影響。為了獲得更好的系統化概述,參照Chen等人[2023a年]的研究,我們在圖2中構建了第一級分類體系,按照LLMs在整個模型流程中所扮演的角色(即增強器、預測器和對齊組件)進行分類。我們進一步細化了這個分類體系,并對初始類別引入了更多粒度。

動機:盡管LLMs越來越多地應用于圖相關任務,但這一快速發展的領域仍缺乏系統的綜述。Zhang等人[2023d年]開展了一項前瞻性的調查,發表了一篇視角論文,探討了圖形與LLMs融合面臨的挑戰和機遇。Liu等人[2023b年]提供了另一項相關調查,總結了現有的圖基模型,并概述了預訓練和適應策略。然而,兩者在綜合覆蓋范圍和專門針對LLMs如何增強圖的分類體系方面均存在不足。相比之下,我們專注于圖和文本模態共存的場景,并提出了一個更為細致的分類體系,系統地回顧和總結了當前LLMs在圖相關任務上的技術現狀。

貢獻:本工作的貢獻可以從以下三個方面概括。1)結構化的分類體系:通過一個結構化的分類體系,展示了該領域的廣泛概覽,并將現有工作分為四個類別(見圖2)。2)全面的回顧:基于提出的分類體系,系統地勾勒出了LLMs在圖相關任務方面的當前研究進展。3)未來方向的探討:我們討論了現有工作中存在的局限性,并指出了可能的未來研究方向。

2、前言

在本節中,我們將首先介紹與本次調查密切相關的兩個關鍵領域的基本概念,即圖神經網絡(GNNs)和大型語言模型(LLMs)。接下來,我們將簡要介紹新提出的分類體系。

2.1 圖神經網絡

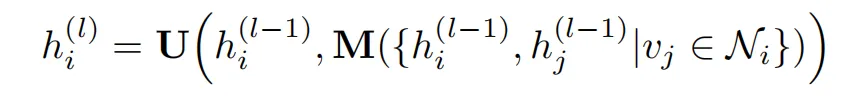

定義:大多數現存的GNN遵循消息傳遞范式,其中包括消息聚合和特征更新過程,例如GCN[Kipf和Welling,2016年]和GAT[Velickovic等人,2018年]。它們通過迭代地聚合鄰域信息并對它們進行非線性函數更新來生成節點表示。前向傳播過程可定義為:

其中,hi(l) 是第 l 層節點 i 的特征向量,Ni 是節點 i 的鄰居節點集合。函數 M 表示聚合鄰居信息的消息傳遞函數,U 表示輸入中心節點特征和鄰居節點特征的更新函數。通過堆疊多層,GNNs能夠從更高階的鄰居那里聚合信息。

(注釋:這個公式描述的是圖神經網絡(GNN)中的一個典型的消息傳遞(message passing)和節點更新(node updating)過程。這個過程是GNN的核心機制,用于在圖中的節點之間傳播和聚合信息。下面是對這個公式的詳細解釋:

1. h(il):

- 這是第l層中節點i的特征向量。在GNN的每一層,每個節點都會有一個特征向量,它包含了節點的信息以及從鄰居節點聚合過來的信息。

2. hi(l-1):

- 這是第l-1層中節點i的特征向量。在GNN中,節點的特征向量會隨著層數的增加而更新,新的特征向量是基于前一層的特征向量和鄰居節點的信息計算得到的。

3. Ni:

- 這是節點i的鄰居節點集合。在圖中,每個節點都有一些直接相連的節點,這些節點被稱為鄰居節點。鄰居節點的信息對于更新當前節點的特征向量至關重要。

4. M:

- 這是消息傳遞函數,用于聚合鄰居節點的信息。這個函數定義了如何將鄰居節點的特征向量合并到當前節點的特征向量中。常見的聚合函數包括求和(sum)、取平均(mean)、最大值(max)等。

5. U:

- 這是更新函數,它使用中心節點的特征和鄰居節點的特征作為輸入來更新節點的特征向量。更新函數通常還會結合一些激活函數(如ReLU)來增加模型的非線性。

6. h(jl-1) | vj ∈ Ni:

- 這表示對于節點i的所有鄰居節點vj,取它們在第l-1層的特征向量h(jl-1)。這是消息傳遞的一部分,其中每個鄰居節點的特征向量都會根據某種規則被聚合。

7. stacking multiple layers:

- 通過堆疊多層GNN,可以聚合來自高階鄰居(不僅是直接鄰居,還包括鄰居的鄰居等)的信息。每一層都會從前一層的特征向量和鄰居節點的信息中學習新的特征表示。

總的來說,這個公式展示了GNN如何通過消息傳遞和節點更新機制來學習圖中節點的高階表示。通過這種方式,GNN能夠捕捉圖中的結構信息和節點間的復雜關系,從而在各種圖相關任務中取得良好的性能。)

圖預訓練和提示:盡管GNN已在圖機器學習中取得一定成果,但它們通常需要昂貴的標注,并且難以泛化至未見過的數據。為了解決這些問題,圖預訓練旨在提取通用知識,使得圖模型能更容易地處理不同任務,而無需大量標注成本。當前主流的圖預訓練方法可以分為對比學習和生成式方法兩大類。例如,GraphCL[You等人,2020年]和GCA[Zhu等人,2021年]遵循對比學習框架,最大化兩個增強視圖之間的相似性。Sun等人[2023b年]將對比思想擴展到了超圖領域。而GraphMAE[Hou等人,2022年]、S2GAE[Tan等人,2023a年]和WGDN[Cheng等人,2023年]則采用了掩蔽圖的某個成分并嘗試重構原始數據的方法。典型的“預訓練與微調”學習方案基于預訓練任務與下游任務在某些內在任務空間上共享共同性的假設。而在自然語言處理領域,研究人員逐漸關注一種新的范式——“預訓練、提示及微調”,其目的是通過重新構造輸入數據以適應預設任務。這一想法也自然地被應用到了圖學習領域。GPPT[Sun等人,2022年]首先通過掩蔽邊預測進行圖模型預訓練,然后將獨立節點轉換為token對,并將下游分類任務重新表述為邊預測任務。此外,All in One[Sun等人,2023a年]提出了一個多任務提示框架,統一了圖提示和語言提示的格式。

2.2 大型語言模型

定義:雖然目前對于大型語言模型(LLMs)尚無明確的定義[Shayegani等人,2023年],但在本調查中我們給出一個針對所提及LLMs的具體定義。關于LLMs的兩項有影響力的調查[Zhao等人,2023d;Yang等人,2023年]從模型規模和訓練方法的角度區分了LLMs和預訓練語言模型(PLMs)。具體來說,LLMs是指那些經過大規模數據預訓練的巨型語言模型(即十億級別參數量),而PLMs則是指早期預訓練的、具有適度參數規模(即百萬級別)的模型,這些模型能夠在特定任務數據上輕松進一步微調,以實現對下游任務更好的表現。鑒于GNNs參數量相對較小,結合GNNs和LLMs時往往不需要具有大型參數的LLMs。因此,我們遵循Liu等人[2023b]的思路,在本調查中將LLMs的定義擴展到包括先前調查中定義的LLMs和PLMs兩類模型。

進化歷程:LLMs可以根據非自回歸和自回歸語言建模的方式劃分為兩大類別。非自回歸LLMs通常專注于自然語言理解,采用“掩碼語言建模”作為預訓練任務,而自回歸LLMs更側重于自然語言生成,經常利用“下一個令牌預測”目標作為其基礎任務。像BERT[Kenton和Toutanova,2019年]、SciBERT[Beltagy等人,2019年]和RoBERTa[Liu等人,2019年]等經典的僅編碼器模型屬于非自回歸LLMs類別。最近,自回歸LLMs持續發展,例如基于編碼器-解碼器結構構建的Flan-T5[Chung等人,2022年]和ChatGLM[Zeng等人,2022年],以及基于僅解碼器架構的GPT-3[Brown等人,2020年]、PaLM[Chowdhery等人,2022年]、Galactica[Taylor等人,2022年]和LLaMA[Touvron等人,2023年]。值得注意的是,LLMs在架構和訓練方法上的進步催生了新興能力[Wei等人,2022a],即通過諸如上下文學習[Radford等人,2021年;Dong等人,2022年]和鏈式思維[Wei等人,2022b]等技術,在小樣本或零樣本場景下處理復雜任務的能力。

2.3 提出的分類體系

我們提出一個分類體系(如圖2所示),該體系將涉及圖形和文本兩種模態的代表性技術組織成三大主要類別:(1) LLM作為增強器,其中LLMs被用來提升GNNs的分類性能;(2) LLM作為預測器,其中LLMs利用輸入的圖結構信息進行預測;(3) GNN與LLM的對齊,通過對齊技術,LLMs語義上增強GNNs的功能。我們注意到,在某些模型中,由于LLMs參與程度較低,很難將其歸入這三大主要類別中。因此,我們將它們單獨歸類為“其他”類別,并在圖2中提供了它們的具體作用。例如,LLM-GNN [Chen等人,2023b]主動選擇節點供ChatGPT注釋,從而通過將LLM作為一個標注器來增強GNN的訓練。GPT4GNAS [Wang等人,2023a]在圖神經網絡架構搜索任務中視LLM為一個經驗豐富的控制器,它利用GPT-4 [OpenAI, 2023]探索搜索空間并生成新的GNN架構。此外,ENG [Yu等人,2023]使LLM成為一個樣本生成器,用于生成帶有標簽的額外訓練樣本,為GNN提供充分的監督信號。

接下來的章節中,我們將按照提出的分類體系中的三大主要類別,分別對將LLMs融入圖相關任務的方法進行全面綜述。

圖2:借助大型語言模型(LLMs)解決圖任務的模型分類體系及其代表性例子

(注釋:使用大型語言模型(LLMs)解決圖任務的模型分類體系,并且提供了一些代表性的例子。這個分類體系將模型分為幾個主要類別,每個類別都有其特定的角色和應用場景。

1. 基于解釋的模型(Explanation-based):

- 這一類模型使用LLMs來生成解釋或理由,以支持圖任務的決策過程。例如,TAPE和LLMRec可能生成為什么某個節點對分類或預測特別重要的理由。

2. LLM作為增強器(LLM as Enhancer):

- 在這一類中,LLMs被用來增強圖神經網絡(GNNs)的性能。GIANT和SimTeG等模型可能會結合LLMs的文本理解能力和GNNs的圖結構處理能力來提高整體性能。

3. 基于嵌入的模型(Embedding-based):

- 這些模型使用LLMs來生成或改進節點或圖的嵌入表示。WalkLM和OFA等模型可能會利用LLMs來學習更豐富的節點特征表示,這些表示可以用于各種下游任務。

4. 凍結(Frozen):

- 這一類涉及到使用預訓練的LLMs,但不對它們的權重進行進一步的訓練或微調。這些模型可能直接使用LLMs的輸出作為特征或輔助信息。

5. 扁平化調整(Flatten-based Tuning):

- 這些方法可能涉及將LLMs的輸出進行扁平化處理,然后對這些特征進行調整或微調,以適應特定的圖任務。

6. LLM作為預測器(LLM as Predictor):

- 在這一類中,LLMs被直接用作預測器,而不依賴于GNNs。GIT-Mol和GraphLLM等模型可能會直接使用LLMs來預測節點屬性或圖的特性。

7. 基于GNN的模型(GNN-based):

- 這些模型結合了GNNs和LLMs,以利用兩者的優勢。GraphGPT和DGTL等模型可能會使用GNNs來處理圖結構數據,同時使用LLMs來處理文本信息。

8. 對稱的(Symmetrical):

- 這一類可能指的是同時使用LLMs和GNNs的模型,兩者在模型中具有相似的角色或重要性。

9. GNN-LLM對齊(GNN-LLM Alignment):

- 這些模型專注于對齊GNNs和LLMs的輸出,以便兩者可以更好地協同工作。GraphFormers和GRAD等模型可能會探索如何整合GNNs的空間信息和LLMs的語言信息。

10. LLM作為注釋器(LLM as Annotator):

- 這一類模型使用LLMs來為圖數據提供注釋或標簽,可能用于半監督或無監督學習場景。

11. LLM作為控制器(LLM as Controller):

- 在這一類中,LLMs可能用來指導或控制GNNs的行為,例如決定哪些部分的圖數據更重要或應該被重點關注。

12. LLM作為樣本生成器(LLM as Sample Generator):

- 這些模型使用LLMs來生成圖任務的樣本數據,可能用于數據增強或模擬場景。)

3、LLM作為增強器

GNNs已成為分析圖結構數據的強大工具。然而,主流基準數據集(如Cora[楊等人,2016年]和Ogbn-Arxiv[胡等人,2020年])采用淺層嵌入方法(如詞袋、跳字模型[Mikolov等人,2013年]或TF-IDF[Salton和Buckley,1988年])來編碼TAG中的文本信息,這不可避免地限制了GNNs在TAG上的性能。LLM作為增強器的方法對應于借助強大的LLMs提高節點嵌入的質量。由此產生的嵌入會被附加到圖結構中,供任何GNNs使用,或者直接輸入下游分類器以完成各種任務。我們將這些方法自然地分為兩類:基于解釋的增強和基于嵌入的增強,取決于它們是否利用LLMs生成額外的文本信息。

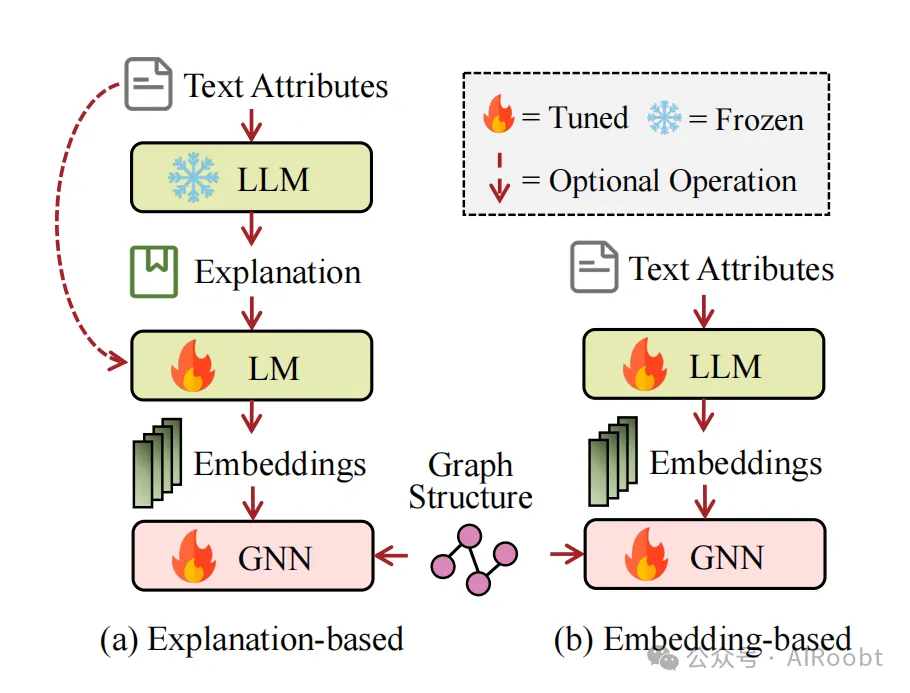

3.1 基于解釋的增強

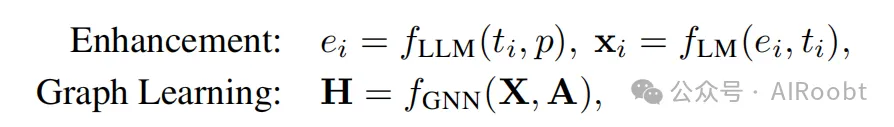

為了豐富文本屬性,基于解釋的增強方法專注于利用LLMs強大的零樣本能力捕獲高層次信息。如圖3(a)所示,通常它們會促使LLMs生成語義豐富的附加信息,如解釋、知識實體和偽標簽。典型流程如下:

其中ti為原始文本屬性,p是設計好的文本提示,ei為LLMs生成的附加文本輸出,xi∈RD和X∈RN×D分別表示維度為D的增強后的節點i的初始節點嵌入和嵌入矩陣,同時利用鄰接矩陣A∈RN×N通過GNNs獲取節點表示H∈RN×d,其中d是表示的維度。例如,TAPE[何等人,2023年]是基于解釋增強方法的先驅工作,它促使LLMs生成解釋和偽標簽以增強文本屬性。之后,相對小型的語言模型會在原始文本數據和解釋上進行微調,以編碼文本語義信息作為初始節點嵌入。陳等人[2023a年]探究了LLMs在圖學習中的潛在能力。他們首先比較了可觀察嵌入的LLMs與淺層嵌入方法,然后提出KEA來豐富文本屬性。KEA促使LLMs生成一系列知識實體及其文本描述,并通過微調的預訓練語言模型和深度句子嵌入模型進行編碼。LLM4Mol[錢等人,2023年]試圖利用LLMs協助分子性質預測。具體來說,它利用LLMs生成原始SMILES的語義豐富的解釋,然后微調一個小規模的語言模型來進行下游任務。LLMRec[魏等人,2023年]旨在利用LLMs解決圖推薦系統中的數據稀疏性和數據質量問題。它通過LLMs強化用戶-項目交互邊,并生成用戶的/項目的側信息,最后使用輕量級的GNN[何等人,2020年]編碼增強后的推薦網絡。

圖3:LLM作為增強器方法的示意圖:

a) 基于解釋的增強,該方法利用LLMs生成文本屬性的解釋以增強文本嵌入;

b) 嵌入式增強,該方法直接通過LLMs獲取文本嵌入作為初始節點嵌入。

(注釋:這兩種方法都旨在改善圖任務中文本屬性的處理。

1.基于解釋的增強(a) Explanation-based enhancement):

- 在這種方法中,LLMs被用來生成文本屬性的解釋。這些解釋是對文本內容的額外描述,可以幫助模型更好地理解文本的含義和上下文。

- 生成的解釋可以與原始的文本嵌入(由傳統的語言模型(LM)生成)結合,從而增強節點的表示。這種增強的表示可以更好地捕捉文本屬性中的復雜性和深度。

- 這種增強的文本嵌入隨后可以用于圖神經網絡(GNNs),以提供更豐富的節點特征,幫助GNNs在圖任務中做出更準確的預測。

2. 基于嵌入的增強(b) Embedding-based enhancement):

- 在這種方法中,LLMs直接用來生成文本嵌入,這些嵌入作為圖任務中節點的初始表示。

- 與基于解釋的方法不同,這里LLMs生成的嵌入不需要與任何其他文本嵌入結合,而是直接作為節點的特征輸入到GNNs中。

- 這種方法利用了LLMs強大的語義理解能力,直接將文本數據轉換為嵌入空間中的向量表示,這些向量能夠捕捉文本的復雜語義信息。

圖片中的圖示還展示了一些可選操作,如調整(Tuned)或凍結(Frozen)LLMs的權重。調整意味著對LLMs進行進一步的訓練或微調,以適應特定的圖任務。凍結則意味著使用LLMs的預訓練權重,不對其進行任何修改。

這兩種方法都利用了LLMs在處理文本數據方面的優勢,通過增強文本屬性的表示來提升圖學習任務的性能。通過這種方式,可以將LLMs的語言理解能力與GNNs的結構學習能力結合起來,以處理更復雜的圖任務。)

3.2 嵌入式增強

參見圖3(b),基于嵌入式的增強方法直接利用LLMs輸出文本嵌入作為GNN訓練的初始節點嵌入:

增強:xi = fLLM(ti)

圖學習:H = fGNN(X, A)

此類方法要求使用具有嵌入可見性或開源的LLMs,因為它需要直接訪問文本嵌入并結合結構信息對LLMs進行微調。當前許多先進LLMs(例如GPT4[OpenAI, 2023年]和PaLM[Chowdhery等人,2022年])是閉源的,并僅提供在線服務。嚴格的限制使得研究人員無法訪問其參數和輸出的嵌入。這類方法大多采用級聯形式,并利用結構信息輔助語言模型在預訓練或微調階段捕捉信息,以便最大程度地應用于大規模應用。典型的例子是GALM[Xie等人,2023年],它在一個給定的大規模圖譜語料庫上預訓練PLMs和GNN聚合器,以捕獲對大量應用最有價值的信息,然后針對特定下游應用進一步微調框架以提升性能。

有幾項研究致力于通過在LLMs的微調階段融入結構信息來生成節點嵌入。代表性的是GIANT[Chien等人,2021年],它通過一種新型的自我監督學習框架微調語言模型,該框架采用XR-Transformers解決鏈接預測上的極端多標簽分類問題。SimTeG[段等人,2023年]和TouchUp-G[朱等人,2023年]遵循相似的方式,兩者都通過類似鏈接預測的方法微調PLMs,幫助它們感知結構信息。兩者之間的微妙差異在于,TouchUp-G在鏈接預測時使用負采樣,而SimTeG則采用參數高效的微調方式加速微調過程。G-Prompt[黃等人,2023b年]在PLMs末端引入了一個圖適配器,以幫助提取具有圖意識的節點特征。一旦訓練完成,任務特定的提示被整合進來,以產生針對各種下游任務的可解釋節點表征。WalkLM[Tan等人,2023b年]是一種無監督的通用圖表示學習方法,第一步是在圖上生成帶屬性的隨機游走并通過自動化文本化程序組成大致有意義的文本序列;第二步則是利用文本序列微調LLM并從LLM中提取表征。METERN[金等人,2023b年]引入關系先驗令牌來捕獲關系特異性信號,并使用一個語言編碼器跨關系建模共享知識。LEADING[薛等人,2023年]有效地微調LLMs并將LLM中的風險知識轉移到下游GNN模型中,從而降低計算成本和內存開銷。

最近的一項工作OFA[劉等人,2023a年]嘗試提出一個通用圖學習框架,該框架可以利用單一圖模型執行適應性下游預測任務。它使用人類可讀的文本描述所有節點和邊,并通過LLMs將不同領域的它們編碼到同一空間中。隨后,通過在輸入圖中插入任務特定的提示子結構,框架能夠適應性地執行不同的任務。

3.3 討論

LLM作為增強器的方法在TAG上展現出卓越的性能,能夠有效捕獲文本和結構信息。此外,它們還表現出強大的靈活性,因為GNNs和LLMs是即插即用的,允許它們利用最新技術來解決遇到的問題。這類方法(特別是基于解釋的增強方法)的另一個優點是它們開辟了使用閉源LLMs輔助圖相關任務的道路。然而,盡管一些論文聲稱其具有良好的可擴展性,實際上,當處理大規模數據集時,LLM作為增強器的方法確實涉及顯著的開銷。以基于解釋的方法為例,對于包含N個節點的圖,它們需要向LLMs的API查詢N次,這的確是一項巨大的成本。

4、LLM作為預測器

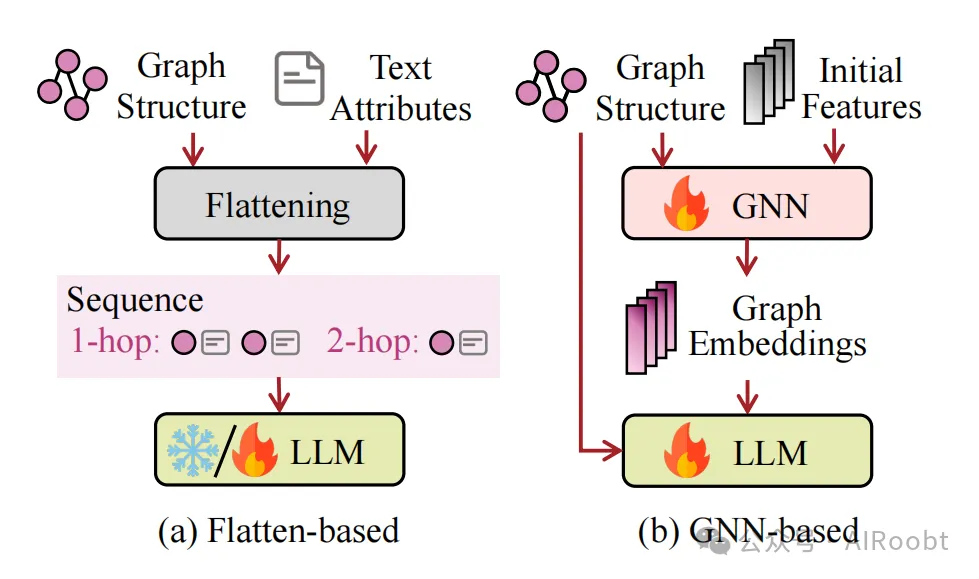

這個類別背后的核心理念是利用LLMs在統一的生成范式下,對廣泛的與圖相關的任務(如分類和推理等)進行預測。然而,將LLMs應用于圖模態時,面臨獨特挑戰,主要原因在于圖數據通常缺乏直接轉化為順序文本的簡單方式,因為不同的圖以不同的方式定義結構和特征。在本節中,我們將模型大致分為基于展平和平面GNN預測兩類,依據是否利用GNNs為LLMs提取結構特征。

(注釋:這個類別的核心思想是使用大型語言模型(LLMs)來預測和處理各種與圖相關的任務,比如圖的分類和邏輯推理等。但是,當我們想用LLMs來處理圖數據時,會遇到一些特別的挑戰。這是因為圖的結構和特征通常是很復雜的,而且不像文本那樣可以很容易地轉換成一連串的文字。所以,在這部分內容中,我們會看到兩種主要的方法來解決這個問題。第一種是“基于展平”的方法,它可能意味著把圖的結構和特征轉換成一種可以被LLMs處理的形式。第二種是“平面GNN預測”,這種方法使用圖神經網絡(GNNs)來幫助LLMs理解圖的結構特征。這兩種方法都是為了讓LLMs更好地處理和預測圖數據。)

4.1 基于展平的預測

目前大多數利用LLMs作為預測器的嘗試采用了將圖轉化為文本描述的策略,這有助于LLMs通過文本序列直接處理圖數據。如圖4(a)所示,基于展平的預測通常包括兩個步驟:(1) 使用展平函數Flat(·)將圖結構轉化為節點或令牌的序列Gseq;(2) 然后應用解析函數Parse(·)從LLMs生成的輸出中檢索預測標簽,如下所示:

圖結構展平:Gseq = Flat(V, E, T ,J )

預測:Y? = Parse(fLLM(Gseq, p))

其中,V、E、T 和J 分別代表節點集合、邊集合、節點文本屬性集合和邊文本屬性集合。p 表示當前圖任務的指令提示,而Y? 是預測得到的標簽。

(注釋:在許多嘗試中,人們通常把圖數據轉換成一連串的文字描述,這樣大型語言模型(LLMs)就可以直接處理這些圖數據了。這個過程大致分為兩步,就像圖4(a)展示的那樣:

1. 圖結構展平:首先,我們使用一個叫做“展平函數”的東西,它把復雜的圖結構(包括節點、邊、節點上的文本信息和邊上的文本信息)轉換成一序列的節點或令牌,我們把這串東西叫做Gseq。

2. 預測:然后,我們用一個叫做“解析函數”的東西,從LLMs根據Gseq和一些提示(這些提示告訴我們LLMs我們現在要做什么任務)生成的輸出中提取出預測的標簽。

用數學符號來表示就是:

- 我們先得到一個序列Gseq,它是由節點V、邊E、節點的文本屬性集合T和邊的文本屬性集合J通過展平函數Flat(·)得到的。

- 接著,我們用LLMs的函數fLLM,輸入是Gseq和任務提示p,最后得到一個預測的輸出Y?。

這里的V、E、T和J分別代表圖中的節點、邊、節點的文本屬性和邊的文本屬性。p是我們給LLMs的指令提示,告訴它我們現在要完成什么任務。Y?是我們想要預測的結果,也就是標簽。)

圖4展示了LLM作為預測器的方法示意圖:

a) 展平策略為基礎的預測方法,通過不同的展平策略將圖形結構與LLM相結合;

b) 基于GNN的預測方法,利用GNN捕獲結構信息供LLM使用。

(注釋:兩種使用大型語言模型(LLMs)作為預測器的方法

1. 基于展平的預測(a) Flatten-based prediction):

- 在這種方法中,圖結構通過某種展平策略被轉換成一個序列,這樣LLMs就可以處理它了。展平函數(Flat(·))將圖的節點和邊轉換成一個線性序列,可能還包括節點和邊的文本屬性。

- 這個序列(Gseq)隨后被輸入到LLM中,LLM根據這個序列生成預測結果。這個過程可能涉及到一些額外的步驟,比如解析LLM的輸出來提取最終的預測標簽(Y?)。

2. 基于GNN的預測(b) GNN-based prediction):

- 在這種方法中,圖神經網絡(GNNs)首先被用來捕捉圖的結構信息。GNNs通過消息傳遞和節點更新機制來學習節點的嵌入表示,這些嵌入表示包含了圖的結構特征。

- 學習到的嵌入表示(可能是1跳或2跳鄰居的信息)隨后被用作LLM的輸入。這樣,LLM可以利用GNNs提供的結構信息來進行預測。

一些具體的步驟和組件:

- 圖結構和文本屬性(Graph Structure & Attributes):這是原始圖數據的兩個組成部分,結構特征描述了節點和邊如何連接,而文本屬性可能包含了節點和邊的描述或標簽。

- 展平(Flattening):這是將圖數據轉換成序列的過程,以便LLMs可以處理。

- GNN序列(GNN Sequence):這是通過GNN處理后得到的節點序列,它包含了結構信息。

- LLM:這是大型語言模型,它接收展平后的序列或GNN的嵌入表示,并生成預測結果。

這兩種方法都試圖將圖數據轉換為LLMs可以處理的格式,但它們在如何準備輸入數據和如何利用LLMs方面有所不同。基于展平的方法直接處理圖的結構,而基于GNN的方法則先使用GNNs來提取結構信息,然后將這些信息傳遞給LLMs。)

模型的解析策略通常標準化。例如,考慮到LLM(大型語言模型)的輸出往往包含其推理和邏輯過程,特別是在鏈式思考(CoT)場景中,一些研究工作[如Fatemi等人,2023;Zhao等人,2023c;Chen等人,2023a;Guo等人,2023;Liu和Wu,2023;Wang等人,2023b]利用正則表達式從輸出中提取預測標簽。某些模型[如Chen等人,2023a;Fatemi等人,2023;Wang等人,2023b;Chai等人,2023;Huang等人,2023a]進一步將LLM的解碼溫度設置為0,以減少LLM預測的變異性并獲得更可靠的結果。另一個方向是將圖任務形式化為多選問答問題[Robinson和Wingate,2022],其中LLM被指示在提供的選項中選擇正確答案。例如,一些研究[如Huang等人,2023a;Hu等人,2023;Shi等人,2023]通過在零樣本環境下給出選項并在提示中附加指令來約束LLM的輸出格式,比如“對于你的答案,不要給出任何推理或邏輯”。此外,還有一些方法,如GIMLET[Zhao等人,2023a]和InstructGLM[葉等人,2023],對LLM進行微調以直接輸出預測標簽,使它們無需額外的解析步驟就能提供準確的預測。

(注釋:在這些模型中,研究人員通常會采用一些標準的方法來從大型語言模型(LLMs)的輸出中提取有用的信息。因為LLMs在解決問題時會展示它們的思考過程,就像人在解決問題時會一步步地推理一樣。有些研究是這樣的:

- 他們會用類似“查找和替換”這樣的技術(正則表達式)來找出LLMs輸出中的關鍵信息,也就是預測的答案。

- 有些模型會讓LLMs的輸出更加確定,不那么隨機。他們通過調整一個叫做“解碼溫度”的設置來實現這一點,把它設為0,這樣LLMs就只給出最可能的答案,而不是很多可能性。

- 另一種方法是把圖的問題變成一個多項選擇題,然后讓LLMs從幾個選項中選擇正確的答案。這就像是在問LLM:“在這些選項中,哪一個是對的?”

- 有些研究還會特別告訴LLMs不需要給出解釋,只需要直接給出答案。這樣,輸出的答案就很簡單,不需要再進行額外的處理。

- 最后,也有一些方法會特別訓練LLMs,讓它們直接輸出預測的標簽,這樣就不用再去分析LLMs說了什么,直接就能得到預測結果。

所以,這些方法都是在嘗試讓LLMs更好地理解和解決圖相關的問題,并且盡可能直接和清晰地給出答案。)

相比于解析策略,展平策略展現出顯著的變化性。接下來,我們將依據LLM參數是否更新這一條件,組織整理展平方法。

LLM凍結狀態下

GPT4Graph[Guo等人,2023]利用諸如GML[Himsolt, 1997]和GraphML[Brandes等人,2013]等圖形描述語言來表示圖形結構。這些語言提供了標準化的語法和語義,用于表示圖形內的節點和邊。受語言學句法樹[Chiswell和Hodges, 2007]啟發,GraphText[Zhao等人,2023c]利用圖-句法樹將圖形結構轉換為一系列節點序列,然后將其輸入到LLM中進行無需訓練的圖形推理。此外,ReLM[Shi等人,2023]使用簡化的分子輸入線性表達系統(SMILES)字符串,為分子圖形結構提供一維線性化表示。圖形數據也可以通過鄰接矩陣和鄰接表等方式表示。若干方法[Wang等人,2023b; Fatemi等人,2023; Liu和Wu, 2023; Zhang等人,2023c]直接采用數值化組織的節點列表和邊列表,以純文本方式描繪圖形數據。GraphTMI[Das等人,2023]還進一步探索了不同模態,如motif和圖像,以便將圖形數據與LLM相結合。

(注釋:在大型語言模型(LLM)的凍結狀態下,意味著我們不訓練或調整LLM的內部參數,而是直接使用它來處理圖數據。這里有幾種不同的方法來表示圖,讓LLM能夠理解并進行推理:

1. 圖形描述語言:

- 有些研究,比如GPT4Graph,使用特殊的圖形描述語言(比如GML和GraphML)來描述圖的結構。這些語言有自己的規則和語義,就像我們用單詞和句子來交流一樣,它們用來描述節點和邊的關系。

2. 圖-句法樹轉換:

- GraphText這種方法受到語言學中句法樹的啟發,它把圖的結構轉換成一系列的節點序列,就像句子中的單詞順序一樣,然后這些序列可以直接輸入到LLM中,讓LLM進行圖推理,而不需要額外的訓練。

3.一維線性化表示:

- ReLM這種方法用一種簡化的分子表示系統(SMILES)來表示分子圖。這種表示就像一個線性的字符串,可以很容易地被LLM讀取和理解。

4.鄰接矩陣和鄰接表:

- 有些方法通過鄰接矩陣或鄰接表來表示圖,這些都是數學上常用的表示圖的方式。鄰接矩陣是一個表格,顯示了圖中每對節點之間是否有邊連接;鄰接表則是列出了每個節點的鄰居節點。

5. 數值化的節點列表和邊列表:

- 還有一些方法直接用數值列表來表示圖中的節點和邊,就像列出了一個清單一樣。這種純文本的描述方式可以讓LLM直接讀取圖的信息。

6. 多模態表示:

- GraphTMI這種方法探索了不同的模態,比如圖的motif(圖案)和圖像,來結合圖數據和LLM。這意味著它不僅僅使用文本,還可能使用圖像等其他類型的數據來幫助LLM更好地理解圖。

這些方法都是在嘗試用不同的方式把圖的信息轉換成LLM能夠處理的格式,讓LLM能夠讀取和推理圖數據,而不需要對LLM進行任何訓練或調整。)

另一方面,使用自然敘述表達圖形結構的方法也正在穩步發展。陳等人[2023a]和胡等人[2023]都將引用網絡的結構信息整合到提示中,這是通過明確地使用單詞"引用(cite)"表示邊關系,并使用論文索引或標題表示節點實現的。而黃等人[2023a]并未使用“引用(cite)”來表示邊,而是通過列舉當前節點隨機選擇的k跳鄰居來描述關系。此外,GPT4Graph[Guo等人,2023]和陳等人[2023a]模仿了GNN的聚合行為,總結當前鄰居的屬性作為額外輸入,旨在提供更多結構信息。值得注意的是,Fatemi等人[2023]探討了多種節點和邊的表示方法,總共檢驗了11種策略。例如,他們使用索引或字母表示節點,并應用箭頭或括號來表示邊的關系。

(注釋:在描述圖結構時,研究人員也在嘗試用更自然的語言來表達。這里有一些具體的方法:

1. 整合引用網絡信息:

- 陳等人和胡等人在他們的研究中,把引用網絡的結構信息放到了提示中。他們用“引用”這個詞來明確表示節點之間的連接關系,就像論文之間互相引用一樣。節點則用論文的索引或標題來表示。

2. 描述節點的鄰居

- 黃等人則用了一種不同的方法。他們不是用“引用”來表示連接,而是列出一個節點的幾跳鄰居,這樣也能表達節點之間的關系。

3. 模仿GNN的聚合行為:

- GPT4Graph和陳等人的研究中,他們模仿了圖神經網絡(GNN)的聚合行為。他們總結了一個節點的鄰居們的屬性,然后把這些信息作為額外的輸入,幫助模型更好地理解圖的結構。

4. 探索不同的表示策略:

- Fatemi等人的研究中,他們探索了很多不同的表示方法。他們用索引或字母來表示節點,用箭頭或括號來表示節點之間的邊關系,總共測試了11種不同的策略。

所以,這些方法都是在嘗試用更自然和直觀的方式來描述圖結構,讓大型語言模型(LLM)能夠更好地理解和處理圖數據。)

LLM調優方面

GIMLET[Zhao等人,2023a]采用了基于距離的位置嵌入技術,以增強LLM對圖形結構的認知能力。在對圖形進行位置編碼時,GIMLET定義了兩個節點之間的相對位置為它們在圖形中的最短距離,這一做法在圖形變換器領域的文獻中得到了廣泛應用[如Ying等人,2021的研究]。類似于黃等人[2023a]的工作,InstructGLM[葉等人,2023]設計了一系列基于最大跳層級別的可擴展提示。這些提示允許中心論文節點通過運用自然語言表述的連接關系,與其任何指定跳層級別的鄰居建立直接關聯,從而能夠與任意期望的鄰近層級建立聯系。

(注釋:在調整大型語言模型(LLM)以更好地處理圖網絡方面,有幾種方法:

1. 基于距離的位置嵌入(GIMLET):

- GIMLET這種方法用了一個技巧,就是給圖中的每個節點一個特別的位置編碼,這個編碼是基于節點之間最短的距離。就像是給每個節點在圖里的位置分配一個坐標,這樣模型就能更容易理解哪些節點是“近”的,哪些是“遠”的。這個方法在圖處理的研究中已經被證明是很有用的。想象一下,當你想教會一個模型理解一張復雜的網狀結構時,就像教一個人理解一個社交網絡或化學分子結構那樣,位置信息至關重要。GIMLET就是教模型關注節點間的相對位置,它把每對節點之間的距離看作是在這個圖形中的“最短路徑”,這樣一來,模型就能更準確地把握不同節點間的關系遠近。這種思想在處理圖形數據的圖形變換器技術中非常流行,比如Ying等人在2021年的研究就曾探討過類似的方法。

2. 可擴展提示(InstructGLM):

- InstructGLM設計了一系列提示,這些提示可以讓模型理解圖中的節點不僅與它的直接鄰居有關系,而且可以與更遠的節點建立聯系。就像是告訴模型,一個節點可以通過幾個“跳”(或者說是中間節點)與圖中的其他節點連接起來。這樣,模型就能理解圖中更復雜的結構和關系了。這個方法有點像制作一份詳細的導航指南,只不過它是為大型語言模型定制的。他們設計了一系列靈活的提示模板,這些模板能夠逐級展開,就像是層層遞進的地圖索引一樣。這樣,模型就能輕松跟隨指引,從一個中心節點出發,無論要探索幾步之遙的鄰居節點還是更遠層次的關系節點,都能通過自然語言表達的連接線索直達目的地。這樣做的好處是,模型不僅能理解單個節點的文本信息,還能結合圖形結構的上下文關系,實現更加精準的信息處理和推理。

這些方法都是在嘗試讓LLM更好地理解圖的結構,通過給節點加上位置信息或者通過設計特別的提示來描述節點之間的關系。這樣,當LLM需要處理圖數據時,它就能更準確地理解圖中的信息,并做出更好的預測或決策。)

4.2 基于GNN的預測

GNN(圖神經網絡)已在通過遞歸的信息交換和節點間聚合,理解圖形結構方面展現出卓越的能力。如圖4(b)所示,與基于展平預測(即將圖形數據轉化為文本描述作為LLM的輸入)相比,基于GNN的預測充分利用GNN的優勢,將圖形數據中存在的內在結構特性和依賴關系與LLM相結合,使LLM具有結構感知能力,如下所示:

圖形學習:H = fGNN(X, A)

預測:Y~ = Parse(fLLM(H, p))

其中X代表節點嵌入矩陣,A為鄰接矩陣,H表示與圖形相關的結構感知嵌入。基于GNN的預測同樣依賴于一個解析器從LLM中提取輸出。然而,將GNN表示集成到LLM中通常需要調整,在訓練過程中提供理想的輸出,這使得LLM的預測格式更容易標準化。

(注釋:圖神經網絡(GNN)就像是一個專門研究圖形的專家,它很擅長通過在圖里的節點之間傳遞和分享信息來理解圖形的結構。就像你在朋友圈里聽說了一些八卦,然后通過這些信息來了解你的朋友們都是誰,他們之間是什么關系。

在圖4(b)中展示的基于GNN的預測方法,就是先用GNN來理解圖形,然后把得到的信息告訴LLM。這就像是先把圖里的信息整理好,然后再告訴LLM,這樣LLM就可以更容易理解這些信息了。

這里的X是每個節點的特征,可以想象成每個節點的一些個人信息,比如年齡、興趣等。A是鄰接矩陣,它告訴我們哪些節點是朋友(即哪些節點是相連的)。H是GNN理解后得到的新信息,它包含了節點之間關系的新理解。

然后,我們用一個解析器從LLM那里得到我們想要的答案。這就像是你問LLM一個問題,然后LLM根據它從GNN那里得到的信息來回答你。

通常,為了讓LLM更好地理解GNN給它的信息,我們可能需要對LLM進行一些調整,讓它知道怎么用這些信息來給出我們想要的答案。這樣,LLM的預測就能更符合我們的期望,也更容易理解。)

各種策略已被提出以融合由GNN學習的結構模式以及LLM捕獲的上下文信息。例如,GIT-Mol[Liu等人,2023c]和MolCA[Liu等人,2023d]都實現了BLIP-2的QFormer[Li等人,2023a]作為跨模態投影器,將圖編碼器的輸出映射到LLM的輸入文本空間。為了有效進行圖-文本交互,采用了多種目標函數和不同的注意力掩蔽策略。GraphLLM[Chai等人,2023]在前綴調優階段通過對圖形表示施加線性投影,得到增強型前綴,使LLM能夠與圖形變換器協同作用,納入對圖形推理至關重要的結構信息。此外,GraphGPT[Tang等人,2023]和InstructMol[Cao等人,2023]都采用簡單的線性層作為輕量級對齊投影器,將編碼后的圖形表示映射到一些圖形令牌,而LLM擅長將這些令牌與多樣化的文本信息對齊。DGTL[Qin等人,2023]則直接將分解的圖形嵌入注入LLM每一層,突出顯示圖形拓撲和語義的不同方面。

(注釋:在圖數據處理中,研究人員提出了各種方法來結合圖神經網絡(GNN)學習到的結構信息和大型語言模型(LLM)捕獲的上下文信息。這里有幾個例子:

1.跨模態投影器:

- 像GIT-Mol和MolCA這樣的研究,使用了一種叫做BLIP-2的QFormer作為跨模態投影器。這個投影器的作用就像是翻譯員,它把GNN輸出的圖信息轉換成LLM能理解的文本信息。

2. 圖-文本交互:

- 為了幫助LLM和圖信息有效地交流,研究人員使用了不同的目標函數和注意力掩蔽策略。這些技術幫助LLM更好地理解圖的結構和文本內容。

3. 增強型前綴:

- GraphLLM研究中,在調整模型的過程中,使用了線性投影來增強圖形表示,這樣LLM就可以更好地和圖變換器一起工作,理解圖形的結構信息。

4. 輕量級對齊投影器:

- GraphGPT和InstructMol研究中,使用了簡單的線性層來把圖形表示轉換成圖形令牌。這些令牌是LLM能夠處理的特殊標記,它們幫助LLM把圖形信息和文本信息對齊。

5. 注入圖形嵌入:

- DGTL研究中,直接把圖的嵌入信息放到LLM的每一層中。這樣做可以讓LLM在處理文本的同時,也關注到圖的拓撲結構和語義信息。

總的來說,這些方法都是在嘗試讓LLM更好地理解和處理圖數據,通過把圖的結構信息轉換成LLM能夠處理的格式,讓兩者能夠有效地結合,從而提高處理圖任務的能力。)

4.3 討論

直接將LLM用作預測器在處理圖形的文本屬性方面顯示出優勢,尤其是在零樣本性能上與傳統GNN相比表現卓越。最終目標是開發和完善將圖形結構信息編碼成LLM能夠有效地理解和操作的格式的方法。基于展平的預測在有效性方面可能具有優勢,而基于GNN的預測往往效率更高。在基于展平的預測中,LLM的輸入長度限制導致每個節點只能訪問其幾跳內的鄰居,這使得捕捉長程依賴性變得困難。此外,由于不涉及GNN,無法解決諸如異質性等GNN固有問題。另一方面,對于基于GNN的預測,由于深度變換器早期層梯度消失問題[Zhao等人,2023a; Qin等人,2023],訓練附加的GNN模塊并將其插入LLM中進行聯合訓練頗具挑戰性。

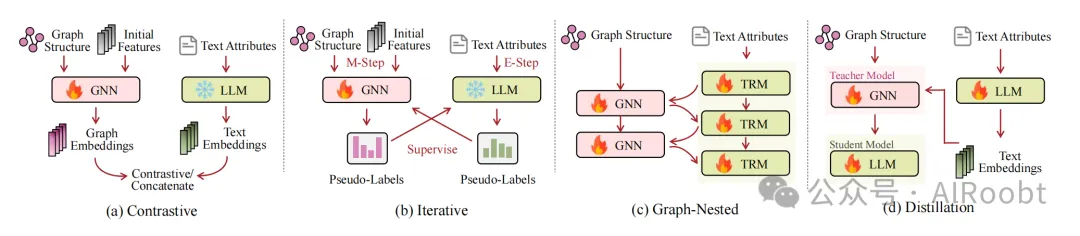

5、GNN與LLM對齊

GNN與LLM的嵌入空間對齊是一種有效結合圖形與文本模態的方法。GNN-LLM對齊確保在特定階段保留每個編碼器的獨特功能,并協調它們的嵌入空間。本節概述了對齊GNN與LLM的技術,根據是否對GNN和LLM同等重視或優先考慮某一模態,這些技術可以分為對稱和非對稱兩類。

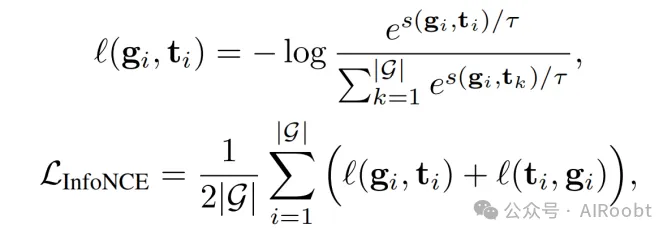

5.1 對稱對齊

對稱對齊是指在對齊過程中對圖形和文本模態進行平等處理。這類方法確保兩種模態的編碼器在各自的應用中都能達到相當的表現水平。典型的對稱對齊架構如圖5(a)所示,采用雙塔樣式,分別使用獨立的編碼器對圖形和文本進行編碼。在對齊過程中,兩種模態僅一次交互。像SAFER [Chandra等人,2020]這樣的方法使用簡單拼接來處理這兩種獨立的嵌入,但這種方法在實現結構信息和文本信息無縫融合方面存在不足,導致兩種模態松散耦合。因此,大多數雙塔樣式模型采用對比學習技術促進對齊,類似于CLIP [Radford等人,2021]用于視覺和語言模態的對齊。一般來說,這些方法包括兩個步驟:第一步是特征提取,獲取圖形表示和文本表示;第二步是使用修改過的InfoNCE損失函數的對比學習過程,其方程式如下:

其中g代表特定圖形的表示,t表示對應圖形文本的表示。s(·, ·)表示評分函數,賦予正對高分值,負對低分值。τ是一個溫度參數,|G|表示訓練數據集中圖形的數量。兩個編碼器的參數都是通過反向傳播基于對比損失進行更新。

圖5展示了GNN-LLM對齊方法的示意圖:

a) 對比、對稱對齊,采用拼接或對比學習方法應用于圖形嵌入和文本嵌入;

b) 迭代對齊,屬于對稱對齊類別,旨在實現兩種模態嵌入間的迭代交互;

c) 圖形嵌套對齊,一種對稱對齊方式,它將GNN與Transformer交織在一起;

d) 知識蒸餾對齊,屬于非對稱對齊,使用GNN作為教師模型來訓練語言模型使其具備對圖形結構的理解能力。

Text2Mol [Edwards等人,2021]提出了跨模態注意力機制,實現在早期融合圖形和文本嵌入。通過transformer解碼器實現,Text2Mol使用LLM的輸出作為源序列,GNN的輸出作為目標序列。這種設置允許注意力機制學習多模態關聯規則,然后利用解碼器的輸出進行對比學習,與GNN處理后的輸出配對。

MoMu [Su等人,2022]、MoleculeSTM [Liu等人,2022]、ConGraT [Brannon等人,2023]和RLMRec [Ren等人,2023]共享類似的框架,采用配對的圖形嵌入和文本嵌入實現對比學習,但在細節上仍存在差異。MoMu和MoleculeSTM均從PubChem [Wang等人,2009]收集分子,前者從已發表的科學論文中檢索相關文本,后者利用分子的相應描述。ConGraT將此架構擴展至分子領域之外,已在社交、知識和引用網絡上驗證了這種圖形-文本配對對比學習方法的有效性。RLMRec建議通過對比建模將LLM的語義空間與推薦系統中的協作關系信號(表明用戶-項目交互)的表示空間對齊。

類似G2P2 [Wen和Fang,2023]和GRENADE [Li等人,2023b]的研究進一步推進了對比學習的使用。具體來說,G2P2增強了對比學習的粒度,并在微調階段引入了提示。在預訓練階段,它在三個層次上應用對比學習:節點-文本、文本-文本摘要和節點-節點摘要,從而強化了文本和圖形表示之間的對齊。提示在下游任務中得以運用,表現出在少量樣本和零樣本文本分類及節點分類任務上的強大性能。另一方面,GRENADE通過整合以圖為中心的對比學習和雙層次的以圖為中心的知識對齊(包括節點級別和鄰域級別對齊)進行優化。

不同于以往方法,迭代對齊方法如圖5(b)所示,對兩種模態平等對待,但在訓練過程中通過允許模態之間進行迭代交互而區別開來。例如,GLEM [Zhao等人,2022]采用期望最大化(EM)框架,其中一個編碼器迭代為另一個編碼器生成偽標簽,使它們能夠對齊它們的表示空間。

5.2 非對稱對齊

當對稱對齊旨在給予兩種模態同等重視時,非對稱對齊則專注于允許一種模態輔助或增強另一種模態。當前研究中,主導方法是利用GNN處理結構信息的能力來強化LLM。這些研究可分為兩大類:嵌套式圖變換器和具有圖意識的蒸餾方法。

嵌套式圖變換器,如圖5(c)所示的GraphFormer [楊等人,2021]就是一個例子,它通過將GNN集成到每個變換器層來展示非對稱對齊。在LLM的每一層中,節點嵌入來自第一個令牌級嵌入,該嵌入對應于[CLS]標記。這一過程涉及收集所有相關節點的嵌入并應用于圖變換器,然后將輸出與輸入嵌入拼接,并傳遞給LLM的下一層。Patton [金等人,2023a]擴展了GraphFormer,提出兩種預訓練策略——網絡上下文化的掩碼語言建模和掩碼節點預測,特別適用于富含文本的圖。在分類、檢索、重排序和鏈接預測等各種下游任務中,它的表現非常出色。

另外,GRAD [Mavromatis等人,2023]采用具有圖意識的蒸餾方法來對齊兩種模態,如圖5(d)所示。它利用GNN作為教師模型為LLM生成軟標簽,促進了聚合信息的傳遞。此外,由于LLM共享參數,在LLM參數更新后,GNN可以從改進的文本編碼中受益。通過迭代更新,開發出一個具備圖意識的LLM,由于去除了GNN,因此在推理階段提高了可擴展性。與GRAD相似,THLM [鄒等人,2023]采用異構GNN來增強LLM的多階拓撲學習能力。它通過兩種不同的策略同時預訓練LLM和輔助GNN。第一種策略側重于預測節點是否為目標節點的上下文圖的一部分。第二種策略利用Masked Language Modeling任務,有助于LLM發展強大的語言理解能力。預訓練過程結束后,丟棄輔助GNN,并對LLM進行微調以適應下游任務。

5.3 討論

為了對齊GNN和LLM,對稱對齊以平等的方式對待每種模態,目的是同時增強GNN和LLM,從而產生能有效處理涉及兩種模態任務的編碼器,利用各自編碼優勢提高模態特異性表征。此外,非對稱方法通過將圖編碼器插入變換器中或直接使用GNN作為教師來增強LLM。然而,對齊技術在面對數據稀缺性問題時面臨挑戰。特別是只有少數圖數據集(例如分子數據集)包含原生的圖-文本對,這限制了這些方法的適用范圍。

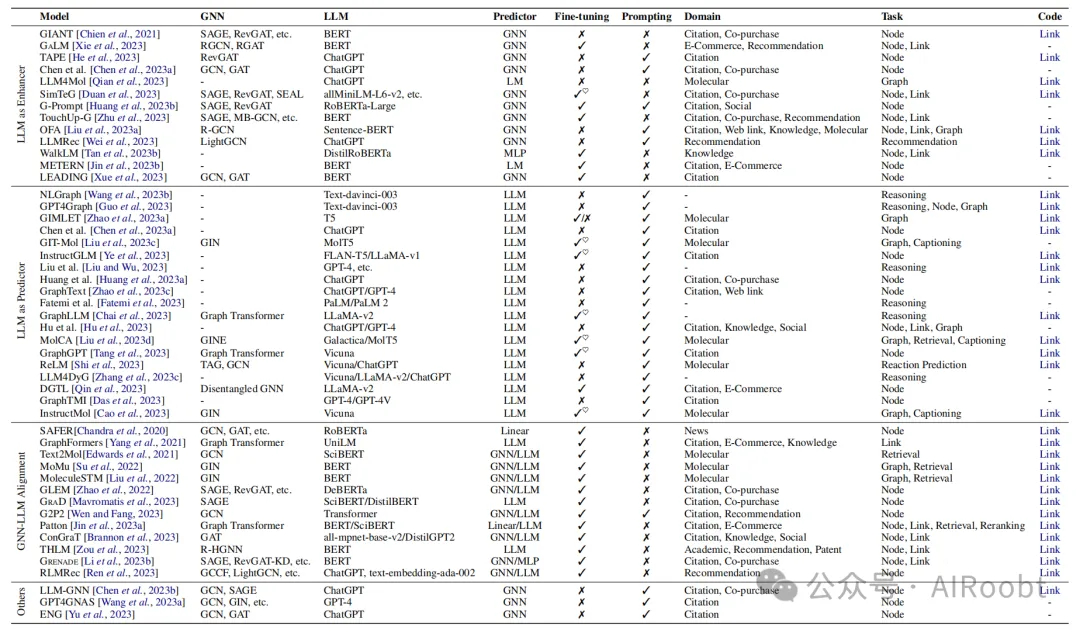

表格1:按發布時間順序排列的文獻匯總,列出了利用LLM協助圖相關任務的各類模型。其中“微調”指是否需要對LLM的參數進行微調,?符號表示該模型采用了參數高效微調(PEFT)策略,比如LoRA和前綴調優。"提示"表明在LLM中使用了文本格式的提示,無論是手動還是自動設置的。

任務縮寫說明:Node代表節點級別的任務;Link代表邊級別的任務;Graph代表圖級別的任務;Reasoning代表圖推理任務;Retrieval代表圖文檢索任務;Captioning代表圖描述生成任務。

6、未來發展方向

表1總結了按照提出的分類法,利用LLMs輔助處理圖相關任務的模型。基于上述回顧與分析,我們認為該領域仍有很大的提升空間。本節我們將討論當前利用LLM理解圖數據能力所面臨的局限性,并列出一些后續研究值得進一步探索的方向。

1. 處理非TAG問題:利用LLMs輔助學習帶有文本屬性的圖已經表現出卓越性能。然而,在現實世界場景中普遍存在大量缺乏豐富文本信息的圖結構數據。例如,在交通網絡(如PeMS03 [宋等人,2020年])中,每個節點代表一個運行中的傳感器,在超像素圖(如PascalVOC-SP[德維迪等人,2022年])中,每個節點代表一個超像素塊。這些數據集并沒有在每個節點上附帶文本屬性,且難以用人類可理解的語言來描述每個節點的語義含義。雖然OFA[劉等人,2023a]提出用人類可理解的文本描述所有節點和邊,并通過LLMs將其嵌入同一空間,但這種方法可能并不適用于所有領域(如超像素圖),在某些特定領域和數據集上的性能可能不盡理想。因此,探索如何利用LLMs強大的泛化能力幫助構建適用于無豐富文本信息的圖的基礎模型是一項有價值的研究方向。

2. 應對數據泄露問題:LLMs中的數據泄露問題已成為討論焦點[Aiyappa等人,2023年]。由于LLMs經過大規模文本語料庫的預訓練,它們很可能至少接觸并記憶了部分常見基準數據集的測試數據,特別是對于引用網絡而言。這使得依賴早期基準數據集的研究可靠性受到質疑。此外,陳等人[2023a]證明了特定的提示可能會增強LLMs對應記憶的“激活”,從而影響評估結果。黃等人[2023a]和何等人[2023]嘗試通過收集新的引用數據集避免數據泄露問題,確保測試論文采樣自ChatGPT截止日期之后的時間段,但這仍然局限于引用領域,且其數據集中圖結構的影響不顯著。因此,重新審視用于準確評估LLMs在圖相關任務上性能的方法至關重要,同時建立公平、系統且全面的基準也是必需的。

3. 提高遷移能力:遷移能力一直是圖領域的一大挑戰[Jiang等人,2022年]。由于各圖的獨特特性和結構,從一個數據集到另一個數據集,或者從一個領域到另一個領域的知識遷移并非易事。不同圖在大小、連通性、節點類型、邊類型以及整體拓撲方面差異顯著,直接在它們之間轉移知識較為困難。盡管LLMs由于在海量語料庫上進行了廣泛預訓練,顯示出了在語言任務上優秀的零樣本/少樣本能力,但在利用LLMs中嵌入的知識提高圖相關任務的遷移能力方面的探索相對有限。OFA[劉等人,2023a]試圖通過將所有節點和邊描述為人類可讀文本,并用單一LLM將來自不同領域的文本嵌入同一向量空間實現跨領域的統一方法。提升遷移能力這一主題仍值得深入研究。

4. 提高可解釋性:可解釋性,又稱為可解釋度,指的是以人類可理解的方式來解釋或展示模型行為的能力[Zhao等人,2023b年]。LLMs在處理圖相關任務時相比GNNs顯示出更好的可解釋性,主要歸因于LLMs能為圖推理生成用戶友好的解釋,包括第3節討論的生成額外解釋作為增強器,以及第4節提及的提供推理過程作為預測器。已有研究表明,在提示范式內探索解釋技術,如上下文學習[Radford等人,2021年]和思維鏈[Wei等人,2022b年],通過向LLM輸入一系列演示和提示以引導其生成特定方向的輸出并解釋其推理過程。進一步的研究應該致力于提升可解釋性。

5. 提高效率:盡管LLMs在圖學習上展現出有效性,但它們在時間和空間效率上可能不如專門設計的圖學習模型如GNNs,尤其是在依賴序列圖描述進行預測的情況下(如第4節所述)。例如,通過API(如ChatGPT和GPT-4)訪問LLMs時,計費模型對于處理大規模圖會產生高昂成本。此外,開源LLMs本地部署的訓練和推理均需消耗大量時間及硬件資源。現有研究[Duan等人,2023年;Liu等人,2023c年;Ye等人,2023年;Chai等人,2023年;Liu等人,2023d年;Tang等人,2023年]已嘗試采用諸如LoRA[胡等人,2021年]和前綴調優[Li和Liang,2021年]等參數高效微調策略使LLMs適應更加高效。我們相信,更多的高效方法可以解鎖在有限計算資源下應用LLMs解決圖相關任務的潛力。

6. 表達能力的分析與改進:盡管LLMs最近在圖相關任務上取得了一些成就,但其理論上的表達力仍未得到充分探索。標準的消息傳遞神經網絡被認為具有與1-Weisfeiler-Lehman(WL)測試相當的表現力,這意味著在1跳聚合下它們無法區分非同構圖[Xu等人,2018年]。因此,有兩個基本問題浮現出來:LLMs理解和處理圖結構的有效程度如何?其表達能力是否超越了GNNs或WL測試?此外,置換不變性是典型GNN的一個有趣特性,在幾何圖學習中尤為重要[Han等人,2022年]。探索如何賦予LLMs這一特性也是一個有趣的研究方向。

7.將LLMs作為智能體:目前結合LLMs和圖的應用中,LLMs常常扮演增強器、預測器和對齊組件的角色。但在更復雜的場景中,這些應用可能并未充分發揮LLMs的潛能。最新研究已經開始探索LLMs作為智能體的新角色,如生成智能體[Park等人,2023年]和領域特定智能體[Bran等人,2023年]。在一個由LLM驅動的智能體系統中,LLMs充當智能體的大腦,輔以規劃、記憶和工具使用等關鍵組件[Weng,2023年]。在復雜圖相關場景,如推薦系統和知識發現中,將LLMs視為智能體首先將任務分解為多個子任務,然后針對每個子任務識別最合適的工具(如GNNs)或許能夠獲得更好的性能表現。此外,將LLMs作為智能體應用于圖相關任務有可能構建出強大且高度泛化的解決方案。

結論

近年來,LLMs在圖相關任務中的應用已經成為了一個突出的研究領域。在本次綜述中,我們的目標是深入介紹現有的將LLMs應用于圖領域的各種策略。首先,我們引入了一種新穎的分類法,依據LLMs在其中扮演的不同角色,即增強器、預測器和對齊組件,將涉及圖形和文本兩種模態的技術分為三類。其次,我們按照這個分類體系系統地回顧了代表性研究成果。最后,我們討論了一些局限性,并指出了幾個未來的研究方向。通過這次全面的回顧,我們旨在揭示在LLMs輔助下的圖學習領域的進展與挑戰,從而激發該領域進一步的優化和發展。

Li Y, Li Z, Wang P, et al. A survey of graph meets large language model: Progress and future directions[J]. arXiv preprint arXiv:2311.12399, 2023.

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/yzqFSVm3j-UsT3niJi8LLw??