大型語言模型的知識融合(ICLR2024) 原創

?摘要: 從頭開始訓練大型語言模型(LLM)可以生成具有獨特功能和優勢的模型,但這需要巨大的成本,并可能導致冗余功能。另一種具有成本效益且引人注目的方法是將現有的預訓練LLM合并為一個更強大的模型。然而,由于這些LLM架構各不相同,直接融合它們的權重并不可行。在本文中,我們引入了LLM知識融合的概念,旨在將現有LLM的能力整合并轉移到一個單一的LLM中。通過利用源LLM的生成分布,我們外化了它們的集體知識和獨特優勢,從而有可能將目標模型的能力提升到超越任何單一源LLM的水平。我們使用三種具有不同架構的流行LLM——Llama-2、MPT 和 OpenLLaMA——在各種基準和任務中驗證了我們的方法。我們的研究結果表明,LLM的融合可以提高目標模型在推理、常識和代碼生成等多種能力上的表現。我們的代碼、模型權重和數據已公開在(https://github.com/fanqiwan/FuseLLM)。

(論文思想:假設我們有三個大型語言模型(LLMs):Llama-2、OpenLLaMA和MPT,它們分別擅長不同任務。Llama-2在推理任務中表現最佳,OpenLLaMA在常識問答上表現出色,而MPT在代碼生成方面非常強大。

現在,我們希望通過FUSELLM方法將這三個模型的知識融合到一個新的目標模型中,讓這個目標模型同時具備這三種能力。以下是FUSELLM方法如何工作的一個簡化示例:

1. 概率分布提取:我們提供一個文本序列,比如 `"The capital of France is..."`,讓Llama-2、OpenLLaMA和MPT分別預測下一個單詞是什么,并生成它們的概率分布。Llama-2可能對“Paris”有較高的概率,OpenLLaMA對“Paris”也有類似的預測,而MPT雖然更擅長代碼生成,但也會給出一個相對較低的概率。

2. 詞匯對齊:由于每個模型使用的分詞器可能不同,我們需要對齊它們生成的tokens,確保這些模型的輸出可以被比較和融合。例如,如果一個模型預測的是“Paris”,而另一個模型可能將其分為兩個token:“Par-” 和 “-is”,我們通過最小編輯距離對齊這些token。

3. 概率融合:我們將三個模型的概率分布進行融合。假設Llama-2和OpenLLaMA在常識問答中表現較好,它們的預測權重會更高。我們選擇使用MinCE方法,也就是選擇具有最小交叉熵分數的模型概率分布,因此目標模型會傾向于使用Llama-2和OpenLLaMA的預測。

4. 持續訓練:接著,我們用這些融合后的概率分布來指導目標模型的訓練,通過最小化目標模型的預測與融合分布之間的差異,讓目標模型逐步學習這三個模型的能力。

最終,目標模型經過持續訓練,不僅可以像Llama-2那樣擅長推理,還能像OpenLLaMA一樣處理常識問題,并在代碼生成任務上有類似MPT的表現。這個融合后的模型將具備更廣泛的能力,能夠在多種任務中表現出色。)

1、引言

隨著大型語言模型(LLMs)如GPT(Brown et al., 2020)和LLaMA(Touvron et al., 2023)系列在各種自然語言處理(NLP)任務中的持續成功,開發屬于自己的LLM已成為公司戰略的關鍵。然而,LLM開發成本極其高昂。除了需要大量的訓練數據、高級技術、巨大的計算資源和熟練的勞動力外,開發過程還對能源消耗和環境造成巨大壓力(Rillig et al., 2023)。雖然這些LLMs在結構和功能上有所不同,但它們在一系列NLP任務上有著相似的能力。因此,除了從零開始訓練LLM的傳統方法外,還有一種替代選擇是將現有的LLM組合成一個新的、更強大的模型,本文稱之為LLM的知識融合。如果成功,這種融合不僅可以降低初始訓練成本,還能使集成模型受益于所有LLM的優勢。該新模型也可以通過微調和適應各種下游任務。此外,融合也可以發生在專注于特定任務的微調LLM之間。

整合多個模型能力的嘗試由來已久。例如,集成方法(Littlestone & Warmuth, 1994; Jiang et al., 2023)直接聚合不同模型的輸出,以增強預測性能和魯棒性。然而,這種方法需要維護多個訓練好的模型,并在推理時執行每一個模型,這對于LLM來說是不可行的,因為它們需要大量的內存和推理時間。同樣,這種方法不支持微調,而微調對于許多LLM來說至關重要。另一種方法是通過參數級的算術操作直接將多個神經網絡合并為一個網絡(Wortsman et al., 2022; Jin et al., 2022)。這種方法通常假設網絡架構統一,并嘗試在不同神經網絡權重之間建立映射,但在LLM的上下文中,這往往是難以實現的。此外,當參數空間存在較大差異時,權重融合可能會導致次優結果(Li et al., 2022)。

在本文中,我們從概率分布的角度探討LLM的融合。對于一個輸入文本,我們認為不同源LLM生成的概率分布可以反映它們對該文本的固有知識。因此,提出的FUSELLM方法利用源LLM的生成分布,將它們的集體知識和個體優勢外化,并通過輕量級的持續訓練將這些知識轉移到目標LLM中。為此,我們開發了一種新策略,用于對齊來自不同LLM的分詞,并探索了兩種融合這些多樣化LLM生成的概率分布的方法。在持續訓練過程中,FUSELLM非常重視最小化目標LLM的概率分布與源LLM的概率分布之間的差異。

為了實證證明FUSELLM的有效性,我們在一個具有挑戰性但通用的LLM融合場景中進行實驗,其中源模型之間的共性最小。具體來說,我們重點關注三個具有不同架構和功能的流行開源LLM:Llama-2(Touvron et al., 2023)、OpenLLaMA(Geng & Liu, 2023)和MPT(Team, 2023)。通過對跨越推理、常識和代碼生成的三個基準共42個任務的評估,驗證了我們的方法訓練出的目標模型在大多數任務中都優于每個源LLM和基線。此外,我們通過在多個特定領域語料庫上持續訓練單個基礎模型,模擬了具有相同架構但功能不同的LLM的存在。根據困惑度(perplexity)的評估結果表明,FUSELLM在將這些結構相同的LLM的能力組合起來時,表現出比傳統的集成和權重融合方法更強的潛力。

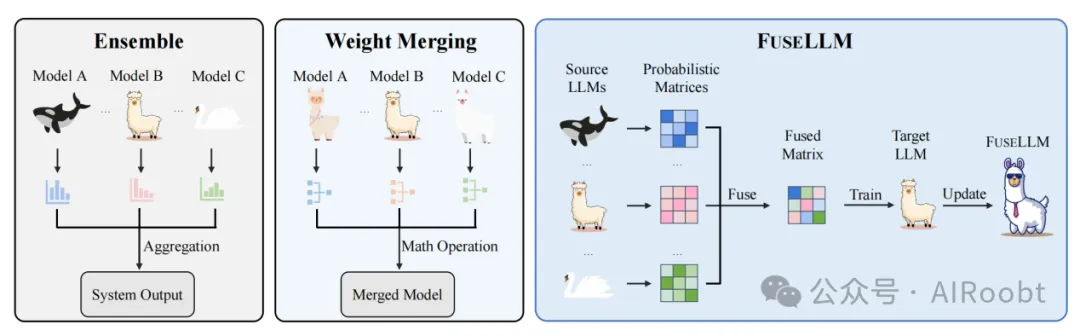

總而言之,本文探討了一個新的挑戰,即LLM的融合,旨在創建一個能夠有效利用多樣化LLM集體能力和獨特優勢的統一模型。如圖1所示,我們提出的方法區別于傳統的集成和權重融合技術,通過優先外化和轉移多個LLM的知識進行融合。本研究得出了一些可能引發未來研究的發現。首先,盡管我們通過輕量級的持續訓練在緊湊、高質量的語料庫上展示了我們方法的有效性,但訓練語料庫的精心選擇可能是一個關鍵考慮因素,尤其是其與下游任務的相關性。其次,在源LLM能力差異顯著的情況下,融合功能對于有效結合各自的優勢至關重要。最后,與傳統的模型集成和融合技術相比,LLM融合領域似乎是一條更具探索前景的途徑,特別是在考慮到LLM的多樣化結構和巨大的模型規模時。

圖1:展示了傳統模型融合技術(集成和權重合并)以及我們針對大型語言模型(LLMs)的知識融合方法(FUSELLM)。不同的動物圖標代表不同的LLMs,不同種類表示擁有不同架構的LLMs。FUSELLM將多個LLMs的知識外化,并將它們的能力轉移到目標LLM上。

2、相關工作

模型融合

整合不同模型的能力一直是一個長期的目標,現有的方法主要分為兩類。首先,傳統的模型集成技術通過結合多個模型的輸出來增強系統整體性能(Littlestone & Warmuth, 1994;Sagi & Rokach, 2018)。需要注意的是,這種技術并不涉及將多個模型顯式地合并為一個新模型。常見的模型集成方法包括加權平均(Littlestone & Warmuth, 1994)或多數投票(Monteith et al., 2011),以整合不同模型的預測結果。最近,Jiang等人(2023)引入了一個集成框架,旨在利用多個開源LLM的多樣化優勢。該框架首先使用成對比較方法來檢測候選輸出之間的細微差異,隨后結合最優的候選結果以產生增強的輸出,發揮其優勢并減少其劣勢。

其次,權重融合是另一種通過參數層面實現模型融合的方法。Gupta等人(2020)和Wortsman等人(2022)通過不同策略或配置獲得的具有相同結構的模型權重進行融合,以提高整體性能。同樣,Cha等人(2021)、Rame等人(2022)和Arpit等人(2022)通過加權平均不同配置的模型來提高分布外(out-of-distribution)的泛化能力。此外,Jin等人(2022)將為特定領域或任務設計的模型融合在一起,以創建能夠處理所有領域或任務的通用模型。除了對整個模型進行參數融合之外,Wang等人(2022b)、Huang等人(2023)和Zhang等人(2023)還應用線性數學運算對適配器參數進行融合,以實現更好的泛化性能。

總而言之,雖然模型集成需要并行部署多個模型,權重融合通常僅限于結構相同的模型。相比之下,本文提出的方法支持通過顯式轉移其知識和能力,將具有不同架構的多個LLM進行融合。

知識蒸餾

知識蒸餾(Hinton et al., 2015)最初提出用于模型壓縮,它包括在一個或多個教師模型的指導下訓練學生模型。在NLP領域,知識蒸餾廣泛應用于文本分類任務中。這些應用包括訓練學生模型以復制教師模型的輸出分布(Sanh et al., 2019;Turc et al., 2019),以及教師模型中間層提取的特征(Sun et al., 2019;Jiao et al., 2020)和關系(Wang et al., 2020)。在文本生成領域,傳統方法側重于最小化學生模型和教師模型生成分布之間的KL散度。這是通過使用教師在每個時間步的概率分布作為監督來實現的(Khanuja et al., 2021;Gu et al., 2023),或者直接在教師生成的文本上進行訓練(Peng et al., 2023;Xu et al., 2023)。

盡管我們的方法框架類似于多教師知識蒸餾,但存在兩個顯著區別。首先,在傳統的知識蒸餾中,學生模型通常被限制為比教師模型小的尺寸。然而,在我們的場景中,對目標模型的尺寸沒有限制。其次,傳統的知識蒸餾通常會導致學生模型在蒸餾后性能低于教師模型。相反,我們期望在融合之后,目標模型的性能能超越任何單個源模型。

3、大型語言模型的知識融合

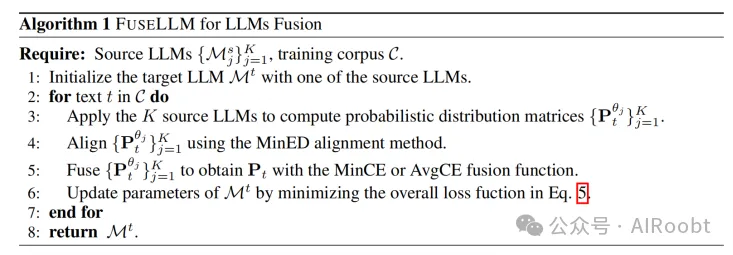

LLM融合的主要目標是外化多個源LLM中嵌入的集體知識,并將它們的能力整合到目標LLM中。給定 K 個源LLM {Msj}j=1K,這些模型架構各異,并分別在不同的數據集上進行預訓練或微調。我們提出的核心思想是通過預測下一個token來激發這些LLM展現其固有的知識。通過評估這些預測生成的概率分布,我們使用最準確的預測來對目標LLM Mt 進行持續訓練,使用語料庫 C 并基于因果語言建模(CLM)目標進行訓練。在接下來的部分中,我們首先簡要介紹基本概念,然后詳細說明我們的LLM融合框架,最后討論實現細節。

3.1 基本概念

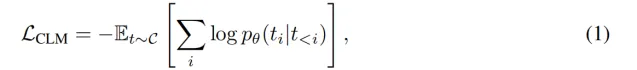

設 t 表示從語料庫 C 中采樣的長度為 N 的文本序列,t_{<i} = (t_1, t_2, ..., t_{i-1}) 表示第 i 個token之前的序列。基于因果語言建模(CLM)目標對參數化為 θ 的語言模型進行訓練,其定義為最小化負對數似然:

其中,p_{θ}(t_i | t_{<i}) 是模型給定前面token后對token t_i 的預測概率。

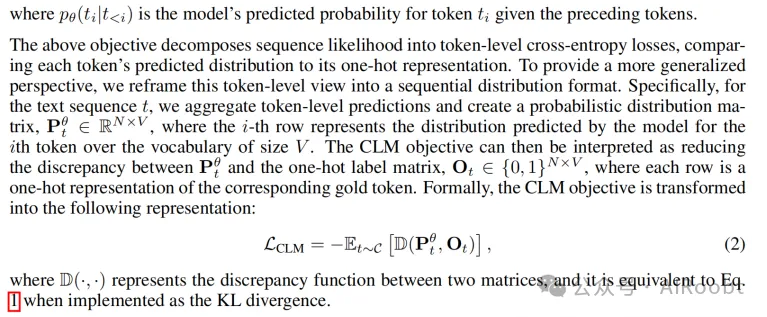

上述目標將序列的似然分解為token級的交叉熵損失,將每個token的預測分布與其單熱(one-hot)表示進行比較。為了提供一個更廣泛的視角,我們將這種token級的視圖重新框定為順序分布的格式。具體而言,對于文本序列 t,我們將token級預測聚合并創建一個概率分布矩陣 P_{θ}^t in mathbb{R}^{N times V},其中第 i 行表示模型對第 i 個token在詞匯表大小為 V 的情況下預測的分布。然后,CLM目標可以解釋為減少 P_{θ}^t 和單熱標簽矩陣 O^t in 0, 1^{N times V} 之間的差異,每行都是對應金標token的單熱表示。形式上,CLM目標轉化為以下表示:

其中 D(·,·) 表示兩個矩陣之間的差異函數,當使用KL散度實現時,等價于公式(1)。

3.2 LLM的融合

基于對語言模型的這一觀點,我們認為概率分布矩陣可以反映其對文本理解中的某些固有知識。因此,來自不同LLM的相同文本的不同概率分布矩陣可用于表示這些模型中嵌入的多樣化知識。考慮到這一點,所提出的FUSELLM方法通過概率建模來處理LLM的融合,旨在通過融合源LLM的概率分布來創建一個統一的LLM。為實現這一點,在開始融合一組LLM時,FUSELLM會對目標LLM進行輕量級的持續訓練,使用一個與預訓練數據集類似的原始文本語料庫。除了依賴CLM目標外,FUSELLM還重點最小化目標LLM的預測概率分布與源LLM概率分布之間的差異。

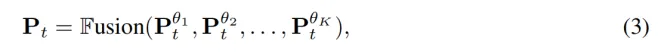

對于語料庫 C 中的每個文本,我們應用提供的 K 個源LLM并獲得一組概率分布矩陣,表示為 P_{θ_j}^t_{j=1}^{K},其中 θ_j 表示第 j 個LLM的參數。利用這些矩陣,我們將單個模型的知識外化到一個統一的空間,實際上是在文本上創建了統一的概率表示。我們承認源LLM之間詞匯表的差異可能導致矩陣 P_{θ_j}^t_{j=1}^{K} 未對齊。為了解決這個問題,我們采用了一個詞匯對齊策略,這將在3.3節中進行解釋,以促進跨模型的更一致概率解釋。

在對齊概率矩陣后,我們繼續將它們融合為一個緊湊的表示。可以應用多種融合策略來實現這一目標,具體將在3.3節中詳細介紹。我們用 P^t 來表示融合后的表示矩陣,定義如下:

其中 text{Fusion}(·) 表示組合多個矩陣的函數,結果矩陣 P^t 被視為源LLM集體知識和獨特優勢的表示。

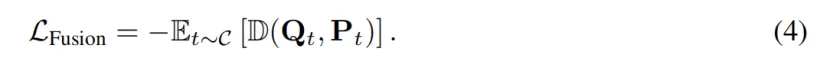

為了將源LLM的能力轉移到目標LLM,我們在目標LLM的預測與融合表示矩陣 P^t 之間強制對齊。我們用 Q^t 來表示目標LLM對文本 t 的輸出分布矩陣,然后將融合目標定義為:

我們的持續訓練的總體目標包括CLM目標 L_{text{CLM}} 和融合目標 L_{text{Fusion}} 的加權組合,公式如下:

3.3 FUSELLM的實現

在本節中,我們介紹FUSELLM方法中詞匯對齊和融合函數的實現細節。

詞匯對齊

確保多個LLM之間的token對齊對知識融合至關重要,因為它可以保證概率分布矩陣的正確映射。Fu等人(2023)采用動態規劃的方法,通過遞歸最小化將一個token序列編輯為另一個序列的總成本。如果兩個token之間存在一對一的映射,則對應的概率分布完全映射。否則,映射的分布退化為單熱向量。由于由不同分詞器為相同序列生成的token通常差異有限,我們建議通過用最小編輯距離(MinED)策略替換Fu等人(2023)提出的精確匹配(EM)約束,以基于最小編輯距離對不同分詞器生成的token進行映射。這種對齊方式的放寬有助于在分布矩陣中保留大量信息,同時引入的誤差很小。更多詞匯對齊的細節可參考附錄A。

融合策略

為了在保留源LLM獨特優勢的同時整合其集體知識,評估不同LLM的質量并對其相應的分布矩陣賦予不同的重要性是至關重要的。為此,在處理文本 t 時,我們使用分布矩陣與金標標簽之間的交叉熵損失作為LLM預測質量的指標(Marion et al., 2023)。較低的交叉熵分數表明源LLM對文本的理解更準確,其預測應賦予更大的權重。基于這一標準,我們引入了兩種融合函數:(1) MinCE:該函數輸出交叉熵分數最低的分布矩陣;(2) AvgCE:該函數根據交叉熵分數對分布矩陣進行加權平均。

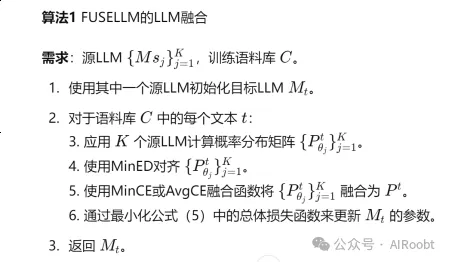

FUSELLM方法的完整流程在算法1中描述。

4、實驗

在我們的實驗中,我們考慮了一種通用但具有挑戰性的LLM融合場景,其中源模型在架構或功能上幾乎沒有共性。具體來說,我們在7B規模下進行實驗,并選擇了三個具有代表性的開源模型:Llama-2、OpenLLaMA和MPT作為融合的源LLM。對于目標LLM,我們選擇了另一個Llama-2 7B,它通常是三個源LLM中最強大的一個。目標LLM從與源模型相同的預訓練權重開始,但在訓練期間會更新參數。為了評估FUSELLM的性能,我們在推理、常識和代碼生成能力的基準上進行了實驗。

4.1 實驗設置

用于持續訓練的數據集

為了持續訓練目標LLM進行LLM融合,重要的是選擇一個緊湊且多樣化的訓練數據集。我們選擇了MiniPile,這是通過仔細的聚類和篩選過程生成的精選數據集。MiniPile由大約100萬個文檔組成,涵蓋22個領域,包含18億個token,約占Llama-2訓練token的0.1%。更多數據集的詳細信息可參見附錄B。

融合函數

對于融合函數,我們使用最小交叉熵(MinCE)。然而,我們將在第4.4節中考察使用其他融合函數的影響。

訓練細節

我們使用批量大小為128、最大長度為2048的Llama-2 7B目標LLM,訓練在配備8個每個40GB顯存的NVIDIA A100 GPU的單節點上進行。我們的訓練框架基于Huggingface Transformers(Wolf et al., 2020)并通過FlashAttention(Dao et al., 2022)加速。我們經驗性地將公式(5)中的組合權重(lambda)設置為0.9。訓練僅進行一個epoch,約需33小時。更多超參數的細節可參見附錄C。

評估

我們在三個基準上評估FUSELLM,這些基準代表LLM的不同核心能力,涵蓋推理、常識和代碼生成。

- Big-Bench Hard (BBH)(Suzgun et al., 2022)是一個評估LLM推理能力的基準。它包含23個選擇題任務和4個自由生成任務,來自Big-Bench(Srivastava et al., 2022),可分為四類:算法和算術推理、自然語言理解、世界知識和多語言知識與推理。我們遵循之前的工作(Wang et al., 2023b),基于少樣本鏈式思維(CoT)提示生成預測并計算精確匹配(EM)準確率。

- Common Sense (CS) 是一個評估LLM常識能力的基準。我們考慮了5個標準選擇題任務:ARC easy和ARC challenge(Clark et al., 2018)、BoolQ(Clark et al., 2019a)、HellaSwag(Zellers et al., 2019)和OpenBookQA(Mihaylov et al., 2018)。我們使用lm-eval-hardness(Gao et al., 2021)進行基于似然的零樣本評估。具體來說,我們選擇給定上下文情況下似然最高的選項并報告準確率。

- MultiPL-E (ME)(Cassano et al., 2022)是一個多語言編程基準,用于評估LLM的代碼生成能力。它由Python基準(Chen et al., 2021)翻譯而成,覆蓋18種編程語言的平行數據集。我們使用bigcode-evaluation-hardness(Ben Allal et al., 2022)進行零樣本代碼生成,涉及10種流行編程語言的HumanEval類任務,并基于每個問題生成的20個樣本報告pass@1(Chen et al., 2021)得分。

基線

在我們的實驗中,我們將FUSELLM與兩組基線進行比較:(1) 原始LLM,包括Llama-2 7B、OpenLLaMA 7B和MPT 7B;(2) Llama-2 CLM:僅使用因果語言建模目標在MiniPile上持續訓練的Llama-2 7B。

4.2 總體結果

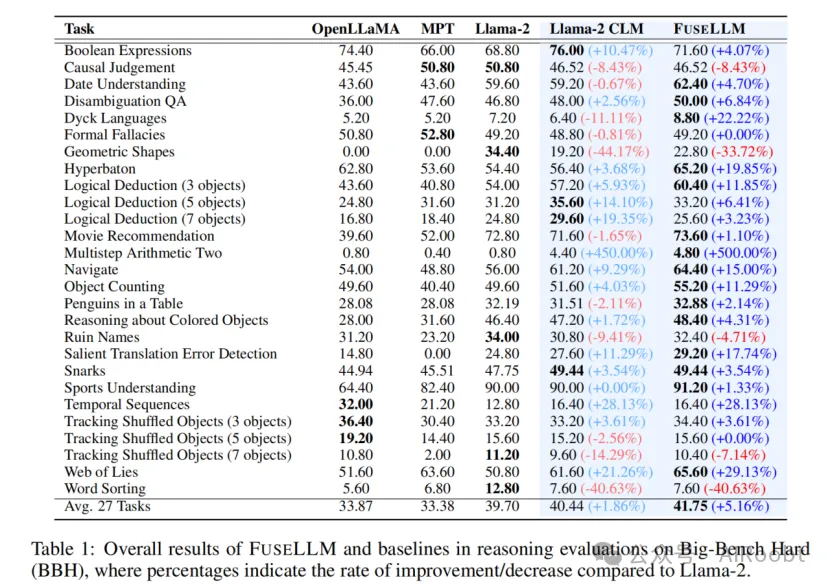

表1展示了FUSELLM與基線方法在BBH上的總體結果。可以看到,三個源LLM在27個BBH任務上的表現各不相同,通常Llama-2表現優于其他模型。使用緊湊且多樣的語料庫進行持續訓練后,Llama-2 CLM相較于Llama-2表現出1.86%的相對提升,盡管這一提升相對溫和且在不同任務中的一致性不高。總體而言,FUSELLM在所有27個任務中的平均相對性能提升為5.16%,顯著優于原始Llama-2。在某些特定任務中,FUSELLM的增強效果尤為顯著(例如,Hyperbaton任務中的準確率從54.40提升至65.20)。在一些簡單持續預訓練導致性能下降的任務中(如Dyck Languages),FUSELLM通過結合個體源LLM的優勢實現了性能恢復。需要注意的是,FUSELLM偶爾在某些任務(如Geometric Shapes和Word Sorting)上表現不佳,這可能有兩個原因。首先,除了Llama-2以外的其他源LLM在這些任務上的表現較差,影響了融合結果。其次,持續訓練數據集與下游任務的相關性也對性能下降有所貢獻。

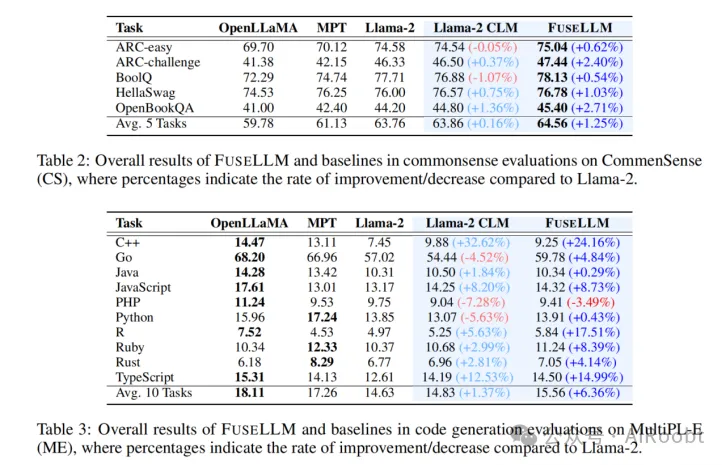

表2展示了FUSELLM與基線方法在Common Sense基準上的零樣本性能。結果表明,FUSELLM在所有五個任務上持續超越基線,平均相對性能提升為1.25%。相比之下,Llama-2 CLM僅表現出0.16%的相對提升,且提升幅度較小。在具有挑戰性的ARC-challenge(2.40%)和OpenBookQA(2.71%)任務中,從Llama-2到FUSELLM的顯著提升突顯了FUSELLM在利用集體知識解決復雜問題方面的有效性。

對于代碼生成評估,表3展示了FUSELLM在MultiPL-E基準上的零樣本性能。我們觀察到,FUSELLM在10個任務中的9個上優于Llama-2,特別是在某些編程語言(如R)的pass@1得分上有顯著提升,從4.97提升至5.84。由于OpenLLaMA和MPT在代碼生成任務中相比Llama-2表現出色,通過FUSELLM融合的結果在平均表現上提升了6.36%,遠高于Llama-2 CLM的1.37%提升。然而,值得注意的是,在該評估中FUSELLM仍然表現出與OpenLLaMA或MPT相比的性能差距。這種差異可以歸因于兩個主要原因:Llama-2作為目標模型在代碼生成上的初始表現較差,以及持續訓練語料庫中與代碼相關的文本比例不足,估計約為7.59%。

4.3 融合概率分布的效果

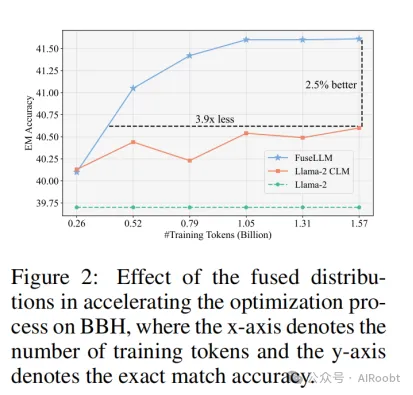

我們探討了從多個LLM獲得的融合概率分布的有效性,并跟蹤訓練過程中性能提升的趨勢。圖2展示了在BBH上的少樣本CoT性能隨訓練數據規模的變化情況。我們的觀察表明,FUSELLM相比Llama-2 CLM在精確匹配(EM)準確率上提升了2.5%,并在僅使用0.52億個token時達到了Llama-2 CLM最佳性能。值得注意的是,與Llama-2 CLM需要的15.7億個token相比,這代表了訓練token需求的3.9倍減少。這些結果表明,LLM生成的概率分布包含比原始文本序列更易學習的知識,從而加速了優化過程。

4.4 實現過程分析

在本節中,我們深入探討了FUSELLM實現中的關鍵要素,包括源LLM的數量、詞匯對齊的標準以及融合函數的選擇。

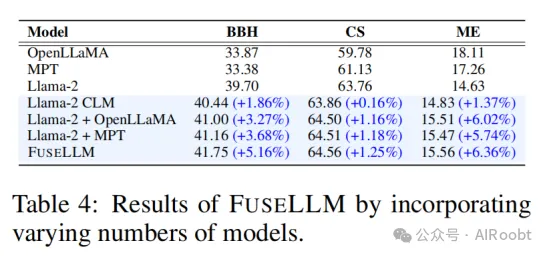

源LLM的數量

我們展示了融合不同數量的LLM的結果。我們注意到,隨著模型數量從1增加到3,FUSELLM的性能顯著提高。然而,整合更多模型的好處在各個基準中的表現有所不同。在BBH中,性能提升是顯而易見的;而在CS或ME中,當融合兩個模型時,提升效果更加顯著。這種現象可能是由于三個模型在BBH中的各項任務上性能差異較大,而在CS或ME任務上的性能差異相對較小。

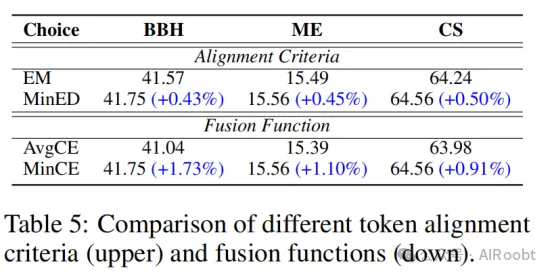

詞匯對齊的標準

在LLM融合過程中,確保不同模型生成的tokens和詞匯表的一致性至關重要。顯然,基于最小編輯距離(MinED)的方法相比Fu等人(

2023)提出的精確匹配(EM)方法表現更優。我們推測這種性能提升源于MinED的寬松限制,能夠有效對齊由不同分詞器生成的輕微差異的tokens,從而保留了大量有用的token信息,同時引入的錯誤較少。

融合函數的選擇

在3.3節中,我們介紹了FUSELLM的兩種融合函數:一種是使用最小交叉熵分數(MinCE)的分布矩陣,另一種是基于交叉熵分數對分布矩陣進行加權平均(AvgCE)。結果表明,FUSELLM使用MinCE在所有基準上的表現優于AvgCE。這可能是由于AvgCE中的簡單加權平均引入了扭曲,削弱了各個LLM的獨特優勢。

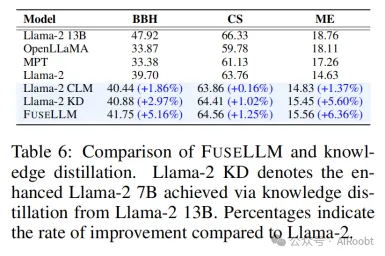

4.5 FUSELLM與知識蒸餾的比較

雖然知識蒸餾技術也可以用于提升LLM的能力,但FUSELLM在兩個方面脫穎而出,正如前文所述。在本節中,我們將FUSELLM與傳統的知識蒸餾進行比較。具體而言,我們從Llama-2 13B中提取概率分布,并應用傳統知識蒸餾方法,將其能力轉移到Llama-2 7B中。通過知識蒸餾獲得的模型(Llama-2 KD)在所有基準上表現優于原始Llama-2 7B,證明了知識蒸餾的有效性。然而,與FUSELLM相比,Llama-2 KD的提升幅度相對較小,尤其是在BBH中(2.97% vs. 5.16%)。這表明通過持續訓練集成三種具有不同架構的7B模型,FUSELLM獲得的優越結果超越了從單個13B模型中簡單提取知識的收益。這一觀察突出了“更多有不同,差異也能成就更多”的理念。

4.6 FUSELLM與集成/融合的比較

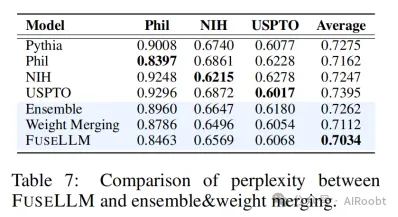

正如之前提到的,傳統技術如模型集成和權重融合通常用于融合多個大型語言模型(LLMs)。為了比較我們提出的FUSELLM與這些現有融合方法的有效性,我們進行了實驗,模擬了多個LLM來源于相同基礎模型但在不同語料庫上訓練的場景。我們首先從The Pile數據集中選擇了三個相關領域(PhilPapers、NIH ExPorter和USPTO Backgrounds),并使用每個領域的10億個token對Pythia 1B模型(Biderman等人, 2023)進行持續訓練,生成了三個結構相同但領域不同的LLM。然后,我們將不同的融合技術應用于這些LLM:(1) 集成方法計算所有LLM生成的概率的加權平均值,權重基于每個模型的表現;(2) 權重融合方法在參數空間中融合多個LLM,融合權重由模型表現決定;(3) FUSELLM在從這三個領域中采樣的1億個token上進行持續訓練。

表7展示了FUSELLM和其他融合方法在測試集上的困惑度(perplexity)結果,我們使用The Pile中實現的方法,按每個UTF-8編碼字節(BPB)測量困惑度。我們觀察到,經過10億個token的訓練后,原始LLM的能力被轉移到每個特定領域的LLM中,導致它們在其他領域的表現下降。盡管所有融合技術都能夠整合不同模型的優勢,但FUSELLM在三個領域中始終實現了最低的平均困惑度,這表明它比集成和權重融合方法更有效地利用集體知識。

5、結論

本文提出了一種稱為FUSELLM的新方法,用于實現大型語言模型(LLMs)的知識融合。我們的主要目標是將多個源LLM的集體知識和獨特優勢外化,并將這些知識轉移到一個目標LLM中。通過從不同的LLM中提取概率分布,我們利用源模型的多樣化能力,使目標LLM在推理、常識和代碼生成等任務上的表現得到提升。與傳統的模型集成和權重融合方法不同,FUSELLM能夠在架構不同的LLM之間實現知識融合。

我們通過實驗驗證了FUSELLM的有效性,實驗結果表明在不同的評估基準上,FUSELLM的目標模型在大多數任務中的性能超越了任何單個源LLM。盡管我們的方法已經展示了其潛力,未來的研究仍可進一步探索以下方向:研究如何在更多LLM之間實現更有效的融合,并開發更加高效的訓練策略,以進一步減少所需的訓練時間和資源。

1School of Computer Science and Engineering, Sun Yat-sen University, China 2Tencent AI Lab

?

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/3ncHDUFWpqhy31QxHpAccg??