多模態大型語言模型(MLLM)綜述 原創 精華

摘要—最近,以GPT-4V為代表的多模態大型語言模型(MLLM)已成為新興的研究熱點,它使用強大的大型語言模型(LLMs)作為“大腦”來執行多模態任務。MLLM出人意料的涌現能力,如基于圖像編寫故事和無需OCR的數學推理,是傳統多模態方法中罕見的,這表明了一條通往人工通用智能的潛在路徑。為此,學術界和工業界都致力于開發能夠與GPT-4V競爭甚至超越的MLLM,以驚人的速度推動研究的極限。在本文中,我們旨在追蹤并總結MLLM的最新進展。首先,我們介紹了MLLM的基本公式,并概述了與其相關的概念,包括架構、訓練策略和數據,以及評估。然后,我們介紹了關于如何擴展MLLM以支持更細粒度、模態、語言和場景的研究主題。我們繼續討論多模態幻覺和擴展技術,包括多模態ICL(M-ICL)、多模態CoT(M-CoT)和LLM輔助視覺推理(LAVR)。為了結束本文,我們討論了現有的挑戰并指出了有希望的研究方向。鑒于MLLM時代才剛剛開始,我們將不斷更新這份綜述,并希望它能激發更多的研究。相關的GitHub鏈接收集了最新的論文,可在??https://github.com/BradyFU/Awesome-Multimodal-Large-Language-Models???找到。

(注釋:"無需OCR的數學推理"指的是系統能夠直接理解和處理數學內容,而無需首先通過光學字符識別(Optical Character Recognition,OCR)技術將手寫或印刷的數學符號轉換為機器可讀的格式。OCR是一種將圖像中的文本轉換為機器編碼文本的技術,它廣泛應用于將紙質文檔數字化。然而,OCR在處理復雜的數學符號和公式時可能會遇到困難,因為這些符號的結構和形狀可能與普通字母數字字符不同,OCR算法可能難以準確識別。模型能夠跳過將數學內容轉換為文本的步驟,直接在視覺層面上處理數學信息,這可以提高處理速度和準確性,并且減少因OCR錯誤而導致的問題。

多模態上下文學習(Multimodal In-Context Learning,M-ICL)結合了自然語言處理(NLP)和計算機視覺(CV)等領域的知識,使模型能夠理解和處理包含多種類型信息(如文本、圖像、音頻等)的數據。上下文學習是指模型利用給定上下文中的信息來指導其學習和推理過程。在M-ICL中,這通常意味著模型會考慮輸入的多模態信息,以及它們之間的關系和上下文,來生成輸出或做出決策。)

1 引言

近年來,大型語言模型(LLMs)取得了顯著的進展[1]、[2]、[3]、[4]、[5]。通過擴大數據規模和模型規模,這些LLMs展現出了非凡的涌現能力,通常包括指令跟隨[5]、[6]、上下文學習(ICL)[7]和思維鏈(CoT)[8]。盡管LLMs在大多數自然語言處理(NLP)任務上展示了驚人的零樣本/少樣本推理性能,但它們本質上對視覺是“盲目”的,因為它們只能理解離散的文本。同時,大型視覺模型(LVMs)可以清晰地“看”[9]、[10]、[11]、[12],但通常在推理上落后。

鑒于這種互補性,LLM和LVM相互靠近,引領了多模態大型語言模型(MLLM)的新領域。正式來說,它指的是基于LLM的模型,具有接收、推理和輸出多模態信息的能力。在MLLM之前,已經有很多工作致力于多模態性,可以分為判別性[13]、[14]、[15]和生成性[16]、[17]、[18]范式。CLIP[13]作為前者的代表,將視覺和文本信息投影到統一的表示空間,為下游多模態任務搭建了橋梁。相比之下,OFA[16]是后者的代表,它以序列到序列的方式統一多模態任務。根據序列操作,MLLM可以被歸類為后者,但與傳統對應物相比,它表現出兩個代表性特征:(1)MLLM基于具有十億級參數規模的LLM,這在以前的模型中是不可用的。

(2)MLLM使用新的訓練范式來釋放其全部潛力,例如使用多模態指令調整[19]、[20]來鼓勵模型遵循新的指令。

憑借這兩個特征,MLLM展現出新的能力,例如基于圖像編寫網站代碼[21],理解梗的深層含義[22],以及無需OCR的數學推理[23]。

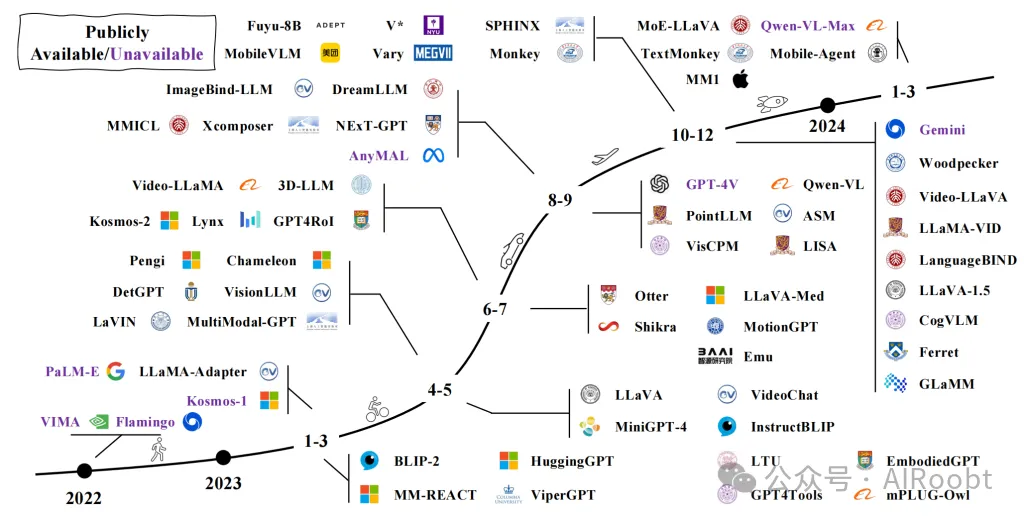

自從GPT-4[3]發布以來,由于它展示的驚人多模態示例,MLLMs的研究熱潮不斷。快速發展是由學術界和工業界的努力推動的。MLLMs的初步研究集中在基于文本提示和圖像[20]、視頻[25]、音頻[27]的文本內容生成上。隨后的工作已經擴展了能力或使用場景,包括:(1)更好的粒度支持。開發了更精細的對用戶提示的控制,以支持通過框[28]或單擊[29]特定對象的特定區域。(2)增強的輸入和輸出模態支持[30]、[31],如圖像、視頻、音頻和點云。除了輸入,像NExT-GPT[32]這樣的項目進一步支持不同模態的輸出。(3)改進的語言支持。已經做出了努力,將MLLMs的成功擴展到其他語言(例如中文)上,這些語言的訓練語料相對有限[33]、[34]。(4)擴展到更多領域和使用場景。一些研究將MLLMs的強大能力轉移到其他領域,如醫學圖像理解[35]、[36]、[37]和文檔解析[38]、[39]、[40]。此外,開發了多模態代理以協助現實世界交互,例如具身代理[41]、[42]和GUI代理[43]、[44]、[45]。圖1展示了MLLM的時間線。

圖1:代表性多模態大型語言模型(MLLMs)的時間線。我們正在見證這一領域的迅速發展。更多的工作可以在我們發布的GitHub頁面上找到,該頁面每天都在更新。

鑒于該領域的快速發展和有希望的結果,我們編寫了這份綜述,為研究人員提供了對MLLMs的基本思想、主要方法和當前進展的把握。請注意,我們主要關注視覺和語言模態,但也包括涉及視頻和音頻等其他模態的工作。具體來說,我們涵蓋了MLLMs最重要的方面,并提供相應的總結,并開放了一個將實時更新的GitHub頁面。據我們所知,這是關于MLLM的第一份綜述。

綜述的后續部分結構如下:綜述首先全面回顧了MLLMs的基本方面,包括(1)主流架構(§2);(2)完整的訓練策略和數據配方(§3);(3)常見的性能評估實踐(§4)。然后,我們深入討論了一些關于MLLMs的重要話題,每個話題都集中在一個主要問題上:(1)哪些方面可以進一步改進或擴展(§5)?(2)如何緩解多模態幻覺問題(§6)?綜述繼續介紹了三種關鍵技術(§7),每種技術都專門用于特定場景:MICL(§7.1)是一種有效的技術,通常在推理階段使用,以提高少樣本性能。另一個重要的技術是M-CoT(§7.2),通常用于復雜的推理任務。然后,我們概述了一個一般性的想法,開發基于LLM的系統來解決復合推理任務或解決常見用戶查詢(§7.3)。最后,我們以總結和潛在研究方向結束我們的綜述。

2 架構

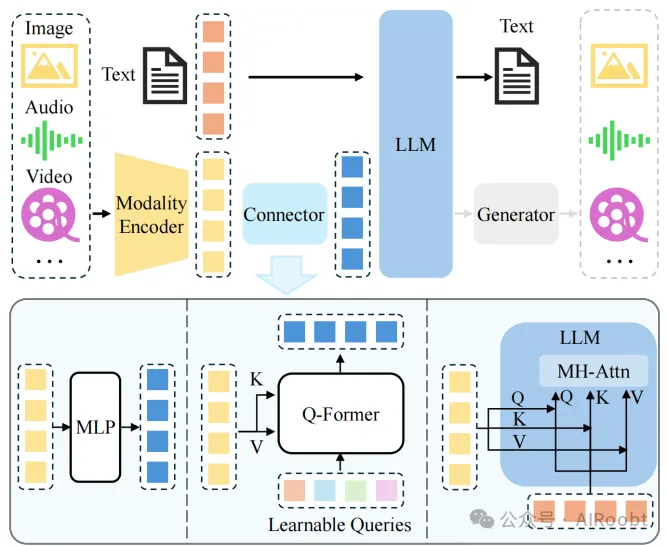

一個典型的多模態大型語言模型(MLLM)可以抽象為三個模塊,即預訓練的模態編碼器、預訓練的大型語言模型(LLM),以及連接它們的模態接口。類比于人類,模態編碼器如圖像/音頻,編碼器是接收和預處理光學/聲學信號的人類眼睛/耳朵,而LLM就像理解并推理處理信號的人類大腦。在兩者之間,模態接口用于對齊不同的模態。一些MLLM還包括一個生成器來輸出除文本之外的其他模態。架構的圖表在圖2中繪制。在這一部分,我們依次介紹每個模塊。

圖2:典型多模態大型語言模型(MLLM)架構的示意圖。它包括一個編碼器、一個連接器和一個大型語言模型(LLM)。可選的生成器可以附加到LLM上,以生成除文本之外的更多模態。編碼器接收圖像、音頻或視頻并輸出特征,這些特征由連接器處理,以便LLM能更好地理解。大致有三種類型的連接器:基于投影的、基于查詢的和基于融合的連接器。前兩種類型采用令牌級融合,將特征處理成令牌,與文本令牌一起發送,而最后一種類型在LLM內部實現了特征級融合。

(注釋:一個典型的多模態大型語言模型(MLLM)架構的組成部分和它們之間的工作流程。

圖片上半部分:

1. 編碼器(Encoder):編碼器是處理輸入數據的組件,它可以接收多種模態的輸入,如圖像、音頻或視頻。編碼器的任務是將這些原始的多模態數據轉換成模型可以理解的特征表示。

2. 連接器(Connector):連接器是連接編碼器輸出和大型語言模型(LLM)的橋梁。它的主要作用是將編碼器輸出的特征進一步處理,使其能夠與LLM的輸入格式兼容,從而讓LLM能夠更好地理解這些特征。

3. 大型語言模型(LLM):LLM是MLLM的核心,通常是一個預訓練的語言模型,負責處理和生成文本。它能夠根據輸入的文本和其他模態的特征,進行語言理解、生成或推理等任務。

4. 生成器(Generator)(可選):生成器是一個可選組件,它可以附加到LLM上,用于生成除文本之外的其他模態輸出,如圖像、音頻或視頻。

圖片下半部分,連接器主要分為三種類型:

- 基于投影的連接器(Projection-based):這種連接器將編碼器輸出的特征投影到與LLM的詞嵌入相同的維度空間,使得特征可以直接與文本令牌一起被LLM處理。

- 基于查詢的連接器(Query-based):這種連接器使用一組可學習的查詢令牌來動態地從編碼器輸出的特征中提取信息。

- 基于融合的連接器(Fusion-based):這種連接器在LLM內部實現特征級別的融合,允許文本特征和視覺特征在模型內部進行更深入的交互和整合。

整個架構的目的是實現對多模態輸入的有效處理和理解,以及在此基礎上進行的語言生成或推理任務。)

2.1 模態編碼器

編碼器將原始信息(如圖像或音頻)壓縮成更緊湊的表示形式。與其從頭開始訓練,更常見的方法是使用已經與其他模態對齊的預訓練編碼器。例如,CLIP [13]結合了一個通過在圖像-文本對上大規模預訓練而與文本語義對齊的視覺編碼器。因此,使用這種最初已經預對齊的編碼器與LLM通過對齊預訓練(見§3.1)對齊更容易。

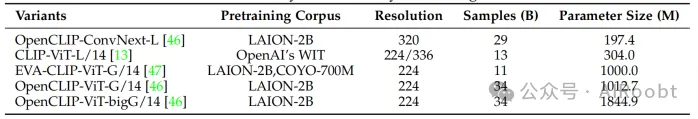

表1:常用圖像編碼器的總結。

常用的圖像編碼器系列在表1中總結。除了普通的CLIP圖像編碼器[13],一些工作還探索使用其他變體。例如,MiniGPT-4 [21]采用了EVA-CLIP [47]、[48](ViT-G/14)編碼器,該編碼器通過改進的訓練技術進行訓練。相比之下,Osprey [29]引入了基于卷積的ConvNext-L編碼器[46]以利用更高分辨率和多級特征。一些工作還探索了無編碼器架構。例如,Fuyu-8b [49]的圖像塊在發送到LLM之前直接被投影。因此,模型自然支持靈活的圖像分辨率輸入。在選擇編碼器時,人們通常會考慮分辨率、參數大小和預訓練語料庫等因素。

值得注意的是,許多工作已經通過實證驗證,使用更高分辨率可以實現顯著的性能提升[34]、[50]、[51]、[52]。擴大輸入分辨率的方法可以分為直接縮放和塊分割方法。直接縮放的方式將更高分辨率的圖像輸入到編碼器,通常涉及進一步調整編碼器[34]或用更高分辨率的預訓練編碼器替換[50]。類似地,CogAgent [44]使用雙編碼器機制,其中兩個編碼器分別處理高分辨率和低分辨率圖像。通過交叉注意力將高分辨率特征注入到低分辨率分支中。塊分割方法將高分辨率圖像切成塊,并重用低分辨率編碼器。例如,Monkey [51]和SPHINX [53]將大圖像分成較小的塊,并將子圖像與下采樣的高分辨率圖像一起發送到圖像編碼器,其中子圖像和低分辨率圖像分別捕獲局部和全局特征。相比之下,參數大小和訓練數據組成與輸入分辨率相比不那么重要,這是通過實證研究發現的[52]。

其他模態也有類似的編碼器。例如,Pengi [27]使用CLAP [54]模型作為音頻編碼器。ImageBind-LLM [30]使用ImageBind [55]編碼器,支持編碼圖像、文本、音頻、深度、熱成像和慣性測量單元(IMU)數據。配備強大的編碼器,ImageBind-LLM可以響應多種模態的輸入。

2.2 預訓練LLM

與其從頭開始訓練一個LLM,更有效和實用的方法是從一個預訓練的模型開始。通過在網絡語料庫上進行巨大的預訓練,LLM已經嵌入了豐富的世界知識,并展示了強大的泛化和推理能力。

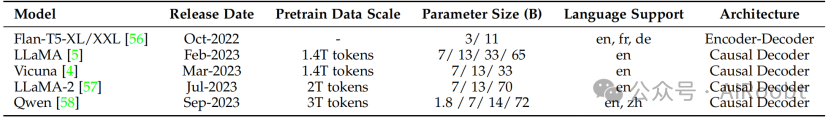

我們在表2中總結了常用的和公開可用的LLM。值得注意的是,大多數LLM屬于因果解碼器類別,遵循GPT-3 [7]。其中,FlanT5 [56]系列是在BLIP-2 [59]和InstructBLIP [60]等工作中使用的相對早期的LLM。LLaMA系列[5]、[57]和Vicuna家族[4]是吸引了大量學術關注的代表性開源LLM。由于這兩個LLM主要在英文語料庫上預訓練,它們在多語言支持上受到限制,例如中文。相比之下,Qwen [58]是一個支持中文和英文的雙語LLM。

表2:常用開源大型語言模型的總結。en、zh、fr和de分別代表英語、中文、法語和德語。

值得注意的是,擴大LLM的參數大小也會帶來額外的收益,類似于增加輸入分辨率的情況。具體來說,Liu等人[50]、[61]發現,將LLM從7B簡單擴大到13B在各種基準測試上帶來了全面的改進。此外,當使用34B LLM時,模型顯示出在訓練期間僅使用英文多模態數據時的零樣本中文能力。Lu等人[62]通過將LLM從13B擴大到35B和65B/70B,發現更大的模型大小在專門為MLLM設計的基準測試上帶來了一致的收益。

也有一些工作使用較小的LLM以便于在移動設備上部署。例如,MobileVLM系列[63]、[64]使用縮小的LLaMA [5](稱為MobileLLaMA 1.4B/2.7B),實現在移動處理器上的高效推理。

最近,對LLM的專家混合(MoE)架構的探索引起了越來越多的關注[65]、[66]、[67]。與密集模型相比,稀疏架構通過選擇性激活參數,實現了在不增加計算成本的情況下擴大總參數大小的能力。實證上,MM1 [52]和MoE-LLaVA [68]發現MoE實現在幾乎所有基準測試上的性能優于密集對應物。

2.3 模態接口

由于LLM只能感知文本,因此有必要彌合自然語言與其他模態之間的差距。然而,以端到端的方式訓練一個大型多模態模型將耗費巨大。更實際的方法是在預訓練的視覺編碼器和LLM之間引入一個可學習的連接器。另一種方法是利用專家模型,如圖像字幕模型,將圖像翻譯成語言,然后將語言發送到LLM。

可學習的連接器。它負責彌合不同模態之間的差距。具體來說,該模塊將信息投影到LLM可以高效理解的空間中。根據多模態信息的融合方式,大致有兩種實現此類接口的方法,即令牌級和特征級融合。

對于令牌級融合,編碼器輸出的特征被轉換為令牌,并與文本令牌連接,然后發送到LLM。一個常見且可行的解決方案是利用一組可學習的查詢令牌以基于查詢的方式提取信息[69],這首先在BLIP-2 [59]中實現,隨后被多種工作[26]、[60]、[70]繼承。這種Q-Former風格的方法是將視覺令牌壓縮成較少數量的表示向量。相反,一些方法簡單地使用基于MLP的接口來彌合模態差距[20]、[37]、[71]、[72]。例如,LLaVA系列采用一個/兩個線性MLP[20]、[50]來投影視覺令牌,并將特征維度與詞嵌入對齊。

在相關話題上,MM1 [52]對連接器的設計選擇進行了消融,并發現對于令牌級融合,模態適配器的類型遠不如視覺令牌的數量和輸入分辨率重要。盡管如此,Zeng等人[73]比較了令牌級和特征級融合的性能,并實證揭示了令牌級融合變體在VQA基準測試中的性能更好。關于性能差距,作者建議交叉注意力模型可能需要更復雜的超參數搜索過程才能達到可比的性能。

作為另一條線,特征級融合插入額外的模塊,使文本特征和視覺特征之間能夠進行深度交互和融合。例如,Flamingo [74]在LLM的凍結Transformer層之間插入額外的交叉注意力層,從而用外部視覺線索增強語言特征。類似地,CogVLM [75]在每個Transformer層中插入一個視覺專家模塊,以實現視覺和語言特征之間的雙重交互和融合。為了更好的性能,引入模塊的QKV權重矩陣是從預訓練的LLM初始化的。類似地,LLaMA-Adapter [76]在Transformer層中引入可學習的提示。這些提示首先嵌入視覺知識,然后作為前綴與文本特征連接。

在參數大小方面,可學習的接口通常與編碼器和LLM相比只占一小部分。以Qwen-VL [34]為例,Q-Former的參數大小約為0.08B,占整個參數的不到1%,而編碼器和LLM分別占約19.8%(1.9B)和80.2%(7.7B)。

專家模型。除了可學習的接口外,使用專家模型,如圖像字幕模型,也是彌合模態差距的一種可行方式[77]、[78]、[79]、[80]。基本思想是在不訓練的情況下將多模態輸入轉換為語言。通過這種方式,大型語言模型(LLMs)可以通過轉換后的語言理解多模態性。例如,VideoChat-Text[25]使用預訓練的視覺模型提取動作等視覺信息,并使用語音識別模型豐富描述。盡管使用專家模型的方法很直接,但可能不如采用可學習的接口那樣靈活。將外來模態轉換為文本會導致信息丟失。例如,將視頻轉換為文本描述會扭曲空間-時間關系[25]。

3 訓練策略和數據

一個成熟的多模態大型語言模型(MLLM)經歷三個訓練階段,即預訓練、指令調整和對齊調整。每個訓練階段需要不同類型的數據,并實現不同的目標。在本節中,我們討論訓練目標,以及每個訓練階段的數據收集和特點。

3.1 預訓練

3.1.1 訓練細節

作為第一階段的訓練,預訓練主要旨在對齊不同的模態并學習多模態世界知識。預訓練階段通常涉及大規模文本配對數據,例如字幕數據。通常,字幕對以自然語言句子描述圖像/音頻/視頻。

這里,我們考慮一個常見的場景,即MLLMs被訓練以對齊視覺與文本。如表3所示,給定一張圖像,模型被訓練以自回歸方式預測圖像的字幕,遵循標準的交叉熵損失。預訓練的一個常見方法是保持預訓練模塊(例如視覺編碼器和LLMs)固定,并訓練一個可學習的接口[20]、[35]、[72]。這個想法是在不丟失預訓練知識的情況下對齊不同的模態。一些方法[34]、[81]、[82]也解除了更多模塊(例如視覺編碼器)的凍結,以使更多的可訓練參數用于對齊。需要注意的是,訓練方案與數據質量密切相關。

表3:一個用于結構化標題數據的簡化模板。{<image>} 是視覺標記的占位符,{caption} 是圖片的標題。請注意,只有標記為紅色的部分用于損失計算。

對于簡短和嘈雜的字幕數據,可以采用較低分辨率(例如224)以加快訓練過程,而對于更長和更清潔的數據,最好使用更高的分辨率(例如448或更高)以減少幻覺。此外,ShareGPT4V[83]發現,在預訓練階段使用高質量的字幕數據時,解鎖視覺編碼器促進了更好的對齊。

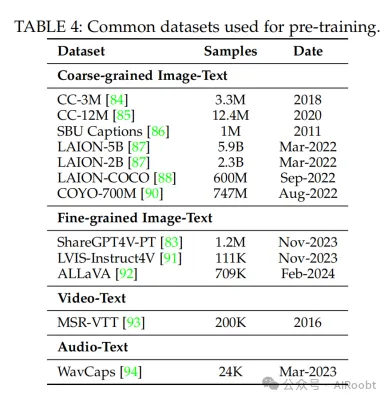

3.1.2 數據

預訓練數據主要有兩個目的,即(1)對齊不同的模態和(2)提供世界知識。預訓練語料庫可以根據粒度分為粗粒度和細粒度數據,我們將依次介紹。我們在表4中總結了常用的預訓練數據集。

粗粒度字幕數據有一些共同的典型特征:(1)數據量大,因為樣本通常來源于互聯網。(2)由于網絡爬取的特性,字幕通常簡短且嘈雜,因為它們來自網絡圖像的alt文本。這些數據可以通過自動工具進行清洗和過濾,例如,使用CLIP[13]模型過濾掉圖像-文本對的相似度低于預定義閾值的樣本。接下來,我們介紹一些代表性的粗粒度數據集。

CC. CC-3M[84]是一個包含3.3M圖像-字幕對的網絡規模字幕數據集,原始描述來源于與圖像關聯的alt文本。作者設計了一個復雜的數據清洗流程:(1)對于圖像,過濾掉不適當的內容或縱橫比的圖像。(2)對于文本,使用NLP工具獲取文本注釋,并根據設計好的啟發式規則過濾樣本。(3)對于圖像-文本對,通過分類器給圖像分配標簽。如果文本注釋與圖像標簽不重疊,相應的樣本將被丟棄。CC-12M[85]是CC-3M的后續工作,包含12.4M圖像-字幕對。與之前的工作相比,CC-12M放寬并簡化了數據收集流程,因此收集了更多的數據。

SBU字幕[86]。它是一個包含1M圖像-文本對的帶字幕的照片數據集,圖像和描述來自Flickr。具體來說,通過使用大量查詢詞查詢Flickr網站獲得一組初始圖像。附加在圖像上的描述因此作為字幕。然后,為確保描述與圖像相關,保留的圖像滿足這些要求:(1)圖像的描述長度令人滿意,由觀察決定。(2)圖像的描述至少包含預定義詞匯列表中的2個詞和通常暗示空間關系的命題詞(例如“on”,“under”)。

LAION。這個系列是大型網絡規模數據集,圖像從互聯網上爬取,并將相關的alt文本作為字幕。為了過濾圖像-文本對,執行了以下步驟:(1)文本長度過短或圖像大小太小或太大的被丟棄。(2)基于URL的圖像去重。(3)提取CLIP[13]嵌入圖像和文本,并使用嵌入丟棄可能的非法內容以及嵌入之間余弦相似度低的圖像-文本對。在這里,我們簡要總結一些典型的變體:

? LAION-5B[87]:這是一個研究用數據集,包含5.85B圖像-文本對。數據集是多語言的,有一個2B的英語子集。

? LAION-COCO[88]:它包含從LAION-5B的英語子集提取的600M圖像。字幕是合成的,使用BLIP[89]生成各種圖像字幕,并使用CLIP[13]選擇最適合圖像的字幕。

COYO-700M[90]。它包含747M圖像-文本對,這些是從CommonCrawl中提取的。為了數據過濾,作者設計了以下策略:(1)對于圖像,過濾掉不適當的大小、內容、格式或縱橫比的圖像。此外,基于pHash值過濾圖像,以去除與公共數據集(如ImageNet和MS-COCO)重疊的圖像。(2)對于文本,只保存長度令人滿意、名詞形式和適當詞匯的英文文本。將刪除句子前后的空白,并將連續的空白字符替換為單個空白。此外,出現超過10次的文本(例如“image for”)將被丟棄。(3)對于圖像-文本對,基于(圖像pHash,文本)元組去除重復樣本。

最近,更多工作[83]、[91]、[92]探索了通過提示強大的MLLMs(例如GPT-4V)生成高質量的細粒度數據。與粗粒度數據相比,這些數據通常包含更長、更準確的圖像描述,從而實現更細粒度的圖像和文本模態之間的對齊。然而,由于這種方法通常需要調用商業用途的MLLMs,成本更高,數據量相對較小。值得注意的是,ShareGPT4V[83]通過首先使用GPT-4V生成的100K數據訓練字幕生成器,然后使用預訓練的字幕生成器將數據量擴大到1.2M,實現了平衡。

3.2 指令微調

3.2.1 介紹

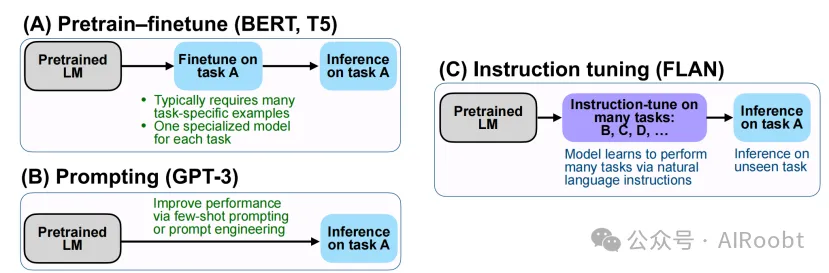

指令指的是對任務的描述。直觀地說,指令微調旨在教模型更好地理解用戶的指令并完成所需的任務。通過這種方式微調,LLM(大型語言模型)可以通過遵循新指令來泛化到未見過的任務,從而提升零樣本性能。這個簡單而有效的想法引發了后續NLP工作的成功,例如ChatGPT [2]、InstructGPT [95]、FLAN [19]、[56] 和 OPT-IML [96]。指令微調與相關典型學習范式的比較如圖3所示。監督微調方法通常需要大量特定任務的數據來訓練特定任務的模型。提示工程方法減少了對大規模數據的依賴,可以通過提示工程完成專門任務。在這種情況下,盡管少樣本性能有所提高,但零樣本性能仍然相當普通[7]。與此不同,指令微調學習如何泛化到未見過的任務,而不是像其他兩種方法那樣擬合特定任務。此外,指令微調與多任務提示高度相關[97]。

圖3:三種典型學習范式的比較。圖像來自[19]。

在本節中,我們描述了指令樣本的格式、訓練目標、收集指令數據的典型方式以及常用的數據集。

3.2.2 訓練細節

一個多模態指令樣本通常包括一個可選的指令和一個輸入輸出對。指令通常是描述任務的自然語言句子,例如,“詳細描述這張圖片。”輸入可以是圖文對,例如VQA任務[99],也可以僅是圖片,例如圖像標題任務[100]。輸出是根據輸入條件生成的指令答案。指令模板是靈活的,可以根據人工設計進行調整[20]、[25]、[98],如表5所示。需要注意的是,指令模板也可以推廣到多輪對話的情況[20]、[37]、[71]、[98]。

表5:結構化多模態指令數據的簡化模板。<instruction>是任務的文本描述。{<image>, <text>}和<output>是數據樣本的輸入和輸出。請注意,對于某些數據集,輸入中的<text>可能會缺失,例如圖像標題數據集僅有<image>。該示例改編自[98]。

正式地說,一個多模態指令樣本可以表示為三元組形式,即 (I, M, R),其中 I、M、R 分別表示指令、多模態輸入和真實響應。MLLM 在給定指令和多模態輸入的情況下預測一個答案:

A = f(I, M;θ)

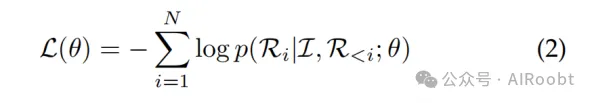

這里,A 表示預測的答案,θ 是模型的參數。訓練目標通常是用于訓練LLM的原始自回歸目標[20]、[37]、[71]、[101],基于此,MLLM 被鼓勵預測響應的下一個標記。目標可以表示為:

其中 N 是真實響應的長度。

3.2.3 數據收集

由于指令數據在格式上更加靈活,任務形式多樣,通常收集數據樣本更為棘手且成本更高。在本節中,我們總結了三種典型的大規模收集指令數據的方法,即數據適配、自指令和數據混合。

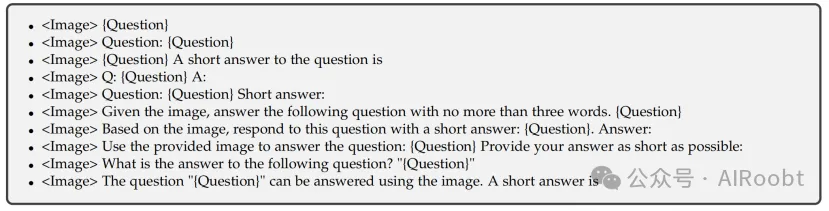

數據適配。任務特定的數據集是高質量數據的豐富來源。因此,許多工作[60]、[70]、[76]、[82]、[101]、[102]、[103]、[104] 利用現有的高質量數據集來構建指令格式化的數據集。以VQA數據集的轉換為例,原始樣本是一個輸入輸出對,其中輸入包括一張圖片和一個自然語言問題,輸出是根據圖片的文本答案。這些數據集的輸入輸出對自然地構成了指令樣本的多模態輸入和響應(見§3.2.2)。指令,即任務的描述,可以來自人工設計或在GPT的幫助下半自動生成。具體來說,一些工作[21]、[35]、[60]、[70]、[102]、[105] 手工制作了候選指令池,并在訓練期間從中抽取一個。我們提供了VQA數據集指令模板的示例,如表6所示。其他工作則手動設計了一些種子指令,并使用這些指令來提示GPT生成更多指令[25]、[82]、[98]。需要注意的是,由于現有的VQA和標題數據集的答案通常簡短,直接使用這些數據集進行指令微調可能會限制MLLMs的輸出長度。有兩種常見策略來解決這個問題。第一種是明確在指令中指定。例如,ChatBridge [104] 明確聲明對于簡短答案數據使用短小簡潔,以及對于傳統粗粒度標題數據使用一個句子和單個句子。第二種是延長現有答案的長度。例如,M3IT [105] 提議通過提示ChatGPT使用原始問題、答案和圖像的上下文信息(例如標題和OCR)來重新措辭原始答案。

表6:VQA數據集的指令模板,引用自[60]。<Image> 和 {Question} 分別是原始VQA數據集中的圖像和問題。

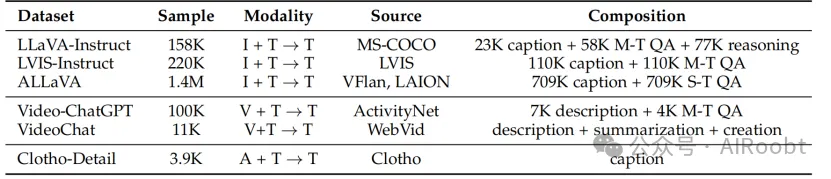

自指令。盡管現有的多任務數據集可以提供豐富的數據來源,但它們通常不能很好地滿足現實世界場景中的人類需求,例如多輪對話。為了解決這個問題,一些工作通過自指令[106] 收集樣本,利用LLMs通過少量手動注釋的樣本生成文本指令跟隨數據。具體來說,一些指令跟隨樣本被手工制作作為演示,然后通過提示ChatGPT/GPT-4生成更多指令樣本,并以這些演示作為指導。LLaVA [20] 將這種方法擴展到多模態領域,通過將圖像翻譯成標題和邊界框的文本,并提示僅文本的GPT-4根據要求和演示生成新數據。這樣構建了一個多模態指令數據集,稱為LLaVA-Instruct-150k。按照這個思路,后續工作如MiniGPT-4 [21]、ChatBridge [104]、GPT4Tools [107] 和DetGPT [72] 開發了滿足不同需求的不同數據集。最近,隨著更強大的多模態模型GPT-4V的發布,許多工作采用GPT-4V生成更高質量的數據,如LVIS-Instruct4V [91] 和ALLaVA [92]。我們總結了通過自指令生成的流行數據集,如表7所示。

表7:自指令生成的流行數據集概述。對于輸入/輸出模態,I:圖像,T:文本,V:視頻,A:音頻。對于數據組成,M-T和S-T分別表示多輪和單輪。

數據混合。除了多模態指令數據外,僅語言的用戶助手對話數據也可以用于提高對話能力和指令跟隨能力[81]、[98]、[101]、[103]。LaVIN [101] 通過隨機抽取語言和多模態數據直接構建小批量數據。MultiInstruct [102] 探索了使用單模態和多模態數據融合訓練的不同策略,包括混合指令微調(結合兩種類型的數據并隨機打亂)和順序指令微調(文本數據后接多模態數據)。

3.2.4 數據質量

最近的研究表明,指令微調樣本的數據質量與數量同樣重要。Lynx [73] 發現,預訓練在大規模但噪聲較大的圖文對上的模型,其性能不如使用較小但更干凈的數據集預訓練的模型。同樣,Wei 等人[108] 發現較少但質量更高的指令微調數據可以實現更好的性能。為了數據過濾,該工作提出了一些評估數據質量的指標,并相應地提出了一種方法來自動過濾出較差的視覺語言數據。在此,我們討論兩個關于數據質量的重要方面。

提示多樣性。提示的多樣性被發現對模型性能至關重要。Lynx [73] 通過實驗證實,多樣的提示有助于提高模型的性能和泛化能力。

任務覆蓋。關于訓練數據中涉及的任務,Du 等人[109] 進行了一項實證研究,發現視覺推理任務在提高模型性能方面優于標題和問答任務。此外,研究表明,增強指令的復雜性可能比增加任務多樣性和包含細粒度空間注釋更有益。

3.3 對齊微調

3.3.1 介紹

對齊微調通常用于模型需要與特定人類偏好對齊的場景,例如減少幻覺的響應(見第6節)。目前,使用人類反饋的強化學習(RLHF)和直接偏好優化(DPO)是對齊微調的兩種主要技術。在本節中,我們依次介紹這兩種技術的主要思想,并提供一些它們在解決實際問題中的應用示例,最后匯總相關數據集。

3.3.2 訓練細節

RLHF [110],[111]。該技術旨在利用強化學習算法使LLM與人類偏好對齊,訓練環節中以人類注釋作為監督。以InstructGPT [95] 為例,RLHF 包括三個關鍵步驟:

1)監督微調。此步驟旨在對預訓練模型進行微調,以呈現初步的預期輸出行為。RLHF 設置中的微調模型稱為策略模型。注意,這一步驟可能會被跳過,因為監督策略模型πSFT可以從指令微調模型初始化(見 §3.2)。

2)獎勵建模。在此步驟中,使用偏好對訓練獎勵模型。給定多模態提示(例如圖像和文本)x 和響應對(yw, yl),獎勵模型 rθ 學習為偏好的響應 yw給出更高的獎勵,反之亦然,如下目標所示:

其中 D = (x, yw, yl)是由人類注釋者標記的比較數據集。實際上,獎勵模型 rθ具有與策略模型相似的結構。

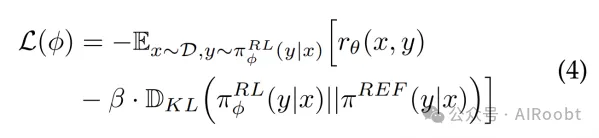

3)強化學習。在此步驟中,采用近端策略優化(PPO)算法來優化RL策略模型 πRLφ。通常在訓練目標中加入每個標記的KL懲罰,以避免偏離原始策略太遠[95],結果目標為:

其中 β是KL懲罰項的系數。通常,RL策略πRFT和參考模型πRLφ都從監督模型 πSFT初始化。

通過這個微調過程,期望獲得的RL策略模型與人類偏好對齊。

研究人員已經探索了使用RLHF技術來更好地實現多模態對齊。例如,LLaVA-RLHF [112] 收集人類偏好數據,并基于LLaVA [20] 調整一個減少幻覺的模型。

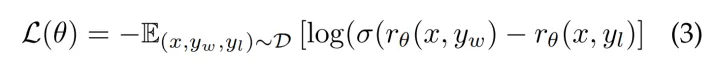

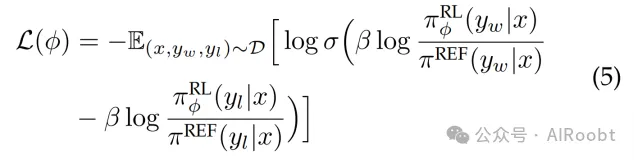

DPO [113]。它利用一個簡單的二元分類損失從人類偏好標簽中學習。與基于PPO的RLHF算法相比,DPO免除了學習顯式獎勵模型的需求,從而簡化了整個流程為兩個步驟,即人類偏好數據收集和偏好學習。學習目標如下:

RLHF-V [114] 通過糾正模型響應中的幻覺,收集了細粒度(片段級別)偏好數據對,并使用獲得的數據執行密集的DPO。Silkie [115] 則通過提示GPT-4V收集偏好數據,并通過DPO將偏好監督提煉到一個指令微調模型中。

3.3.3 數據

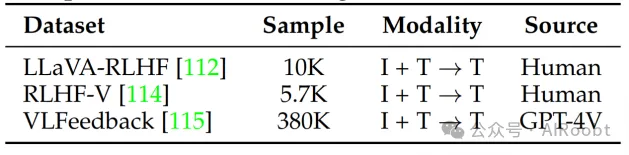

對齊微調的數據收集要點是收集模型響應的反饋,即決定哪個響應更好。收集此類數據通常更昂貴,并且用于此階段的數據量通常比前幾個階段使用的數據還少。在本部分,我們介紹了一些數據集并在表8中進行了總結。

表8:用于對齊調優的數據集概述。對于輸入/輸出模態,I:圖像,T:文本。

LLaVA-RLHF [112]。它包含10K個根據誠實和有用性收集的人類反饋偏好對。該數據集主要用于減少模型響應中的幻覺。

RLHF-V [114]。它收集了5.7K通過片段級別幻覺糾正的細粒度人類反饋數據。

VLFeedback [115]。它利用AI對模型響應提供反饋。數據集中包含超過380K個由GPT-4V根據有用性、真實性和倫理問題評分的比較對。

4 評估

評估是開發MLLMs(多模態大型語言模型)的重要部分,因為它為模型優化提供反饋并有助于比較不同模型的性能。與傳統多模態模型的評估方法相比,MLLMs的評估展示了幾個新特征:(1)由于MLLMs通常是多才多藝的,因此全面評估MLLMs非常重要。(2)MLLMs表現出許多需要特別關注的新興能力(例如無OCR的數學推理),因此需要新的評估方案。MLLMs的評估可以根據問題類型大致分為兩類:封閉集和開放集。

4.1 封閉集

封閉集問題指的是一種可能答案選項是預定義且有限的問題類型。評估通常在任務特定的數據集上進行。在這種情況下,可以自然地通過基準指標[20]、[60]、[70]、[76]、[101]、[102]、[103]、[104]來判斷響應。例如,InstructBLIP [60] 報告了ScienceQA [116] 的準確性,以及NoCaps [118] 和Flickr30K [119] 的CIDEr得分[117]。評估設置通常是零樣本[60]、[102]、[104]、[105]或微調[20]、[35]、[60]、[70]、[76]、[101]、[103]、[105]。前一種設置通常選擇覆蓋不同一般任務的廣泛數據集,并將它們分為保留集和測試集。在前者上進行調優后,在未見過的數據集或任務上評估零樣本性能。相比之下,第二種設置通常出現在特定領域任務的評估中。例如,LLaVA [20] 和 LLaMA-Adapter [76] 報告了ScienceQA [116] 上的微調性能。LLaVA-Med [35] 報告了生物醫學VQA [120]、[121]、[122]的結果。

上述評估方法通常限于選定任務或數據集的較小范圍,缺乏全面的定量比較。為此,一些努力開發了專門為MLLMs設計的新基準[123]、[124]、[125]、[126]、[127]、[128]、[129]。例如,Fu等人[123] 構建了一個綜合評估基準MME,包含14個感知和認知任務。MME中的所有指令-回答對均為手動設計,以避免數據泄漏。MMBench [124] 是一個專門設計用于評估模型能力多個維度的基準,使用ChatGPT將開放響應與預定義選項匹配。Video-ChatGPT [130] 和 Video-Bench [131] 關注視頻領域,并提出了專門的基準和評估工具進行評估。還有一些評估策略設計用于評估模型的特定方面[102],例如POPE [132] 用于評估幻覺程度。

4.2 開放集

與封閉集問題相比,開放集問題的回答更靈活,MLLMs通常扮演聊天機器人的角色。由于聊天內容可以是任意的,因此判斷比封閉式輸出更棘手。標準可以分為手動評分、GPT評分和案例研究。手動評分需要人類評估生成的響應。這種方法通常涉及手工制作的問題,旨在評估特定維度。例如,mPLUG-Owl [81] 收集了一個視覺相關的評估集,以判斷自然圖像理解、圖表和流程圖理解等能力。類似地,GPT4Tools [107] 分別構建了微調和零樣本性能的兩個數據集,并從思維、行動、論點和整體上評估響應。

由于手動評估勞動強度大,一些研究人員探索了使用GPT評分的方法。這種方法通常用于評估多模態對話性能。LLaVA [20] 提議通過僅文本的GPT-4從不同方面(如有用性和準確性)對響應進行評分。具體來說,從COCO [133] 驗證集中抽取30張圖像,每張圖像都通過GPT-4自指令關聯了一個簡短問題、一個詳細問題和一個復雜推理問題。模型和GPT-4生成的答案都被發送給GPT-4進行比較。后續工作遵循這一思路,提示ChatGPT [81] 或GPT-4 [35]、[70]、[101]、[104]、[105] 進行評分[35]、[70]、[81]、[101]、[104] 或判斷哪個更好[103]。

應用僅文本的GPT-4作為評估者的主要問題是評估僅基于圖像相關的文本內容,例如標題或邊界框坐標,而沒有訪問圖像[35]。因此,在這種情況下,將GPT-4設為性能上限可能是有問題的。隨著GPT視覺接口的發布,一些工作[77]、[134] 利用更先進的GPT-4V模型評估MLLMs的性能。例如,Woodpecker [77] 采用GPT-4V根據圖像判斷模型答案的響應質量。由于GPT-4V可以直接訪問圖像,因此這種評估被認為比使用僅文本的GPT-4更準確。

一種補充方法是通過案例研究比較MLLMs的不同能力。例如,一些研究評估了兩個典型的高級商用模型GPT-4V和Gemini。Yang等人[135] 通過在各種領域和任務中制作一系列樣本,對GPT-4V進行了深入的定性分析,涵蓋從基本技能(如標題和對象計數)到需要世界知識和推理的復雜任務(如笑話理解和作為具身代理的室內導航)。Wen等人[136] 通過設計針對自動駕駛場景的樣本,更集中地評估了GPT-4V。Fu等人[137] 通過將模型與GPT-4V進行比較,對Gemini-Pro進行了全面評估。結果表明,盡管響應風格不同,GPT-4V和Gemini在視覺推理能力上表現出相當的水平。

5 擴展

最近的研究在擴展MLLMs(多模態大型語言模型)的能力方面取得了顯著進展,從更強大的基礎能力到更廣泛的場景覆蓋。我們回顧了MLLMs在這方面的主要發展。

粒度支持。為了促進代理與用戶之間的更好互動,研究人員開發了在模型輸入和輸出方面具有更細粒度支持的MLLMs。在輸入方面,支持用戶提示更細致控制的模型逐漸發展,從圖像到區域[28]、[138]、[139],甚至像素[29]、[140]、[141]。具體來說,Shikra [28] 支持區域級輸入和理解。用戶可以通過指向自然語言形式的邊界框,更靈活地與助手互動。Ferret [141] 更進一步,通過設計一種混合表示方案,支持更靈活的指向。該模型支持不同形式的提示,包括點、框和草圖。類似地,Osprey [29] 通過利用分割模型[9] 支持點輸入。借助預訓練分割模型的出色能力,Osprey 使得只需一次點擊即可指定單個實體或其一部分。在輸出方面,隨著輸入支持的發展,定位能力得到了改進。Shikra [28] 支持帶有框注釋的圖像響應,從而提供更高的精度和更細致的指向體驗。LISA [142] 進一步支持掩碼級理解和推理,使得像素級定位成為可能。

模態支持。對模態支持的增加是MLLM研究的一個趨勢。一方面,研究人員探索了使MLLMs支持更多多模態內容輸入,例如3D點云[41]、[143]、[144]、[145]。另一方面,MLLMs也擴展了生成更多模態響應的能力,如圖像[32]、[146]、[147]、[148],音頻[32]、[147]、[149]、[150] 和視頻[32]、[151]。例如,NExT-GPT [32] 提出一個框架,支持混合模態的輸入和輸出,具體來說,是文本、圖像、音頻和視頻的組合,借助于附加在MLLM上的擴散模型[152]、[153]。該框架采用編碼器-解碼器架構,并將LLM作為理解和推理的樞紐。

語言支持。當前的模型主要是單語的,可能是因為高質量的非英語訓練語料稀缺。一些工作致力于開發多語種模型,以覆蓋更廣泛的用戶。VisCPM [33] 通過設計一個多階段訓練方案,將模型能力轉移到多語種環境。具體來說,該方案將英語作為關鍵語言,擁有豐富的訓練語料。利用預訓練的雙語LLM,在指令微調過程中通過添加一些翻譯樣本將多模態能力轉移到中文。采用類似的方法,Qwen-VL [34] 由雙語LLM Qwen [58] 開發,支持中文和英文。在預訓練過程中,中文數據被混合到訓練語料中,以保留模型的雙語能力,占整個數據量的22.7%。

場景/任務擴展。除了開發通用助手外,一些研究專注于需要考慮實際條件的特定場景,另一些則將MLLMs擴展到具有特定專業知識的下游任務。

一個典型的趨勢是將MLLMs適應更多特定的現實生活場景。MobileVLM [63] 探索開發小尺寸變體的MLLMs以用于資源受限的場景。一些設計和技術用于在移動設備上部署,例如更小尺寸的LLMs和量化技術以加速計算。其他工作開發了與現實世界互動的代理[41]、[154]、[155],例如專為圖形用戶界面(GUI)設計的用戶友好助手,如CogAgent [44]、AppAgent [43] 和 Mobile-Agent [45]。這些助手擅長規劃并指導完成用戶指定的任務,作為人機交互的有用代理。另一條線是通過注入特定技能來增強MLLMs,以解決不同領域的任務,例如文檔理解[38]、[39]、[156]、[157] 和醫學領域[35]、[36]、[37]。對于文檔理解,mPLUG-DocOwl [38] 利用各種形式的文檔級數據進行微調,從而增強了無OCR文檔理解模型。TextMonkey [39] 將與文檔理解相關的多個任務結合起來,以提高模型性能。除了傳統的文檔圖像和場景文本數據集,還添加了與位置相關的任務,以減少幻覺并幫助模型學習將響應定位在視覺信息中。MLLMs還可以通過灌輸醫學領域的知識擴展到醫學領域。例如,LLaVA-Med [158] 將醫學知識注入基礎LLaVA [20],開發了一個專注于醫學圖像理解和問答的助手。

6 多模態幻覺

多模態幻覺是指MLLMs生成的響應與圖像內容不一致的現象[77]。作為一個基本而重要的問題,這個問題越來越受到關注。在本節中,我們簡要介紹一些相關概念和研究進展。

6.1 初步介紹

當前關于多模態幻覺的研究可以進一步分為三類[159]:

1. 存在幻覺 是最基本的形式,意味著模型錯誤地聲稱圖像中存在某些物體。

2. 屬性幻覺 指的是錯誤描述某些物體的屬性,例如未能正確識別狗的顏色。它通常與存在幻覺相關,因為屬性的描述應該基于圖像中存在的物體。

3. 關系幻覺 是一種更復雜的類型,也基于物體的存在。它指的是對物體之間關系的錯誤描述,例如相對位置和交互。

接下來,我們首先介紹一些特定的評估方法(§6.2),這些方法對于評估減少幻覺的方法的性能很有用(§6.3)。然后,我們將根據每種方法的主要類別詳細討論當前減少幻覺的方法。

6.2 評估方法

CHAIR [160] 是一個早期的度量,用于評估開放式標題中的幻覺水平。該度量衡量帶有幻覺對象或所有提到對象的句子比例。相比之下,POPE [132] 是一種評估封閉式選擇的方法。具體來說,多個帶有二元選擇的提示被制定,每個提示詢問圖像中是否存在特定對象。該方法還涵蓋了更具挑戰性的設置,以評估MLLMs的魯棒性,同時考慮數據統計。最終評估使用一種簡單的關鍵詞機制,即通過檢測關鍵詞“是/否”,將開放式響應轉換為封閉式二元選擇。采用類似的評估方法,MME [123] 提供了更全面的評估,涵蓋存在、計數、位置和顏色方面,如[77] 所示。

與以前使用匹配機制檢測和決定幻覺的方法不同,HaELM [161] 提出使用僅文本的LLMs作為評判者,自動決定MLLMs的標題是否正確。鑒于僅文本的LLMs只能訪問有限的圖像上下文并需要參考注釋,Woodpecker [77] 使用GPT-4V直接評估基于圖像的模型響應。FaithScore [162] 是一個更細粒度的度量,基于一個例程,將描述性子句分解并分別評估每個子句。基于以前的研究,AMBER [163] 是一個不依賴LLM的基準,涵蓋辨別任務和生成任務,并涉及三種可能的幻覺類型(見§6.1)。

6.3 緩解方法

根據高層次的想法,目前的方法可以大致分為三類:預修正、過程修正和后修正。

預修正。幻覺的一種直觀而直接的解決方案是收集專門的數據(例如負面數據),并使用這些數據進行微調,從而減少幻覺響應的模型。

LRV-Instruction [164] 引入了一個視覺指令微調數據集。除了常見的正面指令外,該數據集還結合了在不同語義層次上精心設計的負面指令,以鼓勵響應忠實于圖像內容。LLaVA-RLHF [112] 收集人類偏好對并使用強化學習技術進行微調,導致模型更符合減少幻覺的答案。

過程修正。另一條途徑是在架構設計或特征表示方面進行改進。這些工作試圖探討幻覺的原因,并在生成過程中設計相應的補救措施來減少幻覺。

HallE-Switch [159] 對對象存在幻覺的可能因素進行了經驗分析,并假設存在幻覺源于未被視覺編碼器定位的對象,它們實際上是基于嵌入在LLM中的知識推斷出來的。基于這一假設,引入了一個連續控制因素和相應的訓練方案,以在推理過程中控制模型輸出中的想象程度。

VCD [165] 認為對象幻覺源于兩個主要原因,即訓練語料中的統計偏差和嵌入在LLM中的強語言先驗。作者注意到,當向圖像注入噪聲時,MLLMs傾向于依賴語言先驗而不是圖像內容進行響應生成,從而導致幻覺。相應地,該工作設計了一種放大-對比解碼方案,以抵消錯誤的偏差。

HACL [166] 調查了視覺和語言的嵌入空間。基于觀察,設計了一種對比學習方案,將配對的跨模態表示拉近,同時推開非幻覺和幻覺文本表示。

后修正。不同于以前的范式,后修正以事后補救的方式減少幻覺,并在輸出生成后糾正幻覺。Woodpecker [77] 是一個不需要訓練的通用幻覺修正框架。具體來說,該方法結合專家模型補充圖像的上下文信息,并設計了一個管道逐步糾正幻覺。該方法是可解釋的,因為每一步的中間結果都可以檢查,對象定位在圖像中。另一種方法LURE [167] 訓練一個專門的修訂器來屏蔽描述中不確定性高的對象,并再次重新生成響應。

7 擴展技術

7.1 多模態上下文學習

ICL(上下文學習)是LLMs的一項重要新興能力。ICL有兩個好的特點:(1)不同于傳統的監督學習范式從大量數據中學習隱式模式,ICL的關鍵在于從類比中學習[168]。具體來說,在ICL設置中,LLMs從一些示例以及可選的指令中學習,并推測新問題,從而以少樣本的方式解決復雜和未見過的任務[22]、[169]、[170]。(2)ICL通常以無訓練的方式實現[168],因此可以靈活地集成到推理階段的不同框架中。一項與ICL密切相關的技術是指令微調(見§3.2),實驗證明其可以增強ICL能力[19]。

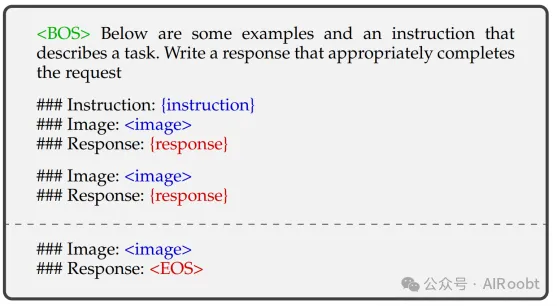

在MLLM的背景下,ICL已擴展到更多模態,形成了多模態ICL(M-ICL)。基于(§3.2)中的設置,在推理時,M-ICL可以通過向原始樣本添加一個示例集(即上下文中的示例集)來實現。在這種情況下,模板可以如表9所示擴展。需要注意的是,我們列出了兩個上下文示例用于說明,但示例的數量和順序可以靈活調整。事實上,模型通常對示例的安排敏感[168]、[171]。

表9:結構化M-ICL查詢模板的簡化示例,改編自[98]。為了說明,我們列出了兩個上下文示例和一個由虛線分隔的查詢。{instruction}和{response}是數據樣本中的文本。<image>是表示多模態輸入的占位符(在本例中為圖像)。<BOS>和<EOS>分別是表示輸入到LLM的開始和結束的標記。

7.1.1 ICL能力的改進

最近,越來越多的工作專注于在各種場景下提高ICL性能。在本節中,我們追蹤了該領域的發展,并總結了一些相關工作。

MIMIC-IT [172] 通過構建帶有多模態上下文的指令數據集,將上下文學習與指令微調結合起來。在引入的數據集上進行指令微調的模型在標題任務中的少樣本性能有所提高。Emu [173] 通過在模型生成和相應的訓練語料中引入額外的模態,擴展了Flamingo [74] 的想法。在引入的視覺解碼器(即Stable Diffusion)的幫助下,模型從額外的視覺監督中學習,并在輸出格式和上下文推理中提供更多的靈活性。具體來說,除了以純文本回答外,模型還可以以圖像的形式給出響應。Sheng等人[174] 采用了類似的想法,嘗試將輸出模態擴展到文本和圖像。該工作沒有采用專門的圖像編碼器,而是采用了統一量化方案和共享嵌入層。

一些其他工作探索了在特定設置下提高少樣本學習性能的方法。Link-context learning [175] 專注于加強圖像-標簽對之間的因果聯系,通過制定正負圖像-描述對來進行對比訓練方案。MMICL [176] 旨在增強多張相關圖像推理的能力。為了加強圖像和文本之間的聯系,該工作提出了一種上下文方案,將交織的圖像-文本數據轉換為統一格式。Jeong [177] 發現,當插入一小部分不相關的圖像/文本作為噪聲時,MLLMs可能會被誤導,給出與上下文不一致的響應。基于這一觀察,該工作相應提出了一種預過濾方法,以去除不相關的上下文并促進更連貫的響應。

7.1.2 應用

在多模態應用方面,M-ICL主要用于兩種場景:(1)解決各種視覺推理任務[22]、[74]、[178]、[179]、[180],(2)教LLMs使用外部工具[169]、[170]、[181]。前者通常涉及從一些特定任務示例中學習并泛化到一個新的但類似的問題。從指令和示例中提供的信息中,LLMs可以了解任務的執行方式和輸出模板,最終生成預期的答案。相比之下,工具使用的示例更為細粒度。它們通常包含一系列可以順序執行以完成任務的步驟。因此,第二種場景與鏈式思維(CoT,見§7.2)密切相關。

7.2 多模態鏈式思維

正如開創性工作[8]指出的那樣,CoT(鏈式思維)是一系列中間推理步驟,已被證明在復雜推理任務中有效[8],[182],[183]。CoT的主要思想是提示LLMs不僅輸出最終答案,還輸出導致答案的推理過程,類似于人類的認知過程。

受NLP成功的啟發,多項工作[184],[185],[186],[187]已經提出將單模態CoT擴展到多模態CoT(M-CoT)。我們首先介紹獲取M-CoT能力的不同范式(§7.2.1)。然后,我們描述M-CoT的更多具體方面,包括鏈式配置(§7.2.2)和模式(§7.2.3)。

7.2.1 學習范式

學習范式也是一個值得研究的方面。大致有三種方式來獲取M-CoT能力,即通過微調和無訓練的少/零樣本學習。這三種方式對樣本數量的要求依次遞減。

直觀地說,微調方法通常涉及為M-CoT學習策劃特定數據集。例如,Lu等人[116]構建了一個包含講座和解釋的科學問答數據集ScienceQA,可以作為學習CoT推理的來源,并在所提出的數據集上微調模型。Multimodal-CoT[185]也使用ScienceQA基準,但以兩步方式生成輸出,即推理過程(鏈式推理步驟)和基于推理過程的最終答案。CoT-PT[187]通過提示微調和特定步驟的視覺偏差相結合來學習隱式鏈式推理。

與微調相比,少/零樣本學習在計算上更高效。它們之間的主要區別在于,少樣本學習通常需要手工制作一些上下文示例,以便模型更容易逐步學習推理。相比之下,零樣本學習不需要任何特定的CoT學習示例。在這種情況下,模型通過提示設計的指令(如“讓我們逐幀思考”或“這兩個關鍵幀之間發生了什么”)學習使用嵌入的知識和推理能力,而無需明確指導[184],[186]。類似地,一些工作[22],[188]通過描述任務和工具使用來提示模型,將復雜任務分解為子任務。

7.2.2 鏈式配置

結構和長度是推理鏈的兩個關鍵方面。在結構方面,當前方法可以分為單鏈和樹形方法。單鏈推理是各種方法中廣泛使用的范式[116],[185]。具體來說,逐步推理過程形成了一個問題-推理-答案的單鏈。最近,一些方法探索了使用更復雜的方案,即樹形鏈進行推理。具體來說,DDCoT[189]將一個問題分解為多個子問題,每個子問題由LLM本身或視覺專家解決生成推理。然后,LLM匯總并利用這些推理生成最終答案。對于鏈式長度,可以分為自適應和預定義兩種形式。前者要求LLM自行決定何時停止推理鏈[22],[116],[169],[170],[185],[188],而后者則在預定義長度時停止鏈式推理[79],[184],[186],[187]。

7.2.3 生成模式

如何構建鏈式推理是一個值得研究的問題。我們將當前的工作總結為(1)基于填充的模式和(2)基于預測的模式。具體來說,基于填充的模式要求在上下文(前后步驟)之間推導步驟,以填補邏輯空白[184],[186]。相比之下,基于預測的模式要求在給定條件(如指令和先前推理歷史)的情況下擴展推理鏈[22],[116],[169],[170],[185],[188]。這兩種模式的共同要求是生成的步驟應一致且正確。

7.3 LLM輔助的視覺推理

7.3.1 介紹

受到工具增強LLMs成功的啟發[190],[191],[192],[193],一些研究探索了調用外部工具[22],[107],[169],[170]或視覺基礎模型[22],[79],[80],[188],[194],[195],[196]進行視覺推理任務的可能性。這些工作將LLMs作為不同角色的助手,構建了任務特定[79],[197],[198]或通用[22],[169],[170],[181],[188]的視覺推理系統。

與傳統視覺推理模型[199],[200],[201]相比,這些工作表現出幾個優點:(1)強大的泛化能力。配備了從大規模預訓練中學到的豐富開放世界知識,這些系統可以輕松泛化到未見過的對象或概念,表現出顯著的零樣本/少樣本性能[169],[170],[195],[197],[198],[202]。(2)新興能力。借助LLMs強大的推理能力,這些系統可以執行復雜任務。例如,給定一張圖片,MM-REACT[22]可以解釋表面下的意義,例如解釋為什么一個模因很有趣。(3)更好的交互性和控制力。傳統模型通常允許有限的控制機制,并且通常需要昂貴的策劃數據集[203],[204]。相比之下,基于LLM的系統能夠在用戶友好界面中進行細致控制(例如點擊和自然語言查詢)[79]。

在這一部分,我們首先介紹構建LLM輔助視覺推理系統中使用的不同訓練范式(§7.3.2)。然后,我們深入探討LLMs在這些系統中扮演的主要角色(§7.3.3)。

7.3.2 訓練范式

根據訓練范式,LLM輔助視覺推理系統可以分為兩種類型,即無訓練和微調。

無訓練。借助預訓練LLMs中存儲的豐富先驗知識,一種直觀而簡單的方法是凍結預訓練模型,并直接提示LLMs滿足各種需求。根據設置,推理系統可以進一步分類為少樣本模型[22],[169],[170],[181]和零樣本模型[79],[197]。少樣本模型需要一些手工制作的上下文示例(見§7.1)來指導LLMs生成程序或執行步驟序列。這些程序或執行步驟作為相應基礎模型或外部工具/模塊的指令。零樣本模型則更進一步,直接利用LLMs的語言/語義知識或推理能力。例如,PointCLIP V2[197]提示GPT-3生成具有3D相關語義的描述,以更好地與相應圖像對齊。在CAT[79]中,LLMs被指示根據用戶查詢改進標題。

微調。一些工作采用進一步微調,以改進工具使用方面的計劃能力[107]或系統的定位能力[142],[205]。例如,GPT4Tools[107]引入了指令微調方法(見§3.2)。相應地,收集了一個新的工具相關指令數據集并用于微調模型。

7.3.3 功能

為了進一步檢查LLMs在LLM輔助視覺推理系統中到底扮演了什么角色,現有相關工作分為三種類型:

- LLM作為控制器

- LLM作為決策者

- LLM作為語義精煉器

前兩種角色與CoT(見§7.2)相關。由于復雜任務需要分解為中間的簡單步驟,因此這些角色經常使用。當LLMs作為控制器時,系統通常在單輪中完成任務,而在決策者的情況下,多輪更為常見。我們在以下部分描述LLMs如何在這些角色中發揮作用。

LLM作為控制器。在這種情況下,LLMs充當中央控制器,(1)將復雜任務分解為更簡單的子任務/步驟,(2)將這些任務分配給適當的工具/模塊。第一步通常利用LLMs的CoT能力完成。具體來說,LLMs被明確提示輸出任務計劃[181]或更直接地調用模塊[107],[169],[170]。例如,VisProg[170]提示GPT-3輸出一個視覺程序,其中每行程序調用一個模塊執行子任務。此外,要求LLMs輸出模塊輸入的參數名。為了處理這些復雜要求,一些手工制作的上下文示例被用作參考[169],[170],[181]。這與推理鏈的優化密切相關(見§7.2),或更具體地說,是最小到最多提示技術[206]。通過這種方式,復雜問題被分解為按順序解決的子問題。

LLM作為決策者。在這種情況下,復雜任務以多輪方式解決,通常是迭代方式[195]。決策者通常履行以下職責:(1)總結當前上下文和歷史信息,決定當前步驟的信息是否足以回答問題或完成任務;(2)組織和總結答案,以用戶友好的方式呈現。

LLM作為語義精煉器。當LLM作為語義精煉器時,研究人員主要利用其豐富的語言和語義知識。具體來說,LLMs通常被指示將信息整合成一致且流暢的自然語言句子[202],或根據不同的具體需求生成文本[79],[197],[198]。

8 挑戰與未來方向

MLLMs的發展仍處于初級階段,因此有很大的改進空間,我們總結如下:

- 當前的MLLMs在處理長上下文的多模態信息方面有限。這限制了擁有更多多模態標記的高級模型的發展,例如長視頻理解和交錯圖像與文本的長文檔。

- MLLMs應升級以遵循更復雜的指令。例如,生成高質量問答對數據的主流方法仍然是提示閉源的GPT-4V,因為它具有先進的指令遵循能力,而其他模型通常無法實現這一點。

- 技術如M-ICL和M-CoT仍有很大的改進空間。當前對這兩種技術的研究仍然處于初級階段,MLLMs的相關能力較弱。因此,探索其潛在機制和改進方向是很有前景的。

- 開發基于MLLMs的具身代理是一個熱門話題。開發能夠與現實世界互動的代理是有意義的。這類工作需要模型具備關鍵能力,包括感知、推理、規劃和執行。

- 安全問題。與LLMs類似,MLLMs可能易受精心設計的攻擊[177],[207],[208]。換句話說,MLLMs可能會被誤導輸出偏見或不理想的響應。因此,提高模型的安全性將是一個重要課題。

9 結論

在本文中,我們對現有的MLLM文獻進行了綜述,并提供了其主要方向的廣泛視角,包括基本配方和相關擴展。此外,我們強調了當前需要填補的研究空白,并指出了一些有前景的研究方向。希望這篇綜述能為讀者提供清晰的MLLM發展現狀,并激發更多的研究工作。

Yin S, Fu C, Zhao S, et al. A survey on multimodal large language models[J]. arXiv preprint arXiv:2306.13549, 2023.

Shanghai Jiao Tong University ,Amazon Web Services.

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:????https://mp.weixin.qq.com/s/a1slqH2ScZnrFmDFpo0R7A???