多模態大模型最全綜述導讀 原創

多模態大模型最新研究綜述簡單版。

不知道最近微軟出的多模態大模型最全綜述 Multimodal Foundation Models: From Specialists to General-Purpose Assistants 大家有沒有看~

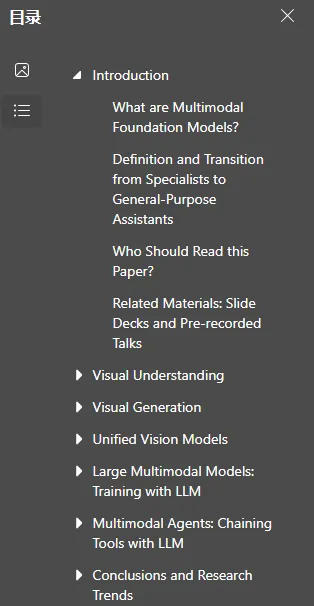

包含5大主題一共119頁,內容又干又多,目前網上找到的中文解讀干貨內容都比較全比較長,很容易迷失其中,一直難以看完。

本期來給大家做一個這篇論文相對簡單的導讀;如果大家有想要著重了解部分或感興趣的內容可以先針對性地看。

下面是一個快捷目錄。

1. 章節分布

2. 具體內容解讀?

章節分布

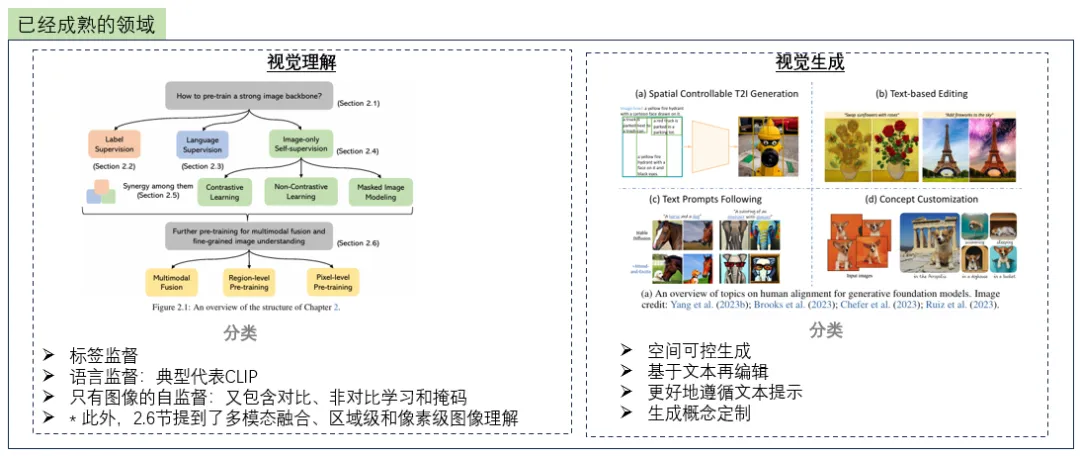

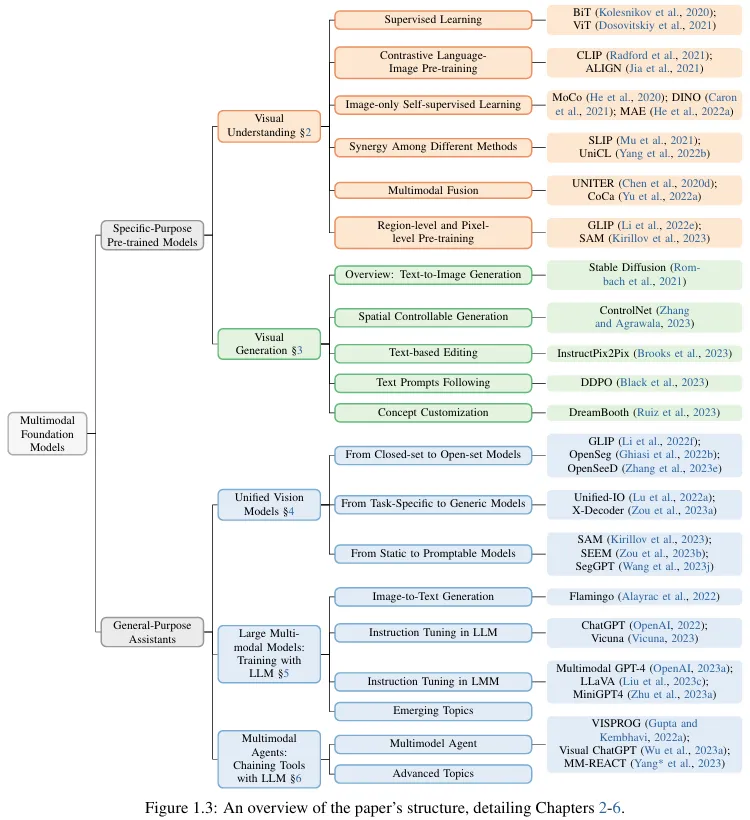

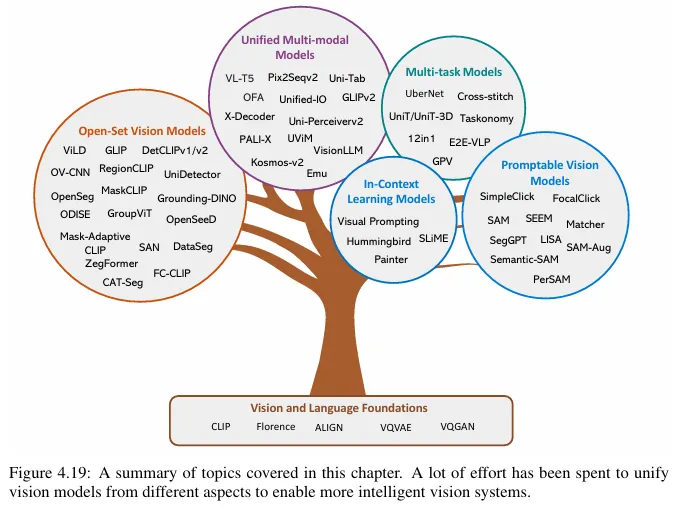

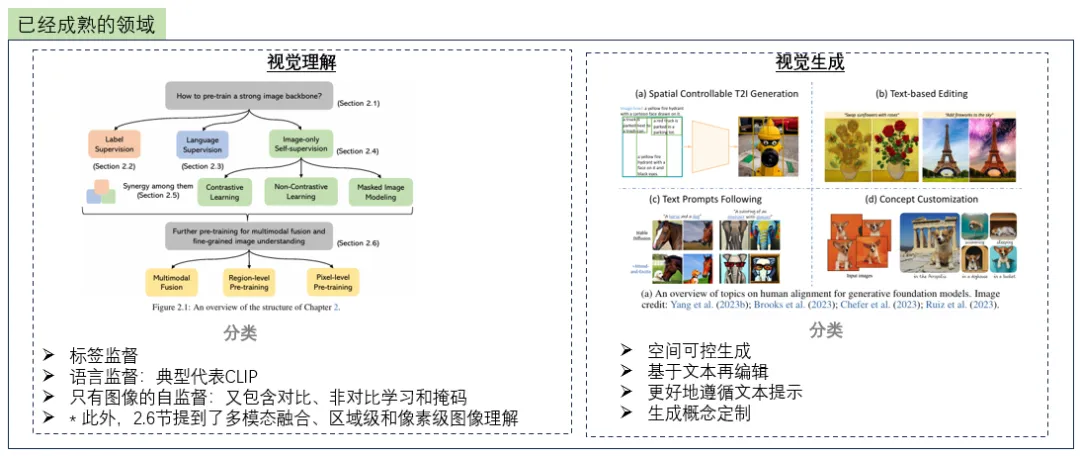

論文從目前已經完善的和還處于最前沿的兩類多模態大模型研究方向出發,全面總結了五個具體研究主題:

- 視覺理解

- 視覺生成

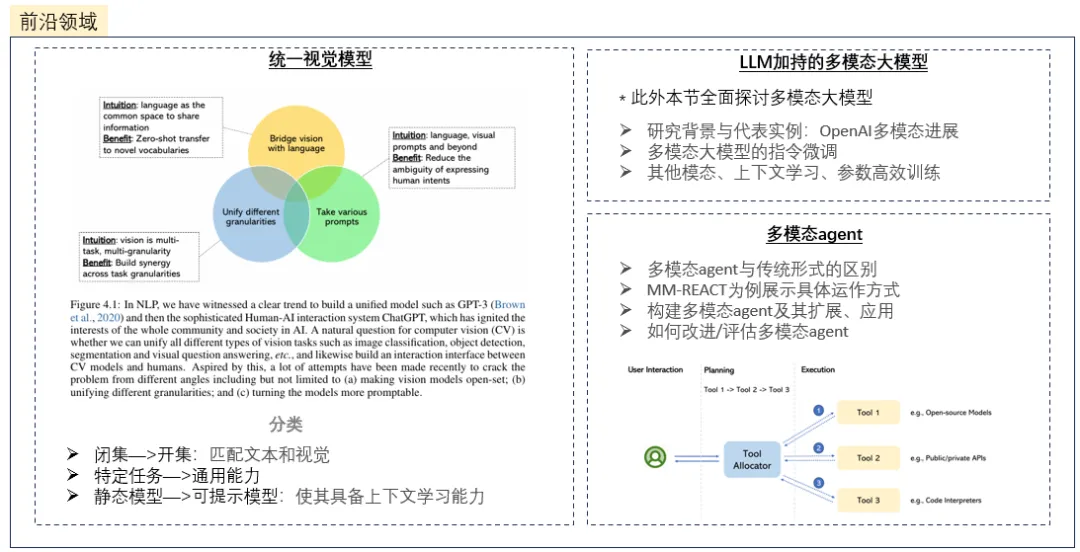

- 統一視覺模型

- LLM加持的多模態大模型

- 多模態agent

這里瓦力畫了一個比較簡單的圖,大致總結一下各個主題的內容,大家可以參考。

具體內容解讀

具體的模型、算法大家都可以針對性地自己了解,這里先給大家總結一些比較關鍵的點:

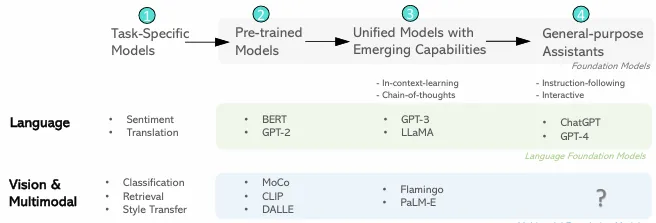

1. 語言或視覺多模態的開發路線

上述四個類別中,第一類是任務特定模型,后面三類屬于基礎模型。

下面以語言為例,聊聊AI的演進趨勢:

- Task-Specific Models:可以對標以前LSTM/RNN時代,需要一個任務訓練一個模型。

- Pre-trained Models:transformer(BERT、GPT)時代,先有預訓練的權重,再繼續適配下游任務進行一次訓練,但還是不同下游任務適配的不一樣權重;這個時代大家站transformer比較多,GPT此類單向注意力的模型一般在生成任務且要求序列生成較穩定的情況下使用。

- Unified Models with Emerging Capabilities開始,GPT3已經展現了一些涌現能力。

- General-purpose Assistant時代:OpenAI堅定地走了GPT路線,并對生成結果進行了對齊,ChatGPT就此誕生了~

2. 多模態中經典的5個問題

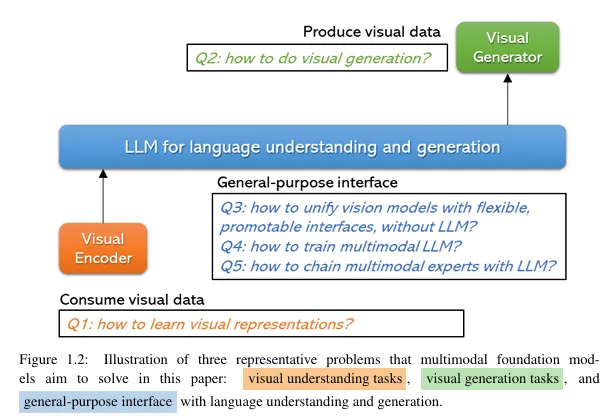

論文中回答了經典的5個問題,也闡述了多模態基礎模型旨在解決的三個代表性問題:視覺理解任務、視覺生成任務和具有語言理解和生成的通用界面。

Q1:如何學習視覺表示?

Q2:如何做視覺生成?

Q3:如何不基于大語言模型訓練一個通用視覺模型?

Q4:如何訓練多模態大語言模型

Q5:如何為大語言模型鏈接一個多模態專家?

下面是論文中各章節及經典的模型推薦,其中橙色的部分,也就是視覺理解主題部分回答了Q1;綠色的部分,視覺生成主題部分回答了Q2;藍色的部分,回答了Q3~Q5。

下面我從文章摘取一些內容簡單回答來上述5個問題,如果大家需要詳細了解的話可以從上圖中對應章節去研讀:

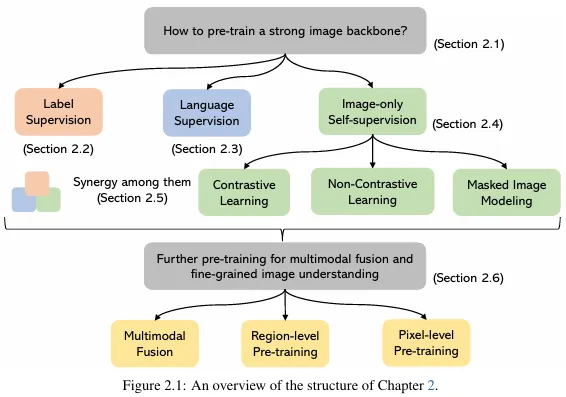

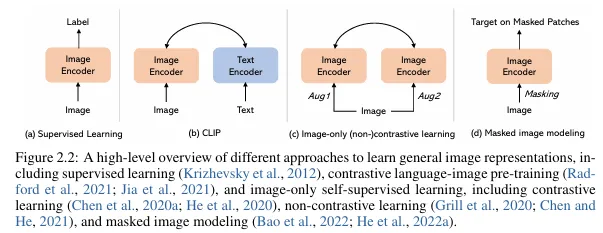

Q1:如何學習視覺表示?

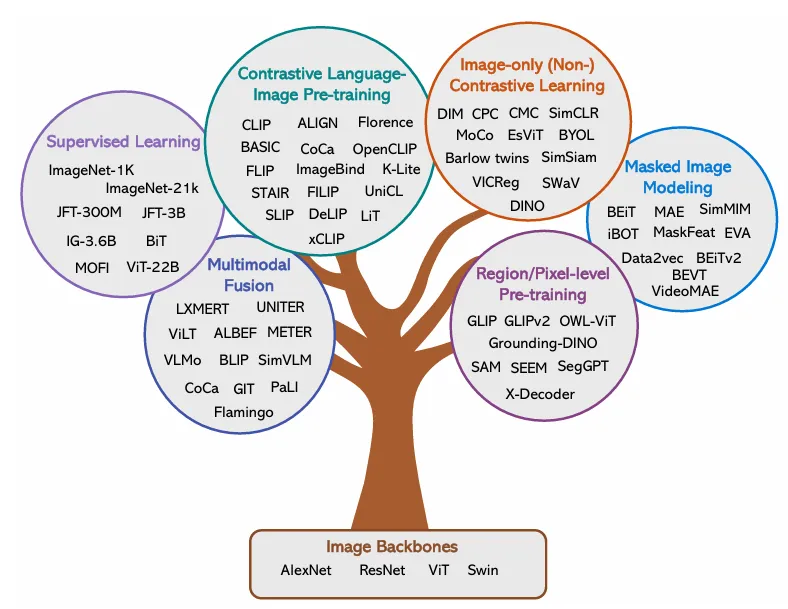

下圖比較清晰的展現了現有的四種方法:

此外,論文中還列出了上述方法的代表模型。

- 監督學習

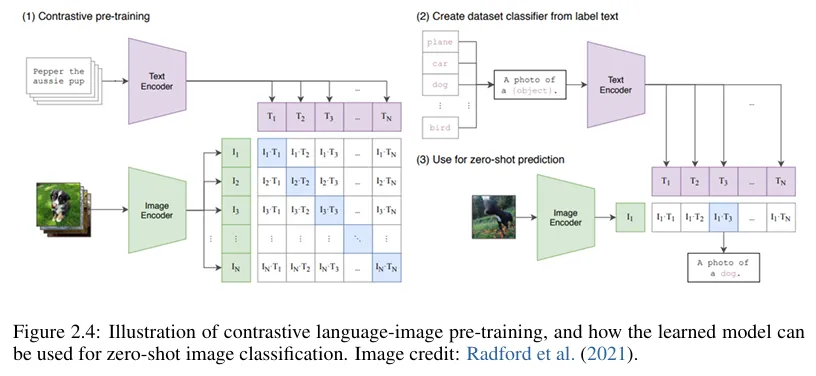

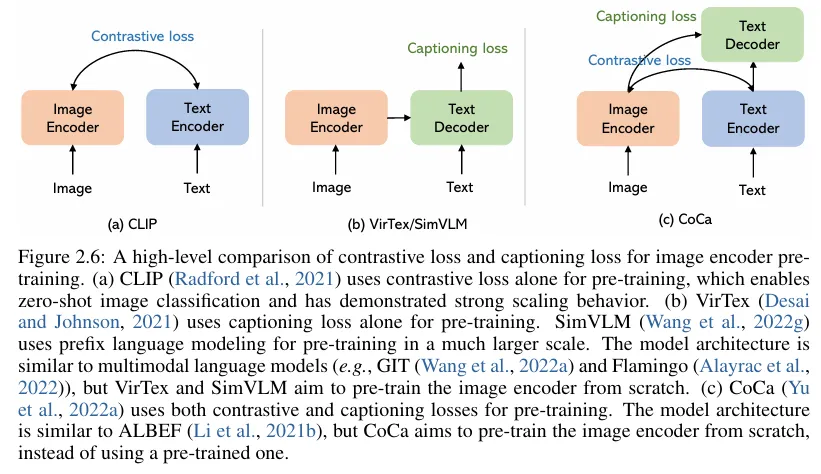

- 對比語言-圖像預訓練

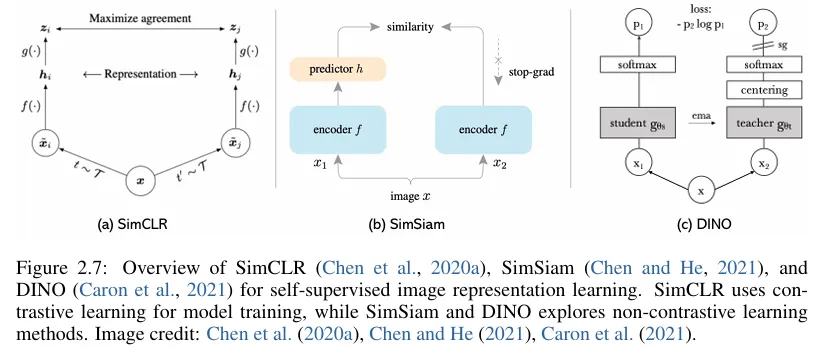

- 純圖像自我監督學習(對比學習、非對比學習)

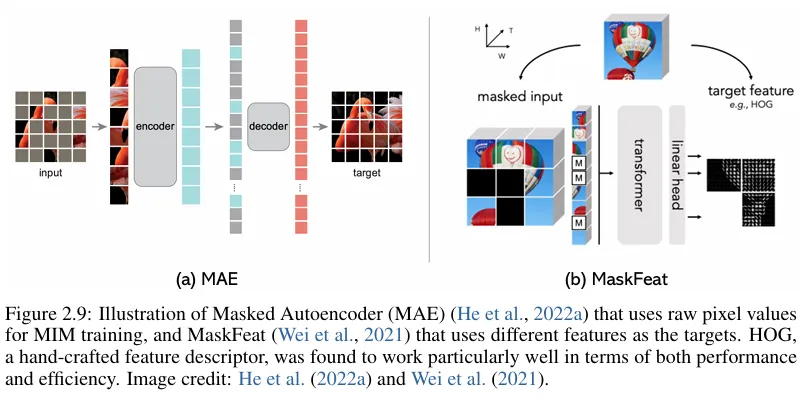

- 掩碼圖像建模

Q2:如何做視覺生成?

現有方法的代表模型。

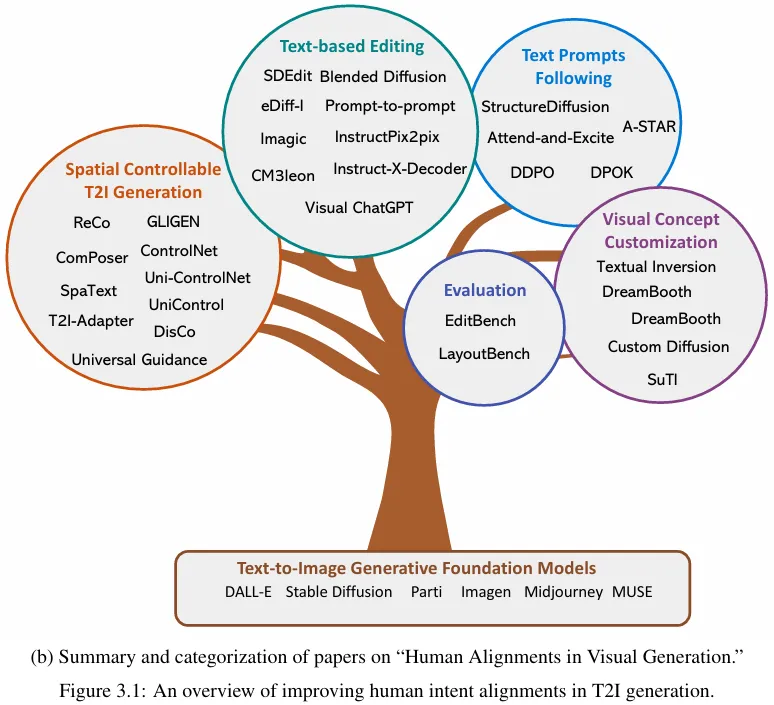

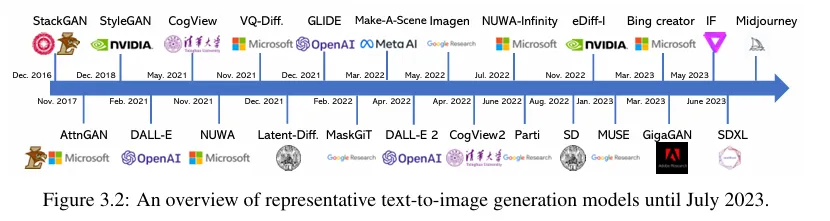

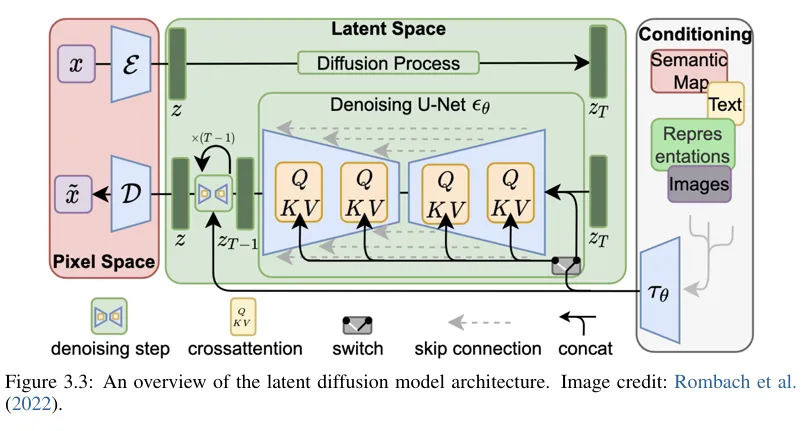

1) 具有代表性的文本到圖像生成模型

2)經典的擴散模型架構

3)未來研究趨勢:統一調優,實現人工對齊

具體又可以分為這三個方向:

- 統一的圖像和文本輸入。

- 調整以對齊為中心的損失和獎勵。

- 多模態內容理解和生成的閉環。

Q3:如何不基于大語言模型訓練一個通用視覺模型?

現有方法的代表模型。

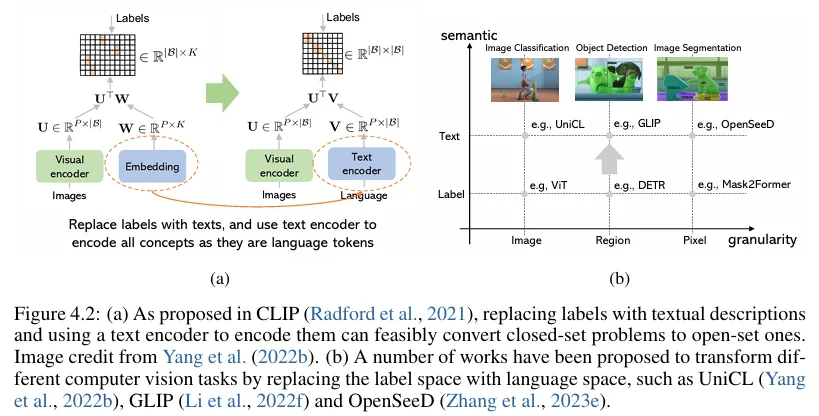

1)從封閉集到開放集

通過引入對比語言-圖像預訓練方法來訓練開放集模型,解決了傳統封閉集模型的局限性。如圖 4.2 (a) 所示,CLIP 不是學習從輸入到標簽的映射,而是使用數億個圖像-文本對學習對齊的視覺語義空間。

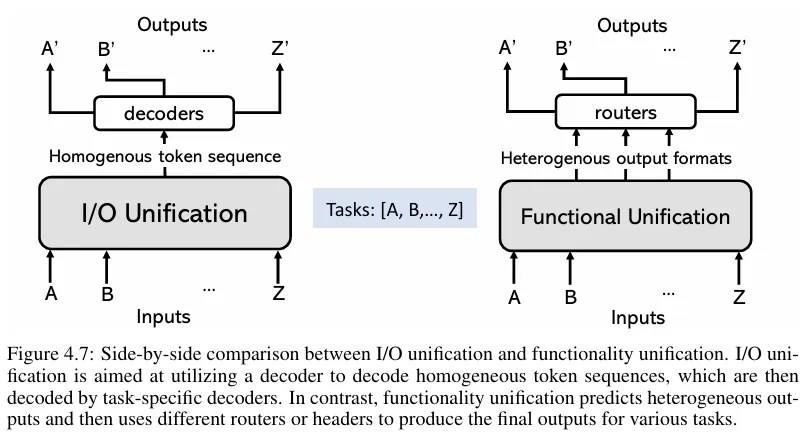

2)從特殊任務到通用

可分為I/O Unification 和Functionality Unification,也就是I/O統一和功能統一。

- I/O統一:使用分詞器將各種任務中使用的不同模式的原始輸入和輸出 (I/O) 分詞化為連貫的序列(視覺或文本)分詞,然后利用統一的序列到序列模型。

- 功能統一:最近許多研究都使用了類似于transformer 的 Encoder-Decoder 架構,需要復雜的模型設計來適應各種任務。

3)從靜態到可提示

這里的研究主要是一些增強靜態視覺模型的能力,目的是為了支持:(i) 多模態提示;(ii) 上下文提示。

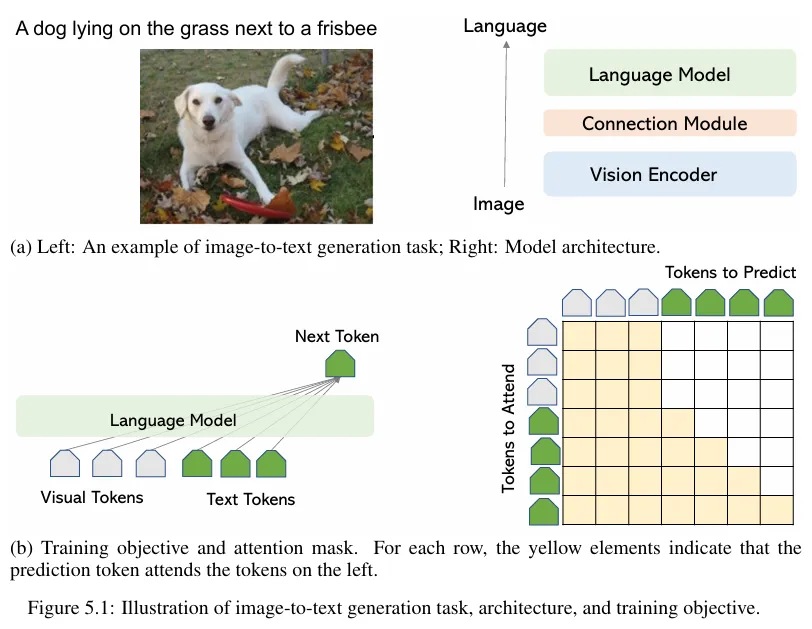

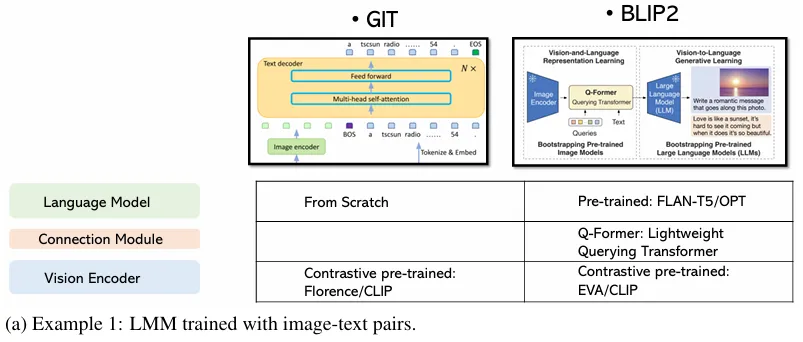

Q4:如何訓練多模態大語言模型?

這里文中舉了兩個例子:

1)LMM 使用圖像-文本成對實例進行訓練

大多數 LMM 都是在大量圖像-文本對上訓練的,其中每個訓練樣本都是一對。

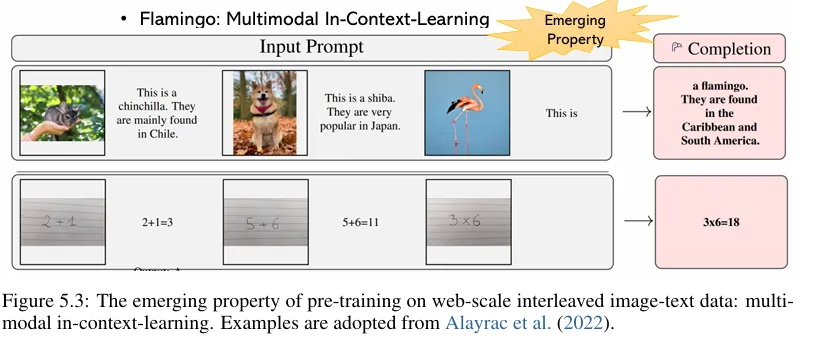

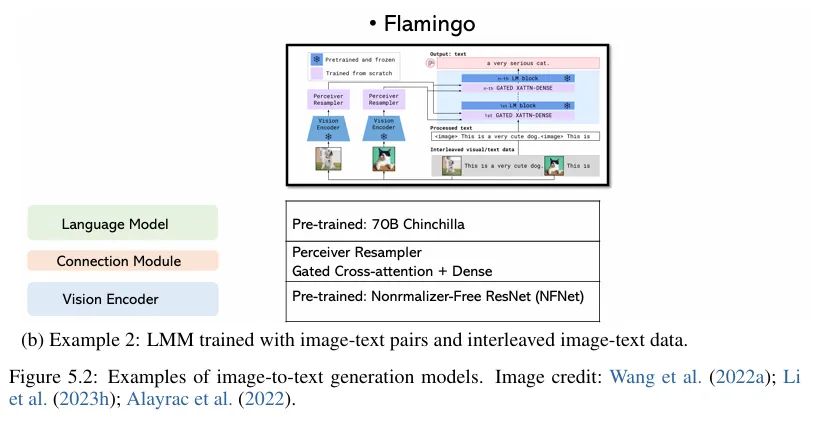

2)使用交錯圖像文本序列實例訓練的 LMM。

論文中以Flamingo為例, Flamingo 使用僅來自 Web 的互補大規模多模態數據的混合進行訓練,而不使用任何用于機器學習目的的注釋數據。訓練完成后,Flamingo可以通過簡單的few-shot learning 直接適應視覺任務,而無需任何額外的任務特定調整。

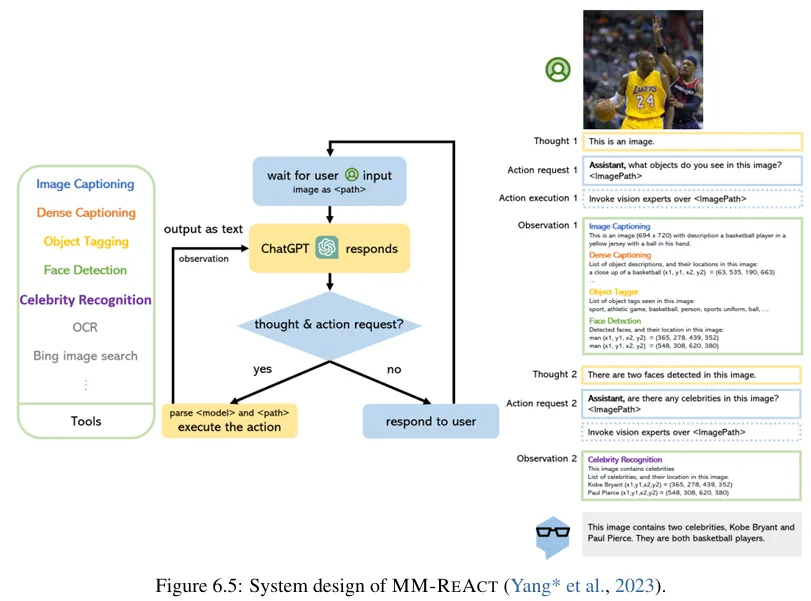

Q5:如何為大語言模型鏈接一個多模態專家?

這里以MM-ReAct為例,其系統范式由 Chat GPT 組成了多模態工具,用于多模態推理和動作。通過使用各種多模態工具增強純語言的 ChatGPT,MM-REACT 支持多模態的輸入和輸出,包括文本、圖像和視頻。

再下面是MM-REAC涌現的多模態推理和動作功能。

那么論文的簡單導讀就是這樣了,如果大家覺得論文過長文本看不進去還可以看論文中1.4節附上的視頻,B站和youtube都有;雖然是英文的,但結合PPT整體看下來是比較容易理解的。

參考文獻:

[2309.10020] Multimodal Foundation Models: From Specialists to General-Purpose Assistants (arxiv.org)

文轉載自公眾號瓦力算法學研所,作者:喜歡瓦力的卷卷

原文鏈接:??https://mp.weixin.qq.com/s/fTiUSPZi8q3qy-Lnt6_EZQ??