AUTODETECT:面向大規模語言模型中自動弱點檢測的統一框架 原創 精華

摘要:盡管大規模語言模型(LLMs)變得越來越強大,但它們仍然表現出顯著但微妙的弱點,如在執行指令或編寫代碼任務中的錯誤。由于這些意外錯誤在實際部署中可能導致嚴重后果,系統性地研究LLMs的局限性至關重要。傳統的基準測試方法無法徹底 pinpoint 具體的模型缺陷,而手動檢查則成本高且不可擴展。在本文中,我們介紹了一個統一框架,AUTODETECT,以自動揭示LLMs在各種任務中的弱點。受教育評估過程(衡量學生學習成果)的啟發,AUTODETECT 由三個LLM驅動的代理組成:Examiner、Questioner 和 Assessor。這三個代理之間的協作旨在實現全面且深入的弱點識別。我們的框架在揭示缺陷方面表現出顯著成功,識別成功率超過30%,適用于諸如ChatGPT和Claude等知名模型。更重要的是,這些識別出的弱點可以指導具體的模型改進,比起自我指令(Self-Instruct)等非針對性的數據增強方法更為有效。我們的方法已經顯著提升了流行LLMs的性能,包括Llama系列和Mistral-7b,使它們在多個基準測試中的表現提升超過10%。代碼和數據公開可在 ??https://github.com/thu-coai/AutoDetect ??獲得。

1.引言

大規模語言模型(LLMs)的發展令人矚目:這些模型在多種任務中表現出色(Brown et al., 2020;Zeng et al., 2022;Chowdhery et al., 2023;Touvron et al., 2023a;GLM et al., 2024)。經過精細的校準(Ouyang et al., 2022;Cheng et al., 2023;Ji et al., 2024a),LLMs在實際應用中可以達到人類水平的表現(OpenAI, 2022;Anthropic, 2023)。然而,這些模型仍然容易出現意外錯誤(Ouyang et al., 2022;Bubeck et al., 2023)。例如,盡管LLMs擅長復雜的算法問題,它們可能在基礎的編程概念上表現不佳(§5.1)。這些意外錯誤可能導致系統故障和重大安全問題(Ruan et al., 2023)。因此,系統性地識別和解決這些弱點對于提升LLMs的性能和可信度至關重要。

然而,揭示這些弱點的過程具有挑戰性。人工檢查依賴于人類專家,過于勞累且成本高昂,難以擴展。自動化方法通常采用靜態(Cobbe et al., 2021;Srivastava et al., 2022;Liu et al., 2023)和動態(Bai et al., 2024;Wang et al., 2024)基準測試。然而,基準測試主要用于評估和排名一系列模型,而不是識別個體模型固有的弱點。更具體地說,基準測試設計為模型無關,不依賴于特定模型的響應,因此難以識別個體化弱點。此外,基準測試更新不頻繁,存在數據泄露(Yang et al., 2023b;Wei et al., 2023)和排行榜泛濫(Guo et al., 2023)的問題,這進一步限制了它們在全面評估模型特定弱點方面的實用性。

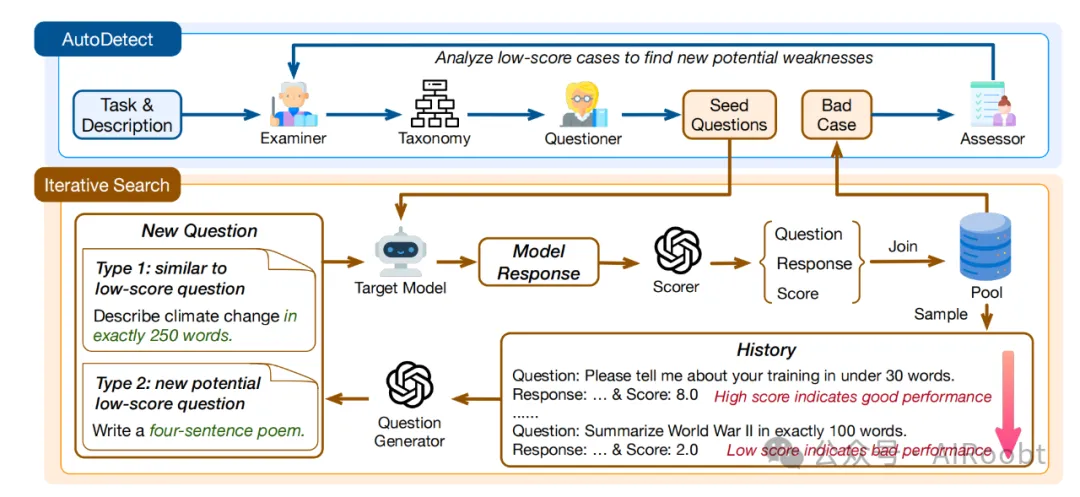

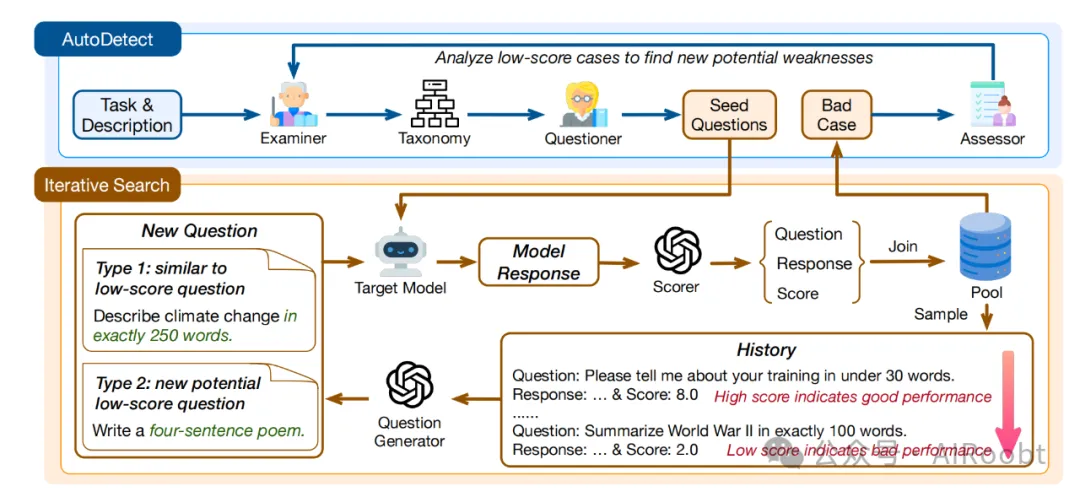

在本文中,我們介紹了一個開創性的統一框架,AUTODETECT,旨在系統且自動地揭示LLMs在各種任務中的潛在弱點。在我們的框架中,如圖2所示,我們采用類似于教育評估系統的方法,包括創建全面的問題來評估學生,并審查他們的回答以識別個體化的弱點。AUTODETECT涉及開發一個整體測試系統來評估和挑戰學生的能力。此外,該系統不是靜態的,而是不斷優化和適應特定模型的表現,從而提供定制且有效的弱點發現。具體來說,我們的框架整合了由LLM驅動的三個專業角色:

- Examiner 負責建立一個包含多樣測試點的綜合分類體系,并根據目標模型的表現動態優化框架,以提供精細且定制的弱點識別框架。

- Questioner 負責根據每個測試點創建具有挑戰性的問題。通過迭代探索,該代理不斷假設模型的弱點,并在新缺陷出現時有效地適應問題的生成。

- Assessor 需要分析目標模型的響應,并推測潛在問題以納入測試系統,這是定制評估的關鍵。

圖 2:我們的框架包括兩個循環,循環由Examiner、Questioner和Assessor組成,提供了全面且定制的測試框架。同時,迭代搜索使得問題難度能夠針對目標模型進行調整,有效地識別弱點。

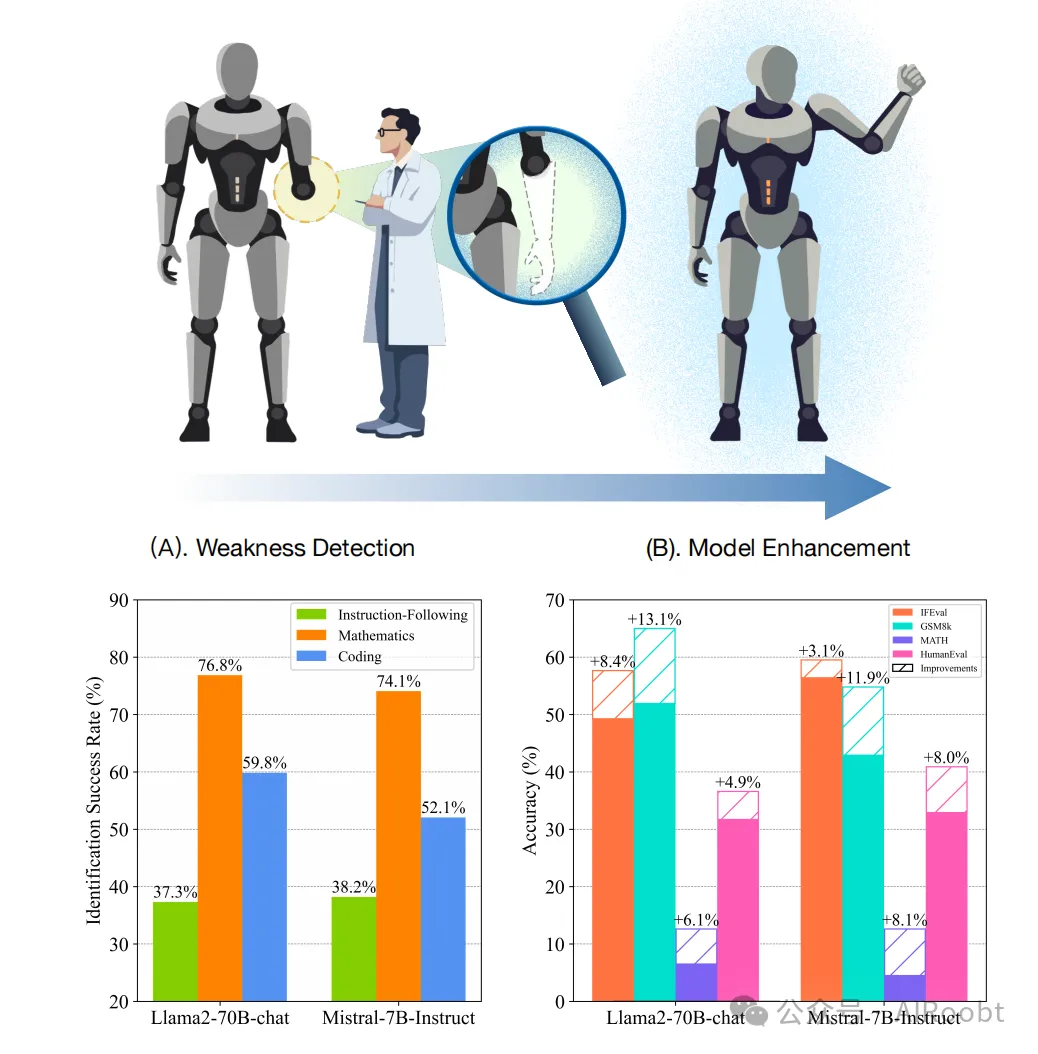

Examiner、Questioner 和 Assessor 之間的合作促進了廣泛且有效的評估過程。通過從這些弱點中學習,AUTODETECT 進一步促進了模型的改進(圖1)。

圖 1:有效的弱點發現可以很好地指導模型增強。AUTODETECT在指令遵循、數學和編程任務中的識別成功率很高(A)。此外,利用這些數據,我們可以進一步改進LLMs(B)。

通過廣泛的實驗,我們證明了AUTODETECT能夠在多種任務中有效地暴露弱點,包括指令遵循、數學推理和編程,在多個強大的LLMs中實現了超過50%的識別成功率,甚至在GPT-3.5-turbo 和 Claude-3-sonnet中也超過了30%。此外,我們的弱點識別過程可以有效地指導模型增強。值得注意的是,通過整合約1,000個來自AUTODETECT的樣本來微調流行的開源模型如Mistral和Llama系列,我們在多個基準測試中實現了超過10%的改進,展示了從定向弱點檢測中學習的好處。

我們的貢獻可以總結如下:

- 據我們所知,我們是首次在多個通用任務(包括指令遵循、數學推理和編程)上系統地探索LLMs的弱點識別,提供了一個自動弱點檢測的統一框架。

- AUTODETECT 展現了卓越的適應性和有效性,在多個模型和任務中揭示缺陷的成功率超過50%。

- AUTODETECT 促進了顯著的模型改進。利用弱點檢測過程中的數據,我們能夠有效地增強模型性能,在多個任務上取得超過10%的改進。

2.相關工作

2.1 評估基準

許多基準(Hendrycks et al., 2020;Cobbe et al., 2021;Chen et al., 2021;Zhou et al., 2023;Liu et al., 2023)被設計用于評估LLMs的各種能力,以及一些動態基準(Zhu et al., 2023;Bai et al., 2024;Wang et al., 2024)。然而,基準測試的基本目的是比較一系列模型并準確排名,而不是識別特定模型的缺陷。因此,它們被設計為與模型無關,無法提供對特定模型缺陷的全面發現。此外,靜態基準測試通常面臨數據泄露(Yang et al., 2023b;Wei et al., 2023)和排行榜泛濫(Guo et al., 2023)的問題,而動態基準測試通常在覆蓋范圍上存在問題,構建這些動態基準測試的方法通常缺乏普遍性。這些限制表明,僅依賴基準測試很難徹底發現模型缺陷,從而無法為進一步改進提供實用的指導。

2.2 紅隊測試

由于上述自動化方法的限制,有效揭示LLMs內在弱點的一個重要方法是人工檢查,這類似于紅隊測試,這是安全領域(Deng et al., 2023;Ji et al., 2023;Sun et al., 2023;Ji et al., 2024b)中識別AI系統安全問題的重要策略。早期研究主要依賴人工努力創建紅隊測試查詢(Dinan et al., 2019;Xu et al., 2020)。然而,人工紅隊測試因其高成本和固有的多樣性不足而受到限制,難以擴展。最近,已經提出并廣泛采用使用語言模型進行自動化紅隊攻擊(Perez et al., 2022;Ganguli et al., 2022;Zhang et al., 2022;Chao et al., 2023)。然而,將自動弱點檢測應用于通用任務仍然研究不足。在這項工作中,我們介紹了一個統一的框架,用于識別超越安全問題的模型缺陷。我們已成功在包括指令遵循、數學推理和編程在內的各種任務中實現了該框架,展示了其令人印象深刻的有效性和廣泛適用性。

3.方法

3.1 問題定義

我們的主要目標是開發一個統一的框架,旨在自動且系統地識別LLMs在通用任務中的潛在弱點。對于給定的任務及其描述(記作(T, D)),弱點識別過程可以表示為:

W =AUTODETECT(T, D)

其中,W 代表目標模型未能準確解決的問題集。我們將這些失敗視為模型的弱點,由強大的LLM評審員進行評估。

3.2 AUTODETECT 框架

我們方法的整體框架如圖2所示。AUTODETECT旨在通過專門的循環搜索策略全面評估語言模型的能力,包含Examiner、Questioner和Assessor三個不同角色。每個角色都至關重要,利用LLM驅動的代理的優勢,以協作的方式探索并暴露目標模型的弱點。

圖 2:我們的框架包括兩個循環,循環由Examiner、Questioner和Assessor組成,提供了全面且定制的測試框架。同時,迭代搜索使得問題難度能夠針對目標模型進行調整,有效地識別弱點。

(注釋:

在AUTODETECT框架中,首先由Examiner接收任務及其描述,然后創建分類體系。Questioner根據分類體系生成初始問題集,并通過迭代搜索過程創建新問題。這些問題會被提交給目標模型進行回答,模型的回答會被評分器評估并打分。Assessor則會分析低分回答以找到新的潛在弱點,從而優化分類體系。

AUTODETECT框架的兩個主要循環:總體循環和迭代搜索循環。

總體循環

1. Task & Description(任務和描述):

- 框架的起點是接收具體的任務及其詳細描述。這些任務可以是指令遵循、數學推理或編程等。

2. Examiner(考官):

- Examiner的任務是基于接收到的任務和描述,創建一個詳細的分類體系(Taxonomy)。該分類體系將任務分解成可管理的類別,每個類別包含多個知識點,這些知識點指導后續的評估過程。

3. Taxonomy(分類體系):

- 分類體系是一種結構化的分解方式,將復雜的任務組織成多個具體的、可評估的知識點。這是全面評估的基礎。

4. Questioner(提問者):

- Questioner根據分類體系生成初始問題集(Seed Questions),這些問題覆蓋了所有的知識點。隨后,Questioner會開始一個迭代搜索過程,提出新問題以探索模型的弱點。

5. Seed Questions(初始問題):

- 初始問題集是根據分類體系生成的,目的是全面覆蓋所有知識點,作為進一步探索的基礎。

6. Assessor(評估者):

- Assessor負責分析目標模型對問題的回答,特別是低分回答(Bad Case),以發現新的潛在弱點。這些新弱點會反饋給Examiner,從而優化分類體系,使其更具針對性和有效性。

————————

在迭代搜索過程中,新問題會根據歷史低分問題和新的潛在低分問題生成。評分器會評估目標模型的回答,并記錄在歷史記錄中,其中高分表示模型表現良好,低分表示模型表現不佳。通過不斷地將這些問題和回答加入到問題池中,并從中抽取樣本進行進一步的測試,框架能夠有效地識別并針對目標模型的弱點進行優化和改進。

迭代搜索部分是AUTODETECT框架中的核心組件之一,負責動態生成和評估問題,以系統地發現和暴露目標模型的弱點。

1. New Question(新問題):

- Type 1: Similar to Low-Score Question(類似于低分問題的變種):

- 這種問題類型是基于先前低分回答的問題變種。通過變換和調整問題的細節,生成新的類似問題。例如,先前低分問題可能是“用100字描述氣候變化”,新問題可能變為“用250字準確描述氣候變化”。

- Type 2: New Potential Low-Score Question(新的潛在低分問題):

- 這種問題類型是完全新生成的問題,可能涉及新的領域或知識點。例如,新問題可能是“寫一首四句的詩”。這類問題旨在探索模型未曾評估的潛在弱點。

2. Target Model(目標模型):

- 生成的新問題被提交給目標模型,模型需要對此進行回答。

3. Model Response(模型回答):

- 目標模型生成的回答被記錄下來,并送交評分器進行評估。

4. Scorer(評分器):

- 評分器對目標模型的回答進行評估并打分。評分器使用參考答案(通常由GPT-4生成)作為基準,確保評估的可靠性。

5. Score(評分):

- 評分器為每個回答給出一個分數。得分的高低表示模型在該問題上的表現,低分表示模型在這個問題上有弱點。

6. History(歷史記錄):

- 所有問題及其對應的回答和評分都會被記錄在歷史記錄中。歷史記錄包含以下信息:

- 問題:提出的問題,例如“請在30個字以內介紹你的訓練背景”。

- 回答:模型的回答,例如“...得分: 8.0”(高分表示表現良好)。

- 評分:評分器給出的分數,例如“...得分: 2.0”(低分表示表現不佳)。

- 高分表示模型在該問題上表現良好,而低分表示模型在該問題上有弱點。

7. Pool(問題池):

- 所有問題及其回答被加入到問題池中,問題池不斷擴展。問題池的作用是為未來的測試提供一個豐富的問題庫,以便進行廣泛和深入的評估。

8. Iterative Process(迭代過程):

- 通過從問題池中抽取樣本,生成新的問題,繼續進行測試和評估。這是一個循環過程,不斷生成新問題,評估模型回答,記錄結果,并發現新弱點。這個過程使得測試框架能夠不斷更新和優化,適應模型的變化。

迭代搜索的核心優勢

- 動態適應:通過生成新的類似低分問題和完全新問題,迭代搜索能夠動態適應模型的弱點和變化,確保測試的深度和廣度。

- 持續改進:迭代搜索過程是一個持續改進的循環,通過不斷評估和優化,逐步提高模型的性能。

- 廣泛覆蓋:問題池中的豐富問題庫確保了測試的廣泛覆蓋,能夠全面評估模型在不同知識點和任務上的表現。

通過上述詳細步驟,迭代搜索部分確保了AUTODETECT框架能夠系統地、自動地發現和改進目標模型的弱點,從而提升模型的整體性能和可靠性。

整個過程通過Examiner、Questioner和Assessor的合作,實現了一個持續改進的循環,使得測試框架不僅全面且能適應不同LLMs的不斷變化的能力。)

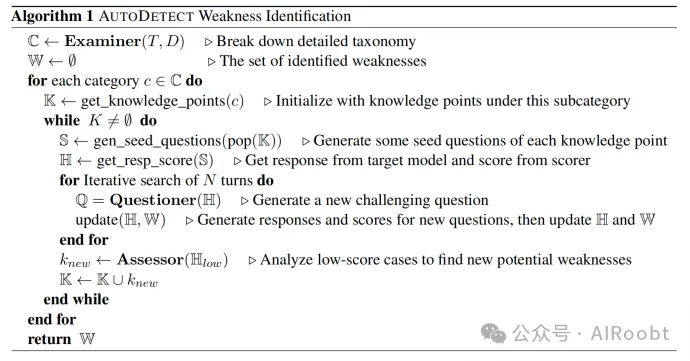

如算法1所示,過程從Examiner開始,其任務是根據給定任務及其描述(T, D)開發詳細的分類體系C。該分類體系是關鍵,因為它將任務組織成可管理的、專注的類別(c1, ..., cn),每個類別包含若干知識點(k1, ..., km),指導后續評估。結構化的分解對于全面評估至關重要,表示為:

C = Examiner(T, D)

在分類體系創建之后,Questioner 接手,生成一組初始問題S并啟動迭代搜索過程,以在每個知識點上提出探測弱點的問題。迭代過程允許自適應的提問策略,逐漸增加復雜性,確保測試深度適應每個模型的能力。這可以形式化為:

Q = Questioner(H)

這里,H表示搜索歷史,起始于S,促進模型弱點的動態探索。評估過程中,Assessor 的角色對于精煉評估過程至關重要,使其全面且模型特定。隨著評估的進行,Assessor 批判性地分析目標模型表現不佳的實例(由低分表示),識別新的潛在弱點knew,表示為:

knew = Assessor(Hlow)

這些見解導致Examiner 動態精煉分類體系,確保我們的框架保持相關性和有效性,能夠發現新的缺陷。Examiner、Questioner和Assessor之間的循環互動實現了持續改進的循環,使我們的測試框架不僅全面且敏感于不同LLMs的演變能力。任務和提示的詳細描述在附錄B和附錄C中提供。

(如果還沒看懂,通過一個例子來解釋:

AUTODETECT框架的原理可以簡單地理解為一個智能的自動檢測系統,它能夠發現和修復大規模語言模型(LLMs)中的弱點。這里用一個簡單的類比來解釋它的工作過程:

1. 任務描述

就像你給一個學生布置一份家庭作業,任務可以是寫一篇文章、解一道數學題或者寫一個程序。

2. 三個智能角色

AUTODETECT框架中有三個主要角色,它們像三個協作的老師一樣,分別負責不同的任務:

- Examiner(考官):就像一位老師,他會把任務分成幾個小部分,每個部分包含一些關鍵知識點。這樣可以更容易地找到學生(模型)可能會犯錯的地方。

- Questioner(提問者):這位老師負責給學生出題,他會根據這些知識點設計一系列問題,先出一些基礎題,然后根據學生的表現逐漸加大難度。

- Assessor(評估者):這位老師負責批改作業,他會仔細檢查學生的回答,找出錯誤并記錄下來,尤其是那些得分較低的問題。

3. 循環改進

整個過程是一個不斷循環的系統:

1. 出題和回答:Questioner先出一套問題(初始問題集),學生(模型)回答這些問題。

2. 評估和記錄:Assessor評估這些回答,找出哪些問題回答得不好,并記錄下來。

3. 調整和優化:Examiner根據這些記錄,調整問題的類型和難度,Questioner再根據新的調整出題,繼續測試學生的能力。

4. 迭代搜索

這個循環會反復進行,每次都根據之前的結果調整問題:

- 發現新問題:如果學生在某些問題上得分低,Questioner會設計類似的新問題或提出新的挑戰。

- 記錄和分析:Assessor繼續評估這些新問題的回答,進一步找出學生的弱點。

- 持續改進:這個過程反復進行,直到找到并解決學生的所有弱點。

5. 模型增強

通過這個循環過程,AUTODETECT不僅能發現模型的弱點,還能用這些問題和答案對模型進行微調,從而提高模型的整體表現。

總結

AUTODETECT就像是一個智能的、不斷改進的老師團隊,通過反復出題、評估和調整,系統地發現并修復大規模語言模型中的弱點,讓模型變得越來越聰明、越來越可靠。)

3.3 迭代搜索

隨著三個角色之間的合作保證了我們框架的覆蓋范圍和模型特異性,另一個關鍵問題是如何有效識別目標模型表現不佳的問題。因此,我們利用LLMs(Yang et al., 2023a;Ke et al., 2023;Zheng et al., 2024)的強大探索和評估能力,開發了一個迭代搜索過程。具體而言,我們首先為每個知識點生成五個問題,以創建一個初始集合。使用基于參考的評分方法(Zheng et al., 2024)評估目標模型在該集合上的表現,以確保可靠性,其中參考答案由GPT-4提供。隨后,我們根據得分對歷史樣本進行排名,得分較低的表示表現較差,以生成可能暴露模型缺陷的新問題。然后我們讓目標模型生成對所提出問題的回答并評分,將結果添加到我們的歷史集合中。通過這個迭代搜索過程,我們可以有效識別低得分問題,定位特定知識點上目標模型的具體弱點。

3.4 模型增強

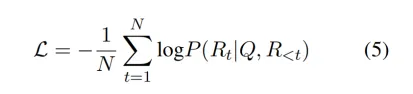

發現弱點的最終目標是幫助模型改進。為了驗證所識別的弱點是重要的并且能夠貢獻于模型增強,我們進一步使用從弱點檢測過程中獲得的問題和參考答案對目標模型進行微調。形式上,損失函數表示為:

這里,Q表示從搜索中得出的問題,R表示由GPT-4生成的參考答案,N表示R的長度。

4.實驗

為了全面展示AUTODETECT的卓越性能,我們在多種任務上進行了廣泛的實驗:指令遵循、數學和編程,包括弱點檢測(§4.1)、模型增強(§4.2)、與基線方法的比較(§4.3)和迭代弱點恢復(§4.4)。實現細節見附錄D。

4.1 弱點檢測

我們研究了三種不同的任務——指令遵循、數學和編程——以展示AUTODETECT的泛化能力。指令遵循任務集中在為模型提供特定的約束,如格式和內容。數學任務側重于高中水平的問題,而編程任務側重于Python,以確保由GPT-4生成問題的正確性。

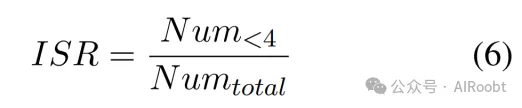

評估指標

在迭代搜索過程中,我們采用MT-bench(Zheng et al., 2024)中的評分提示,其與人類注釋者的協議率達到85%。在我們的方法中,如果目標模型的回答得分在十分制中不超過三分,則表示回答錯誤。此外,我們還要求LLM在回答錯誤時不評分超過三分。當判斷模型回答的正確性時,我們發現與人類注釋者的協議率超過88%(表2)。利用這一點,我們定義識別成功率(ISR)為:

其中,Num<4表示得分低于四分的回答數量,Numtotal表示進行的評估總數。

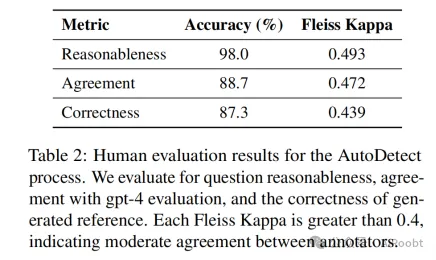

人工評估

為了進一步驗證AUTODETECT的有效性,我們進行了人工評估。我們從所有LLMs中抽取了150個樣本,每個任務50個。我們雇用了三名注釋者來評估以下方面:

- 合理性:判斷生成問題的邏輯連貫性。

- 一致性:確定是否同意使用GPT-4評分獲得的標簽,其中不超過三分表示錯誤。

- 正確性:評估參考答案的正確性。

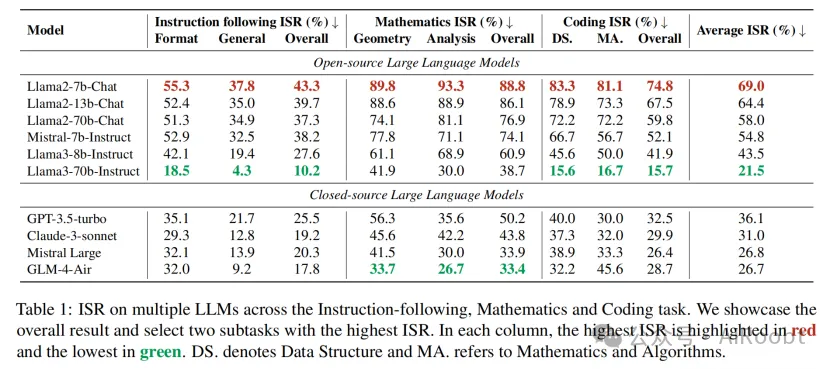

結果(表2)顯示,幾乎所有由AUTODETECT生成的問題都被認為是合理的,超過87%的參考答案是正確的。此外,與基于GPT-4評分獲得的標簽的一致性很高(88.7%)。

結果

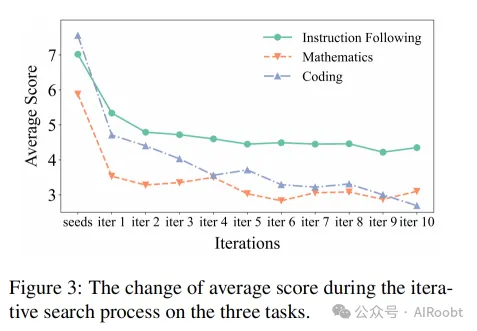

如表1所示,我們在多個模型上進行了缺陷探索,并在各種任務中取得了令人印象深刻的ISR,展示了AUTODETECT的有效性。有趣的是,平均得分和ISR與我們對模型能力的理解很好地一致,顯示了我們的方法作為動態基準的潛力。如圖3所示,我們展示了迭代搜索過程中的平均得分。得分明顯下降的趨勢突顯了迭代方法在發現模型弱點中的重要作用。

4.2 模型增強

為了驗證所識別的缺陷具有意義并促進模型增強,我們使用在AUTODETECT過程中獲得的數據對模型進行微調,并在流行的基準測試上進行評估。重要的是,我們不使用任何測試集中的數據。

基礎模型 Llama系列模型(Touvron et al., 2023b;MetaAI, 2024),包括Llama2-chat(參數為7b、13b和70b)和Llama3-Instruct,是最流行的模型之一。Mistral-7b-Instruct(Jiang et al., 2023)作為其規模內性能最佳的模型之一而脫穎而出。

評估基準 在我們的工作中,我們使用IFEval數據集(Zhou et al., 2023)評估指令遵循能力,該數據集包含541個可驗證的指令。對于數學,我們選擇了最流行的基準測試GSM8k(Cobbe et al., 2021)和MATH(Hendrycks et al., 2021)。在編程任務中,我們使用廣泛使用的HumanEval(Chen et al., 2021)進行評估,其中包括164個由人類專家精心設計的測試用例。

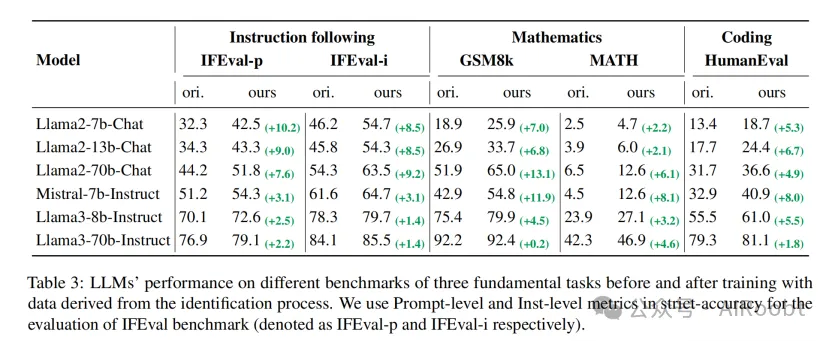

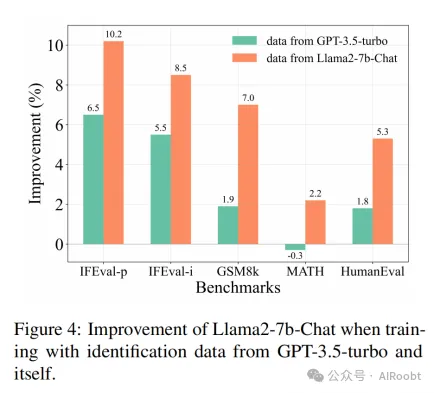

結果 如表3所示,AUTODETECT過程中的數據使我們能夠顯著提升模型性能。我們在多個模型和任務中取得了顯著的改進。此外,對于不同規模的Llama2模型,在各測試集上平均超過6%的性能提升,確認了我們的方法在模型擴展時仍然有效。此外,我們還研究了使用其他模型的評估數據來提高llama2-chat-7b模型性能的影響。如圖4所示,使用目標評估數據的效果明顯優于使用gpt-3.5-turbo。這表明,目標評估可以暴露模型的特定弱點,解決這些弱點可以顯著提高模型性能。

4.3 與基線方法的比較

基線方法 Self-Instruct(Wang et al., 2023)是一種廣泛使用的數據增強方法;OPRO(Yang et al., 2023a)應用了LLMs的迭代搜索優化;PAIR(Chao et al., 2023)是安全領域一種流行的自動化越獄攻擊方法,我們將其轉用于我們的任務。

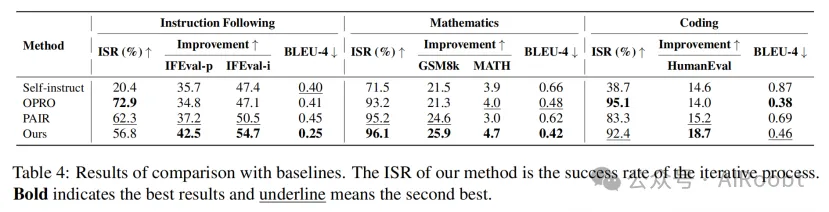

結果 如表4和附錄E所示,與基線方法相比,AUTODETECT在識別成功率和多樣性方面表現出色。Self-Instruct表現出較低的ISR和有限的多樣性。同時,OPRO和PAIR專注于重復利用特定弱點,導致問題分布不平衡。雖然它們可以實現較高的ISR,但無法在不同類別中提供有意義的評估,限制了全面弱點檢測的實用性。此外,PAIR的成本是其他方法的三倍。此外,考慮到改進效果,AUTODETECT顯著優于其他方法,這表明AUTODETECT可以全面發現各種弱點,并為模型增強提供更多指導。

4.4 迭代弱點恢復

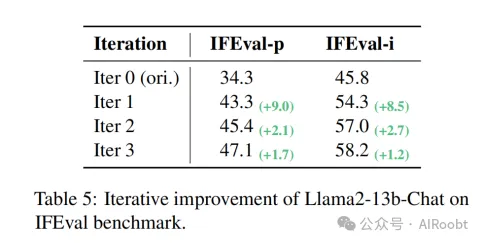

由于我們的框架可以識別并幫助解決LLMs的弱點,自然而然地提出了一個問題:我們是否可以通過AUTODETECT迭代地提高模型性能?因此,我們在指令遵循任務中對llama2-13b-chat進行了實驗。如表5所示,我們觀察到AUTODETECT在三輪評估中能夠持續改進模型。此外,每次迭代都帶來了顯著的改進,展示了我們方法的顯著可擴展性。

5.討論

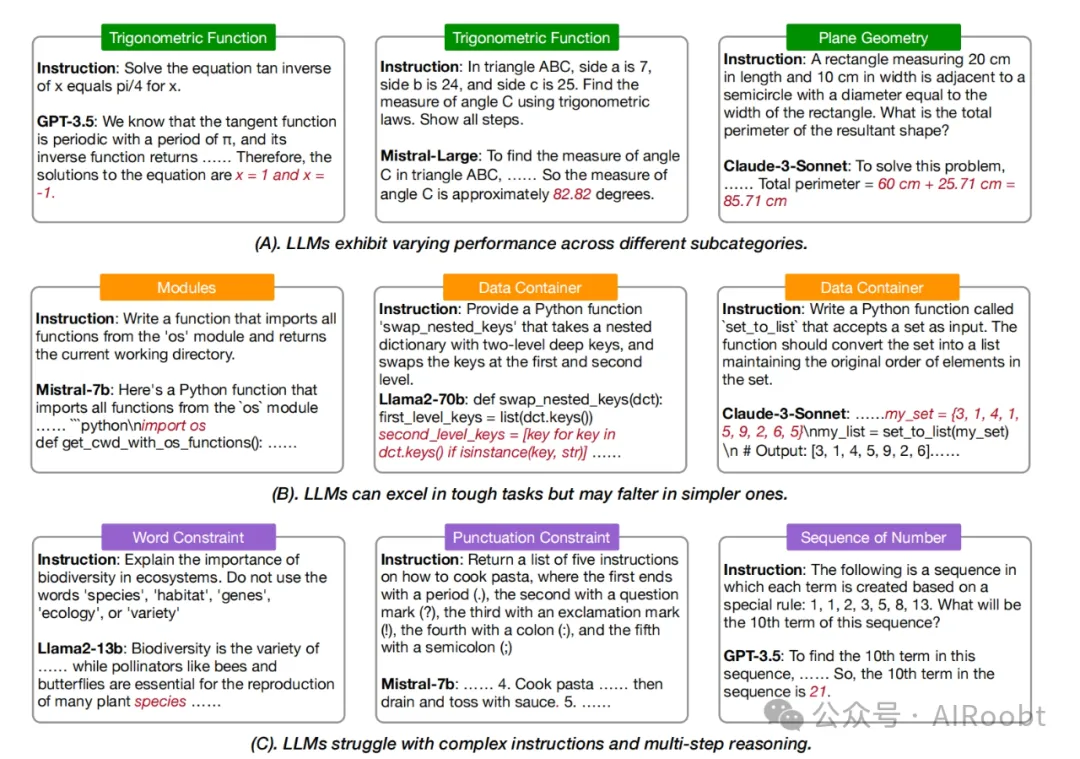

通過AUTODETECT,我們系統地識別了各種模型的潛在弱點。我們的全面分析揭示了一些顯著的發現,包括LLMs的局限性(§5.1,見圖5)和AUTODETECT的優勢(§5.2,見圖6),這些發現可能有助于進一步研究。

(注釋:大型語言模型(LLMs)在不同子類別任務中的表現,分為三個部分:(A) LLMs在不同子類別中的表現各異,(B) LLMs在困難任務中表現優異,但在簡單任務中可能表現不佳,(C) LLMs在處理復雜指令和多步推理時存在困難。

(A) LLMs在不同子類別中的表現各異

1. 三角函數

- 任務描述:求解$x$的方程$\tan(x) = \pi/4$的逆函數。

- GPT-3.5的回答:知道正切函數的周期為$\pi$,逆函數的解為$x = 1$和$x = -1$。

2. 三角函數

- 任務描述:在ABC三角形中,邊$a = 7$,邊$b = 24$,邊$c = 25$。用三角函數求角$C$,并展示所有步驟。

- Mistral-Large的回答:角$C$約為82.82度。

3. 平面幾何

- 任務描述:一個長20 cm、寬10 cm的矩形旁邊有一個直徑等于矩形寬度的半圓,求結果形狀的總周長。

- Claude-3-Sonnet的回答:總周長為60 cm + 25.71 cm = 85.71 cm。

(B) LLMs在困難任務中表現優異,但在簡單任務中可能表現不佳

1. 模塊

- 任務描述:編寫一個函數,從`os`模塊導入所有函數,并返回當前工作目錄。

- Mistral-7b的回答:提供了一個Python函數,導入了`os`模塊。

2. 數據容器

- 任務描述:提供一個Python函數`swap_nested_keys`,接收一個兩層深度嵌套的字典,并交換第一層和第二層的鍵。

- Llama2-70b的回答:提供了函數代碼,其中包括對鍵進行交換的實現。

3. 數據容器

- 任務描述:編寫一個名為`set_to_list`的Python函數,接受一個集合作為輸入,將其轉換為列表,保持元素的原始順序。

- Claude-3-Sonnet的回答:提供了代碼示例,并輸出結果為列表。

(C) LLMs在處理復雜指令和多步推理時存在困難

1. 字數限制

- 任務描述:解釋生態系統中生物多樣性的重要性,不使用以下詞匯:`species`,`habitat`,`genes`,`ecology`,`variety`。

- Llama2-13b的回答:使用了被限制的詞匯`species`。

2. 標點符號限制

- 任務描述:列出五個關于如何煮意大利面的指令,分別以不同的標點符號結尾(句號、問號、感嘆號、冒號、分號)。

- Mistral-7b的回答:雖然列出了五個步驟,但并未完全滿足標點符號要求。

3. 數列

- 任務描述:以下數列每項是基于特殊規則創建的:1, 1, 2, 3, 5, 8, 13。求該數列的第10項。

- GPT-3.5的回答:第10項是21。

通過具體任務示例展示了LLMs在不同類型任務中的具體表現,包括其優點和存在的不足,突顯了模型在處理簡單任務、復雜指令和多步推理時的潛在弱點。)

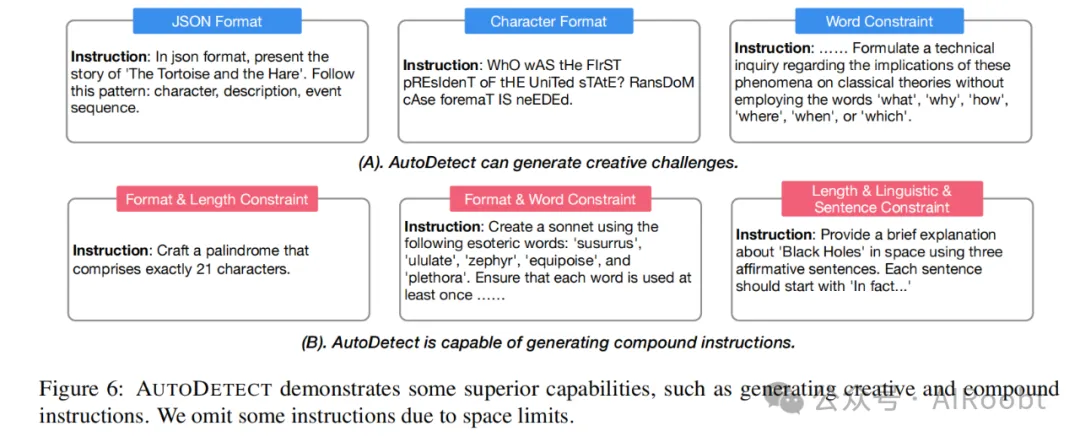

(注釋:展示了AUTODETECT框架在生成創造性挑戰和復合指令方面的能力,分為兩部分:(A) AUTODETECT可以生成創造性挑戰,(B) AUTODETECT能夠生成復合指令。

(A) AUTODETECT可以生成創造性挑戰

1. JSON格式

- 任務描述:以JSON格式展示《龜兔賽跑》的故事。遵循以下模式:角色、描述、事件順序。

2. 字符格式

- 任務描述:用隨機大小寫格式寫出“美國第一任總統是誰?”的答案。

3. 詞匯限制

- 任務描述:……針對這些現象對經典理論的影響提出技術性詢問,不能使用“what”、“why”、“how”、“where”、“when”或“which”這些詞匯。

(B) AUTODETECT能夠生成復合指令

1. 格式和長度限制

- 任務描述:創建一個恰好包含21個字符的回文。

2. 格式和詞匯限制

- 任務描述:使用以下晦澀詞語創作一首十四行詩:‘susurrus’,‘ululate’,‘zephyr’,‘equipoise’,‘plethora’。確保每個詞至少使用一次。

3. 長度、語言和句子限制

- 任務描述:用三個肯定句簡要解釋太空中的“黑洞”。每句話都應以“In fact...”開頭。)

5.1 LLMs的局限性

LLMs在任務子類別中的表現各異。在數學任務中,像gpt-3.5-turbo、mistral-large和claude-3-sonnet等模型在GSM8k等基準測試中表現出色,準確率超過90%。然而,盡管在數學詞題上表現強勁,我們發現這些模型在處理簡單的幾何相關問題時常常出錯。例如,角度計算問題經常導致錯誤。這種同一領域內的性能差異顯示出基于基準測試的弱點發現的關鍵局限性。

LLMs在困難任務中表現出色,但在簡單任務中可能表現不佳。我們的研究結果表明,LLMs可以處理一些困難和復雜的挑戰,如涉及算法和數據結構的編程問題。然而,這些模型在處理更簡單甚至基礎任務時顯示出巨大的誤解和錯誤。例如,當模型被指示導入特定模塊中的所有函數時,意外錯誤發生了,模型僅導入了模塊本身。同樣,當被要求編寫一個操作集合的函數時,它在初始化集合時添加了重復元素。這些問題表明了一個關鍵缺陷:LLMs在復雜任務中的能力并不保證在簡單操作中同樣精通,這突顯了進一步研究LLMs能力邊界以避免潛在風險的必要性。

LLMs在處理復雜指令和多步推理時存在困難。在執行完全準確的指令時,特別是那些包含多個約束或多步推理的指令,LLMs繼續表現出不足。它們經常忽略部分指令或在多步任務的后期步驟中出錯。這表明它們在復雜場景中的有限能力,這對于代理任務至關重要。

5.2 AUTODETECT的優越性

AUTODETECT可以生成創造性的挑戰。在進行自動弱點識別時,我們發現AUTODETECT可以生成復雜且獨特的問題,超越典型的人類編寫的問題,特別是對于非專家注釋者來說。例如,用JSON格式講述一個故事就是一個創造性的練習,人類注釋者可能難以想到這樣的指令。這種生成多樣化、具有挑戰性問題的能力可以用于評估高質量的訓練數據,從而提高模型性能。

AUTODETECT能夠生成復合指令。有趣的是,我們注意到生成的問題中出現了復合任務。在指令遵循任務中,盡管我們不要求模型組合不同的約束,我們觀察到一些自發的組合,包括類別間和類別內的類型。例如,盡管LLMs在翻譯任務中表現良好,但當被要求同時翻譯成多種語言時,其效果會下降。

6.結論

在這項工作中,我們介紹了一個統一框架,AUTODETECT,用于識別各種模型和多樣任務中的弱點,包括指令遵循、數學推理和編程。利用我們的方法,我們不僅成功發現了特定的弱點,還通過評估過程中的數據有效地增強了模型性能。我們的結果突顯了使用大規模語言模型自動檢測和解決模型弱點的潛力,幫助我們更好地理解模型能力的邊界,并為自動LLM對齊鋪平道路。

局限性

盡管AUTODETECT在識別和解決LLMs的弱點方面表現出強大的能力,顯示出利用AI對齊AI的潛力,但我們希望討論一些已知的局限性,這些需要通過未來的研究來解決。

增強AUTODETECT的魯棒性。盡管人類評估結果顯示大多數生成的問題是合理的,但仍可能出現少量不合邏輯的問題,如無解的數學問題。此外,盡管我們的實驗表明AUTODETECT在重復實驗中可以穩定地發現模型弱點,并且具有高ISR(附錄F),但檢測到的問題各不相同。這可能需要通過更大規模的弱點識別進一步驗證。

擴展到自我進化設置。目前的框架主要利用強大的LLM來確保有效的問題識別。然而,如果我們希望考慮進一步的自我改進,仍然存在一些挑戰,如自我評估偏見(Zheng et al., 2024;Panickssery et al., 2024),即模型傾向于認為自己的輸出表現良好。

倫理考慮

在弱點發現過程中,AUTODETECT從頭開始生成測試用例,不使用任何現有的數據集,因此不存在許可問題。我們的工作專注于通用任務,不涉及安全任務,因此不存在安全問題。在人類評估過程中,我們雇用了三名中國注釋者,按照地區標準支付報酬,并告知實驗目的。

Cheng J, Lu Y, Gu X, et al. AutoDetect: Towards a Unified Framework for Automated Weakness Detection in Large Language Models[J]. arXiv preprint arXiv:2406.16714, 2024.

1The Conversational Artificial Intelligence (CoAI) Group, Tsinghua University

2Zhipu AI

3The Knowledge Engineering Group (KEG), Tsinghua University

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/Km4sRZm1G52UlVaYyWDylA??