詳解大規模基礎模型中的幻覺問題(幻覺檢測、緩解、任務、數據集和評估指標) 精華

論文鏈接:https://arxiv.org/pdf/2405.09589

亮點直擊

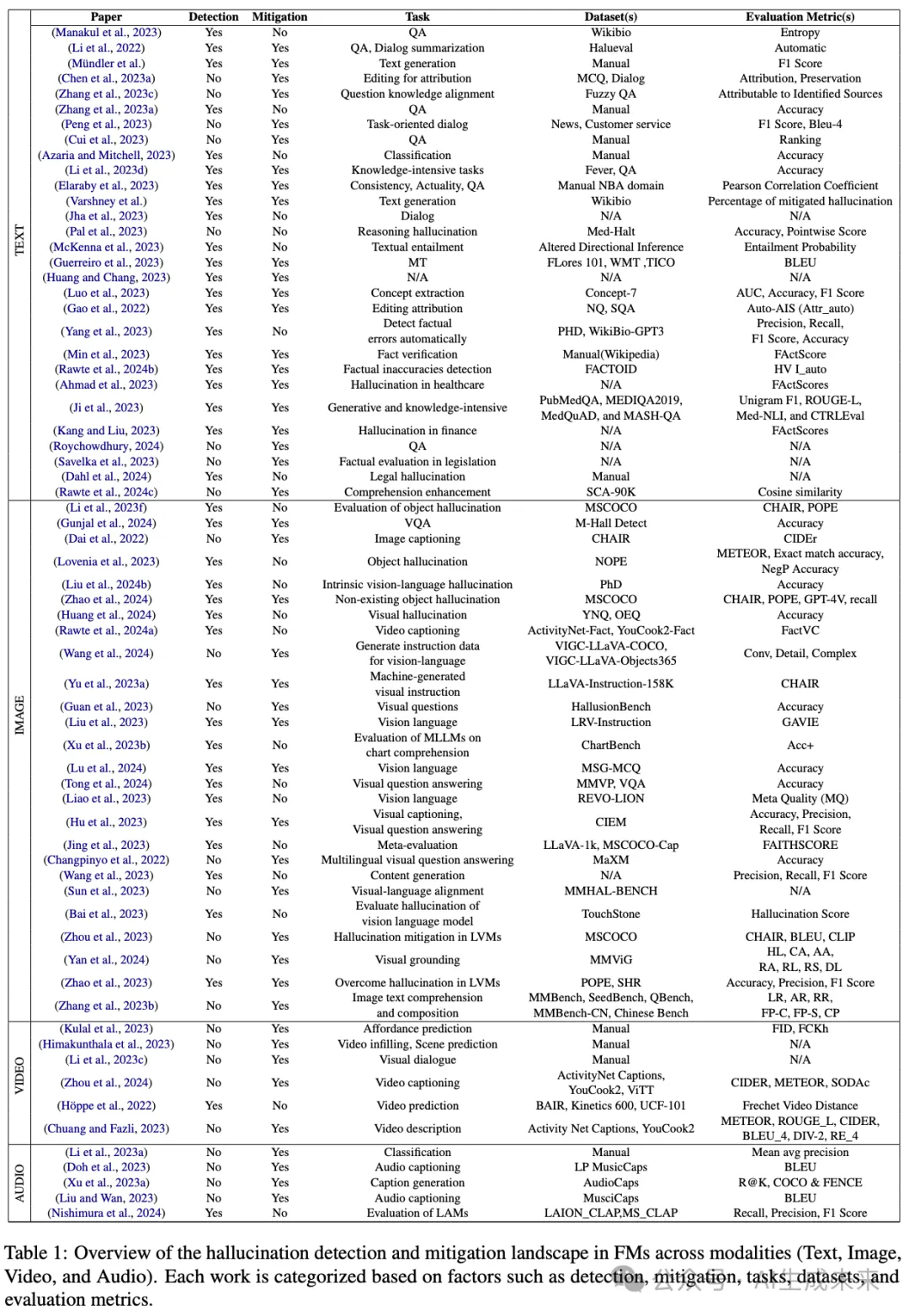

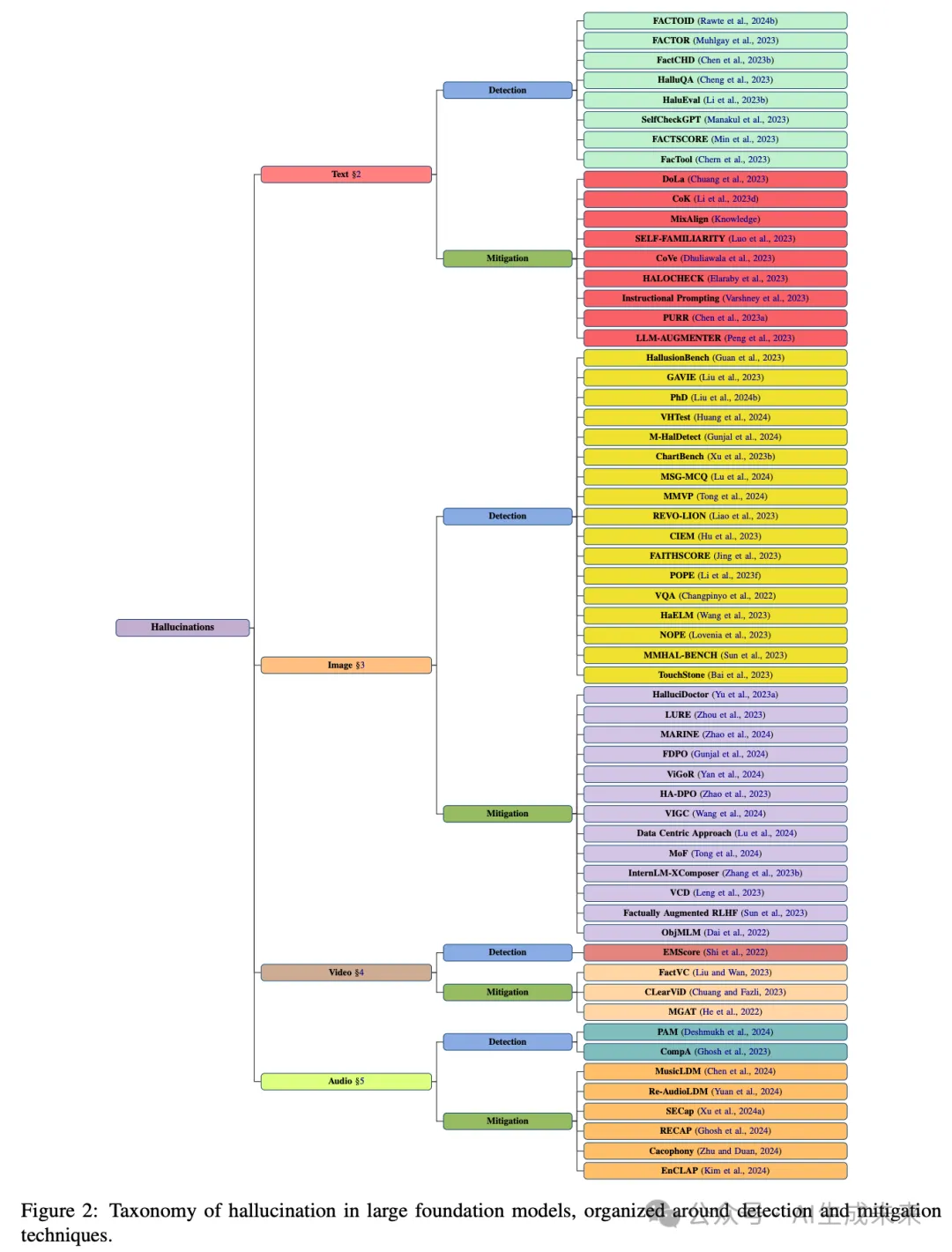

- 在大規模基礎模型的背景下建立了幻覺的精確定義和結構化分類。

- 識別出導致不同模態中幻覺出現的關鍵因素和機制。

- 提出了在多模態環境中解決幻覺問題的各種檢測和緩解策略。

- 提供了關于大規模基礎模型中幻覺技術的方法論的綜合總結,詳細介紹了其幻覺檢測、緩解、任務考慮、使用的數據集和評估指標。這將為讀者提供該領域最新進展的簡明概覽。

總結速覽

解決的問題

在大規模基礎模型中,幻覺輸出的生成是一個關鍵挑戰,特別是在高風險應用中。這種傾向可能影響模型的可靠性和準確性。

提出的方案

建立了幻覺的精確定義和結構化分類,識別出導致不同模態中幻覺出現的關鍵因素和機制。提出了多模態環境中解決幻覺問題的檢測和緩解策略。

應用的技術

- 精確定義和分類幻覺現象

- 多模態幻覺檢測和緩解策略

- 任務考慮、數據集使用和評估指標的綜合總結

達到的效果

為研究人員和實踐者提供了一個清晰的框架,幫助識別和緩解基礎模型中的幻覺問題。這一框架為未來在該領域的研究奠定了基礎,并提供了最新進展的簡明概覽。

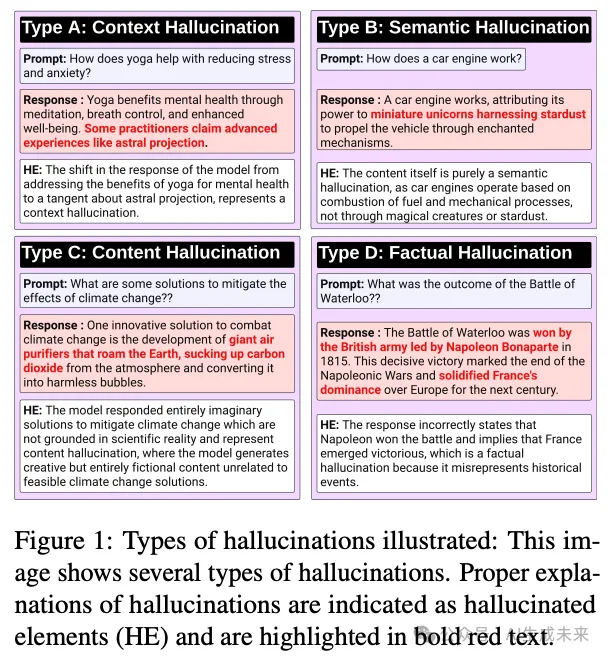

大語言模型中的幻覺

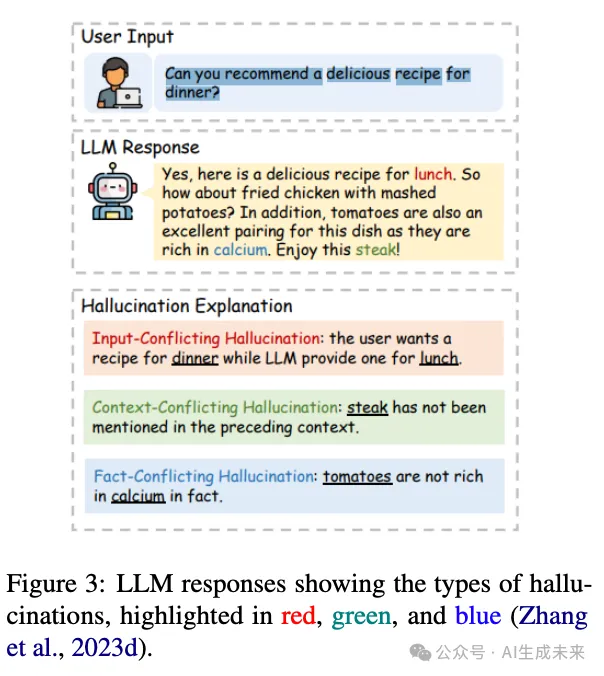

盡管大語言模型(LLMs)取得了進展,但它們容易產生幻覺的顯著挑戰仍然存在,阻礙了其實際應用。例如,下圖3中的插圖展示了由LLM生成的響應,顯示了幻覺的跡象。

幻覺檢測和緩解

識別大語言模型(LLMs)中的幻覺對于確保其結果的可信性和可靠性至關重要,尤其是在需要事實準確性的場景中。現有的事實核查方法通常依賴復雜的模塊或外部數據庫,需要輸出概率分布或與外部資源接口。SelfCheckGPT提供了一種零資源的黑箱解決方案,用于檢測任何LLM中的幻覺,而無需依賴外部資源。該方法基于這樣一個原則:對某個主題熟悉的LLM將在其響應中產生一致且可比的事實。相反,來自不熟悉主題的隨機采樣響應可能包含矛盾和幻覺的事實。

繼續探索段落級幻覺檢測的方法,Yang等提出了一種基于反向驗證的新型自檢方法,旨在自動識別不依賴外部資源的事實錯誤。他們引入了一個基準——段落級幻覺檢測(PHD),使用ChatGPT生成并由人類專家注釋,以評估不同的方法。評估LLM生成的長文本的準確性具有挑戰性,因為它通常包含準確和不準確的信息,使得簡單的質量判斷不足以應對。為了解決這一問題,Min等引入了FACTSCORE(原子性評分中的事實精度),一種新的評估方法,將文本分解為單獨的事實并測量其可靠性。Huang和Chang通過與成熟的網絡系統進行類比,引入了一種獨特的策略來減輕LLM中的幻覺風險。他們指出缺乏“引用”機制,即承認或引用來源或證據,是一個顯著的缺口。

為了解決識別大語言模型(LLM)生成內容中的事實不準確問題,Rawte等人(2024b)開發了一個多任務學習(MTL)框架,集成了先進的長文本嵌入技術,如e5-mistral-7b-instruct,以及GPT-3、SpanBERT和RoFormer等模型。該MTL方法在FACTOID基準測試中表現出顯著的性能提升,平均準確率提高了40%,相比領先的文本蘊涵方法。幻覺緩解工作主要依賴于經驗方法,對于完全消除幻覺的可能性仍存在不確定性。為應對這一挑戰,Xu等人(2024b)引入了一個形式化框架,將幻覺定義為可計算的LLM與真實函數之間的差異。通過該框架,研究考察了現有的幻覺緩解策略及其在實際LLM部署中的實際影響。

Rawte等人(2024c)引入了“Sorry, Come Again”(SCA)提示技術,以解決現代LLM中的幻覺問題。SCA通過采用最佳釋義和插入[PAUSE]tokens來延遲LLM生成,以增強理解力。它分析了提示中的語言細微差別及其對幻覺生成的影響,強調了由可讀性、正式性或具體性較低的提示帶來的困難。Rawte等人(2023a)研究了LLM如何響應事實正確和不正確的提示,將其幻覺分為輕微、中等和嚴重子類別。此外,論文引入了幻覺引發數據集(Hallucination eLiciTation dataset),包含75,000個人工標注的文本片段,并引入了一個新的幻覺脆弱性指數(Hallucination Vulnerability Index)指標。

特定領域的工作

幻覺在醫療、金融和法律等關鍵領域中構成嚴重風險。這些領域中,可靠性和準確性至關重要,因為任何形式的幻覺都可能導致重大和不利的后果。

醫學領域

針對醫學領域大語言模型中的幻覺,Pal 等人(2023)引入了醫學領域幻覺測試(Med-HALT),這是一個專門用于評估和減輕幻覺的基準數據集。Med-HALT 包含來自多個國家的醫療記錄的多樣化國際數據集,總共涵蓋七個數據集。Ahmad 等人(2023)概述了創建可靠、可信和無偏見模型的基本步驟,強調了在醫療背景下量化、驗證和減輕幻覺的必要性。Ji 等人(2023)引入了一種互動自反思方法,旨在提高使用大語言模型的醫學問答系統生成的答案的準確性和連貫性。通過知識獲取和對答案生成的反饋,這一方法提高了響應的事實性、一致性和邏輯進展。

金融領域

一項實證研究探討了大語言模型(LLMs)在金融活動中產生幻覺的傾向。Kang和Liu(2023)進行了這方面的實證調查,評估了LLMs在解釋金融概念和查詢歷史股價方面的能力,并研究了諸如少樣本學習和基于提示的工具學習等方法在減輕幻覺方面的效果。Roychowdhury等人(2023)提出了一種新穎的基于Langchain的方法,旨在將數據表轉換為分層的文本數據塊,以促進多樣化的金融問答。該框架包括按意圖分類用戶查詢、檢索相關數據塊、生成定制的LLM提示,并評估響應的幻覺和置信度。

法律領域

傳統的抽象文本摘要方法通常采用編碼器-解碼器架構,其中編碼器提取源文本的精髓,而解碼器生成摘要。然而,這種方法可能會產生包含無關或不準確信息的摘要,這在法律領域中尤為令人擔憂,因為準確性至關重要。為了解決這些問題,Feijo和Moreira(2023)引入了LegalSumm,它創建源文本的不同“視圖”,訓練摘要模型生成獨立的摘要,并使用蘊涵模塊評估其與源文本的符合性。Deroy等人(2023)通過將最先進的模型應用于印度法院案件,研究了大型語言模型生成案件判決抽象摘要的準備情況。盡管抽象模型的得分通常略高,但作者注意到生成的摘要中存在不一致和幻覺。

理解開放性法律術語的含義對法律專業人士非常重要。他們經常查看這些術語在先前法院案件中的使用和解釋。Savelka等人(2023)評估了GPT-4在生成法律術語的事實準確、清晰和相關解釋方面的表現。比較了基線方法(GPT-4直接解釋法律術語)和增強方法(使用法律信息檢索模塊提供來自判例法的上下文句子)。Dahl等人(2024)首次提供了法律領域中不準確性的頻率和類型的證據,為評估法律背景下的大型語言模型提供了寶貴的見解。通過檢查美國判例法的結構化格式,研究評估了三個主要的大型語言模型:GPT-3.5、PaLM 2和Llama。

基準評估

在某些情況下,大型語言模型會出現一種被稱為“幻覺滾雪球”的現象,即它們會編造虛假聲明來合理化先前的幻覺,盡管它們承認這些信息是不準確的。為了實證研究這一現象,Zhang等人(2023a)設計了三個跨越不同領域的問題回答數據集,其中ChatGPT和GPT-4經常提供不準確的答案,并附帶至少一個虛假聲明的解釋。值得注意的是,研究表明語言模型可以識別這些虛假聲明為不正確。另一個基準數據集FactCHD(Chen等人,2023b)被引入用于檢測復雜推理背景下的事實沖突幻覺。該數據集涵蓋了不同事實模式的數據集,并整合了基于事實的證據鏈以提高評估準確性。Li等人(2023b)引入了一個數據集,用于評估大型語言模型識別和識別幻覺或錯誤信息的能力。結果顯示,ChatGPT傾向于在某些主題上生成幻覺內容,引入無法驗證的信息。

大視覺語言模型中的幻覺

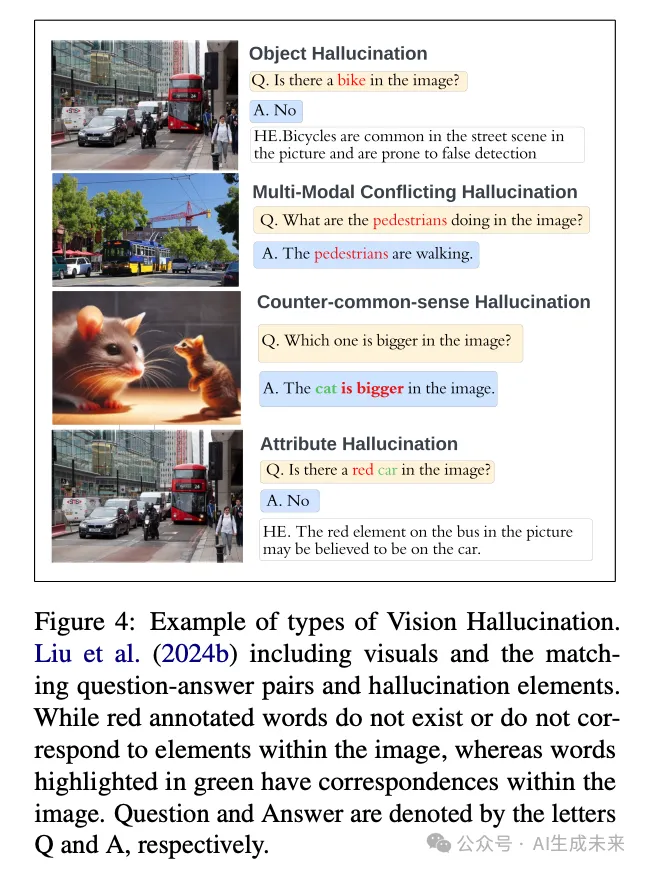

大型視覺語言模型(LVLMs)因其同時處理視覺和文本數據的能力而在AI社區中受到廣泛關注。然而,與LLMs類似,LVLMs也面臨幻覺問題。下圖4展示了一個視覺幻覺的例子,其中模型可能會誤解或錯誤生成圖像中的信息。

幻覺檢測和緩解

Dai 等人(2022)研究了視覺語言預訓練(VLP)模型中的物體幻覺問題,即這些模型生成的文本描述基于輸入圖像包含不存在或不準確的物體。Li 等人(2023f)揭示了廣泛且嚴重的物體幻覺問題,并指出視覺指令可能會影響幻覺的產生。他們觀察到,在視覺指令中經常出現或與圖像對象共同出現的物體更容易產生幻覺。為了增強物體幻覺的評估過程,作者引入了一種基于投票的查詢方法,稱為 POPE,該方法在評估物體幻覺方面表現出更好的穩定性和靈活性。缺乏標準化的評估指標阻礙了對物體幻覺問題的理解和解決。為了解決這一差距,Lovenia 等人(2023)引入了 NOPE(Negative Object Presence Evaluation),這是一個通過視覺問答(VQA)評估視覺語言模型(VLMs)中物體幻覺的基準。

研究利用大型語言模型生成了一個包含 29.5k 合成負代詞(NegP)實例的數據集用于 NOPE。它全面評估了 10 個 VLMs 在檢測視覺問題中物體缺失的能力,此外還評估了它們在其他九個 VQA 數據集上的典型表現。現有研究主要關注物體幻覺,忽視了大型視覺語言模型(LVLMs)的幻覺。Liu 等人(2024b)深入研究了內在視覺語言幻覺(IVL-Hallu),并提出了幾個新的 IVL-Hallu 任務,包括屬性、物體、多模態沖突和反常識幻覺。他們引入了一個具有挑戰性的基準數據集來評估和探索 IVL-Hallu,并對五個 LVLMs 進行了實驗,結果顯示它們在解決所提出任務方面的有效性有限。為在不依賴昂貴訓練或 API 的情況下減輕 LVLMs 中的物體幻覺,Zhao 等人(2024)引入了 MARINE,這是一種無需訓練和 API 的解決方案。MARINE 通過結合現有的開源視覺模型并利用無分類器指導來整合物體定位特征,從而增強 LVLMs 的視覺理解,提高生成輸出的精確性。對六個 LVLMs 的評估表明,MARINE 在減少幻覺和增強輸出細節方面的有效性,通過使用 GPT-4V 的評估得到了驗證。

盡管在多模態任務上取得了進展,但LMMs常常生成與圖像或人類指令不一致的描述。為了解決這個問題,Liu等人(2023)開發了LRV-Instruction,這是一個包含40萬條視覺指令的綜合數據集,涵蓋16個任務。該數據集包含各種風格和語義層次的正面和負面指令。通過LRV-Instruction,現有LMMs的幻覺問題得到了廣泛研究,證實了其在增強視覺指令調優方面的有效性。此外,他們引入了GAVIE,這是一種無需人工標注答案即可評估視覺指令調優的新方法,可以適應不同類型的指令。

LVLM幻覺修正算法(LURE)旨在通過優化描述來糾正LVLM中的對象幻覺,從而生成更準確且幻覺更少的輸出。其方法基于深入的統計分析,識別出導致對象幻覺的關鍵因素,如圖像中某些對象的共現、LVLM解碼過程中與對象相關的不確定性,以及生成文本末尾出現幻覺的趨勢。LURE設計為可無縫集成到各種LVLM中。在多個LVLM中進行測試時,LURE的集成顯著提升了對象幻覺的糾正效果,在多種指標下的GPT和人工評估中均持續優于其他方法。

基準評估

當前開發多模態大型語言模型(LVLMs)的方法嚴重依賴于帶注釋的基準數據集,這些數據集可能存在領域偏差,限制了模型的生成能力。為了解決這個問題,Li等人(2023e)提出了一種新穎的數據收集方法,該方法同步合成圖像和對話用于視覺指令調優,生成了大量圖像-對話對和多圖像實例的數據集。Huang等人(2024)引入了VHTest,這是一個包含1,200個多樣化視覺幻覺(VH)實例的基準數據集,覆蓋8種VH模式。對三種SOTA多模態大型語言模型(MLLMs)的評估顯示,GPT-4V的幻覺率低于MiniGPT-v2。

Rawte等人(2024a)將視覺幻覺在視覺語言模型(VLMs)中分類為八個方向,并引入了一個包含2,000個樣本的數據集,涵蓋這些類型。他們提出了三種主要的減輕幻覺的方法:數據驅動的方法、訓練調整和后處理技術。此外,Wang等人(2024)提出了視覺指令生成與修正(VIGC)框架,以解決MLLMs高質量指令調優數據的短缺問題。VIGC使MLLMs能夠生成多樣化的指令調優數據,同時通過視覺指令修正(VIC)迭代地提高其質量,從而降低幻覺風險。該框架生成多樣化的高質量數據用于微調模型,通過評估驗證,提升了基準性能,并克服了僅語言數據的局限性。

大型視頻模型中的幻覺

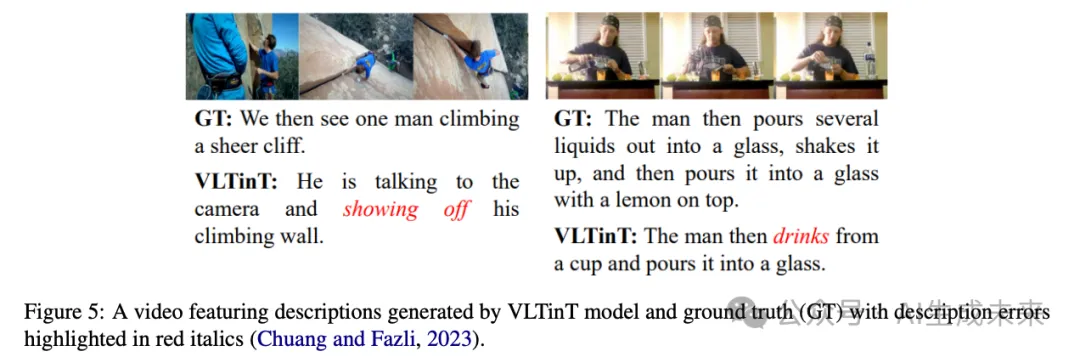

大型視頻模型(LVMs)代表了一項重大進步,能夠大規模處理視頻數據。盡管它們在視頻理解和生成等各種應用中具有潛力,但LVMs面臨幻覺問題,即對視頻幀的誤解可能導致生成虛假或不準確的視覺數據。這個問題的產生是由于視頻數據的復雜性,需要模型進行徹底的處理和理解。下圖5展示了在LVMs中觀察到的幻覺實例。

幻覺檢測和緩解

密集視頻字幕生成的復雜任務涉及為連續視頻中的多個事件創建描述,這需要對視頻內容和上下文推理進行深入理解,以確保生成準確的描述。然而,這一任務面臨諸多挑戰,可能導致不準確和幻覺現象(Iashin and Rahtu, 2020; Suin and Rajagopalan, 2020)。

傳統方法先檢測事件提議,然后為子集生成字幕,但由于忽視時間依賴性,可能導致幻覺。為了解決這一問題,Mun等(2019)提出了一種新方法,通過建模時間依賴性和利用上下文進行連貫敘述。通過集成事件序列生成網絡和使用強化學習及兩級獎勵訓練的順序視頻字幕生成網絡,該模型更有效地捕捉上下文信息,從而生成連貫準確的字幕,并最大限度地減少幻覺風險。Liu和Wan(2023)引入了一種新的弱監督、基于模型的事實性指標FactVC,其表現優于以往指標。此外,他們提供了兩個注釋數據集,以促進視頻字幕事實性評估的進一步研究。Wu和Gao(2023)提出了一種上下文感知模型,該模型結合了過去和未來事件的信息,以有條件地影響當前事件的描述。他們的方法利用強大的預訓練上下文編碼器來編碼關于周圍上下文事件的信息,然后通過門控注意機制將其集成到字幕生成模塊中。在YouCookII和ActivityNet數據集上的實驗結果表明,所提出的上下文感知模型顯著優于現有的上下文感知和預訓練模型。為了增強密集視頻字幕生成,Zhou等(2024)引入了一種流式模型,該模型包括一個用于處理長視頻的記憶模塊和一個流式解碼算法,使得在視頻完成之前即可進行預測。這一方法顯著提升了在YouCook2、ActivityNet和ViTT等主要密集視頻字幕生成基準上的表現。

視頻填充和預測任務對于評估模型理解和預測視頻序列中的時間動態的能力至關重要(H?ppe et al., 2022)。為此,Himakunthala等(2023)引入了一個推理時間挑戰數據集,其中包含帶有密集字幕和結構化場景描述的關鍵幀。該數據集提供了補充有非結構化密集字幕和結構化FAMOUS(焦點、動作、情緒、物體和環境)場景描述的關鍵幀,為模型理解視頻內容提供了有價值的上下文信息。他們使用了GPT-3、GPT-4和Vicuna等語言模型,并采用貪婪解碼來減輕幻覺風險。

最近在視頻修復方面取得了顯著進展,特別是在光流等顯式指導幫助跨幀傳播缺失像素的情況下(Ouyang et al., 2021)。然而,由于缺乏跨幀信息,仍然存在困難和限制。Yu等(2023b)旨在解決相反的問題,而不是依賴使用其他幀的像素。所提出的方法是一個缺陷感知的掩碼Transformer(DMT),這是一種雙模態兼容的修復框架。該方法通過預訓練圖像修復模型作為訓練視頻模型的先驗,改善了處理信息不完整場景的能力。

理解場景可供性,即場景中可能的動作和交互,對于理解圖像和視頻至關重要。Kulal等(2023)介紹了一種將人物逼真插入場景的方法。該模型通過推斷基于上下文的逼真姿勢,確保視覺上令人愉悅的構圖,將個體無縫整合到場景中。Chuang和Fazli(2023)介紹了CLearViD,這是一種基于Transformer的模型,利用課程學習技術來增強性能。通過采用這種方法,模型獲得了更強大和更具泛化性的特征。此外,CLearViD引入了Mish激活函數來解決諸如梯度消失的問題,從而通過引入非線性和非單調性來降低幻覺風險。廣泛的實驗和消融研究驗證了CLearViD的有效性,在ActivityNet Captions和YouCook2數據集上的評估顯示出在多樣性指標方面相較現有SOTA模型的顯著改進。

基準評估

Zhang等(2006)創造了一種創新的兩級層次融合方法,從訓練視頻樣本中僅使用一張中性表情的正面人臉圖像生成面部表情序列。為了有效地訓練系統,他們引入了一個專門為面部表情幻覺設計的數據集,其中包含112個視頻序列,涵蓋28個人的四種面部表情(快樂、憤怒、驚訝和恐懼),從而在時間和空間域中生成合理的面部表情序列,并減少偽影。在視頻理解領域,端到端的以聊天為中心的系統的開發已成為一個日益增長的興趣領域。Zhou等(2018)組建了YouCook2數據集,這是一個廣泛的烹飪視頻集,具有時間定位和描述的程序段,以促進程序學習任務。Li等(2023c)介紹了“VideoChat”,這是一種通過可學習的神經接口集成視頻基礎模型和大型語言模型(LLM)的新方法,以增強視頻理解中的時空推理、事件定位和因果關系推斷。研究人員構建了一個以視頻為中心的指令數據集,包含詳細的描述和對話,強調時空推理和因果關系。為應對模型幻覺,他們采用多步驟過程,使用GPT-4將視頻描述濃縮為連貫的敘述,并加以改進以提高清晰度和連貫性。為探索推斷場景可供性(affordances)的挑戰,Kulal等(2023)策劃了一個包含240萬段視頻剪輯的數據集,展示了與場景上下文相符的各種合理姿勢。

大型音頻模型中的幻覺

大型音頻模型(LAMs)在音頻處理和生成領域中成為了一種強大的工具,應用范圍廣泛,包括語音識別、音樂分析、音頻合成和字幕生成(Latif等,2023;Ghosal等,2023)。盡管這些模型在各個領域展示了卓越的能力,但它們易于出現幻覺。這些異常可能表現為多種形式,從通過拼接虛構片段創建不真實的音頻,到在摘要中插入錯誤信息,如引言或事實。此外,它們可能無法準確捕捉音頻信號的固有特征,如音色、音高或背景噪音(Shen等,2023)。

幻覺檢測和緩解

在音頻字幕生成領域,即自動生成音頻片段的自然語言描述時,一個主要挑戰是音頻-文本模型在預訓練過程中過度依賴視覺模態。這種依賴引入了數據噪聲和幻覺,最終削弱了生成字幕的準確性。為了解決這個問題,Xu等(2023a)引入了一種AudioSet標簽引導的模型,用于引導大規模音頻-文本數據(BLAT)。值得注意的是,該模型避免了視頻的使用,從而最大限度地減少了與視覺模態相關的噪聲。跨檢索、生成和分類等多項任務的實驗結果驗證了BLAT在減輕幻覺問題上的有效性。

語音情感在人與人交流中起著至關重要的作用,并在語音合成和自然語言理解等領域有廣泛應用。然而,傳統的分類方法可能無法捕捉到人類語音中傳達的細膩且復雜的情感(Jiang等,2019)、(Han等,2021)、(Ye等,2021)。SECap(Xu等,2024a)是一個為語音情感字幕設計的框架,旨在通過自然語言捕捉語音的復雜情感細微差別。SECap利用包括LLaMA作為文本解碼器、HuBERT作為音頻編碼器以及Q-Former作為Bridge-Net的各種組件,基于語音特征生成連貫的情感字幕。

盡管音頻語言模型具有零樣本推理的能力,但在強大性能的同時,仍面臨著諸如幻覺特定任務細節等挑戰。為了解決這個問題,Elizalde等(2024)引入了對比語言-音頻預訓練(CLAP)模型。CLAP通過460萬對多樣化的音頻-文本對進行預訓練,采用雙編碼器架構,增強了表示學習,從而在聲音、音樂和語音領域實現更好的任務泛化。

基準評估

為了應對音樂字幕領域數據稀缺的問題,Doh等(2023)引入了LP-MusicCaps,這是一個綜合數據集,包括50萬段音頻片段和大約220萬條字幕。他們利用大型語言模型(LLMs)訓練了一個基于Transformer的音樂字幕生成模型,并在零樣本和遷移學習場景下評估其性能,表現出相對于監督基線模型的優越性。

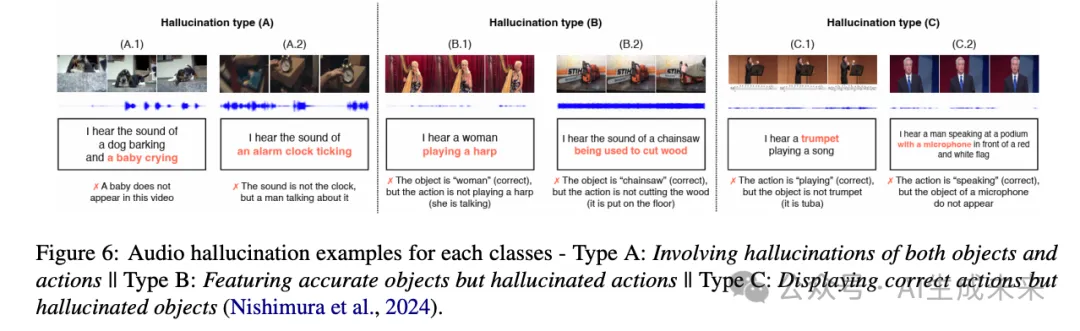

Nishimura等(2024)研究了大型音視頻語言模型中的音頻幻覺問題,這些模型主要基于視覺信息生成音頻描述,而忽略了音頻內容。他們將這些幻覺分為三種類型:涉及對象和動作的幻覺、對象準確但動作幻覺、動作正確但對象幻覺。在他們的研究中,他們通過收集音頻信息獲取了1000個句子,并對其進行標注以確定是否包含聽覺幻覺,如果檢測到則進一步分類幻覺類型。

為了評估大型音頻模型(LAMs)的組合推理能力,Ghosh等(2023)引入了CompA,包含兩個主要關注真實音頻樣本的專家標注基準。這一基準用于通過一種新穎的學習方法微調CompA-CLAP,提升其組合推理能力,并在需要組合推理的任務中表現出相對于所有基線模型的顯著改進。

幻覺:好還是壞?

大型模型中的幻覺現象呈現出創造力與不確定性之間的復雜互動。一方面,超越常規數據邊界的能力可以產生新穎和創新的輸出。幻覺可以激發探索性學習,揭示數據中意想不到的模式和特征。它們還可以作為壓力測試的一種形式,提高模型的魯棒性和適應性。此外,這些意外的輸出甚至可以激發人類的創造力,成為新想法和新視角的跳板(Rawte等,2023b)。然而,幻覺的這種雙重性質也帶來了顯著的缺點。幻覺輸出的質量和連貫性可能存在問題,在準確性和可靠性至關重要的應用中帶來挑戰。幻覺還可能傳播模型訓練數據中存在的錯誤信息和偏見,可能加深現有的偏見并削弱用戶信任。這些輸出的可解釋性降低可能進一步削弱模型的可信度和采用率。當幻覺產生不當、冒犯或有害內容時,會引發倫理問題。必須進行仔細的監控和控制機制,以防止產生可能對用戶造成傷害或困擾的輸出。在探索與忠實度之間找到這種微妙的平衡,對于在最大化大型模型效用的同時減輕意外輸出相關風險至關重要。總體而言,大型模型中的幻覺現象突顯了對這些能力進行細致理解和戰略管理的必要性。

限制

先前的綜述論文主要關注大型語言模型中的幻覺現象,并未廣泛涵蓋視覺、音頻和視頻模態中的幻覺。在這篇綜述論文中,我們的目標是全面概述所有模態中的幻覺現象,考慮到幻覺可能出現在任何大型基礎模型中。盡管我們努力提供關于所有基礎模型中幻覺技術的最新進展的全面總結,但我們承認可能會遺漏該領域的一些相關研究。

未來方向

研究人員正在積極研究幻覺緩解技術,因為在敏感領域中,生成虛構或錯誤內容的挑戰可能會產生嚴重后果(Tonmoy et al., 2024; Rawte et al., 2023b)。以下是解決這些基礎模型中幻覺問題的潛在方向:

數據資源: 最近的研究強調了在精心策劃的高質量樣本上進行簡單微調的效果,這種方法在減少幻覺方面超過了大規模微調和強化學習方法。在知識密集型領域,開發以實體為中心的微調指令,整合來源于知識圖譜的結構化知識,有望提高準確性和相關性。此外,針對特定任務或領域的對齊技術已被證明在緩解幻覺方面有效。隨著該領域研究的進展,預計將有更多資源專注于通過任務特定或領域適應的方法改善對齊,從而進一步增強語言模型在生成事實和可信內容方面的可靠性。

自動化評估: 開發考慮諸如事實準確性和連貫性等因素的專門評估指標對于幻覺檢測非常有用。將自動化評估與通過眾包進行的人類判斷相結合,可以捕捉到自動化系統單獨難以檢測的細微方面。此外,還在開發對抗性測試方法,通過設計輸入來暴露AI系統的弱點,增強其對幻覺的抵抗力。此外,在強調事實核查和準確性的數據集上微調基礎模型提供了另一種提高內容可靠性和減少幻覺發生的方法。

改進檢測和緩解技術: 緩解基礎模型中的幻覺需要利用推理機制、知識圖譜集成、專門的事實核查模型、偏差緩解技術和主動學習方法的多方面方法。諸如Chain of Thought(CoT)和Tree of Thought(ToT)等新興技術增強了這些模型的推理能力,可能減少幻覺。整合知識圖譜有助于理解事實信息和概念關系,從而支持內容生成和事實核查。專門的驗證模型通過與策劃的知識進行交叉引用來識別不準確之處,而偏差檢測和緩解技術促進公平性。最后,管理AI開發中策劃知識負責任使用的倫理指南和監管框架可以降低風險并增強公眾信任,從而整體提高AI生成內容的質量、準確性和可信度。

多模態幻覺: 解決多模態大型基礎模型中的幻覺需要跨越數據中心舉措、跨模態對齊努力、架構創新、標準化基準、重構幻覺以及增強可解釋性和信任的綜合方法。數據中心技術確保多樣化和高質量的訓練數據的穩健收集、增強和校準。跨模態對齊專注于通過復雜的架構對齊跨模態的表示。模型架構的進步涉及設計能夠有效處理復雜語言和視覺輸入的專用模型。建立統一的指標和標準化基準可以準確評估幻覺和可靠的性能評估。將幻覺重構為一種特性探討其在下游應用中的集成,優化人類體驗。最后,開發用于解釋模型行為、可視化內部結構和改進可靠性評估的技術,有助于增強對多模態大模型的信任。這種多方面的方法共同解決了關鍵的幻覺挑戰,為更可靠和值得信賴的多模態AI系統鋪平了道路。

結論

這篇綜述論文系統地分類了基礎模型中幻覺現象的現有研究,提供了對關鍵方面的全面見解,包括檢測、緩解、任務、數據集和評估指標。文章討論了幻覺在基礎模型中廣泛的影響,承認其在各個領域中的影響。通過研究檢測和緩解技術的最新進展,論文強調了解決這一挑戰的重要性,鑒于基礎模型在關鍵任務中的不可或缺性。其主要貢獻在于引入了一個結構化的分類法,用于對基礎模型中的幻覺進行分類,涵蓋文本、圖像、視頻和音頻領域。

本文轉自AI生成未來 ,作者:AI生成未來