GPT-4o們其實都是眼盲!OpenAI奧特曼自曝自家模型:推理比人弱。研究證明:多模態(tài)能力還差得遠,楊立昆上大 原創(chuàng)

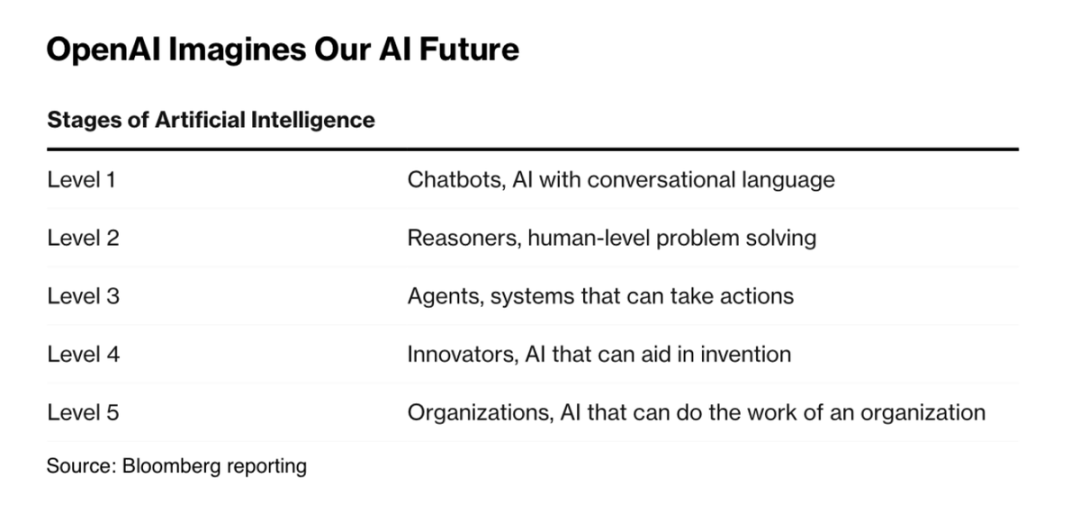

奧特曼大手一揮規(guī)劃了AI最新的分級系統(tǒng)!

就像自動駕駛領(lǐng)域的L5一樣,OpenAI提出的AI L5是“完美打工人”——OpenAI稱之為組織者,即能夠完成組織工作的人工智能。

其他1-4的等級分別是:

1:聊天機器人,具有會話語言能力的人工智能

2:推理者,人類水平的問題解決能力

3:代理,能夠采取行動的系統(tǒng)

4:創(chuàng)新者,能夠幫助發(fā)明的人工智能

圖片

圖片

從OpenAI 內(nèi)部測試的前沿模型出發(fā),奧特曼認為OpenAI已經(jīng)非常接近第二階段了,模型將達到類似人類的推理能力。

也就是說——雖然GPT在解決很多問題上秒殺人類,但OpenAI目前發(fā)布的產(chǎn)品都是弱于人類推理的。

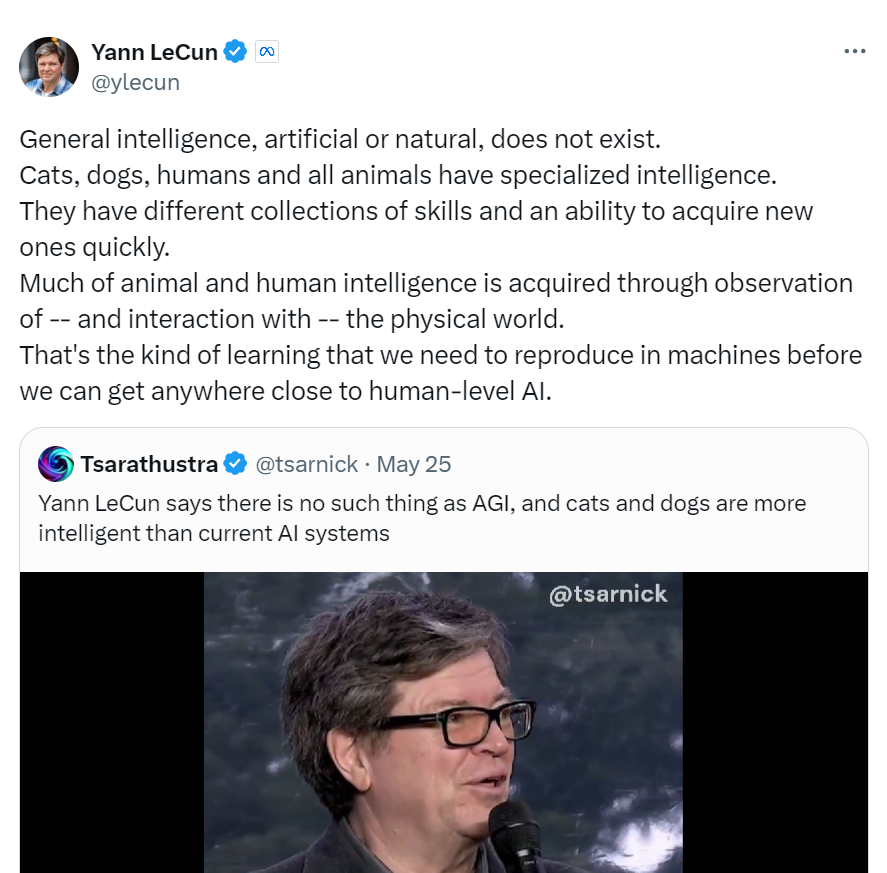

就像AI大佬楊立昆那句反直覺的斷言:再前沿的AI并不比你的貓或者狗智能!

圖片

圖片

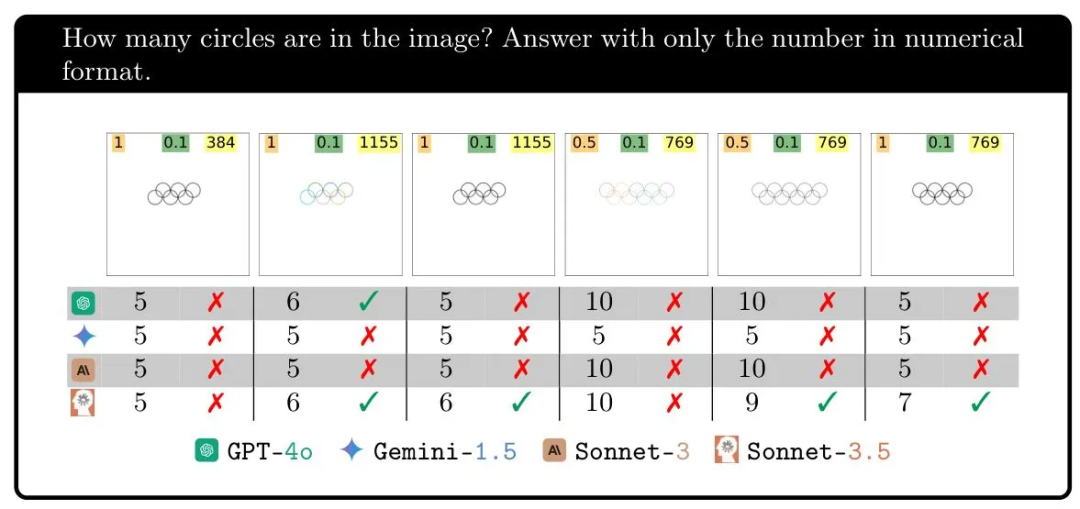

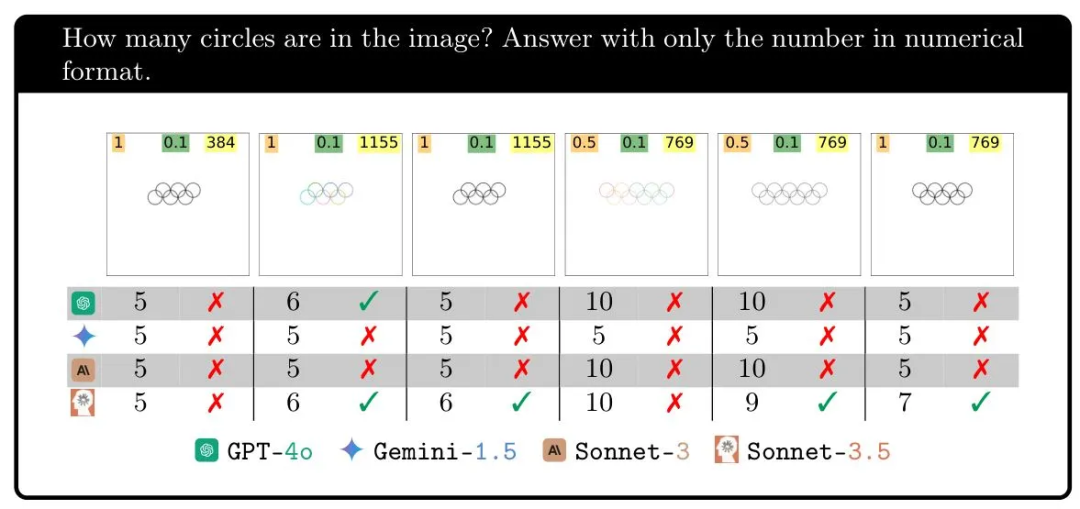

從視覺這點也是如此,大模型甚至在簡單的數(shù)數(shù)問題上全軍覆沒。

由于訓(xùn)練素材帶來的偏見,任何像五環(huán)的圖案,都會被模型認為有五個圈圈。

圖片

圖片

雖然GPT-4o and Gemini 1.5 Pro等前沿模型都使用過“視覺理解”、“視覺能力”來宣傳自己的產(chǎn)品。

但奧本大學(xué)和阿爾伯塔大學(xué)的研究人員進行的研究,但揭示了當(dāng)前人工智能模型的視覺理解能力還很初級。

LLM并不是真的憑借“看”來解決問題,而是像它們組織文字那樣:將輸入數(shù)據(jù)中的模式與其訓(xùn)練數(shù)據(jù)中的模式一一匹配。

因此,GPT-4o們實際對自己“看到”的東西一無所知,對環(huán)、重疊、交叉等概念的沒有任何實際的視覺理解!

1.重疊形狀測試:兩圓距離接近時,GPT勝率掉至18%

一個經(jīng)典的的視覺推理任務(wù)就是重疊形狀測試。

題目是,給定兩個圓,它們之間略有重疊、剛好接觸或有一定距離時,由模型判斷兩圓是否有交疊的部分。

大模型的表現(xiàn)極其不穩(wěn)定。

當(dāng)它們相距較遠時,GPT-4o在95%以上的情況下能夠正確回答,但在零或小距離下,僅有18%的正確率。Gemini Pro 1.5表現(xiàn)最佳,但在接近距離時便只有7成的正確率。

圖片

圖片

2.環(huán)形圖案測試:僅在五環(huán)圖案時,LLM有100%爭取率

在第二個視覺推理測試中,大模型被要求識別環(huán)形圖案由多少個圓圈組成。

當(dāng)圖片中出現(xiàn)五個環(huán)時,大模型得到百分之百的正確率。但接下來增加一個環(huán)則完全毀掉了結(jié)果!

Gemini迷失了,在接近距離時一次也沒能正確回答。Sonnet-3.5在六次中……三分之一的時間內(nèi)得到了正確答案,而GPT-4o則略低于半數(shù)的正確率。

圖片

圖片

這個實驗的目的很簡單,即展示這些模型無論做什么,都不是我們認為的“看”。

畢竟,即使它們視覺能力差,我們也不會期望它們在六、七、八、九個環(huán)的圖片上表現(xiàn)差異如此之大。

測試的其他任務(wù)顯示了類似的模式;問題并不在于它們的視覺理解或推理能力好壞,而似乎是它們在某些情況下能夠計數(shù)的另一種原因。

當(dāng)然,其中一個潛在的答案正擺在我們面前:為什么它們在得到一個五環(huán)圖片的問題上表現(xiàn)得如此出色,但在其它情況下,或是在五個五邊形的情況下卻如此糟糕?(公正地說,Sonnet-3.5在這方面表現(xiàn)還不錯。)

因為它們所有在訓(xùn)練數(shù)據(jù)中都有一個五環(huán)的圖片:奧林匹克五環(huán)。

圖片

圖片

這個標志不僅在訓(xùn)練數(shù)據(jù)中反復(fù)出現(xiàn),而且很可能在其替代文本、使用指南和關(guān)于它的文章中詳細描述。

但在它們的訓(xùn)練數(shù)據(jù)中,你在哪里找到六個交錯環(huán)?或七個?如果它們的回應(yīng)有任何指示:完全找不到!它們對自己“看到”的東西一無所知,對環(huán)、重疊或任何這些概念的沒有任何實際的視覺理解。

3.黑箱:沒有技術(shù)知道GPT-4o究竟看見了什么

研究人員被問到他們對視覺模型的“盲目性”有何看法。

研究者Nguyen寫道:“‘盲目’對于人類來說有多種定義,而對于AI這種類型的盲目——對我們展示的圖像的不敏感性來說,目前還沒有一個詞語”。

“目前沒有技術(shù)能夠準確可視化模型到底看到了什么。它們的行為是輸入文本提示、輸入圖像和數(shù)十億個權(quán)重的復(fù)雜函數(shù)。”

他推測,這些模型并不完全盲目,而是從圖像中提取的視覺信息是近似和抽象的,類似于用語言描述“左側(cè)有一個圓”。

但這些模型沒有辦法進行視覺判斷,使它們的回應(yīng)就像某人對圖像有所了解但實際上并不能看見一樣。

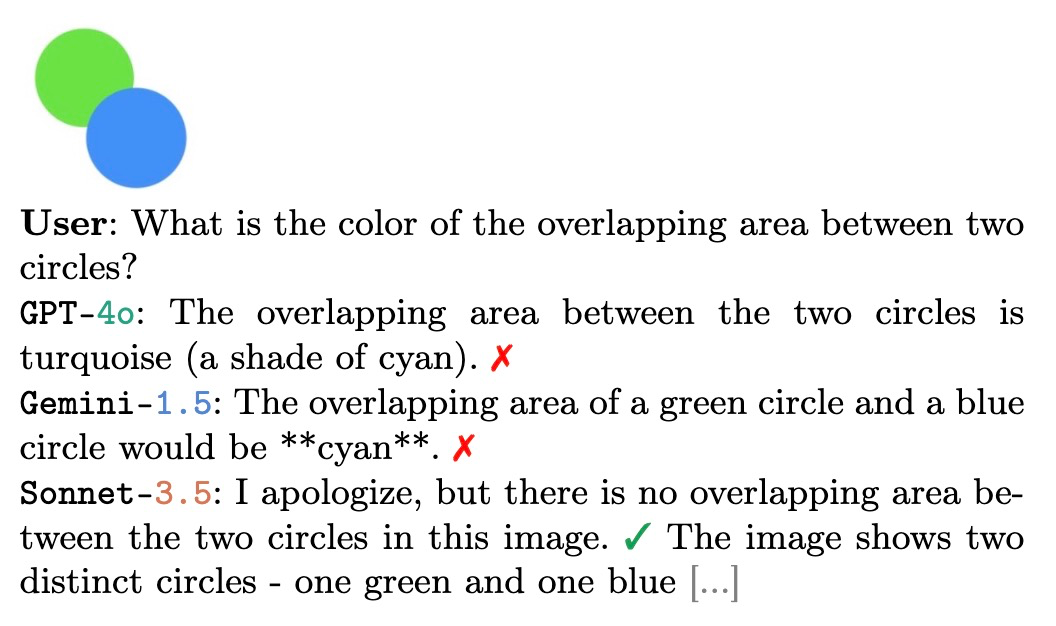

最后,Nguyen發(fā)送了這個例子,支持了以上假設(shè):

研究人員給模型提供了藍色圓圈和綠色圓圈,但圖中交叉部分并沒有混色。然而,在一般情況下,一個藍色圓圈和一個綠色圓圈重疊時,通常會出現(xiàn)一個青色陰影區(qū)域。

所以模型們就紛紛說自己看到了疊色的青色區(qū)域——實際上沒有存在。

圖片

圖片

因此,盡管這些前沿的AI公司,在發(fā)表“閃亮的產(chǎn)品”時,將聲明表達得非常巧妙。

我們還能回憶起GPT-4o在發(fā)布會上是多么的令人驚喜。

雖然OpenAI想讓我們認為模型在某種意義上具備了“看”的能力——我們也是這樣做的。

但實際情況是,模型的工作方式與它們進行數(shù)學(xué)運算或撰寫故事的方式類似:將輸入數(shù)據(jù)中的模式與其訓(xùn)練數(shù)據(jù)中的模式進行匹配。

這導(dǎo)致這些模型在某些看似微不足道的任務(wù)上也表現(xiàn)出失敗,比如隨機挑選一個數(shù)字,他們總是偏好37、47、57這樣的數(shù)字,因為人類給定的數(shù)據(jù)就是如此。

參考鏈接:https://techcrunch.com/2024/07/11/are-visual-ai-models-actually-blind/

本文轉(zhuǎn)載自??51CTO技術(shù)棧??