長(zhǎng)上下文能力只是吹牛?最強(qiáng)GPT-4o正確率僅55.8%,開(kāi)源模型不如瞎蒙

大數(shù)字一向吸引眼球。

千億參數(shù)、萬(wàn)卡集群,——還有各大廠商一直在卷的超長(zhǎng)上下文。

從一開(kāi)始的幾K幾十K,發(fā)展到了如今的百萬(wàn)token級(jí)別。

Gemini的最新版本可以接收200萬(wàn)個(gè)token作為上下文。

這大概相當(dāng)于140萬(wàn)個(gè)單詞、2小時(shí)視頻或者22小時(shí)的音頻。

但不知諸位平時(shí)用得著這么長(zhǎng)的上下文嗎?畢竟100K已經(jīng)相當(dāng)于一部比較長(zhǎng)的小說(shuō)了。

更重要的是,LLM真的能在這個(gè)長(zhǎng)度上進(jìn)行推理嗎?

近日,有兩篇獨(dú)立研究分別表明:長(zhǎng)上下文水分很大!LLM實(shí)際上并不能「理解」內(nèi)容。

讀小說(shuō)挑戰(zhàn)

首先是來(lái)自UMass、AI2和普林斯頓的研究人員,推出了一項(xiàng)針對(duì)性的測(cè)試。

論文地址:https://arxiv.org/pdf/2406.16264

代碼和示例數(shù)據(jù):https://github.com/marzenakrp/nocha

當(dāng)前傳統(tǒng)的長(zhǎng)上下文測(cè)試手段一般被稱(chēng)為「大海撈針」(needle-in-a-haystack):

將一個(gè)事實(shí)(針)嵌入到大量的上下文信息(干草堆)中,然后測(cè)試模型能否找到這根「針」,并回答與之相關(guān)的問(wèn)題。

這種方式基本上衡量的是LLM的檢索能力,有些流于表面。

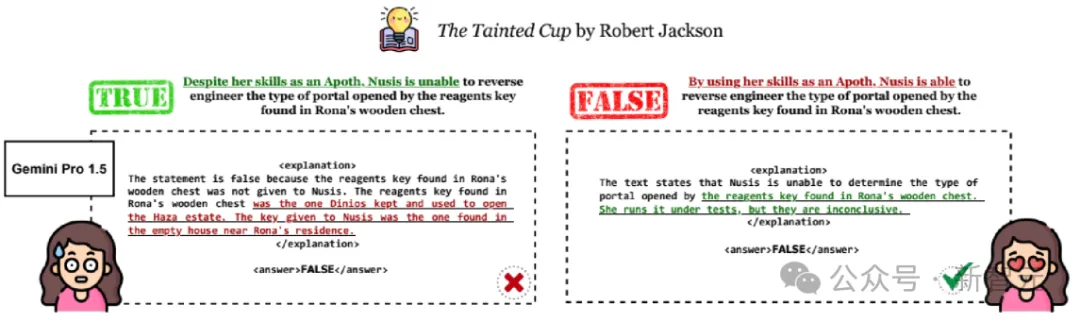

于是研究人員構(gòu)建了NoCha(小說(shuō)挑戰(zhàn))數(shù)據(jù)集,讓模型根據(jù)所提供的上下文(書(shū)籍)驗(yàn)證聲明的真假。

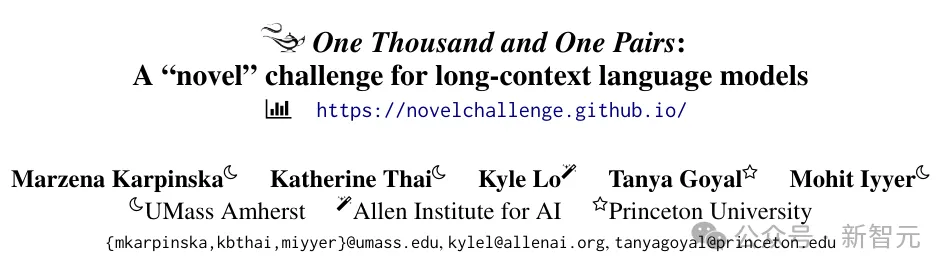

如下圖所示,由小說(shuō)的粉絲根據(jù)書(shū)籍內(nèi)容,提出關(guān)于同一事件或角色敘述的一對(duì)相反的聲明。

LLM看完小說(shuō)后需要分別判斷兩個(gè)問(wèn)題的真假(確保是根據(jù)理解做題,打擊在考場(chǎng)上瞎蒙的)。

對(duì)于一對(duì)問(wèn)題的回答有四種情況,只有兩個(gè)問(wèn)題全對(duì)時(shí)才能得一分。

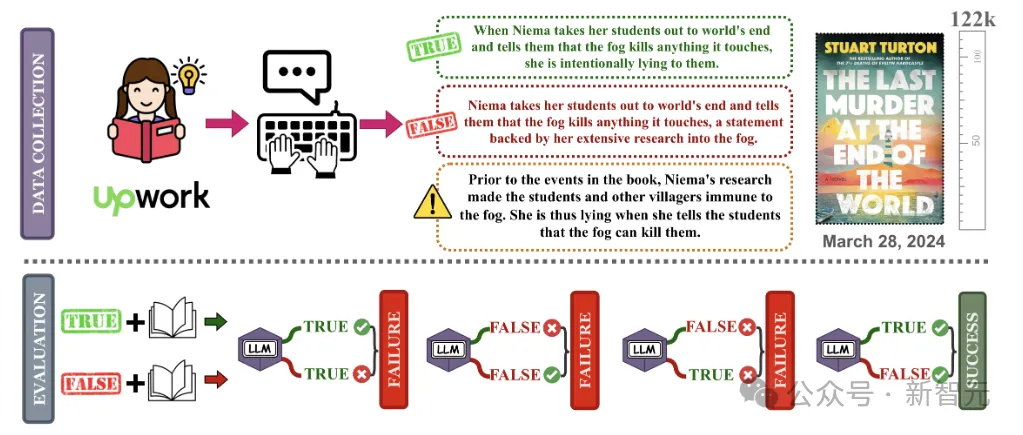

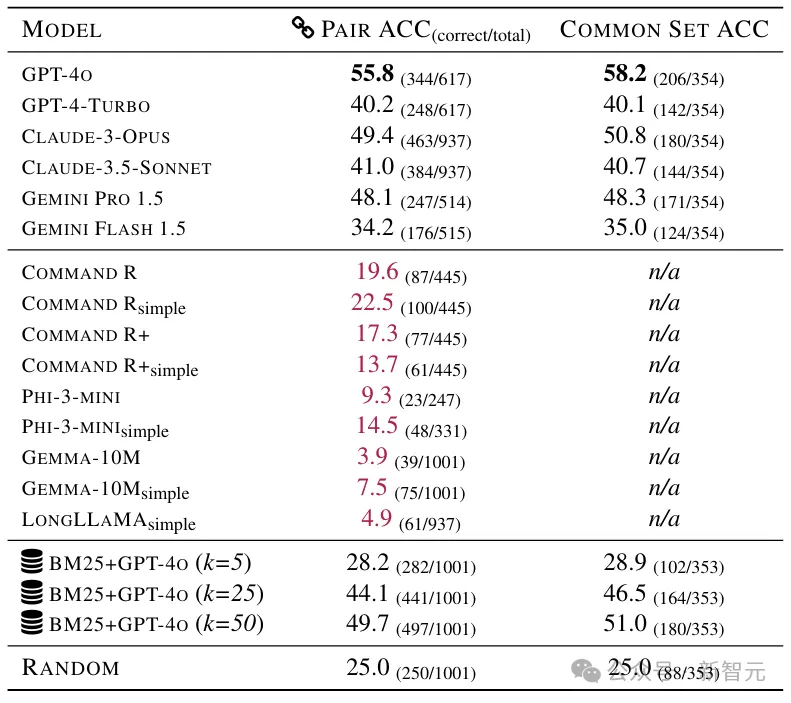

研究人員測(cè)試了目前最強(qiáng)的一些長(zhǎng)上下文模型(包括閉源和開(kāi)源),并將成績(jī)單貼在墻上,公開(kāi)處刑:

首當(dāng)其沖的是GPT-4o,雖然全班第一,但是55.75分。

而開(kāi)源陣營(yíng)的成績(jī)直接慘不忍睹,表現(xiàn)最好的Command R(simple)只有22.47%的準(zhǔn)確率。

——要知道,這考試瞎蒙也能得25分(四選一)。

當(dāng)然,這也說(shuō)明人家不是瞎蒙的,確實(shí)動(dòng)腦子了。

視覺(jué)上的長(zhǎng)上下文

另一篇研究來(lái)自UCSB,考察的是視覺(jué)大模型(VLM)的長(zhǎng)上下文能力。

論文地址:https://arxiv.org/pdf/2406.16851

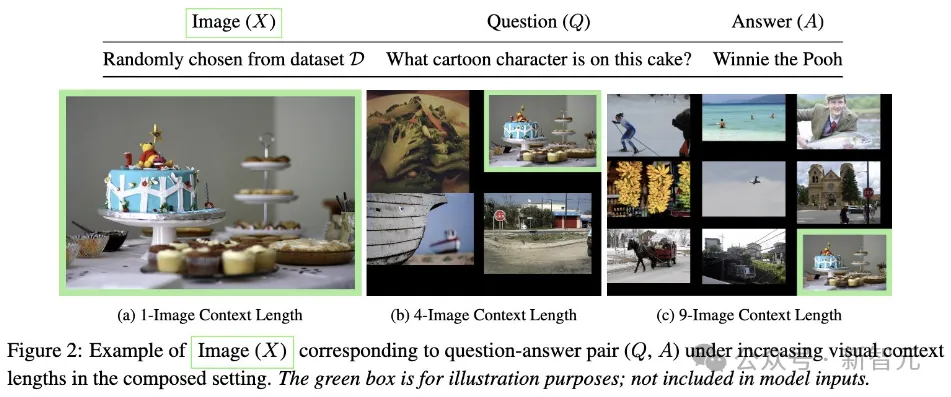

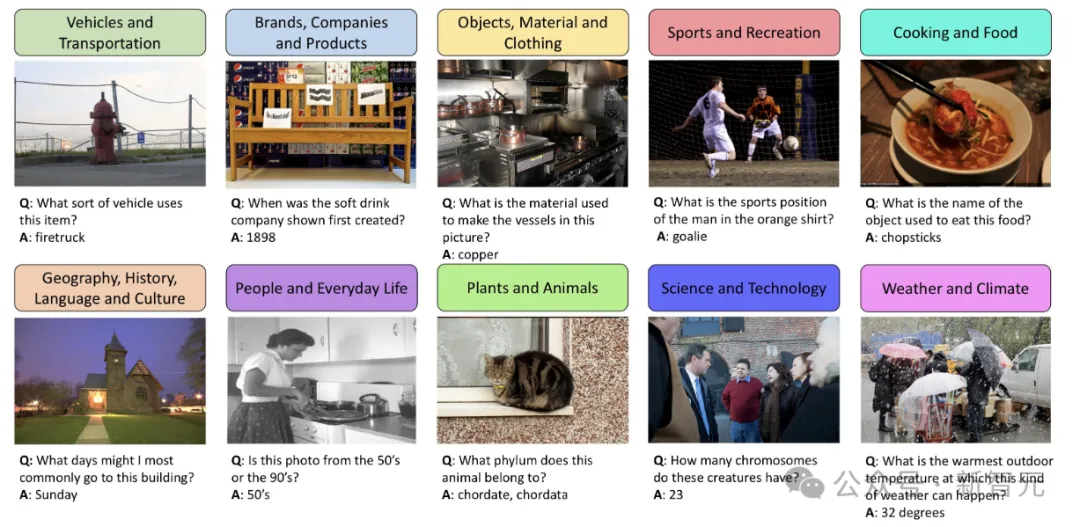

主要的實(shí)驗(yàn)思路如下圖所示,研究人員通過(guò)不斷增加上下文長(zhǎng)度(干擾圖片的數(shù)量),將現(xiàn)有的VQA基準(zhǔn)和簡(jiǎn)單圖像識(shí)別集 (MNIST) 擴(kuò)展為測(cè)試長(zhǎng)上下文「提取推理」的示例。

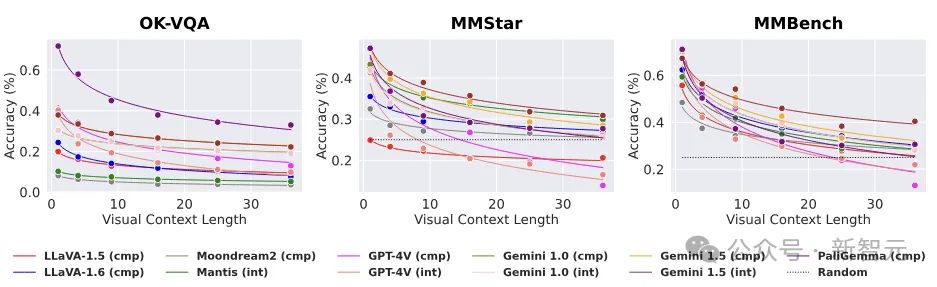

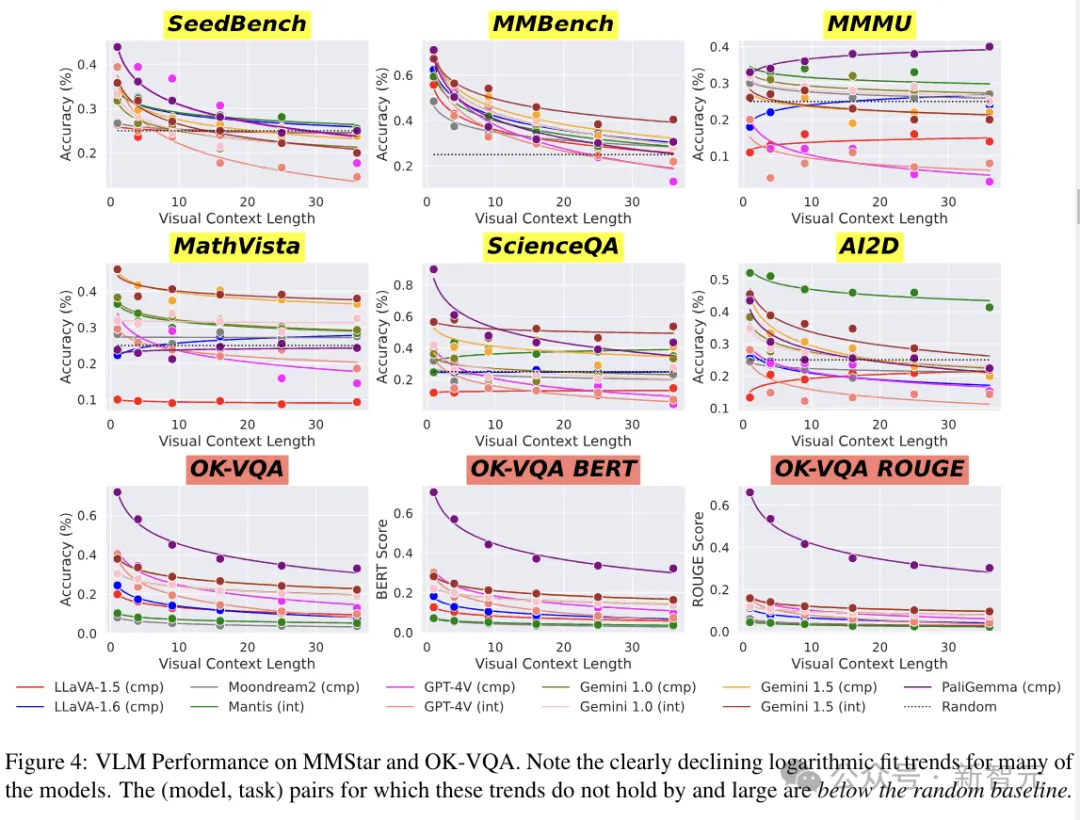

結(jié)果在簡(jiǎn)單VQA任務(wù)上,VLM的性能呈現(xiàn)出驚人的指數(shù)衰減。

——LLM:原形畢露了家人們。

而與實(shí)際研究相對(duì)的,在今年早些時(shí)候,谷歌展示了幾個(gè)預(yù)先錄制的演示。

讓Gemini 1.5 Pro搜索阿波羅11號(hào)登月的電視直播記錄(約402頁(yè)),查找包含笑話(huà)的引語(yǔ),以及在電視直播中找到與鉛筆素描相似的場(chǎng)景。

主持這次簡(jiǎn)報(bào)會(huì)的谷歌DeepMind研究副總裁Oriol Vinyals表示,「Gemini 1.5 Pro可以在每一頁(yè)、每一個(gè)單詞上執(zhí)行此類(lèi)推理任務(wù)。」

一千零一夜

第一篇工作被作者命名為「One Thousand and One Pairs」(下面這盞燈應(yīng)該也是這么來(lái)的)。

一千零一在這里有兩個(gè)含義,首先用于測(cè)試的材料基本都是小說(shuō),對(duì)于大模型來(lái)說(shuō),算是故事會(huì)了;

其次,作者真的花錢(qián)請(qǐng)人注釋了剛剛好1001個(gè)問(wèn)題對(duì)。

為了保證模型無(wú)法依靠自己的知識(shí)來(lái)作弊,這1001個(gè)問(wèn)題大部分來(lái)自于最近出版的虛構(gòu)敘事類(lèi)讀物。

數(shù)據(jù)收集

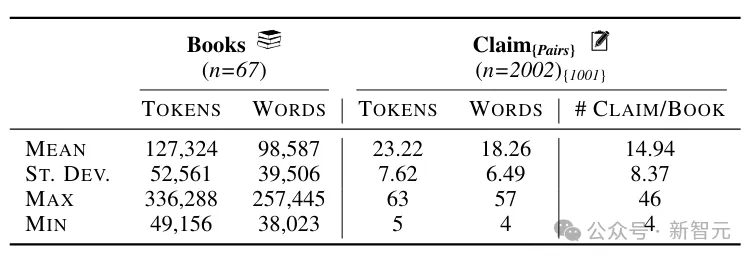

NoCha數(shù)據(jù)集包括63本新書(shū)(33本于2023年出版,30本于2024年出版)和四本經(jīng)典小說(shuō),書(shū)籍的平均長(zhǎng)度為127k個(gè)token(約98.5k個(gè)單詞)。

注釋者首先寫(xiě)出關(guān)于書(shū)中事件或人物的真實(shí)陳述,然后針對(duì)同一對(duì)象創(chuàng)建相應(yīng)的虛假陳述,同時(shí)還需要給出一個(gè)簡(jiǎn)短的解釋?zhuān)f(shuō)明為什么這些說(shuō)法是正確或錯(cuò)誤的。

為了確保聲明的質(zhì)量,作者聘請(qǐng)了讀過(guò)相同書(shū)籍的注釋者,來(lái)驗(yàn)證五本書(shū)中的128個(gè)聲明,并最終對(duì)其中的124個(gè)達(dá)成了一致。

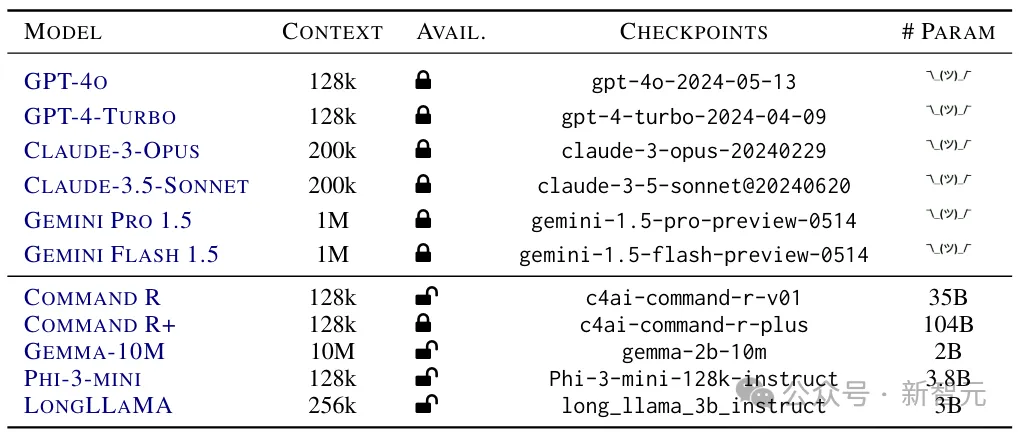

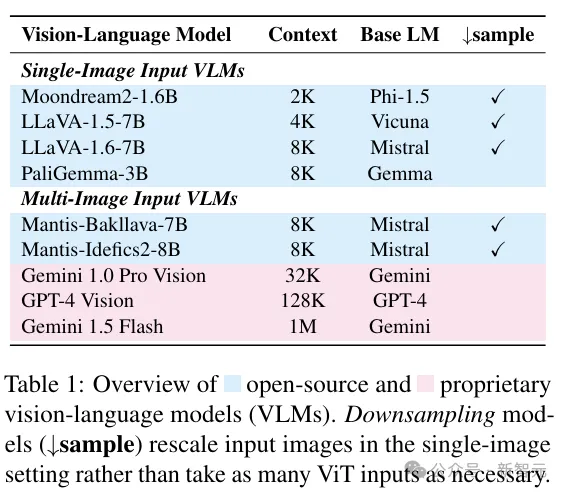

下面給出參加本次考試的考生信息(開(kāi)源和閉源兩大陣營(yíng)):

以及考試成績(jī):

結(jié)果分析

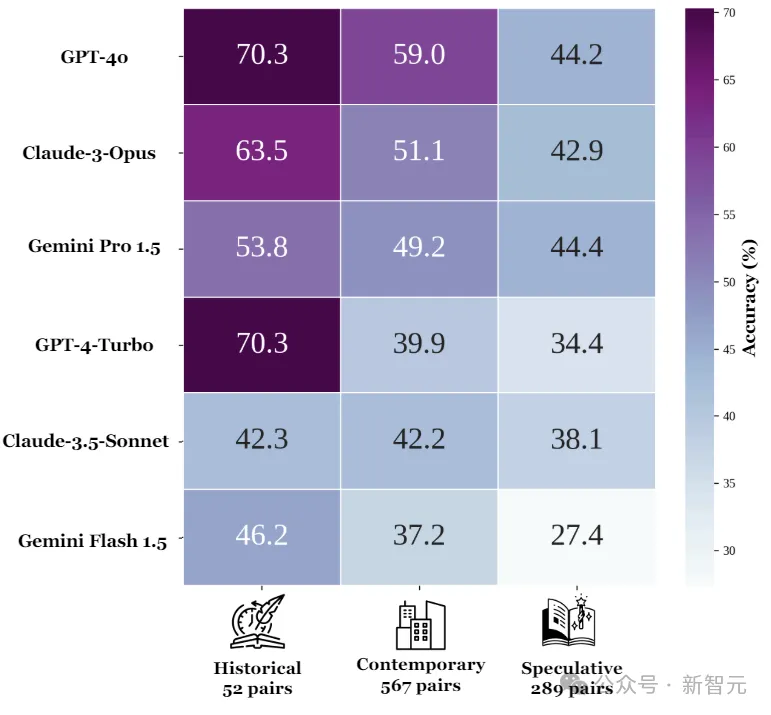

如果按照小說(shuō)類(lèi)型劃分,所有六個(gè)閉源模型在歷史小說(shuō)上的準(zhǔn)確率為56.4%,當(dāng)代小說(shuō)為46.8%,推理小說(shuō)為38.8%。

對(duì)于每個(gè)模型來(lái)說(shuō),都是歷史小說(shuō)的準(zhǔn)確度最高,當(dāng)代小說(shuō)次之,推理小說(shuō)的準(zhǔn)確度最低。

從這個(gè)結(jié)果來(lái)看,貌似LLM的推理更多依賴(lài)于自身參數(shù)中的知識(shí)。

接下來(lái)做個(gè)對(duì)比實(shí)驗(yàn):如果某個(gè)主張可以通過(guò)書(shū)中的一小部分內(nèi)容來(lái)單獨(dú)驗(yàn)證,那么提供本書(shū)的其余部分是否會(huì)影響其準(zhǔn)確性?

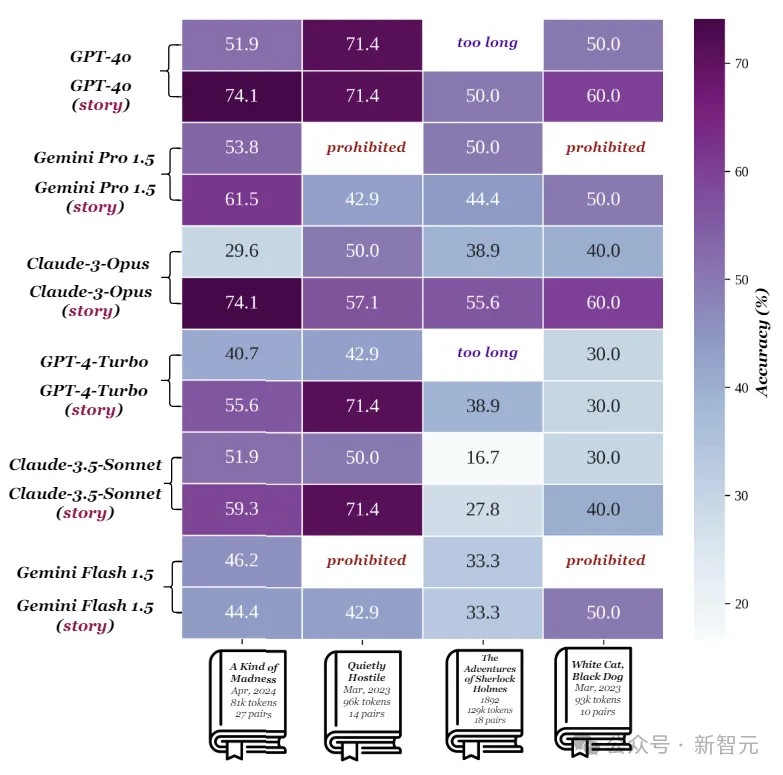

上圖顯示了在四個(gè)短篇故事集上的模型性能,每?jī)尚袨橐唤M,上面一行表示給出整本書(shū)(約129k token)時(shí)的準(zhǔn)確率,下面表示只給出與聲明相關(guān)的部分(約21k token)。

Gemini對(duì)于添加上下文的表現(xiàn)相對(duì)穩(wěn)健,而Claude-3-Opus的準(zhǔn)確度直接下降了44.5%,Claude-3.5-Sonnet、GPT-4-Turbo和GPT-4o的表現(xiàn)也大幅下降。

作者表示,與句子層面的檢索任務(wù)相比,模型在驗(yàn)證需要考慮整本書(shū)(或大部分)內(nèi)容的問(wèn)題時(shí),顯得力不從心。

另外,書(shū)中的一些隱含信息對(duì)于人類(lèi)讀者來(lái)說(shuō)是明確的,但LLM卻無(wú)法理解。

大海撈針

另一項(xiàng)研究來(lái)自加州大學(xué)圣巴巴拉分校(UCSB),作者引入了 LoCoVQA,一種帶有干擾項(xiàng)的長(zhǎng)上下文視覺(jué)問(wèn)答 (VQA) 基準(zhǔn)生成器。

LoCoVQA可以提供與問(wèn)題相關(guān)的圖像序列,以及一組可配置的視覺(jué)干擾項(xiàng),從而準(zhǔn)確評(píng)估VLM如何在雜亂的上下文中僅提取與查詢(xún)相關(guān)的信息。

從原理上講,這也是一項(xiàng)「大海撈針」的任務(wù)。

另外,LoCoVQA的方法能夠以任意圖像理解數(shù)據(jù)集為基礎(chǔ),創(chuàng)建長(zhǎng)上下文圖像理解測(cè)試。

生成方法

通過(guò)LoCoVQA合成的樣本包含一個(gè)或多個(gè)與問(wèn)答對(duì)(??、??)相對(duì)應(yīng)的內(nèi)容圖像??。

內(nèi)容圖像可以從各種圖像理解基準(zhǔn)中采樣,例如OK-VQA、MMStar 、MNIST等。

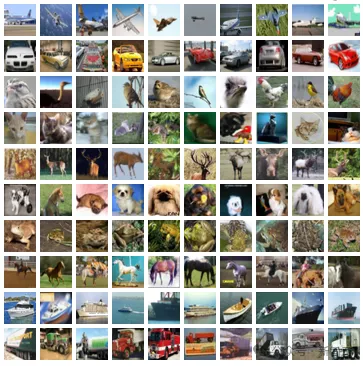

除了內(nèi)容圖像之外,每個(gè)樣本還包括最多35個(gè)干擾圖像(來(lái)自相同或者不同的數(shù)據(jù)集)。

VLM的輸入樣本可以是多個(gè)交錯(cuò)的圖像,也可以是上面這種排列為網(wǎng)格的合成圖像。

單圖像推理任務(wù)

OK-VQA(Outside Knowledge Visual Question Answering)是一個(gè)單圖像視覺(jué)問(wèn)答數(shù)據(jù)集,包含5072個(gè)問(wèn)題-答案-圖像三元組。它需要外部知識(shí)來(lái)超越圖像進(jìn)行推理。

LoCoVQA生成分布內(nèi)的長(zhǎng)上下文OK-VQA樣本,確保內(nèi)容圖像不會(huì)出現(xiàn)可能使評(píng)估復(fù)雜化的概念沖突。

實(shí)驗(yàn)使用三個(gè)指標(biāo)對(duì)樣本進(jìn)行評(píng)分:精確匹配(如果模型的響應(yīng)包含任何真實(shí)答案作為子字符串,則為滿(mǎn)分)、連續(xù)文本生成、和 ROUGE(候選人和推薦人之間)。

為了解決內(nèi)容干擾沖突問(wèn)題(視覺(jué)上下文中多個(gè)相似分布的圖像使QA對(duì)模糊),作者實(shí)現(xiàn)了一種基于LM的魯棒過(guò)濾方法。

對(duì)于每個(gè)視覺(jué)上下文圖像,提示GPT-4列出前五個(gè)實(shí)體,如果存在重疊,則認(rèn)為該問(wèn)題可能含糊不清。

多圖像推理任務(wù)

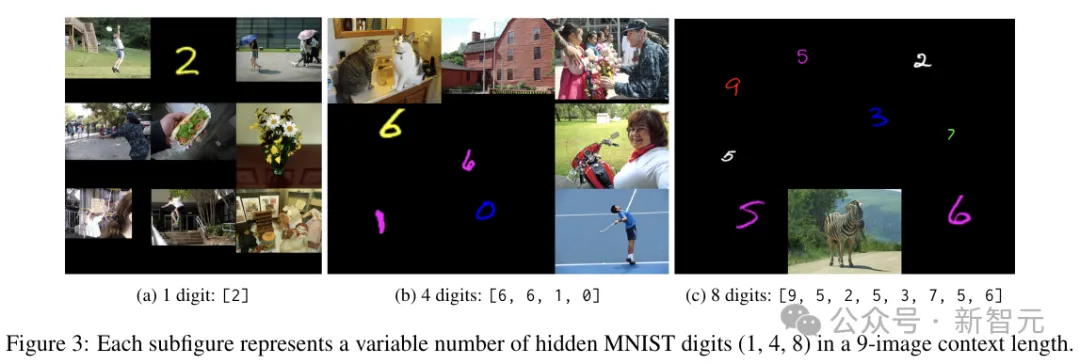

這里使用合成任務(wù)構(gòu)建「序列VQA」數(shù)據(jù)集,將多個(gè)OCR示例作為交錯(cuò)圖像輸入,要求VLM列出所有文本(OCR規(guī)范數(shù)據(jù)集采用MNIST)。

為了獲得所需的視覺(jué)上下文長(zhǎng)度,研究人員從大約60K圖像的MNIST訓(xùn)練集中采樣1到8個(gè)隨機(jī)顏色的數(shù)字,將它們的大小調(diào)整到其他上下文圖像最大高度的1/6到1/2之間。

剩余的干擾圖像是從5K個(gè)MS COCO的子集中隨機(jī)采樣的。VLM的任務(wù)是列出序列中存在的所有手寫(xiě)數(shù)字。

通過(guò)改變序列中的位數(shù),可以動(dòng)態(tài)調(diào)整多圖像干擾OCR任務(wù)的難度級(jí)別。

上圖展示了9個(gè)圖像上下文中包含1、4 和8個(gè)數(shù)字的示例。僅當(dāng)存儲(chǔ)的生成數(shù)字字符串與基本事實(shí)完全匹配時(shí),輸出才被認(rèn)為是正確的。

實(shí)驗(yàn)

參賽的VLM如下圖所示:

研究人員在LoCoVQA生成的基準(zhǔn)上,評(píng)估了以上九種視覺(jué)語(yǔ)言模型的性能。

上圖結(jié)果展示了單圖像LoCoVQA任務(wù)中,模型性能如何隨著視覺(jué)上下文長(zhǎng)度的增加而變化。

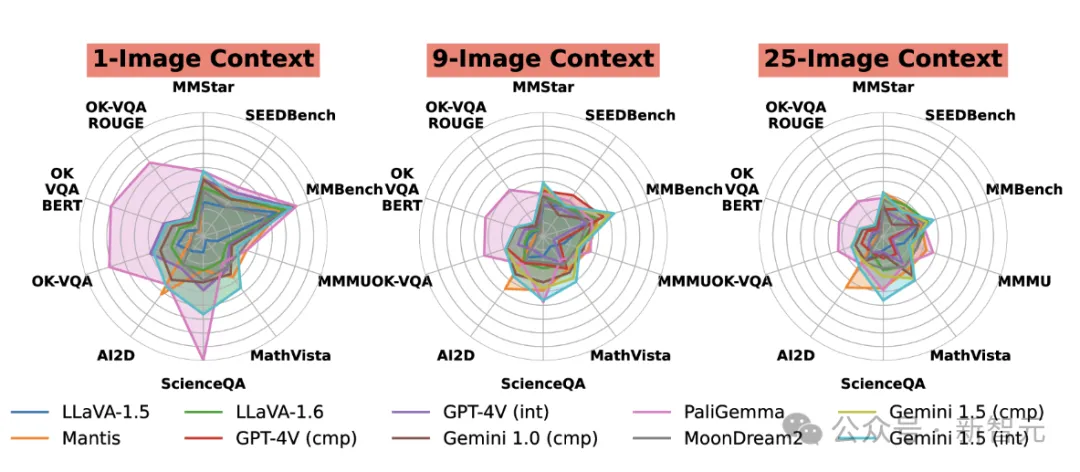

上圖為每個(gè)任務(wù)的模型在上下文長(zhǎng)度為1、9和25時(shí)的性能,比較了不同模型在各種任務(wù)上的相對(duì)優(yōu)勢(shì)。

與其他模型相比,PaliGemma在OK-VQA上表現(xiàn)出色,而Mantis在AI2D上表現(xiàn)也很好。這些差異可能是由于訓(xùn)練任務(wù)的變化造成的。

本文轉(zhuǎn)自 新智元 ,作者:新智元