LLM合集:MiniMax-01 開源,性能比肩 GPT-4o,上下文窗口領先 20-32 倍

1.MiniMax-01: Scaling Foundation Models with Lightning Attention

我們推出了 MiniMax-01 系列,包括 MiniMax-Text-01 和 MiniMax-VL-01。這兩款產品不僅性能可與頂尖模型相媲美,而且在處理更長文本上下文方面具備卓越能力。其核心技術是Lightning Attention及其高效的擴展方法。為充分發揮計算能力,我們將其與混合專家(MoE)技術相結合,打造出擁有 32 個專家模塊、共計 4560 億參數的模型,每個Token激活 459 億參數。針對 MoE 和閃電注意力機制,我們開發了優化的并行策略以及高效的計算 - 通信重疊技術。通過這種方式,我們能夠在包含數百億參數的模型上,對數百萬Token長度的上下文進行高效的訓練與推理。MiniMax-Text-01 在訓練時上下文窗口可達 100 萬個Token,推理時以較低成本外推至 400 萬個Token。我們的視覺 - 語言模型 MiniMax-VL-01 則通過使用 5120 億視覺 - 語言Token持續訓練構建而成。在標準和內部基準測試中,我們的模型性能與 GPT-4o、Claude-3.5-Sonnet 等最先進模型相當,但上下文窗口長度卻是它們的 20 - 32 倍。我們已在https://github.com/MiniMax-AI上公開發布 MiniMax-01 。

論文: ??https://arxiv.org/pdf/2501.08313??

2. Diffusion Adversarial Post-Training for One-Step Video Generation

擴散模型在圖像和視頻生成領域應用廣泛,但其迭代生成過程緩慢且成本高昂。盡管現有的蒸餾方法已在圖像領域展現出一步生成的潛力,但生成質量仍顯著下降。在本文中,我們提出在擴散預訓練之后,針對真實數據采用對抗后訓練(APT)方法,實現一步視頻生成。

為提升訓練穩定性和生成質量,我們對模型架構和訓練流程進行了多項改進,并引入了近似的 R1 正則化目標。實驗表明,經對抗后訓練的模型 Seaweed - APT,能夠在單步前向評估中實時生成 2 秒時長、分辨率為 1280×720、幀率 24fps 的視頻。此外,該模型還能一步生成 1024 像素的圖像,生成質量與當前最先進的方法相當。

論文: ??https://arxiv.org/pdf/2501.08316??

3.MangaNinja: Line Art Colorization with Precise Reference Following

MangaNinjia 源于擴散模型,專門用于參考引導的線稿上色任務。為確保精準轉錄角色細節,我們融入了兩項精心設計:一是補丁混洗模塊,助力參考彩色圖像與目標線稿之間的對應關系學習;二是點驅動控制方案,實現精細的色彩匹配。在自行收集的基準數據集上進行的實驗表明,我們的模型在精準上色方面優于當前的其他解決方案。我們還展示了所提出的交互式點控制在處理復雜情況、跨角色上色、多參考圖像協調等方面的潛力,這些都是現有算法難以企及的。

論文: ??https://arxiv.org/pdf/2501.08332??

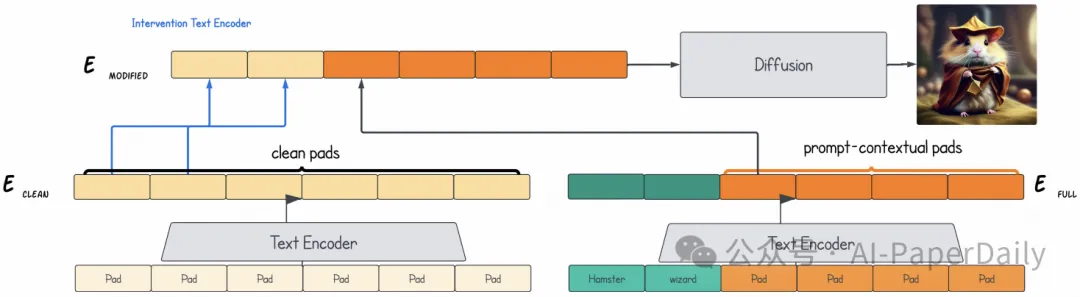

4.Padding Tone: A Mechanistic Analysis of Padding Tokens in T2I Models

文本轉圖像(T2I)擴散模型依靠編碼后的提示詞來引導圖像生成過程。通常,在對文本進行編碼之前,這些提示詞會通過添加填充標記擴展到固定長度。盡管這是一種默認做法,但填充標記對圖像生成過程的影響卻從未有人研究過。在這項研究中,我們首次深入分析了填充標記在 T2I 模型中所起的作用。

我們開發了兩種因果分析技術,用于剖析在 T2I 流程的不同組件中,信息是如何編碼到標記表示中的。借助這些技術,我們探究了填充標記何時以及如何影響圖像生成過程。我們的研究結果揭示了三種不同的情況:填充標記可能在文本編碼階段、擴散過程中影響模型輸出,或者被模型有效忽略。此外,我們還明確了這些情況與模型架構(交叉注意力或自注意力)及其訓練過程(文本編碼器凍結或訓練)之間的關鍵聯系。 這些見解有助于我們更深入地理解填充標記的作用機制,有望為未來 T2I 系統的模型設計和訓練方法提供參考。

論文: ???https://arxiv.org/pdf/2501.06751??

本文轉載自??AI-PaperDaily??,作者: AI-PaperDaily ????