BERT如何增強NLP的性能 原創

BERT通過使用其雙向方法幫助機器理解人類語言的場景,從而增強NLP的性能。本文探討BERT如何實現這一目標。

大型語言模型(LLM)對人類語言的理解和處理起到了重要的催化作用。自然學習處理(NLP)彌合了人類與機器之間的溝通鴻溝,帶來了無縫的客戶體驗。

NLP對于解釋具有直接意圖的簡單語言非常有用。但是,當涉及到解釋由同音異義詞、同義詞、反義詞、諷刺等引起的文本歧義時,它還有很長的路要走。

“來自Transformers的雙向編碼器表示”(BERT)通過幫助NLP理解給定句子中每個單詞的場景和含義,在增強NLP性能方面發揮了關鍵作用。

以下理解BERT的工作原理及其在NLP中的重要作用。

一、理解BERT

BERT是谷歌公司為NLP開發的開源機器學習框架。它通過使用雙向方法為給定文本提供適當的場景來增強NLP。它從文本的兩端(即前面和后面)的單詞進行分析。

BERT的雙向方法幫助它產生精確的單詞表示。通過生成單詞、短語和句子的深度場景表示,BERT提高了NLP在各種任務中的表現。

二、BERT的工作原理

BERT的卓越性能可歸功于其基于Transformers的架構。Transformers是一種神經網絡模型,在處理順序數據(例如語言處理)的任務中表現得非常好。

BERT采用多層雙向Transformer編碼器對單詞進行串聯處理。Transformer可以捕捉句子中的復雜關系,以理解語言的細微差別。它還能捕捉到意義上的細微差異,這些差異會顯著改變句子的場景。這與NLP相反,NLP利用單向方法預測序列中的下一個單詞,可能阻礙場景學習。

BERT的主要目標是生成語言模型,因此它只使用編碼器機制。令牌按順序送入Transformers編碼器。它們首先被嵌入到向量中,然后在神經網絡中進行處理。生成一系列向量,每個向量對應一個輸入令牌,提供場景化表示。BERT部署了兩種訓練策略來解決這個問題:掩模語言模型(MLM)和下句預測(NSP)。

掩碼語言模型(MLM)

這種方法包括屏蔽每個輸入序列中單詞的某些部分。該模型接受訓練,根據周圍單詞提供的場景來預測被屏蔽單詞的原始值。

為了更好地理解這一點,看下這個例子:

“我在喝蘇打水。”(I am drinking soda)

在上面的句子中,如果把“喝”這個詞去掉,還可以使用哪些其他恰當的單詞?其他可以用的單詞還有“啜飲、分享、吮吸等”,但不能用“吃”、“切”等隨意的單詞。

因此,大型語言模型必須了解語言結構以選擇正確的單詞。為模型提供模型輸入,其中包含一個空白的單詞或以及應該存在的單詞。這個過程通過獲取文本并遍歷它來創建數據。

下句預測(NSP)

這個過程訓練一個模型來確定第二個句子是否符合第一個句子的含義。BERT預測第二個句子是否與第一個句子相連。這是通過使用分類層將[CLS]令牌的輸出轉換為2 x 1形狀的向量來實現的。

第二句出現在第一句之后的概率是通過SoftMax計算出來的。本質上,BERT模型包括將上述兩種方法一起訓練。這產生了一個健壯的語言模型,具有增強的功能,可以理解句子中的場景及其之間的關系。

三、BERT在NLP中的作用

BERT在NLP中起著不可缺少的作用。它在各種NLP任務中的作用概述如下:

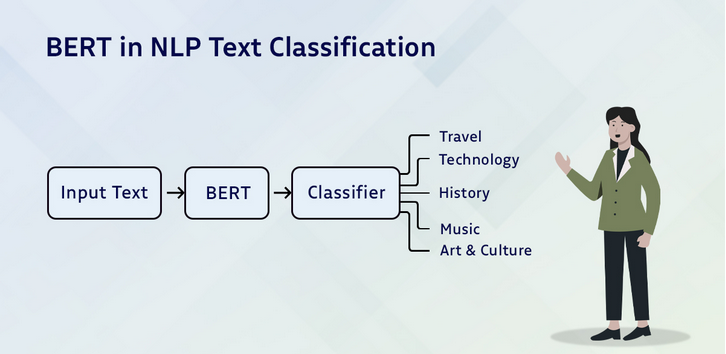

文本分類

文本分類用于情感分析,將文本分為積極、消極和中性。這里可以通過在Transformers輸出上添加一個分類層來使用BERT,即[CLS]令牌。這個令牌表示從整個輸入序列中收集的信息。然后,它可以用作分類層的輸入,以預測特定的任務。

問題回答

它可以通過獲取關于標記答案開始和結束的兩個額外向量的知識進行訓練來回答問題。BERT通過問題和附帶的段落進行訓練,使其能夠預測給定段落中答案的開始和結束位置。

命名實體識別(NER)

使用文本序列來識別和分類實體,例如人員、公司、日期等。通過從Transformer中獲取每個令牌的輸出向量來訓練NER模型,然后將其輸入分類層。

語言翻譯

用來翻譯語言,關鍵語言輸入和相關的翻譯輸出可用于訓練模型。

谷歌智能搜索

BERT利用一個Transformer同時研究多個令牌和句子,使谷歌引擎能夠識別搜索文本并產生相關結果的目標。

文本摘要

BERT為抽取和抽象模型推廣了一個流行的框架。前者通過識別文檔中最重要的句子來創建摘要。相比之下,后者使用新句子來創建摘要,這包括重新措辭或使用新詞,而不僅僅是提取關鍵句子。

四、BERT NLP模型的優缺點

作為一個大型語言模型,BERT有其優點和缺點。為了清楚起見,需要參考以下幾點:

優點

- BERT的多種語言訓練使其非常適合用于英語以外的項目。

- 對于特定于任務的模型來說,這是一個很好的選擇。

- 由于BERT是用大量的數據庫進行訓練的,因此它很容易用于小型、定義明確的任務。

- BERT可在微調之后立即使用。

- 頻繁更新,準確性高。

缺點

- BERT規模巨大,因為它接受了大量數據的訓練,這影響了它如何預測和從數據中學習。

- 考慮到它的大小,其成本高昂,需要更多的計算。

- BERT對下游任務進行了微調,這些任務往往比較繁瑣。

- 訓練BERT很耗時,因為它有很多權重,需要更新。

- BERT在訓練數據中容易出現偏差,人們需要意識到并努力克服這些偏差,以創建具有包容性和道德性的人工智能系統。

五、BERT NLP模型的未來趨勢

目前開發人員正在進行研究,以解決NLP中的挑戰,例如穩健性、可解釋性和倫理考慮。零樣本學習、少樣本學習和常識推理的進展將用于開發智能學習模型。

這些都有望推動NLP的創新,并為開發更智能的語言模型鋪平道路。這些版本將有助于解鎖洞察力,并加強專業領域的決策。

將BERT與人工智能和機器學習技術(如計算機視覺和強化學習)相結合,必將帶來一個創新和可能性的新時代。

結論

隨著BERT的不斷發展,先進的NLP模型和技術正在出現。BERT將通過增強人工智能理解和處理語言的能力,讓人工智能的未來發展具有更廣闊的前景。BERT的潛力遠遠超越了普通的NLP任務。

BERT模型正在為醫療保健、金融和法律開發專門的或特定于領域的模型版本,實現了對語言的場景理解。它是NLP的一個重要里程碑,在文本分類、命名實體識別和情感分析等多種任務上取得了突破。

原文標題:How BERT Enhances the Features of NLP,作者:Matthew McMullen

鏈接:https://dzone.com/articles/how-bert-enhances-the-features-of-nlp。