一種將RAG、KG、VS、TF結合增強領域LLM性能的框架

SMART-SLIC框架:旨在將RAG結合向量存儲(Vector Stores)、知識圖譜(Knowledge Graphs)和張量分解(Tensor Factorization)來增強特定領域的大型語言模型(LLMs)的性能。

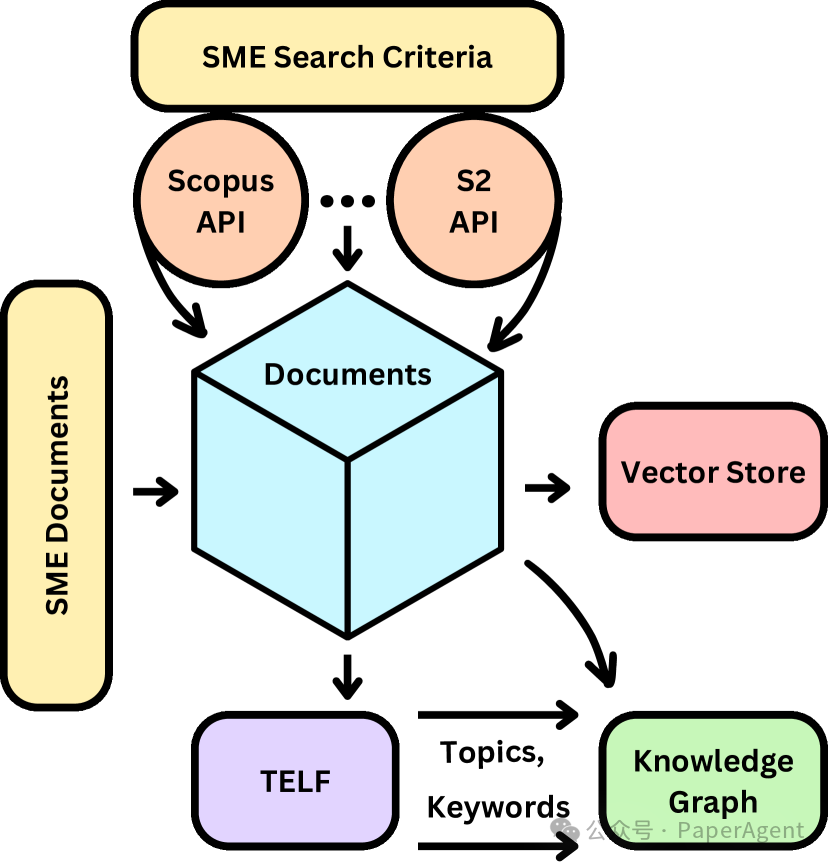

SMART-SLIC系統框架

SMART-SLIC框架的關鍵組成部分和操作流程:包括構建特定領域的數據集、知識圖譜本體論、向量存儲以及檢索增強生成(RAG)過程:

A. 特定領域的數據集:

- 項目從由主題專家(SMEs)選定的核心文檔開始,這些文檔代表了想要構建數據集的特定領域。

- 利用SCOPUS、Semantic Scholar和OSTI等授權API,通過引用和參考文獻網絡擴展數據集。

- 為了保持核心數據集的中心質量和主題一致性,采用了幾種修剪策略來刪除與核心文檔無關的文檔。

B. 降維:

- 通過非負張量分解從數據集中提取潛在結構,使用T-ELF工具進行文檔聚類,并自動確定最佳聚類數量。

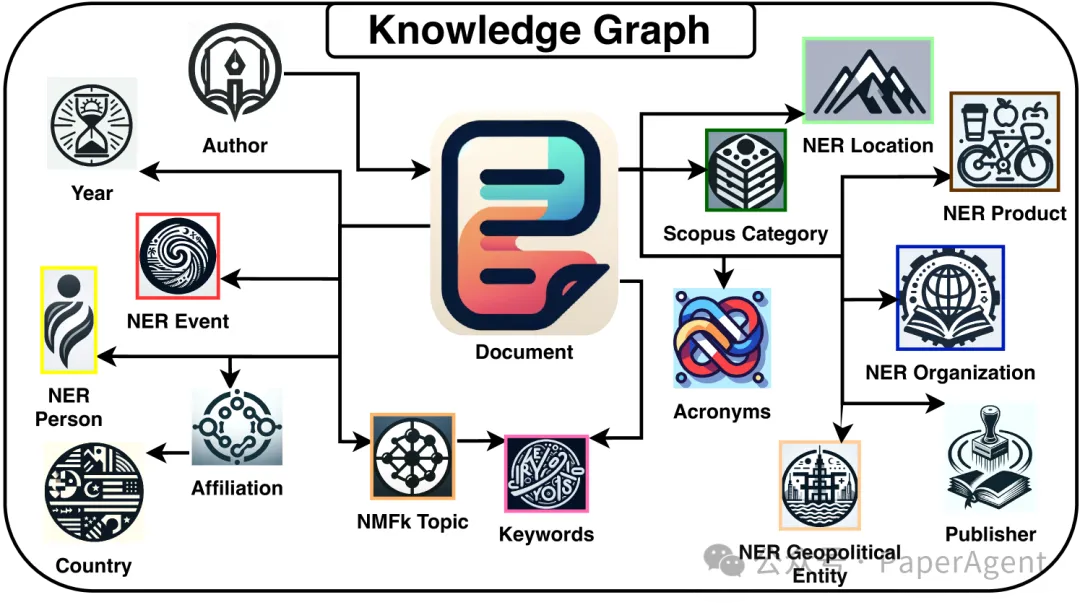

C. 知識圖譜本體論:

- 將T-ELF提取的特征和文檔元數據映射成一系列頭、實體和尾關系,形成方向三元組,然后注入Neo4j知識圖譜。

- 知識圖譜包含了文檔元數據以及從文檔中提取的潛在特征。

D. 向量存儲組裝:

- 將文檔向量化后存入Milvus向量數據庫,以支持RAG過程。

- 文檔的全文被分割成較小的段落,并且每個段落都被賦予一個整數ID,以指示其在原始文檔中的位置。

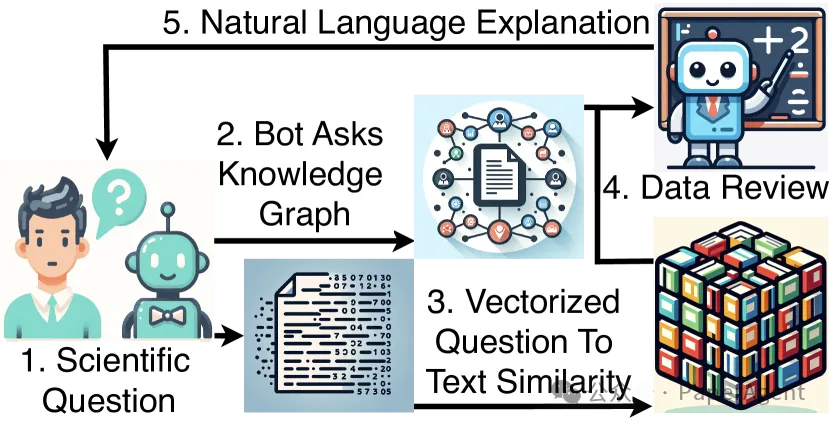

E. 檢索增強生成RAG:

- SMART-SLIC RAG實現:

SMART-SLIC框架中的RAG實現依賴于知識圖譜(KG)和向量存儲(VS)來提供結構化和非結構化的領域特定信息。

當用戶提出問題時,LLM首先將查詢轉化為向量嵌入,然后與現有文本進行比較以找到最相似的文本。

檢索到的信息被添加到原始查詢中,LLM利用這些上下文信息生成相關答案。

最后,LLM以自然語言構建最終答案,向用戶解釋答案。

RAG流程圖

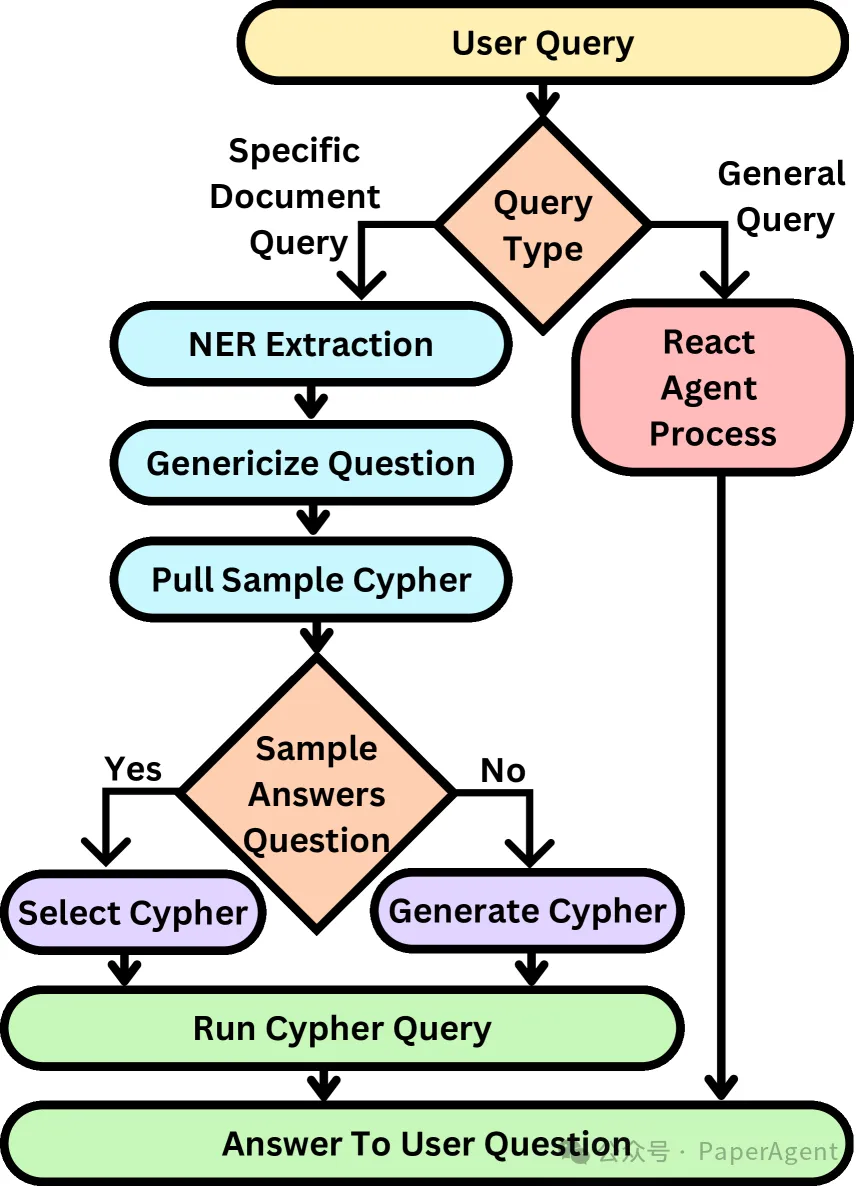

- 問題路由流程:?

SMART-SLIC采用問題路由流程來確定用戶查詢的類型,并根據查詢類型選擇相應的處理工具和流程。

問題分為“通用查詢”和“特定文檔查詢”。通用查詢調用ReAct Agent處理流程。

特定文檔查詢則調用檢索查詢或合成查詢。

理解用戶的問題對于將信息路由到適當的工具集和后續流程至關重要。

用戶查詢路由概覽

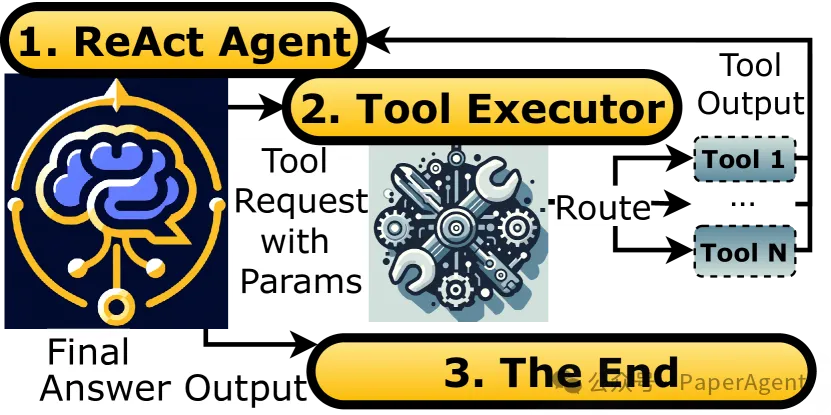

- ReAct Agent處理流程:?

ReAct Agent處理流程包括ReAct Agent、工具執行器和結束節點。

ReAct Agent負責收集輸入、做出可操作的決策并解釋結果。

工具執行器接收來自代理的工具名稱和輸入參數,調用相應的功能并返回輸出。

結束節點標志著Reason-Act循環的完成,將最終輸出返回給用戶。

ReAct Agent的節點和工具

SMART-SLIC框架在實際應用中的表現,并提供了評估結果:

A. 數據集:

- 初始選擇了30篇由主題專家(SME)挑選的、專注于大規模惡意軟件分析和異常檢測領域的文檔作為核心文檔。

- 通過引用和參考文獻網絡對數據集進行了兩次擴展,最終得到8790篇科學出版物構成的數據集。

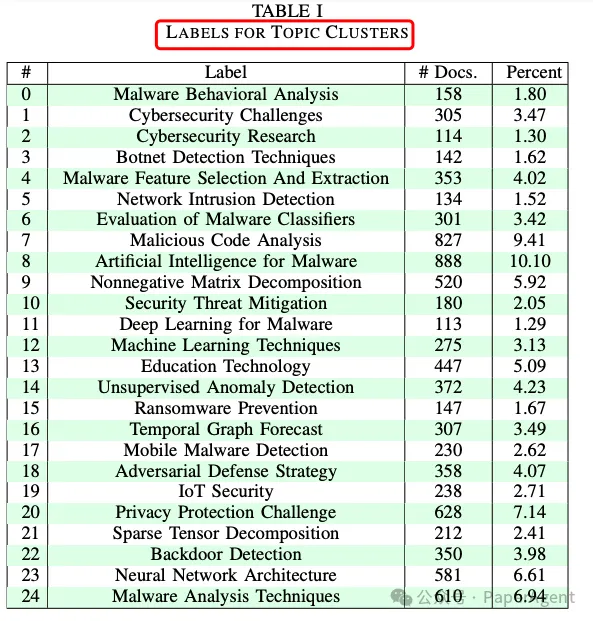

B. 潛在特征提取:

- 使用T-ELF對數據集進行張量分解,確定了25個主題聚類作為所有評估k值中的最佳劃分。

- 分解過程使用了高性能計算資源,整個過程大約耗時2小時。

C. 向量存儲:

- 將8790篇文檔向量化后存入Milvus向量數據庫。

- 其中22%的文檔有全文文本,這些也被向量化并存入Milvus。

D. 知識圖譜:

- 從T-ELF輸出的25個聚類中,格式化數據為1,457,534個三元組,并注入知識圖譜。

- 知識圖譜中包含了321,122個節點和1,136,412條邊關系。

知識圖譜Schema

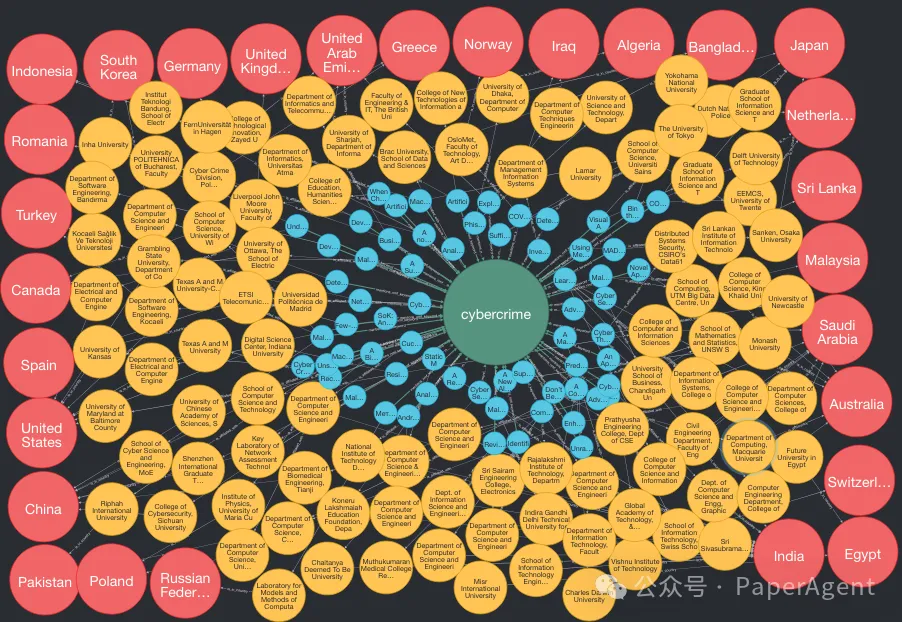

關鍵詞“網絡犯罪”的圖形搜索。返回單個關鍵詞(綠色)以及相關聯的文檔(淺藍色)。文檔還鏈接了附屬機構(黃色)和機構所在的國家(紅色)。

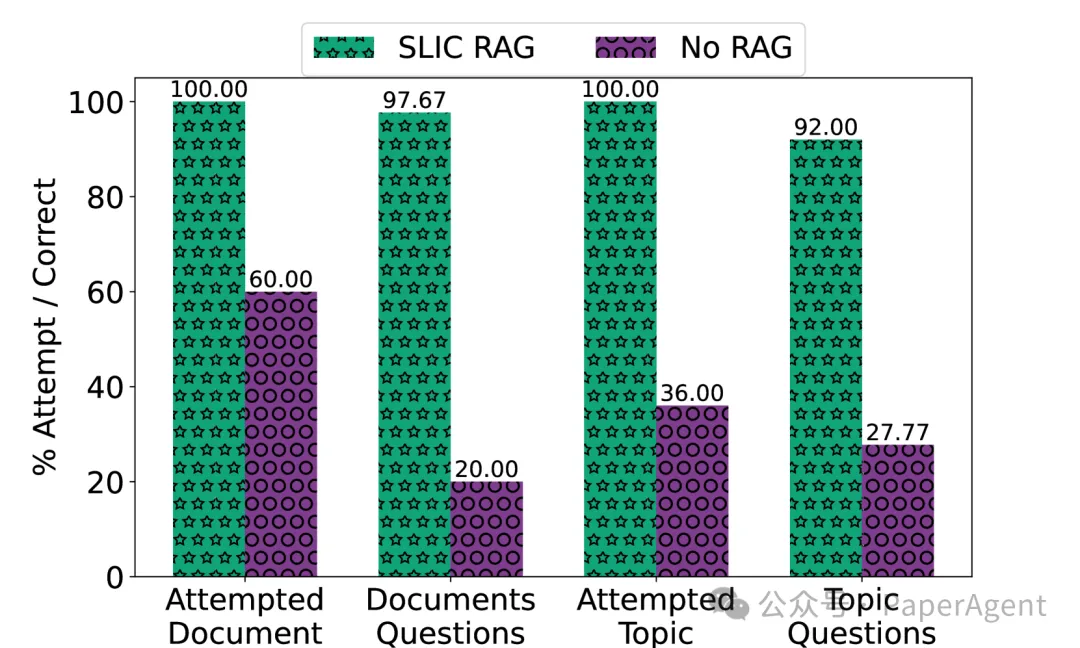

E. 問答驗證:

- 使用文檔特定問題和主題特定問題對系統進行了零樣本條件下的問答測試。

- 比較了使用GPT-4-instruct模型在有無RAG框架的情況下的回答性能。

- 結果顯示,使用RAG時,GPT-4-instruct模型回答問題的準確率達到97%,而沒有使用RAG時,模型有40%的問題未回答,回答的問題準確率僅為20%。

F. 復雜問題解答:

- 還測試了更復雜的問題,這些問題需要通過各種檢索方法進行徹底搜索。

- SME提出了幾個問題,使用SMART-SLIC RAG流程得到的回答與SME選擇的DOI一致,證明了代理在檢索相關來源方面的準確性。

- 沒有使用RAG時,LLM的回答不準確,存在編造答案的情況,且未提供DOI引用,降低了信息的可信度。?

兩種問題類型,文檔和主題,展示了使用SMART-SLIC RAG和不使用RAG時,LLM的嘗試百分比和正確百分比。

https://arxiv.org/pdf/2410.02721

Domain-Specific Retrieval-Augmented Generation

Using Vector Stores, Knowledge Graphs, and Tensor Factorization本文轉載自??PaperAgent??