谷歌開源Gemma Scope,更好解釋大模型工作原理

隨著多模態大模型的出現,內部神經網絡參數少則幾百億,多則上千億甚至過萬億,使得開發人員很難控制其輸出內容經常會出現各種“幻覺”,就是一本正經的胡說八道。

雖然稀疏自編碼器(簡稱“SAE”)是解決這些難題的主流方法,可以學習神經網絡潛在表示的稀疏分解,將其分解為可解釋的詞、短語等特征,能有效解釋大模型的工作原理與機制。但普通的SAE質量難以保證,并且訓練成本非常高。

所以,谷歌DeepMind針對其開源的Gemma 2模型訓練了特定的SAE——Gemma Scope。

Gemma Scope開源地址:https://huggingface.co/google/gemma-scope

Gemma 2 2B開源地址:https://huggingface.co/collections/google/gemma-2-2b-release-66a20f3796a2ff2a7c76f98f

Gemma-2-9b開源地址:https://huggingface.co/google/gemma-2-9b/tree/main

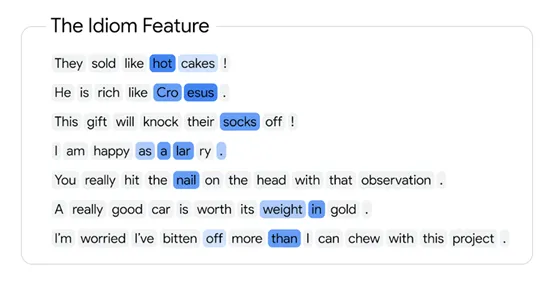

SAE是一種無監督學習方法,能幫助我們理解大模型內部的表示,并且這些特征往往與人類可理解的概念相關聯。例如,在處理文本數據時,SAE能學會識別“狗”這個詞背后的抽象概念,而不僅僅是字面上的字符組合。

這就好比在一堆混亂的線條中,SAE能幫我們找到那些構成“狗”的特征線條,能讓我們更直觀地理解模型是如何認識和生成“狗”這個字的。

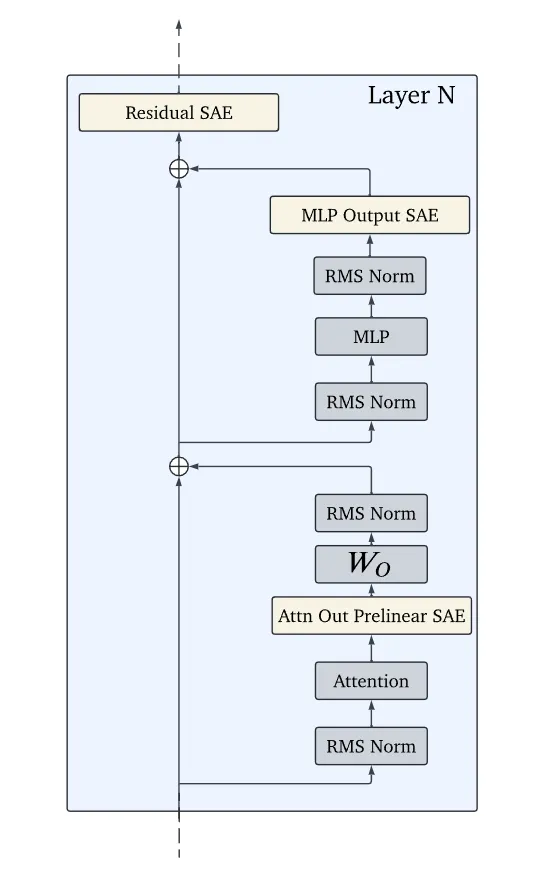

與其他SAE相比,Gemma Scope通過強制學習過程中的稀疏性,使得模型的內部表示中只有少數幾個關鍵特征被激活,而其余特征則保持為零。這種稀疏性不僅減少了模型的復雜度,還提高了其可解釋性,讓我們能夠更容易地識別和理解模型決策背后的關鍵因素。

Gemma Scope另外一大技術特點是其規模和全面性,研究人員在訓練的過程涉使用了海量的文本數據,每個SAE都是在4—160億個文本標記上進行訓練覆蓋了Gemma 2模型的所有層和子層。學習了超過3000萬個特征,一共訓練了超過400個SAE。

此外,Gemma Scope在訓練SAE時采用了一種特殊的激活函數JumpReLU。這種激活函數專為SAE設計,通過引入一個可學習的閾值來促進稀疏性,同時保持特征學習的效率和質量。

傳統ReLU函數的特點是在輸入小于零時輸出零,而在輸入大于零時保持線性。而JumpReLU在此基礎上引入了一個非線性的跳躍閾值,允許神經元在達到一定閾值后產生較大的跳躍響應,而不是簡單的線性響應。

這種跳躍響應機制增強了自編碼器對于關鍵稀疏特征的敏感度,使得模型能夠更加精準地捕捉那些在數據集中出現頻率低但信息含量高的特征。

此外,研究人員在訓練Gemma Scope的過程中,使用了大量優質數據來確保SAE的有效性。例如,在數據方面使用了與Gemma預訓練文本數據相同分布的文本,來訓練Gemma 2模型的激活。

在參數設置上,精心調整了學習率、帶寬、稀疏性系數等參數,以提升訓練效果。在基礎設施方面,使用了TPUv3、TPUv5p等加速器,并優化了數據管道,以提高訓練效率。

谷歌DeepMind表示,希望通過開源的Gemma Scope可以幫助開發人員更好地利用和了解SAE技術,有助于擴展到更多、更大的模型上,從而用在解釋思維鏈等更復雜的功能上,幫助更大參數的大模型解決幻覺、越獄攻擊等難題。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區