Stability.ai開源3D模型,僅需0.5秒就能快速生成

著名開源大模型平臺Stability.ai開源了3D生成模型——Stable Fast 3D(以下簡稱“SF3D”)。

用戶通過圖片僅需0.5秒就能快速生成高質量3D模型,還包括UV展開網格、材質參數、具有減少照明烘焙的反照率顏色,以及可選的四邊形或三角形重網格等,這也是目前最快的3D生成模型。

開源地址:https://github.com/Stability-AI/stable-fast-3d

huggingface:https://huggingface.co/stabilityai/stable-fast-3d

在傳統(tǒng)的3D重建模型中,變換器通常輸出較低分辨率的Triplane表示,這會導致在高頻和高對比度紋理場景中出現明顯的混疊偽影,在實際應用中效果較差需要頻繁的手動處理才能使用。

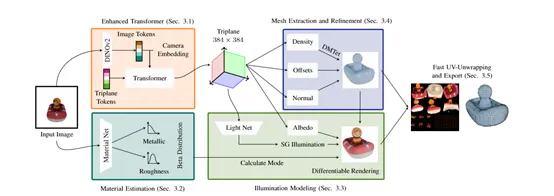

而SF3D是基于TripoSR架構,通過引入多個新模塊來改進輸出質量。增強的Transformer網絡預測更高分辨率的三平面,有助于減少混疊偽影。該網絡從DINO切換到改進的DINOv2以獲取圖像標記,低分辨率(64×64)的三平面會引入明顯偽影,而通過提高分辨率可以緩解這一問題。

還受PointInfinity的啟發(fā),增強的Transformer網絡輸出更高分辨率的三平面,例如,通過避免在更高分辨率三平面標記上的自注意力,使復雜度與輸入大小呈線性關系,從而產生96×96分辨率、1024通道的三平面,進一步通過打亂輸出特征的維度。

為了增強反射對象的輸出網格外觀,在渲染時生成更好的模型材質,SF3D通過 “Material Net”的網絡來實現這一點,該網絡從輸入圖像中預測整個物體的單一金屬和粗糙度值。

為了穩(wěn)定訓練并防止直接回歸時的網絡崩潰,SF3D采用了一種概率預測方法,預測Beta分布的參數,并通過最小化對數似然來訓練網絡。

SF3D還引入了“Light Net”的網絡來預測輸入圖像中的光照,從而解決因光照變化(如陰影)導致的問題。

Light Net通過使用從變換器得到的高分辨率Triplane來預測球形高斯照明圖。這種巧妙設計允許SF3D在渲染時考慮到3D空間關系和物體表面的照明變化,從而生成沒有混入光照效果的均勻物體。

SF3D使用了一種光照解耦損失函數,確保學習到的照明與訓練數據中觀察到的照明條件一致,從而解決了外觀和陰影之間的歧義。

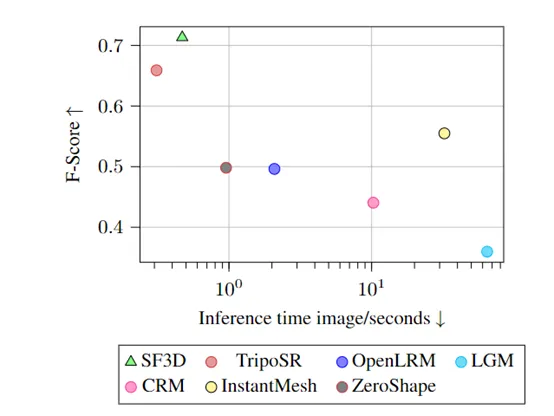

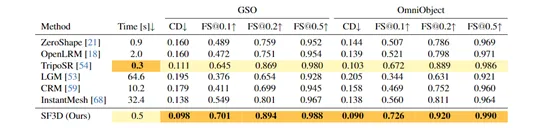

為了全面評估SF3D的性能,研究人員選擇了GSO和OmniObject3D作為主要的數據集。這些數據集包含了多種類型的3D對象,能夠充分測試SF3D在不同場景下的表現。為了確保測試的公正性和可比性,所有比較方法都在相同的硬件環(huán)境下運行。

并將SF3D與OpenLRM、TripoSR、LGM、CRM、InstantMesh和ZeroShape知名3D模型進行了綜合對比。結果顯示,SF3D優(yōu)于當前主流3D模型,能夠重建準確的形狀產生更詳細的紋理,并且視覺質量更高。

本文轉自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)