基于Llama 3.1和一臺MacBook搭建商用級知識庫

1、為什么要在 MacBook 上搭建知識庫?

最核心最重要的是我們手上的文檔資料出于安全要求,不能隨便上傳到云服務,也就無法實際驗證知識庫的實際效用。另外對于 IT 同學來說,自己親手搭建一個完整的方案、能靈活調整和對接各種不同的模型、評測各種模型不同的表現,也是出于對技術的探索本能使然。

使用的 MacBook 配置如下,對大模型經過量化處理(比如:int8)后,可以流暢運行。

圖片

圖片

2、知識庫的架構設計

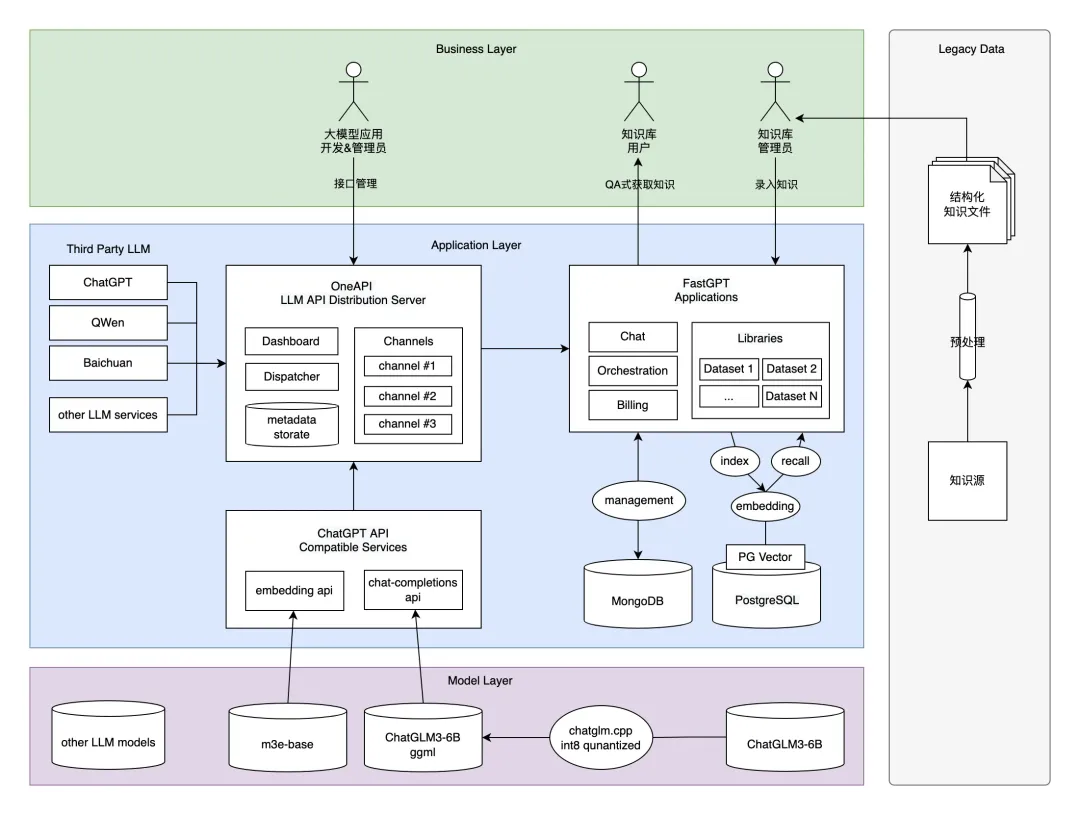

基于一臺 MacBook 搭建部署的架構設計如下圖,在這套架構設計中,我們采用了實力排上游、并且對企業和學術都友好的最新開源大模型 Llama 3.1。

并采用了基于 m3e-base 模型的 embedding search RAG 方案。基于這兩個模型封裝和 ChatGPT 兼容的 API 接口協議;通過引入 One API 接口管理 & 分發系統,形成統一 LLM 接口渠道管理平臺規范,并把封裝好的接口協議注冊進去;搭建與 Dify.ai 齊名開源大模型知識庫平臺管理系統 FastGPT,實現集私有知識數據源預處理、嵌入檢索、大模型對話一體的完整知識庫應用流程。

麻雀雖小五臟俱全,最終形成一套既滿足商用標準、又能在 MacBook 跑起來的的方案。雖然智能程度和實際需求還有一定差距,但至少我們在不用額外購買顯卡或云服務的情況下,以最小成本部署運行、并且能導入實際業務數據(如:設計文檔、業務流程文檔、項目管理文檔、技術分享文檔等等)進行實操驗證,值得每位工程師都來動手嘗試一下。

3、知識庫的部署設計

基于 MacBook 的部署方案分為四個主要環節、14個具體步驟,只要一步步實操下去,每位 IT 同學都可以在自己的 MacBook 上擁有屬于自己的私有大模型知識庫系統,步驟清單如下:

部分步驟可以簡單地通過 Docker 鏡像一鍵部署完成,但本著對細節一桿子插到底的部署思路,還是采取了純手工作業的方法。

本文轉載自公眾號玄姐聊AGI 作者:玄姐