Transformer 動畫揭秘:數據處理的四大關鍵技術 原創 精華

0、背景

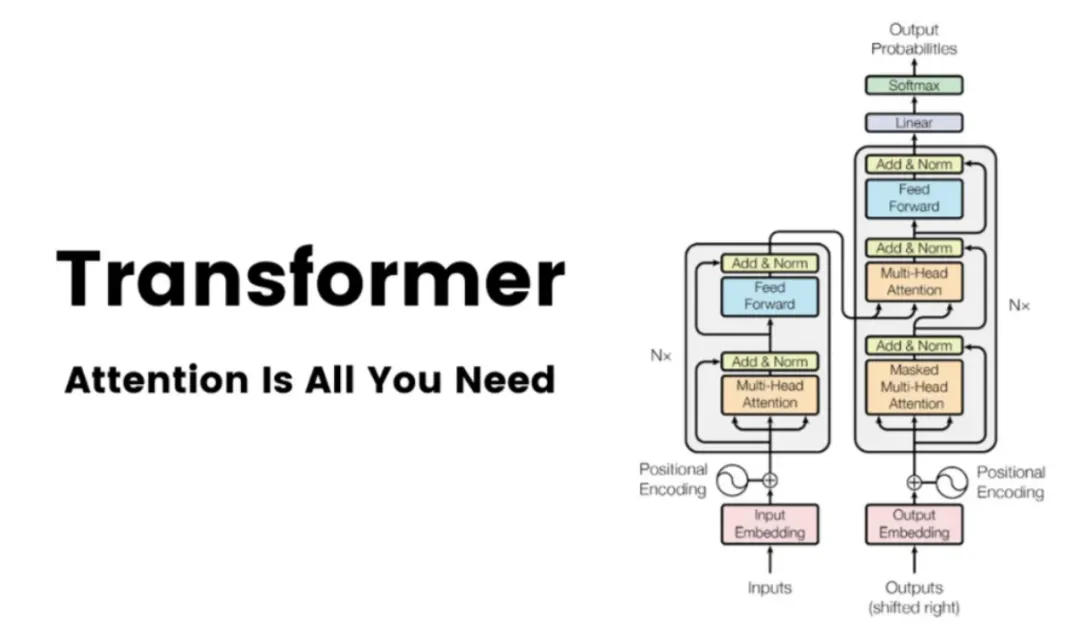

Transformer 大模型,一種基于自注意力機制的神經網絡架構,已被廣泛應用于各種自然語言處理任務,比如:機器翻譯、文本摘要、生成問答等。

從端到端的角度來看,Transformer 大模型中數據的處理流程主要包括四個階段:首先是嵌入階段(Embedding),隨后是注意力機制階段(Attention),然后是通過多層感知機(MLPs)進行處理,最后是從模型的表示轉換到最終輸出的解嵌入階段(Unembedding),如下圖所示:

圖:Embedding -> Attention -> MLPs -> Unembedding

下面是對這四個階段的簡要介紹。

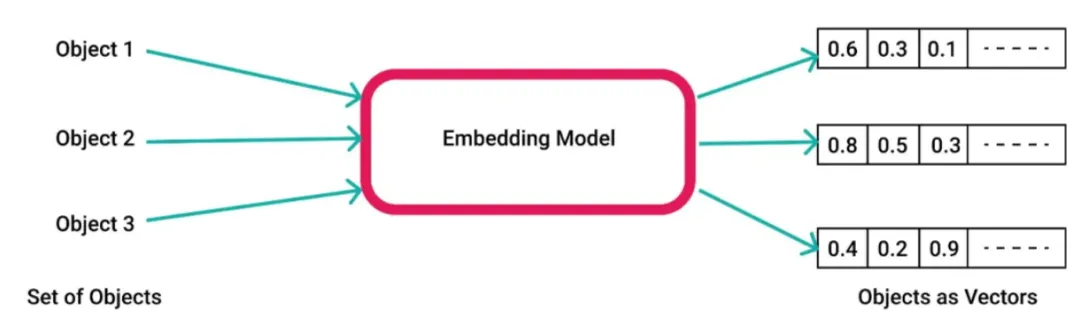

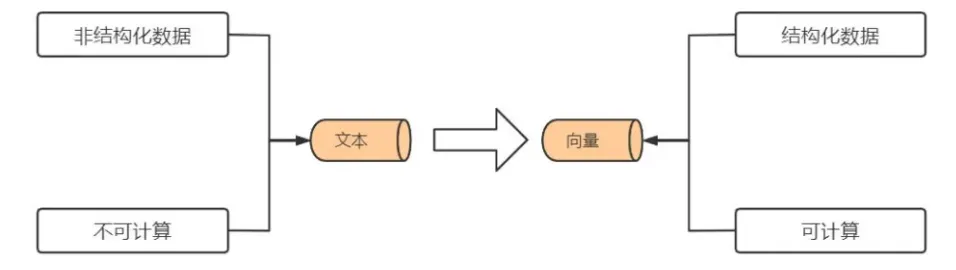

1、Embedding(嵌入)階段

大模型的輸入通常由離散的詞匯或符號組成(比如:在英文文本中,每個單詞或標點符號都是一個單獨的符號)。嵌入層的作用是將這些離散的符號轉換成連續的、具有固定維度的向量(通常稱為詞嵌入)。這些向量能夠捕獲符號的語義以及上下文信息。

在Transformer 大模型中,無論是編碼器(Encoder)還是解碼器(Decoder),都包含一個嵌入層。此外,在解碼器中,還會添加一個位置嵌入(Positional Embedding)層,用于記錄序列中單詞的位置信息,這是因為 Transformer 大模型不通過 RNN 或 CNN 等傳統結構來直接捕捉序列的順序信息。

2、Attention (注意力機制)階段

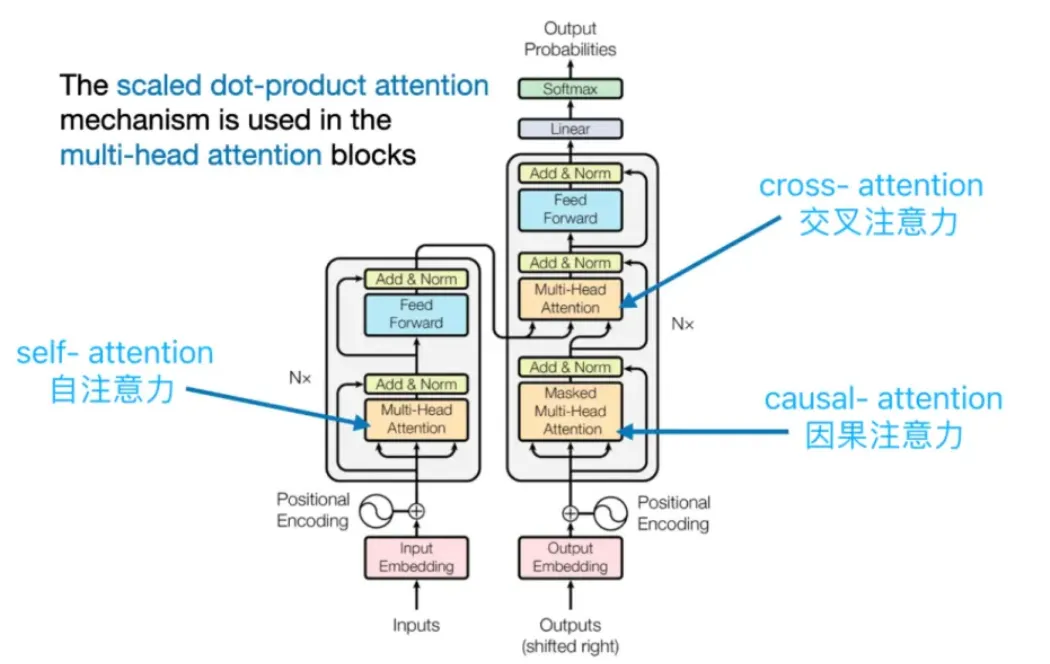

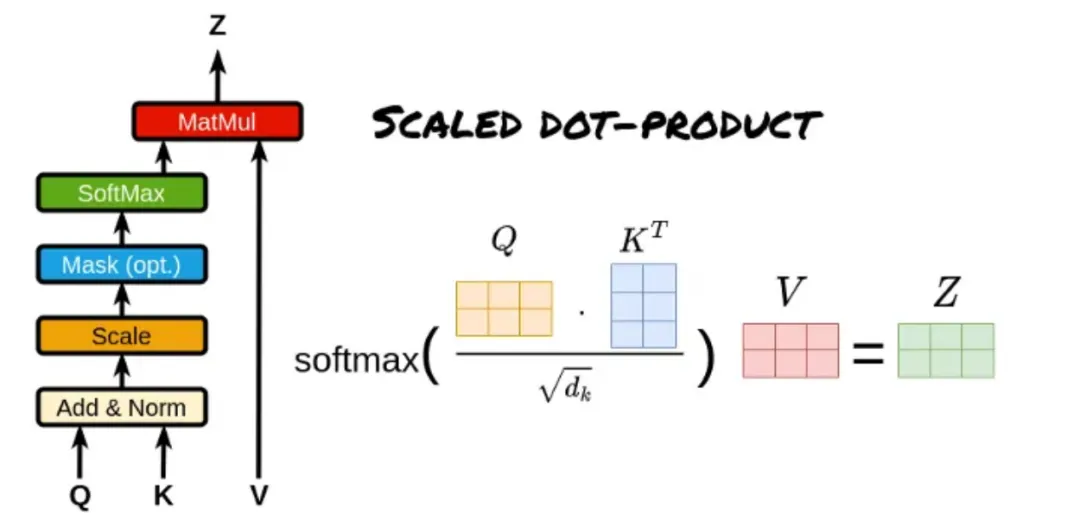

注意力機制構成了 Transformer 大模型的基石,它使得大模型能夠在產生當前輸出時聚焦于輸入序列中的各個部分。Transformer 大模型采用了多種類型的注意力機制,其中包括自注意力(Self-Attention)、編碼器-解碼器注意力(Encoder-Decoder Attention)以及掩碼多頭注意力(Masked Multi-Head Attention)。

自注意力機制使得大模型能夠識別序列內不同位置之間的相互關系,進而把握序列的內在結構。編碼器-解碼器注意力機制則使得大模型在輸出生成過程中能夠針對輸入序列的特定部分給予關注。在注意力機制的運算過程中,會生成一個注意力權重矩陣,該矩陣揭示了輸入序列中每個位置對于當前位置的貢獻程度。

3、MLPs(多層感知機,也稱為前饋神經網絡)階段

在注意力機制處理之后,大模型會利用一個或多個全連接層(也稱為前饋網絡或 MLPs)來進行更深層次的變換和特征提取。

這些全連接層能夠捕捉輸入數據中的非線性關系,并輔助模型識別更復雜的模式。在 Transformer 大模型中,MLPs 一般被置于自注意力層和歸一化層之間,共同構成了所謂的“編碼器塊”或“解碼器塊”。

4、Unembedding(從模型表示到最終輸出)階段

這一過程可以被視作從大模型的內部表示到最終輸出格式的轉換。

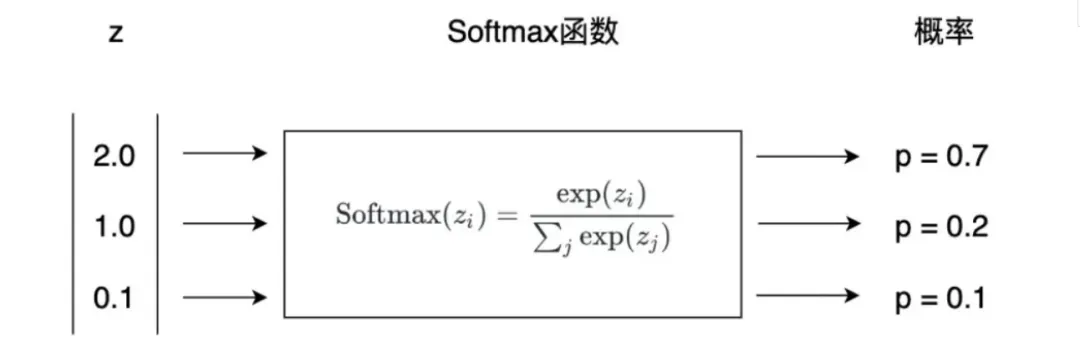

在文本生成任務中,比如:機器翻譯,解碼器的輸出將通過一個線性層和一個 Softmax 函數,以產生一個概率分布,該分布反映了下一個輸出詞(token)的概率。

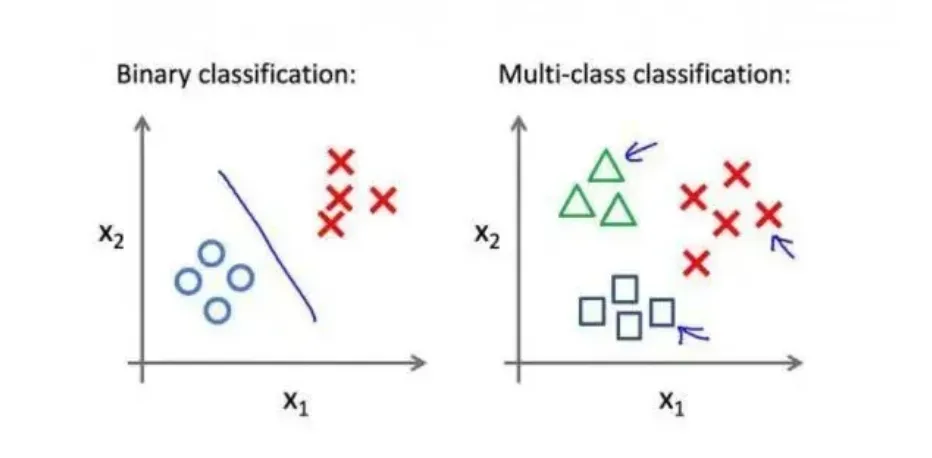

而在其他類型的任務中,比如:文本分類,解碼器的輸出可能直接用于損失函數的計算(比如:交叉熵損失),或者通過其他方法轉換成最終的預測結果。

本文轉載自公眾號玄姐聊AGI 作者:玄姐

原文鏈接:????https://mp.weixin.qq.com/s/wY5WtAlqHNPQN7LbAS9c8g??