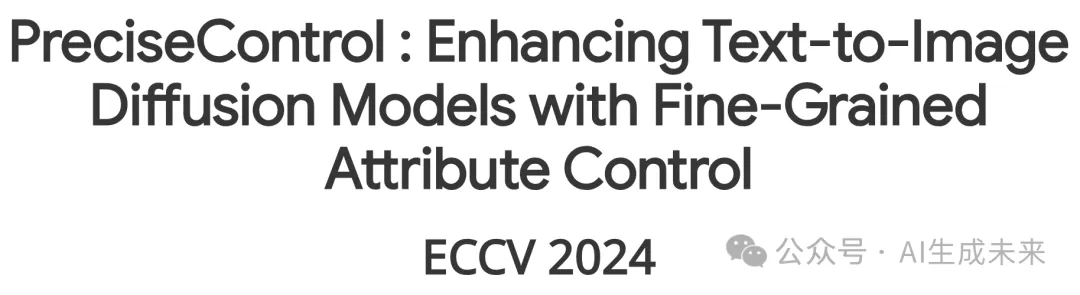

T2I與StlyeGAN2首次聯(lián)手!PreciseControl:單肖像生成精細(xì)個(gè)性化圖像!

論文鏈接:https://arxiv.org/pdf/2408.05083

工程主頁:https://rishubhpar.github.io/PreciseControl.home/

git鏈接:https://github.com/rishubhpar/PreciseControl

最近,大家看到了一波針對文本到圖像(T2I)擴(kuò)散模型的個(gè)性化方法的興起,這些方法通過少量圖像來學(xué)習(xí)一個(gè)概念。現(xiàn)有的方法在用于人臉個(gè)性化時(shí),難以實(shí)現(xiàn)具有身份保留的令人信服的反演,并依賴于對生成的人臉進(jìn)行語義文本編輯。然而,人們希望對面部屬性進(jìn)行更細(xì)粒度的控制,這僅靠文本提示是難以實(shí)現(xiàn)的。

方法

提要

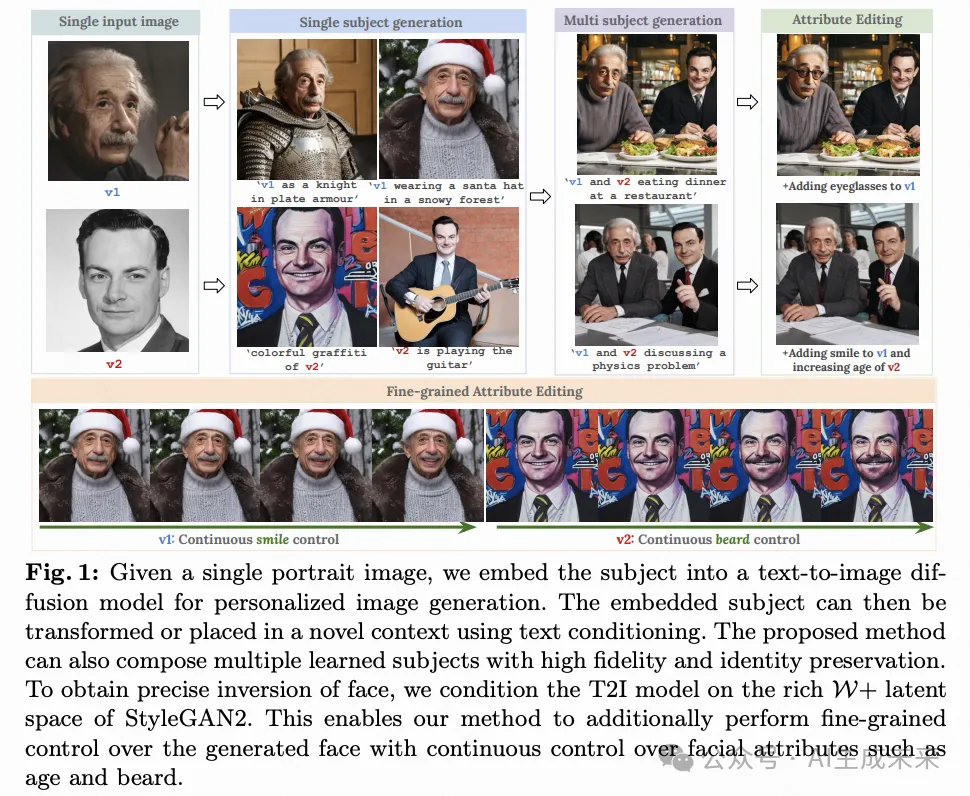

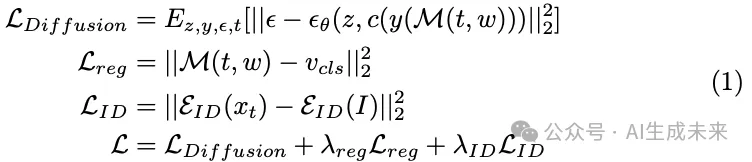

文本到圖像擴(kuò)散模型。 本研究使用StableDiffusion-v2.1作為代表性的文本到圖像(T2I)擴(kuò)散模型。Stable Diffusion 基于潛在擴(kuò)散模型,它在潛在空間中應(yīng)用擴(kuò)散過程。其訓(xùn)練包括兩個(gè)階段:a)訓(xùn)練一個(gè)VAE或VQ-VAE自編碼器,將圖像映射到壓縮的潛在空間;b)在潛在空間中訓(xùn)練一個(gè)擴(kuò)散模型,以文本為條件引導(dǎo)生成。這個(gè)框架將自編碼器中細(xì)粒度細(xì)節(jié)的學(xué)習(xí)與擴(kuò)散模型中的語義特征學(xué)習(xí)分離開來,從而使得擴(kuò)展更加容易。

概覽

潛在適配器 M

訓(xùn)練

本文進(jìn)行兩階段訓(xùn)練,首先在面部數(shù)據(jù)集上對潛在適配器M進(jìn)行預(yù)訓(xùn)練,然后對M和擴(kuò)散 U-Net 進(jìn)行幾次特定主體的訓(xùn)練,使用低秩更新來改善身份識別,具體如下所述。

推理

人臉屬性的細(xì)粒度控制

多人組成

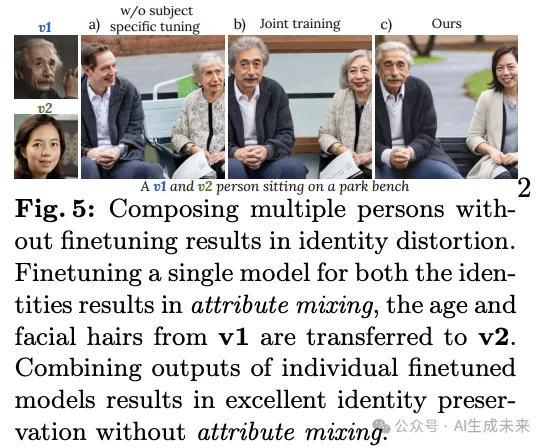

本文的方法可以擴(kuò)展到在單個(gè)場景中組合多個(gè)主體身份。簡單地在文本提示中 embedding多個(gè)令牌 embedding(每個(gè)主體一個(gè)),而不進(jìn)行主體特定的調(diào)整,會(huì)導(dǎo)致身份失真(如下圖5a所示)。聯(lián)合進(jìn)行主體特定調(diào)整可以改善身份識別,但會(huì)出現(xiàn)屬性混合的問題,即一個(gè)主體的面部屬性被轉(zhuǎn)移到另一個(gè)主體上,如下圖5b中的年齡和頭發(fā)。這是文本到圖像(T2I)生成中的一個(gè)常見問題,模型在處理場景中的多個(gè)對象時(shí),容易綁定錯(cuò)誤的屬性。本文采用了一種不同的方法,靈感來自于MultiDiffusion,在這個(gè)方法中,本文運(yùn)行多個(gè)串聯(lián)的擴(kuò)散過程,每個(gè)主體和背景各一個(gè)。在每一步的去噪過程中,將這些過程的輸出進(jìn)行組合。

本文使用實(shí)例分割mask來進(jìn)行處理。對于每個(gè)主體,本文通過其對應(yīng)的主體特定微調(diào)模型運(yùn)行擴(kuò)散過程。這種方法能夠保留每個(gè)微調(diào)模型學(xué)習(xí)到的主體細(xì)節(jié),并實(shí)現(xiàn)多個(gè)人物的高保真組合,而不會(huì)出現(xiàn)屬性混合的問題。為了獲得實(shí)例分割mask,本文使用包含兩個(gè)人物的提示運(yùn)行單個(gè)擴(kuò)散過程,并在生成的圖像上應(yīng)用現(xiàn)成的分割模型SAM。此外,本文可以在W+空間中通過潛在變量操控對單個(gè)主體進(jìn)行細(xì)粒度的屬性編輯,同時(shí)保留其他主體的完整性,如上圖1所示。

實(shí)驗(yàn)

本文在StableDiffusion-v2.1上進(jìn)行所有實(shí)驗(yàn),將其作為代表性的文本到圖像(T2I)模型。對于反演,本文使用在面部數(shù)據(jù)集上訓(xùn)練的預(yù)訓(xùn)練StyleGAN2 e4e編碼器,將圖像映射到W+空間。在接下來的章節(jié)中,本文首先討論數(shù)據(jù)集和指標(biāo),然后是單主體和多主體個(gè)性化的結(jié)果、細(xì)粒度屬性編輯以及消融研究。

數(shù)據(jù)集 & 評估指標(biāo)

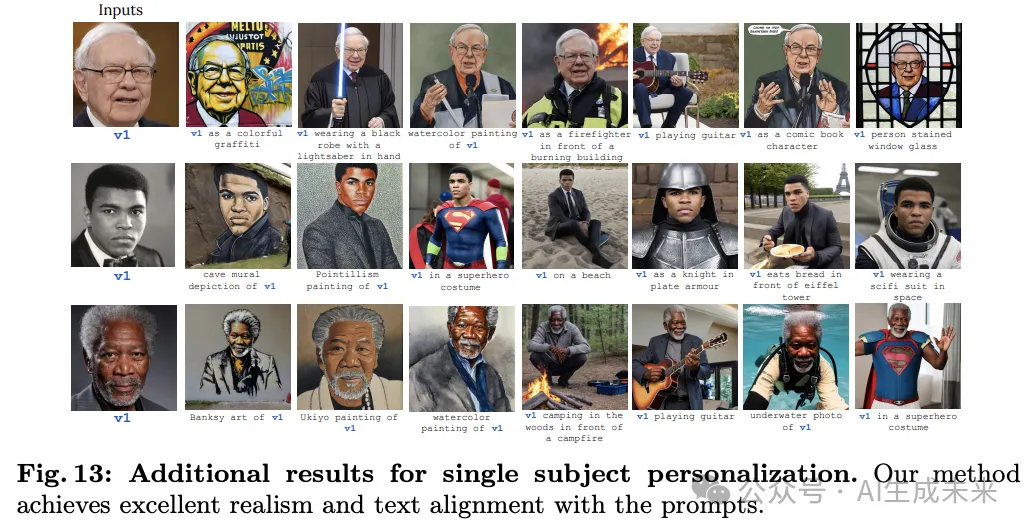

數(shù)據(jù)集:潛在適配器的訓(xùn)練使用了由StyleGAN2生成的合成圖像和來自FFHQ數(shù)據(jù)集的真實(shí)圖像的組合。數(shù)據(jù)集包含了70,000張圖像及其對應(yīng)的通過e4e獲得的w潛在代碼。本文收集了一個(gè)包含30個(gè)主體的評估數(shù)據(jù)集,其中包括科學(xué)家、名人、運(yùn)動(dòng)員和科技高管。本文還在補(bǔ)充材料中對“非名人”身份和合成面孔進(jìn)行了評估。本文使用了一組25種多樣化的文本提示,包括用于風(fēng)格化、背景更改和執(zhí)行特定動(dòng)作的文本。

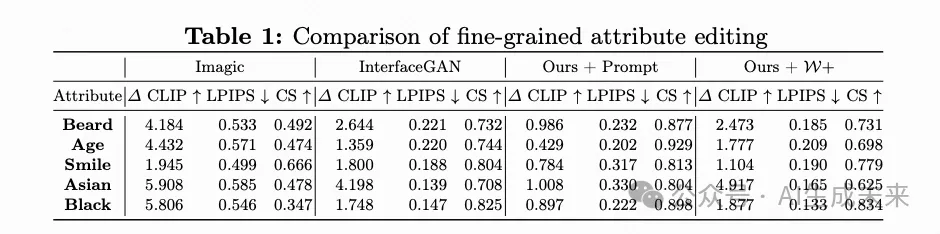

評估指標(biāo):本文使用兩個(gè)廣泛使用的指標(biāo)來評估個(gè)性化性能:提示相似性(Prompt similarity)——使用CLIP來測量提示與生成圖像的對齊程度;身份相似性(Identity similarity, CS)——通過計(jì)算來自面部 embedding的余弦相似度來測量輸入圖像與生成圖像之間的身份相似性。為了評估細(xì)粒度屬性編輯,本文計(jì)算屬性提示(例如,“一個(gè)微笑的人”)編輯前后的提示相似性變化(? CLIP)。此外,本文使用LPIPS和身份相似性來測量編輯過程中圖像的變化。對于理想的細(xì)粒度屬性編輯,較高的? CLIP表示有意義的編輯,而較低的LPIPS和較高的身份相似性表示源身份的保留。

與個(gè)性化方法的比較。

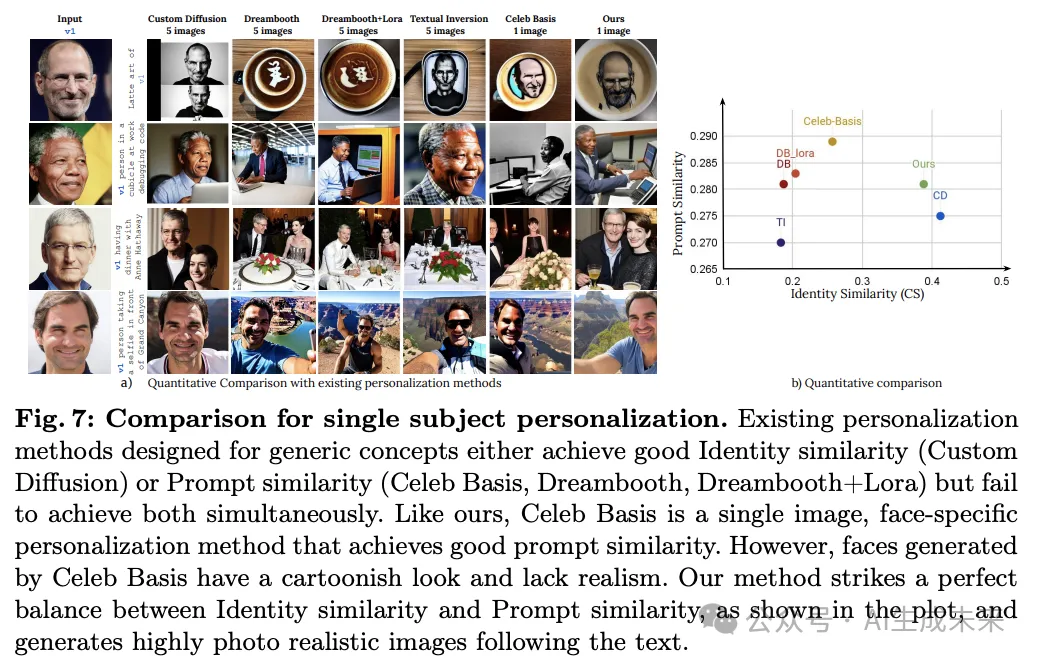

單主體個(gè)性化。

Custom Diffusion能夠 embedding主體并保持其身份;然而,它主要生成特寫面孔,并且不根據(jù)文本提示對主體進(jìn)行風(fēng)格化或使其執(zhí)行動(dòng)作。Dreambooth無法忠實(shí)地 embedding主體的身份,而通過LoRA訓(xùn)練,身份保留得到改善,同時(shí)文本對齊性提高,這有助于避免過擬合。Textual Inversion和Celeb Basis的身份保留效果較差,因?yàn)樗鼈儍H微調(diào)token embedding而不是U-Net。

這段文字討論了Celeb Basis方法在文本對齊方面的表現(xiàn)。由于Celeb Basis方法在跨越名人姓名的基礎(chǔ)上施加了強(qiáng)有力的正則化,因此在文本對齊上表現(xiàn)最佳。本文的方法在文本對齊和身份保留之間找到了完美的平衡。需要注意的是,本文的方法和Celeb Basis都只使用1張輸入圖像,這在一定程度上會(huì)影響身份識別,而Custom-diffusion方法需要5張圖像。本文還在補(bǔ)充材料中提供了與基于編碼器的模型以及最近的IP-adaptor方法的額外比較。

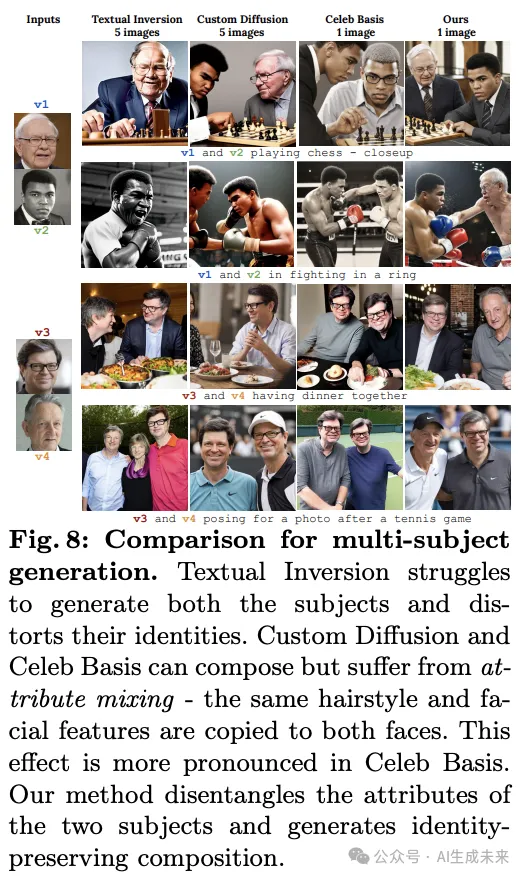

這段文字討論了多主體個(gè)性化的生成結(jié)果。本文在下圖8、14中展示了 embedding多人物組合的結(jié)果,具體來說,本文在生成過程中結(jié)合了主體特定調(diào)優(yōu)模型的中間輸出。本文與多概念個(gè)性化方法、Textual Inversion、Custom Diffusion和Celeb Basis進(jìn)行了比較。

對于Textual Inversion和Celeb Basis,本文為每個(gè)主體分別學(xué)習(xí)了兩個(gè)不同的token embedding。對于Custom Diffusion,本文對兩個(gè)主體的投影矩陣進(jìn)行了聯(lián)合微調(diào)。Textual Inversion無法在場景中生成兩個(gè)主體。Celeb Basis和Custom Diffusion能夠生成兩個(gè)主體,但存在屬性混合的問題(例如,v4的眼鏡被轉(zhuǎn)移到了v3上)。如前所述,Celeb Basis大多數(shù)情況下會(huì)生成卡通化的面孔。

本文的方法通過運(yùn)行多個(gè)主體特定的擴(kuò)散過程解決了屬性混合問題,并生成了高度逼真的組合。

通過潛在操縱進(jìn)行細(xì)粒度控制

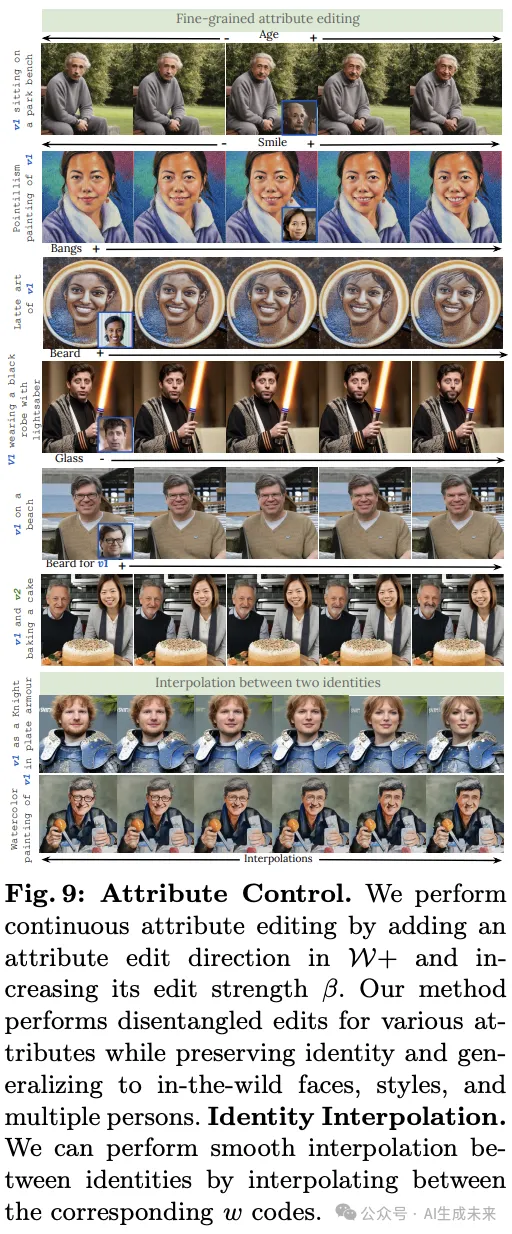

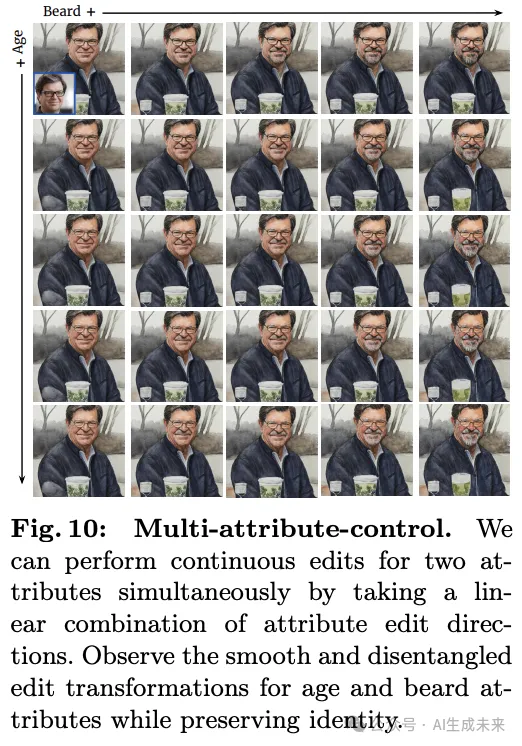

提出的方法將StyleGAN的解耦W+潛空間與T2I模型的token embedding空間匹配,通過潛空間操作實(shí)現(xiàn)對圖像屬性的連續(xù)控制。本文展示了由StyleGAN解耦潛空間驅(qū)動(dòng)的兩個(gè)重要圖像編輯應(yīng)用:1)細(xì)粒度屬性編輯和2)平滑身份插值。此外,本文的模型還可以恢復(fù)受損的人臉圖像,如低分辨率或修復(fù)被遮蓋的面部特征。

細(xì)粒度屬性編輯。本文通過在輸入圖像的W編碼中添加一個(gè)全局潛在編輯方向來執(zhí)行屬性編輯。為了對所有屬性采用統(tǒng)一的方法,本文采取了一種簡化的方法來獲取編輯方向,收集了一小組(<20)的在屬性編輯前后的配對人像圖像(使用現(xiàn)成的屬性編輯方法生成)。接下來,本文計(jì)算對應(yīng)配對W的潛向量之間的差異,并對其進(jìn)行平均以獲得全局編輯方向。

身份插值。W+空間還允許在兩個(gè)身份之間進(jìn)行平滑插值。給定兩個(gè)輸入圖像,本文獲得它們對應(yīng)的潛向量,并進(jìn)行線性插值以獲得中間潛向量。當(dāng)通過潛在適配器作為條件使用時(shí),這些潛向量會(huì)產(chǎn)生逼真的人臉插值,面部之間的變化平滑,同時(shí)保留背景,如圖9底部所示。

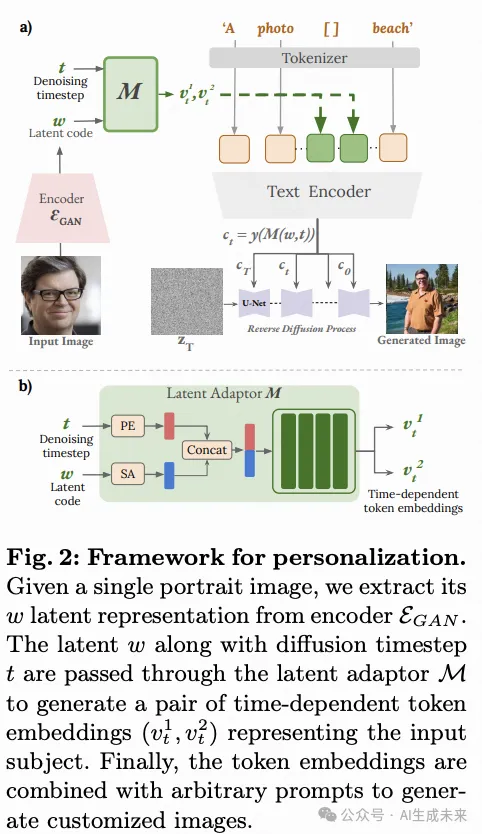

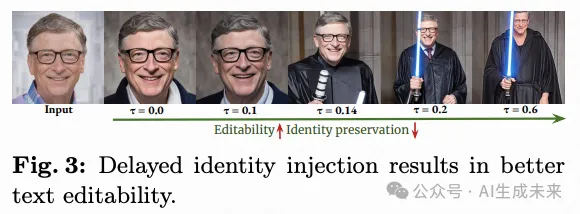

消融實(shí)驗(yàn)

結(jié)論

本文提出了一種新穎的框架,將T2I擴(kuò)散模型與StyleGAN2模型的W+空間結(jié)合,用于細(xì)粒度屬性控制。具體來說,本文學(xué)習(xí)了一種潛在映射器,將來自W+的潛在代碼投射到通過去噪、正則化和身份保留損失學(xué)習(xí)的T2I模型的輸入token embedding空間。這個(gè)框架提供了一種自然的方法,通過使用GAN編碼器模型獲取潛在代碼來 embedding真實(shí)的人臉圖像。然后可以通過兩種方式編輯 embedding的人臉——粗略的基于文本的編輯和通過在W+中進(jìn)行潛在操控的細(xì)粒度屬性編輯。

本文轉(zhuǎn)自 AI生成未來 ,作者:IISc