詳解Latte:應用于文生視頻的DiT模型

論文題目:

Latte: Latent Diffusion Transformer for Video Generation

論文鏈接:

??https://arxiv.org/pdf/2401.03048v1.pdf??

開源鏈接:

??https://github.com/Vchitect/Latte??

項目主頁:

??https://maxin-cn.github.io/latte_project/??

先來看下Latte的視頻生成效果。

一、 方法介紹

總體上,Latte 包含兩個主要模塊:預訓練 VAE 和視頻 DiT。預訓練 VAE 編碼器將視頻逐幀從像素空間壓縮到隱空間,視頻 DiT 對隱式表征提取 token 并進行時空建模,最后 VAE 解碼器將特征映射回像素空間生成視頻。為了得到最優的視頻質量,作者著重探究了 Latte 設計中兩個重要內容,(1) 視頻 DiT 模型整體結構設計以及 (2) 模型與訓練細節的最優設計(The best practices)。

1.1 Latte 整體模型結構設計探究

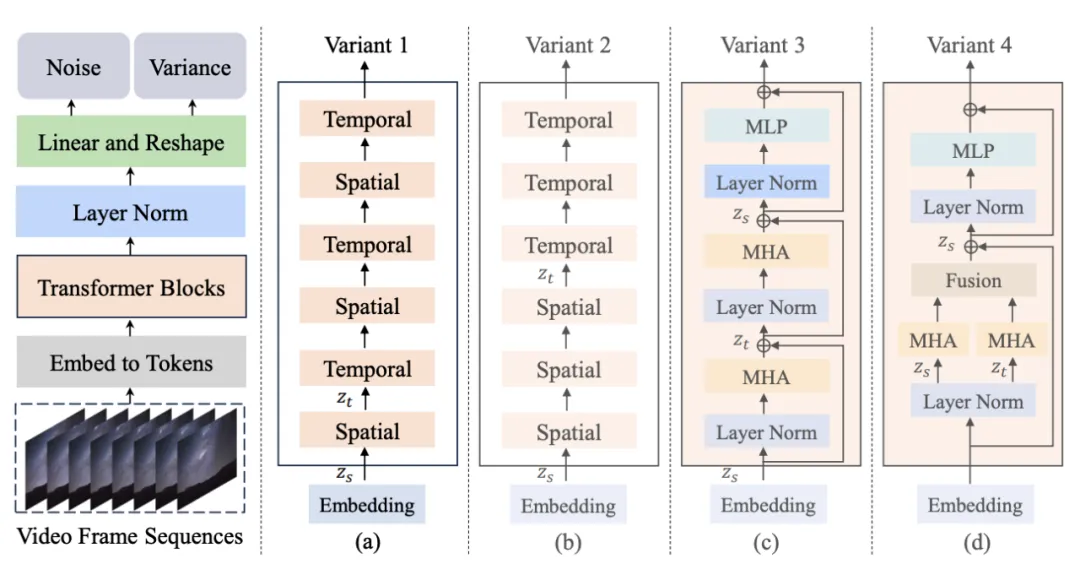

圖 1. Latte 模型結構及其變體

作者提出了 4 種不同的 Latte 變體 (圖 1),從時空注意力機制的角度設計了兩種 Transformer 模塊,同時在每種模塊中分別研究了兩種變體(Variant):

1.單注意力機制模塊,每個模塊中只包含時間或者空間注意力。

時空交錯式建模 (Variant 1): 時間模塊插入到各個空間模塊之后。

時空順序式建模 (Variant 2): 時間模塊整體置于空間模塊之后。

2. 多注意力機制模塊,每個模塊中同時包含時間與空間注意力機制 (Open-sora所參考變體)。

串聯式時空注意力機制 (Variant 3): 時空注意力機制串行建模。

并聯式時空注意力機制 (Variant 4): 時空注意力機制并行建模并特征融合。

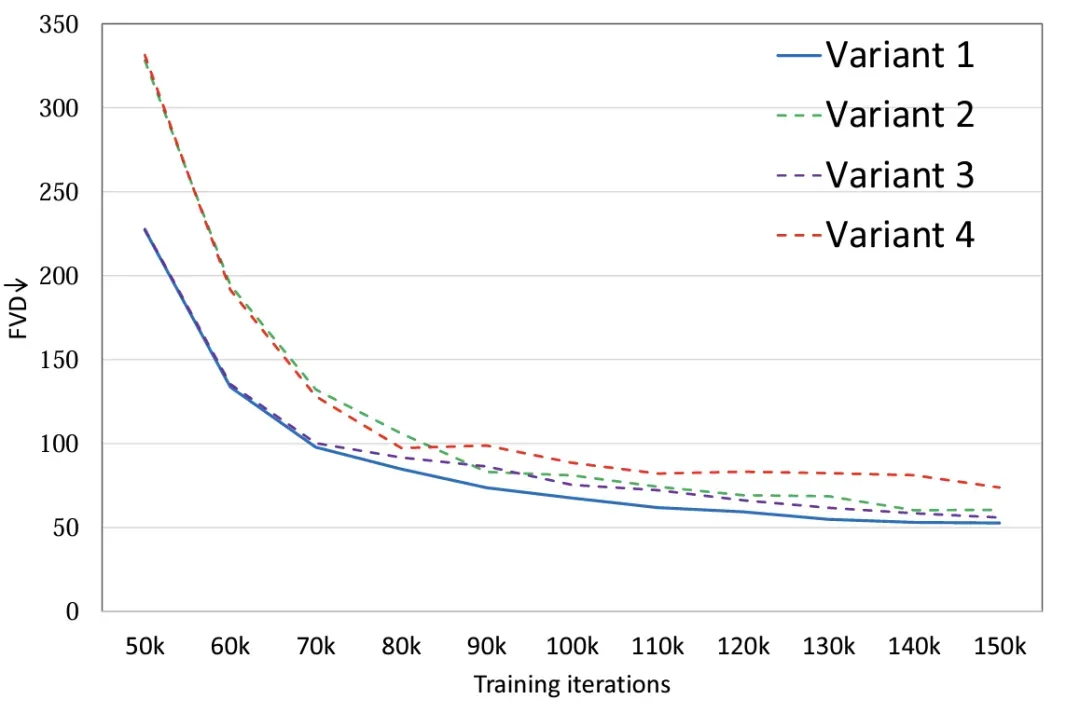

實驗表明 (圖 2),通過對 4 種模型變體設置相同的參數量,變體 4 相較于其他三種變體在 FLOPS 上有著明顯的差異,因此 FVD 上也相對最高,其他 3 種變體總體性能類似,變體 1 取得了最優異的性能,作者計劃未來在大規模的數據上做更加細致的討論。

圖 2. 模型結構 FVD

1.2 Latte 模型與訓練細節的最優設計探究(The best practices)

除了模型總體結構設計,作者還探究了其他模型與訓練中影響生成效果的因素。

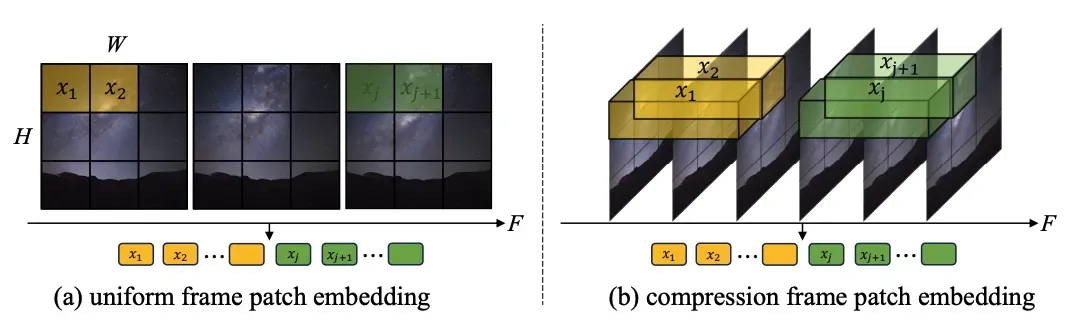

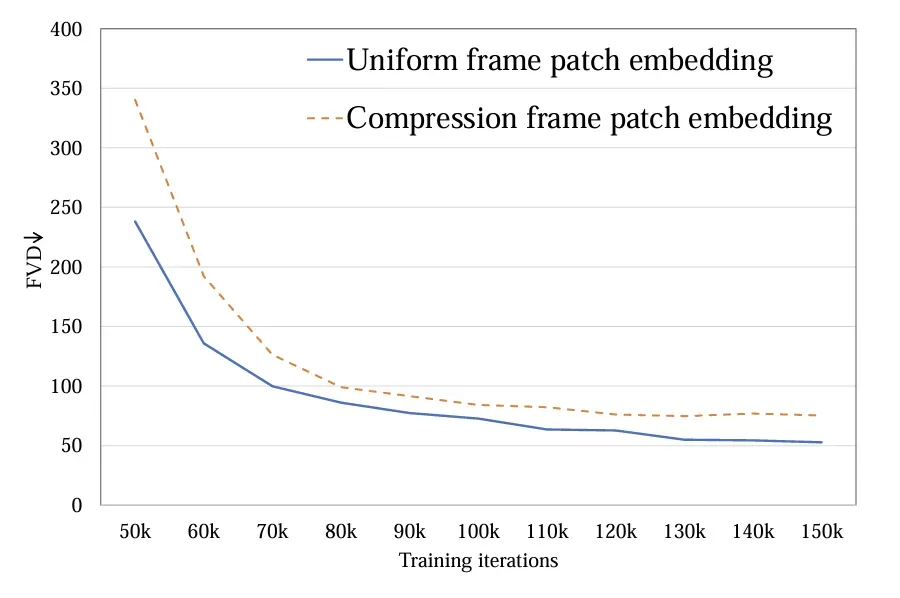

1.Token 提取:探究了單幀 token(a)和時空 token(b)兩種方式,前者只在空間層面壓縮 token,后者同時壓縮時空信息。實驗顯示單幀 token 要優于時空 token(圖 4)。與 Sora 進行比較,作者猜測 Sora 提出的時空 token 是通過視頻 VAE 進行了時間維度的預壓縮,而在隱空間上與 Latte 的設計類似都只進行了單幀 token 的處理。

圖 3. Token 提取方式,(a) 單

幀 token 和 (b) 時空 token

圖 4. Token 提取 FVD

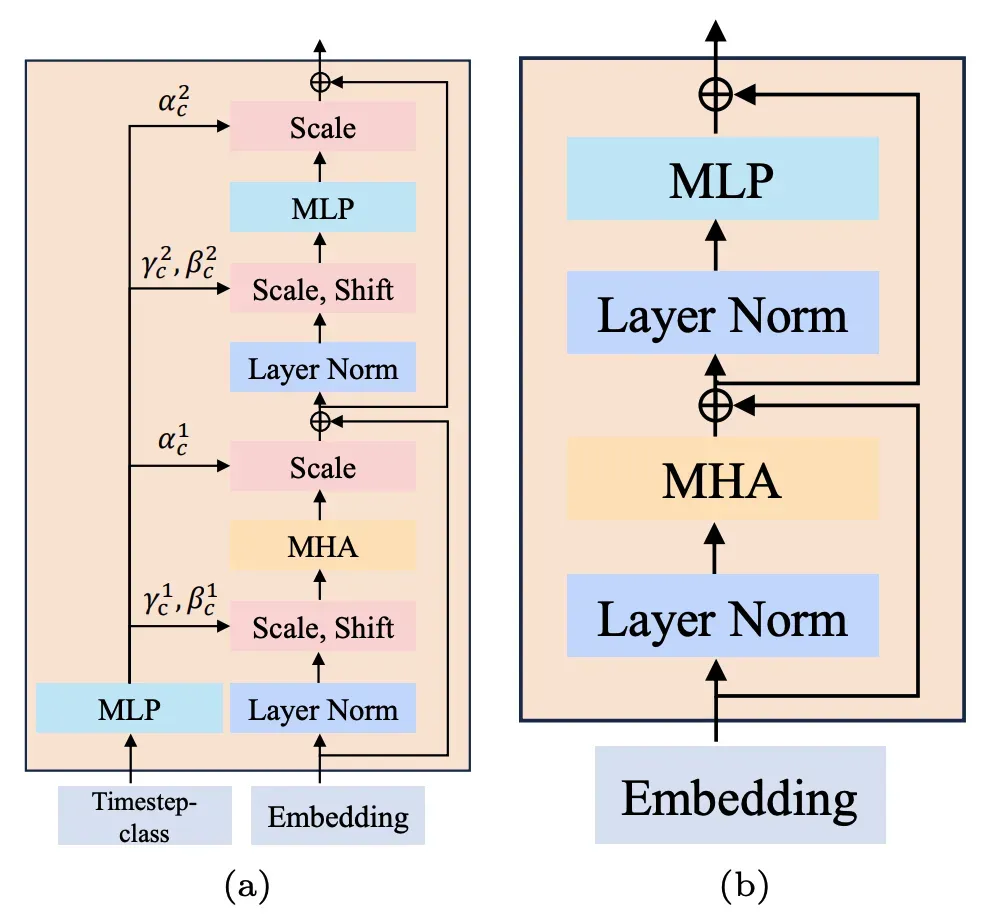

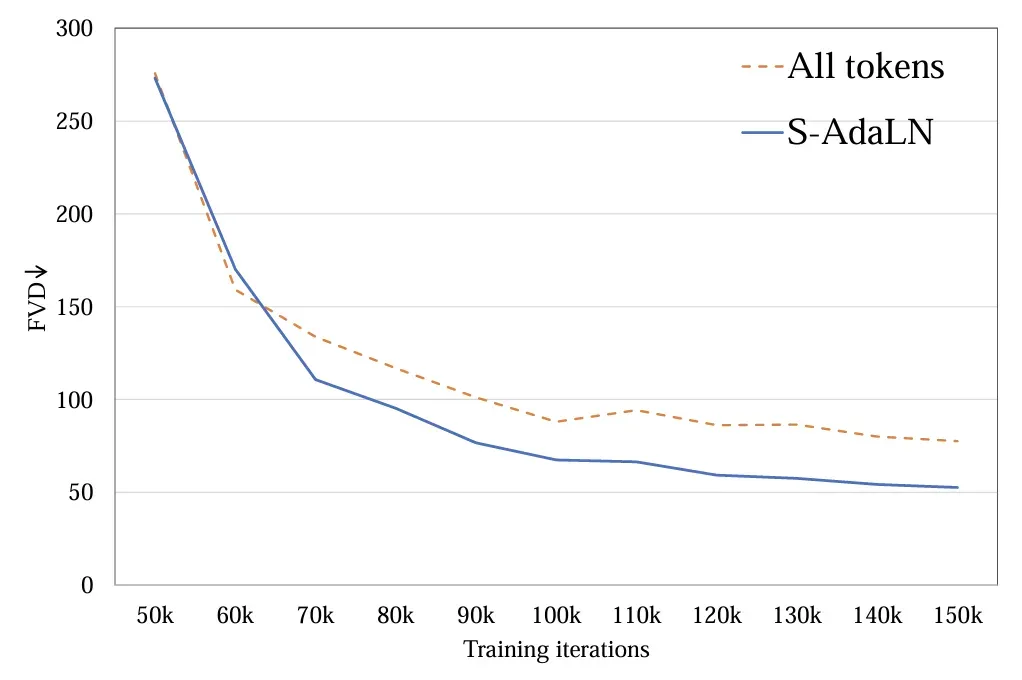

2.條件注入模式:探究了(a)S-AdaLN 和(b)all tokens 兩種方式 (圖 5)。S-AdaLN 通過 MLP 將條件信息轉換為歸一化中的變量注入到模型中。All token 形式將所有條件轉化為統一的 token 作為模型的輸入。實驗證明,S-AdaLN 的方式相較于 all token 對于獲得高質量的結果更加有效 (圖 6)。原因是,S-AdaLN 可以使信息被直接注入到每一個模塊。而 all token 需要將條件信息從輸入逐層傳遞到最后,存在著信息流動過程中的損失。

圖 5. (a) S-AdaLN 和 (b) all tokens。

圖 6. 條件注入方式 FVD

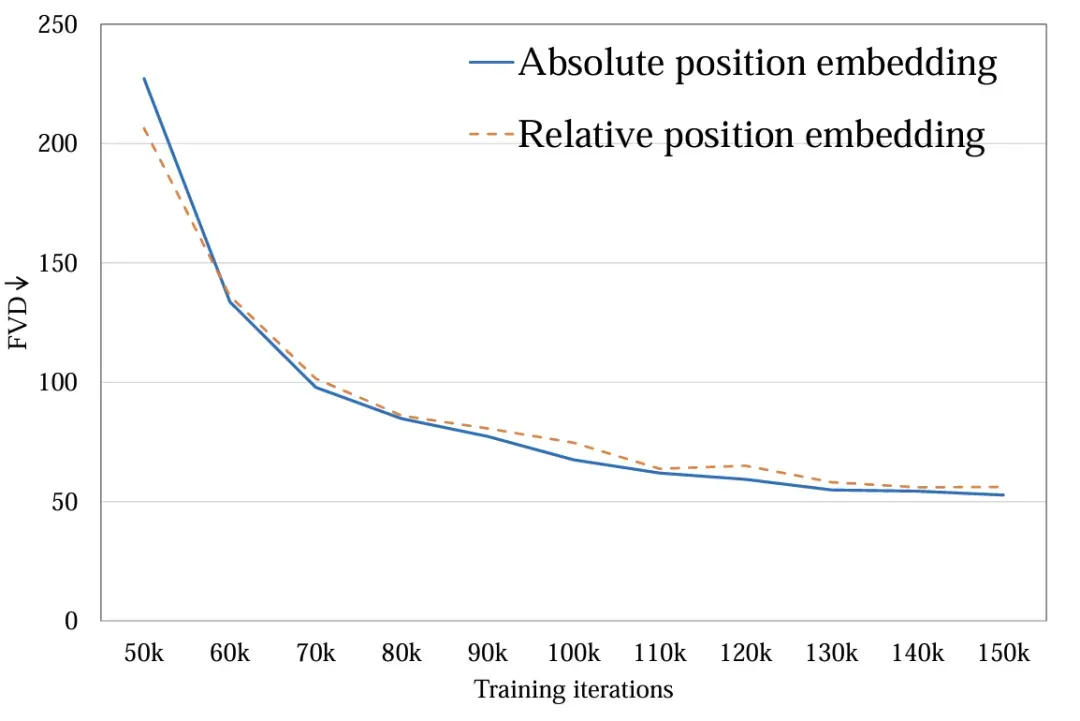

3.時空位置編碼:探究了絕對位置編碼與相對位置編碼。不同的位置編碼對最后視頻質量影響很小 (圖 7)。由于生成時長較短,位置編碼的不同不足以影響視頻質量,對于長視頻生成,這一因素需要被重新考慮。

圖 7. 位置編碼方式 FVD

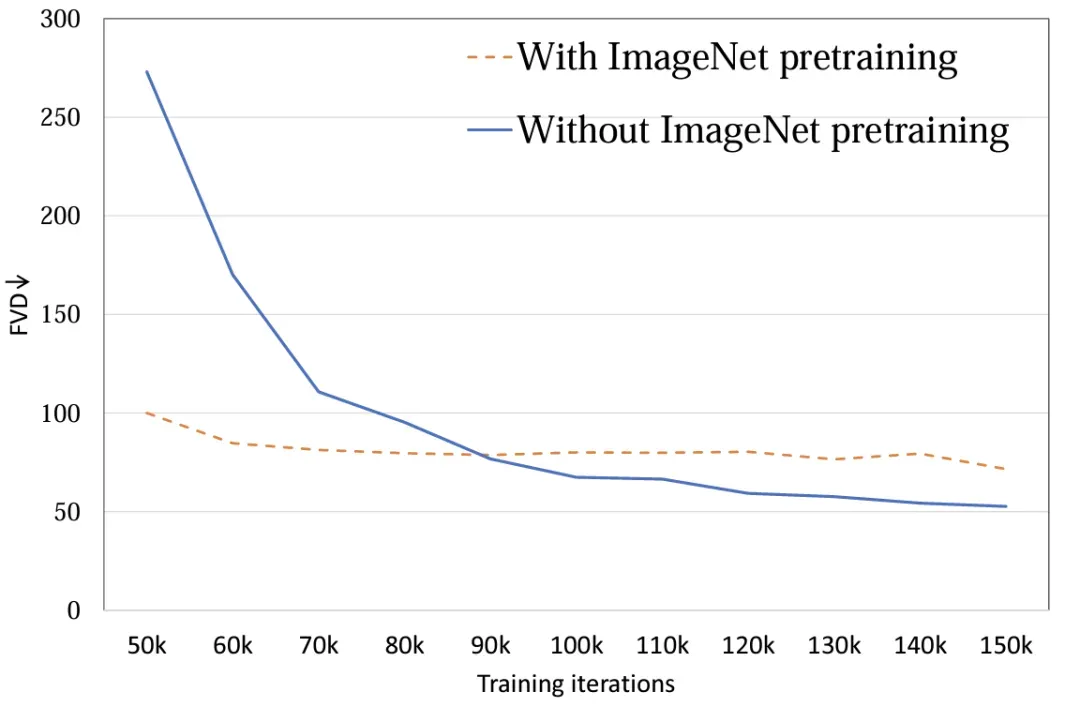

4.模型初始化:探究使用 ImageNet 預訓練參數初始化對模型性能的影響。實驗表明,使用 ImageNet 初始化的模型具有較快的收斂速度,然而,隨著訓練的進行,隨機初始化的模型卻取得了較好的結果 (圖 8)。可能的原因在于 ImageNet 與訓練集 FaceForensics 存在著比較大的分布差異,因此未能對模型的最終結果起到促進作用。而對于文生視頻任務而言,該結論需要被重新考慮。在通用數據集的分布上,圖像與視頻的內容空間分布相似,使用預訓練 T2I 模型對于 T2V 可以起到極大的促進作用。

圖 8. 初始化參數 FVD

5.圖像視頻聯合訓練:將視頻與圖像壓縮為統一 token 進行聯合訓練,視頻 token 負責優化全部參數,圖像 token 只負責優化空間參數。聯合訓練對于最終的結果有著顯著的提升 (表 2 和表 3),無論是圖片 FID,還是視頻 FVD,通過聯合訓練都得到了降低,該結果與基于 UNet 的框架 [2][3] 是一致的。

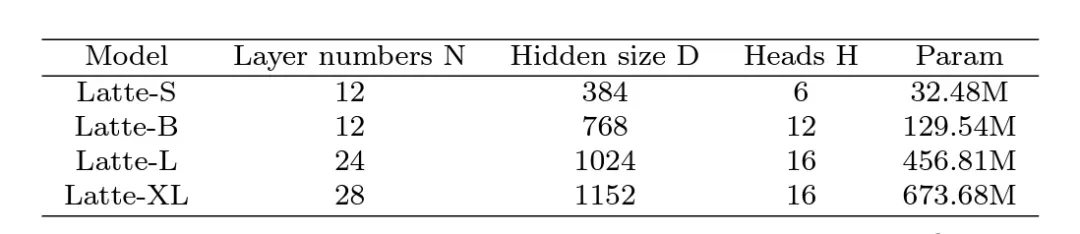

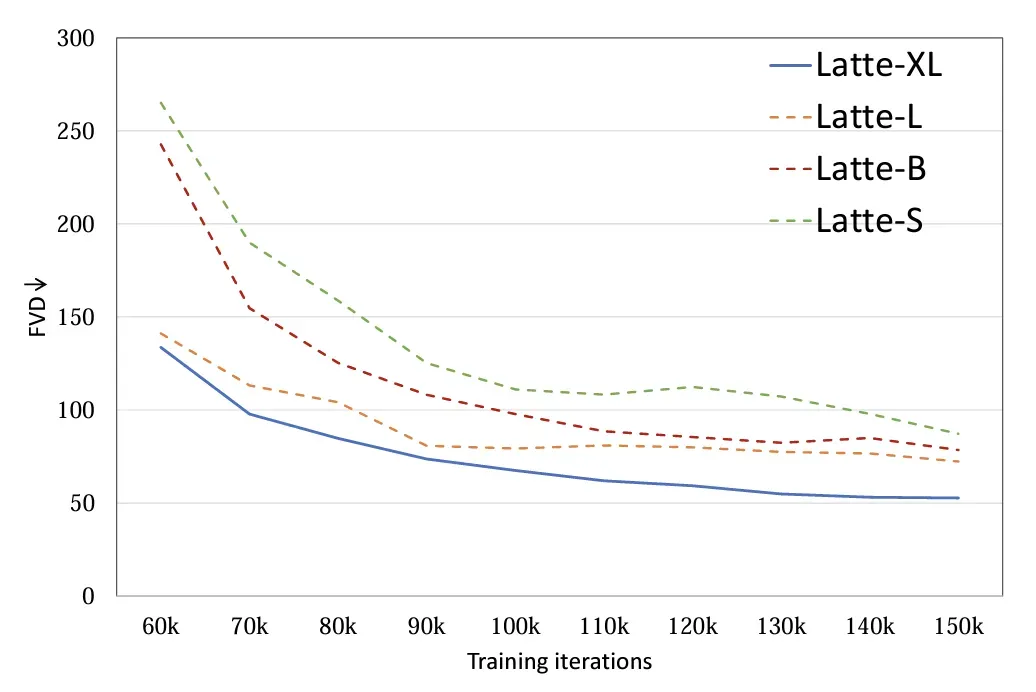

6.模型尺寸:探究了 4 種不同的模型尺寸,S,B,L 和 XL (表 1)。擴大視頻 DiT 規模對于提高生成樣本質量有著顯著的幫助 (圖 9)。該結論也證明了在視頻擴散模型中使用 Transformer 結構對于后續 scaling up 的正確性。

表 1. Latte 不同尺寸模型規模

圖 9. 模型尺寸 FVD

三、定性與定量分析

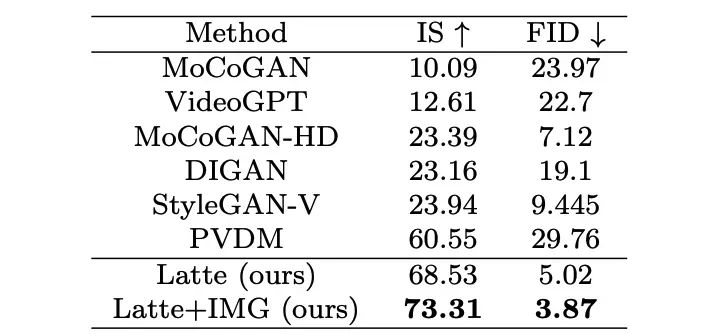

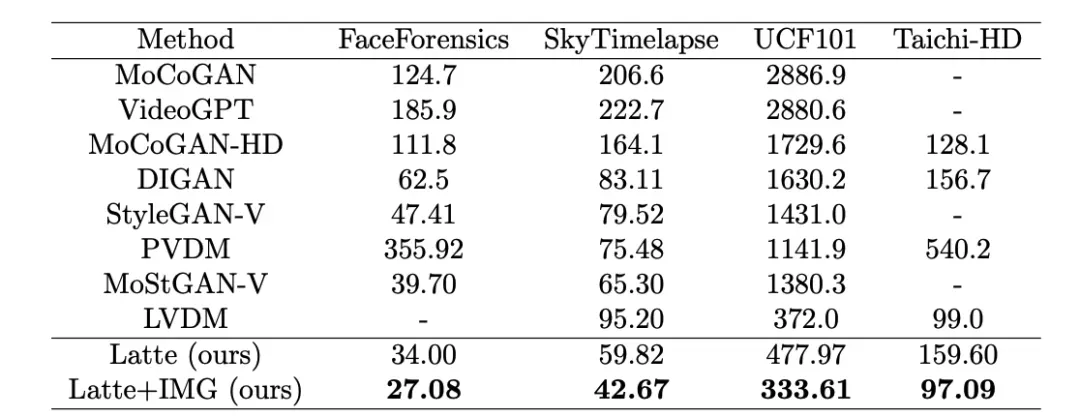

作者分別在 4 個學術數據集(FaceForensics,TaichiHD,SkyTimelapse 以及 UCF101)進行了訓練。定性與定量(表 2 和表 3)結果顯示 Latte 均取得了最好的性能,由此可以證明模型整體設計是具有優異性的。

表 2. UCF101 圖片質量評估

表 3. Latte 與 SoTA 視頻質量評估

三、文生視頻擴展

為了進一步證明 Latte 的通用性能,作者將 Latte 擴展到了文生視頻任務,利用預訓練 PixArt-alpha [4] 模型作為空間參數初始化,按照最優設計的原則,在經過一段時間的訓練之后,Latte 已經初步具備了文生視頻的能力。后續計劃通過擴大規模驗證 Latte 生成能力的上限。

四、討論與總結

Latte 作為全世界首個開源文生視頻 DiT,已經取得了很有前景的結果,但由于計算資源的巨大差異,在生成清晰度,流暢度上以及時長上與 Sora 相比還具有不小的差距。團隊歡迎并在積極尋求各種合作,希望通過開源的力量,打造出性能卓越的自主研發大規模通用視頻生成模型。

參考文獻

[1] Peebles, William, and Saining Xie. "Scalable diffusion models with transformers." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2023.

[2] Ho, Jonathan, et al. Imagen video: High definition video generation with diffusion models. arXiv preprint arXiv:2210.02303 (2022)

[3] Wang, Yaohui, et al. "Lavie: High-quality video generation with cascaded latent diffusion models." arXiv preprint arXiv:2309.15103 (2023).

[4] Chen, Junsong, et al. "PixArt-: Fast Training of Diffusion Transformer for Photorealistic Text-to-Image Synthesis." arXiv preprint arXiv:2310.00426 (2023).

Illustration From IconScout By 22