自然(Nature)科學數據子刊:用于對話情境中情緒識別的 EEG-音頻-視頻數據集的創新應用 精華

情感識別技術在現代人機交互中扮演著越來越重要的角色。隨著人工智能和機器學習技術的快速發展,理解和識別人類情感已成為實現更自然、更人性化互動的關鍵。情感識別不僅能夠提升用戶體驗,還能在心理健康監測、智能客服、教育和娛樂等多個領域發揮重要作用。在對話情境中,準確識別情感尤為重要,因為情感狀態直接影響交流的效果和質量。通過捕捉和分析對話中的情感信號,機器可以更好地理解用戶需求,提供更個性化和貼心的服務。

9 月 19 日來自于納扎爾巴耶夫大學和高麗大學的跨過研究團隊為了推動情感識別技術的發展,引入了EaV(EEG-audio-Video)數據集,這是首個在對話情境中結合腦電圖(EEG)、音頻和視頻三種主要模態的公開情感數據集。EaV數據集的獨特之處在于其多模態數據的同步記錄,涵蓋了42名參與者在提示對話場景中的情感反應。每位參與者在實驗中表現出五種情感:中性、憤怒、快樂、悲傷和平靜。通過對這些數據的分析,研究人員能夠更全面地理解人類情感的表現形式,為開發更先進的情感識別模型提供了寶貴的資源。他們的技術論文《EaV: EEG-audio-Video Dataset for Emotion Recognition in Conversational Contexts》發表于自然(Nature)Scientific Data子刊。

EaV數據集的開發由納扎爾巴耶夫大學計算機科學系和高麗大學人工智能系的專家共同完成。納扎爾巴耶夫大學的研究團隊包括Min-Ho Lee、Adai Shomanov、Balgyn Begim、Zhuldyz Kabidenova、Aruna Nyssanbay和Adnan Yazici,他們在計算機科學和情感識別領域具有豐富的研究經驗。高麗大學的Seong-Whan Lee教授則在腦電圖(EEG)和人工智能領域享有盛譽。這個跨國研究團隊結合了兩所大學的技術優勢和研究資源,致力于推動情感識別技術的發展,為實現更自然的人機交互奠定了堅實的基礎。

數據集介紹

EaV(EEG-audio-Video)數據集是一個多模態情感數據集,專為對話情境中的情感識別而設計。該數據集包含42名參與者的30通道腦電圖(EEG)、音頻和視頻記錄。每位參與者在基于提示的對話場景中表現出五種情感:中性、憤怒、快樂、悲傷和平靜。每位參與者進行了200次互動,總計8,400次互動。EaV數據集的獨特之處在于其多模態數據的同步記錄,涵蓋了參與者在對話中的情感反應,為情感識別研究提供了豐富的數據資源。

參與者來自納扎爾巴耶夫大學,包括學生和普通人群,年齡在20到30歲之間,均為英語熟練者。每位參與者在實驗中扮演重要角色,通過選擇與目標情感相關的腳本,并在對話系統中表達這些情感。參與者的多樣性和主動參與確保了數據集的廣泛適用性和代表性。

實驗在受控環境中進行,以確保數據的高質量和一致性。參與者佩戴EEG帽子進行腦電圖記錄,同時同步記錄音頻和視頻數據。具體設備和方法如下:

EEG數據:使用BrainAmp系統記錄腦電活動,通過30個Ag/AgCl電極采集EEG數據,采樣率為500 Hz。數據初始記錄在BrainVision Core Data Format中,后轉換為Matlab (.mat)格式。

音頻數據:使用高質量麥克風準確捕捉參與者的口頭反應,音頻數據記錄并存儲為WAV格式。

視頻數據:在顯示器上安裝網絡攝像頭,專注于參與者的面部,視頻數據初始記錄為AVI格式,后轉換為MPEG-4 (.MP4)格式以減小文件大小。

實驗使用基于Python編程語言的PsychoPy軟件進行,包括視頻和腳本的呈現、記錄管理、確保精確的時間控制以及各模態的通信。通過這些精細的實驗設計和數據收集方法,EaV數據集為情感識別研究提供了堅實的基礎和豐富的數據資源。

實驗設計

實驗環境及其控制條件

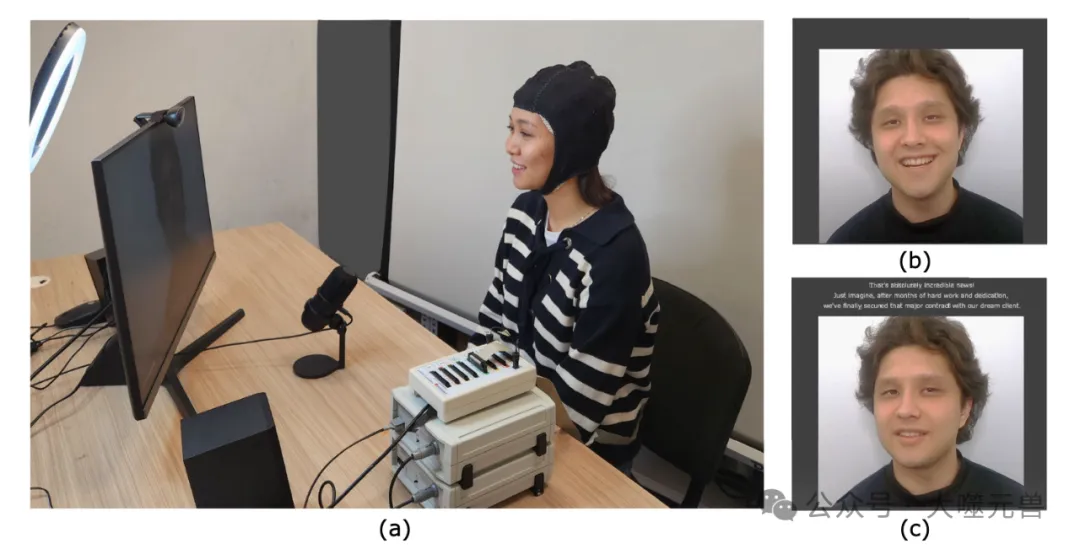

圖1:實驗裝置示意圖。(a) 參與者戴上帽子進行腦電圖記錄,并同步記錄多模式數據,(b)聽力條件:向參與者顯示預先錄制的視頻,提示他們的互動,(c)口語條件:在監視器的中心提供腳本。鼓勵參與者在給定腳本的范圍之外自由表達自己。此圖中描繪的個人提供了知情同意書,以公開其圖像。

為了確保數據的高質量和一致性,實驗在一個受控環境中進行。參與者舒適地坐在電腦顯示器前,顯示器為27英寸,刷新率為60 Hz,用于顯示對話和其他視覺刺激。實驗室環境經過精心設計,以減少外部干擾和視覺分散。

照明和背景:在參與者背后放置白色屏幕,并使用燈光設備均勻照亮參與者的面部,確保面部表情的清晰記錄。

EEG設備:使用BrainAmp系統記錄腦電活動,通過30個Ag/AgCl電極采集EEG數據,采樣率為500 Hz。電極放置在特定的頭皮位置,確保數據的準確性和一致性。

音頻設備:使用高質量麥克風準確捕捉參與者的口頭反應,確保音頻數據的清晰度和準確性。

視頻設備:在顯示器上安裝網絡攝像頭,專注于參與者的面部,確保面部表情和情感反應的完整記錄。

提示對話的設計及其對情感誘發的影響。

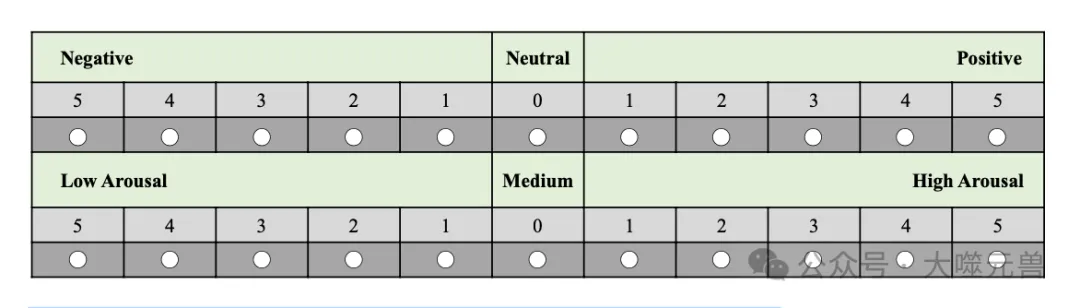

圖2:情緒對效價和喚醒水平的主觀自我評估。

實驗設計了基于提示的對話場景,以誘發參與者的特定情感。參與者在實驗中選擇與目標情感相關的腳本,并在對話系統中表達這些情感。每次對話包括聽和說的互動,確保參與者在不同情境下的情感反應被全面捕捉。對話腳本由OpenAI的ChatGPT生成,并由研究人員審查和編輯,確保情感的清晰和適當。通過這種設計,研究團隊能夠在控制條件下誘發參與者的真實情感反應,為情感識別研究提供可靠的數據基礎。

數據的分段及存儲格式

為了便于數據分析和處理,實驗數據被分段并存儲在標準化格式中。

視頻數據:視頻片段被分為每段20秒,存儲為MP4格式。每個參與者文件夾包含200個視頻片段,涵蓋五種情感類別和兩種任務(聽和說)。

音頻數據:音頻文件僅關注說話任務,存儲為WAV格式。每個參與者文件夾包含100個音頻文件。

EEG數據:EEG數據最初以[時間 × 通道]的維度連續記錄,經過高通濾波和帶通濾波處理后,數據按事件標記分段,結構為[實例 × 時間 × 通道]。處理后的EEG數據結構為:[200個實例 × 10,000個時間點(20秒 × 500 Hz) × 30個通道]。

這些精細的實驗設計和數據收集方法,使得EaV數據集為情感識別研究提供了堅實的基礎和豐富的數據資源。

數據處理與分析

在數據處理階段,研究團隊對EEG、音頻和視頻數據進行了詳細的預處理,以確保數據的質量和一致性。

EEG數據:EEG數據最初以500 Hz的采樣率連續記錄。為了減少數據量并去除噪聲,研究團隊將數據下采樣至100 Hz,并在0.5-50 Hz的頻率范圍內進行帶通濾波。經過這些預處理步驟,EEG數據被格式化為[實例 × 時間 × 通道]的結構,具體為[400個實例 × 10,000個時間點(20秒 × 500 Hz) × 30個通道]。

音頻數據:音頻數據使用Librosa庫進行預處理,提取了Mel頻率倒譜系數(MFCCs)、Chroma特征和Mel頻譜圖等關鍵特征。這些特征被連接在一起,形成用于進一步處理的輸入數據。

視頻數據:視頻片段被分為每段5秒,包含150幀。研究團隊從每段視頻中提取每第6幀,最終得到10,000幀(包括訓練和測試數據)。這些幀被用于訓練和測試情感識別模型。

為了實現情感識別,研究團隊選擇了幾種不同的模型,包括傳統的卷積神經網絡(CNN)和最新的Transformer架構。

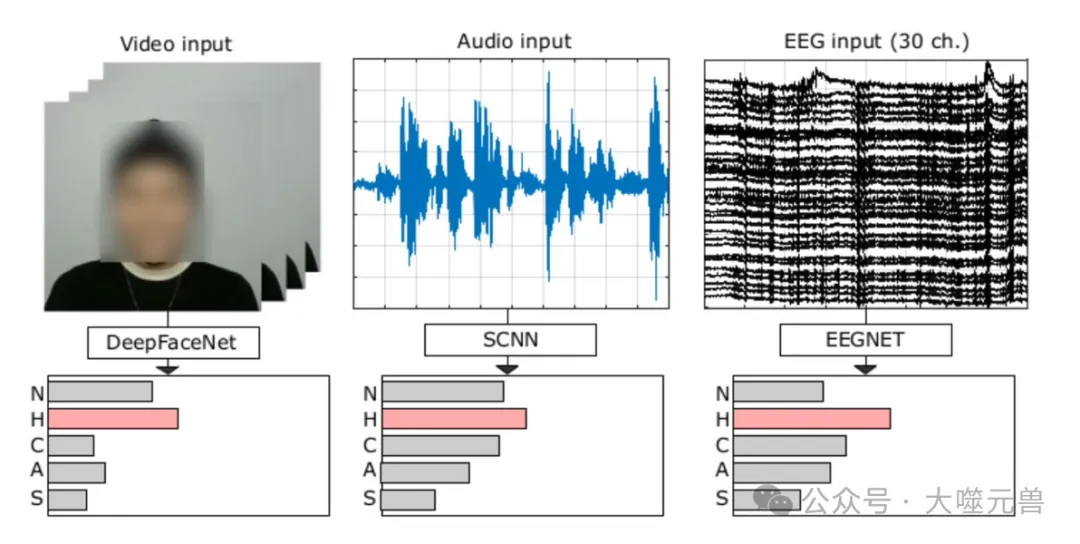

CNN模型:研究團隊設計了適用于每種模態的CNN模型。對于EEG數據,使用了EEGNet架構,該架構包括2D卷積層、深度卷積層和可分離卷積層。對于視頻數據,使用了DeepFace模型,該模型由一系列卷積層、池化層和全連接層組成。音頻數據則使用了一維卷積神經網絡(SCNN)架構,包含四個1D卷積層和ReLU激活函數。

Transformer模型:Transformer模型因其處理依賴關系的能力而被選用。研究團隊使用了EEGformer、AST和ViViT等特定的Transformer架構,分別驗證了EEG、音頻和視頻數據的性能。

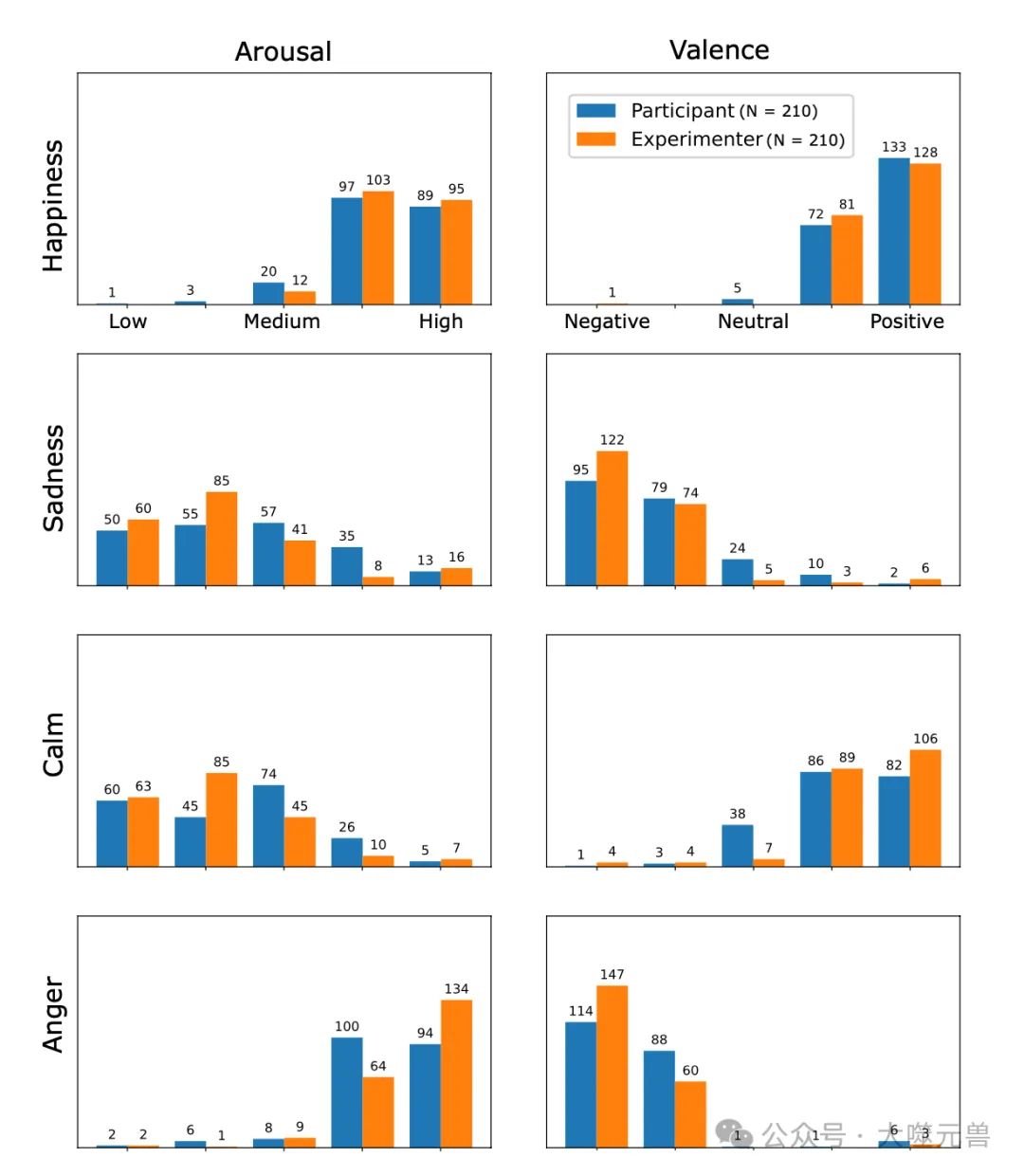

圖3:參與者和實驗者情緒評分的比較分析:一項關于四種情緒狀態(快樂、悲傷、平靜和憤怒)的喚醒和情緒水平的研究。N-所有參與者的評分數據點總數。

研究團隊對模型在不同模態下的性能進行了詳細評估,主要使用平均準確率和F1得分作為衡量指標。

EEG數據:使用EEGNet模型,EEG數據的平均準確率為60.0%,F1得分為0.58。這表明EEG數據在情感識別中具有一定的準確性,但仍有改進空間。

音頻數據:音頻數據的平均準確率為61.9%,F1得分為0.61。音頻數據在識別高喚醒狀態(如憤怒和快樂)方面表現尤為出色。

視頻數據:視頻數據的平均準確率為71.4%,F1得分為0.70。視頻數據在情感識別中表現最佳,特別是在識別高喚醒情感方面。

圖4:情緒分類的多模態輸入數據及其相應的處理管道。單次試驗持續時間為5秒。對音頻數據進行預處理以創建輸入圖像,同時將原始視頻/EEG數據饋送到每個CNN模型。這些CNN模型的輸出結果為五種情緒狀態提供了softmax預測:中性(N)、幸福(H)、平靜(C)、憤怒(A)和悲傷(S)。此圖中描繪的個人提供了知情同意書,以公開其圖像。

技術驗證

在技術驗證階段,研究團隊采用了一系列嚴格的方法來評估情感識別模型的性能。首先,數據集被分為訓練集和測試集,確保模型在不同數據集上的表現具有一致性和可靠性。具體步驟如下:

數據分割:將數據集按70%訓練集和30%測試集的比例進行分割。對于每個參與者,音頻數據被分為400個5秒的樣本,其中280個用于訓練,120個用于測試。

模型訓練:使用簡單的端到端CNN模型和最新的Transformer架構進行訓練。訓練過程中不使用驗證集,直接在固定的訓練輪數內進行訓練。

性能評估:通過計算平均準確率和F1得分來評估模型的多分類性能。這些指標能夠全面反映模型在不同情感類別上的表現。

技術驗證的目的是確保模型在不同模態下的性能具有可比性和一致性,同時識別出各模態在情感識別中的優勢和不足。

研究團隊對不同模態下的情感識別性能進行了詳細分析,結果如下。

EEG數據:使用EEGNet模型,EEG數據的平均準確率為60.0%,F1得分為0.58。這表明EEG數據在情感識別中具有一定的準確性,但仍有改進空間。

音頻數據:音頻數據的平均準確率為61.9%,F1得分為0.61。音頻數據在識別高喚醒狀態(如憤怒和快樂)方面表現尤為出色。

視頻數據:視頻數據的平均準確率為71.4%,F1得分為0.70。視頻數據在情感識別中表現最佳,特別是在識別高喚醒情感方面。

此外,研究團隊還使用預訓練的Transformer模型對音頻和視頻數據進行了驗證,結果顯示這些模型在這兩種模態下的分類性能有所提升,分別達到62.7%和74.5%的平均準確率。然而,EEGTransformer模型的表現較差,準確率為53.5%,F1得分為0.52。

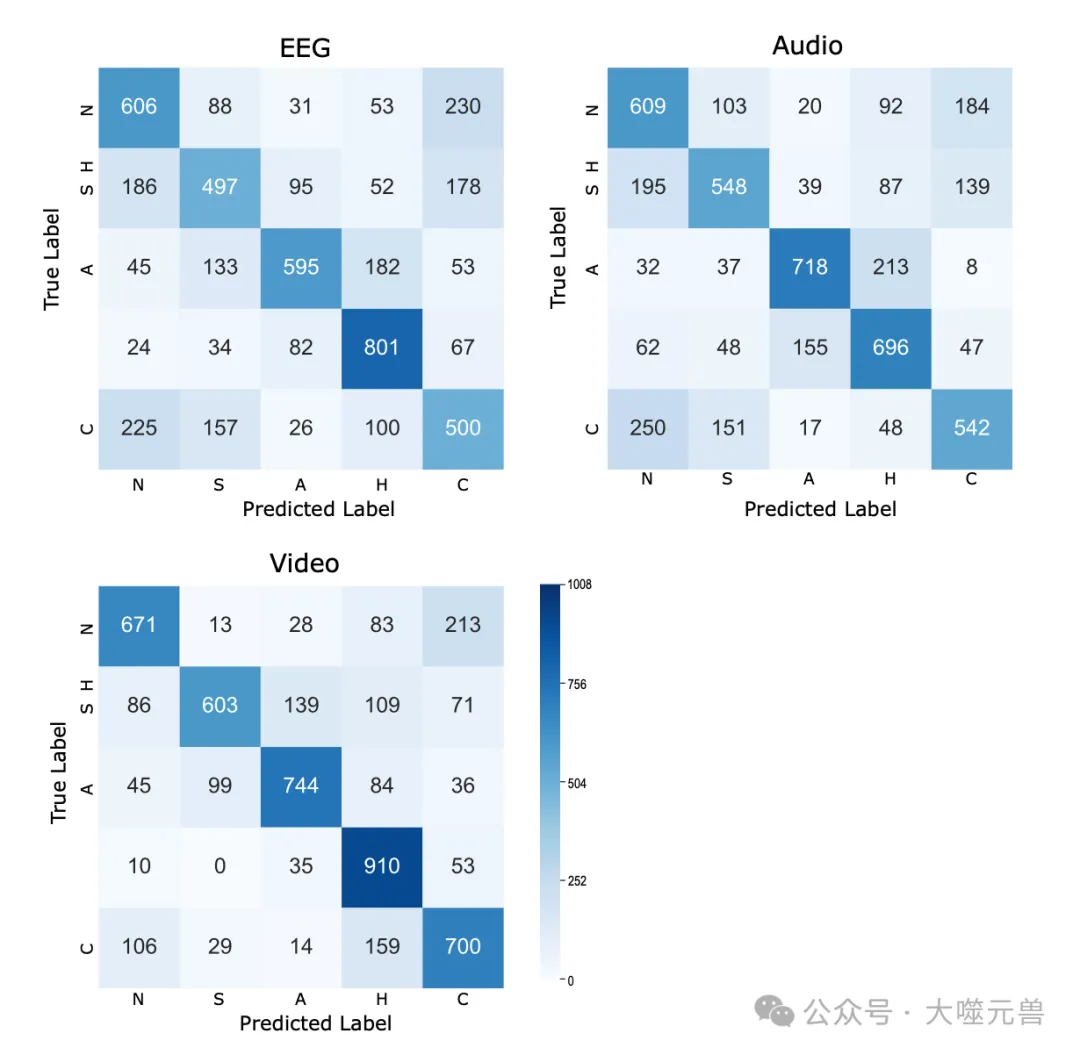

混淆矩陣提供了不同情感類別之間的分類準確性和誤判情況。以下是各模態下的混淆矩陣分析。

EEG模態:在分類快樂和中性情感方面表現出色,但在低喚醒情感(如悲傷和平靜)上存在顯著誤判。

音頻模態:在辨別高喚醒狀態(如憤怒和快樂)方面表現優異,但在低喚醒情感上也存在誤判。

視頻模態:視頻數據在分類高喚醒情感(如憤怒和快樂)方面表現最佳,但在低喚醒情感上存在顯著誤判,常將低喚醒情感誤判為高喚醒情感。

圖5:使用EEG、音頻和視頻數據對所有參與者的五個情緒類別進行分類的累積混淆矩陣。矩陣代表每種情緒:中性(N)、悲傷(S)、憤怒(A)、幸福(H)和平靜(C)。所有參與者每班的總測試試驗為1008(24個口語任務×42名參與者)。

使用說明

EaV數據集已在Zenodo通用開放存儲庫上發布,研究人員和開發者可以通過遵守數據使用協議(DUA)來訪問和使用該數據集。具體步驟如下:

訪問存儲庫:前往Zenodo存儲庫,搜索EaV數據集。

申請訪問:填寫并提交數據使用協議(DUA)申請表。申請表中需要提供申請人的全名、所屬機構、職位/職稱以及數據集的預期使用描述。

協議批準:一旦申請獲得批準,申請人將獲得數據訪問權限。數據集的使用需嚴格遵守DUA中的條款和條件,確保數據的合法和合規使用。

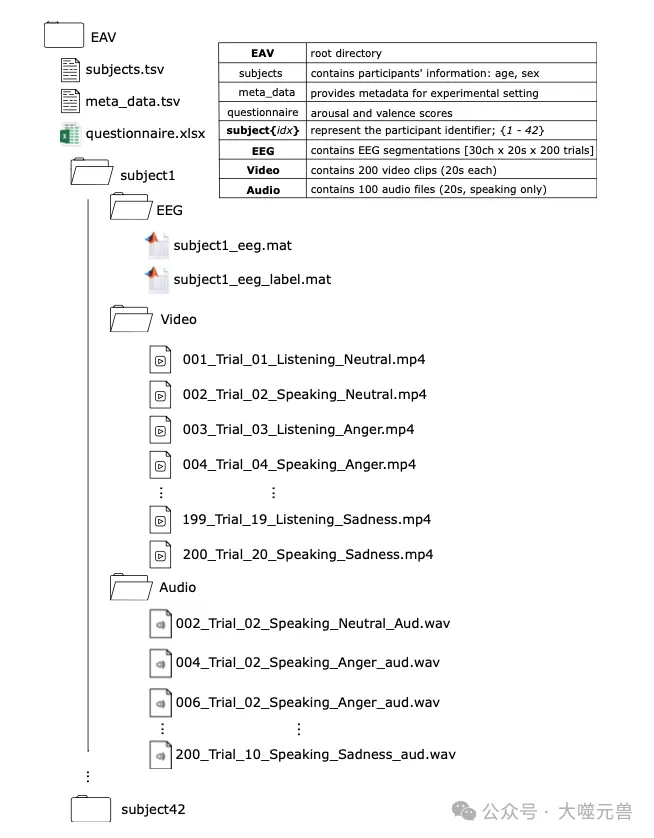

數據集的結構標準化,便于導航和使用。根文件夾EVA包含參與者文件夾,每個文件夾內有三個子文件夾:視頻、音頻和EEG。視頻文件以MP4格式存儲,音頻文件以WAV格式存儲,EEG數據以MAT格式存儲。

為了有效分析EaV數據集,研究團隊推薦了以下工具和庫。

EEG數據分析

BBCI工具箱:提供廣泛的信號處理功能,包括偽影去除、頻譜/空間濾波、重采樣和重新參考。適用于Matlab環境。

OpenBMI:類似于BBCI工具箱,提供豐富的EEG信號處理功能。

MNE工具箱:適用于Python環境,提供信號處理和可視化方法。

視聽數據分析

DeepFace:用于視頻分析的深度神經網絡模型庫,包含一系列卷積層、池化層和全連接層。

1D-Speech-Emotion-Recognition:用于音頻分析的庫,包含一維卷積神經網絡模型,適用于情感識別任務。

圖6:數據存儲庫的結構便于直觀導航。在初級級別下,文件夾名為“subject{idx}”,其中“idx”表示參與者標識符。每個特定于參與者的目錄都包含三個子目錄:“視頻”、“音頻”和“EEG”。相應地,這些子目錄中的數據文件遵循其特定的格式:視頻文件保存為*。MP4,音頻記錄在*中。WAV格式和EEG數據存儲為*。MAT文件。

局限性與未來展望

盡管EaV數據集在情感識別領域具有重要貢獻,但其實驗設計和數據集本身也存在一些局限性。

實驗使用了提示和擺拍的對話場景,雖然這種設計有助于標準化對話并確保類別標簽的平衡,但可能無法完全捕捉真實對話中的自發情感表達。參與者的情感反應可能因提示對話而被夸大或淡化,導致情感試驗不匹配。

由于EEG帽子的設置可能限制參與者的面部表情,特別是覆蓋了前額區域,這可能影響面部表情的自然性和準確性。參與者年齡限制在20到30歲之間,且均為非英語母語者,這可能導致結果的偏差,特別是在應用語言模型或使用預訓練模型時。

預定義的五種情感類別(中性、憤怒、快樂、悲傷、平靜)可能無法涵蓋人類情感的全部范圍,限制了數據集的代表性。

為了保持基線結果的一致性,研究團隊在EEG數據處理中未使用偽影去除、空間濾波和歸一化等清理方法,這可能影響數據的質量和分析結果。

基于EaV數據集,未來的研究可以在以下幾個方面進行改進和擴展。

增強對話場景的自然性:未來的研究可以設計更自然的對話場景,減少提示和擺拍的成分,捕捉參與者在真實對話中的自發情感反應。這將有助于提高情感識別模型的實際應用效果。

多樣化參與者背景:擴大參與者的年齡范圍,并包括不同語言背景的參與者,以提高數據集的多樣性和代表性。這將有助于開發更通用的情感識別模型。

擴展情感類別:增加更多的情感類別,如驚訝、恐懼、厭惡等,以更全面地覆蓋人類情感的多樣性。這將有助于提高情感識別模型的精度和適用性。

改進數據清理方法:在EEG數據處理中引入偽影去除、空間濾波和歸一化等清理方法,以提高數據質量和分析結果的可靠性。

多模態融合技術:探索更先進的多模態數據融合技術,結合EEG、音頻和視頻數據,以提高情感識別的準確性和魯棒性。可以嘗試使用最新的深度學習模型,如Transformer架構,進一步提升性能。

實時情感識別:開發實時情感識別系統,應用于智能客服、心理健康監測等實際場景中,驗證模型的實用性和有效性。

通過這些改進和擴展,EaV數據集將能夠更好地支持情感識別研究,推動這一領域的發展,為實現更自然、更人性化的人機交互奠定堅實基礎。(END)

參考資料:https://www.nature.com/articles/s41597-024-03838-4

本文轉載自 ??大噬元獸??,作者: FlerkenS