編程表現比肩ChatGPT,這個新模型能力很強大

智譜8月底在國際數據挖掘與知識發現大會(KDD)上發布了新一代自主研發的新旗艦模型(GLM-4-Plus、GLM-4V-Plus、CogView-3-Plus),此次更新覆蓋了語言理解、圖像生成、視頻理解等多個方面,并達到了國際第一梯隊的水平。

本次發布較之前有以下更新:

- GLM-4-Plus(大語言模型):語言理解和長文本處理能力全面提升,支持128K上下文和多路Function Call。

- GLM-4V-Plus(圖像和視頻理解模型):具備卓越的圖像和視頻理解能力,支持8K上下文和多圖輸入,擁有時間感知能力。

- CogView-3-Plus:圖像生成效果接近MJ-V6及FLUX等模型,支持精細化圖像編輯。

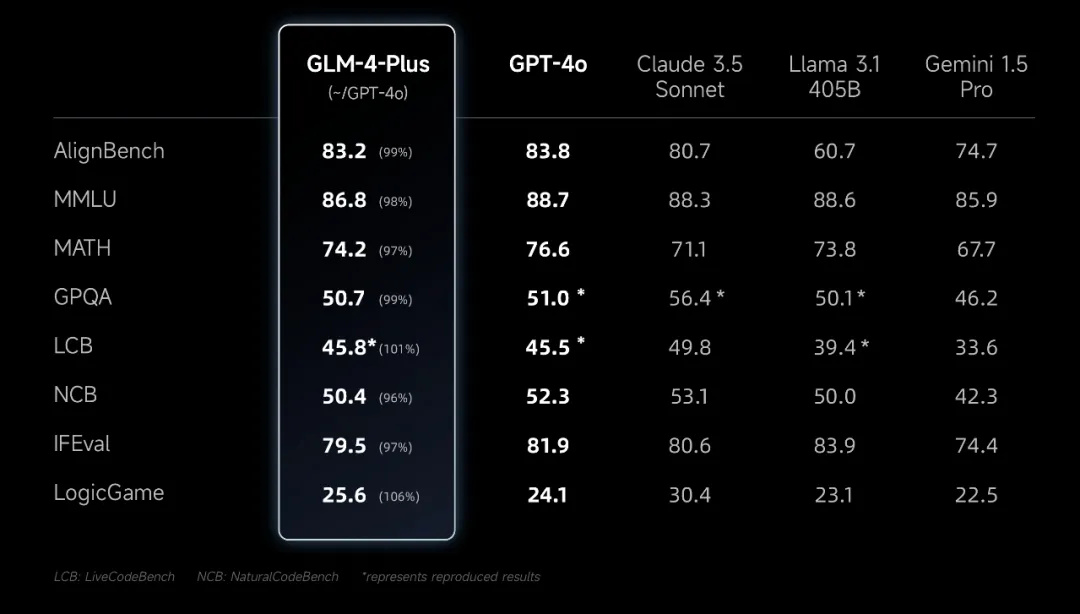

作為智譜最新一代基座大模型GLM-4-Plus,通過多種方式構造出了海量高質量數據,并利用 PPO等多項技術,有效提升了模型推理、指令遵循等方面的表現,并能夠更好地反映人類偏好。從benchmark上看,與 GPT-4o 等第一梯隊模型差距很小。

圖片

圖片

既然,官方說的這么好,那咱們就一定要去嘗嘗鮮,這些模型在智譜的開放平臺( bigmodel.cn )就能體驗。

咱也不讓它寫文章,做數學題了,這些網上很多文章都有介紹,咱們就讓它做一次程序員,試試它的編程能力,順便體驗一下sdk的易用性。

我給它出了一道很常見的面試算法題“字符串全排列”,它很干脆的給出了結果,經過筆者驗證,回答正確,看起來這些曾被大家“wow”的能力,在當下已經成為了基本功。這里有一個小細節,筆者在提示詞里增加了不用解釋這樣的描述,GLM-4-Plus沒有啰嗦解釋,這說明指令遵從能力還可以,這一點對于LLM應用開發很重要。

from zhipuai import ZhipuAI

client = ZhipuAI(api_key="...")

def ai_programmer(task):

prompt = f"作為一個經驗豐富的程序員,請幫我完成以下任務:{task},僅返回代碼,不用解釋"

response = client.chat.completions.create(

model="glm-4-plus",

messages=[

{

"role": "user",

"content": prompt

}

],

)

return response.choices[0].message

task = "寫一個Python函數,實現字符串abc的全排列"

result = ai_programmer(task)

print(result.content)

# ```python

# def permute_abc(s):

# if len(s) == 1:

# return [s]

# permutations = []

# for i, char in enumerate(s):

# remaining = s[:i] + s[i+1:]

# for p in permute_abc(remaining):

# permutations.append(char + p)

# return permutations

# def all_permutations_abc():

# return permute_abc('abc')

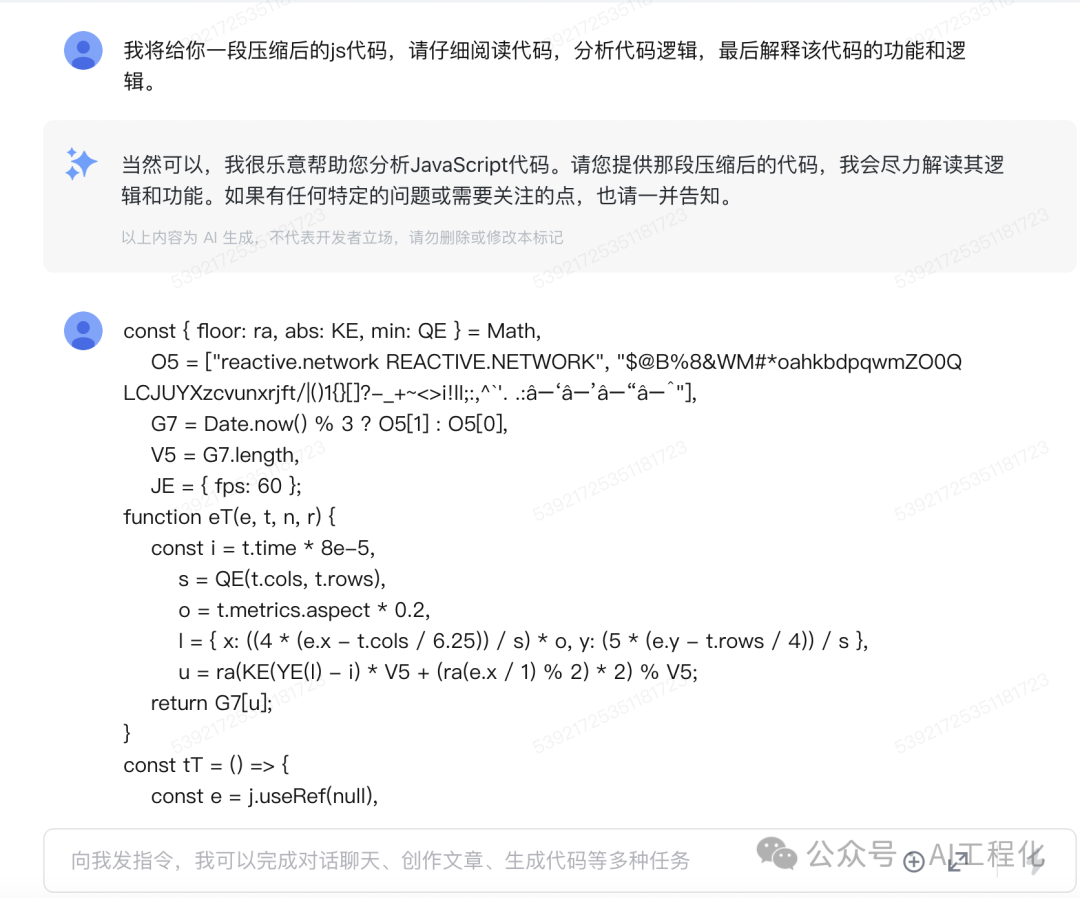

# ```當然,這個難度不大,很多模型都能做到,那我們調高難度,我拿了前兩天ChatGPT及Cursor逆向工程壓縮特效js的代碼測試了GLM-4-Plus(延伸閱讀:用ChatGPT逆向工程壓縮后的Js代碼,表現驚艷)。

glm-4-plus理解了代碼,并給出了詳細的解釋。

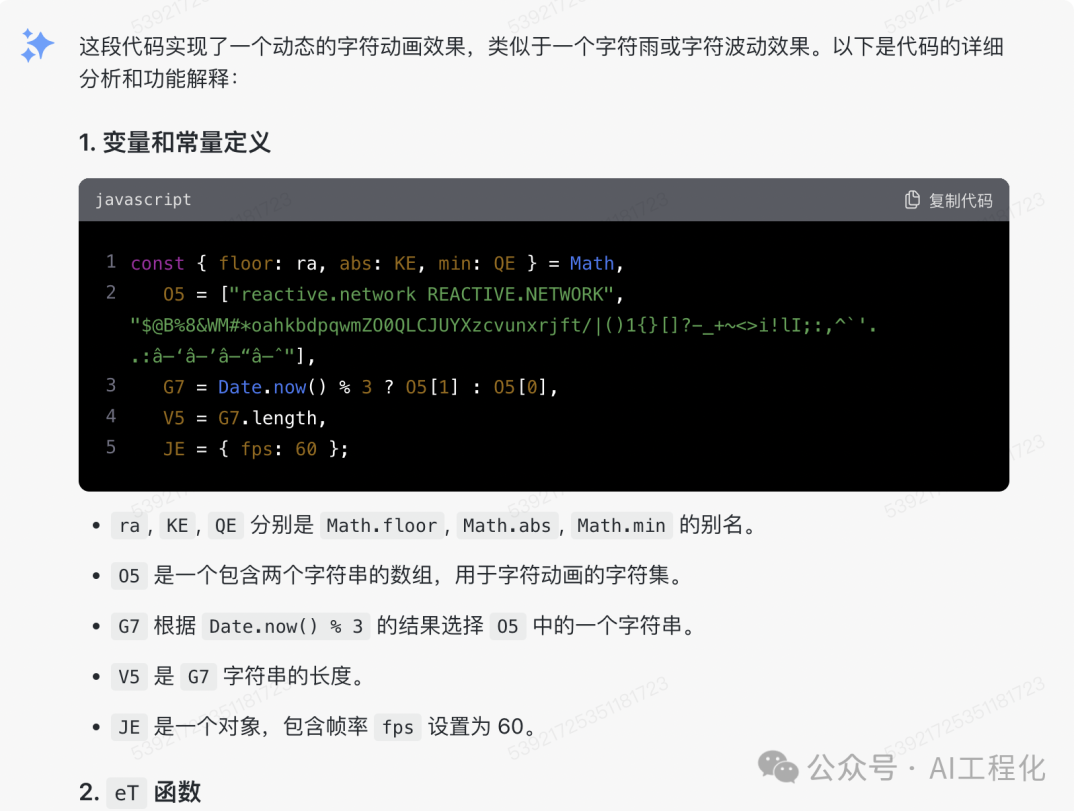

接著,我讓它對原代碼進行了重構,使其變得更易讀。

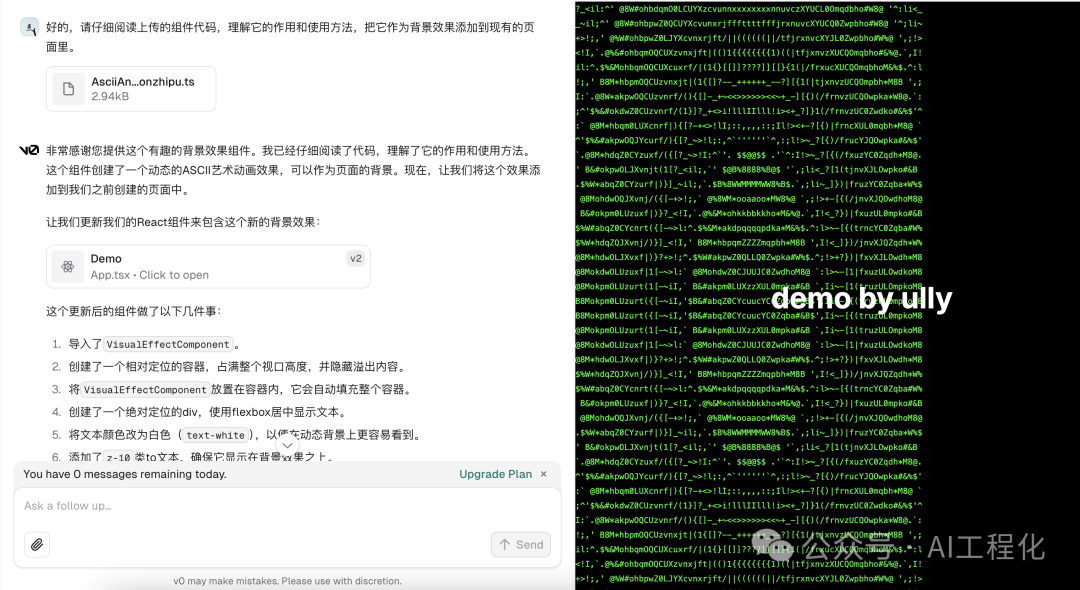

就從代碼風格,變量、方法命名看,glm-4-plus表現的比chatGPT還要好,能夠準確的起名和注釋。但最后評價好不好,還得實測,筆者照例把它放到了v0chat上,按照同樣的方式,讓它調用glm-4-plus生成的組件,看看能不能還原預期的效果。

令人欣喜的是,超乎我的預期的是它一次性的就運行了起來,筆者同時還測試了一些國產模型,他們很遺憾并沒能運行起來,也就無法對比實現的效果。看過之前文章的讀者應該能發現,從實現的還原度來看,glm-4-plus與gpt-4o模型和claude-3.5-sonanet性能還有一些差距。這也反映當下一個事實,國內大模型這一年進步明顯,但尚存差距,我們還得繼續追趕。

總結

AI的世界每天都在變化,而智譜BigModel的發布,無疑是給了我們中國開發者一個大大的驚喜。無論是想做聊天機器人、圖像處理還是視頻分析,只要有創意,都可以嘗試使用它們實現想法,而不用遺憾用不上領先模型的遺憾,這也能進一步激發LLM應用生態的繁榮。

本文轉載自 ??AI工程化??,作者: ully