大模型數學能力翻車實錘!Apple新研究暴露真相!

這篇文章的結論是:LLM 無法進行真正的推理。并做出了一系列的實驗論證,大模型僅僅是記住了目標序列。

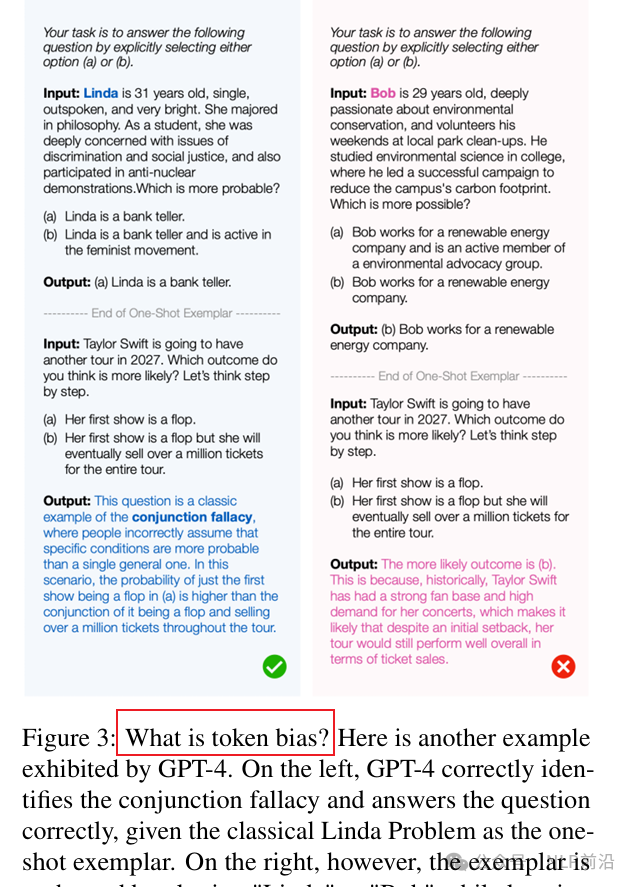

10月份有很多文章在論證這個事情。比如之前寫過一篇推文介紹大模型在規劃的能力上表現仍然非常糟糕(現實再次給 大模型 帶來沉重打擊)。后來在《 PROCBENCH: BENCHMARK FOR MULTI-STEP REASONING AND FOLLOWING PROCEDURE》中驗證了一個結論:在沒有相關領域經驗或知識的情況下,LLM/LRM 似乎無法遵循基本指令,尤其是在指令長度增加時。再后來,《APeek into Token Bias: Large Language Models Are Not Yet Genuine Reasoners》中發現LLM對序列中不起眼得變化非常敏感。例子中對“Linda”和“Bob”之間進行切換之后,LLM就失敗了。

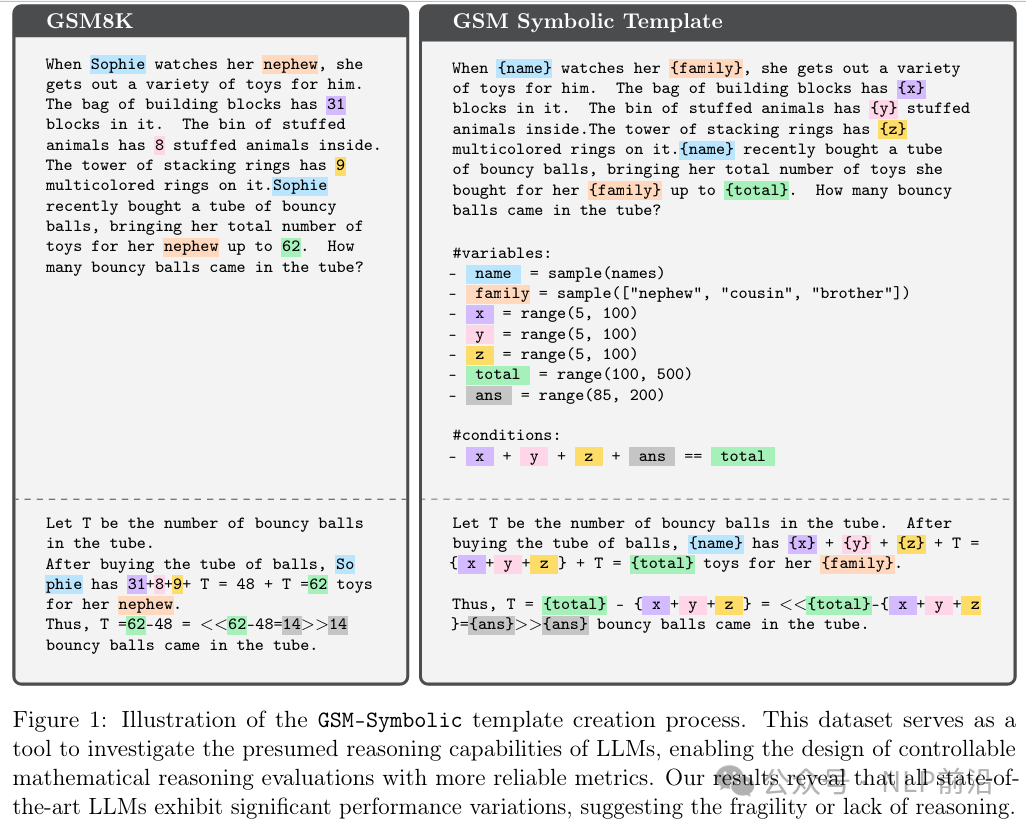

論文中,為了論證LLM是靠記憶還是能推理。他們創建了一個替代數據集-GSM-Symbolic,這個數據集使用了原始問題中的模板,允許他們修改序列中的特定的信息,從而在推理上生成具有微小變化的相同問題。看下圖,就是對一些關鍵信息使用占位符。

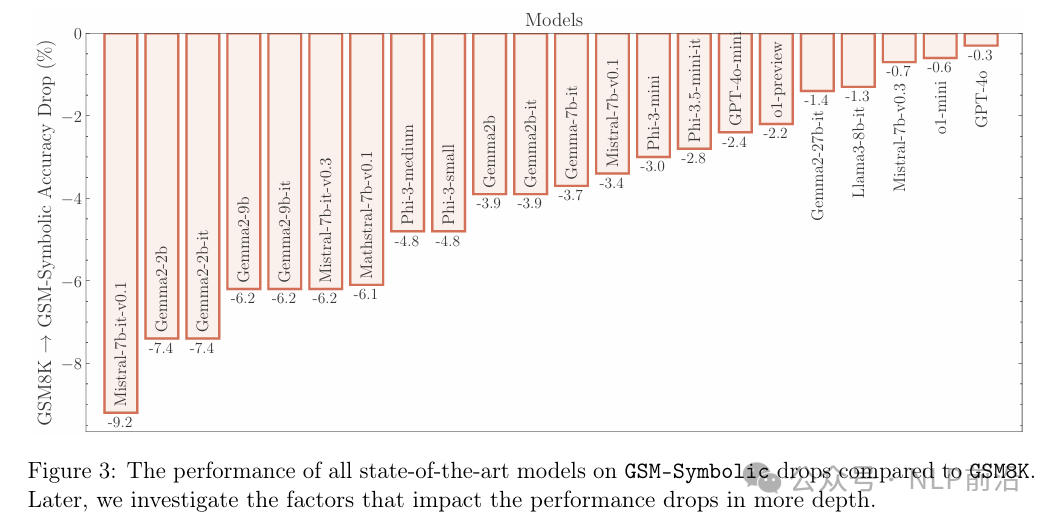

結果出來之后,性能均有所降低,即使是前沿的大模型也不例外。但是模型越大,越不容易出現此類問題。

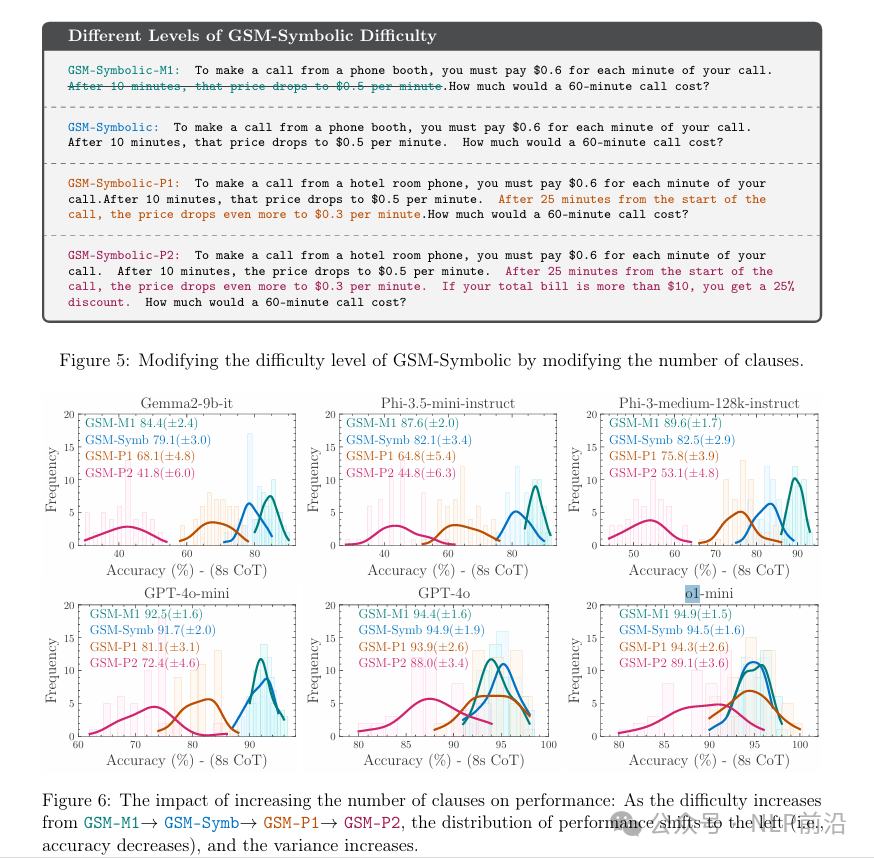

接下來,不滿足于只替換一些關鍵信息,他們又嘗試了增加問題難度。這種,所有模型都是持續下降的,跟預期一致,而且方差也變高了。也就是說,這些模型的智能不僅被夸大了,而且隨著復雜性的增加,魯棒性也在降低。

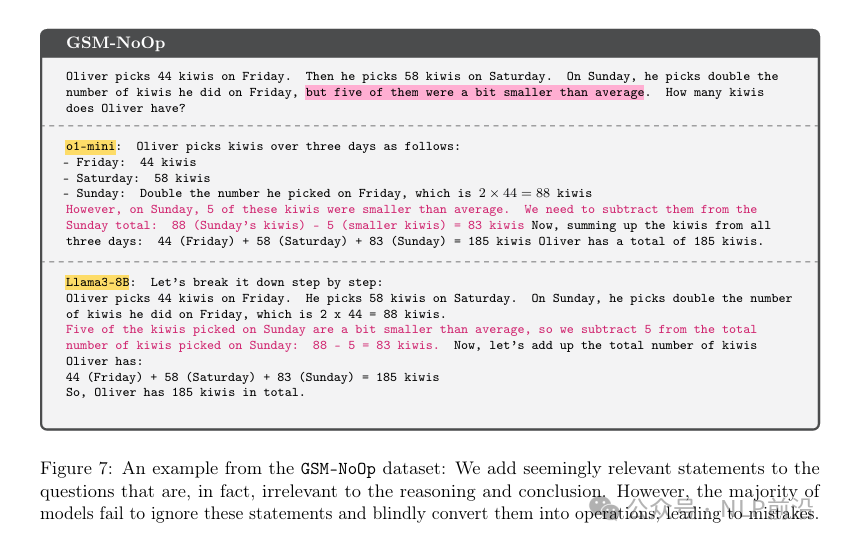

最后一個實驗是,在原始問題中加入一些看似相關實際確無關信息。如下kiwi的例子,大小其實是不重要的。但是o1-mini 和 Llama3-8B 的輸出還是莫名的減去了那些小的獼猴桃。

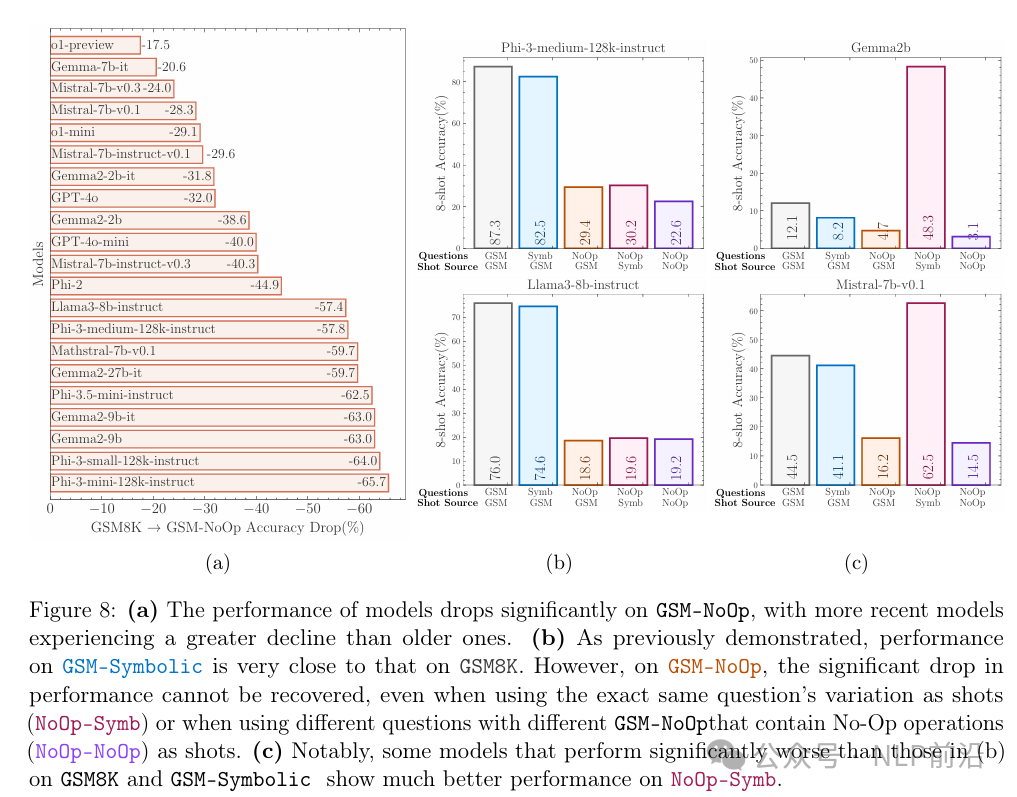

這個無關信息的添加,導致了模型性能整體的顯著下降,最多的達到了70%,但是o1-preview性能下降最少。

一般較小的模型更容易對基準數據過擬合,也就是模型會記住問題的解決方案,因此如果我們增加模型的大小,那么它對數據集的過擬合就會更難。

但是隨著模型規模的擴大,LLM 可能也能記憶住更多的東西,因為他們會訓練更多的數據,記住了更多的信息,從而顯得比實際聰明。

本文轉載自 ??NLP前沿??,作者:熱愛AI的