大模型技術進階路線,有了基礎應該怎么進階? 原創

“ 高性能大模型的打造,是一項復雜的系統性工程 ”

在上一篇文章中講了學習大模型的基礎路線,而如果是對有一定基礎的人來說,應該怎么進階呢?也就是說大模型更加高級的技術棧有哪些?

一個好的基礎能夠讓你在學習的道路上事半功倍,但絕對不是學習的終點,大模型技術也不外如是。

大模型的進階學習路線

在上一篇的文章中介紹了大模型的基礎學習路線,比如基礎理論,編程,深度學習框架等等。

以上技術都屬于大模型技術的基礎,不論是做學術研究,還是個人學習都已經足夠;但是一項技術并不僅僅用來學習的,還需要能夠在企業生產中應用,而在生產環境中對穩定性的要求要遠高于對技術的追求。

那么怎么才能打造一款能夠在企業生產中使用的大模型呢?而這就屬于大模型技術的進階;如果說大模型的基礎是能夠做出來一個大模型,那么大模型的進階就是怎么把大模型做的更好。

下面也將從幾個方面介紹一下大模型的進階:

- 模型優化

- 硬件加速

- 分布式并行計算

模型優化

我們知道大模型目前最大的瓶頸就是算力問題,而算力就代表著成本,大模型技術面臨著高昂的成本問題。這也間接導致了很多小微企業對大模型望而卻步,原因就是無法承擔大模型巨大的資金成本和技術成本。

因此,就有很多模型優化的技術,比如說遷移學習,模型剪枝,模型蒸餾等;目的就是用最小的成本,快速的打造出一款能用的,好用的大模型。

模型剪枝:模型剪枝通過刪除冗余神經元和連接,減少模型的大小而不犧牲性能。

模型量化:模型量化通過降低精度,如從float32轉化為int8,降低模型的計算量和存儲需求。

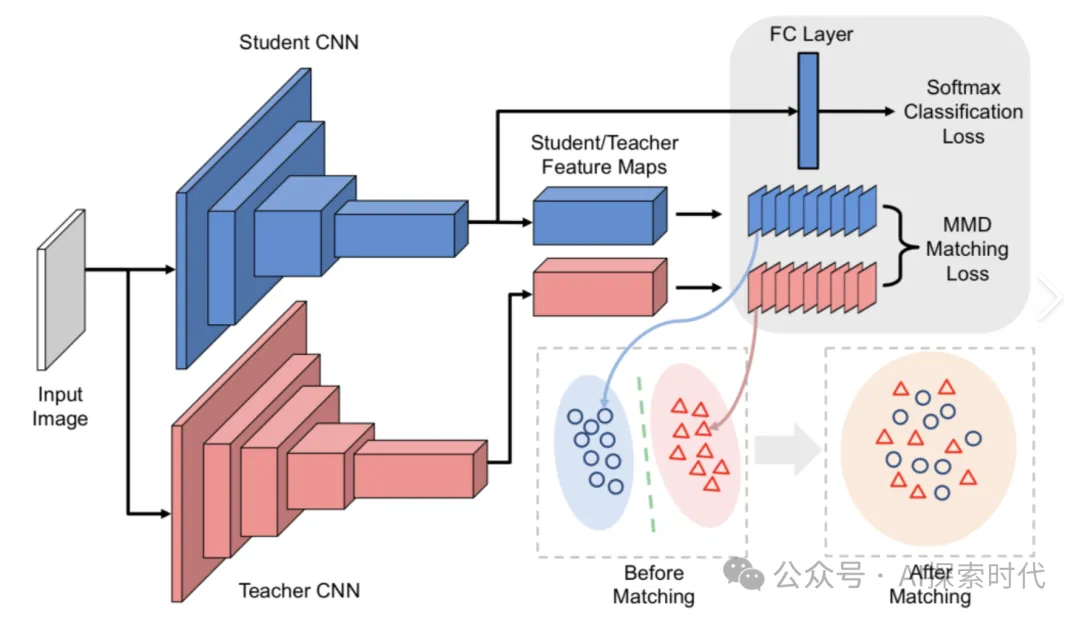

知識蒸餾:知識蒸餾則是將大模型的知識轉移到小模型,保持小模型的準確性。

通過以上方法,能夠大大提高模型部署效率和資源利用率,降低企業成本。

硬件加速

關于硬件加速每個了解大模型的人應該都知道一些,最簡單也是最知名的方式就是增加GPU的數量;而英偉達市值的飆升,以是因為其強大的算力芯片。

那么硬件加速具體是什么情況呢?

其實加速有多種方式,成本最低的就是優化模型架構,使用更加高效的算法,這些叫做軟件加速。但以目前的技術來說,軟件加速的能力有限,因此唯一的辦法就是堆量,通過大量的計算硬件資源的堆積來解決算力不足的問題。

大模型常見的硬件加速除了GPU之外,還有FPGA和ASIC等。

CPU,GPU,FPGA,ASIC是目前AI計算過程中最主流的四種芯片類型,CPU這玩意不用多說,任何電子產品都離不開它的存在;但CPU這玩意功能強大,但并不是很適合AI處理。

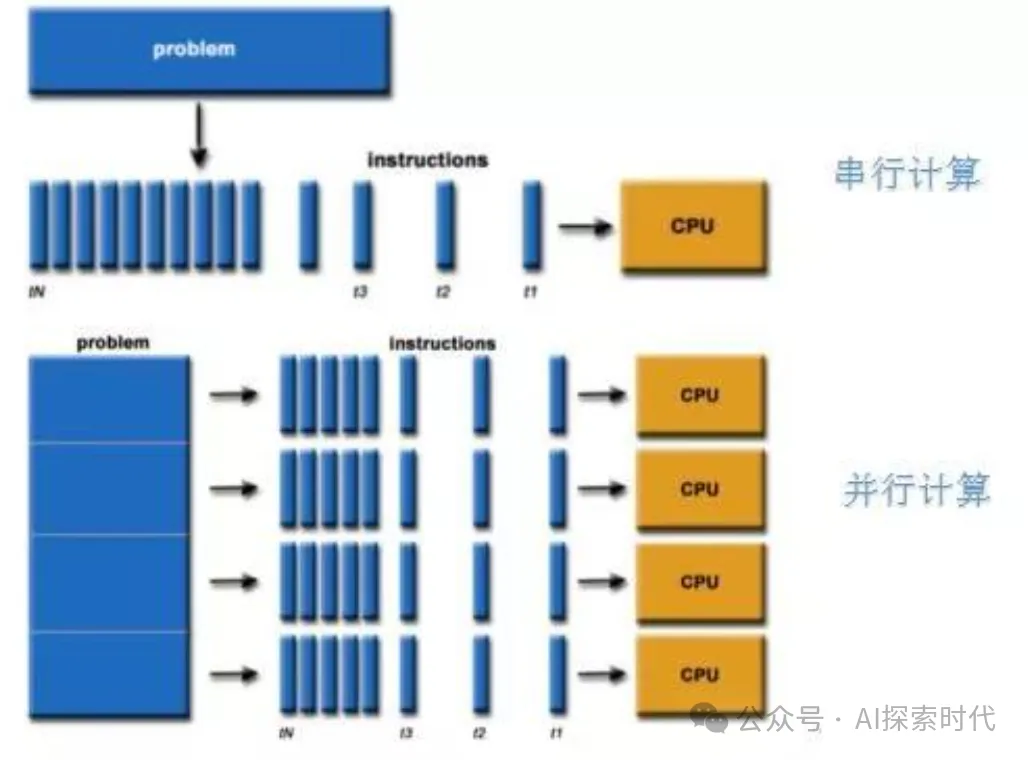

原因就是CPU就是一個大學生,它能夠處理復雜的數學問題;但AI算力更多的需求并不是處理復雜的邏輯問題,而是計算一大段100以內的加減法,大學生再厲害它的時間和精力也是有限的,遠不如找幾百個小學生每人算一題來的快。

因此,GPU這玩意就是大力出奇跡的典型代表,我不需要多么高深的知識儲備,只需要簡單的1加1等于2就行了。

而FPGA是指現場可編程門陣列,它是一個可以現場編程的,并按照預定設計意圖來工作的集成電路。FPGA最厲害的地方是可以通過配置的方式來實現任意需要的功能組合,并且可以以大規模并行的方式實施算法,這意味著我們可以非常迅速和高效的執行大數據處理。

ASIC——特定應用集成電路,它是用來專門針對某一領域設計的芯片,比如神經網絡計算芯片——NPU,Tensor計算芯片TPU等。因為針對特定領域,所以ASIC往往可以表現出比GPU和CPU更強的性能。

分布式并行計算

大模型由于其強大的算力需求,在單臺機器上已經很難完成大模型的訓練和微調,因此采用分布式并行計算是一個無法避免的選擇。

所謂的并行計算,就是把大模型根據模塊或功能拆分,然后部署到多臺機器上進行計算。其難點是模塊的拆分,以及不同機器上的數據協調和整合。

在傳統的分布式系統中,比如web開發是根據功能模塊進程拆分,不同服務之間通過API的方式進行交互,而且不同服務之間沒有強關聯性。

但大模型不同,大模型是一個整體它的任何環節出問題都會導致模型的失效,因此大模型只能采用并行計算的方式進行分布式部署。

而根據不同的并行方式,大模型并行計算又分為多種類型,如:

- 數據并行

- 張量并行

- 流水線并行

不同的并行方式有其獨特的特點和實現方式,不同的模型根據實現方式不同也有其最適合的并行計算方式。但總體來說,并行計算是大模型訓練和微調的基礎,沒有并行計算,大模型也很難存在。

打造一款能用好用且高性能的大模型并不是一件簡單的事情,其中涉及到很多復雜的理論和難點,同時還要面臨著巨大的技術和資金成本,因此打造大模型并不是人人都能參與的工作。

本文轉載自公眾號AI探索時代 作者:DFires