為什么有了大模型還需要用Embedding模型?

不知道大家有沒有想過這個問題?

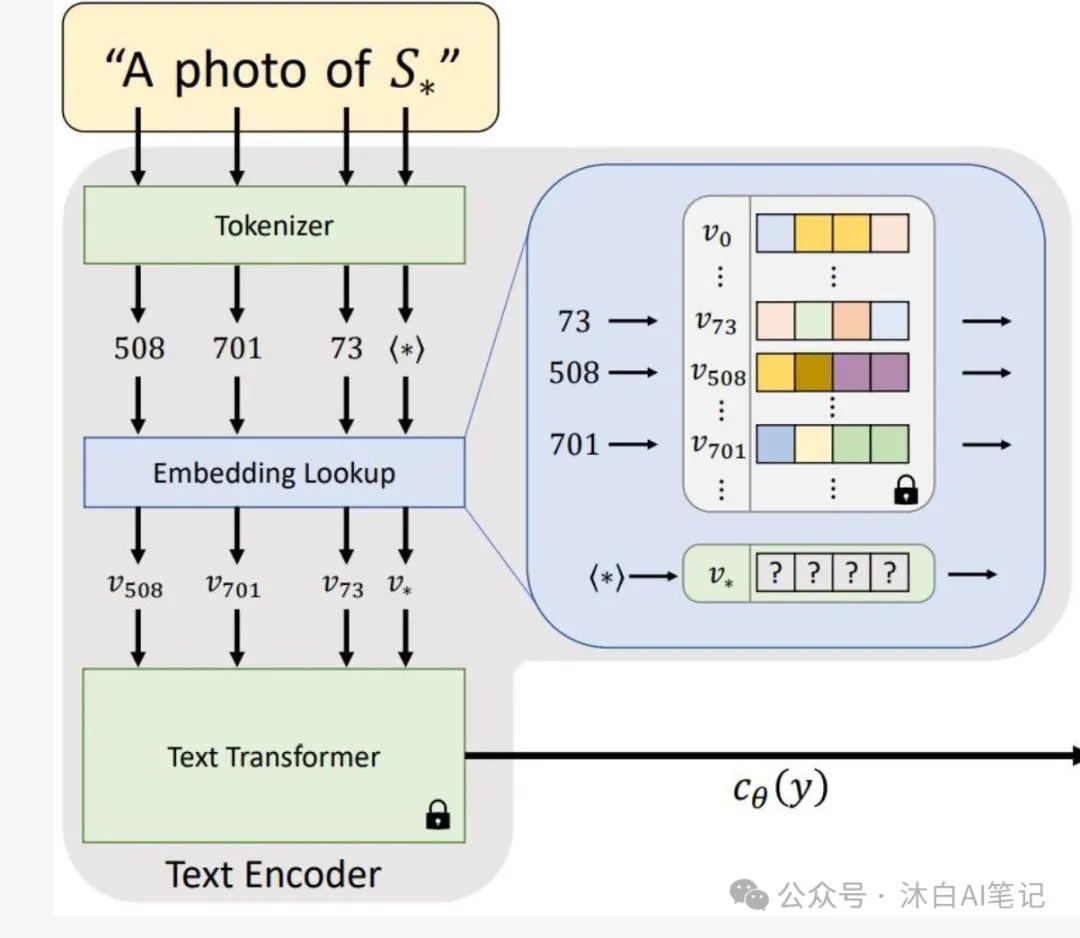

我這兩天對這個問題還深入思考了一下,思考的初衷是來源于現在這么多的開源大模型,而且挺多是多模態場景,而Embedding模型相對單模且英文語料居多,如果能復用大模型的output layer,是不是會加速手頭上的實驗進展。

但思考后覺得效果應該是比不上原生的Embedding模型,有空再專門測試一下看看。

可能主要有以下幾點原因:

- 像LLM模型都是預測next token,那么針對next token的預測,模型肯定更加關注在這個token附近的信息,那么對應這個Embedding也更多是這附近的局部信息。而我們需要的Embedding表征,是輸入句子的全局表征,而不是“你好嗎,我吃飯了,你可以出來了嗎?”這句話里,對其中“你可以出來了嗎”做的局部信息特征映射。

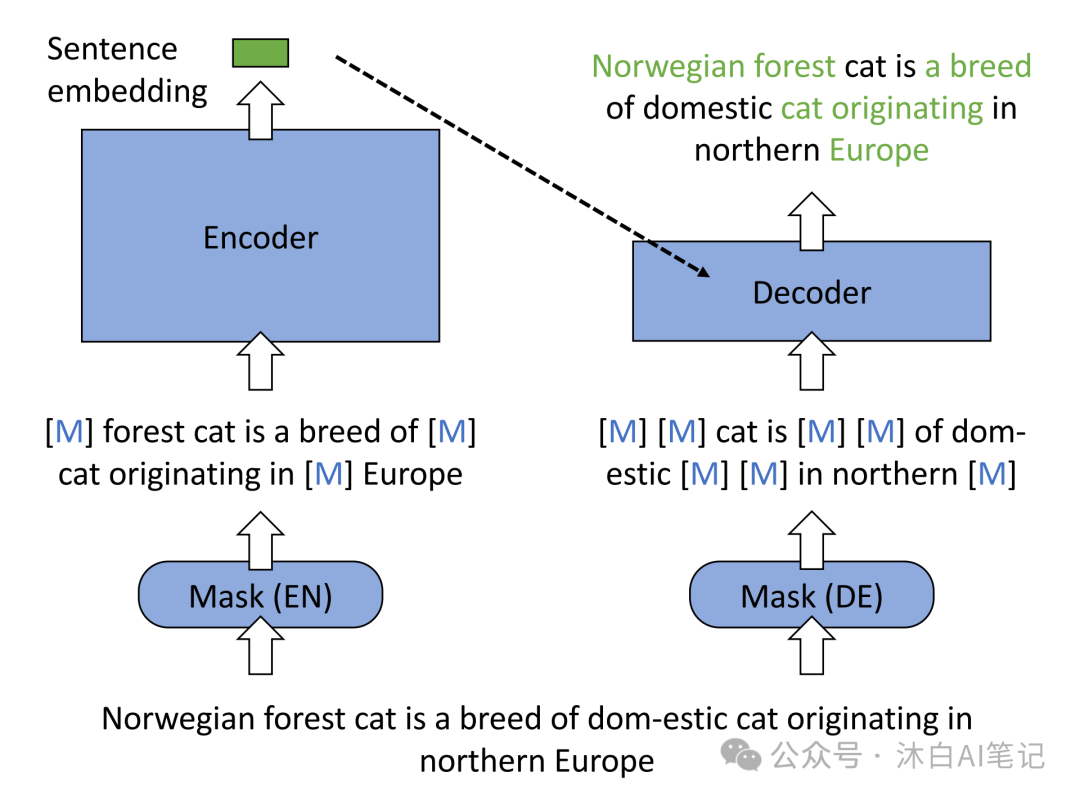

- 目前比較好的Embedding模型都用到了對比學習,這種學習方式能夠更精確地學習的全局Eembedding特征,如果用LLM也可以在下游接一個自監督訓練器,效果也會很不錯,就是成本有點高。最近有一篇paper也可供參考:《Improving Text Embeddings with Large Language Models》

對比學習目標是,學習一個這樣的特征提取器,在它提取的特征所構建的 embedding 空間中,同類樣本的 embedding 互相靠近,而不同類樣本的embedding相互遠離。通常,同類樣本對互稱為正樣本(positive sample),不同類樣本對互稱為負樣本(negative sample)。

本文轉載自 ??沐白AI筆記??,作者: 楊沐白

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦