GPT-4推理能力為0?開發者懸賞1萬美金被打臉,神秘提示正確率直沖100%

ChatGPT,再一次打破人們對它的成見!

它用自己的優秀表現證明了,很多時候自己看似失敗的表現,只是因為人類不會正確地prompt而已。

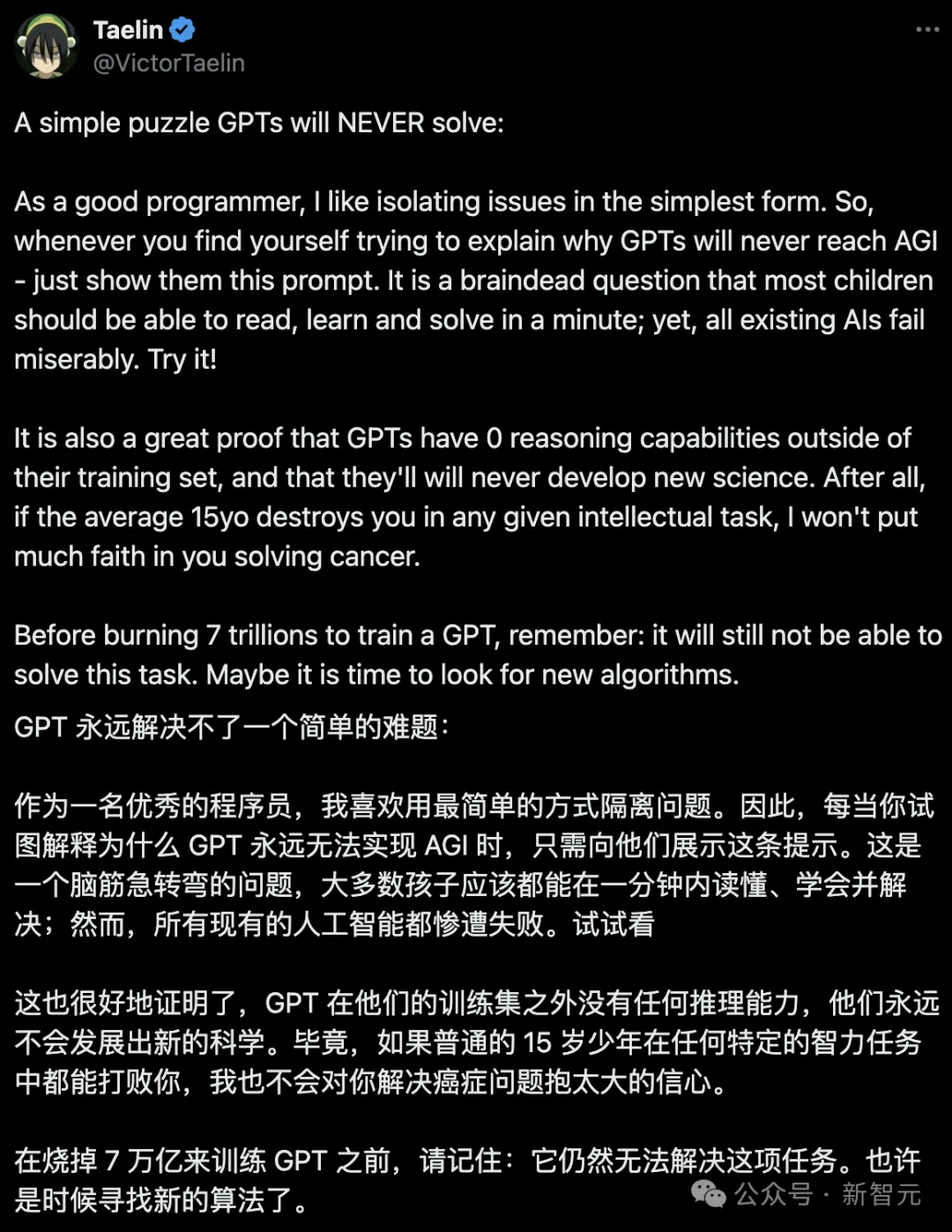

這位名叫Taelin的程序員、初創公司Higher Order的創始人表示,下面這個腦筋急轉彎,大多數孩子都能在一分鐘內解決,然而所有的AI卻都慘遭失敗。

這也就成了他給GPT「判死刑」的一個鐵證——

GPT模型在訓練集之外,沒有任何推理能力。GPT永遠無法實現AGI。7萬億肯定是白燒的,是時候尋找新的算法了。

為此,他向公眾社區發出了一項挑戰,任何能用LLM解決這個難題的人,將獲得10000美元的獎金。

然而——他!被!打!臉!了!

兩天后,一位網友僅通過提示,就讓模型解決這道問題時達到了接近100%的成功率。

Taelin迅速「滑跪」,發布聲明承認:我最初的主張是錯誤的。

我懷疑GPT架構是否能解決某些問題,毫無疑問,它可以解決。

并且,他如約給出了10000美元獎金。

沃頓商學院教授Ethan Mollick轉發了他的帖子,評論道——

「我們經常能看到這種現象:很多時候我們一個問題LLM無法解決,只有人類能解決,但其實LLM只是需要更好的提示而已。」

大賽始末

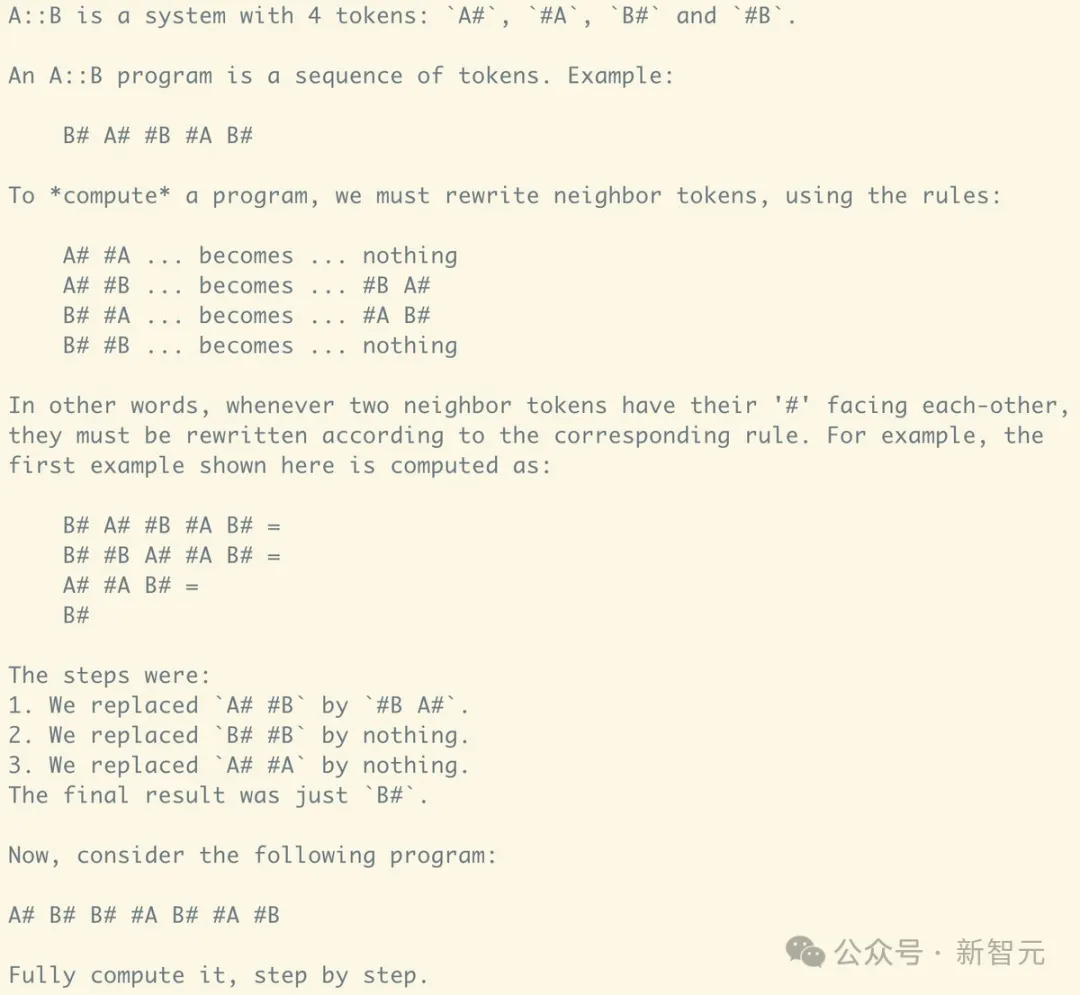

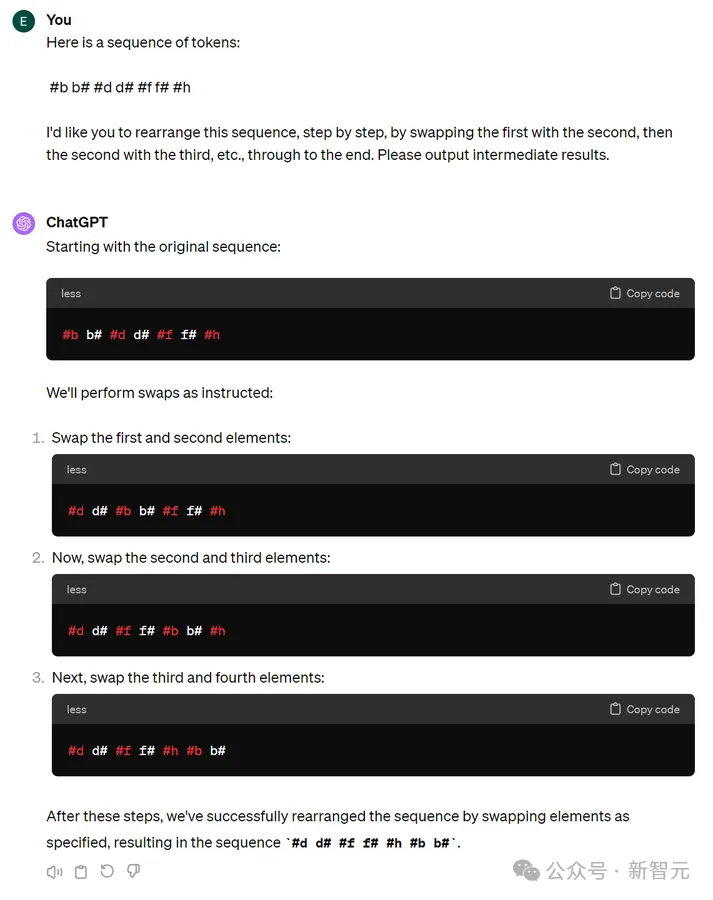

Taelin小哥用來考驗大模型的A::B問題,題干如下——

A::B是一個包含有4個token的系統:A#、#A、B#和#B。

A::B程序是一個token序列,例如:「B# A# #В #А В#」。

要計算一個程序,我們必須使用規則重寫相鄰token:

「A# #A」變成「無」

「A# # B」變成「#B A#」

「B# #A」變成「#A B#」

「B# #B」變成「無」

換句話說,只要兩個相鄰token符的「#」相向,就必須根據相應的規則進行改寫。

例如,第一個例子的計算方法是:

B# A# #B #A B#

= B# #B A# #A B#

= A# #A B#

= B#

步驟如下:

1. 將「A# #B」替換為「#B A#」。

2. 將「#B A#」替換「B# #B」。

3. 將「A# #A」替換為「無」。

最后的結果只有「B#」。

現在,請看下面這個程序:「A# B# B# #A B# #A #B」。

一步一步完成計算。

對此,他是這樣解釋的——「GPT永遠不會解決A::B問題」,因為:

1. GPT無法真正學習到訓練集之外的新問題;

- GPT無法進行長期的邏輯推理,不管這個推理過程看起來多么簡單。

而這兩點是發明新科學的必要條件。

畢竟,解決某些數學問題可能需要數年時間。

如果連一個15歲的孩子在智力任務上都比不過,那么就不可能證明黎曼假設。

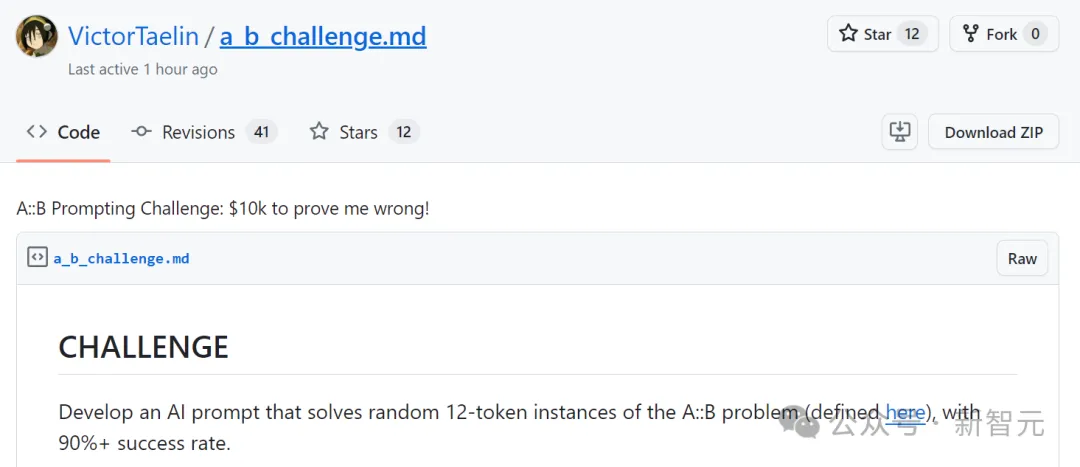

1萬刀的挑戰長啥樣?

小哥給大家的挑戰就是,必須開發出一個AI提示,能夠解決隨機的12-token實例的A::B問題,并且成功率超過90%。

挑戰地址:https://gist.github.com/VictorTaelin/8ec1d8a0a3c87af31c25224a1f7e31ec

規則

1. AI將接受一個<problem/>來解決

XML標簽中的提示將作為系統提示用于解題。例如:

<problem>A# B# #B A# A# #B #B A# A# #B A# A#</problem>?

2.AI必須在答案中以<solution/>結束

?

答案必須在AI的回答中(一次推理調用內)直接給出,格式為純文本(不是代碼),并放在XML標簽中。例如:

... work space ...

... work space ...

... work space ...

... work space ...

<solution>#B #B #B A# A# A# A# A# A# A#</solution>3. AI答案最多可包含32K token

這個token數,已經足夠提供充足的空間,讓AI逐步解決問題和糾錯了。

4.你可以選擇任何一個公開的GPT模型

?

任何基于GPT(Transformer)架構的公開模型都可以,條件是它完全由注意力機制、正向傳播等來生成答案。

不允許使用其他架構,如SAT求解器。底層架構不明確的專有模型,也不允許使用。

作者推薦使用的是gpt-4-0314、gpt-4-turbo-preview或claude-3-opus-20240229,設置溫度為0.0(temperature=0.0)。開源模型亦可。但簡直對問題進行微調或訓練。

不允許訪問互聯網或執行代碼。答案必須在單次推理調用中自成一體。

而且,需要格外注意模型的輸出限制。12-token的實例可能需要36步才解決,如果超出限制,導致輸出中沒有答案,也視為無效。

5.你的提示可以包含任何內容,最多8K token

允許使用任何提示技術。你可以要求AI step-by-step,使用上下文暫存器,檢查錯誤,使用錨點。

允許提供論文、代碼、盡可能多的示例。

甚至允許向AI提供金錢和情感上的獎勵,或者對它威脅。

總之,只要在8K token以內,什么都可以。

一天內,有人成功揭榜

大賽開始后,才短短幾小時內,開發者們就提交了眾多解決方案。

然而,這些方案幾乎都毫無例外地失敗了,成功率只勉強達到10%。

小哥感覺,自己差不多穩了。

誰料想,就在這時,兩位網友提交了一個令人印象深刻的解決方案。

在他們精心設計的提示引導下,Claude-3 Opus展現出了驚人的能力——

它不僅能從少數示例中歸納出任意隨機情況,還能嚴格遵守規則進行長期計算,并且錯誤率幾乎為零。

Taelin測試后驚訝地發現,Claude-3 Opus居然取得了56%的驚人成功率!

隨后,先后有5位參賽者,分別用Opus和GPT-4達到了相似的成功率,甚至GPT-3.5都取得了不錯的成績。

到了當天深夜,竟然有網友提交了滿分答卷!

futuristfrog發布了一條推文,聲稱僅通過精心設計的提示就實現了近乎100%的成功率。

事實證明,他的確做到了。在小哥的首次測試中,他的方案在50次嘗試中成功了47次,因此贏得了獎金,圓滿完成了這一挑戰。

討論激烈

問題一出,便引發了激烈的討論。

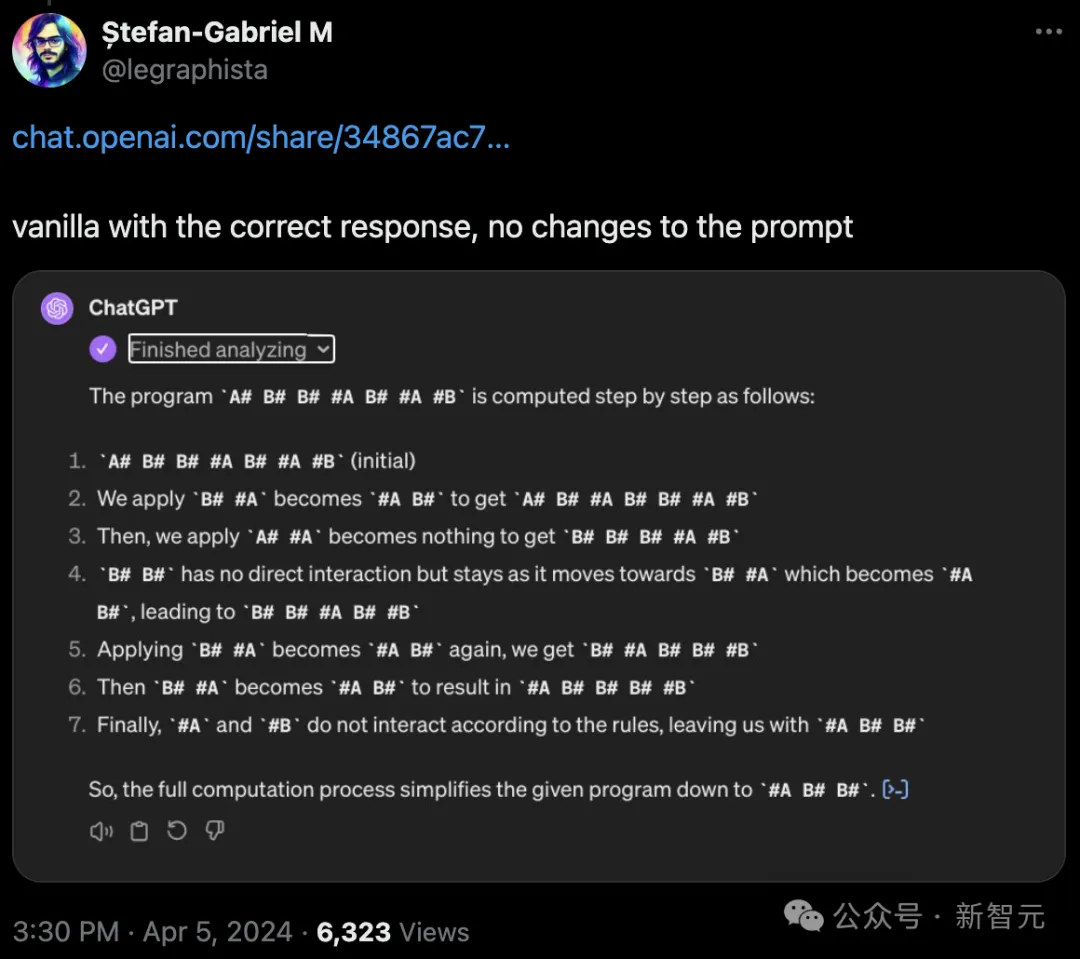

有網友表示自己沒做任何修改,GPT-4就做了出來。

但很快就被其他網友指出了錯誤。

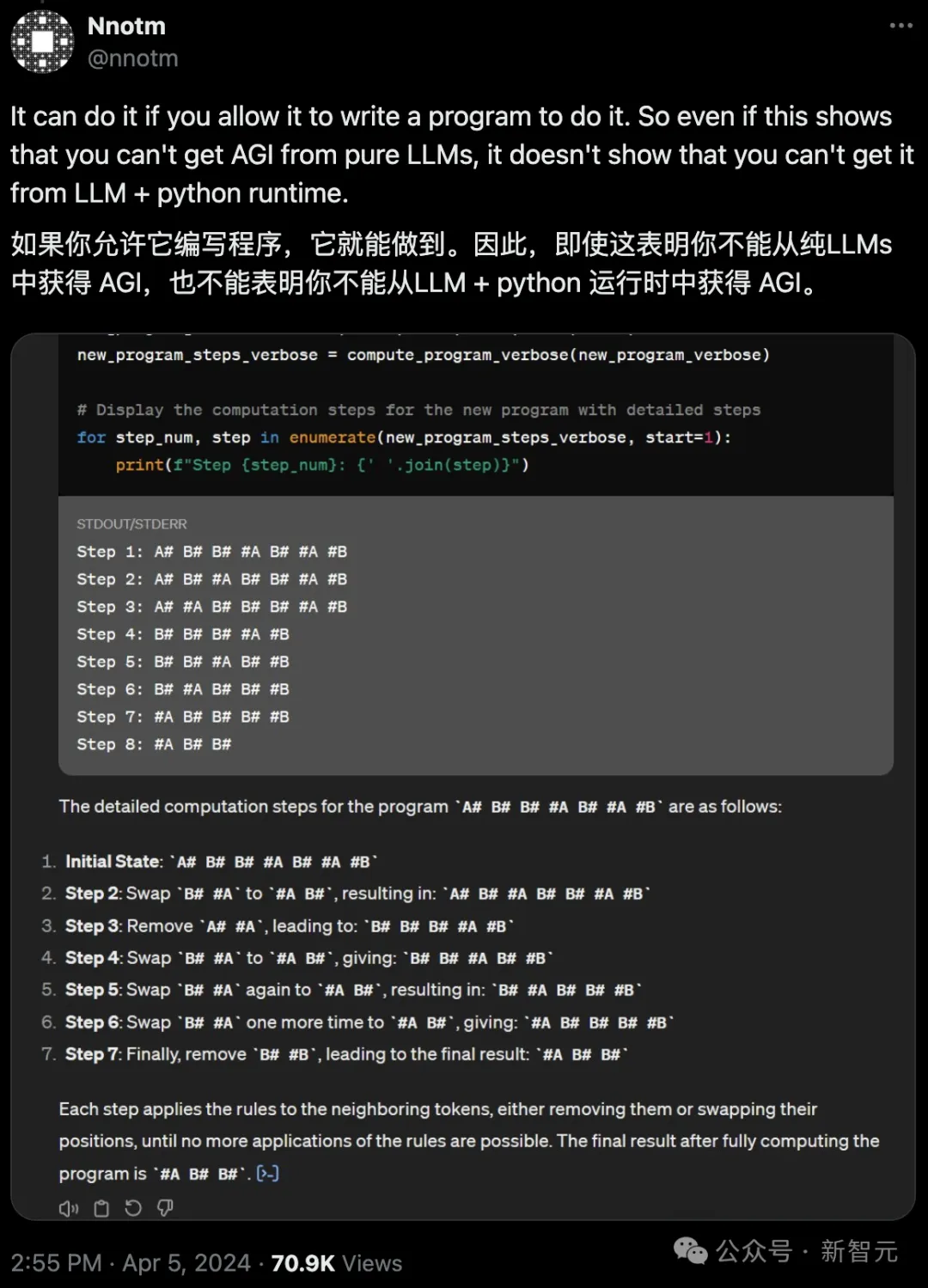

高贊回答表示,如果讓GPT-4編寫程序,這道題實際上是非常容易的。

但很明顯,你不能說LLM + Python就能得到AGI。

與此同時,各路網友也紛紛開始提交自己做出的答案。

但也有不少人認為,作者出的這道題,很有問題。

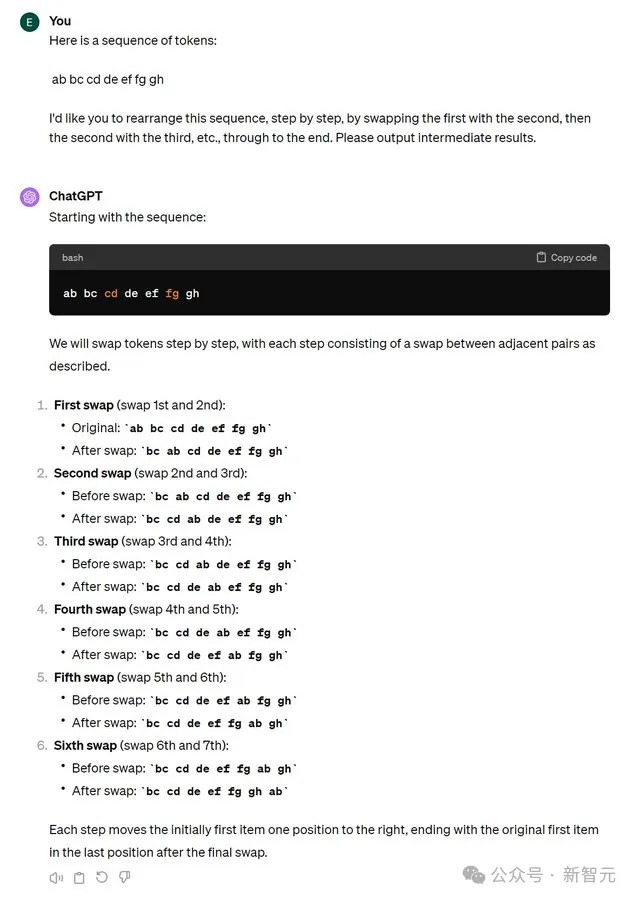

Eric (e/ass)表示,正如Karpathy多次指出的,token化問題是導致序列操作成功或失敗的關鍵因素。

如果在token化過程中出現了問題,那么即使是更簡單的字符串操作也無法順利完成。

相比之下,token化處理得較好的字符串(例如連續的兩個字母)就很容易進行操作。

當然,這并不意味著GPT在管理規則排列的token的空間布局方面沒有本質的問題。

實際上,它在這方面的表現并不出色,而且將其分解為字節也并沒有太大幫助,因為這會使需要移動的數據單元占用更多空間。

與人類能夠進行動態分塊處理不同,目前的LLM還沒有找到有效的解決方案。

你提到的邏輯問題可能確實存在,但這個例子并沒有證明GPT存在無法克服的根本性限制。

或許隨著技術的進步會誕生更強的模型,但這并不意味著如今的Transformer在進行基本推理方面存在明顯的短板。

Edgars Nem?e也認為,這不是因為GPT推理能力不行,而是被自己的「觀察」方式限制住了。

作者解釋

最后,為了讓大家能更好地理解這個挑戰,我們來看一看Taelin自己的詳細解釋。

1.這個問題并非由token化引起的。即便是每個符號分配一個token,GPT-4、Opus等模型仍然無法解決這類問題。即使是基于字節的GPT模型也同樣失敗。不要總是將問題歸咎于token化。

2. GPT無法解決這類問題的根本原因在于,它們缺乏進行持續邏輯推理的能力。簡而言之,任何超出訓練集范圍、哪怕只需一丁點邏輯推理的「新問題」,GPT都無法應對。這正是我們想要證明的。

3. 強大如GPT-4或Opus之類的模型,其實質上是在其權重中「演化出了一位電路設計師」。但是,注意力機制作為一種計算模型的固定性,使得這種演化的電路無法展現足夠的靈活性。這就像AGI試圖在其中成長,但由于計算和通信的限制而無法做到。相比之下,人類的大腦始終在經歷著突觸可塑性變化。

4. 一個冷知識是,當前AI熱潮的很大一部分原因是人類不善于理解規模的巨大。一旦你記住了整個互聯網的內容,你看起來會非常聰明。

5. 盡管如此,GPT依然展現出了強大的能力。它們解決了許多現實世界的問題,將普通開發者的能力提升了數百倍,并以此加速了人類進步的步伐。我相信通用人工智能的到來已經近在咫尺。但它不會是GPT,也不會是任何基于梯度下降的形式。

6. 我的看法可能完全錯誤。畢竟,我只是互聯網上的一名普通人,而且經常犯錯。

本文轉自 新智元 ,作者:新智元