大模型的記憶困境:平衡持續學習與災難性遺忘 精華

一、引言

持續學習是智能的關鍵方面。它指的是從非平穩數據流中增量學習的能力,對于在非平穩世界中運作的自然或人工智能體來說是一項重要技能。人類是優秀的持續學習者,能夠在不損害先前學習技能的情況下增量學習新技能,并能夠將新信息與先前獲得的知識整合和對比。

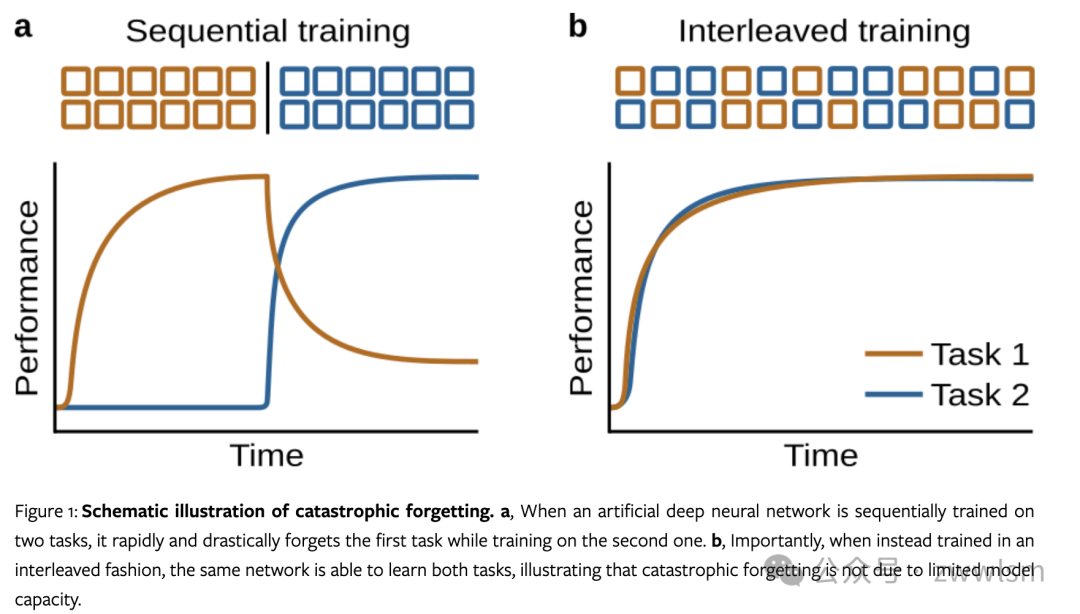

然而,深度神經網絡雖然在其他方面可以與人類智能相媲美,但幾乎完全缺乏這種持續學習的能力。最引人注目的是,當這些網絡被訓練學習新事物時,它們傾向于"災難性地"忘記之前學到的東西。

深度神經網絡無法持續學習有重要的實際意義:

- 深度學習模型需要長時間在大量數據上訓練才能獲得強大性能,但如果有新的相關數據可用,僅在新數據上快速更新網絡是行不通的。

- 即使在新舊數據上一起繼續聯合訓練,通常也無法獲得令人滿意的結果。

- 業界實踐中往往會定期在所有數據上從頭重新訓練整個網絡,盡管這會帶來巨大的計算成本。

因此,為深度學習開發成功的持續學習方法可能會帶來顯著的效率提升,并大幅減少所需資源。此外,持續學習還可以用于糾正錯誤或偏差,以及邊緣設備的實時在線學習等應用場景。

二、持續學習問題

2.1 災難性遺忘

災難性遺忘是指人工神經網絡在學習新信息時傾向于快速且劇烈地忘記先前學習的信息。下面是一個簡單的示例代碼,展示了災難性遺忘現象:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.neural_network import MLPClassifier

# 生成兩個簡單的二分類數據集

np.random.seed(0)

X1 = np.random.randn(100, 2)

y1 = (X1[:, 0] + X1[:, 1] > 0).astype(int)

X2 = np.random.randn(100, 2) + 3

y2 = (X2[:, 0] - X2[:, 1] > 0).astype(int)

# 創建并訓練神經網絡

model = MLPClassifier(hidden_layer_sizes=(10,), max_iter=1000)

# 訓練任務1

model.fit(X1, y1)

accuracy1_before = model.score(X1, y1)

# 訓練任務2

model.fit(X2, y2)

accuracy1_after = model.score(X1, y1)

accuracy2 = model.score(X2, y2)

print(f"Task 1 accuracy before Task 2: {accuracy1_before:.2f}")

print(f"Task 1 accuracy after Task 2: {accuracy1_after:.2f}")

print(f"Task 2 accuracy: {accuracy2:.2f}")這個示例展示了一個簡單的神經網絡在連續學習兩個任務時的災難性遺忘現象。在學習第二個任務后,模型在第一個任務上的性能顯著下降。

2.2 持續學習的其他重要特征

除了避免災難性遺忘,成功的持續學習方法還應具備以下特征:

- 適應性

- 利用任務相似性

- 與任務無關

- 噪聲容忍

- 資源效率和可持續性

下表總結了這些特征及其重要性:

特征 | 描述 | 重要性 |

適應性 | 快速適應新情況或環境 | 對于實時應用至關重要 |

利用任務相似性 | 在相關任務之間實現正遷移 | 提高學習效率和泛化能力 |

與任務無關 | 不依賴于任務標識符 | 更接近真實世界的學習場景 |

噪聲容忍 | 處理原始、嘈雜的數據 | 增強模型在實際應用中的魯棒性 |

資源效率 | 高效使用計算和存儲資源 | 使持續學習在實踐中可行 |

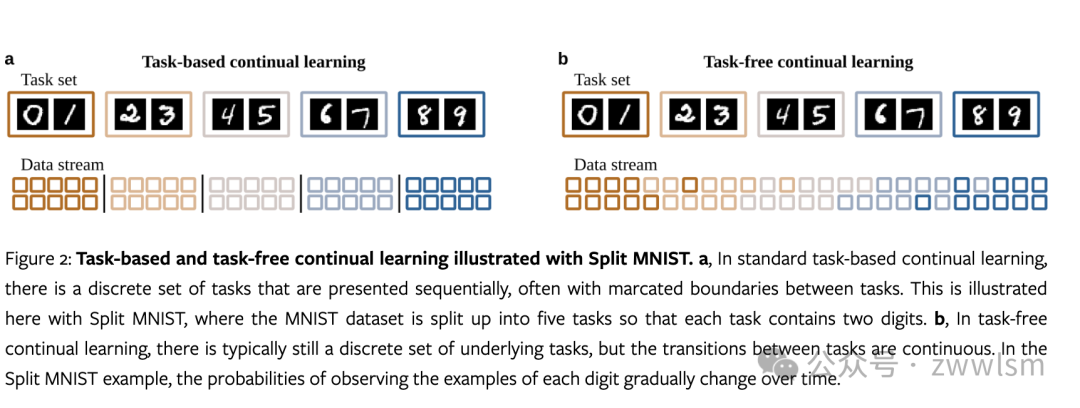

2.3 基于任務與無任務持續學習

基于任務的持續學習假設存在一組離散的任務,而無任務持續學習允許任務之間的漸進過渡和任務重復。以下是一個簡化的示例,展示了這兩種方法的區別:

import numpy as np

def generate_data(task, n_samples=100):

if task == 0:

return np.random.randn(n_samples, 2), (np.random.randn(n_samples) > 0).astype(int)

else:

return np.random.randn(n_samples, 2) + 2, (np.random.randn(n_samples) > 0).astype(int)

# 基于任務的持續學習

for task in [0, 1]:

X, y = generate_data(task)

# 訓練模型...

# 無任務持續學習

for t in range(1000):

task_prob = min(1, t / 500) # 任務概率隨時間變化

task = np.random.choice([0, 1], p=[1-task_prob, task_prob])

X, y = generate_data(task, n_samples=1)

# 訓練模型...2.4 三種持續學習場景

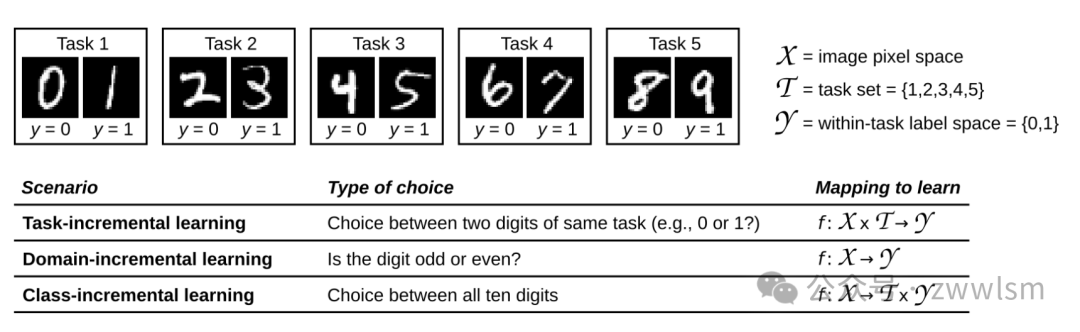

van de Ven和Tolias (2018) 區分了三種持續學習場景:任務增量學習 (Task-IL)、領域增量學習 (Domain-IL) 和類增量學習 (Class-IL)。這些場景的主要區別在于測試時是否提供任務身份以及是否必須推斷任務身份。

首先,讓我們解釋一下"任務身份"的概念:任務身份是指在持續學習過程中,明確指示當前數據屬于哪個特定任務或上下文的信息。例如,在一個圖像分類問題中,任務身份可能指示當前圖像是來自動物識別任務還是交通標志識別任務。

現在,讓我們看下這三種學習場景:

- 任務增量學習 (Task-IL):

在這種場景中,網絡被期望學習一系列不同的任務。

在訓練和測試時,任務身份都是已知的。

網絡可以使用任務特定的組件,如每個任務的專用輸出層。

主要挑戰:在不同任務之間共享和遷移知識,同時避免負遷移。

示例:學習動物分類(任務1)和建筑分類(任務2),網絡知道當前是哪個分類任務。

- 領域增量學習 (Domain-IL):

在這種場景中,問題的基本結構保持不變,但輸入分布或上下文發生變化。

在訓練和測試時,任務身份(或域身份)通常是未知的。

網絡需要適應不同的域,而不依賴于明確的域標識符。

主要挑戰:在不知道具體域的情況下,對不同域的數據進行泛化。

示例:在不同天氣條件下識別交通標志,網絡不知道當前是哪種天氣條件。

- 類增量學習 (Class-IL):

在這種場景中,網絡需要逐步學習識別越來越多的類別。

新類別在訓練過程中逐步引入,但在測試時需要區分所有已學習的類別。

任務身份在測試時是未知的,網絡需要在所有已學類別中進行選擇。

主要挑戰:在不忘記舊類別的同時學習新類別,并在所有類別之間進行有效區分。

示例:先學習識別貓和狗,然后學習識別鳥和魚,最后需要在這四種動物中進行分類。

這三種場景可以用以下表格進行比較:

特征 | 任務增量學習 (Task-IL) | 領域增量學習 (Domain-IL) | 類增量學習 (Class-IL) |

任務身份(訓練時) | 已知 | 未知 | 已知 |

任務身份(測試時) | 已知 | 未知 | 未知 |

主要挑戰 | 知識共享和遷移 | 跨域泛化 | 增量類別學習和區分 |

輸出空間 | 每個任務固定 | 跨任務固定 | 隨新類別增加 |

理解這些場景的區別對于設計和評估持續學習算法至關重要,因為每種場景都帶來了獨特的挑戰和約束。

2.5 評估

持續學習的評估通常涵蓋三個方面:性能、診斷分析和資源效率。以下是一個簡單的評估框架示例:

class ContinualLearningEvaluator:

def __init__(self):

self.performance_history = []

self.backward_transfer = []

self.forward_transfer = []

self.memory_usage = []

self.computation_time = []

def evaluate(self, model, task_id, X_test, y_test):

# 評估性能

performance = model.score(X_test, y_test)

self.performance_history.append((task_id, performance))

# 計算向后遷移

if task_id > 0:

prev_performance = self.performance_history[task_id-1][1]

self.backward_transfer.append(performance - prev_performance)

# 記錄資源使用

self.memory_usage.append(model.get_memory_usage())

self.computation_time.append(model.get_computation_time())

def report(self):

print(f"Average Performance: {np.mean([p for _, p in self.performance_history]):.2f}")

print(f"Average Backward Transfer: {np.mean(self.backward_transfer):.2f}")

print(f"Average Memory Usage: {np.mean(self.memory_usage):.2f} MB")

print(f"Total Computation Time: {sum(self.computation_time):.2f} s")三、持續學習方法

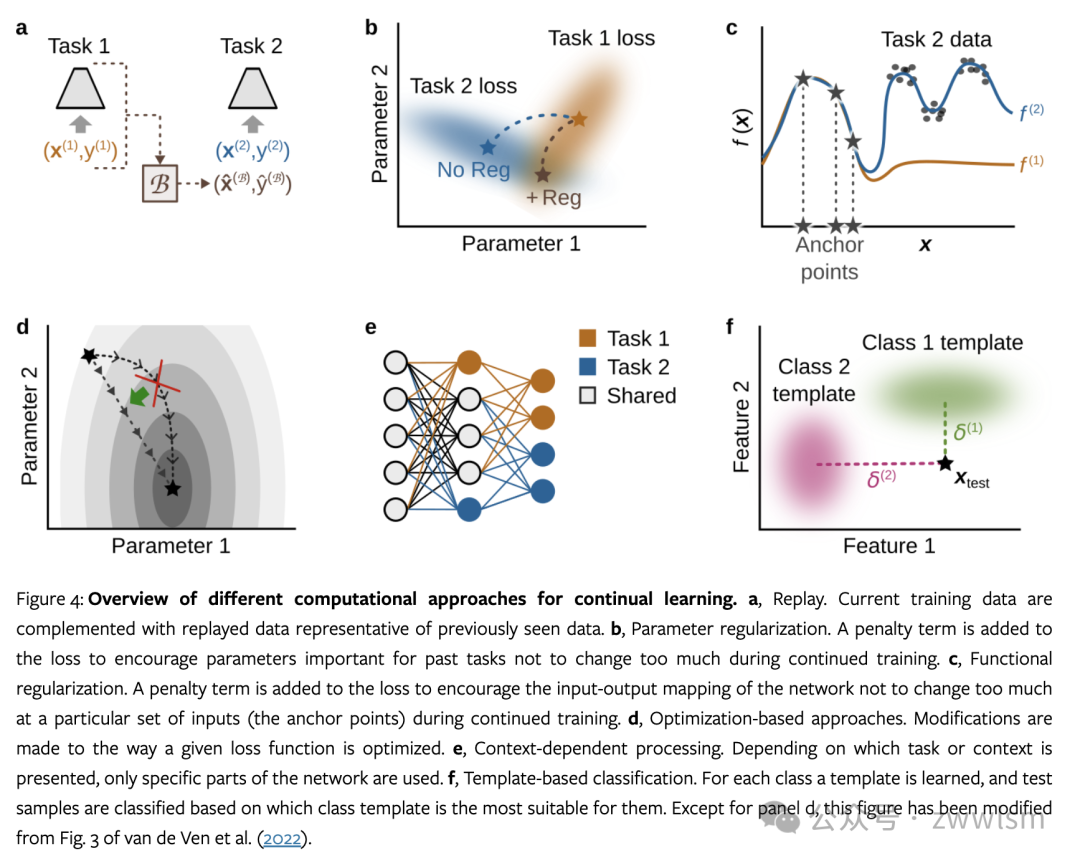

3.1 回放

回放是一種模仿人類記憶系統的方法,通過重復先前學習的信息來防止遺忘,通過補充當前任務的訓練數據與代表先前任務的數據來近似交錯學習。

詳細解釋:

- 工作原理:存儲部分舊數據或其表示,在學習新任務時同時訓練這些舊數據。

- 類型:

經驗回放:直接存儲和重放原始數據樣本。

生成回放:使用生成模型來創建和重放類似于舊數據的樣本。

- 優點:

直接對抗遺忘,保持對舊任務的良好性能。

實現簡單,效果通常很好。

- 缺點:

需要額外的存儲空間來保存舊數據或生成模型。

可能增加訓練時間和計算復雜度。

- 實現考慮:

選擇性存儲:設計策略來選擇最具代表性或最重要的樣本進行存儲。

平衡舊數據和新數據:在訓練中平衡回放數據和新數據的比例。

隱私問題:在某些應用中,存儲原始數據可能引發隱私問題。

以下是一個簡單的經驗回放實現:

class ExperienceReplay:

def __init__(self, buffer_size=1000):

self.buffer = []

self.buffer_size = buffer_size

def add_experience(self, experience):

if len(self.buffer) >= self.buffer_size:

self.buffer.pop(0)

self.buffer.append(experience)

def sample_batch(self, batch_size):

return random.sample(self.buffer, min(batch_size, len(self.buffer)))

# 使用示例

replay_buffer = ExperienceReplay()

for epoch in range(num_epochs):

for x, y in current_task_data:

# 訓練當前任務

model.train_step(x, y)

# 添加經驗到緩沖區

replay_buffer.add_experience((x, y))

# 回放舊經驗

if len(replay_buffer.buffer) > batch_size:

replay_batch = replay_buffer.sample_batch(batch_size)

for old_x, old_y in replay_batch:

model.train_step(old_x, old_y)3.2 參數正則化

參數正則化通過限制模型參數的變化來防止遺忘,通過阻止對重要參數的大幅度更改來實現的,特別是那些對先前任務重要的參數。

詳細解釋:

- 工作原理:在學習新任務時,對網絡參數施加約束,使其不會過度偏離對舊任務重要的值。

- 方法:

L2正則化:基于參數重要性的加權L2懲罰。

Fisher信息矩陣:使用Fisher信息來估計參數重要性。

- 優點:

不需要存儲原始數據,節省存儲空間。

可以與標準的神經網絡訓練方法無縫集成。

- 缺點:

可能限制模型學習新任務的能力。

難以準確估計參數重要性,特別是在復雜模型中。

實現考慮:

重要性估計:開發更精確的參數重要性估計方法。

自適應正則化:根據任務的相似性動態調整正則化強度。

稀疏性:探索如何利用參數正則化來促進模型的稀疏性。

以下是一個使用Fisher信息矩陣的參數正則化示例:

import torch

import torch.nn as nn

import torch.optim as optim

class EWC(nn.Module):

def __init__(self, model, lambda_reg=0.1):

super(EWC, self).__init__()

self.model = model

self.lambda_reg = lambda_reg

self.fisher = {}

self.old_params = {}

def estimate_fisher(self, data_loader, num_samples=1000):

self.model.eval()

for name, param in self.model.named_parameters():

self.fisher[name] = torch.zeros_like(param.data)

for i, (input, target) in enumerate(data_loader):

if i >= num_samples:

break

self.model.zero_grad()

output = self.model(input)

loss = F.cross_entropy(output, target)

loss.backward()

for name, param in self.model.named_parameters():

self.fisher[name] += param.grad.data ** 2 / num_samples

for name, param in self.model.named_parameters():

self.old_params[name] = param.data.clone()

def ewc_loss(self):

loss = 0

for name, param in self.model.named_parameters():

loss += (self.fisher[name] * (param - self.old_params[name]) ** 2).sum()

return self.lambda_reg * loss

# 使用示例

model = MyModel()

ewc = EWC(model)

# 估計Fisher信息

ewc.estimate_fisher(old_task_loader)

# 訓練新任務

optimizer = optim.SGD(model.parameters(), lr=0.01)

for epoch in range(num_epochs):

for x, y in new_task_data:

optimizer.zero_grad()

output = model(x)

loss = F.cross_entropy(output, y) + ewc.ewc_loss()

loss.backward()

optimizer.step()在這個示例中,EWC?類實現了Elastic Weight Consolidation (EWC) 算法,這是一種常用的參數正則化方法。estimate_fisher?方法估計參數的Fisher信息,而ewc_loss方法計算正則化損失。

3.3 功能正則化

功能正則化的目標是防止網絡的輸入-輸出映射在特定輸入(稱為"錨點")處發生大的變化,旨在保持網絡在特定輸入點的輸出一致性,而不是直接約束參數。

詳細解釋:

- 工作原理:在學習新任務時,保持網絡在選定錨點上的輸出與之前的輸出相似。

- 方法:

知識蒸餾:使用舊模型的輸出作為軟目標。

特征蒸餾:在中間層保持特征表示的一致性。

- 優點:

比參數正則化更靈活,因為它關注的是輸入-輸出映射而不是具體參數。

可以更好地捕捉任務之間的關系。

- 缺點:

選擇合適的錨點可能具有挑戰性。

計算開銷可能比參數正則化大。

- 實現考慮:

錨點選擇:開發自動選擇代表性錨點的方法。

多層正則化:在網絡的多個層次上應用功能正則化。

自適應溫度:在知識蒸餾中動態調整溫度參數。

以下是一個簡單的功能正則化實現:

import torch

import torch.nn as nn

import torch.nn.functional as F

class FunctionalRegularization(nn.Module):

def __init__(self, model, num_anchors=100, lambda_reg=0.1):

super(FunctionalRegularization, self).__init__()

self.model = model

self.num_anchors = num_anchors

self.lambda_reg = lambda_reg

self.anchors = None

self.old_outputs = None

def set_anchors(self, data_loader):

self.anchors = []

self.model.eval()

with torch.no_grad():

for inputs, _ in data_loader:

self.anchors.append(inputs[:self.num_anchors])

if len(self.anchors) * inputs.size(0) >= self.num_anchors:

break

self.anchors = torch.cat(self.anchors)[:self.num_anchors]

self.old_outputs = self.model(self.anchors)

def functional_reg_loss(self):

if self.anchors is None:

return 0

new_outputs = self.model(self.anchors)

return self.lambda_reg * F.mse_loss(new_outputs, self.old_outputs)

# 使用示例

model = MyModel()

func_reg = FunctionalRegularization(model)

# 設置錨點

func_reg.set_anchors(old_task_loader)

# 訓練新任務

optimizer = optim.Adam(model.parameters())

for epoch in range(num_epochs):

for x, y in new_task_data:

optimizer.zero_grad()

output = model(x)

loss = F.cross_entropy(output, y) + func_reg.functional_reg_loss()

loss.backward()

optimizer.step()在這個示例中,FunctionalRegularization?類實現了一個簡單的功能正則化方法。set_anchors?方法選擇錨點并記錄舊的輸出,而functional_reg_loss方法計算功能正則化損失。

3.4 基于優化的方法

基于優化的方法通過修改學習算法本身來實現持續學習,而不是直接修改損失函數。

詳細解釋:

- 工作原理:調整優化過程以更好地適應持續學習的場景。

- 方法:

梯度投影:將梯度投影到不會干擾舊任務性能的子空間。

自適應學習率:根據參數對舊任務的重要性調整學習率。

元學習:學習一個能夠快速適應新任務的優化算法。

- 優點:

可以更精細地控制學習過程。

不需要顯式存儲舊數據或大幅修改模型結構。

- 缺點:

可能增加計算復雜度。

有時難以與現有的深度學習框架集成。

- 實現考慮:

計算效率:設計計算高效的梯度投影或自適應學習率方法。

與其他方法的結合:探索如何將基于優化的方法與其他持續學習技術結合。

理論保證:研究這些方法的理論性質,如收斂性和泛化能力。

以下是一個使用自適應學習率的示例:

class AdaptiveLearningRateOptimizer:

def __init__(self, model, base_lr=0.01, importance_threshold=0.1):

self.model = model

self.base_lr = base_lr

self.importance_threshold = importance_threshold

self.parameter_importance = {}

def estimate_importance(self, data_loader):

self.model.eval()

for name, param in self.model.named_parameters():

self.parameter_importance[name] = torch.zeros_like(param.data)

for inputs, targets in data_loader:

self.model.zero_grad()

outputs = self.model(inputs)

loss = nn.functional.cross_entropy(outputs, targets)

loss.backward()

for name, param in self.model.named_parameters():

self.parameter_importance[name] += torch.abs(param.grad.data)

def get_adapted_lr(self, name, param):

importance = self.parameter_importance[name]

adapted_lr = torch.where(

importance > self.importance_threshold,

self.base_lr / importance,

torch.ones_like(importance) * self.base_lr

)

return adapted_lr

def step(self):

for name, param in self.model.named_parameters():

if param.grad is not None:

adapted_lr = self.get_adapted_lr(name, param)

param.data -= adapted_lr * param.grad.data

# 使用示例

model = MyModel()

optimizer = AdaptiveLearningRateOptimizer(model)

# 估計參數重要性

optimizer.estimate_importance(old_task_loader)

# 訓練新任務

for epoch in range(num_epochs):

for inputs, targets in new_task_loader:

model.zero_grad()

outputs = model(inputs)

loss = nn.functional.cross_entropy(outputs, targets)

loss.backward()

optimizer.step()這個示例實現了一個基于參數重要性的自適應學習率優化器。它首先估計每個參數的重要性,然后在訓練新任務時,根據參數的重要性調整學習率。

3.5 上下文相關處理

上下文相關處理通過為不同任務或上下文激活網絡的不同部分來減少干擾,思想是僅對特定任務或上下文使用網絡的某些部分,參考 MoE 網絡。

詳細解釋:

- 工作原理:根據當前任務或上下文動態調整網絡結構或激活模式。

- 方法:

多頭輸出:為每個任務使用專門的輸出層。

條件計算:使用門控機制選擇性激活網絡部分。

動態架構:根據需要增加新的網絡組件。

- 優點:

可以有效減少任務間的干擾。

允許模型根據需要增長,適應新任務。

- 缺點:

可能需要任務標識符,這在某些場景中不可用。

可能導致模型規模隨任務數量增長而顯著增加。

- 實現考慮:

任務識別:開發在沒有明確任務標識符的情況下識別當前任務的方法。

資源效率:設計能夠有效利用網絡容量的動態架構策略。

知識共享:在任務特定處理的同時促進跨任務知識共享。

以下是一個簡單的多頭輸出層實現:

import torch

import torch.nn as nn

class MultiHeadNetwork(nn.Module):

def __init__(self, input_size, hidden_size, num_tasks, task_output_sizes):

super(MultiHeadNetwork, self).__init__()

self.shared_layers = nn.Sequential(

nn.Linear(input_size, hidden_size),

nn.ReLU(),

nn.Linear(hidden_size, hidden_size),

nn.ReLU()

)

self.task_heads = nn.ModuleList([

nn.Linear(hidden_size, output_size) for output_size in task_output_sizes

])

def forward(self, x, task_id):

shared_output = self.shared_layers(x)

return self.task_heads[task_id](shared_output)

# 使用示例

input_size = 784 # 例如,對于MNIST數據集

hidden_size = 256

num_tasks = 5

task_output_sizes = [10, 10, 10, 10, 10] # 假設每個任務都是10類分類

model = MultiHeadNetwork(input_size, hidden_size, num_tasks, task_output_sizes)

# 訓練

optimizer = torch.optim.Adam(model.parameters())

for epoch in range(num_epochs):

for inputs, targets, task_id in mixed_task_loader:

optimizer.zero_grad()

outputs = model(inputs, task_id)

loss = nn.functional.cross_entropy(outputs, targets)

loss.backward()

optimizer.step()這個示例實現了一個具有多個輸出頭的網絡,每個任務使用一個專門的輸出頭。共享層處理所有任務的輸入,而特定于任務的頭部用于最終的分類。

3.6 基于模板的分類

基于模板的分類為每個類別學習一個原型或模板,并基于樣本與這些模板的相似度進行分類。

詳細解釋:

- 工作原理:學習每個類別的代表性模板,將新樣本分類到最相似的模板。

- 方法:

原型網絡:學習類別原型的嵌入表示。

基于距離的分類:使用樣本到原型的距離進行分類。

動態擴展:隨著新類別的引入添加新的模板。

- 優點:

適合處理類增量學習問題。

可以輕松添加新類別,而不需要重新訓練整個模型。

- 缺點:

可能難以捕捉復雜的類內變化。

在高維空間中,基于距離的方法可能遇到挑戰。

- 實現考慮:

模板更新:設計有效的策略來更新和維護類別模板。

度量學習:探索更好的相似度度量方法,以提高分類性能。

層次化模板:為處理大規模類別集開發層次化的模板結構。

以下是一個使用原型網絡的簡單實現:

import torch

import torch.nn as nn

import torch.nn.functional as F

class PrototypicalNetwork(nn.Module):

def __init__(self, input_size, embedding_size):

super(PrototypicalNetwork, self).__init__()

self.encoder = nn.Sequential(

nn.Linear(input_size, 256),

nn.ReLU(),

nn.Linear(256, embedding_size)

)

self.prototypes = nn.Parameter(torch.randn(100, embedding_size)) # 假設最多100個類

def forward(self, x):

embeddings = self.encoder(x)

distances = torch.cdist(embeddings, self.prototypes)

return -distances # 返回負距離作為相似度得分

def add_prototype(self, new_data):

with torch.no_grad():

new_embedding = self.encoder(new_data).mean(0)

self.prototypes = nn.Parameter(torch.cat([self.prototypes, new_embedding.unsqueeze(0)]))

# 使用示例

input_size = 784 # 例如,對于MNIST數據集

embedding_size = 64

model = PrototypicalNetwork(input_size, embedding_size)

# 訓練

optimizer = torch.optim.Adam(model.parameters())

for epoch in range(num_epochs):

for inputs, targets in train_loader:

optimizer.zero_grad()

similarities = model(inputs)

loss = F.cross_entropy(-similarities, targets)

loss.backward()

optimizer.step()

# 添加新類

for new_class_data, _ in new_class_loader:

model.add_prototype(new_class_data)這個示例實現了一個簡單的原型網絡。它學習將輸入嵌入到一個低維空間中,并為每個類維護一個原型。分類是通過計算嵌入與原型之間的距離來完成的。

4. 深度學習與認知科學中的持續學習

深度學習和認知科學在持續學習研究中有不同但相關的目標。深度學習旨在設計能夠持續學習的人工神經網絡,而認知科學關注理解大腦如何實現這種能力。

以下是一個表格,總結了兩個領域在持續學習研究中的一些關鍵差異和潛在的協同效應:

方面 | 深度學習 | 認知科學 | 潛在協同效應 |

研究目標 | 開發持續學習算法 | 理解大腦的持續學習機制 | 借鑒生物學啟發設計算法 |

方法論 | 計算模型和實驗 | 行為實驗和神經影像學 | 結合計算模型和生物學數據 |

遺忘研究 | 關注災難性遺忘 | 研究多種遺忘機制 | 設計更自然的遺忘機制 |

評估指標 | 任務性能和資源效率 | 認知功能和靈活性 | 開發更全面的評估框架 |

時間尺度 | 通常關注短期學習 | 研究終身學習過程 | 開發長期持續學習系統 |

5. 結論

持續學習是人工智能領域的一個重要挑戰,它不僅需要解決災難性遺忘問題,還需要開發能夠快速適應、利用任務相似性、與任務無關、容忍噪聲并高效使用資源的模型。

本章回顧了六種主要的持續學習計算方法:回放、參數正則化、功能正則化、基于優化的方法、上下文相關處理和基于模板的分類。每種方法都有其優缺點,實際應用中往往需要結合多種方法來獲得最佳效果。

未來的研究方向可能包括:

- 開發更有效的知識表示和存儲方法

- 設計能在不同抽象層次上進行遷移學習的架構

- 探索元學習在持續學習中的應用

- 結合神經科學和認知科學的見解,開發更接近人類學習方式的算法

補充資料:Fisher信息矩陣

Fisher信息矩陣是一個在統計學和機器學習中廣泛使用的概念,在持續學習中,特別是在參數正則化方法中,它扮演著重要角色。

Fisher信息矩陣的定義

在神經網絡的上下文中,Fisher信息矩陣 F 是一個平方矩陣,其大小等于模型參數的數量。對于參數 θ,Fisher矩陣定義為:

Fisher 信息矩陣的定義:

解釋:

- F 是 Fisher 信息矩陣

- θ 表示模型參數

- p(x|θ) 是給定模型參數 θ 時數據 x 的似然

- ?_θ 表示對參數 θ 的梯度

- E 表示對數據分布的期望

Fisher矩陣在持續學習中的應用

- 參數重要性估計:Fisher矩陣的對角元素可以被解釋為參數重要性的度量。較大的對角元素表示相應的參數對模型輸出有較大影響。

- 正則化:在諸如Elastic Weight Consolidation (EWC)等方法中,Fisher矩陣用于構建正則化項,以防止重要參數的大幅變化:

其中:

- L(θ) 是總的損失函數

- L_B(θ) 是新任務 B 的損失

- λ 是正則化強度

- F_i 是 Fisher 矩陣的第 i 個對角元素

- θ_i 是當前參數

- θ_{A,i} 是完成任務 A 后的參數

- 優化:Fisher矩陣提供了參數空間的局部幾何信息,可以用來指導優化過程,使其在不大幅改變重要參數的情況下學習新任務。

Fisher矩陣的計算

在實踐中,精確計算Fisher矩陣通常是不可行的,特別是對于大型神經網絡。因此,通常使用近似方法:

- 對角近似:只計算Fisher矩陣的對角元素,大大減少了計算和存儲成本。

- 經驗Fisher:使用有限的數據樣本來估計Fisher矩陣,而不是對整個數據分布求期望。

在實踐中,通常使用經驗 Fisher 矩陣的對角近似:

$ F_ii} ≈ \frac{1}{N} \sum_{n=1}^N (\frac{\partial \log p(x_nθ){\partial θ_i})^2 $

解釋:

- F_{i} 是 Fisher 矩陣的第 i 個對角元素

- N 是樣本數量

- x_n 是第 n 個數據樣本

- θ_i 是第 i 個模型參數

- Kronecker因子分解:將Fisher矩陣分解為Kronecker積的形式,在保留更多結構信息的同時降低計算復雜度。

示例代碼

以下是一個使用PyTorch計算Fisher信息矩陣對角近似的簡單示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

def compute_fisher_diag(model, data_loader, num_samples=1000):

fisher = {}

for name, param in model.named_parameters():

fisher[name] = torch.zeros_like(param.data)

model.eval()

for i, (input, target) in enumerate(data_loader):

if i >= num_samples:

break

model.zero_grad()

output = model(input)

loss = F.nll_loss(F.log_softmax(output, dim=1), target)

loss.backward()

for name, param in model.named_parameters():

fisher[name] += param.grad.data ** 2 / num_samples

return fisher

# 使用示例

model = YourNeuralNetwork()

fisher_diag = compute_fisher_diag(model, train_loader)

# 在EWC中使用Fisher信息

for name, param in model.named_parameters():

ewc_loss += 0.5 * fisher_diag[name] * (param - old_params[name]).pow(2).sum()Fisher矩陣的優缺點

優點:

- 提供了參數重要性的理論基礎。

- 不需要存儲原始數據,保護隱私。

- 可以與標準的深度學習優化技術結合。

缺點:

- 精確計算在大型模型中計算成本高。

- 對角近似可能丟失重要的參數間相關性信息。

- 在非凸優化問題中,局部幾何信息可能不足以捕捉全局結構。

Fisher信息矩陣是持續學習中參數正則化方法的核心工具之一,它提供了一種理論上合理的方式來估計參數重要性并指導模型在學習新任務時如何保護舊知識。然而,其實際應用還面臨著計算效率和準確性的挑戰,這也是當前研究的重點之一。

本文轉載自??芝士AI吃魚??,作者:芝士AI吃魚