如何解決模型的災難性遺忘問題?清華大學提出新方法! 精華

探索連續學習中的新方法

在人工智能領域,尤其是在語言模型(LM)的發展過程中,連續學習(CL)始終是一個挑戰。傳統的學習方法往往面臨著災難性遺忘的問題,即新知識的學習可能會導致舊知識的丟失。這一問題不僅影響模型的長期穩定性,還可能限制其在實際應用中的效能。

為了解決這一問題,研究者們提出了多種策略,如重復學習、架構調整和參數調整等方法。然而,這些方法往往依賴于舊任務數據或任務標簽,而這在實際應用中可能難以獲得。因此,探索不依賴外部標簽和數據的連續學習新方法顯得尤為重要。

最近,一種名為“MIGU”(基于幅度的梯度更新)的新方法應運而生,它通過利用語言模型線性層輸出的L1標準化幅度分布的內在差異,實現了無需任務標簽和重復數據的連續學習。這一方法的核心在于,在模型的前向傳播階段捕獲并標準化線性層的輸出,然后在反向傳播階段,只更新那些具有最大L1標準化幅度的參數。這種策略不僅簡化了學習過程,還有效地利用了模型固有的行為特征,從而解鎖了其連續學習的潛能。

通過在不同的語言模型架構和連續學習基準上的實驗驗證,MIGU方法在不同的連續微調和連續預訓練設置中均展示了出色的性能,甚至在某些情況下超越了現有的最先進方法。例如,在一個包含15個任務的連續學習基準測試中,MIGU方法使得模型的平均準確率比傳統的參數高效微調基線提高了15.2%。

此外,MIGU方法的靈活性也體現在其能夠與現有的連續學習方法(如重復學習、架構基方法和參數基方法)無縫集成,進一步提升了模型的連續學習能力。這一創新的探索不僅為連續學習領域提供了新的視角,也為實際應用中的語言模型持續優化和更新開辟了新的可能性。

1. 論文標題:Unlocking Continual Learning Abilities in Language Models

2. 機構:

- Wenyu Du, Ka Chun Cheung, Reynold Cheng: The University of Hong Kong

- Shuang Cheng: ICT, Chinese Academy of Sciences

- Tongxu Luo: CUHK-SZ

- Zihan Qiu, Zeyu Huang: Tsinghua University

- Ka Chun Cheung: NVIDIA

- Jie Fu: HKUST

3. 論文鏈接:??https://arxiv.org/pdf/2406.17245.pdf??

4. 項目地址:??https://github.com/wenyudu/MIGU??

MIGU方法介紹

在持續學習(CL)的領域中,語言模型(LM)面臨著災難性遺忘的挑戰,這限制了它們在持續學習任務中的長期可持續性。為了解決這一問題,研究人員提出了多種方法,包括基于復習的方法、基于架構的方法和基于參數的方法。然而,這些方法往往依賴于舊任務數據或任務標簽,這在實際應用中可能難以獲取或成本較高。

針對這一挑戰,本文介紹了一種名為“MIGU”(基于幅度的梯度更新)的新方法。MIGU方法不需要復習舊任務數據,也不需要任務標簽,它通過只更新輸出幅度較大的模型參數來實現持續學習。這種方法利用了語言模型線性層輸出的L1標準化幅度分布的固有差異,這些差異在處理不同任務數據時表現不同。

1. MIGU的工作原理

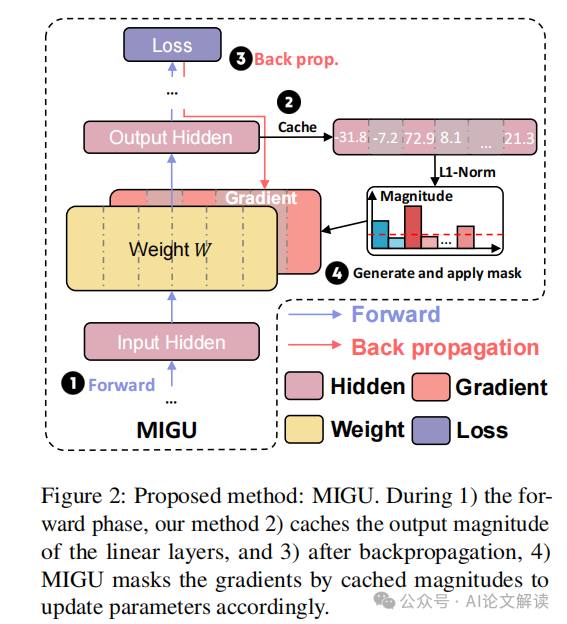

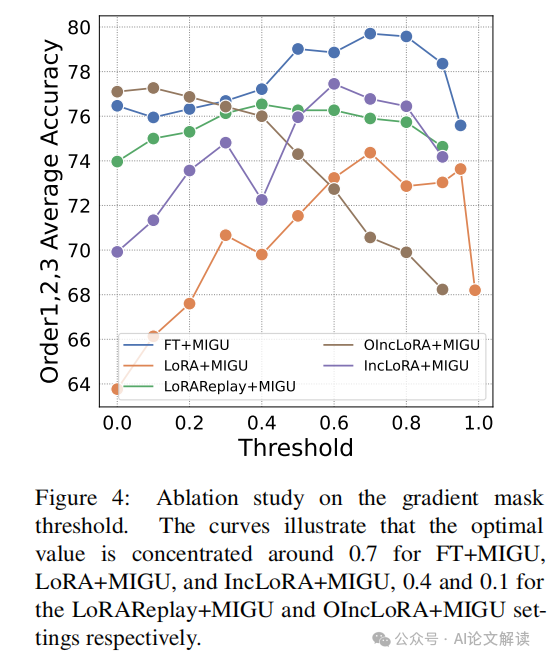

MIGU方法包括兩個主要步驟:在前向傳播階段,緩存并標準化線性層的輸出幅度;在后向傳播階段,只更新那些L1標準化幅度最大的參數。具體來說,MIGU在模型的前向傳播階段計算每個線性層的輸出,然后使用L1范數對這些輸出進行標準化,得到一個幅度分布向量。在后向傳播階段,MIGU根據預定義的閾值比例T,只更新幅度最大的參數,從而有效地利用語言模型處理不同任務時輸出幅度的固有差異,減少不同任務間的梯度沖突,解鎖模型的持續學習能力。

2. MIGU的實驗驗證

MIGU方法已在三種主要的語言模型架構(T5、RoBERTa和Llama2)上進行了測試,并在持續微調和持續預訓練的設置中,針對四個持續學習基準進行了評估。實驗結果顯示,MIGU在所有測試中均達到了最先進或相當的性能。例如,在一個包含15個任務的持續學習基準測試中,MIGU使平均準確率比傳統的參數高效微調基線提高了15.2%。

實驗設計與數據集

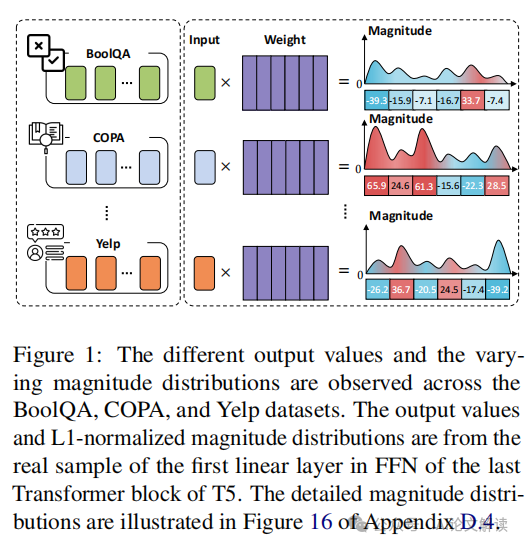

在探索語言模型(LMs)的持續學習(CL)能力的研究中,我們提出了一種名為“MIGU”(基于幅度的梯度更新)的新方法。這種方法利用了語言模型線性層輸出的L1標準化幅度分布的固有差異,實現了無需任務標簽的持續學習。這一發現基于對不同任務數據處理時線性層輸出幅度分布的觀察。例如,在T5模型的最后一個Transformer塊的前饋網絡(FFN)的第一線性層中,對于BoolQA、COPA和Yelp三個任務,幅度分布有顯著不同。

實驗設計

在實驗中,我們首先在前向傳播階段緩存并標準化線性層的輸出幅度,然后在反向傳播階段,只更新L1標準化幅度最大的T個參數,其中T是預定義的閾值比率。這種設計使得模型能夠針對不同任務有效地利用其固有特征來更新參數,從而緩解任務間的梯度沖突,釋放其持續學習的潛力。

數據集

我們在三種主要的語言模型架構上評估了MIGU方法:僅編碼器的RoBERTa、編碼器-解碼器的T5模型和僅解碼器的Llama2。實驗涉及兩種持續預訓練設置:持續預訓練和持續微調,使用四個CL基準數據集。這些數據集包括標準CL基準和長序列CL基準,涵蓋了多種文本分類任務和問答任務。例如,在一個包含15個任務的長序列CL數據集中,MIGU方法使平均準確率相比傳統的參數高效微調基線提高了15.2%。

通過這些設計和數據集的使用,我們的實驗不僅驗證了MIGU方法在不同語言模型架構和持續學習場景下的有效性,還展示了它如何與現有的三種主流CL方法(基于復習的方法、基于架構的方法和基于參數的方法)無縫集成,進一步增強了語言模型的CL能力。

實驗結果與分析

在探索語言模型(LMs)的持續學習(CL)能力的過程中,我們引入了一種名為“MIGU”的新方法(基于幅度的梯度更新),這種方法利用LMs線性層中L1標準化輸出的幅度分布的固有差異,實現了無需任務標簽的持續學習。通過實驗,我們在三種主要的LM架構(T5, RoBERTa和Llama2)上驗證了MIGU的效果,并在四個CL基準測試中進行了持續的微調和持續的預訓練設置測試。

1. 實驗設置與基準測試

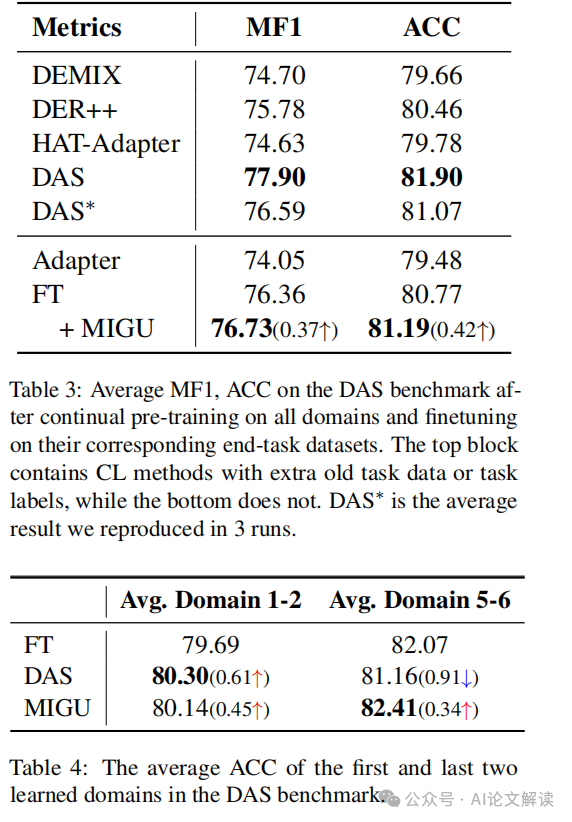

我們在不同的持續學習設置中評估了MIGU,包括持續微調和持續預訓練。使用的基準數據集包括標準CL基準和長序列CL基準,以及用于持續預訓練的DAS基準。這些基準覆蓋了從文本分類到領域適應的多種任務。

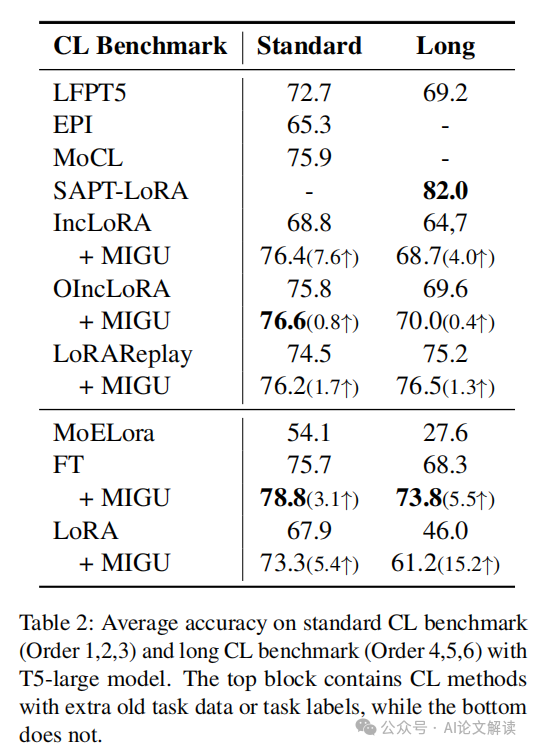

2. 實驗結果

在T5-large模型上的持續微調實驗中,MIGU在沒有舊任務數據或任務信息的情況下,與傳統的參數高效微調基線相比,平均準確率提高了15.2%。此外,MIGU與現有的三種CL方法(基于重演的、基于架構的和基于參數的方法)無縫集成,進一步增強了LMs的CL能力。

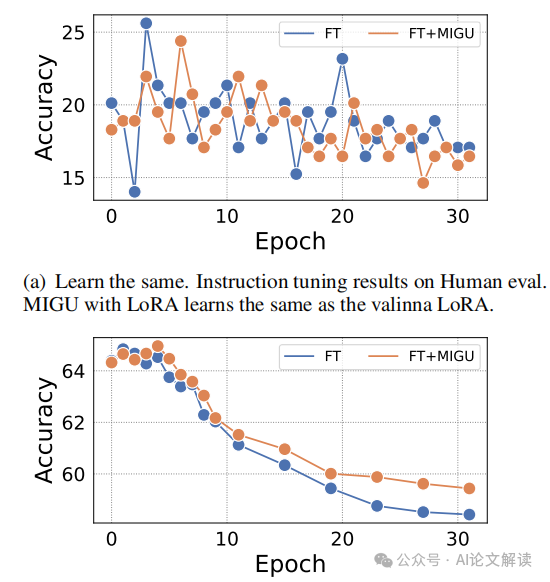

在RoBERTa模型的持續預訓練實驗中,MIGU也顯示出與或優于其他先進CL方法的性能。例如,在DAS基準測試中,FT+MIGU在MF1和ACC指標上均實現了改進。

3. 分析與討論

MIGU通過在后向傳播階段僅更新具有最大L1標準化幅度的參數,有效地利用了任務間的幅度分布差異,減少了不同任務間的梯度沖突。這種方法不僅減少了對舊任務數據的依賴,而且也避免了在LMs場景中獲取精確任務標簽的困難。

我們的實驗結果表明,MIGU能夠顯著提高在多任務學習環境中的模型性能,特別是在處理長序列任務和需要高度領域適應性的場景中。此外,MIGU的實現簡單,計算效率高,易于與現有的CL策略集成,為未來的研究和應用提供了新的可能性。

通過這些實驗,我們證明了MIGU方法在解鎖LMs的持續學習潛力方面的有效性和通用性,為持續學習的未來研究提供了新的視角和工具。

MIGU的優勢與挑戰

MIGU(基于幅度的梯度更新)是一種針對語言模型(LM)持續學習的新方法,它通過利用LM線性層輸出的L1標準化幅度分布的固有差異,實現了無需任務標簽和重復訓練數據的模型參數更新。這種方法在多個持續學習(CL)基準測試中展示了其有效性,能夠顯著提高模型在多任務學習環境中的表現,并且與現有的CL方法(如重復訓練、架構調整和參數調整方法)無縫集成,進一步增強了模型的CL能力。

1. MIGU的優勢

MIGU的主要優勢在于其獨特的更新機制,該機制只更新那些具有較大L1標準化幅度的參數,從而有效減少了不同任務間的梯度沖突,解決了傳統CL方法中常見的災難性遺忘問題。例如,在一個包含15個任務的CL基準測試中,MIGU比傳統的參數高效微調基線提高了15.2%的平均準確率。此外,MIGU不依賴于舊任務數據或精確的任務標簽,使其在數據獲取成本高或數據不可用的情況下尤為有用。

2. MIGU的挑戰

盡管MIGU在多個方面表現出色,但它也面臨一些挑戰。首先,MIGU依賴于模型線性層輸出的幅度分布差異,這需要模型能夠在不同任務之間展示出足夠的幅度變化,這在某些情況下可能不容易實現。其次,盡管MIGU減少了對舊任務數據的依賴,但在沒有任何任務標簽的情況下,如何有效地區分和處理不同任務的學習過程仍然是一個開放的問題。此外,MIGU的效果可能受到模型架構和任務性質的限制,其在不同類型的語言模型和任務上的普適性和效率仍需進一步驗證。

總體而言,MIGU提供了一種創新的解決方案來增強語言模型的持續學習能力,通過簡單的幅度基準更新機制解鎖了模型的潛在CL能力,盡管存在挑戰,但其在實際應用中的潛力值得進一步探索和優化。

結論與未來展望

在本研究中,我們提出了一種名為MIGU(基于幅度的梯度更新)的新方法,用于解決語言模型(LMs)在持續學習(CL)中的災難性遺忘問題。MIGU方法通過利用LMs線性層輸出的L1標準化幅度分布的固有差異,實現了無需任務標簽和重復樣本的持續學習。我們的實驗結果表明,MIGU在多種LM架構和持續學習場景中均表現出色,能夠與現有的CL方法無縫集成,進一步提升性能。

1. 性能提升

MIGU在多個持續學習基準測試中取得了顯著的性能提升。例如,在一個包含15個任務的長序列CL基準測試中,MIGU使得模型的平均準確率比傳統的參數高效微調基線提高了15.2%。這一結果證明了MIGU在處理多任務學習和避免任務間梯度沖突方面的有效性。

2. 與現有CL方法的集成

MIGU能夠與重復基、架構基和參數基的CL方法無縫集成,進一步增強了LMs的持續學習能力。通過與這些方法的結合,MIGU不僅提高了模型在新任務上的學習能力,還有效減少了對舊任務知識的遺忘。

3. 未來研究方向

盡管MIGU已經取得了一定的成功,但我們認為還有幾個方向值得進一步探索:

- 擴展到更大規模的模型和任務:未來可以考慮將MIGU應用于更大規模的LMs和更復雜的任務序列,以測試其在更廣泛應用中的效果。

- 探索其他內在特征:除了輸出幅度分布,LMs可能還有其他未被充分利用的內在特征。未來的研究可以探索這些特征在CL中的潛在用途。

- 優化計算效率:雖然MIGU已經相對高效,但在處理大規模數據和模型時,進一步優化其計算效率仍然很有必要。

本文轉載自?? AI論文解讀??,作者:柏企科技圈