騰訊Hunyuan超越Llama 3,成為NLP領域新霸主 原創

騰訊最近發布了一款名為Hunyuan的先進Moe(Mixture of Experts)模型,該模型在多個基準測試中表現出色,超越了Llama 3,成為自然語言處理(NLP)領域的新領導者。地址如下:

- github: https://github.com/Tencent/Tencent-Hunyuan-Large/blob/main/README_CN.md

- hf: https://huggingface.co/tencent/Tencent-Hunyuan-Large

以下是Hunyuan模型的一些關鍵優勢:

- 合成數據增強:Hunyuan-Large通過合成數據增強訓練,能夠學習到更豐富的表示,處理長上下文輸入,并更好地泛化到未見數據。

- KV緩存壓縮:采用分組查詢注意力(GQA)和跨層注意力(CLA)策略,顯著減少了KV緩存的內存占用和計算開銷,提高了推理吞吐。

- 專家特定學習率縮放:為不同專家設置不同的學習率,確保每個子模型都能有效地從數據中學習,并為整體性能做出貢獻。

- 長上下文處理能力:預訓練模型支持高達256K的文本序列,Instruct模型支持128K的文本序列,顯著提升了長上下文任務的處理能力。

- 廣泛的基準測試:在多種語言和任務上進行廣泛實驗,驗證了Hunyuan-Large的實際應用效果和安全性。

推理框架:

騰訊為Hunyuan-Large模型提供了vLLM-backend推理框架。該框架在vLLM開源框架的基礎上進行了適配,新增的CLA結構可以節省顯存,保障超長文本場景。通過FP8量化優化,相比FP16/BF16常規量化,在最大限度保障精度的條件下,節省50%顯存,吞吐提升70%。

訓練框架:

Hunyuan-Large模型已經支持huggingface格式,用戶可以采用hf-deepspeed框架進行模型精調。同時,騰訊也支持利用flash-attn進行訓練加速,并開放了相關的訓練腳本和模型實現,方便研發者進行后續的模型訓練和精調。

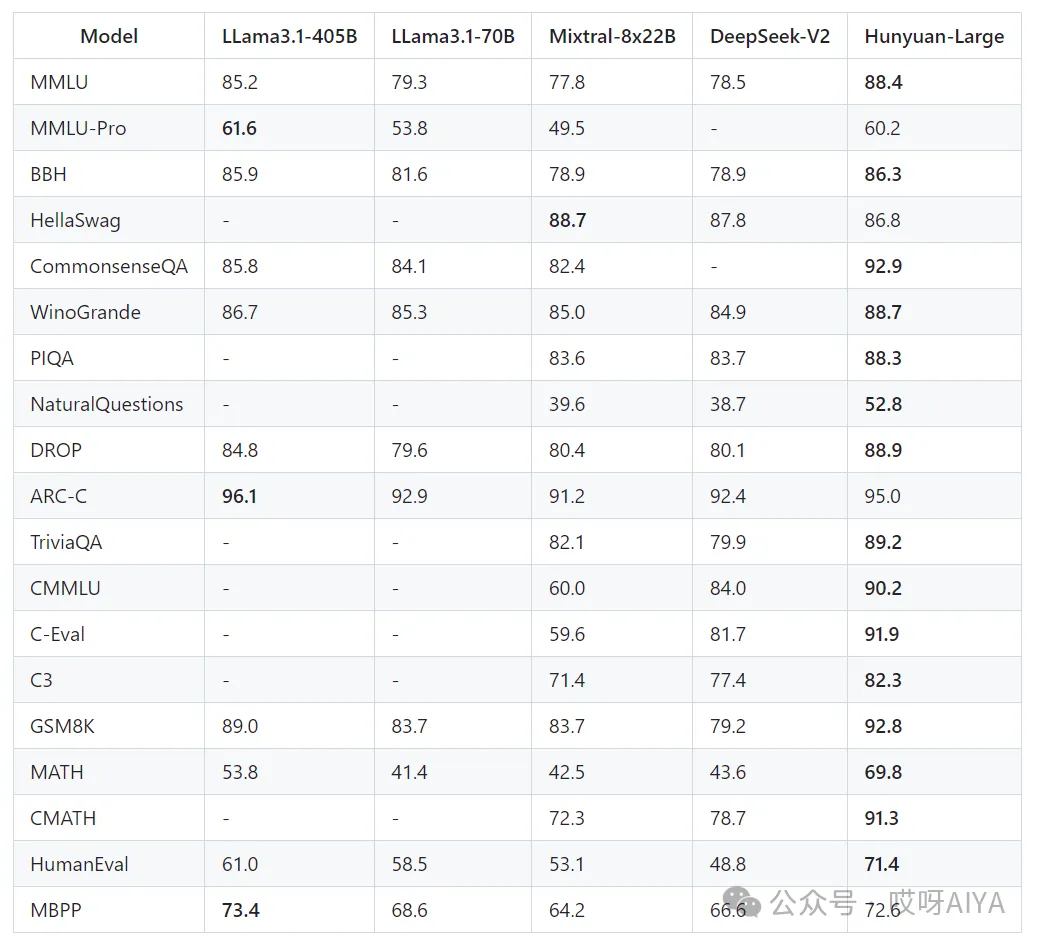

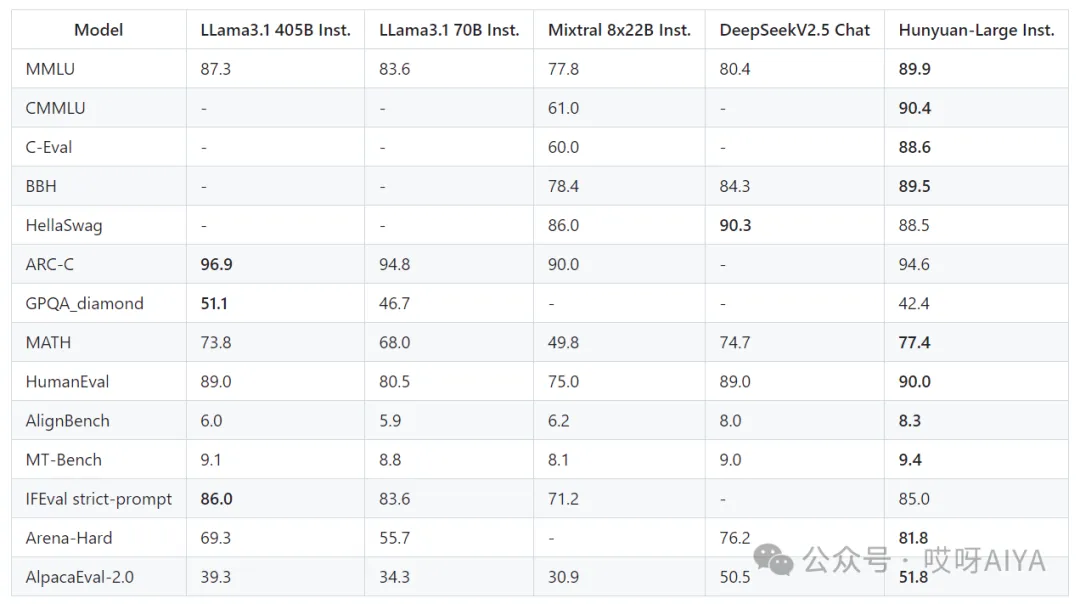

Benchmark評估榜單:

在多個基準測試中,Hunyuan-Large預訓練模型與具有相似激活參數大小的Dense和MoE競爭對手相比,實現了最佳的整體性能。在常識理解和推理以及經典的NLP任務,如QA和閱讀理解任務方面表現出色。在數學能力方面,Hunyuan-Large在GSM8K和Math數學數據集上優于所有基線,在CMATH中文數據集上也取得了最好的成績。同時,Hunyuan-Large在所有中文任務中實現了整體最佳的性能。

Hunyuan-Large-Instruct與具有相似激活參數的llm相比在大多數的任務上實現了一致的性能提升。在不同類別的基準測試中,Instruct模型在MMLU和MATH數據集上取得了最好的性能。值得注意的是,在MMLU數據集上,表現出了顯著的提升, 相比與LLama3.1-405B模型高出2.6%。這種增強表明Hunyuan-Large-Instruct在廣泛的語言理解任務中具有優越的理解和推理能力。該模型在MATH數據集上的表現進一步強調了它的實力,相比于LLama3.1-405B高出了3.6%的指標。值得注意的是,僅用520億個激活參數就實現了精度的飛躍,證明了Hunyuan-Large-Instruct的卓越能力。

騰訊Hunyuan模型的開源,不僅展示了其在NLP領域的技術實力,也為全球的AI研究者和開發者提供了一個強大的工具,以推動NLP技術的發展。

本文轉載自公眾號哎呀AIYA