騰訊發(fā)布全新混元大模型Hunyuan-Large:全球最大開源Transformer模型,助力AI發(fā)展新高度 原創(chuàng)

01、概述

近年來,大型語言模型(LLM)已成為許多人工智能系統(tǒng)的核心支撐,從自然語言處理(NLP)到計算機視覺,再到科學研究領域,LLM的應用無處不在。然而,伴隨著AI需求的激增,LLM的規(guī)模和計算需求也迅速增加。這些龐大的模型在訓練和推理時資源消耗極大,推動研究者們不斷探索更高效的模型架構。在此背景下,**專家混合模型(Mixture of Experts, MoE)**成為了備受關注的解決方案,它通過選擇性地激活不同的模型部分以提升性能。盡管MoE模型前景廣闊,但真正大規(guī)模開源的MoE模型卻寥寥無幾,這在一定程度上限制了AI領域的創(chuàng)新和實際應用。

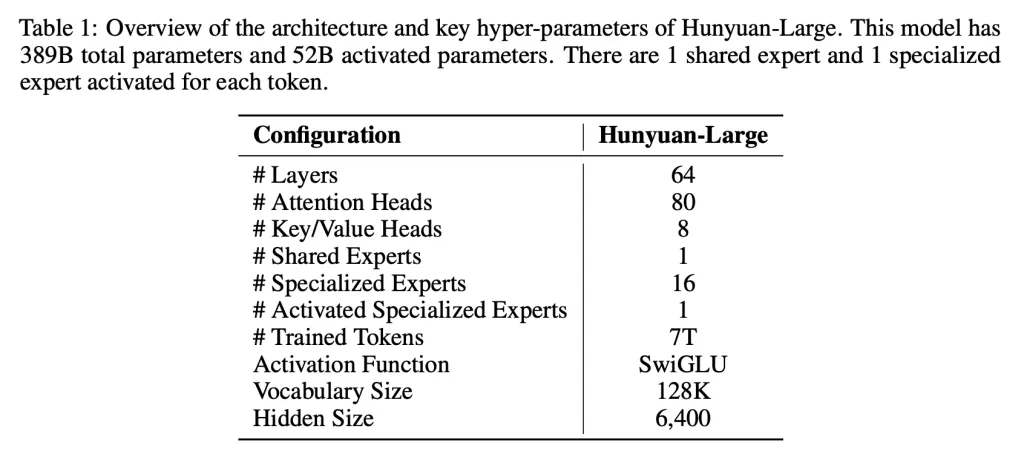

騰訊此次發(fā)布的Hunyuan-Large,是目前業(yè)界最大的開源Transformer架構MoE模型。其總參數(shù)量高達3890億,其中活躍參數(shù)量為520億。這款模型不僅支持長達256K個token的超大上下文處理,還在技術層面上實現(xiàn)了眾多創(chuàng)新,能夠在自然語言處理及通用AI任務上取得優(yōu)異的表現(xiàn),甚至在某些方面超越了業(yè)界領先的模型,如LLama3.1-70B和LLama3.1-405B。Hunyuan-Large的發(fā)布對于AI研究和應用領域而言意義重大,它不僅為開發(fā)者和研究者提供了強大的資源,還在AI性能與規(guī)模性之間取得了良好的平衡,為行業(yè)創(chuàng)新提供了新的可能。

02、技術突破:混元大模型的核心亮點

1. 海量數(shù)據預訓練,適應多領域需求

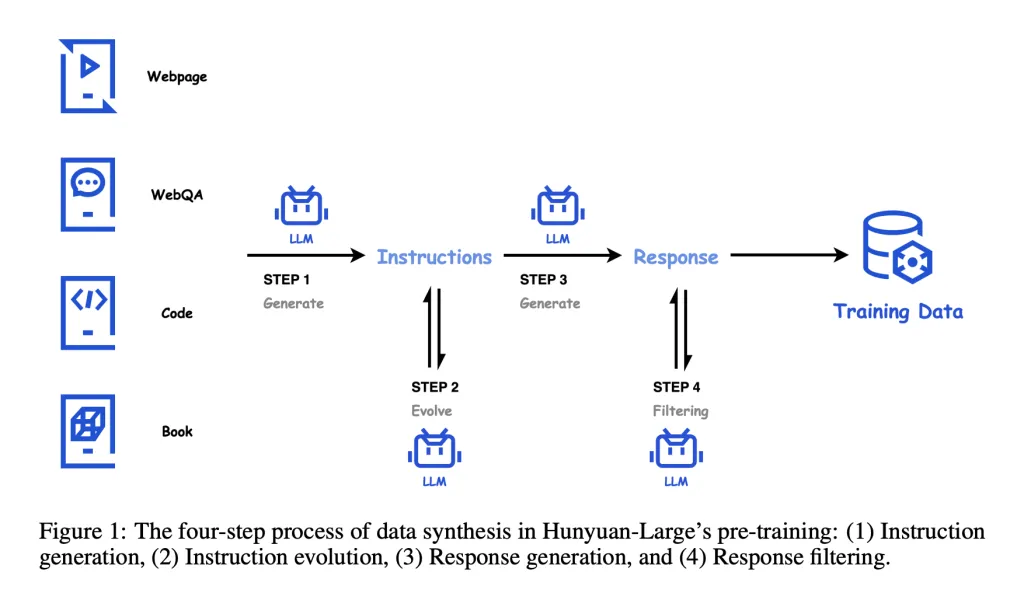

為了賦予模型廣泛的通用性,Hunyuan-Large在預訓練階段采用了七萬億個token的數(shù)據,其中包含1.5萬億條合成數(shù)據,涵蓋數(shù)學、編程、多語言等領域。這種多樣化的數(shù)據大幅提升了模型的泛化能力,使其在不同領域的表現(xiàn)更加出色,尤其在與其他同規(guī)模模型的對比中展現(xiàn)了明顯優(yōu)勢。

2. 專家路由策略優(yōu)化:提升性能與效率

混元大模型在架構設計上引入了混合專家路由策略。這種方法根據任務需求智能選擇激活的模型組件,避免不必要的資源消耗,從而提升計算效率。每個“專家”模塊能夠根據任務需求獨立訓練和優(yōu)化,這種分布式學習策略顯著增強了模型在處理不同任務時的精度和速度。

3. KV緩存壓縮:降低內存負擔

在模型推理過程中,內存開銷常常是一個瓶頸。騰訊在Hunyuan-Large中創(chuàng)新性地采用了KV緩存壓縮技術,有效降低了推理階段的內存占用。這一技術使得模型能夠在不犧牲響應質量的前提下顯著提升擴展性,為超大規(guī)模LLM的高效部署奠定了基礎。

4. 專家特定學習率:精細化的訓練機制

Hunyuan-Large的另一個亮點在于引入了專家特定學習率的機制。此設計允許模型中的不同組件根據其任務難度和復雜度調整學習速率,使得共享組件與專家模塊之間的負載分配更加均衡。這種精細化的訓練策略不僅提高了模型的收斂效率,也進一步提升了Hunyuan-Large在處理復雜任務時的表現(xiàn)。

03、性能測試:領先的NLP任務表現(xiàn)

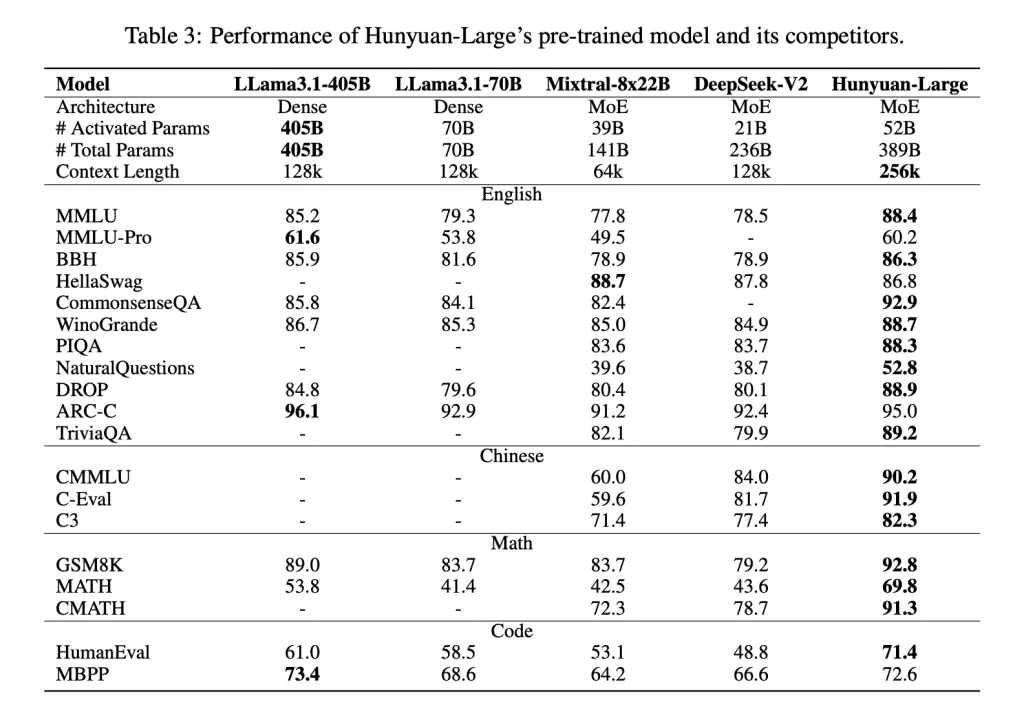

Hunyuan-Large的技術優(yōu)勢在多項NLP任務測試中得到了驗證。根據多個基準測試結果,該模型在問答、邏輯推理、編程、閱讀理解等任務上都表現(xiàn)優(yōu)異。例如,在被廣泛認可的MMLU(多任務語言理解)測試中,Hunyuan-Large取得了88.4分,明顯超越了LLama3.1-405B的85.2分。這一結果顯示了Hunyuan-Large不僅在活躍參數(shù)較少的情況下實現(xiàn)了高效訓練,還在長文本處理能力上填補了現(xiàn)有LLM的不足。

Hunyuan-Large的優(yōu)勢尤為適合需要長上下文理解的應用場景,例如文檔分析、法律文本理解、科學研究等領域。這些任務通常涉及大量信息的匯總和精確分析,混元大模型的長上下文處理能力為這些高需求應用提供了強大的技術支撐。

04、開放的研發(fā)平臺:為AI社區(qū)注入新活力

與眾多封閉的大模型不同,Hunyuan-Large的開源特性使其成為業(yè)界關注的焦點。騰訊提供了完整的開源代碼庫和預訓練檢查點,為開發(fā)者、研究者提供了靈活的研發(fā)資源,便于進一步探索和定制化應用。開源不僅是技術共享的表現(xiàn),更是促進AI社區(qū)協(xié)同發(fā)展的重要一步。

通過開放的研發(fā)平臺,Hunyuan-Large為AI從業(yè)者和科研人員提供了更多實驗的可能性,尤其是在資源有限的小團隊中,這一模型的高效架構和開源特性極具價值。研究人員可以在此基礎上進一步優(yōu)化或結合特定應用場景,開發(fā)出符合自身需求的AI工具,推動技術的多樣化應用。

05、對AI未來發(fā)展的意義:Hunyuan-Large的創(chuàng)新價值

Hunyuan-Large的發(fā)布不僅展示了騰訊在AI技術領域的領先優(yōu)勢,也為全球AI創(chuàng)新樹立了新的標桿。3890億參數(shù)的規(guī)模和KV緩存壓縮、專家特定學習率等技術創(chuàng)新,為解決大型模型計算資源需求過高的問題提供了切實可行的方案。這款模型的開源不僅是騰訊推動AI開放生態(tài)的重要一步,更是推動全球AI技術應用的重大貢獻。

未來,隨著Hunyuan-Large在各領域的實際應用,預計會涌現(xiàn)出更多基于該模型的創(chuàng)新應用,如智能客服、精準推薦、內容生成等。這些應用不僅能提升用戶體驗,也將進一步驗證混元大模型的技術優(yōu)勢。作為新一代開源大型語言模型的代表,Hunyuan-Large無疑會引領AI技術進入更廣泛、更高效的發(fā)展軌道。

06、結語

騰訊此次發(fā)布的Hunyuan-Large混元大模型,憑借其3890億的龐大參數(shù)、精細的專家路由策略和KV緩存壓縮等技術亮點,展現(xiàn)了頂尖的AI性能和擴展性。這款開源模型不僅為技術開發(fā)者和研究者提供了強大的工具,也為AI領域的創(chuàng)新發(fā)展注入了新的活力。在未來的AI生態(tài)系統(tǒng)中,Hunyuan-Large將成為推動技術進步的關鍵力量。

參考:

- ??https://github.com/Tencent/Tencent-Hunyuan-Large??

- ??https://huggingface.co/tencent/Tencent-Hunyuan-Large??

- ??https://arxiv.org/pdf/2411.02265??

本文轉載自公眾號Halo咯咯 作者:基咯咯