什么是多模態AI 如何融合和對齊? 原創

近年來,大型語言模型Large Language Models(LLM)的研究取得了顯著的進展(例如GPT-3,LLaMa,ChatGPT,GPT-4),這些模型在各項自然語言處理(NLP)任務上展現了出色的性能。

通過在海量數據上預訓練,LLM獲得了豐富的知識以及強大的推理能力。只需要輸入一些用戶指令,這些模型就可以解析指令、進行推理并給出符合用戶預期的回答。這些能力背后蘊含著眾多關鍵思想和技術,包括指令微調(Instruction Tuning),上下文學習(In-Context Learning)和思維鏈(Chain of Thought)等,以及多模態。

什么是多模態

多模態人工智能利用來自多個不同模態(如文本、圖像、聲音、視頻等)的數據進行學習和推理。多模態人工智能強調不同模態數據之間的互補性和融合性,通過整合多種模態的數據,利用表征學習、模態融合與對齊等技術,實現跨模態的感知、理解和生成,推動智能應用的全面發展。

接下來分三部分:_數據采集與表示、數據處理與融合、學習與推理,一起來科普下多模型的基本術語。

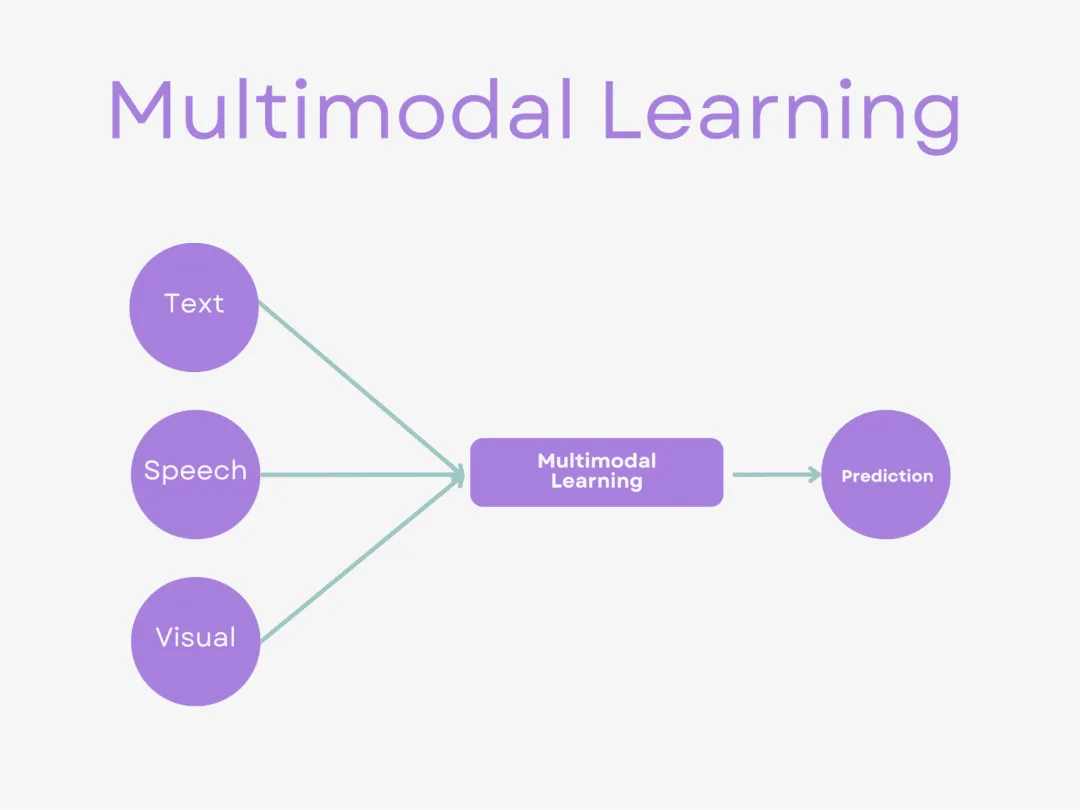

多模態學習(Multimodal Learning)是一種利用來自不同感官或交互方式的數據進行學習的方法,這些數據模態可能包括文本、圖像、音頻、視頻等。多模態學習通過融合多種數據模態來訓練模型,從而提高模型的感知與理解能力,實現跨模態的信息交互與融合。接下來分三部分:模態表示、多模態融合、跨模態對齊,一起來總結下多模型的核心。

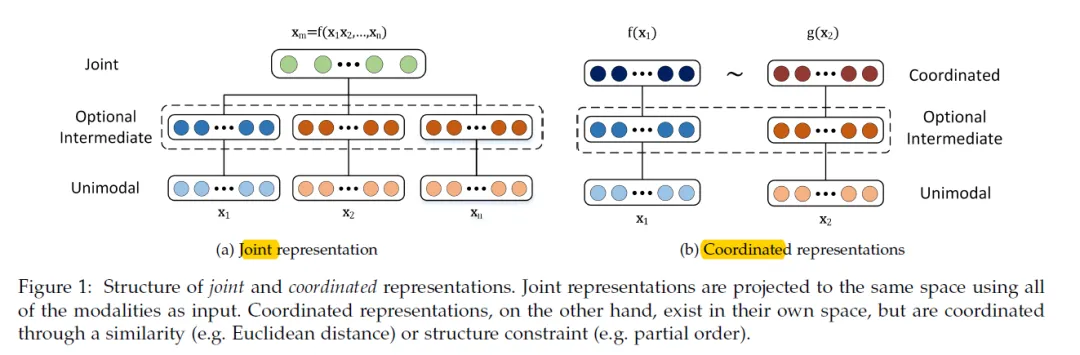

什么是多模態協同表示(Coordinated Representation)?多模態協同表示是一種將多個模態的信息分別映射到各自的表示空間,但映射后的向量或表示之間需要滿足一定的相關性或約束條件的方法。這種方法的核心在于確保不同模態之間的信息在協同空間內能夠相互協作,共同優化模型的性能。

什么是多模態融合

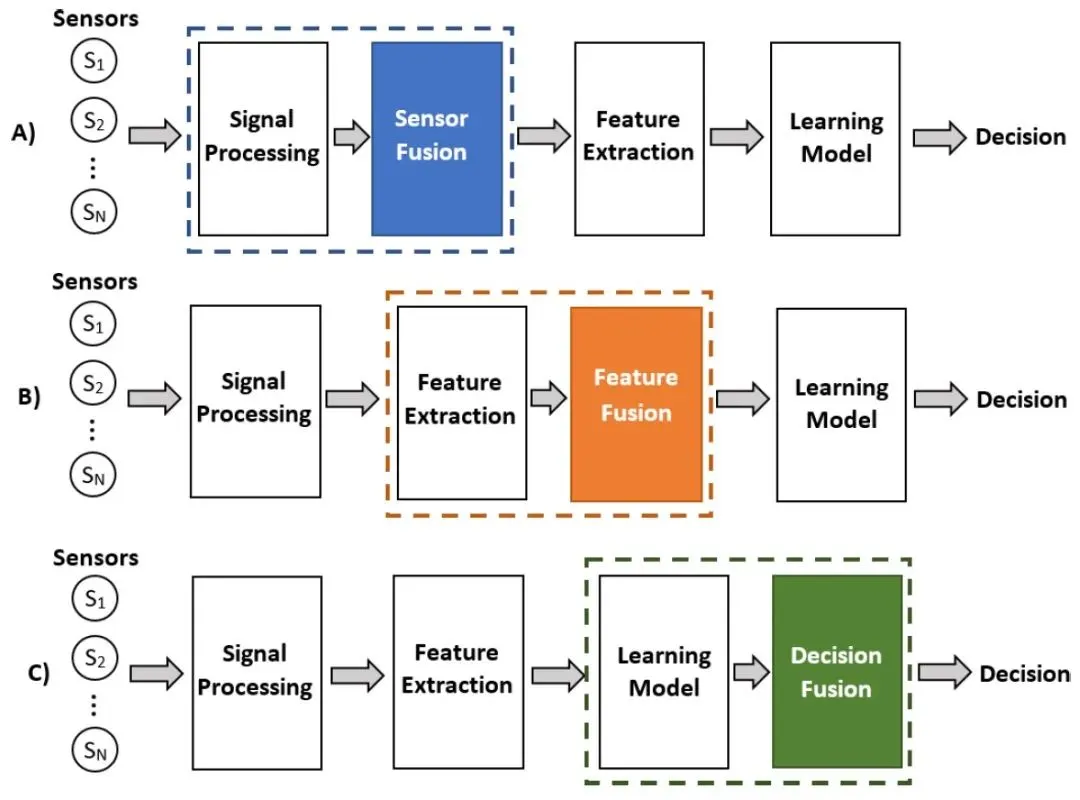

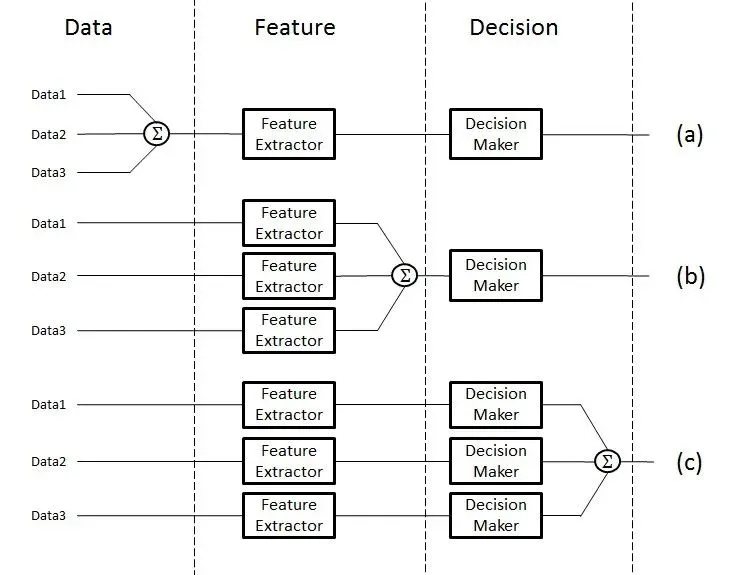

什么是多模態融合(MultiModal Fusion)?多模態融合能夠充分利用不同模態之間的互補性,它將抽取自不同模態的信息整合成一個穩定的多模態表征。從數據處理的層次角度將多模態融合分為數據級融合、特征級融合和目標級融合。

多模態融合

- 數據級融合(Data-Level Fusion):

- 數據級融合,也稱為像素級融合或原始數據融合,是在最底層的數據級別上進行融合。這種融合方式通常發生在數據預處理階段,即將來自不同模態的原始數據直接合并或疊加在一起,形成一個新的數據集。

- 應用場景:適用于那些原始數據之間具有高度相關性和互補性的情況,如圖像和深度圖的融合。

- 特征級融合(Feature-Level Fusion):

- 特征級融合是在特征提取之后、決策之前進行的融合。不同模態的數據首先被分別處理,提取出各自的特征表示,然后將這些特征表示在某一特征層上進行融合。

- 應用場景:廣泛應用于圖像分類、語音識別、情感分析等多模態任務中。

- 目標級融合(Decision-Level Fusion):

- 目標級融合,也稱為決策級融合或后期融合,是在各個單模態模型分別做出決策之后進行的融合。每個模態的模型首先獨立地處理數據并給出自己的預測結果(如分類標簽、回歸值等),然后將這些預測結果進行整合以得到最終的決策結果。

- 應用場景:適用于那些需要綜合考慮多個獨立模型預測結果的場景,如多傳感器數據融合、多專家意見綜合等。

什么是多模態對齊

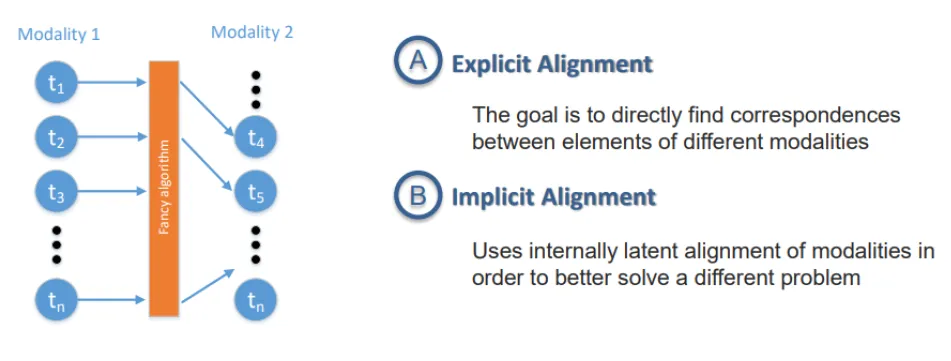

什么是跨模態對齊(MultiModal Alignment)?跨模態對齊是通過各種技術手段,實現不同模態數據(如圖像、文本、音頻等)在特征、語義或表示層面上的匹配與對應。跨模態對齊主要分為兩大類:顯式對齊和隱式對齊。

什么是顯示對齊(Explicit Alignment)?直接建立不同模態之間的對應關系,包括無監督對齊和監督對齊。

- 無監督對齊:利用數據本身的統計特性或結構信息,無需額外標簽,自動發現不同模態間的對應關系。

- CCA(典型相關分析):通過最大化兩組變量之間的相關性來發現它們之間的線性關系,常用于圖像和文本的無監督對齊。

- 自編碼器:通過編碼-解碼結構學習數據的低維表示,有時結合循環一致性損失(Cycle Consistency Loss)來實現無監督的圖像-文本對齊。

- 監督對齊:利用額外的標簽或監督信息指導對齊過程,確保對齊的準確性。

- 多模態嵌入模型:如DeViSE(Deep Visual-Semantic Embeddings),通過最大化圖像和對應文本標簽在嵌入空間中的相似度來實現監督對齊。

- 多任務學習模型:同時學習圖像分類和文本生成任務,利用共享層或聯合損失函數來促進圖像和文本之間的監督對齊。

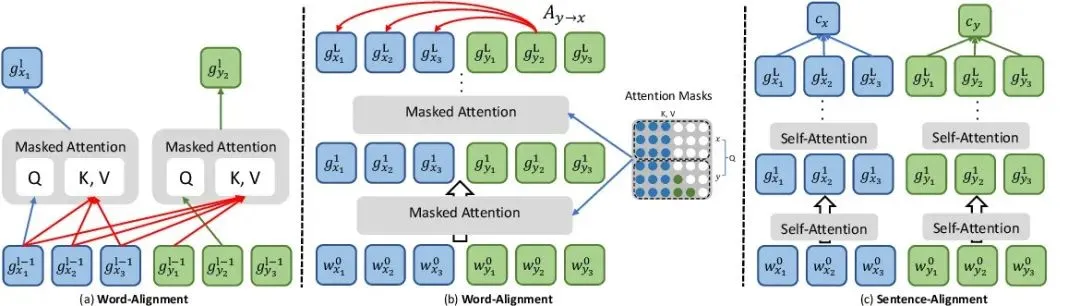

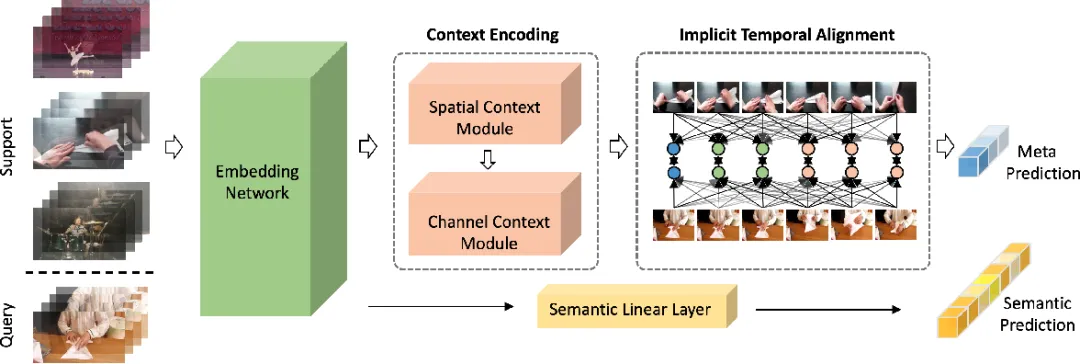

什么是隱式對齊(Implicit Alignment)?不直接建立對應關系,而是通過模型內部機制隱式地實現跨模態的對齊。這包括注意力對齊和語義對齊。

注意力對齊:通過注意力機制動態地生成不同模態之間的權重向量,實現跨模態信息的加權融合和對齊。Transformer模型:在跨模態任務中(如圖像描述生成),利用自注意力機制和編碼器-解碼器結構,自動學習圖像和文本之間的注意力分布,實現隱式對齊。BERT-based模型:在問答系統或文本-圖像檢索中,結合BERT的預訓練表示和注意力機制,隱式地對齊文本查詢和圖像內容。

語義對齊:在語義層面上實現不同模態之間的對齊,需要深入理解數據的潛在語義聯系。圖神經網絡(GNN):在構建圖像和文本之間的語義圖時,利用GNN學習節點(模態數據)之間的語義關系,實現隱式的語義對齊。預訓練語言模型與視覺模型結合:如CLIP(Contrastive Language-Image Pre-training),通過對比學習在大量圖像-文本對上訓練,使模型學習到圖像和文本在語義層面上的對應關系,實現高效的隱式語義對齊。

多模特LLM示例

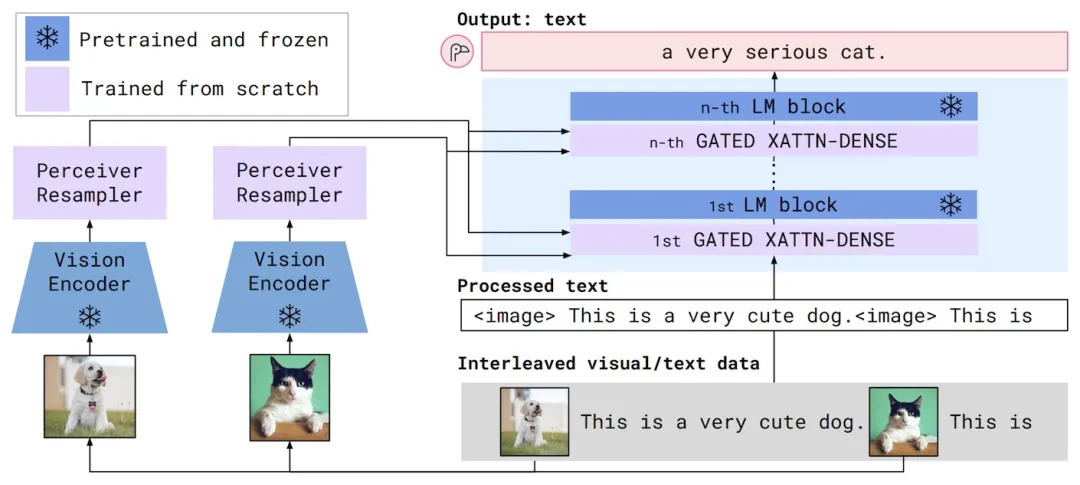

Flamingo是2022年推出的多模態大語言模型。視覺和語言組件的工作原理如下:

視覺編碼器將圖像或視頻轉換為嵌入(數字列表)。這些嵌入的大小取決于輸入圖像的尺寸或輸入視頻的長度,因此另一個稱為感知器重采樣器的組件將這些嵌入轉換為通用的固定長度。

語言模型接收文本和來自 Percever Resampler 的固定長度視覺嵌入。視覺嵌入用于多個“交叉注意力”塊,這些塊學習根據當前文本權衡視覺嵌入不同部分的重要性。

圖 1 來自 Flamingo 論文,展示了模型架構。

訓練分為三個步驟:

- 視覺編碼器使用 CLIP 進行預訓練。CLIP 實際上同時訓練視覺編碼器和文本編碼器,因此此步驟中的文本編碼器將被丟棄。

- 該語言模型是一個預先訓練了下一個標記預測的Chinchilla模型,即根據一系列先前的字符預測下一組字符。大多數 LLM(如 GPT-4)都是這樣訓練的。您可能會聽到這種類型的模型被稱為“自回歸”,這意味著該模型根據過去的值預測未來的值。

- 在第三階段,將未經訓練的交叉注意力模塊插入語言模型中,并在視覺編碼器和語言模型之間插入未經訓練的感知器重采樣器。這是完整的 Flamingo 模型,但交叉注意力模塊和感知器重采樣器仍需要訓練。為此,整個 Flamingo 模型用于計算下一個標記預測任務中的標記,但輸入現在包含與文本交錯的圖像。此外,視覺編碼器和語言模型的權重被凍結。換句話說,只有感知器重采樣器和交叉注意力模塊實際上得到更新和訓練。

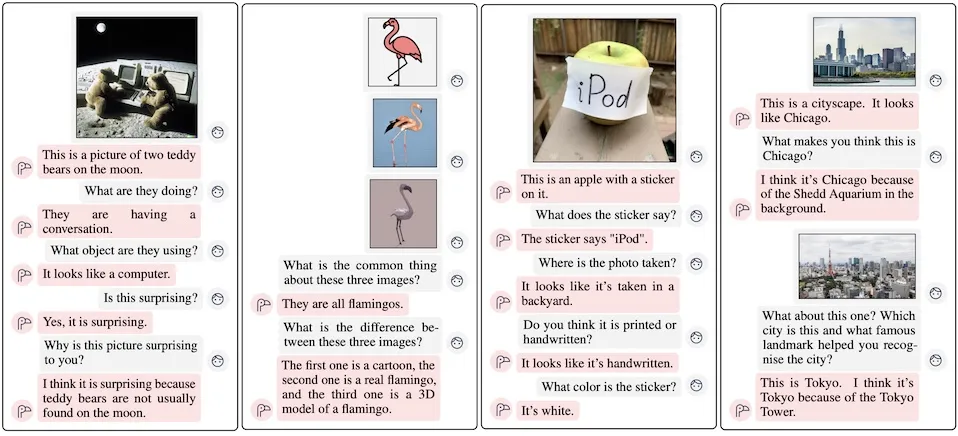

經過訓練,Flamingo 能夠執行各種視覺語言任務,包括以對話形式回答有關圖像的問題。

圖 2 取自 Flamingo 論文,展示了視覺對話的示例。

Flamingo 論文:

??https://arxiv.org/pdf/2204.14198??

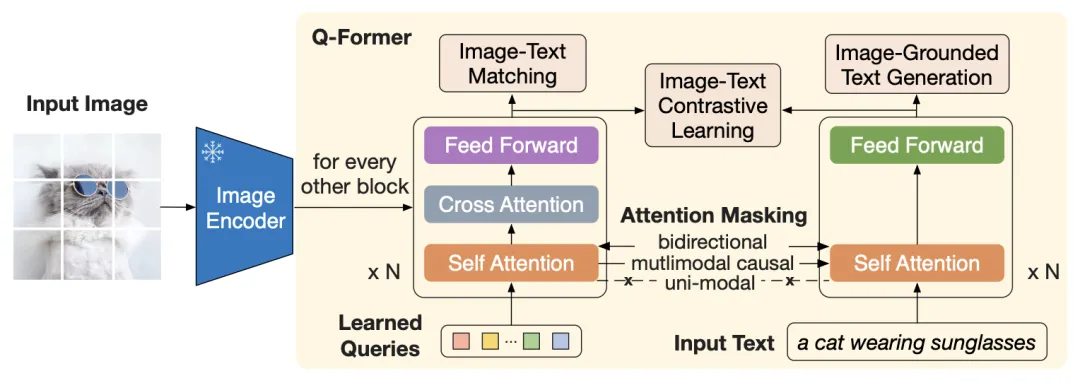

BLIP-2是一款多模態 LLM,于 2023 年初發布。與 Flamingo 一樣,它包含預訓練的圖像編碼器和 LLM。但與 Flamingo 不同的是,圖像編碼器和LLM 均未受影響(預訓練后)。

為了將圖像編碼器連接到 LLM,BLIP-2 使用“Q-Former”,它由兩個組件組成:

- 視覺組件接收一組可學習的嵌入和凍結圖像編碼器的輸出。與 Flamingo 中所做的一樣,圖像嵌入被輸入到交叉注意層中。

- 文本組件接收文本。

圖摘自 BLIP-2 論文,展示了 Q-Former 的內部結構及其訓練目標。

BLIP-2 訓練分為兩個階段:

- 在第 1 階段,Q-Former 的兩個組件針對三個目標進行訓練,這些目標實際上源自BLIP-1論文:

- 圖像-文本對比學習(類似于 CLIP,但有一些細微的差別)。

- 基于圖像的文本生成(生成圖像的標題)。

- 圖像-文本匹配(二元分類任務,其中對于每個圖像-文本對,模型必須回答 1 來表示匹配,否則回答 0)。

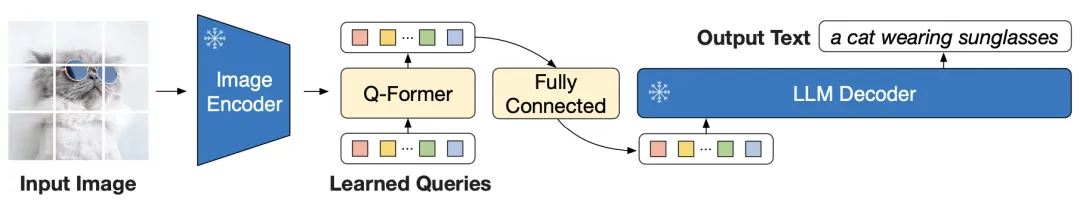

- 在第 2 階段,通過在 Q-Former 和 LLM 之間插入投影層來構建完整模型。此投影層將 Q-Former 的嵌入轉換為具有與 LLM 兼容的長度。然后,完整模型負責描述輸入圖像。在此階段,圖像編碼器和 LLM 保持凍結狀態,并且僅訓練 Q-Former 和投影層。

圖 3 摘自 BLIP-2 論文,展示了完整的模型架構。投影層標記為“完全連接”。

在論文的實驗中,他們使用 CLIP 預訓練圖像編碼器和OPT或Flan-T5作為 LLM。實驗表明,BLIP-2 在各種視覺問答任務上的表現都優于 Flamingo,但可訓練參數卻少得多。這使得訓練過程更加輕松,且更具成本效益。

BLIP-2 論文:

??https://arxiv.org/pdf/2301.12597??

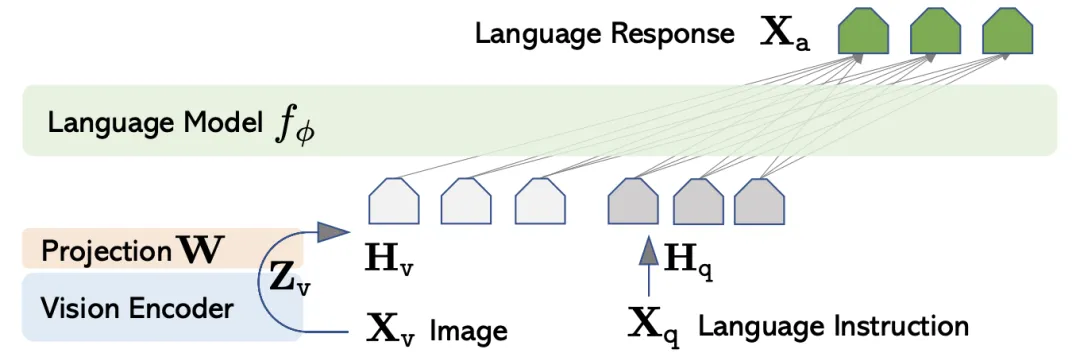

LLaVA是一種多模態 LLM,于 2023 年發布。其架構非常簡單:

- 視覺編碼器使用 CLIP 進行預訓練。

- LLM 是經過預先訓練的Vicuna模型。

- 視覺編碼器通過單個投影層連接到 LLM。

請注意視覺編碼器和 LLM 之間的組件的簡單性,與 BLIP-2 中的 Q-Former 以及 Flamingo 中的感知器重采樣器和交叉注意層相比。

訓練分為兩個階段:

- 在第 1 階段,訓練目標是圖像字幕。視覺編碼器和 LLM 被凍結,因此只訓練投影層。

- 在第 2 階段,LLM 和投影層在部分合成的指令跟蹤數據集上進行微調。它是部分合成的,因為它是在 GPT-4 的幫助下生成的。

圖 1 來自 LLaVA 論文,展示了完整的模型架構。

作者對 LLaVA 的評價如下:

- 他們使用 GPT-4 來評估 LLaVA 在部分合成數據集上的響應質量。在這里,LLaVA 相對于 GPT-4 的得分為 85%。

- 他們在名為 ScienceQA

LLaVA 說明,簡單架構在使用部分合成數據進行訓練可取得優異結果。LLaVA論文:https://arxiv.org/pdf/2304.08485

本文轉載自公眾號數字化助推器 作者:天涯咫尺TGH

原文鏈接:??https://mp.weixin.qq.com/s/ca3J3xMN8Z5V8jQv2jUoOA??