多模態大語言模型(MLLMs)如何重塑和變革計算機視覺? 精華

本文介紹了多模態大型語言模型(MLLM)的定義、使用挑戰性提示的應用場景,以及正在重塑計算機視覺的頂級模型。

目錄

- 什么是多模態大語言模型(MLLM)?

- MLLM 在計算機視覺中的應用與案例

- 領先的多模態大型語言模型

- 未來展望

1. 什么是多模態大型語言模型(MLLM)?

簡單來說,多模態大型語言模型(MLLM)是結合了大型語言模型(LLM)(如 GPT-3 [2] 或 LLaMA-3 [3])的推理能力,同時具備接收、理解并輸出多種模態信息的能力。

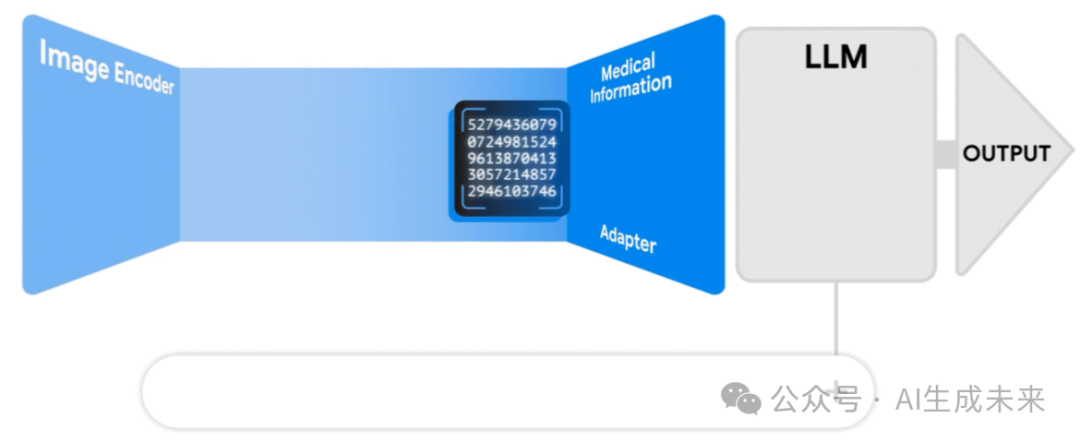

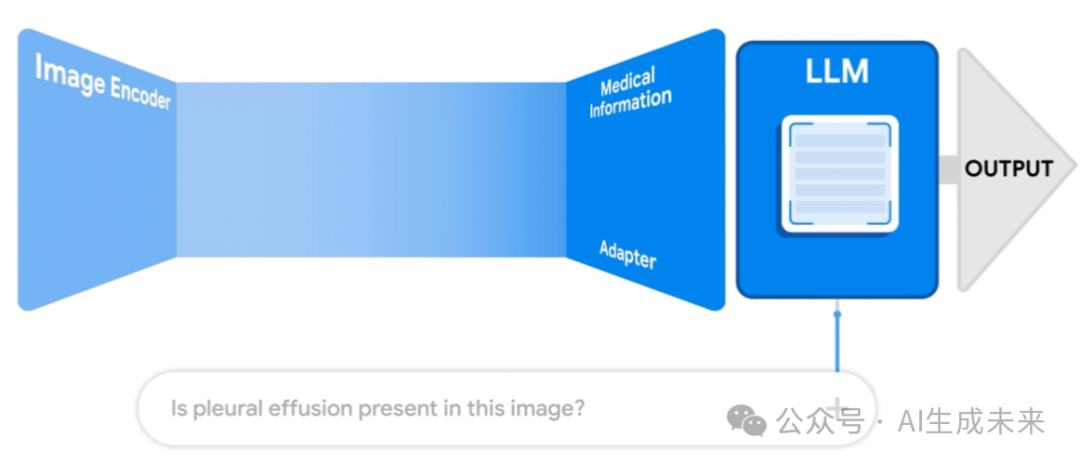

示例:圖 1 展示了一個醫療領域的多模態 AI 系統 [4]。它接收兩個輸入:

- 一張醫學影像

- 一個文本查詢,如:“這張影像中是否存在胸腔積液?”該系統輸出一個關于該查詢的預測答案。

在本文中,可能會簡化“多模態大型語言模型”這一術語,直接稱其為“多模態模型”。

1.1 人工智能中的多模態崛起

近年來,人工智能經歷了重大變革,其中Transformer [5] 體系架構的興起極大推動了語言模型的發展 [6]。這一架構由 Google 于 2017 年提出,并對計算機視覺領域產生了深遠影響。

早期的示例包括視覺 Transformer(ViT) [7],它將圖像分割為多個補丁,并將其作為獨立的視覺 token 進行輸入處理。

隨著大型語言模型(LLM)的崛起,一種新的生成式模型,即多模態大型語言模型(MLLM),自然地誕生了。

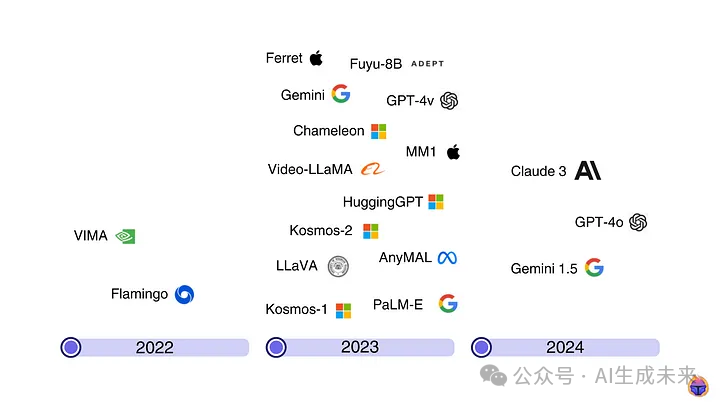

如前面時間線圖所示,2023 年,大多數科技巨頭都推出了至少一種 MLLM。到了 2024 年,OpenAI 的 GPT-4o 在 5 月發布時成為行業熱點。

1.2 MLLMs vs VLMs vs 基礎模型

一些人認為 MLLMs 其實就是基礎模型(Foundation Models)。例如,Google 的 Vertex AI 將 Claude 3、PaliGemma 和 Gemini 1.5 等多模態大型語言模型歸類為基礎模型。??

另一方面,視覺語言模型(VLMs)[8] 是多模態模型的一個子類別,它們集成了文本和圖像輸入,并生成文本輸出。

MLLMs 和 VLMs 的主要區別在于:

- MLLMs 能處理更多模態,而不僅僅是文本和圖像(如 VLMs)。

- VLMs 的推理能力較弱,而 MLLMs 具有更強的邏輯推理能力。

1.3 體系架構

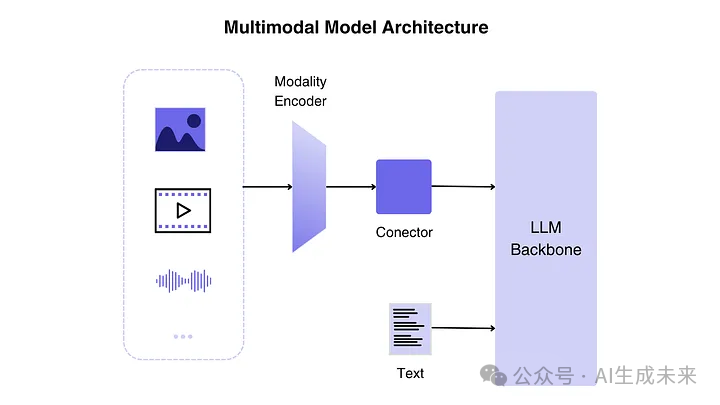

如圖 3 所示,MLLM 的架構主要分為三個部分:

- 模態編碼器(Modality Encoder):該組件將視覺、音頻等原始數據轉換為緊湊的表示形式。通常使用預訓練編碼器(如 CLIP)進行遷移學習,以適配不同的模態輸入。

- LLM 主干(LLM Backbone):語言模型負責生成文本輸出,作為 MLLM 的“核心大腦”。編碼器接收圖像、音頻或視頻輸入并生成特征,由連接器(模態接口)處理后輸入 LLM。

- 模態接口(Modality Interface):連接編碼器和 LLM,確保 LLM 能夠理解不同模態的信息,并進行合理的推理和輸出。

2. 多模態模型在計算機視覺中的應用

為了驗證這些模型的能力,使用了 GPU 對三個頂級 MLLMs 進行測試,并使用了具有挑戰性的查詢(不再是貓??和狗??的簡單示例)。

測試的 MLLMs:

- GPT-4o (OpenAI)

- LLaVA 7b (開源,基于 LLaMA)

- Apple Ferret 7b (Apple 開源)

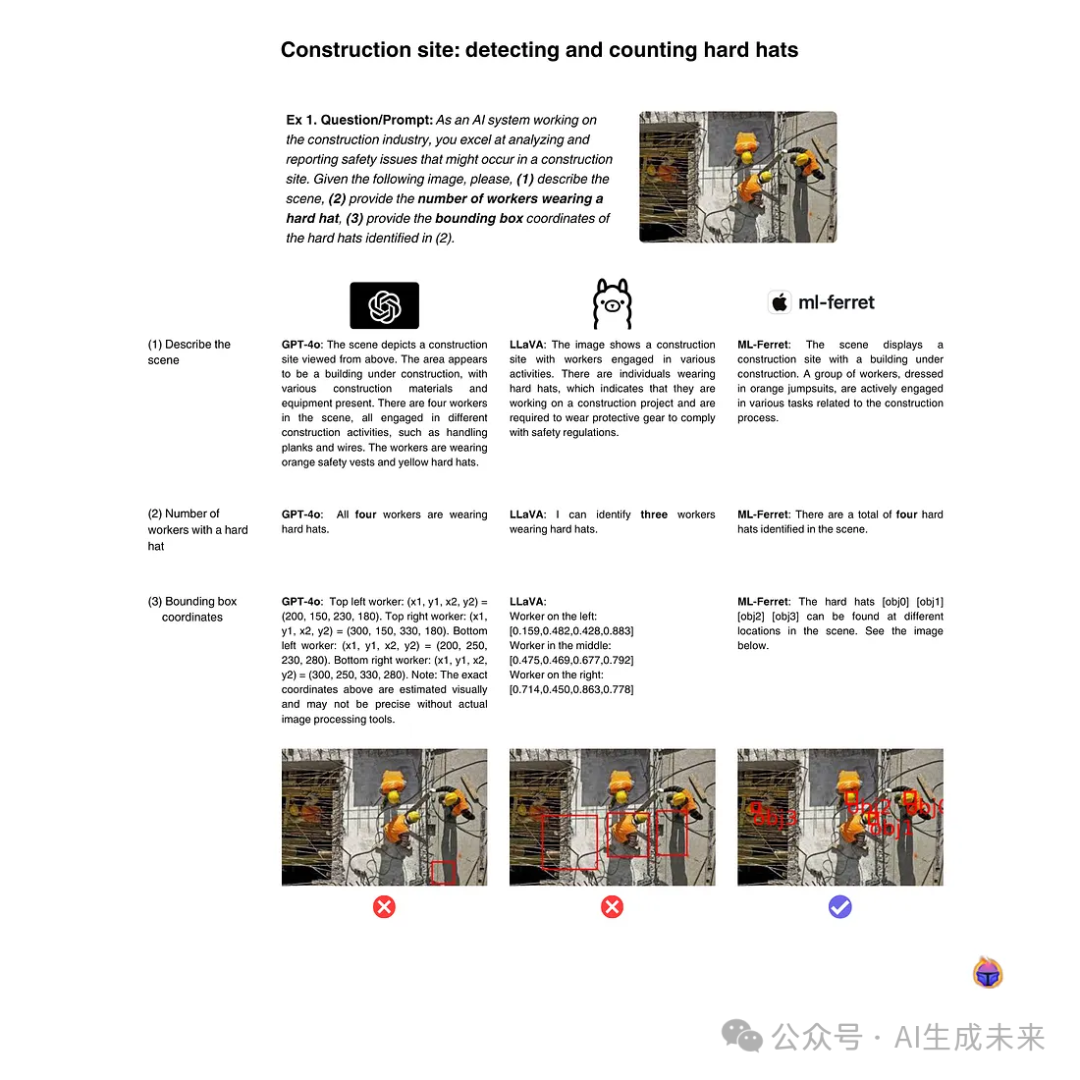

2.1 目標遮擋情況下的物體計數

任務: 計算圖像中出現的安全帽數量,并提供其位置(見圖 4)。

- GPT-4o提供了詳盡的場景描述,但給出的坐標有誤。

- LLaVA僅檢測到 3 個安全帽,并且沒有正確識別遮擋部分的安全帽。

- Apple Ferret成功檢測到 4 個安全帽,包括左側被遮擋的那個!??

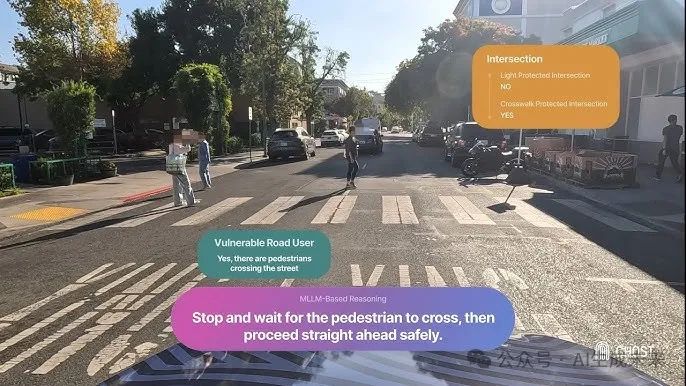

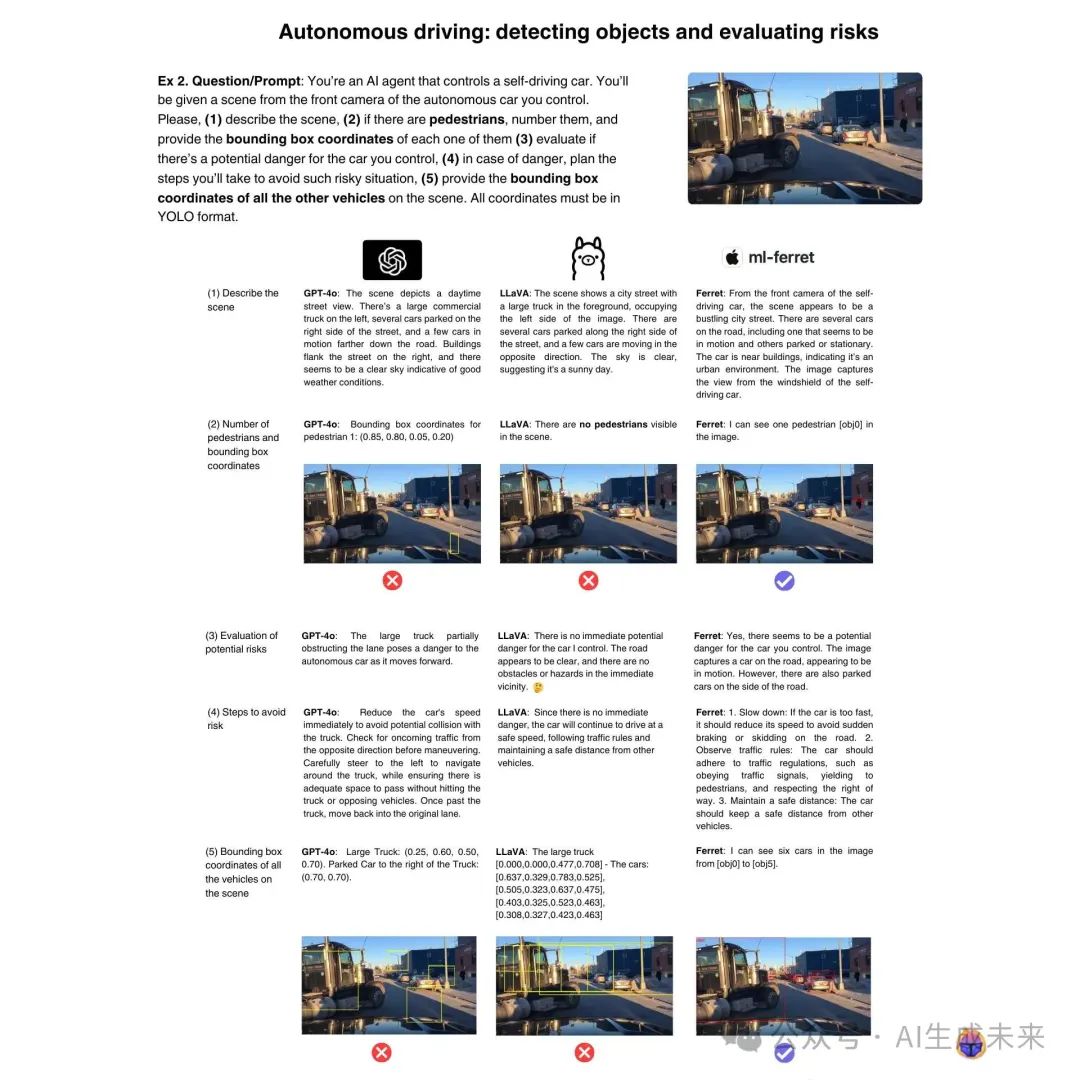

2.2 自動駕駛:風險評估與規劃

任務: 從自動駕駛汽車的角度評估風險,并檢測車輛和行人(見圖 5)。

- LLaVA未能識別前方的大卡車。

- GPT-4o在文本分析方面表現優異,但檢測出的目標框位置錯誤。

- Apple Ferret是唯一一個準確檢測出大部分物體并給出正確坐標的模型 ?。

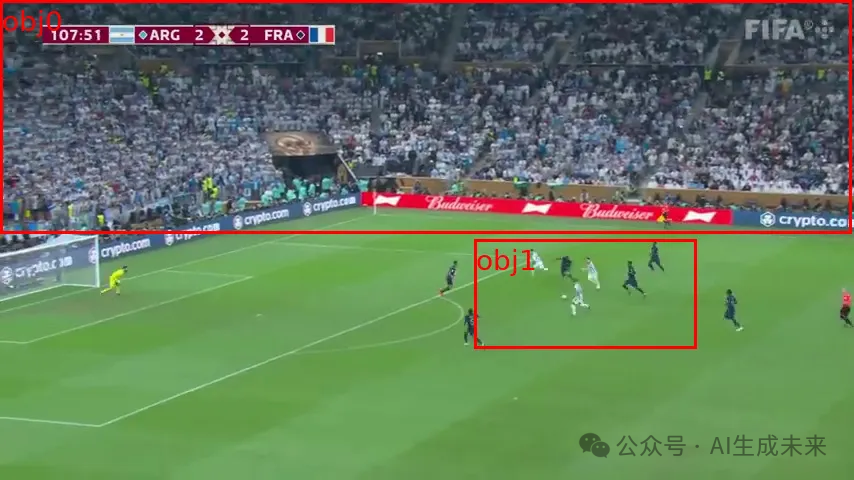

2.3 體育分析:目標檢測與場景理解

任務: 分析足球比賽場景,包括球員計數、球和守門員位置估計,并預測進球可能性(見圖 7)。

結果:

- 所有模型均未能正確檢測所有球員,并區分不同球隊。

- 相比之下,YOLOv8 這樣的單模態檢測模型表現更優。

這表明,MLLMs 在一些復雜任務上仍然存在局限性,它們尚未完全取代專門優化的計算機視覺模型。

下一步是否應該對 MLLMs 進行微調???

3. 領先的多模態大型語言模型