HuggingFace模型轉一鍵llamafile包完整教程,通義千問成功案例分享

隨著通義千問開源版的發布,越來越多的用戶希望能在本地部署這款優秀的中文大模型。然而,傳統的部署方式往往需要復雜的環境配置,讓很多非技術背景的用戶望而卻步。今天,我要向大家介紹一個革命性的方案:將通義千問轉換為Llamafile格式,實現真正的一鍵運行!

有關 llamafile 的特點,我在上周的文章中做過總結。這次我給大家帶來的是著名的中文開源大模型“通義千問”的本地一鍵運行解決方案。

為什么選擇通義千問?

通義千問(Qwen)是阿里云開源的大語言模型,具有以下特點:

- 強大的中文理解能力:針對中文場景深度優化

- 開源免費:可以自由部署和使用

- 持續更新:版本迭代快,性能不斷提升

- 社區活躍:有大量中文用戶分享使用經驗

一、為什么選擇Llamafile部署方案?

相比于傳統的Ollama和llama.cpp部署方式,Llamafile具有以下突出優勢:

- 一鍵運行,對通義千問用戶特別友好

- 無需安裝Python、CUDA等復雜環境

- 無需配置模型參數

- 雙擊即可運行,像運行微信一樣簡單

- 適合普通用戶的硬件要求

- 支持在普通筆記本上運行

- 無需GPU,CPU即可運行

- 優化后的通義千問3B版本僅需4GB內存

- 全平臺支持

- Windows用戶可以直接雙擊exe文件運行

- Mac用戶可以直接在終端運行

- Linux用戶可以通過命令行啟動

二、實戰:將通義千問轉換為Llamafile

下面我們以廣受歡迎的中文大模型通義千問(Qwen2.5-3B)為例,詳細介紹在Linux下的轉換過程。

步驟1:下載Hugging Face模型

首先需要從Hugging Face下載模型文件:

from huggingface_hub import snapshot_download

model_id = "Qwen/Qwen2.5-3B-Instruct"

print("Downloading model: "+model_id)

snapshot_download(repo_id=model_id, local_dir="Qwen2.5-3B", local_dir_use_symlinks=False, revision="main")步驟2:轉換為llama.cpp格式

2.1 準備環境

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cpp

pip install -r requirements.txt2.2 轉換為GGUF格式

下面的命令會將模型轉換為GGUF格式。

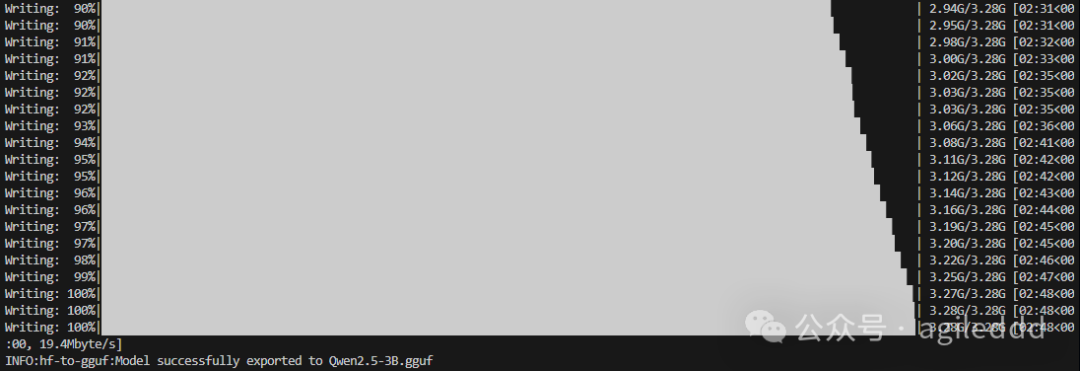

python llama.cpp/convert_hf_to_gguf.py ./Qwen2.5-3B --outfile Qwen2.5-3B.gguf --outtype q8_0

以下是轉換完成的畫面。

步驟3:生成Llamafile

3.1 下載Llamafile運行時

wget https://github.com/Mozilla-Ocho/llamafile/releases/download/0.8.16/llamafile-0.8.16.zip

unzip llamafile-0.8.16.zip3.2 轉換為Llamafile格式

./llamafile-0.8.16/bin/llamafile-convert Qwen2.5-3B.gguf轉換完成后,你將得到Qwen2.5-3B.llamafile文件。

運行方法

- Linux/MacOS:

./Qwen2.5-3B.llamafile- Windows:將文件重命名為?Qwen2.5-3B.llamafile.exe后雙擊運行

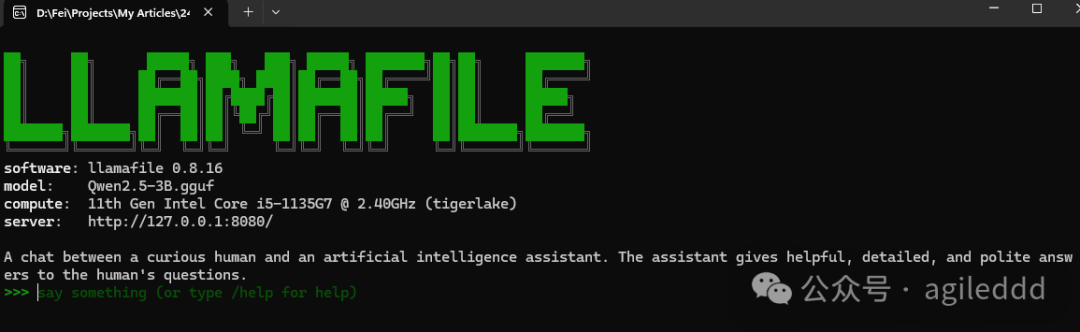

雙擊Qwen2.5-3B.llamafile.exe 后的命令行顯示畫面

我的 i5 筆記本純 CPU 運行也能達到 7 tokens/秒

三、總結與展望

通過Llamafile格式,我們終于可以像運行普通軟件一樣使用通義千問了!這不僅讓AI技術變得更加平民化,也為通義千問這樣優秀的中文模型提供了更好的使用體驗。

未來,我們期待看到:

- 通義千問更多版本的Llamafile格式支持

- 更好的中文交互體驗優化

- 更多本地化應用場景

補充說明:本教程以通義千問3B版本為例,更大的模型(如7B、14B版本)也可以使用相同的方法轉換,但需要相應更多的系統內存。建議根據自己的電腦配置選擇合適的模型版本。

本文轉載自??非架構??,作者: surfirst