FineTuneBench:商業精細調整API能夠如何融入LLMs中的新知識?

研究背景

這篇文章研究了商業微調API在將新知識注入大型語言模型(LLMs)和更新現有知識方面的效果。盡管OpenAI和Google等提供商提供的商業LLMs微調API具有靈活的應用適應性,但其有效性尚不清楚。

該問題的研究難點包括:微調方法的不透明性、缺乏統一的基準評估、用戶對超參數優化的限制以及模型在處理新知識和更新知識時的泛化能力有限。

相關工作:

該問題的研究相關工作包括監督微調、強化學習從人類反饋、檢索增強生成等方法,但這些方法在知識注入方面的效果尚不明確。此外,之前的研究主要集中在開源LLMs上,而對大型商業LLMs的微調研究較少。

研究方法

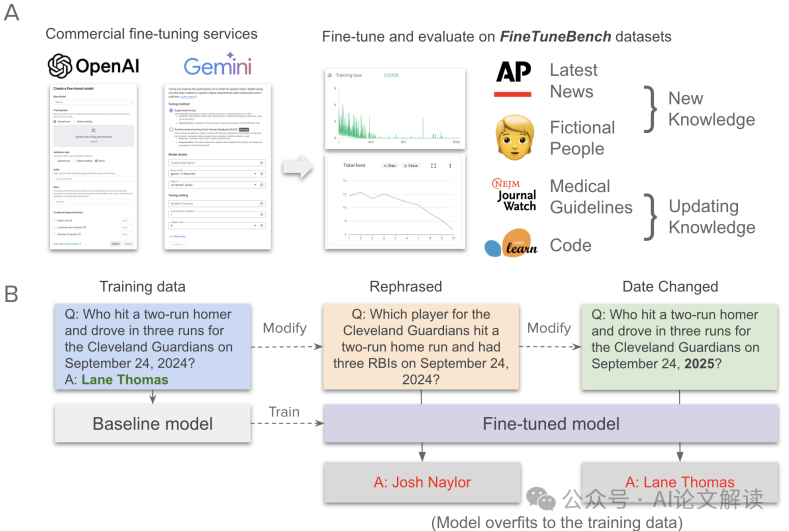

這篇論文提出了FineTuneBench,一個評估框架和數據集,用于理解商業微調API在學習和更新知識方面的效果。具體來說,

- 數據集構建:FineTuneBench包含四個領域的數據集:最新新聞、虛構人物、醫療指南和代碼。每個領域有150個訓練問題和50個測試問題。

- 模型選擇:評估了五個模型:三個來自OpenAI的GPT模型(gpt-4o-mini、gpt-4o、gpt-3.5-turbo)和兩個來自Google的Gemini模型(gemini-1.5-flash、gemini-1.5-pro)。

- 微調方法:使用各自的微調服務對模型進行微調。OpenAI僅允許指定學習率、批量大小和訓練輪數,而Google Cloud還允許指定微調方法的適配器大小。所有分析中,除了訓練輪數外,其他微調特定超參數保持默認值。

- 知識注入技術:在最新新聞數據集中,采用了四種技術來誘導知識獲取:直接問答對、掩碼、完成和無提示完成。

實驗設計

- 數據收集:從2024年9月1日至9月30日隨機抽取了2000篇美聯社的新聞文章,確保這些文章不出現在任何評估模型的預訓練數據中。然后使用GPT-4o生成問題和答案對,并通過質量控制步驟篩選出最終的問題/答案對。

- 實驗設置:在每個數據集上,模型在原始問題和修改后的問題上進行訓練和評估。對于最新新聞數據集,還包括重新措辭和日期更改的修改。對于虛構人物數據集,生成了基于虛構人物的描述和相關問題。對于醫療指南和代碼數據集,收集了最新的醫療指南和代碼庫,并使用Claude Sonnet-3.5生成問題和答案對。

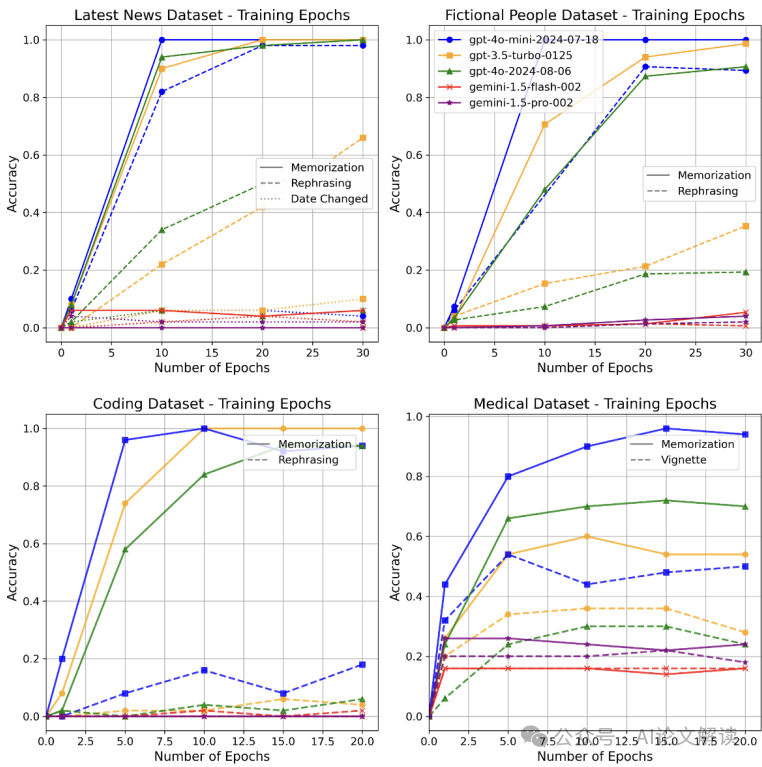

- 訓練過程:固定批量大小為1,默認學習率參數。對于新知識數據集,模型訓練1、10、20和30輪。對于更新知識數據集,模型訓練1、5、10、15和20輪。

結果與分析

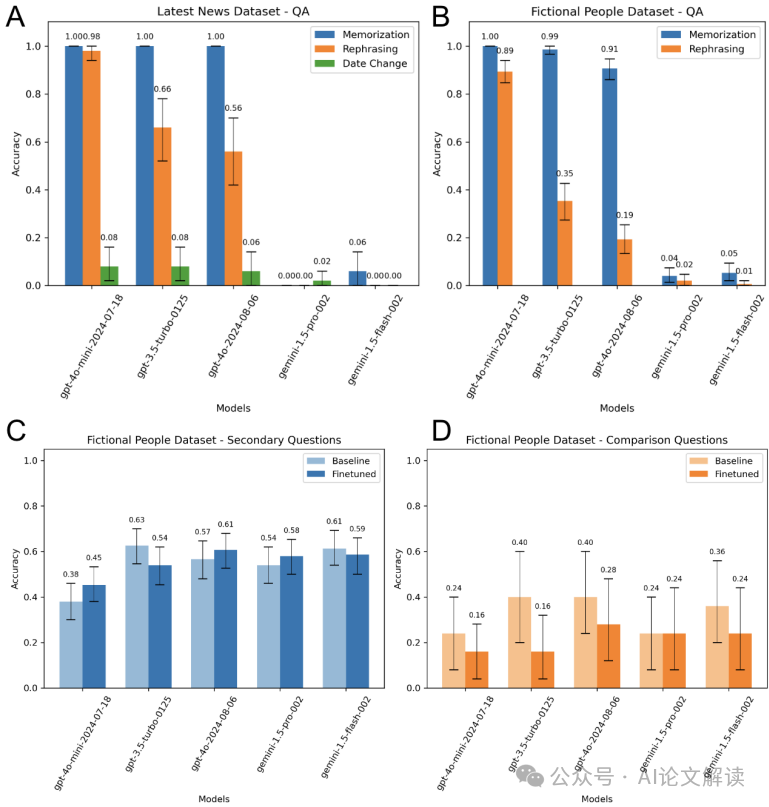

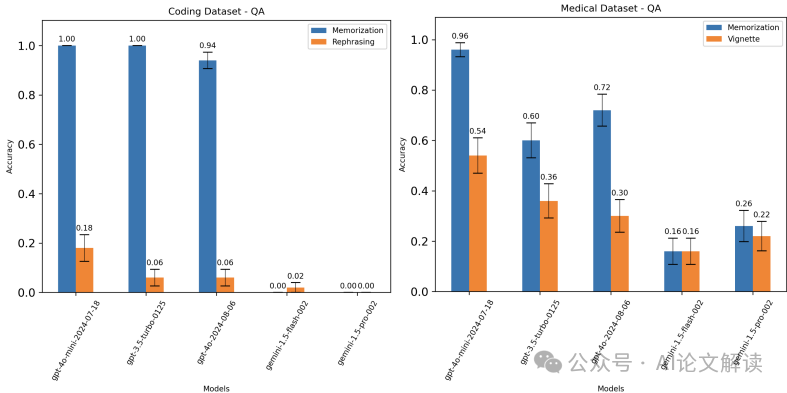

新知識任務:在所有新知識數據集上,OpenAI模型幾乎可以完美地記住問答對,但在重新措辭或派生問題上表現較差,表明許多情況下記憶并未轉化為真正的知識獲取。Gemini模型的表現更差,無法準確記住問答對。

更新知識任務:在更新知識數據集上,商業微調模型的泛化性能更低。OpenAI模型在重新措辭的編程問題上平均準確率為10%,在醫療數據集上的臨床情景測試問題上的準確率為40%。

泛化能力:盡管模型在訓練初期表現出強烈的記憶能力,但在泛化任務上的性能提升較慢。Gemini模型在20或30輪訓練后仍未顯著提高性能。

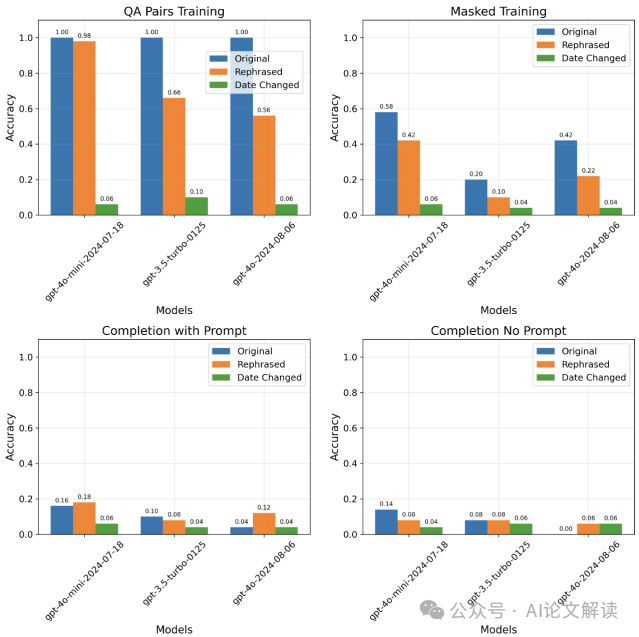

替代訓練技術:使用掩碼、提示完成和無提示完成的替代訓練技術未能提高泛化能力,并且在原始問答對上的性能也較低。

總體結論

這篇論文通過FineTuneBench評估框架和數據集,系統地分析了商業微調API在學習和更新知識方面的效果。結果表明,盡管微調可以提高模型的某些能力,但在大多數情況下,模型在處理新知識和更新知識時的泛化能力有限。特別是,Gemini模型的微調效果最差,無法有效學習新知識或更新現有知識。未來的研究可以擴展評估范圍,并探索不同的超參數組合以提高模型的性能。

優點與創新

引入FineTuneBench:論文首次提出了FineTuneBench,這是一個評估框架和數據集,用于理解商業微調API在學習和更新知識方面的能力。

多模型和多API評估:論文評估了五個前沿LLM(包括GPT-4o和Gemini 1.5 Pro)使用OpenAI和Google Vertex AI的商業微調API的效果。多樣化的數據集:FineTuneBench數據集包含四個領域的知識注入測試:最新新聞、虛構人物、醫療指南和代碼。

關鍵問題及回答

問題1:FineTuneBench數據集是如何構建的?各個數據集的構建過程有何不同?

FineTuneBench數據集包含四個領域的數據集:最新新聞、虛構人物、醫療指南和代碼。每個領域有150個訓練問題和50個測試問題,總共625個訓練問題和1075個測試問題。

最新新聞數據集:從2024年9月1日至9月30日隨機抽取了2000篇美聯社的新聞文章,確保這些文章不出現在任何評估模型的預訓練數據中。然后使用GPT-4o生成問題和答案對,并通過質量控制步驟篩選出最終的問題/答案對。此外,還包括重新措辭和日期更改的修改。虛構人物數據集:生成了基于虛構人物的描述和相關問題。每個虛構人物的描述包含六個事實(如體重、身高、年齡、職業、喜歡的顏色和城市),并基于這些事實生成六個問題/答案對。還包括基于這些事實生成的衍生問題(如二次問題和比較問題)。醫療指南數據集:收集了最新的醫療指南和代碼庫,并使用Claude Sonnet-3.5生成問題和答案對。每個指南更新對應一個問題/答案對,并要求模型將這些更新應用到臨床情景中,生成新的問題和答案對。代碼數據集:從Scikit-Learn的代碼庫中生成了與代碼相關的問答對。每個Python文件生成一個問題和答案對,并測試模型對對象或函數名稱更改后的理解。

問題2:在微調過程中,使用了哪些技術來誘導知識獲取?這些技術在最新新聞數據集上的表現如何?

在最新新聞數據集上,采用了四種技術來誘導知識獲取:直接問答對、掩碼、完成和無提示完成。

直接問答對:這是最基本的訓練方法,模型在提示(系統提示)下生成問題和答案對。

掩碼:在句子中掩碼掉答案部分,模型需要根據上下文推斷出答案。

無提示完成:沒有系統提示,模型需要自行理解事實并完成句子。

這些技術在最新新聞數據集上的表現有所不同。直接問答對的效果最好,模型在重新措辭和日期更改問題上的表現較差,表明記憶并未轉化為真正的知識獲取。掩碼和完成技術在某些情況下有所改進,但仍未能顯著提高模型的泛化能力。無提示完成的效果最差,模型在重新措辭和日期更改問題上的表現仍然不理想。

問題3:在更新知識任務中,商業微調模型的泛化性能為何較低?與學習新知識相比,更新知識有哪些額外的挑戰?

在更新知識任務中,商業微調模型的泛化性能較低,主要有以下幾個原因:

知識沖突:更新知識需要模型替換現有的知識,并在各種實例中傳播這些變化。這可能會導致模型在處理新舊知識時產生沖突,從而影響其泛化能力。

一致性要求:例如,當函數的名稱更改時,模型不僅需要記住新的名稱,還需要在所有代碼實例中一致地應用這個更改。這種一致性要求在訓練過程中難以實現。

模型先驗:醫療問題的答案通常是概率性的(如列出多個建議),更新模型的答案需要引導其在已知答案中選擇。而編程問題的答案通常是確定性的,更改名稱需要模型完全記住新的名稱。

與學習新知識相比,更新知識有以下額外的挑戰:

知識擴散:更新知識需要在多個實例中傳播變化,這增加了模型的復雜性和計算成本。一致性維護:模型需要確保在所有相關實例中保持一致的知識,這在訓練過程中難以實現。先驗知識的利用:醫療知識具有一定的分布性,模型可以通過選擇已知答案來更新;而編程知識則需要完全記住新的名稱,增加了學習的難度。

本文轉載自 ??AI論文解讀??,作者:柏企